Calcul analytique |

| Cours pour les Journées Nationales du Calcul Formel |

|

| 29 novembre 2011 |

|

. Ce travail a

été subventionné par le projet

. Ce travail a

été subventionné par le projet

Préface |

7 |

1Motivation |

9 |

1.1Vers un système de calcul formel/analytique |

9 |

1.2Exemples |

10 |

1.2.1Intégration numérique certifiée |

10 |

1.2.2Exemple : résolution polynomiale |

10 |

1.2.3Exemple : suivi de chemin |

11 |

1.2.4Exemple : nombres de Bell |

11 |

1.3Utilité du calcul analytique pour le calcul formel |

12 |

1.3.1Résolution de systèmes polynomiaux par homotopie |

12 |

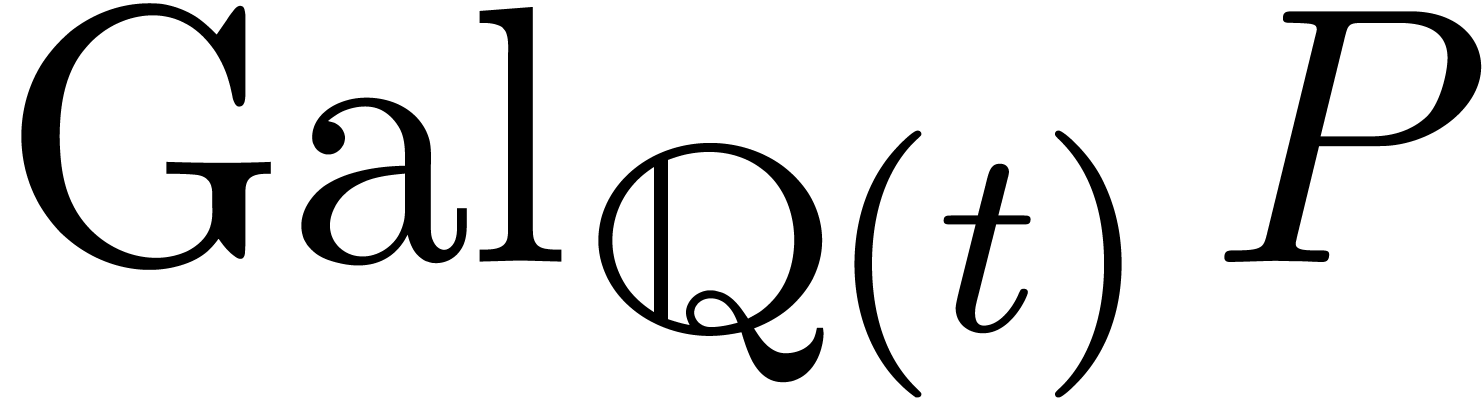

1.3.2Groupe de Galois d'une fonction algébrique |

12 |

1.3.3Groupe de Galois différentiel |

13 |

Monodromie d'un opérateur différentiel |

13 |

Groupe de Galois différentiel |

13 |

1.4Utilité du calcul formel pour le calcul analytique |

14 |

1.5Outils communs pour calculs formel et analytique |

14 |

2Analyse calculable |

15 |

2.1Nombres réels calculables |

15 |

2.1.1Définition |

15 |

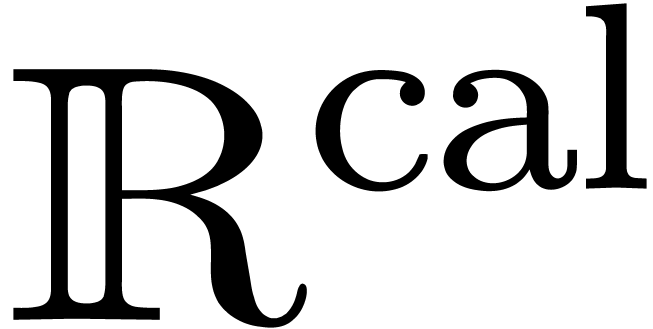

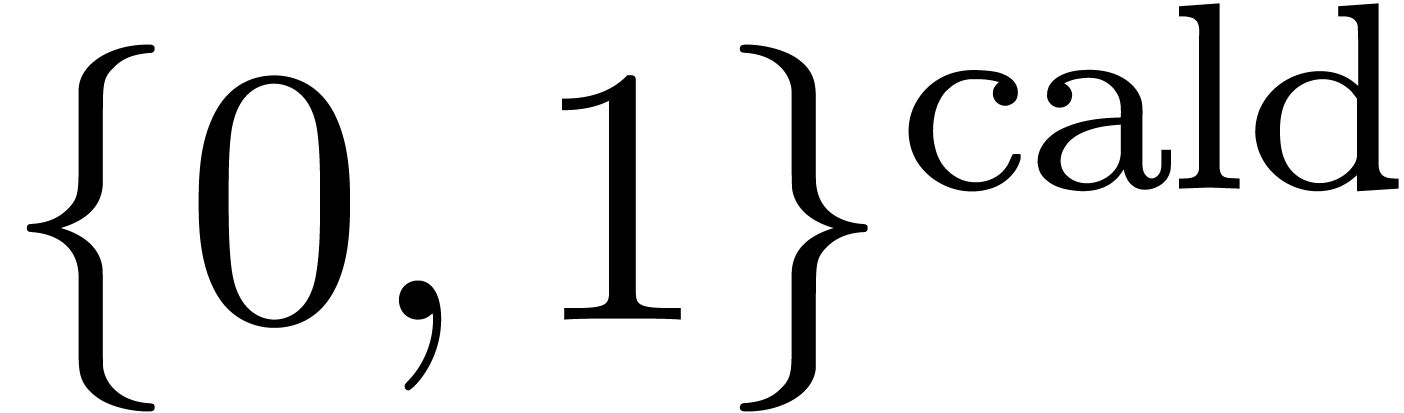

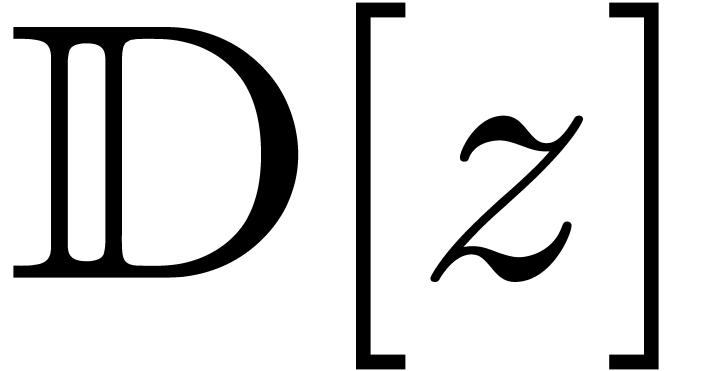

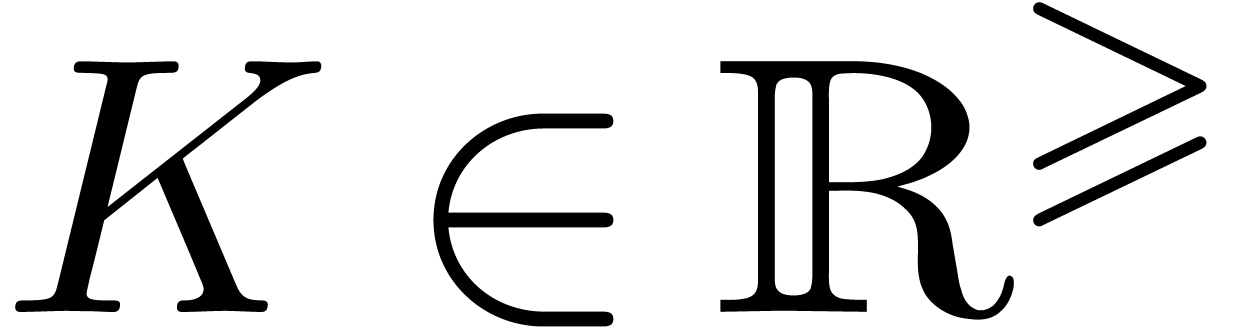

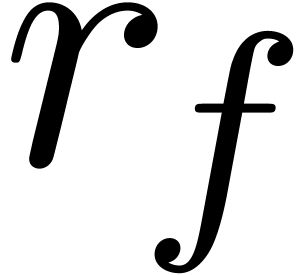

2.1.2Nombres réels calculables dans |

16 |

2.2Théorèmes classiques de non calculabilité |

16 |

2.2.1Théorème de Turing |

16 |

2.2.2Théorème de Grzegorczyk |

17 |

2.2.3Théorème de Denef et Lipschitz |

17 |

2.2.4Questionnaire |

17 |

2.3Semi calculabilité et typage |

18 |

2.3.1Autres types de calculabilité |

18 |

2.3.2Typage |

19 |

2.3.3Structures effectives |

19 |

2.3.4Approximateurs |

20 |

3Arithmétique de boules |

21 |

3.1Principes |

21 |

3.1.1Encadrements par des boules |

21 |

3.1.2Opérations |

22 |

3.1.3Opérations en précision limitée |

22 |

3.1.4Arithmétique d'intervalles |

23 |

3.1.5Prédicats |

24 |

3.1.6Estimations d'erreur a priori |

24 |

3.2Limiter la surestimation |

25 |

3.2.1L'ennemi |

25 |

3.2.2Le problème pour le calcul des puissances successives |

26 |

3.2.3Choix d'une bonne représentation par boules complexes |

26 |

3.2.4Minimisation de la profondeur du calcul |

27 |

3.2.5La méthode perturbative |

27 |

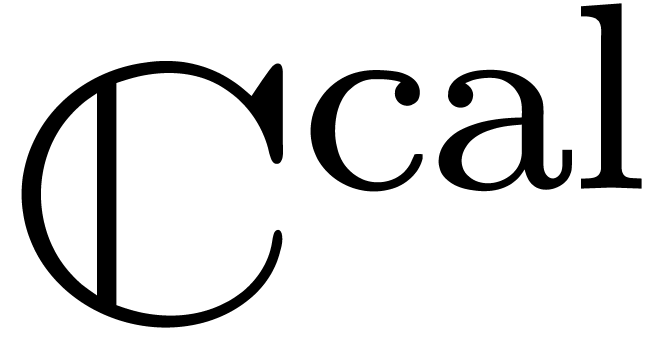

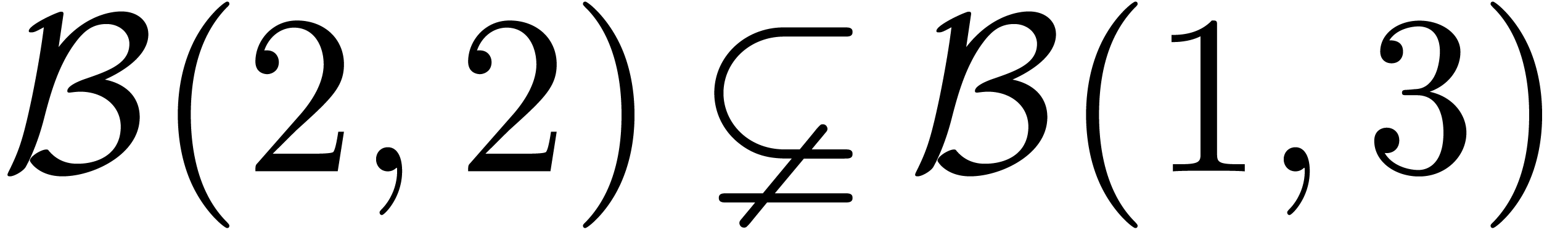

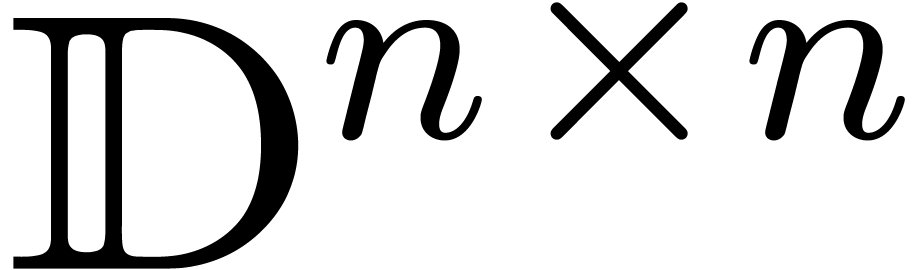

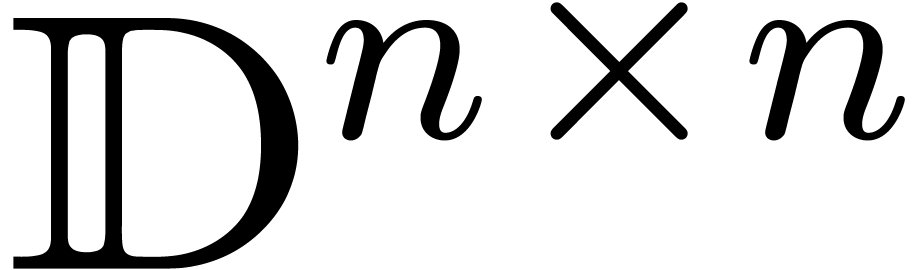

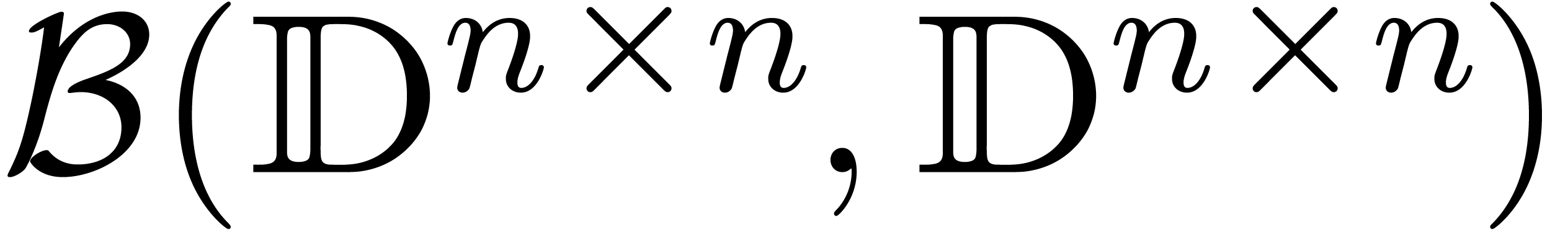

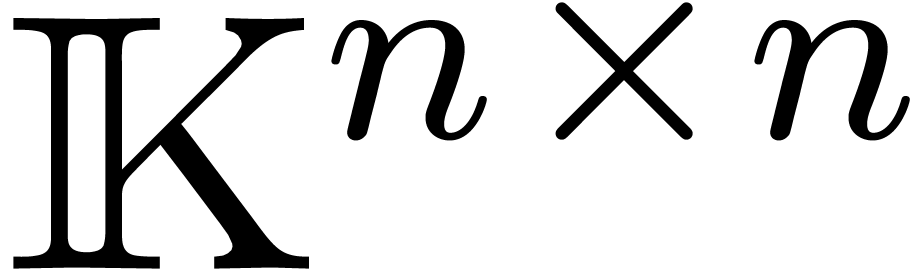

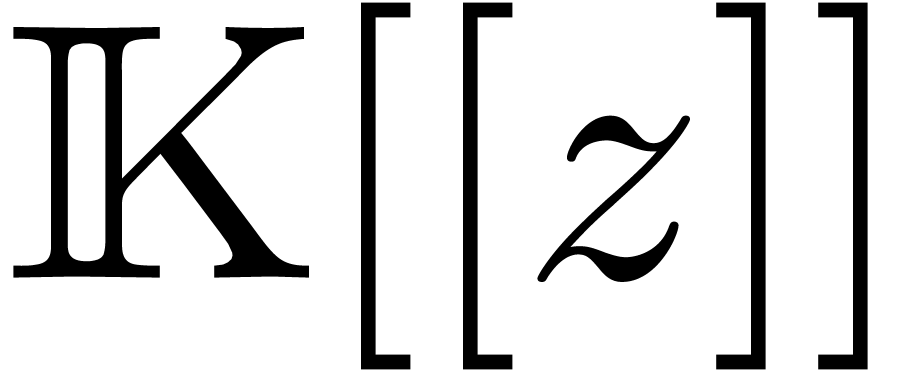

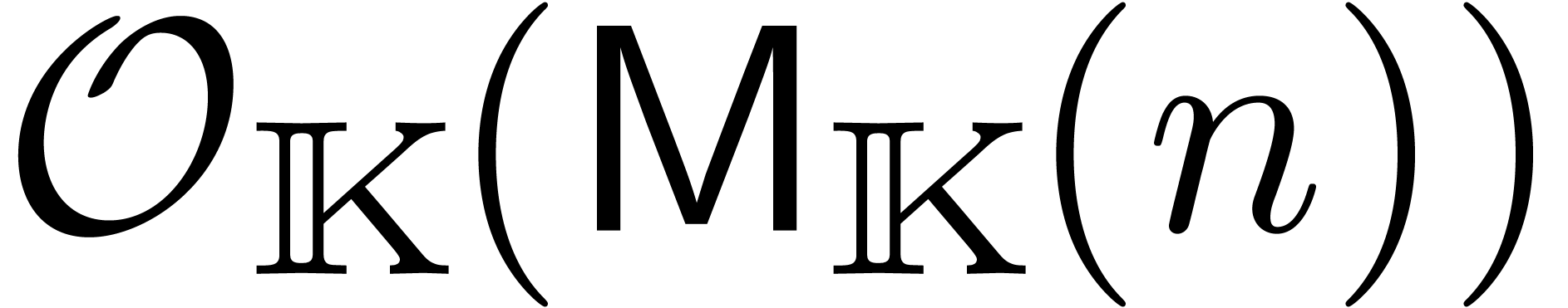

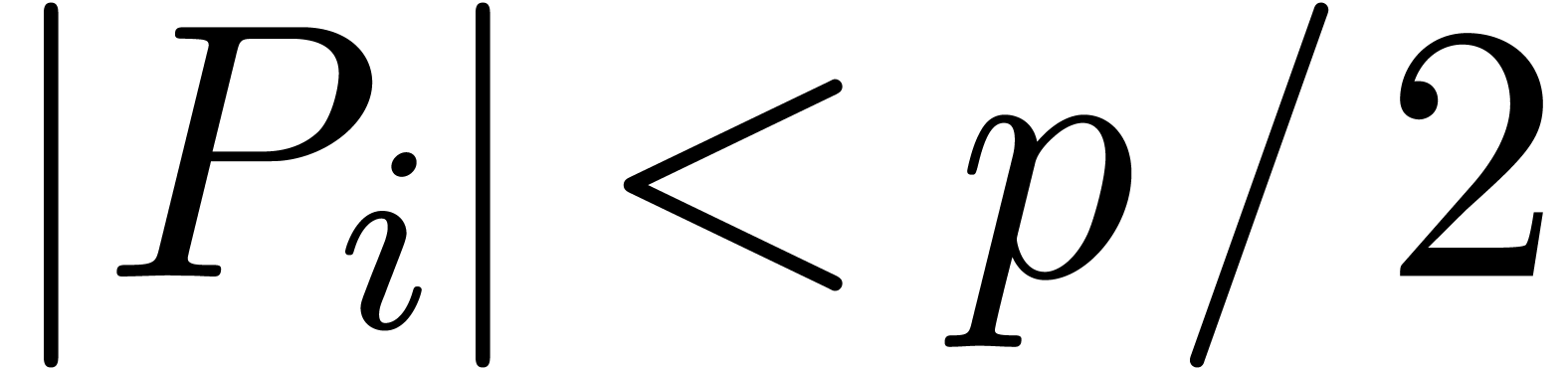

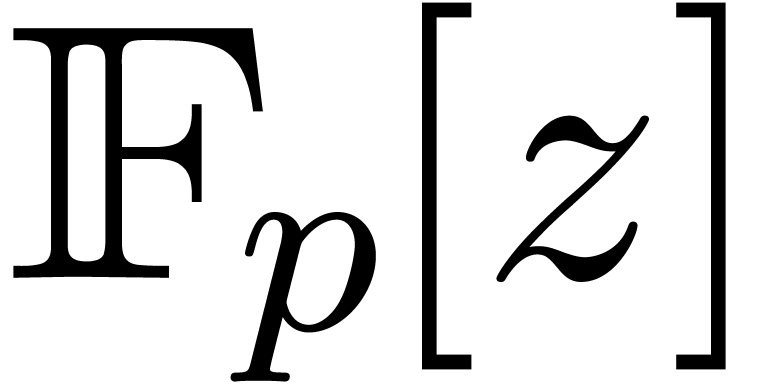

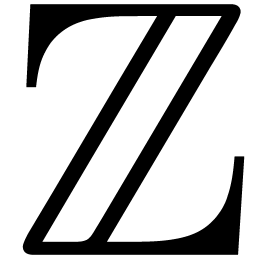

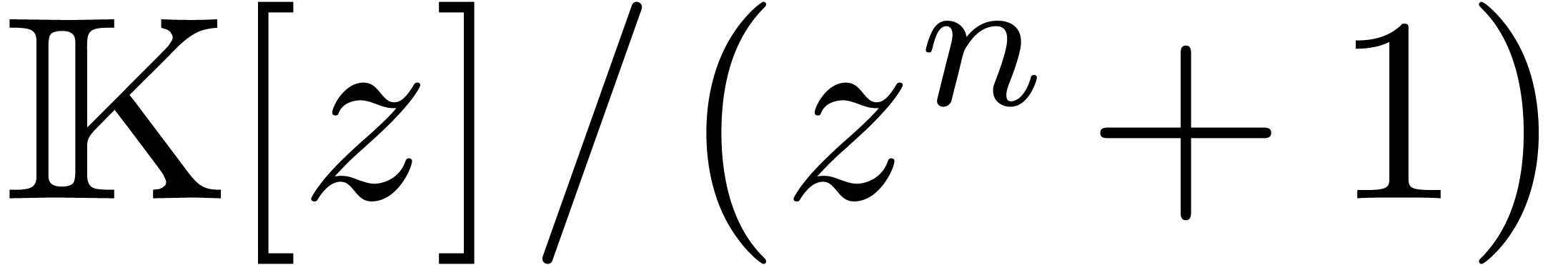

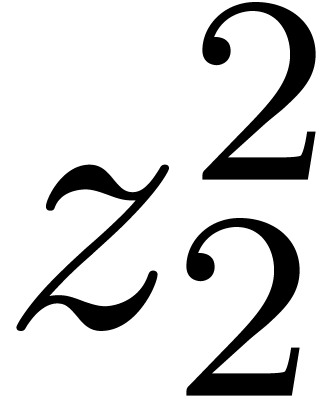

3.2.6Calcul d'une forme échelon certifiée dans

|

28 |

3.3Perte de précision intrinsèque et surestimation |

29 |

3.3.1Nombre de conditionnement et perte de précision |

29 |

3.3.2Extensions optimales et surestimation |

30 |

3.3.3Surestimation de l'arithmétique standard |

31 |

3.4Qualité versus efficacité |

32 |

3.4.1Le Graal : estimations efficaces et de qualité |

32 |

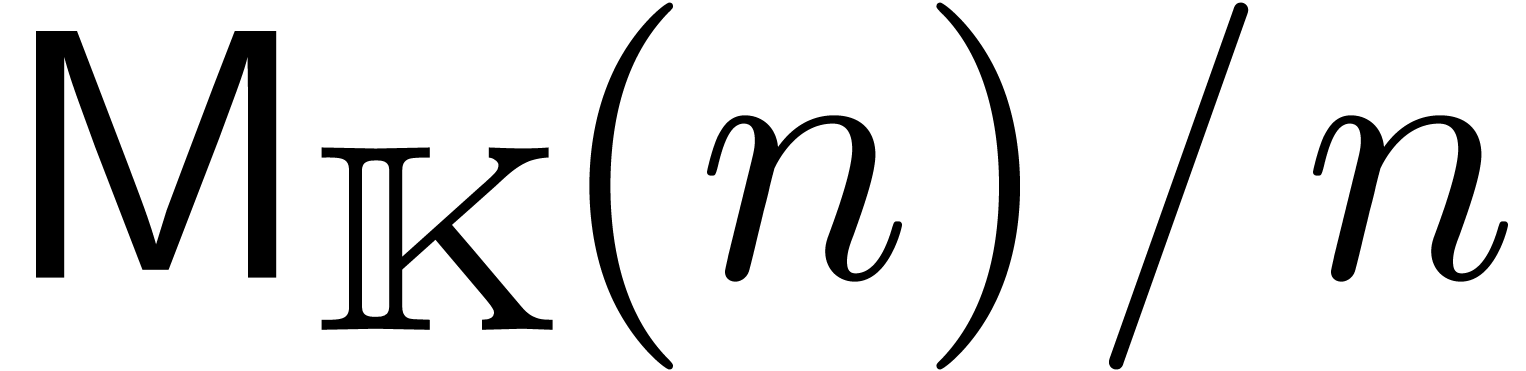

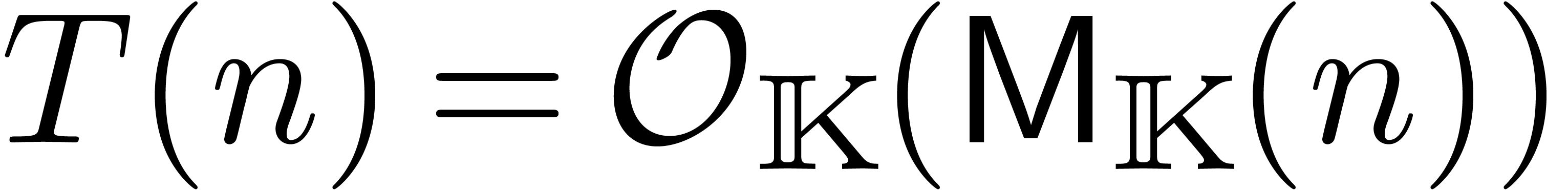

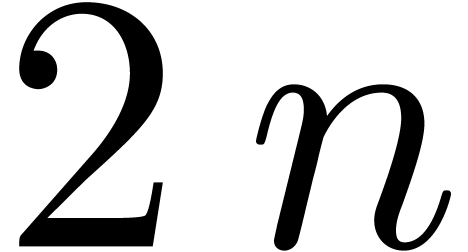

3.4.2Multiplication de matrices |

33 |

3.5Hiérarchie numérique |

34 |

4Arithmétique rapide |

37 |

4.1Rappels sur la complexité |

37 |

4.2Algorithmes sur les polynômes et sur les séries |

38 |

4.2.1Multiplication de polynômes |

38 |

4.2.2Multiplication de séries tronquées |

39 |

4.2.3Méthode de Newton |

39 |

4.2.4Évaluation multi-points |

40 |

4.3Calcul détendu |

41 |

4.3.1Principe du calcul détendue |

41 |

4.3.2Multiplication détendue naïve |

41 |

4.3.3Multiplication détendue par Karatsuba |

42 |

4.3.4Multiplication détendue rapide |

42 |

4.3.5Multiplication détendue super rapide |

43 |

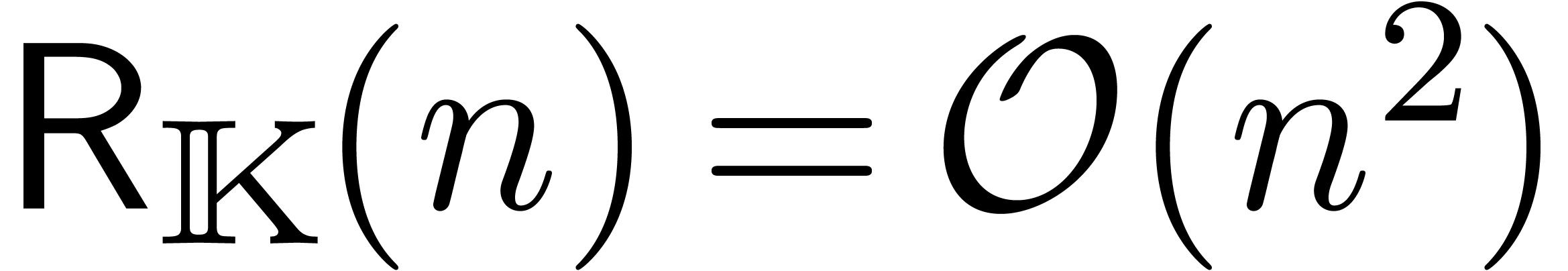

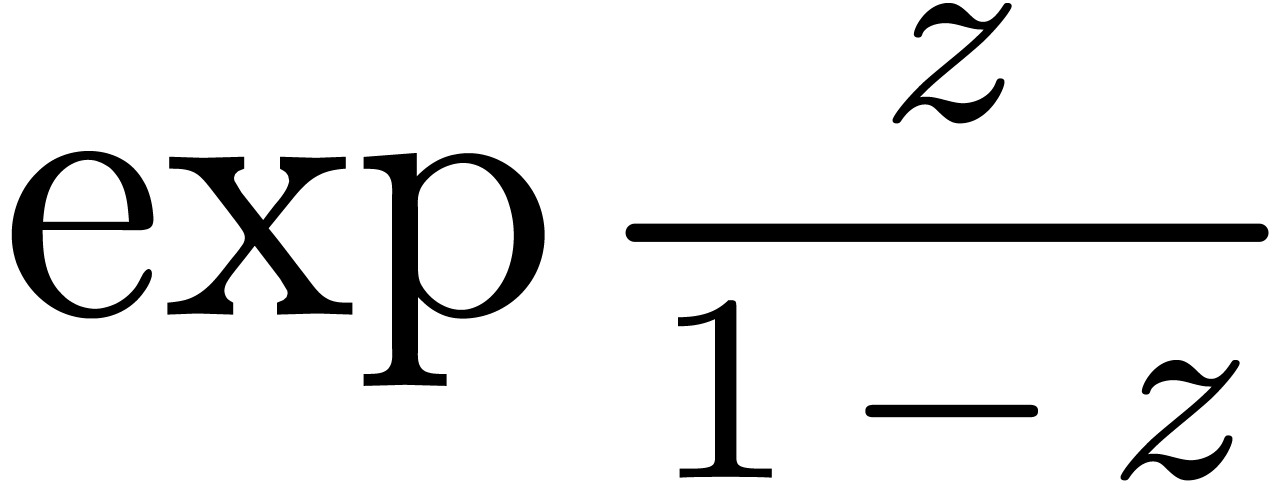

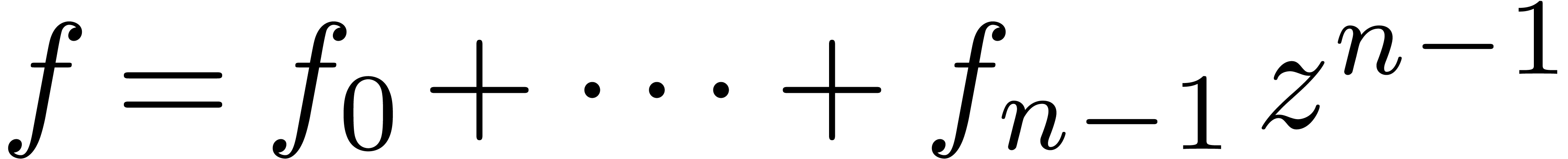

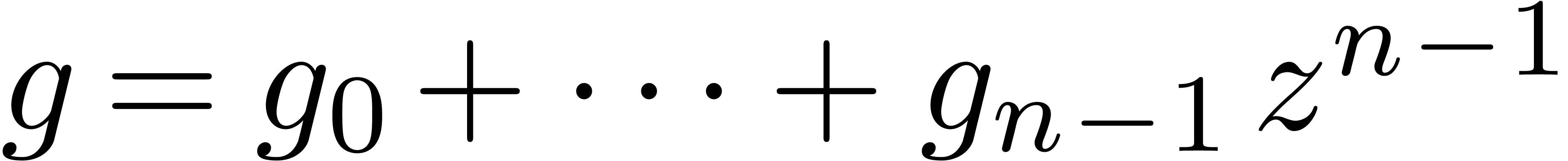

4.3.6Exemple : nombres de Bell exacts |

43 |

4.4Méthodes multi-modulaires |

44 |

4.4.1Principes et variantes |

44 |

4.4.2Évaluation rapide de dags |

46 |

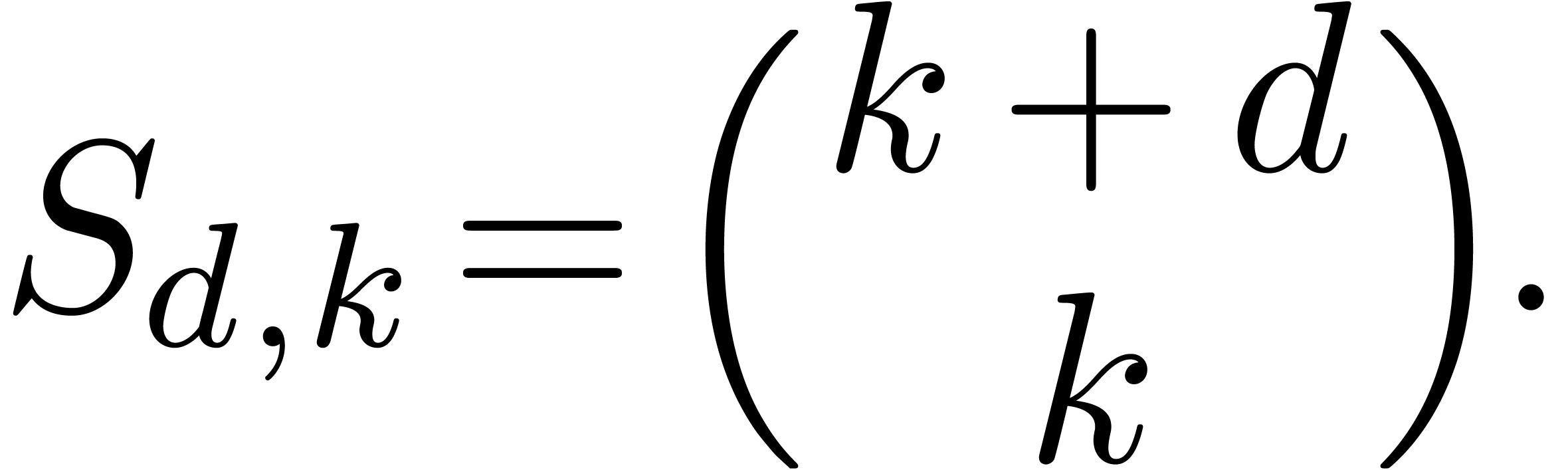

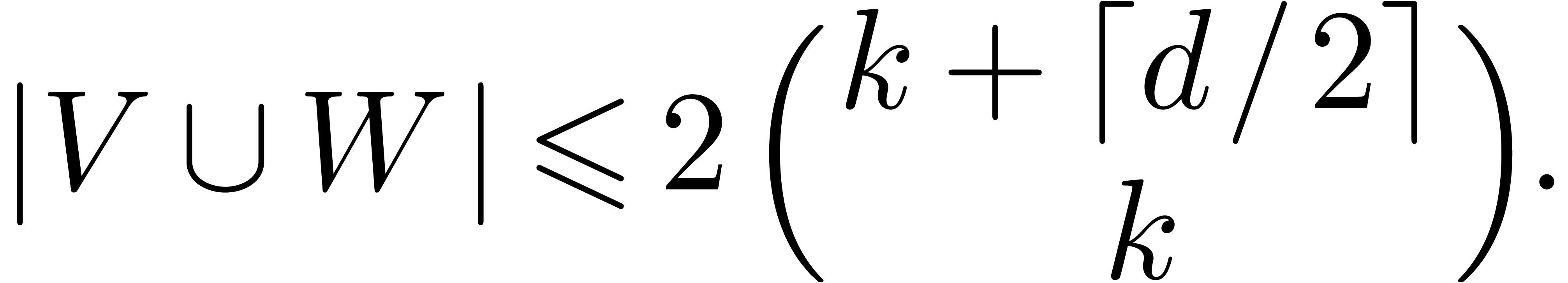

4.4.3Évaluation rapide de polynômes en plusieurs variables |

47 |

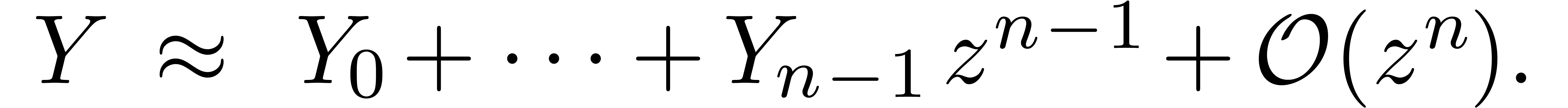

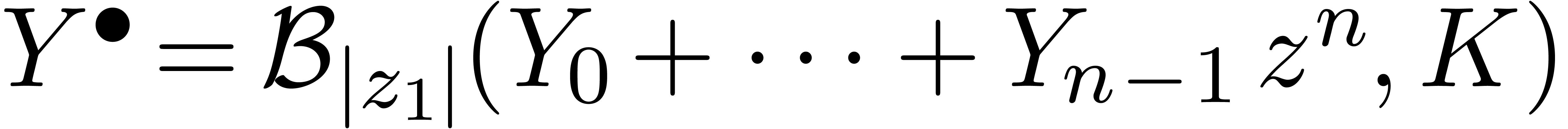

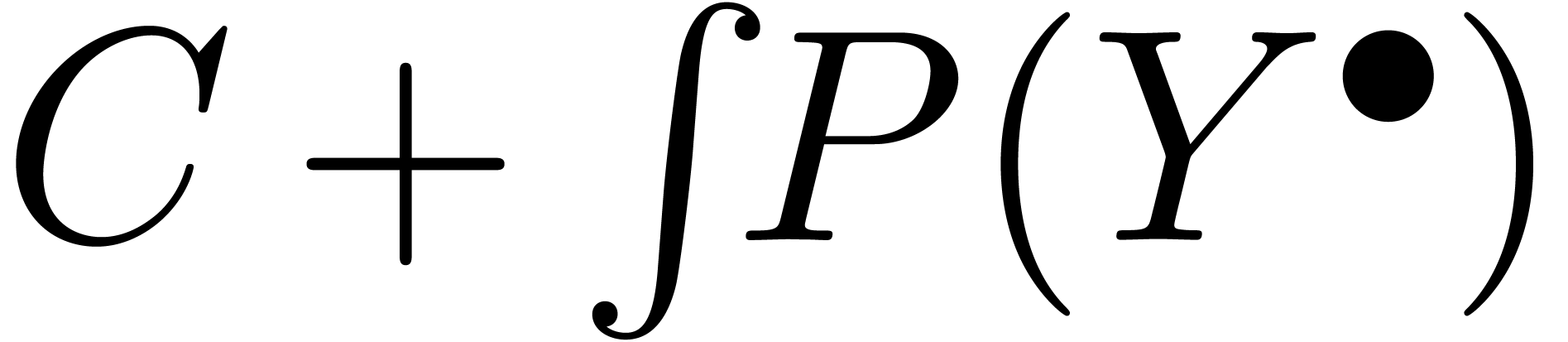

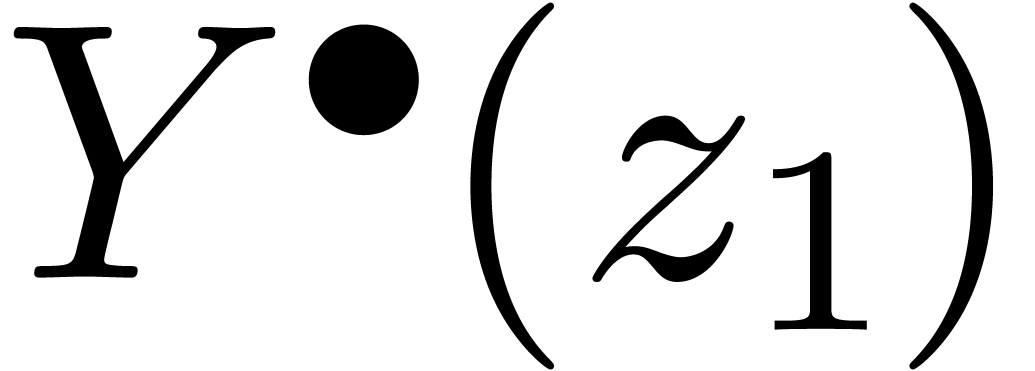

5Développements certifiés en série |

49 |

5.1Algorithmes rapides et numériquement stables |

49 |

5.1.1Instabilité numérique de la multiplication rapide |

49 |

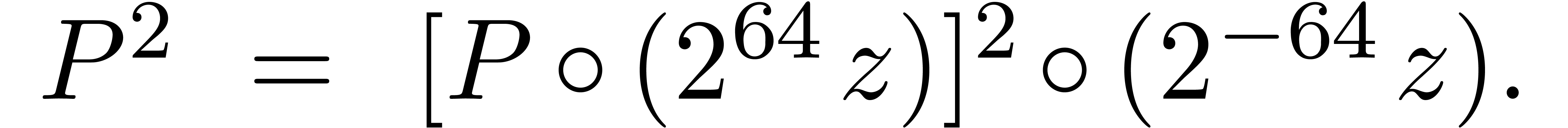

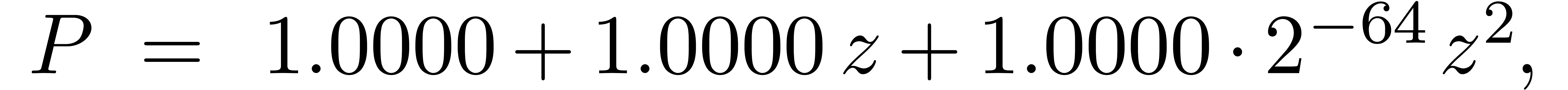

5.1.2Préconditionnement par mise à l'échelle |

49 |

5.1.3Calcul numériquement stable des nombres de Bell |

50 |

5.2Certification du calcul des coefficients |

50 |

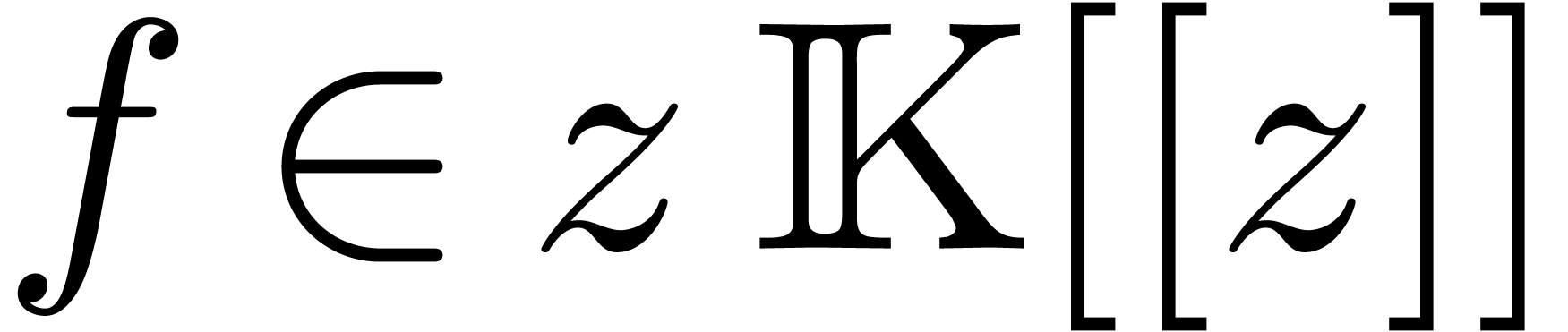

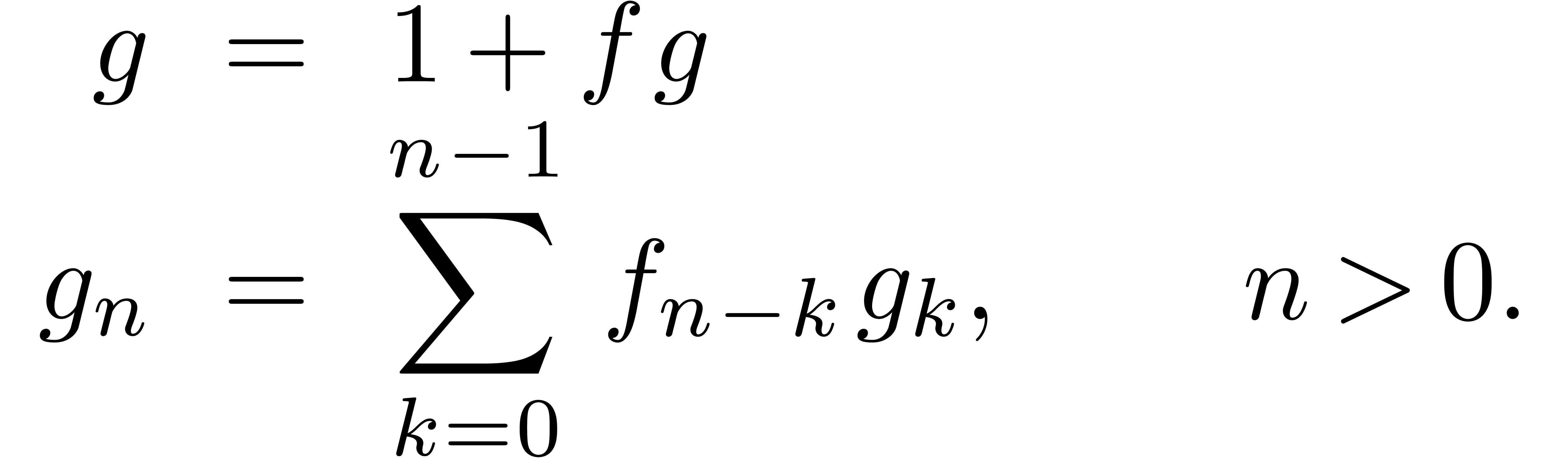

5.2.1Inversion |

50 |

5.2.2Exponentiation et résolution d'équations différentielles |

51 |

5.2.3Calcul certifié des nombres de Bell |

51 |

5.3Modèles de Taylor |

52 |

5.3.1Définition |

52 |

5.3.2Opérations |

52 |

5.3.3Généralisations |

53 |

5.4Réduction de la surestimation |

53 |

5.4.1L'idée sur un exemple |

53 |

5.4.2Application à la recherche de solutions réelles d'un système polynomial |

54 |

5.5Intégration de systèmes dynamiques |

54 |

5.5.1Algorithme de base |

55 |

5.5.2Effet d'enveloppement |

55 |

5.5.3Variante pour les modèles de Taylor |

56 |

5.5.4Qualité des estimations |

57 |

5.5.5Exemple dans |

58 |

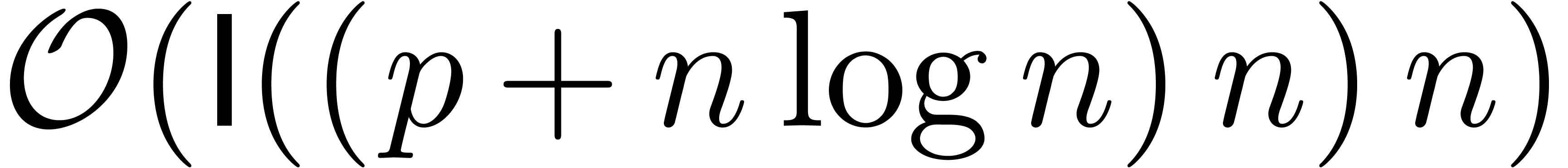

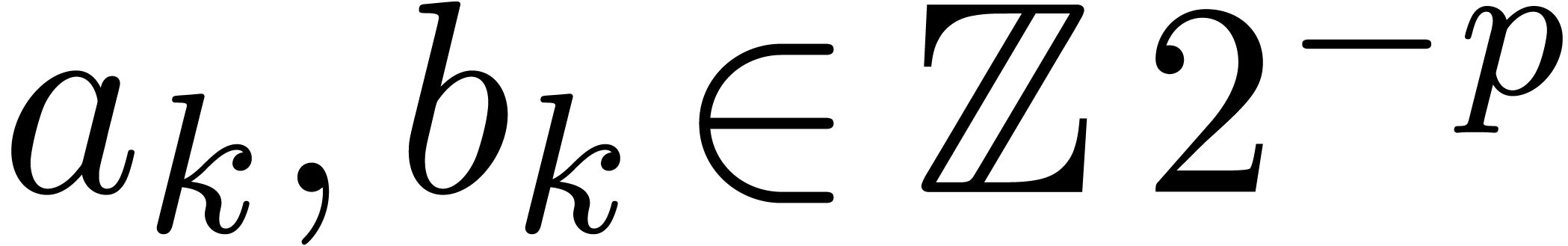

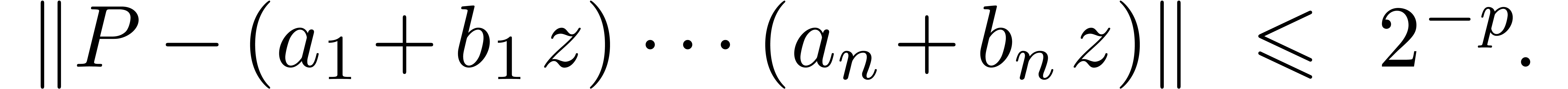

6Calcul des racines d'un polynôme en une variable |

61 |

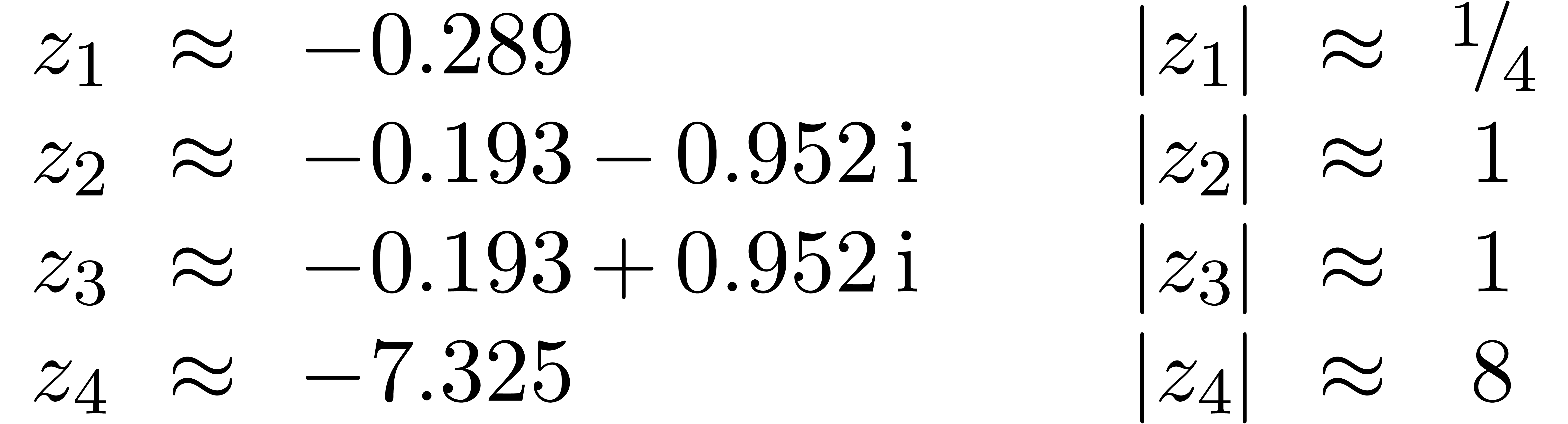

6.1Exemples pour différents types de polynômes |

62 |

6.1.1Polynômes tirés au hasard |

62 |

6.1.2Polynômes avec zéros de grandes multiplicités |

63 |

6.1.3Expérience à propos du conditionnement |

64 |

6.1.4Séries formelles tronquées |

65 |

6.2Quelques méthodes numériques classiques |

66 |

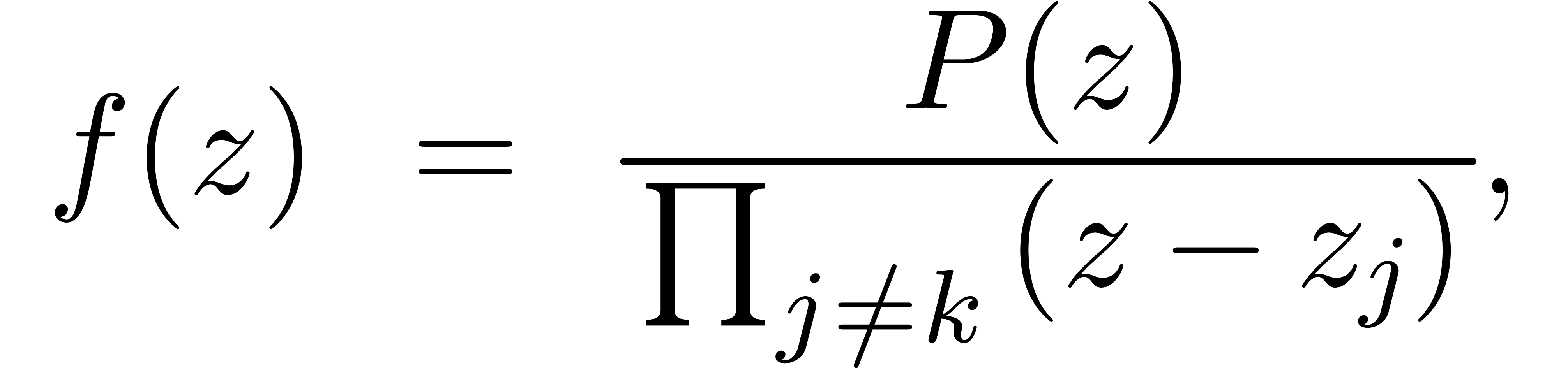

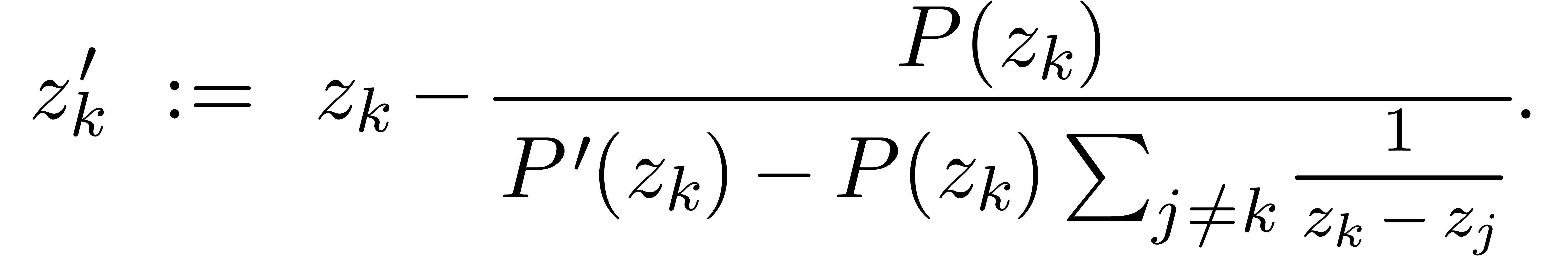

6.2.1Itération d'Aberth |

66 |

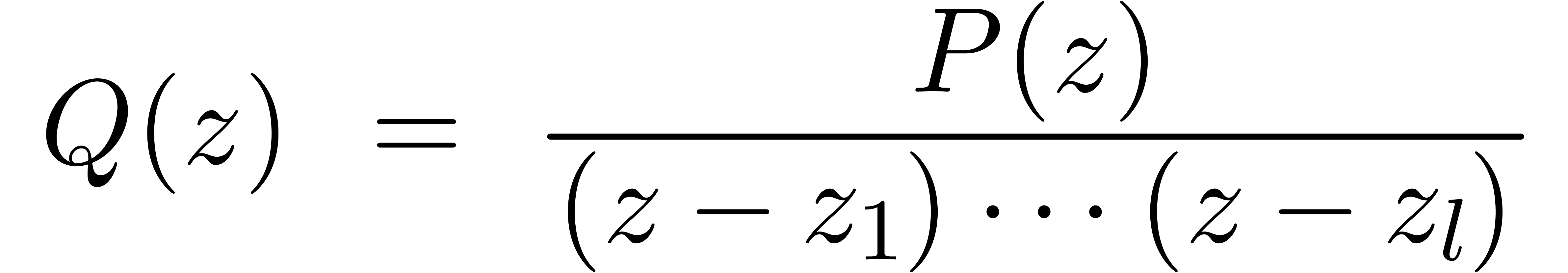

6.2.2Méthode par homotopie |

66 |

6.2.3Transformation de Graeffe |

66 |

6.3Polygone numérique de Newton |

67 |

6.3.1Exemple d'un polygone numérique de Newton |

67 |

6.3.2Évaluation du polynôme et polygone numérique de Newton |

68 |

6.4Stabilité numérique et efficacité : un mariage difficile |

69 |

6.5Évaluation multi-point rapide |

70 |

6.6Certification des racines |

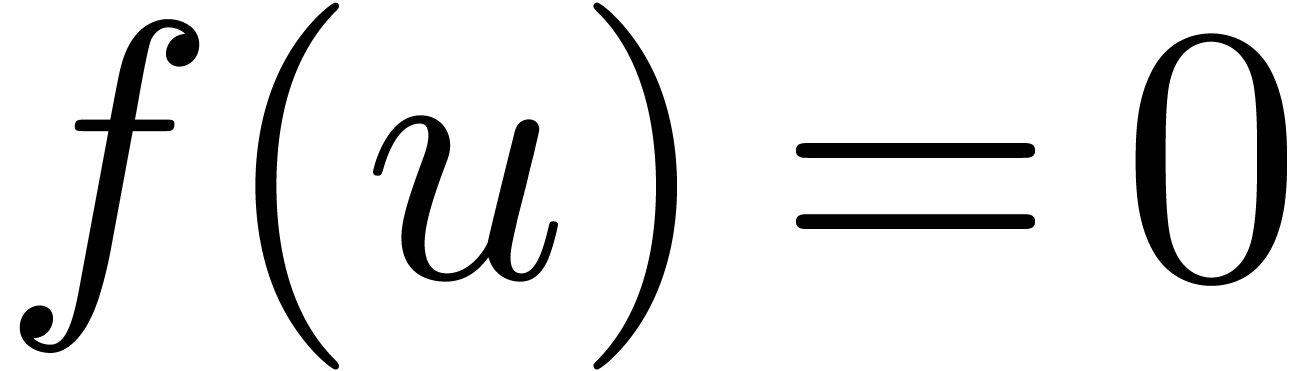

70 |

6.6.1Racines simples |

70 |

6.6.2Racines multiples |

71 |

7Méthodes par homotopie |

73 |

7.1Introduction |

73 |

7.1.1Historique |

73 |

7.1.2Première difficulté : solutions partant vers l'infini |

74 |

7.1.3Deuxième difficulté : solutions multiples |

74 |

7.2Algorithmes de suivi de chemin |

75 |

7.2.1Cas purement numérique |

75 |

7.2.2Certification naïve par Krawczyk-Rump uniforme |

76 |

7.2.3Certification plus précise par modèles de Taylor |

76 |

7.3Racines multiples et suivi de troupeaux de solutions |

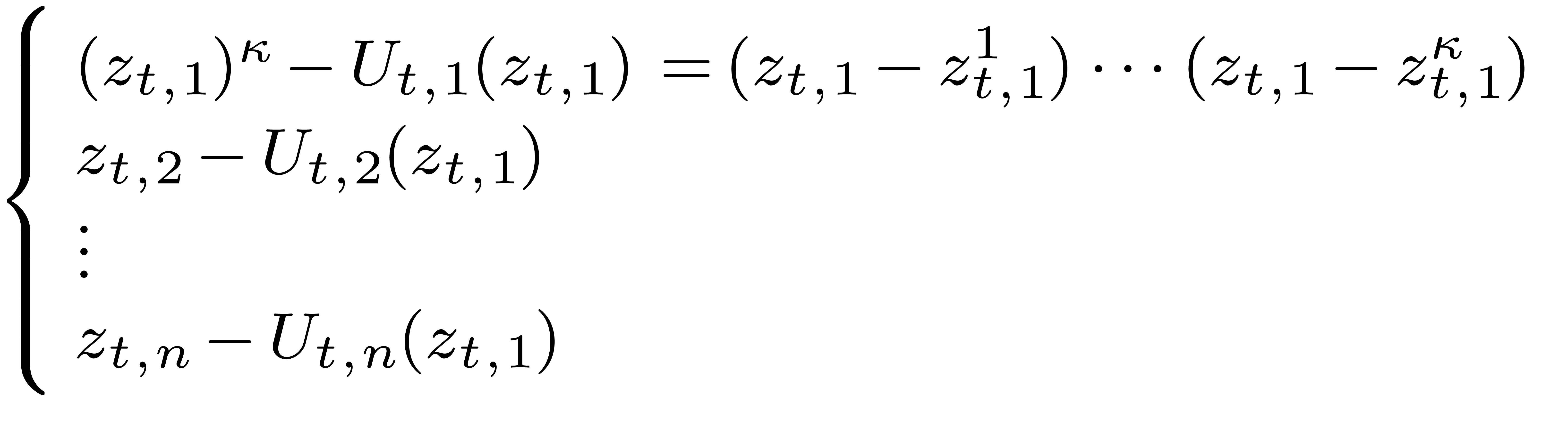

77 |

7.3.1La méthode sur un exemple |

77 |

7.3.2Le cas général |

78 |

7.4Comparaisons avec d'autres méthodes |

78 |

7.4.1Un exemple dans |

78 |

7.4.2Discussion et perspectives |

80 |

Références |

83 |

Ce cours est une adaptation des « slides » que j'avais présentés à mon cours sur le calcul analytique aux Journées Nationales de Calcul Formel, en novembre 2011 à Luminy. J'ai rajouté un peu de matériel supplémentaire et quelques explications plus détaillées par rapport à la présentation originale, sans toutefois avoir cherché la perfection d'un cours sur papier habituel.

Pourquoi un cours sur le calcul analytique ? Traditionnellement, on choisit le calcul formel pour la beauté du calcul symbolique ! Or, les techniques du calcul formel admettent de nombreuses applications en analyse, et le calcul numérique peut parfois permettre une résolution plus efficace ou directe de problèmes en calcul formel. Toutefois, quand j'ai commencé à m'intéresser à des problèmes plus analytiques, il me manquait la culture nécessaire en analyse calculable et en arithmétique d'intervalles. Ce cours cherche à exposer les techniques les plus utiles de ces domaines, tout en gardant le lien avec le calcul formel en filigrane.

Le document inclut un certain nombre de sessions du système

Remerciement. Merci à Jérémy Berthomieu pour ses commentaires sur le premier jet du manuscrit.

Le projet

L'approche du calcul formel est particulièrement bien

adaptée pour des objets de nature algébrique ou

combinatoire — algèbre linéaire, élimination

polynomiale, énumération combinatoire, théorie de

Galois, etc. En revanche, les systèmes numériques

classiques sont beaucoup plus efficaces pour des problèmes plus

analytiques, comme l'intégration d'équations

différentielles. Malheureusement, les systèmes

numériques actuels opèrent principalement en

précision fixe et incorporent peu d'outils pour certifier les

résultats. La session suivante en

maple> 1.000000000000000000000001 - 1;0.

Il est donc tentant de transposer l'esprit de calcul exact et garanti du calcul formel à l'analyse. Or le calcul formel et le calcul numérique sont encore dans une grande mesure des mondes distincts. D'une part, il y a peu d'intersections quant aux algorithmes de base utilisés (algèbre linéaire, polynômes, séries, etc.). D'autre part, il n'existe pas d'environnement de programmation convivial qui soit adapté aux deux mondes. En effet, les interactions actuelles se limitent surtout à des interfaces de type « boîte noire ».

Le calcul analytique se situe à la confluence de plusieurs domaines. L'analyse calculable, qui sera discutée dans le chapitre 2, propose une fondation réaliste au regard des architectures existantes d'ordinateurs. Un deuxième point théorique important concerne le développement d'algorithmes numériques certifiés, poursuivant des travaux classiques sur l'arithmétique des intervalles. Dans le chapitre 3, nous exposerons une variante de cette théorie : l'arithmétique de boules.

Évidemment, dans un système de calcul analytique, il est impératif de pouvoir approcher des nombres réels aussi précisément que nécessaire, donc de travailler en précision multiple. Ceci conduit à une pénalité énorme en efficacité par rapport à l'analyse numérique classique, et il convient de réduire cette pénalité autant que possible. Dans le chapitre 4, nous rappelons quelques résultats classiques en théorie de complexité. Dans les derniers chapitres 5, 6 et 7, nous combinons les différentes techniques en les appliquant à l'intégration de systèmes dynamiques et à la résolution polynomiale.

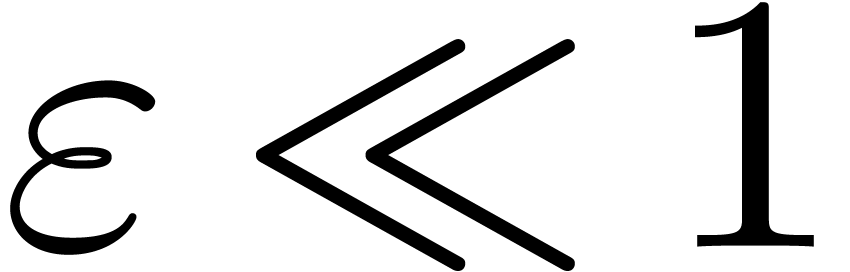

Pendule

Pour  ,

,  ,

,  ,

calculer

,

calculer  (ou

(ou  )

avec

)

avec

Systèmes dynamiques plus généraux

Soit  et considérons

et considérons

Pour  ,

,  et

et  , calculer (si possible)

, calculer (si possible)

avec

avec

Fonctions spéciales

Fonctions élémentaires  ,

etc.

,

etc.

Fonctions holonomes :  ,

,

.

.

Autres :  , fonctions

thêta, fonctions de Matthieu, etc.

, fonctions

thêta, fonctions de Matthieu, etc.

Remarque 1.1. Il y a de nombreux autres exemples de fonctions

spéciales intéressantes en théorie de nombres.

Certaines de ces fonctions sont différentiellement

algébriques comme ci-dessus. D'autres, comme  ou

ou  se calculent par transformées

intégrales. Voir aussi le cours de Karim Belabas pour plus de

renseignements et l'utilité du calcul analytique dans ce domaine.

se calculent par transformées

intégrales. Voir aussi le cours de Karim Belabas pour plus de

renseignements et l'utilité du calcul analytique dans ce domaine.

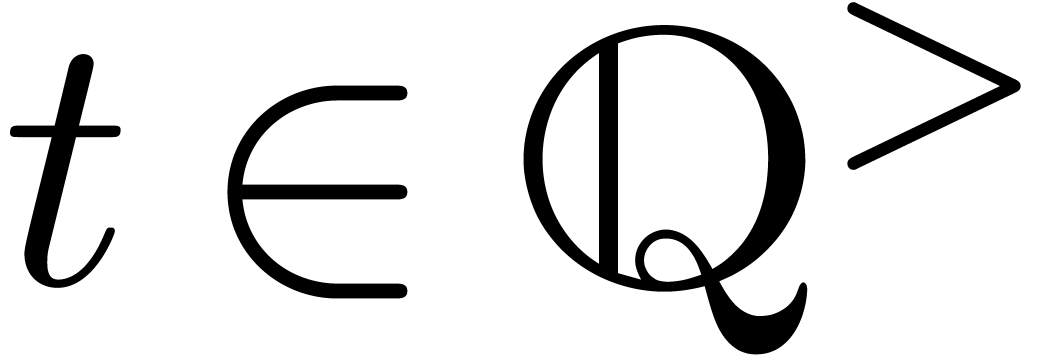

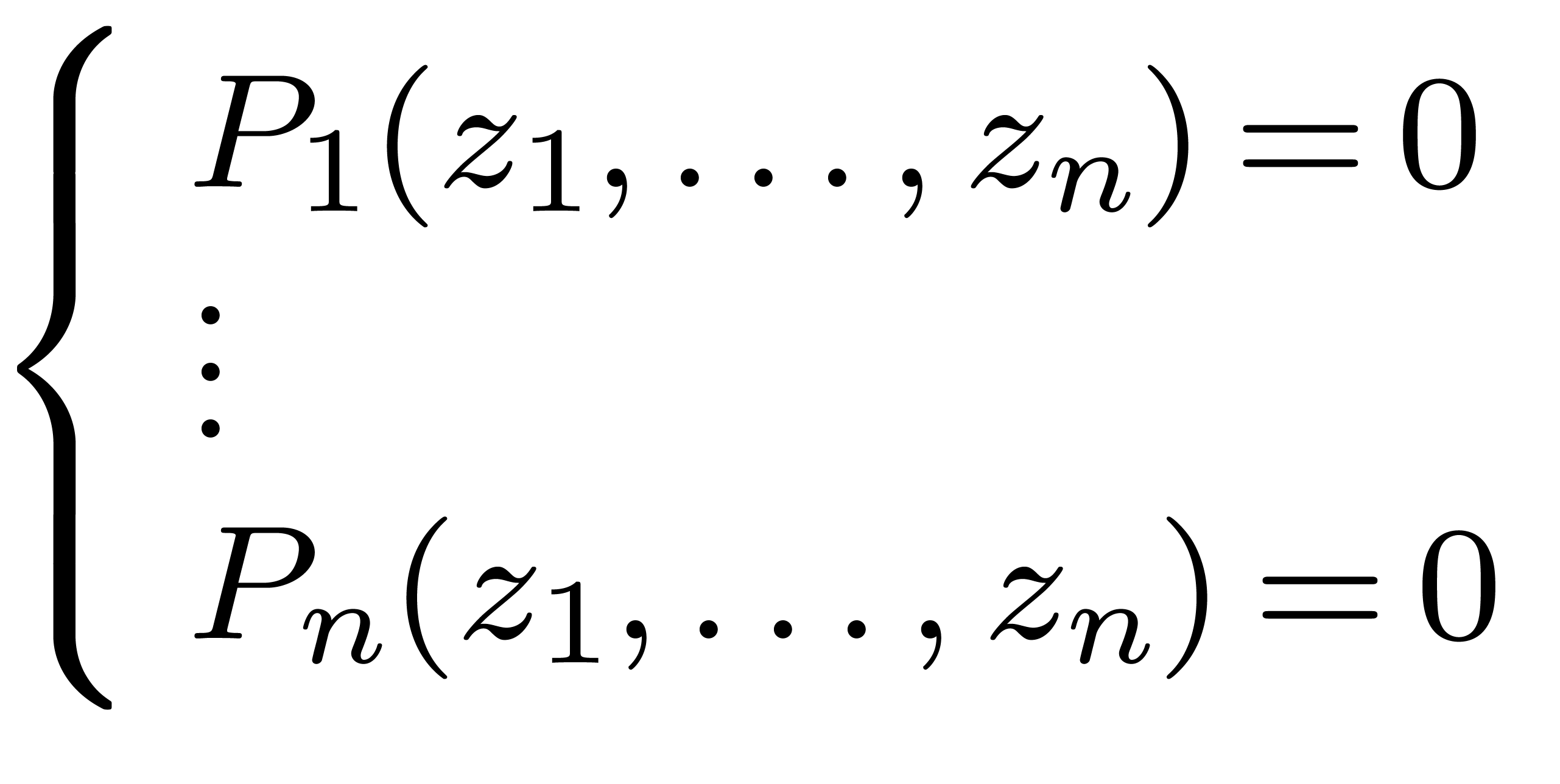

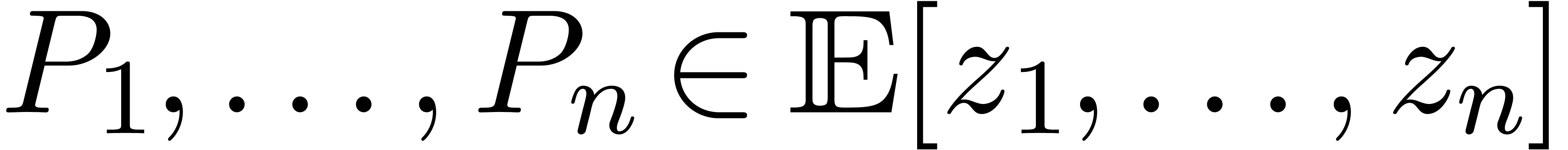

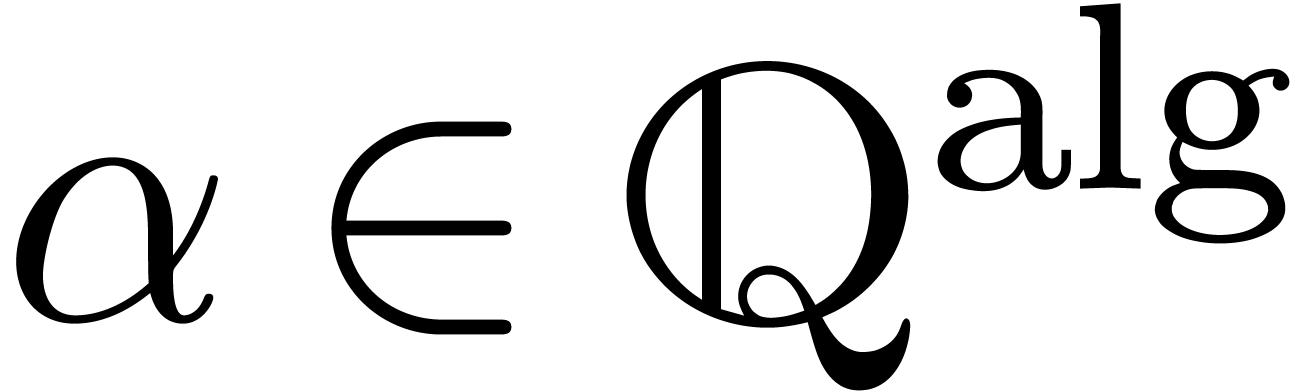

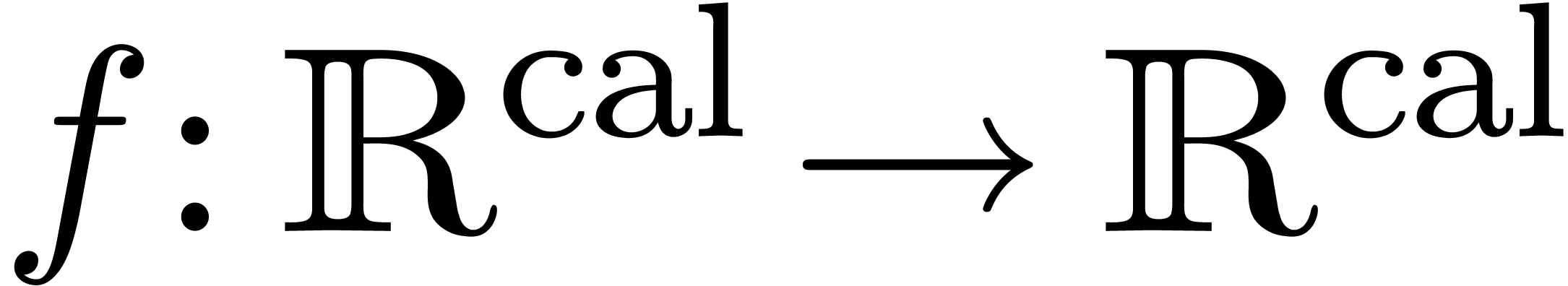

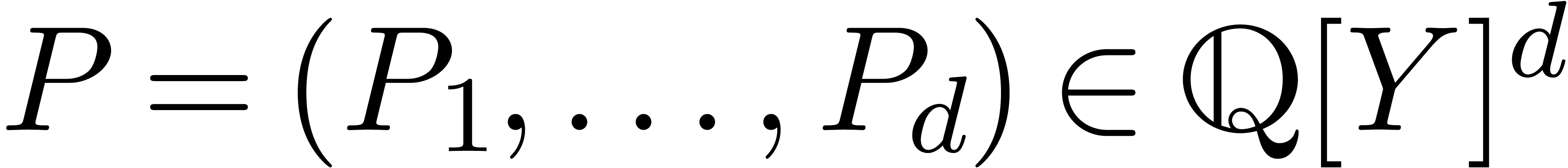

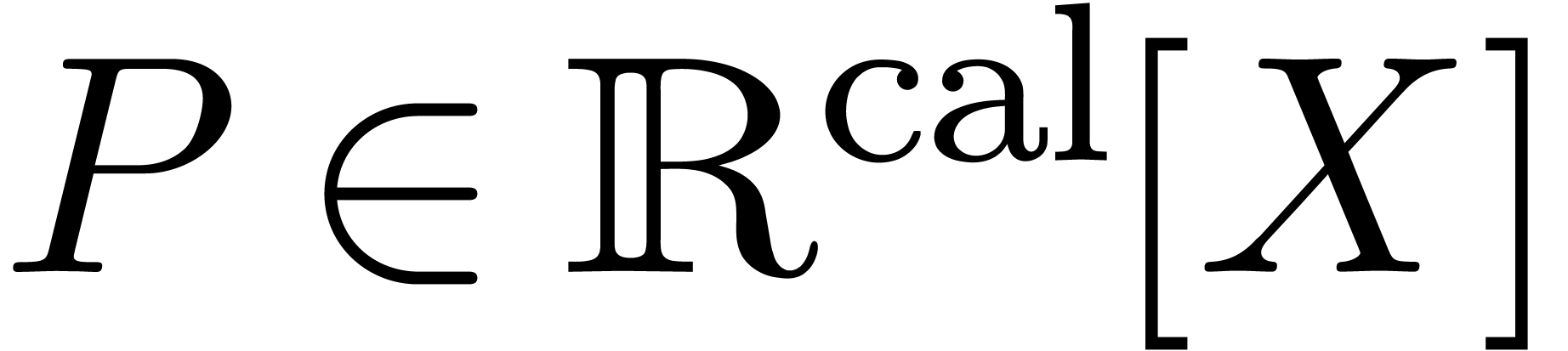

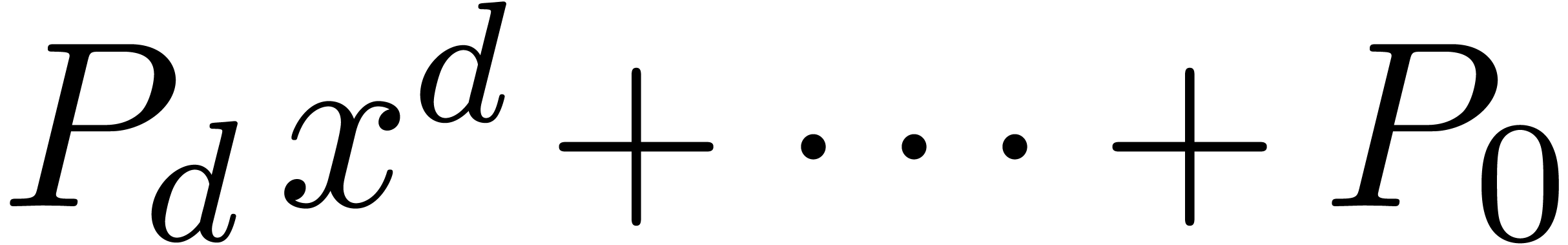

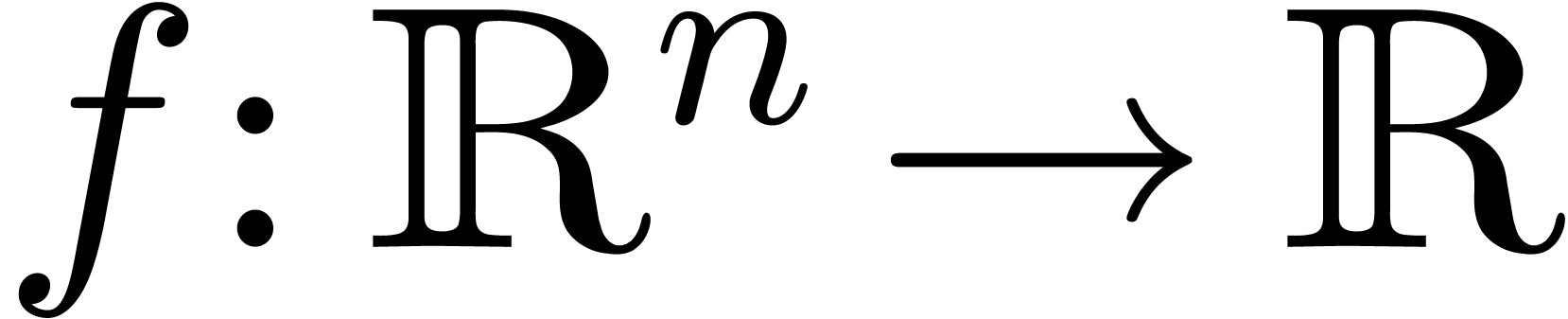

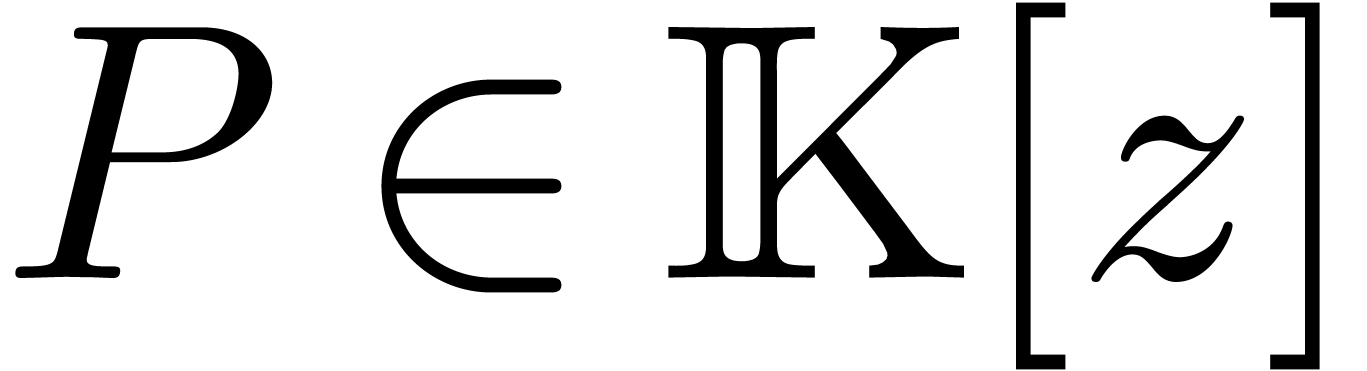

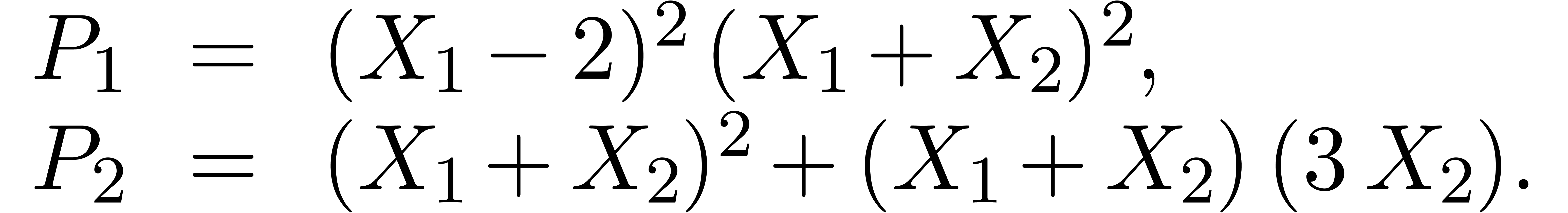

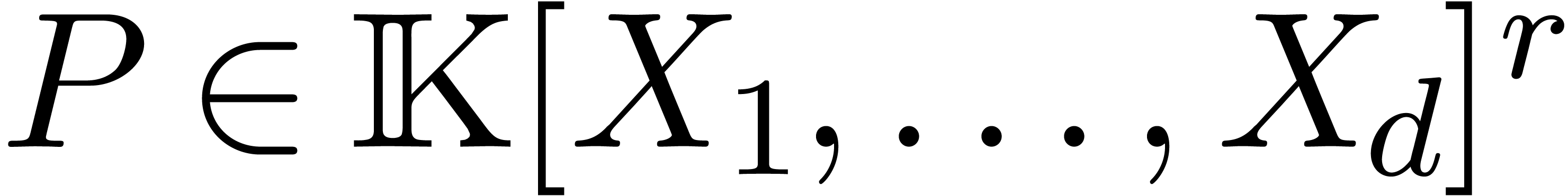

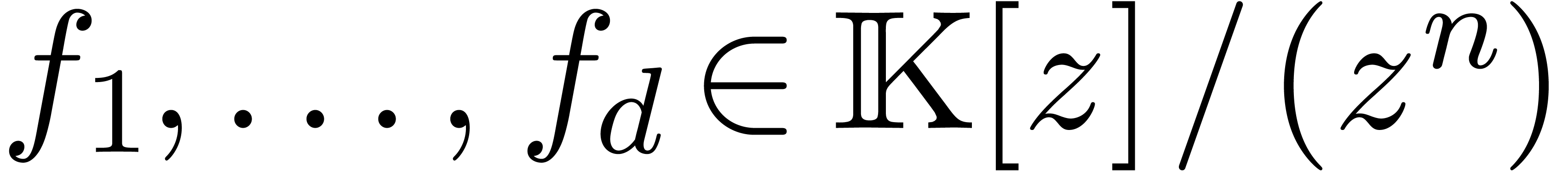

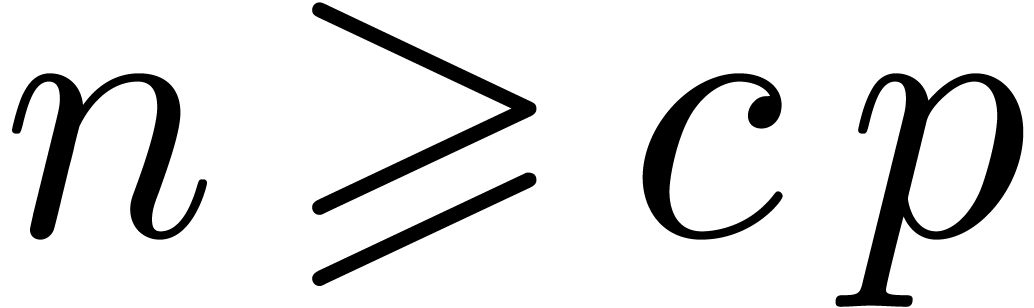

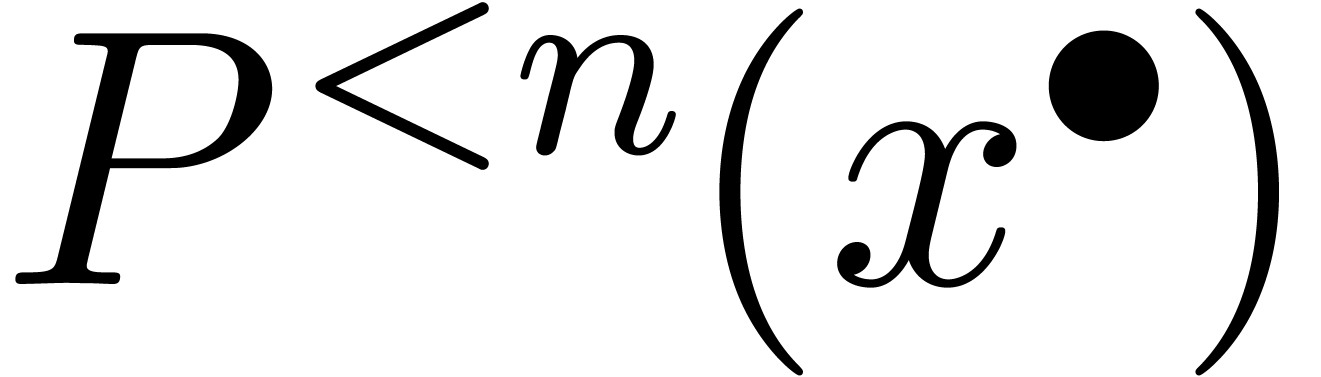

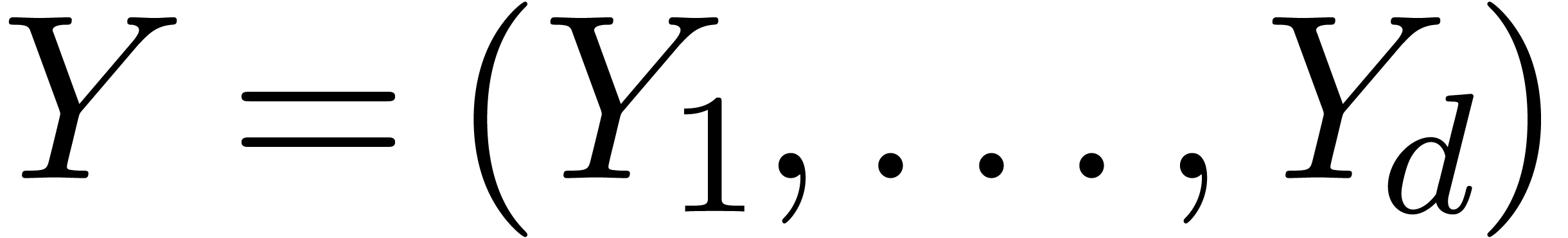

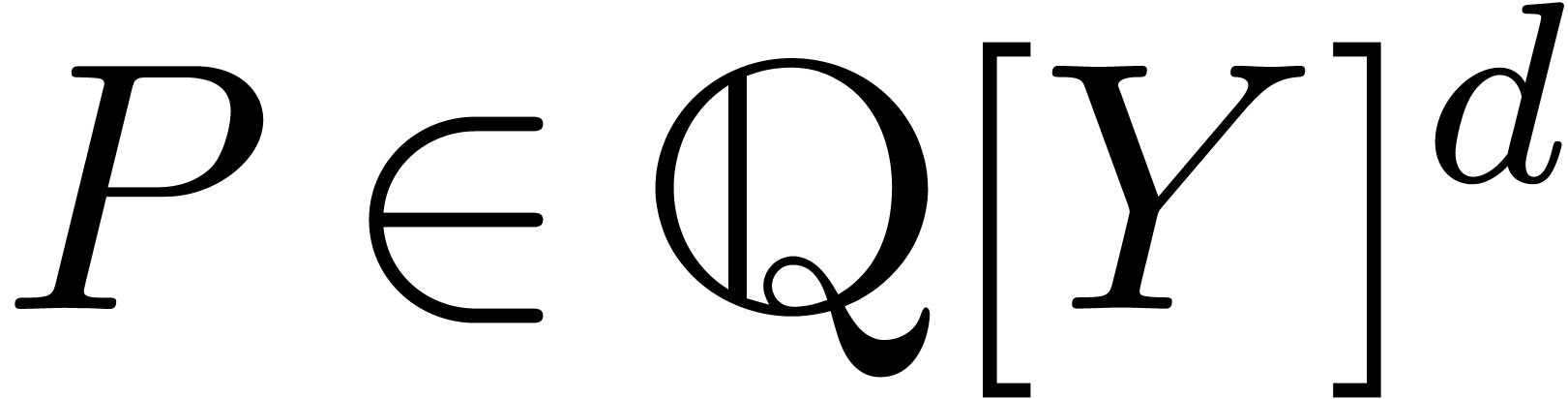

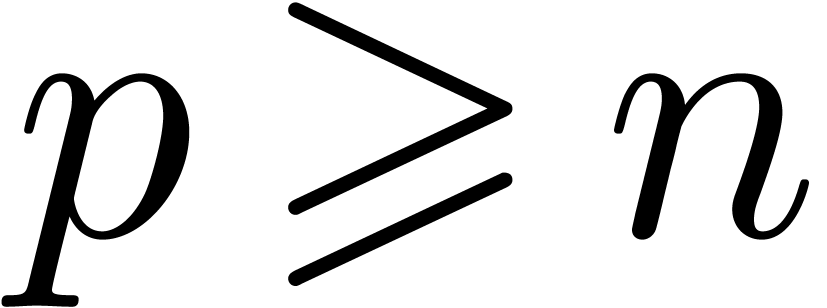

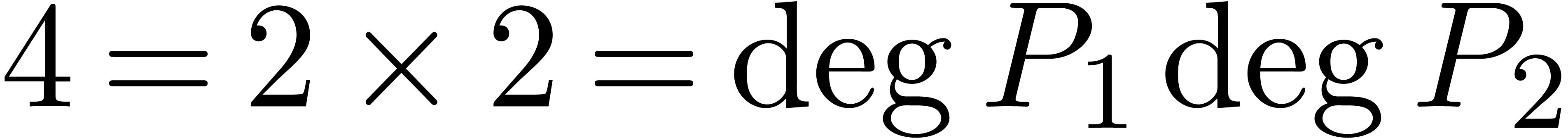

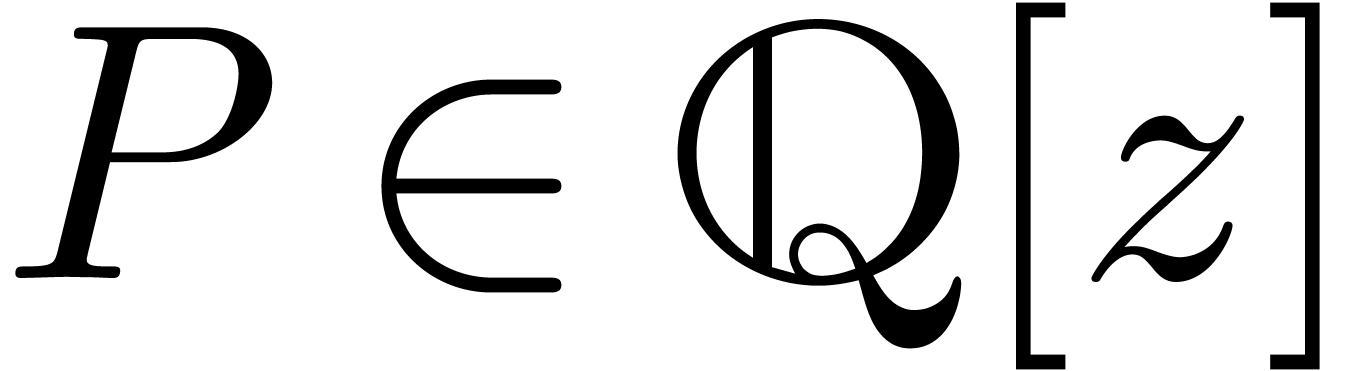

Étant donné un système zéro-dimensionnel

avec  , trouver les

zéros “dans

, trouver les

zéros “dans  ”.

Plus précisément et ici encore, il faudrait pouvoir

approcher les zéros avec autant de précision que

souhaitée.

”.

Plus précisément et ici encore, il faudrait pouvoir

approcher les zéros avec autant de précision que

souhaitée.

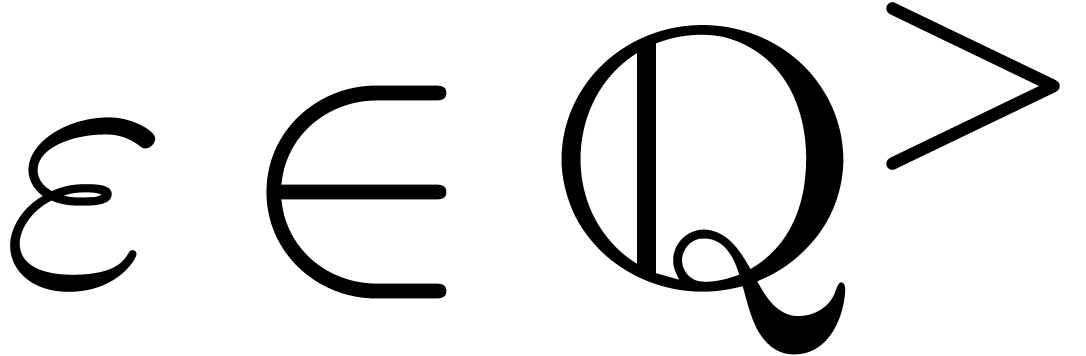

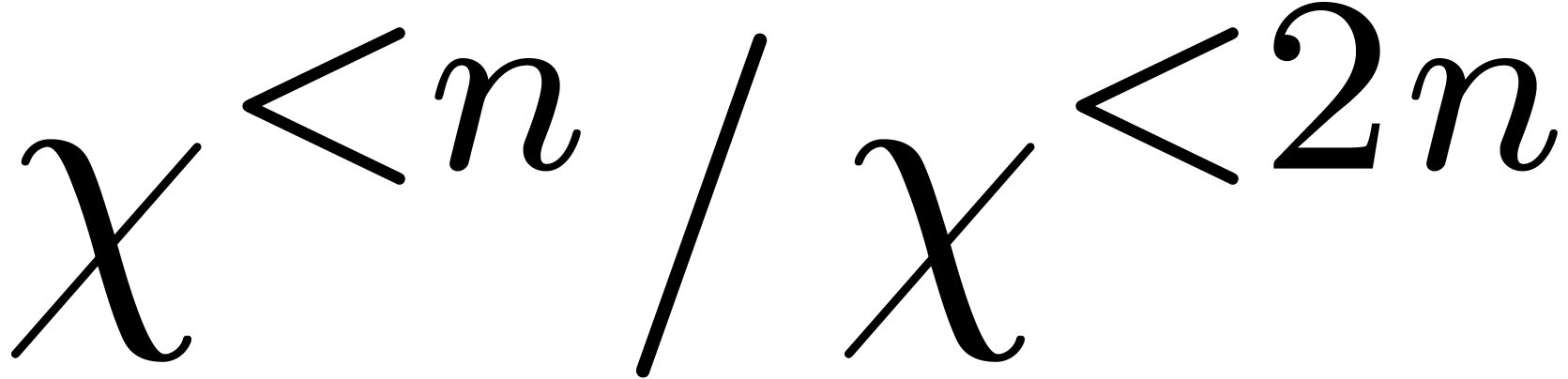

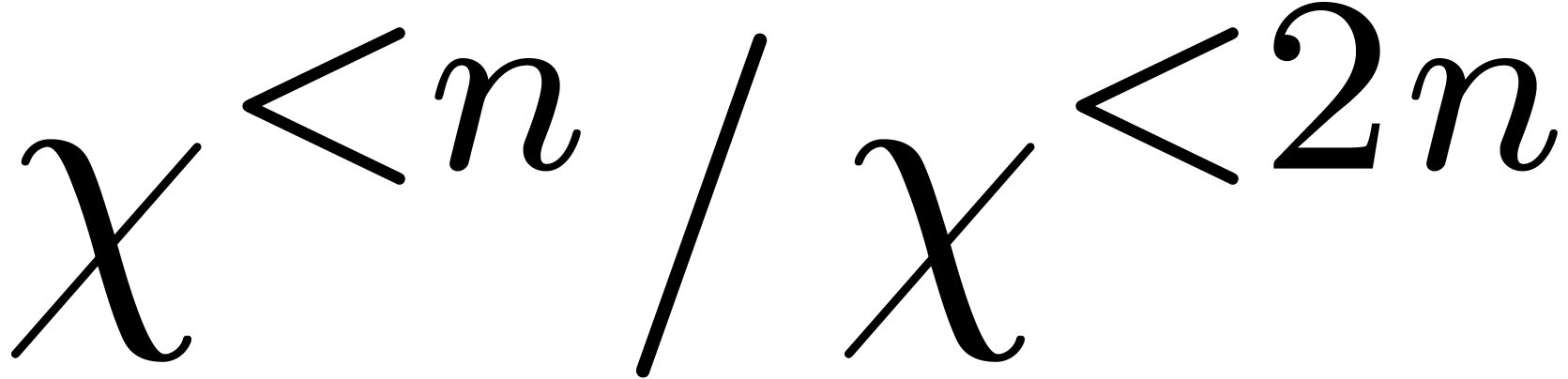

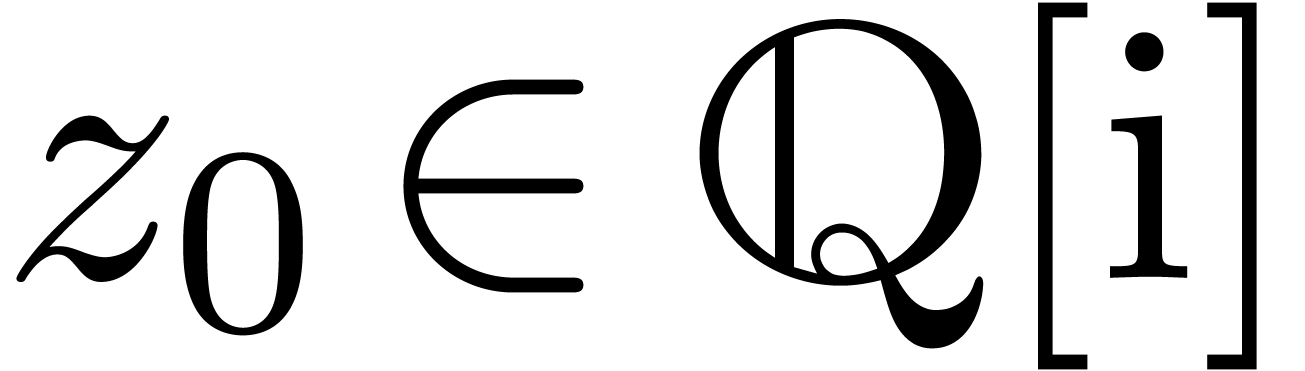

Variante : prendre  ,

où

,

où  désigne l'ensemble des

“constantes exp-log”, construits à partir de

désigne l'ensemble des

“constantes exp-log”, construits à partir de  en utilisant les opérations

en utilisant les opérations  et

et  .

.

Variante : chercher les racines dans  .

.

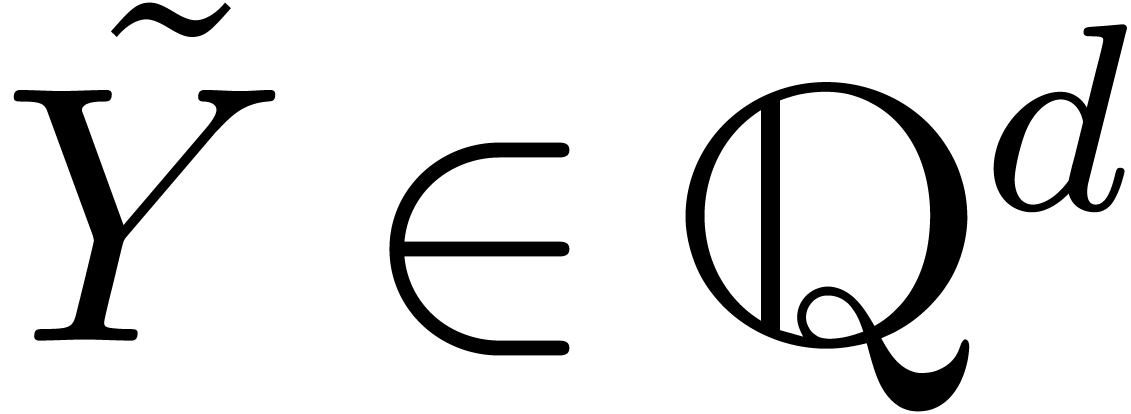

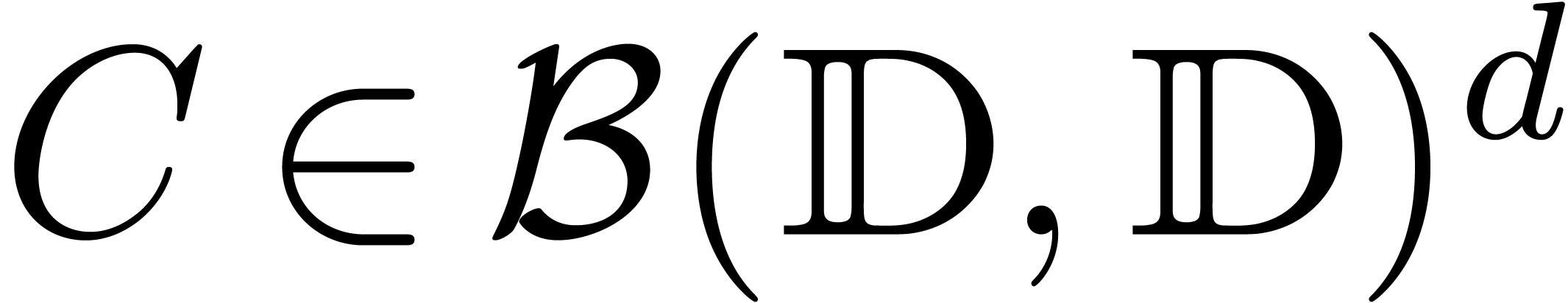

avec  zéro-dimensionnel en

zéro-dimensionnel en  pour

pour  et

et  fini.

fini.

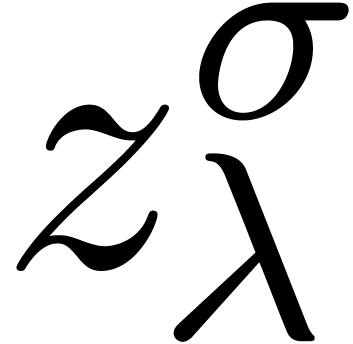

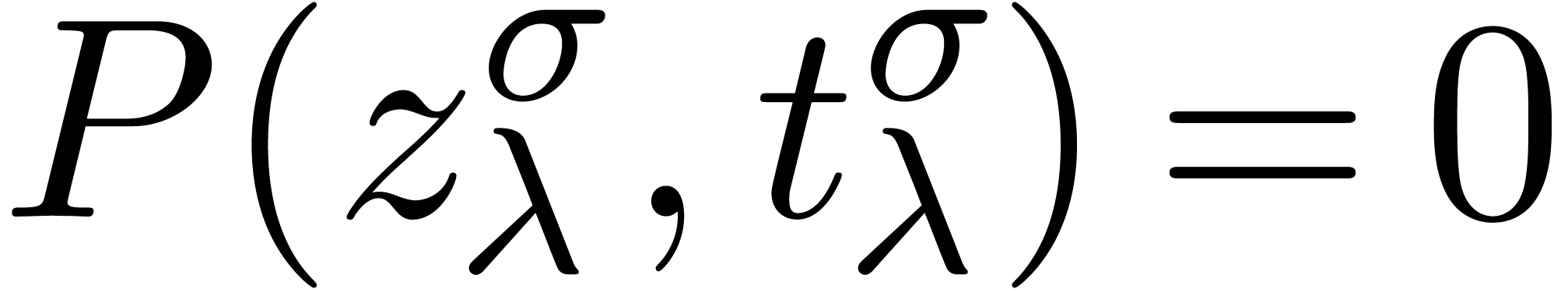

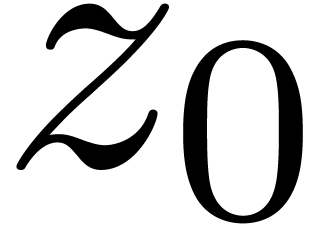

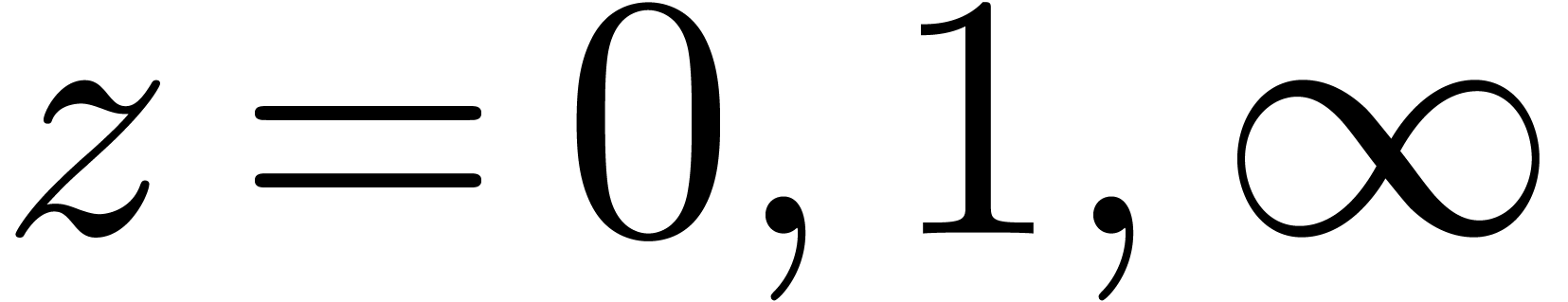

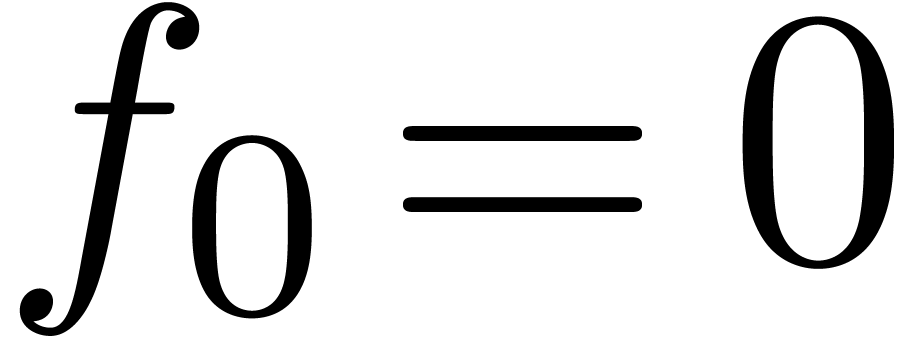

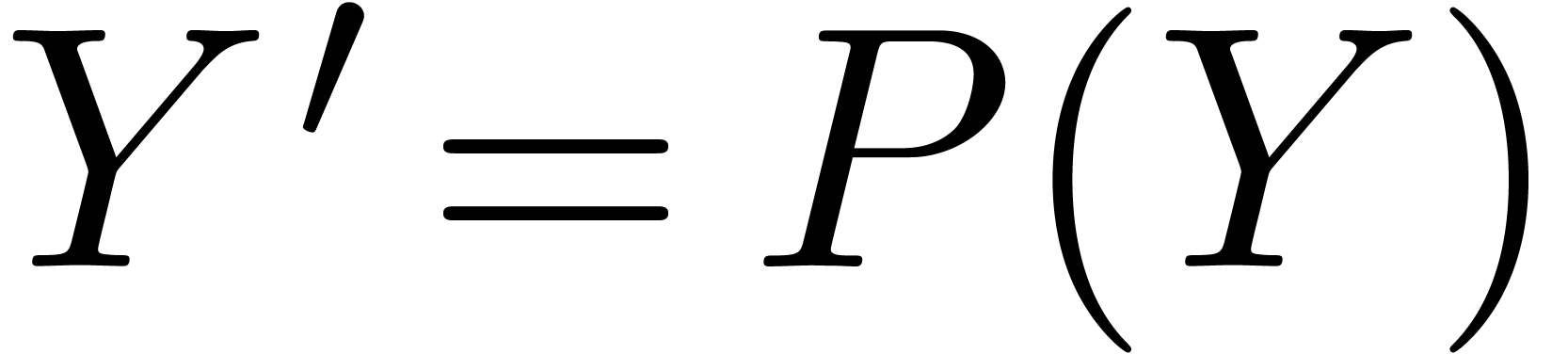

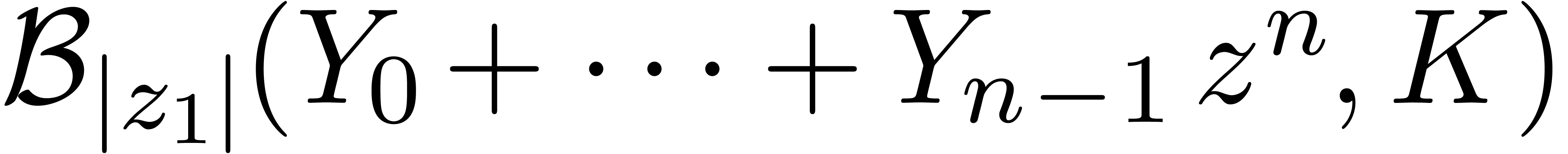

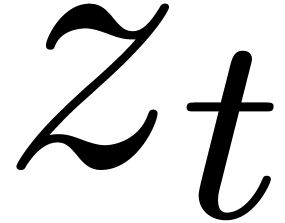

Étant donné  avec

avec  et un chemin

et un chemin  qui évite

qui évite  , calculer le chemin

, calculer le chemin  avec

avec  pour tout

pour tout  .

.

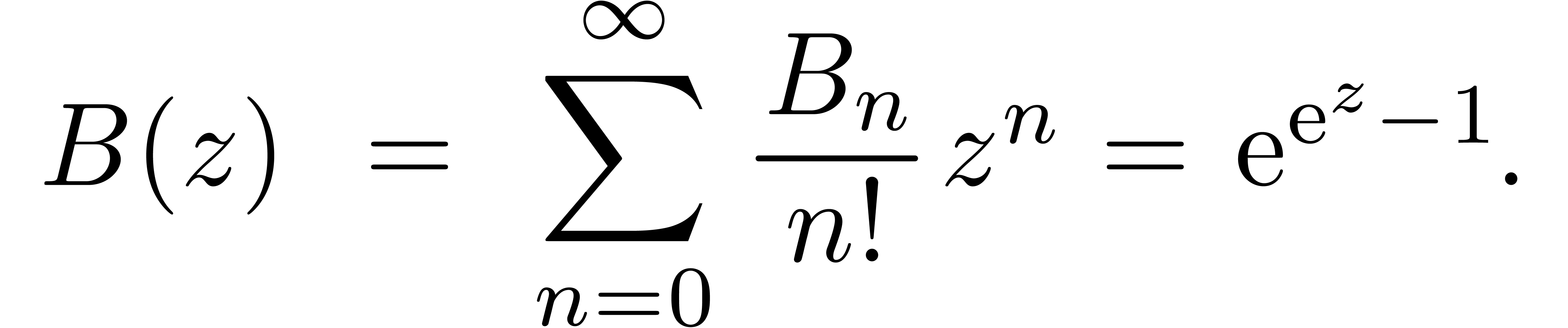

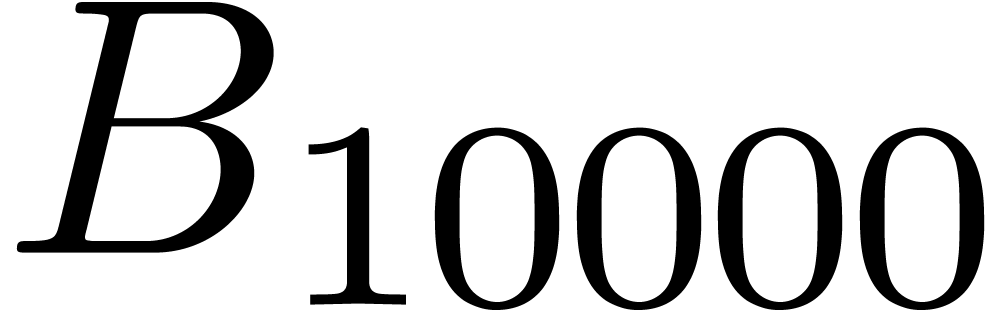

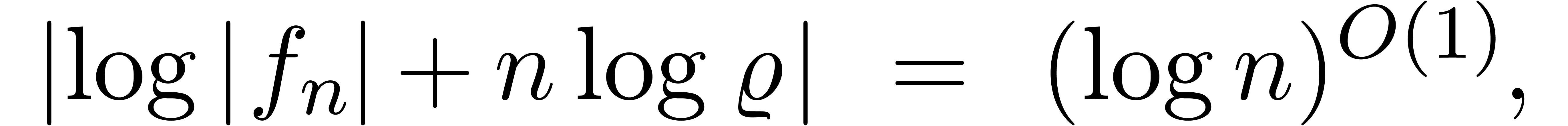

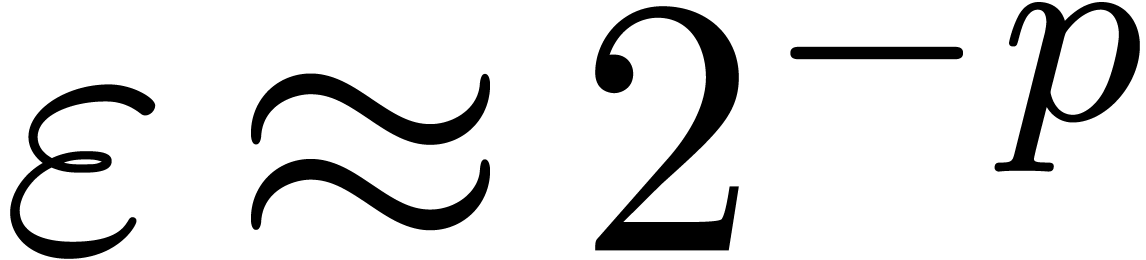

Problème 1 : calculer  avec une erreur relative de

avec une erreur relative de  .

.

Problème 2 : trouver automatiquement le développement asymptotique

Problème 3 : pour  ,

trouver une constante explicite pour le

,

trouver une constante explicite pour le  .

.

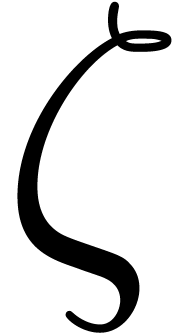

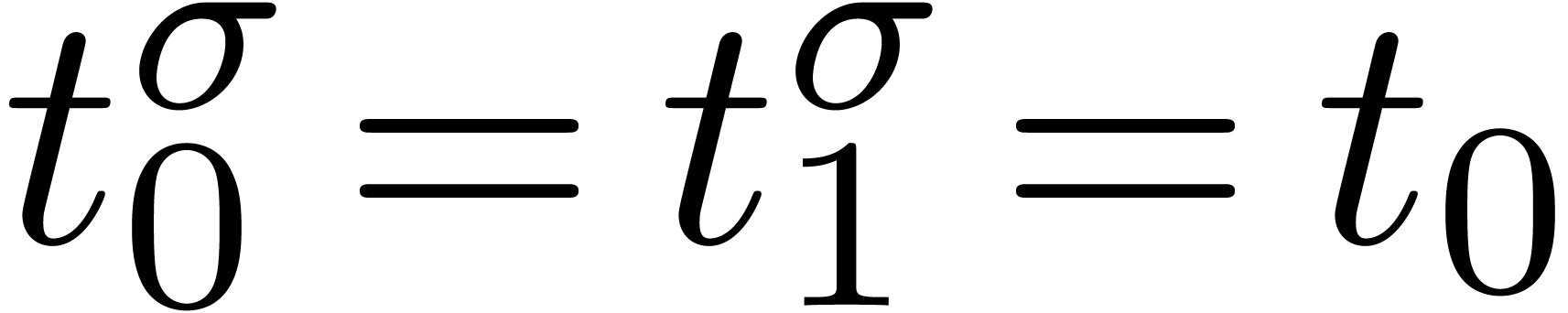

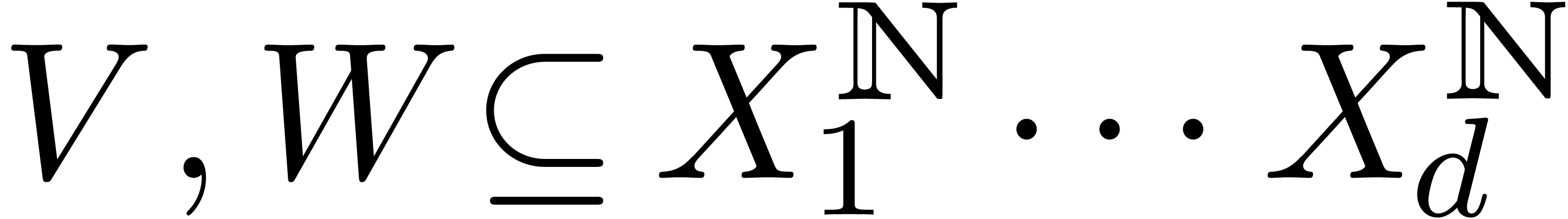

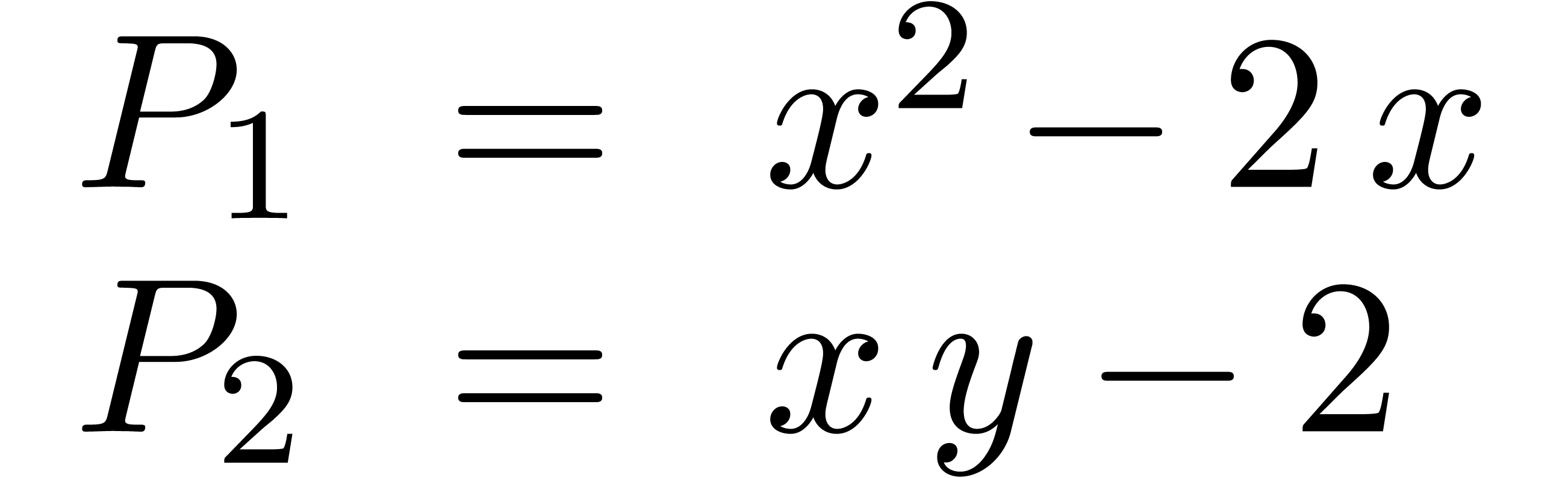

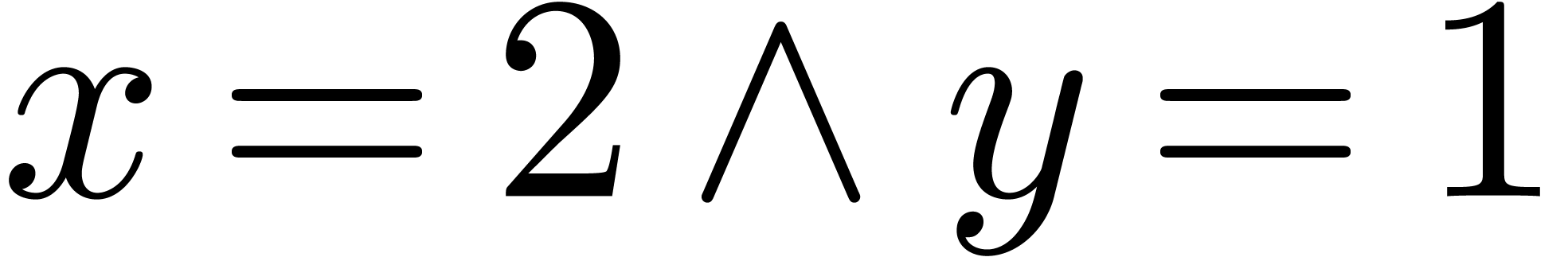

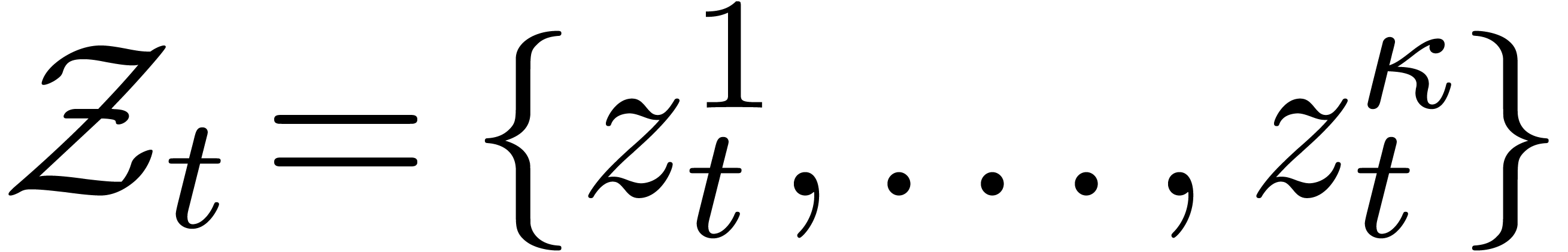

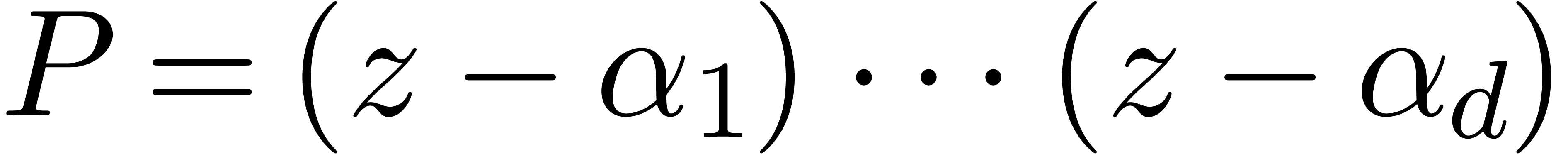

La technique incontestablement la plus importante en calcul analytique est la déformation. Une application astucieuse est la résolution de systèmes polynomiaux par homotopie. Supposons par exemple que l'on veuille résoudre un système

Ce système est suffisamment « générique

» pour que toutes ses solutions soient simples et pour qu'il y ait

exactement  solutions (comme prédit par la

borne de Bézout). En particulier, le système «

ressemble » (en degré, nombre et nature des solutions) au

système beaucoup plus simple

solutions (comme prédit par la

borne de Bézout). En particulier, le système «

ressemble » (en degré, nombre et nature des solutions) au

système beaucoup plus simple

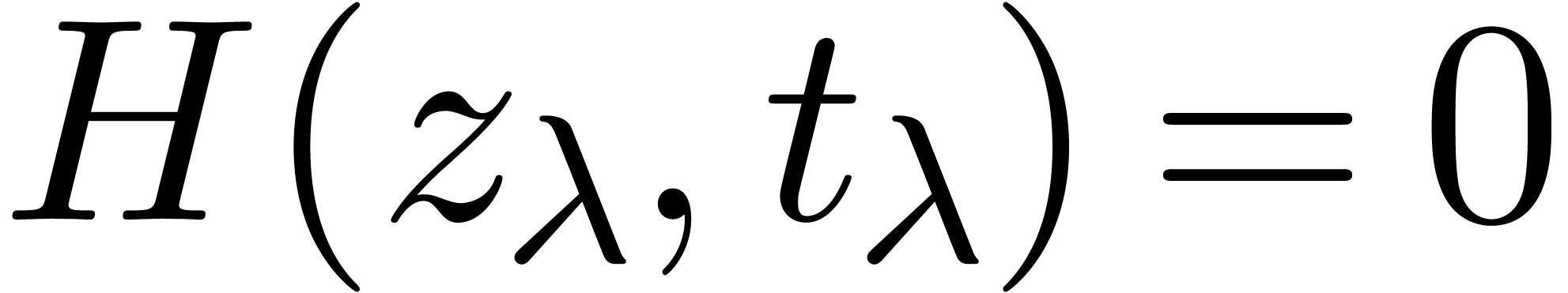

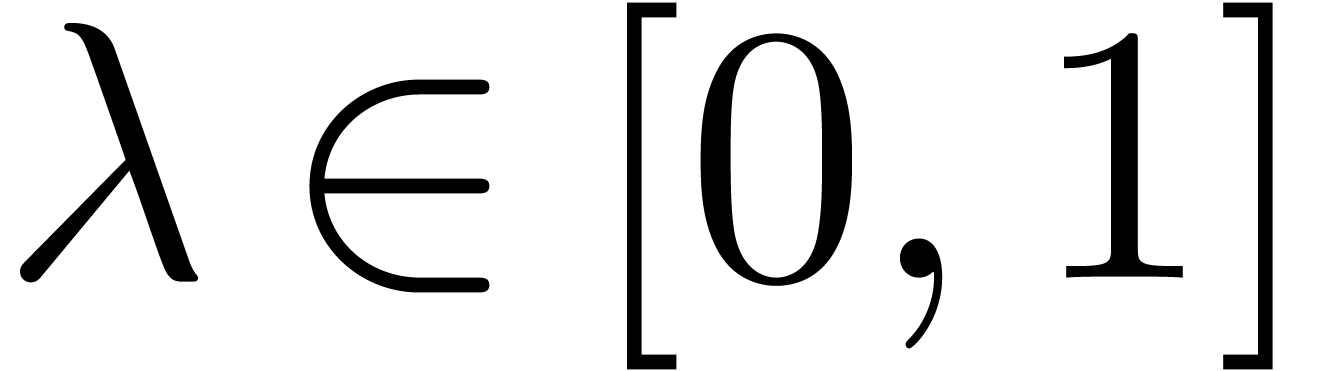

On considère maintenant l'homotopie

qui donne le système  en

en  et le système du départ

et le système du départ  en

en  . Partant des solutions

. Partant des solutions  en

en  , on obtient

donc les solutions de

, on obtient

donc les solutions de  par déformation, en

suivant les solutions quand on fait bouger

par déformation, en

suivant les solutions quand on fait bouger  de

de

vers

vers  (voir la section 1.2.3 et le chapitre 7).

(voir la section 1.2.3 et le chapitre 7).

La technique de suivi de chemin est aussi utile pour le calcul du groupe

de Galois d'un polynôme  ,

vu comme polynôme en

,

vu comme polynôme en  sur

sur  . On procède comme suit :

. On procède comme suit :

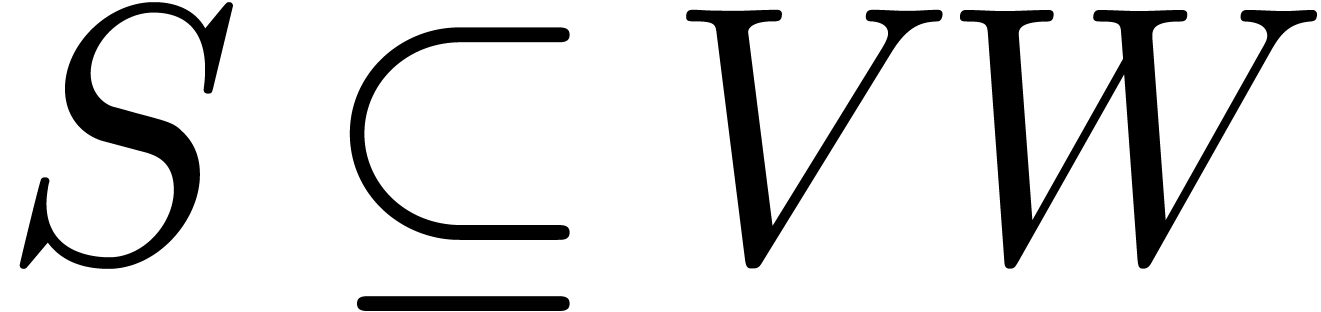

Soit  l'ensemble des racines de

l'ensemble des racines de  .

.

Soient  les racines de

les racines de  en

en  .

.

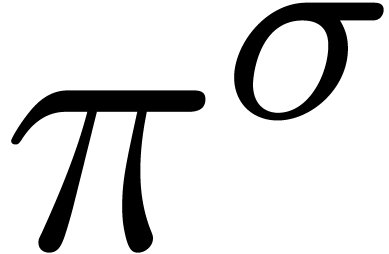

Pour tout  :

:

Construire un chemin  avec

avec  tournant autour de

tournant autour de  .

.

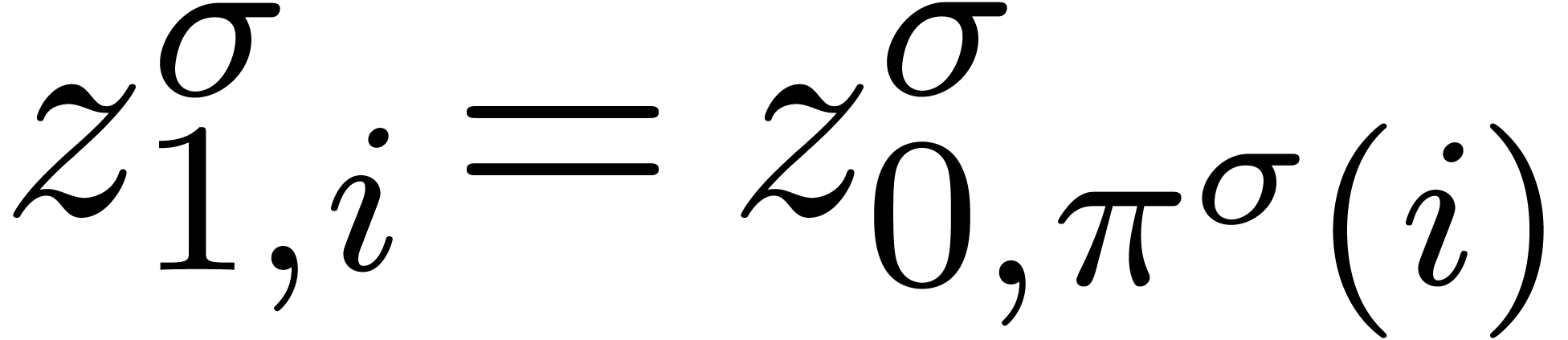

Remonter en un chemin  avec

avec  pour tout

pour tout  .

.

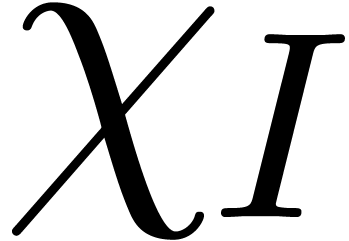

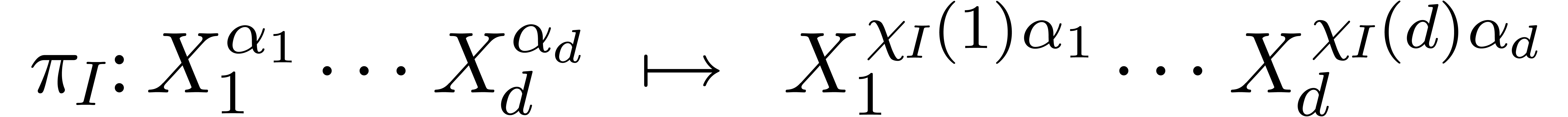

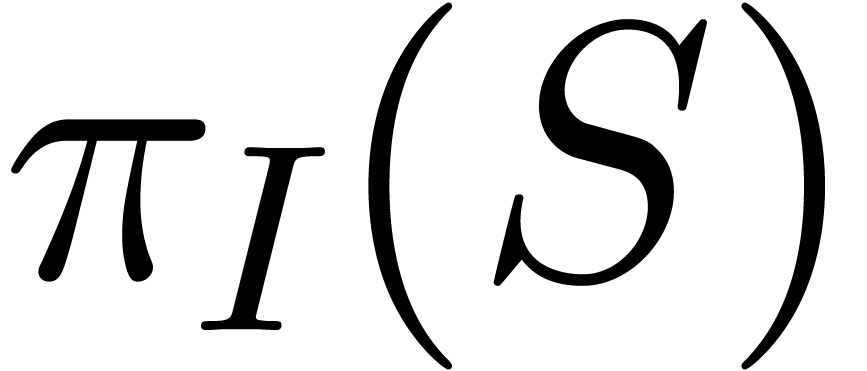

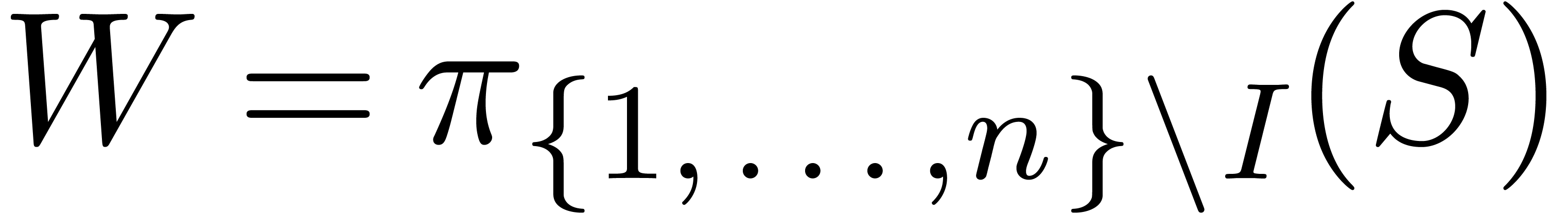

Calculer la permutation  de

de  avec

avec  .

.

On montre que les  génèrent

génèrent  .

.

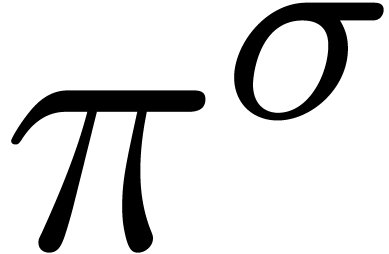

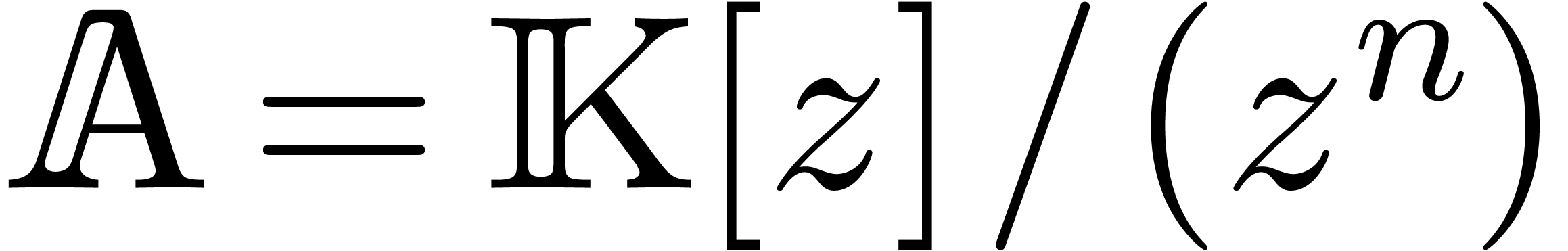

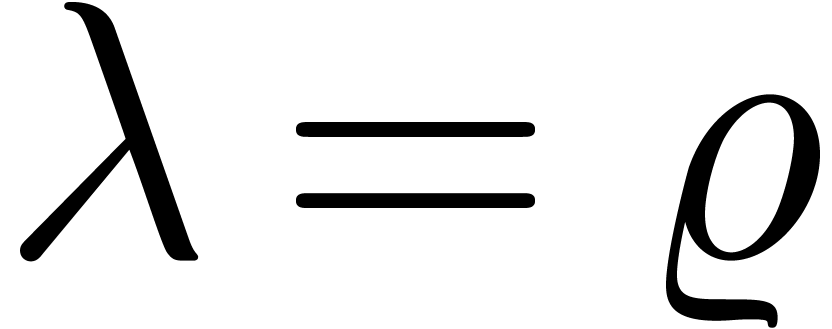

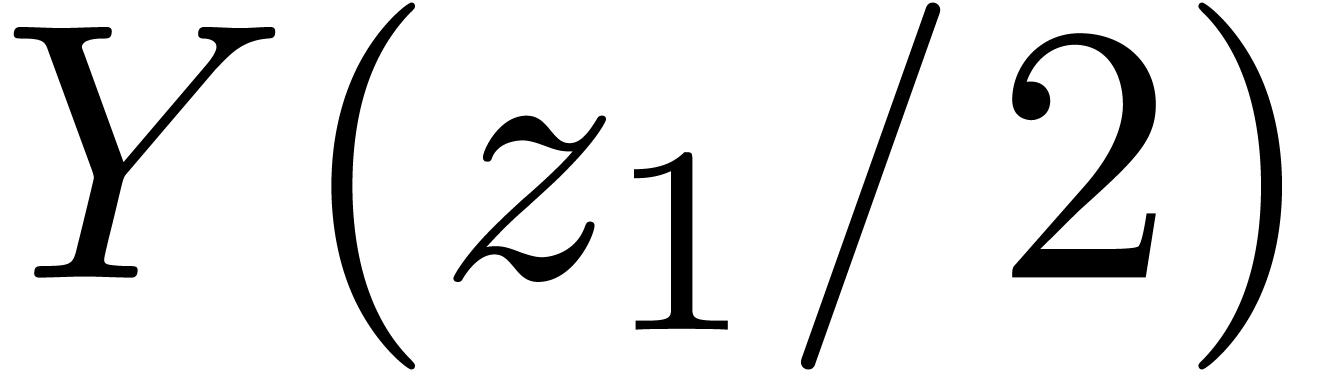

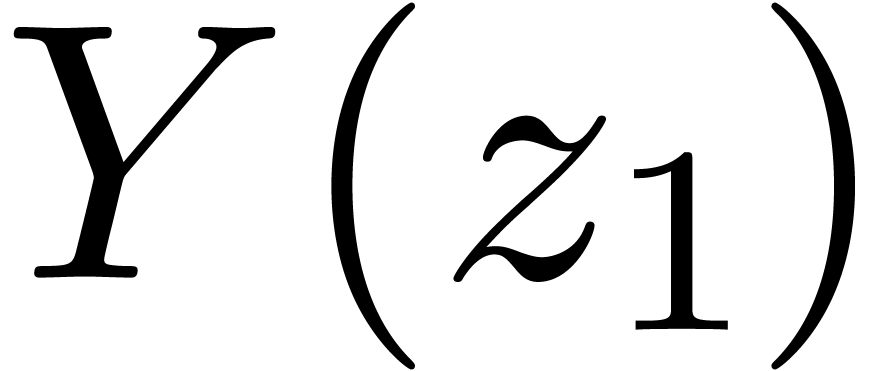

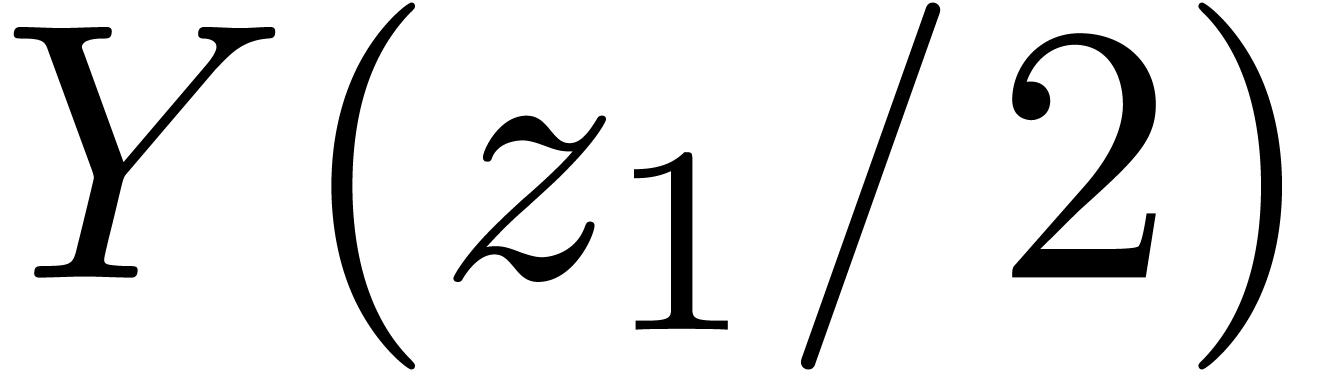

Prendre

|

|

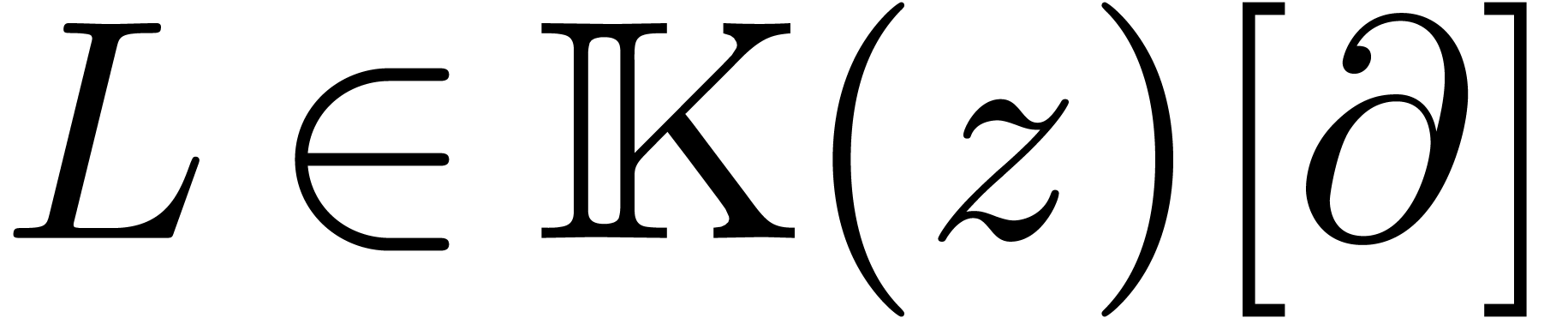

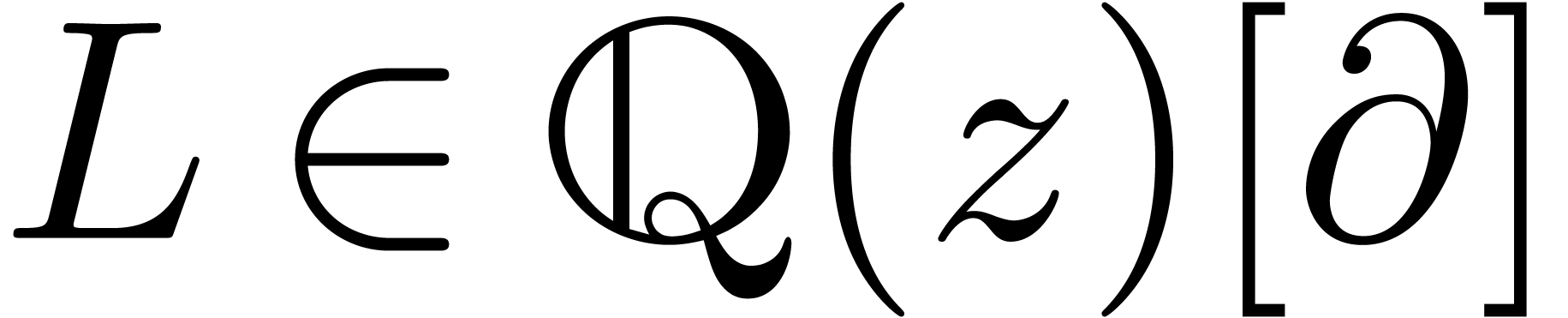

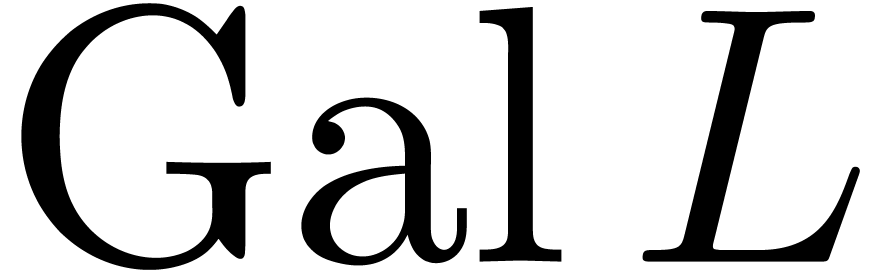

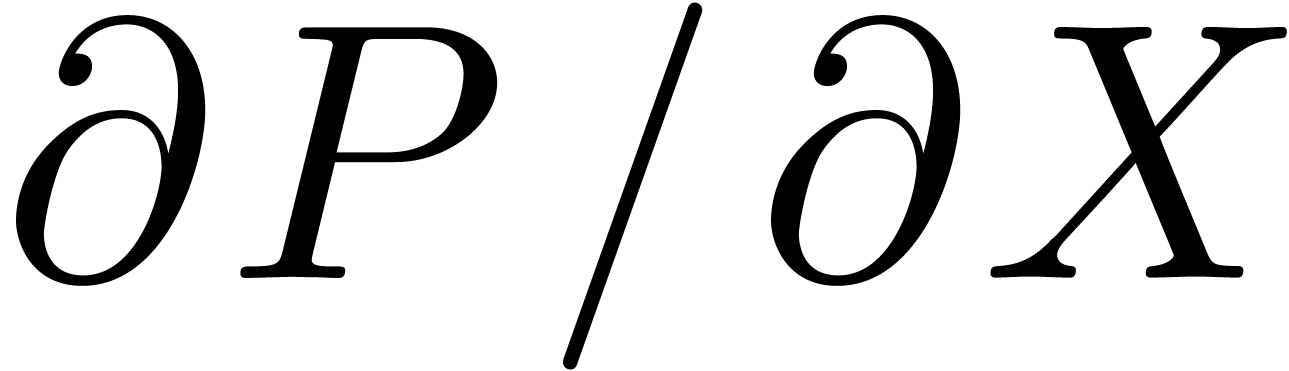

L'algorithme pour calculer le groupe de Galois d'une fonction

algébrique s'adapte au cas des opérateurs

différentiels  .

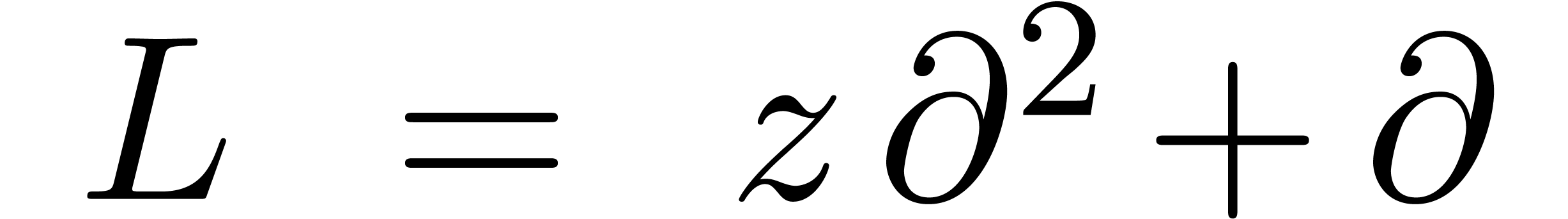

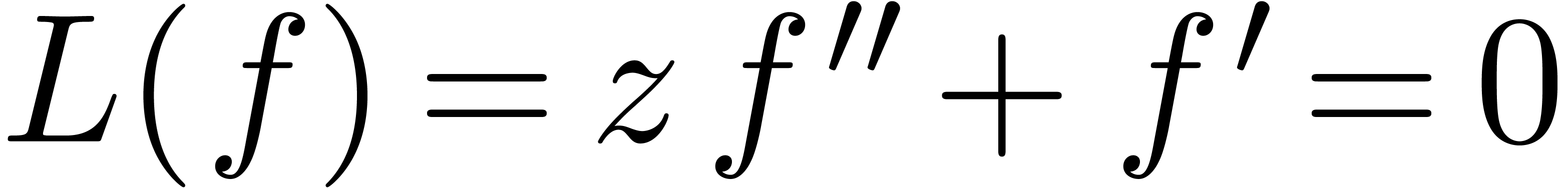

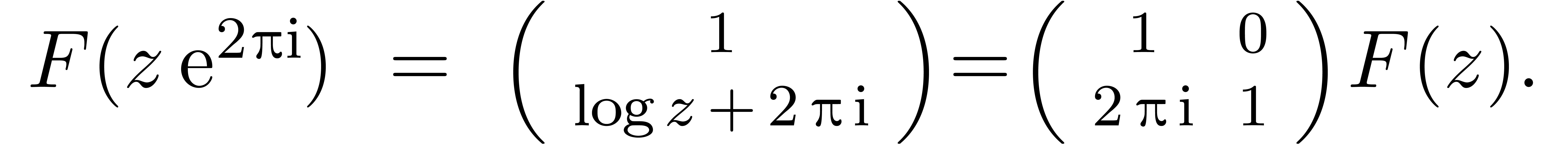

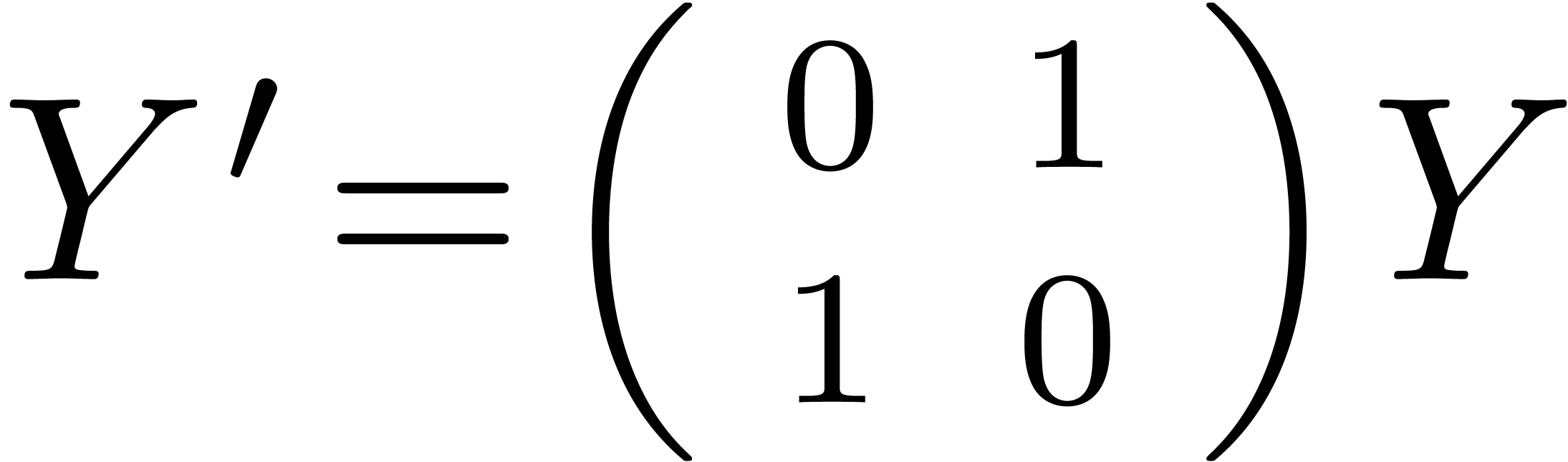

Considérons par exemple

.

Considérons par exemple

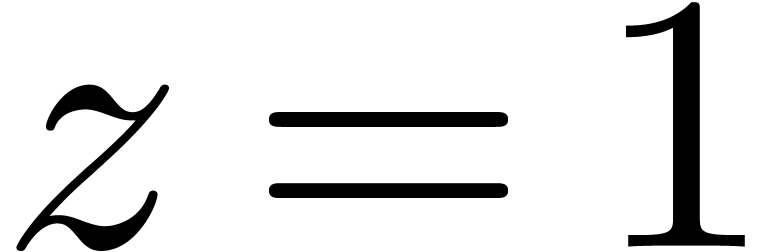

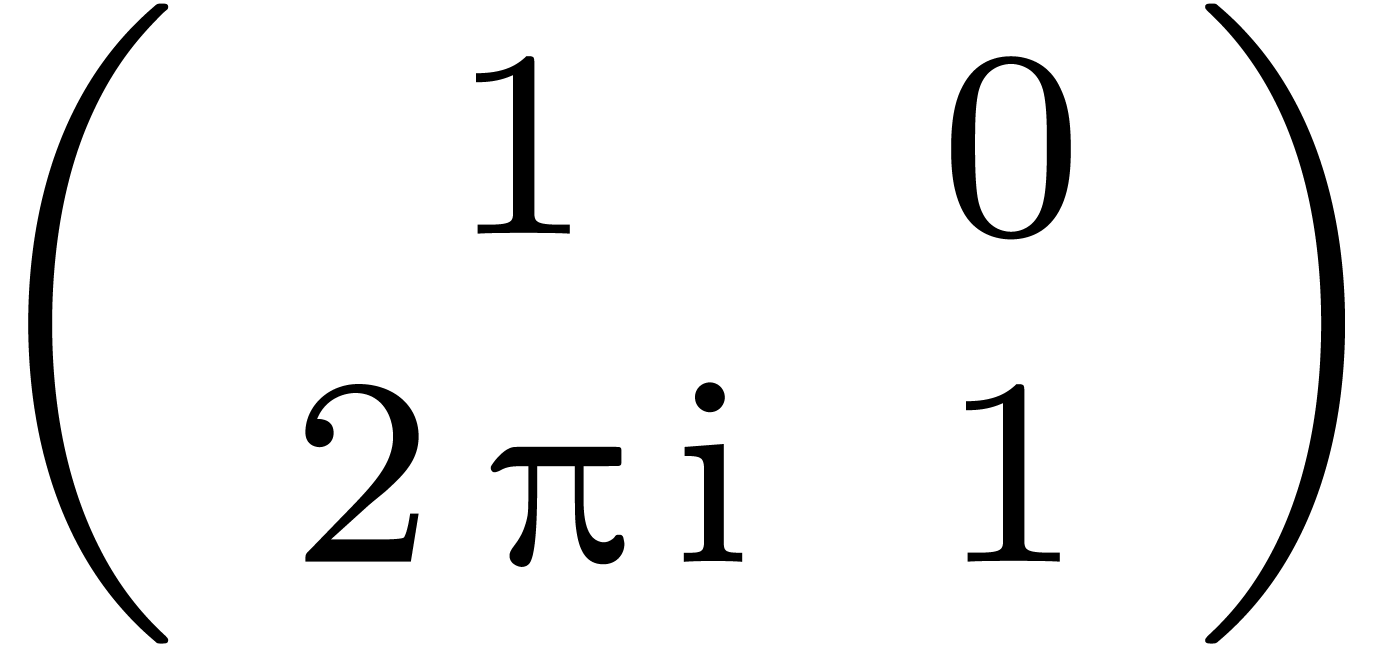

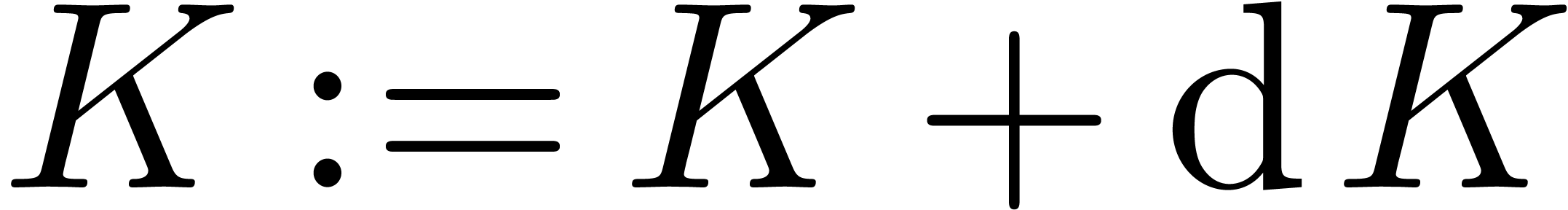

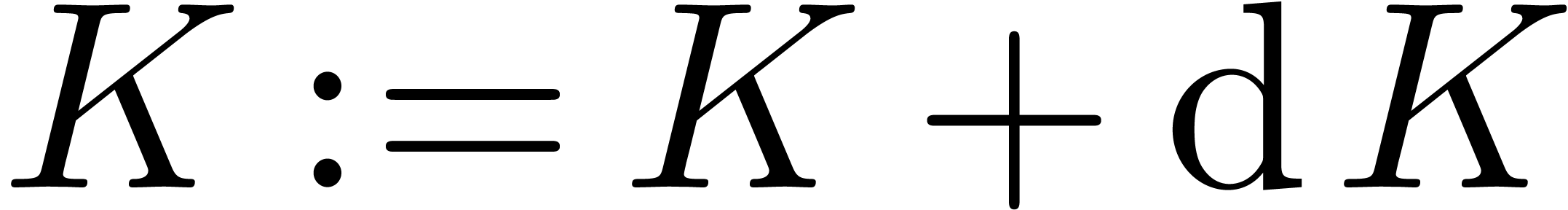

Base de solutions pour  en

en  :

:

Prolongement analytique de la solution  autour de

autour de

:

:

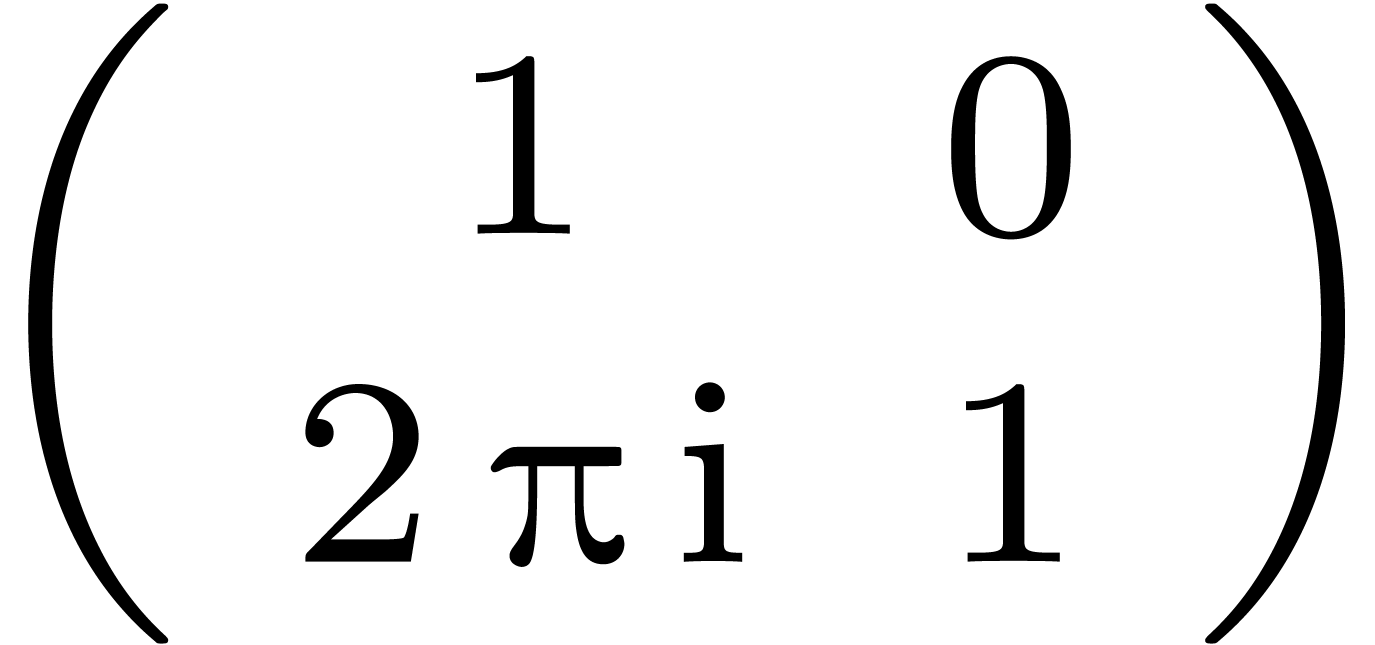

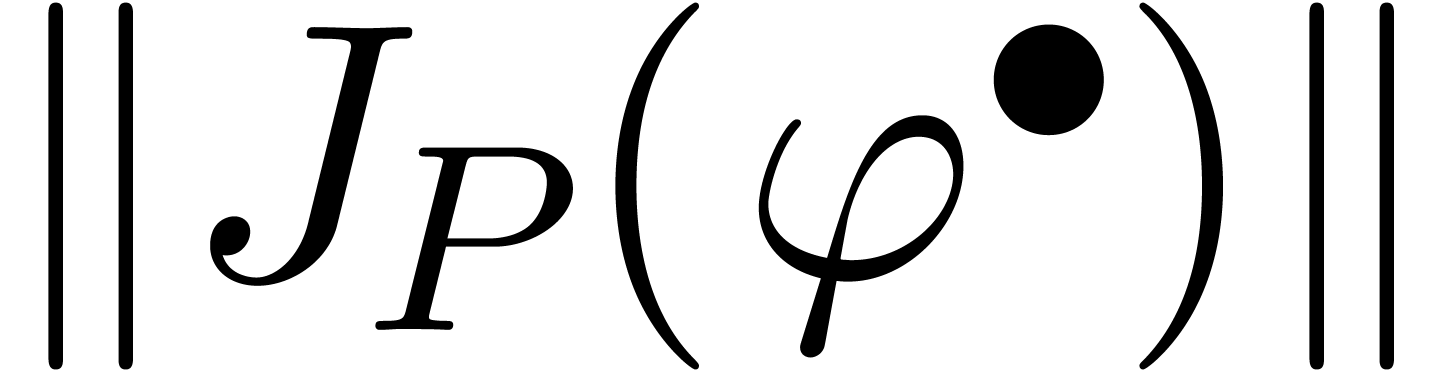

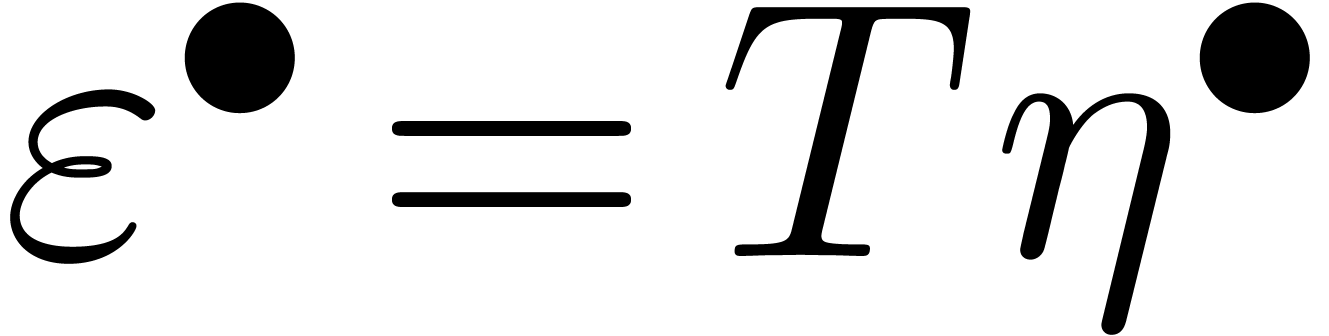

La matrice de monodromie  joue un rôle

analogue à la permutation

joue un rôle

analogue à la permutation  de l'exemple 1.2.

de l'exemple 1.2.

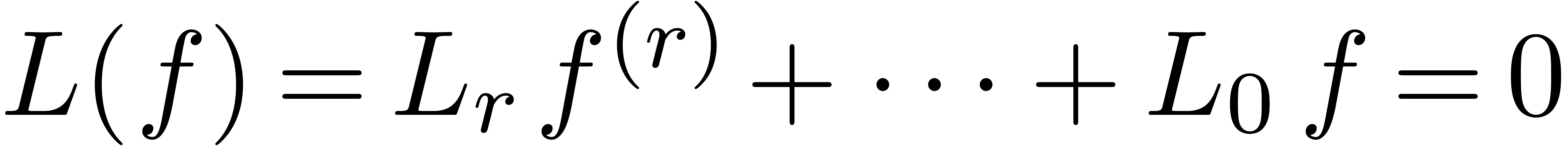

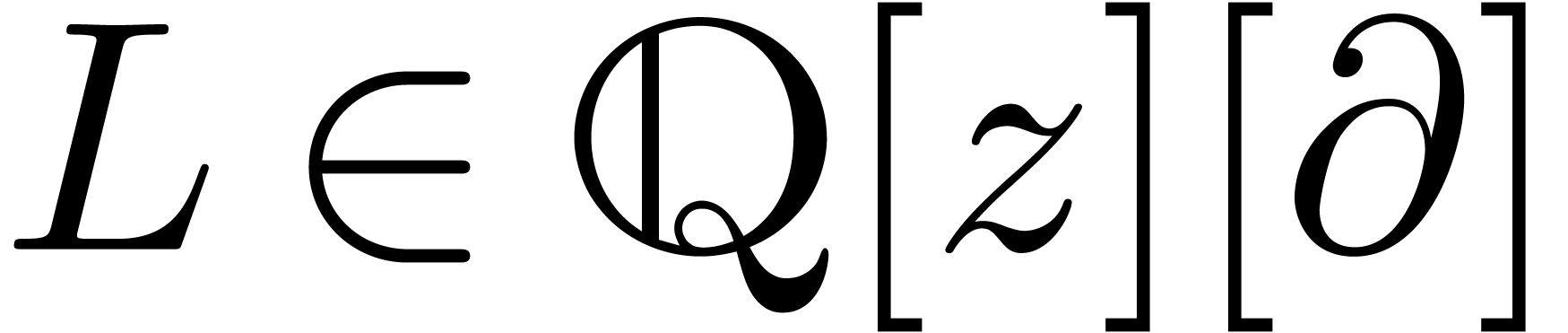

Soit  un opérateur différentiel

linéaire qui n'admet que des singularités

régulières. Alors son groupe de Galois différentiel

un opérateur différentiel

linéaire qui n'admet que des singularités

régulières. Alors son groupe de Galois différentiel

est généré par ces matrices

de monodromie en tant que groupe de algébrique fermé ;

c'est le théorème de densité de Schlesinger [64, 65]. Dans le cas général, il

faut rajouter les matrices de Stokes et les matrices exponentielles ;

c'est le théorème de Martinet-Ramis [52].

est généré par ces matrices

de monodromie en tant que groupe de algébrique fermé ;

c'est le théorème de densité de Schlesinger [64, 65]. Dans le cas général, il

faut rajouter les matrices de Stokes et les matrices exponentielles ;

c'est le théorème de Martinet-Ramis [52].

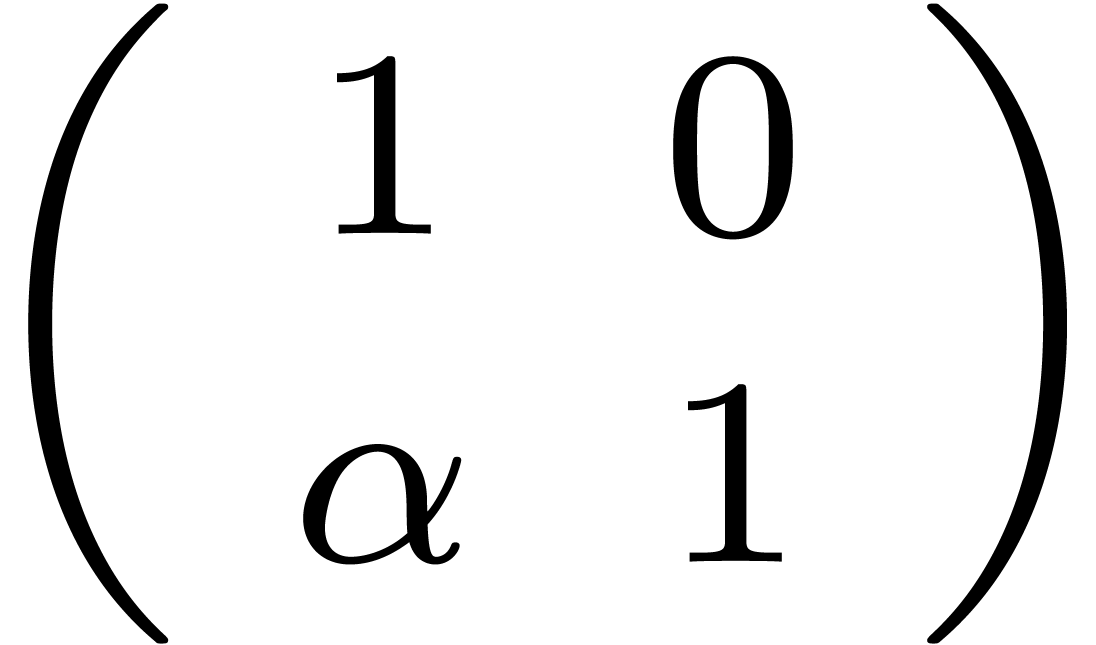

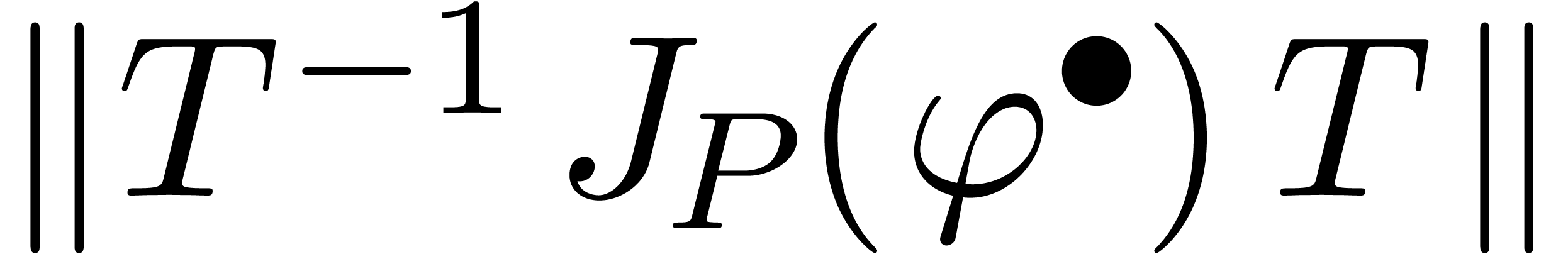

Exemple 1.3. Dans l'exemple ci-dessus, le plus petit groupe

algébrique fermé qui contient la matrice  est constitué de toutes les matrices du type

est constitué de toutes les matrices du type  avec

avec  .

.

Toutes ces matrices de monodromie peuvent se calculer de façon

certifiée et en temps presque linéaire [18,

77, 78]. Ceci reste vrai pour les matrices

exponentielles et les matrices de Stokes [82], grace

à la théorie d'accéléro-sommation

d'Écalle [25, 26, 27, 12]. Pour une précision suffisamment grande de calcul,

ceci conduit a un algorithme pour calculer le groupe de Galois

différentiel [81]. En particulier, on obtient un

algorithme de factorisation de  .

.

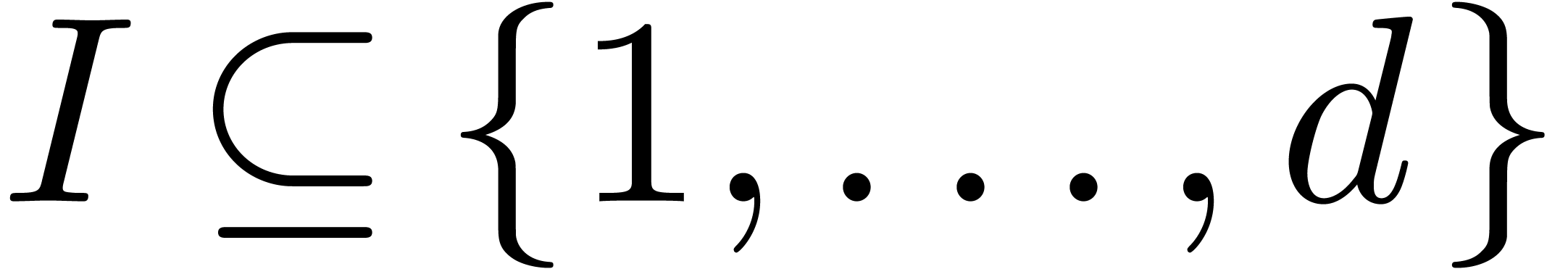

Remarque 1.4. L'algorithme de factorisation marche grosso

modo comme ceci. Soit  un système

fondamental de solutions en un point non singulier

un système

fondamental de solutions en un point non singulier  et supposons que les matrices

et supposons que les matrices  générant

générant  ont été

calculées par rapport à

ont été

calculées par rapport à  .

L'opérateur

.

L'opérateur  se factorise si et seulement

si

se factorise si et seulement

si  admet un sous espace vectoriel stable non

trivial sous l'action de

admet un sous espace vectoriel stable non

trivial sous l'action de  ,

c'est à dire sous l'action de l'algèbre

générée par

,

c'est à dire sous l'action de l'algèbre

générée par  .

.

Pour une précision de calcul donnée, si un tel espace  stable existe, il se calcule donc par algèbre

linéaire. Soit

stable existe, il se calcule donc par algèbre

linéaire. Soit  une base de

une base de  . Alors l'opérateur

. Alors l'opérateur  divise

divise  . Les coefficients de

. Les coefficients de

sont présentés comme des

séries à coefficients dans

sont présentés comme des

séries à coefficients dans  ,

mais sont en réalité dans

,

mais sont en réalité dans  .

On obtient les coefficients en tant que fractions rationnelles dans

.

On obtient les coefficients en tant que fractions rationnelles dans  par Padé-Hermite et développements en

fractions continues. On montre que pour une précision de calcul

suffisante, on obtient ou bien un

par Padé-Hermite et développements en

fractions continues. On montre que pour une précision de calcul

suffisante, on obtient ou bien un  qui divise

effectivement

qui divise

effectivement  dans

dans  ,

ou bien un certificat numérique qu'il n'existe pas de sous-espace

vectoriel non trivial

,

ou bien un certificat numérique qu'il n'existe pas de sous-espace

vectoriel non trivial  .

.

Prétraitement symbolique  meilleure efficacité

meilleure efficacité

Plus généralement : asymptotique formelle  évaluation rapide de fonctions

évaluation rapide de fonctions

De façon similaire, la résolution de systèmes algébriques surdéterminés peut bénéficier d'un prétraitement pour calculer une base de Gröbner ; ensuite on peut par exemple chercher les solutions numériques par méthode d'homotopie.

Calcul de schémas numériques rapides

Runge-Kutta à des ordres élevés

Bonnes bases de fonctions pour éléments finis

Bonnes bases d'ondelettes

Arithmétique rapide

Calcul rapide en multi-précision

Algorithmes denses rapides sur les polynômes, les matrices et les séries

Traitement efficace de structures creuses et en évaluation

Besoin d'un bon langage

Mathématiquement expressif

Sémantiquement propre

Interface conviviale

Compilé (au moins pour le calcul analytique)

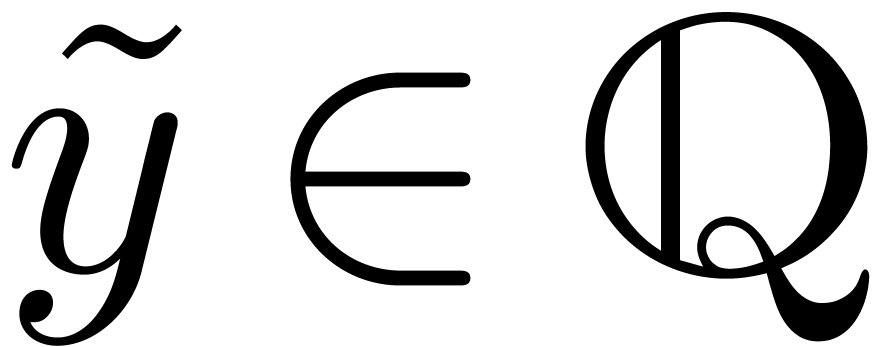

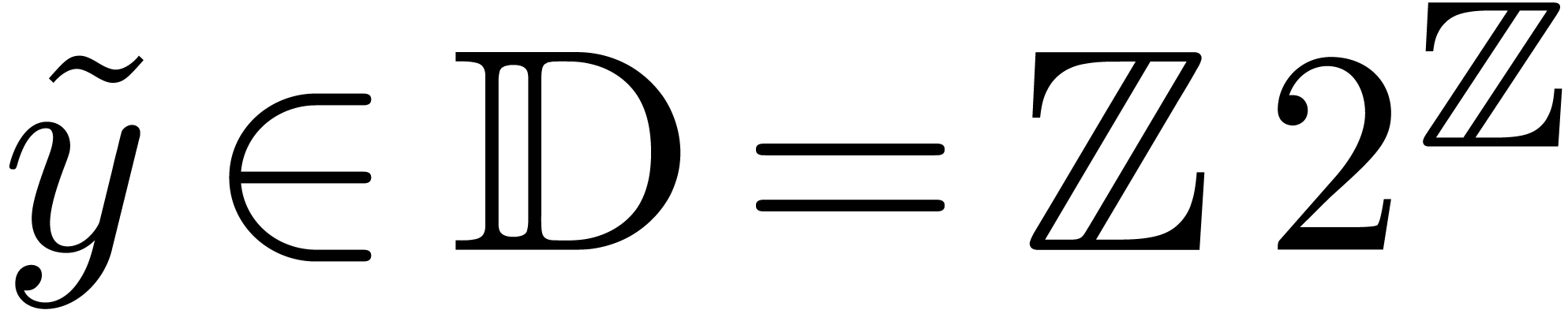

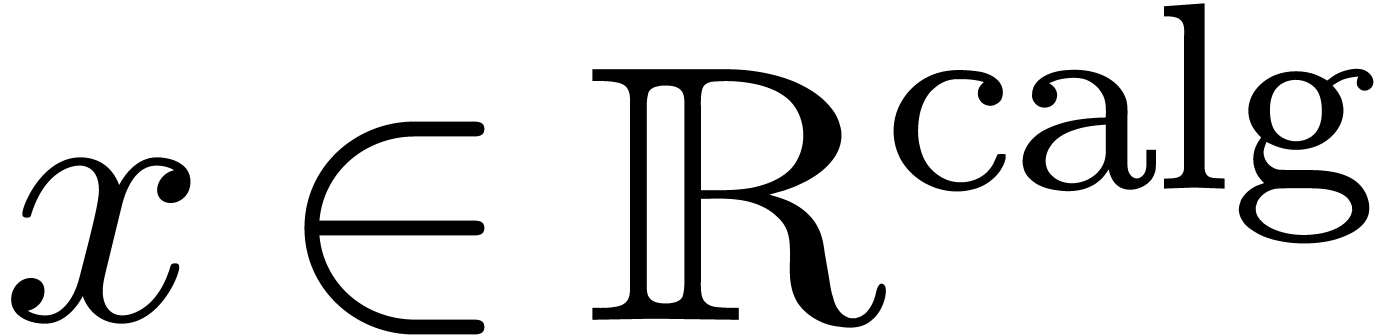

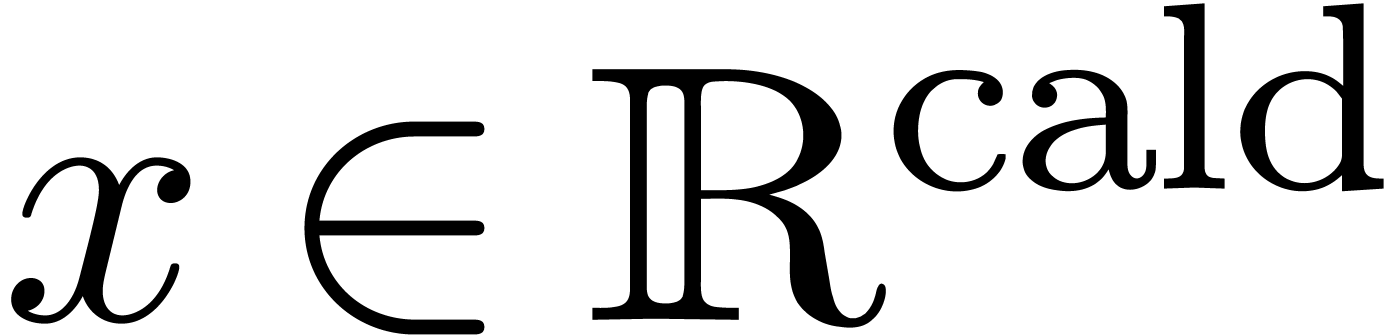

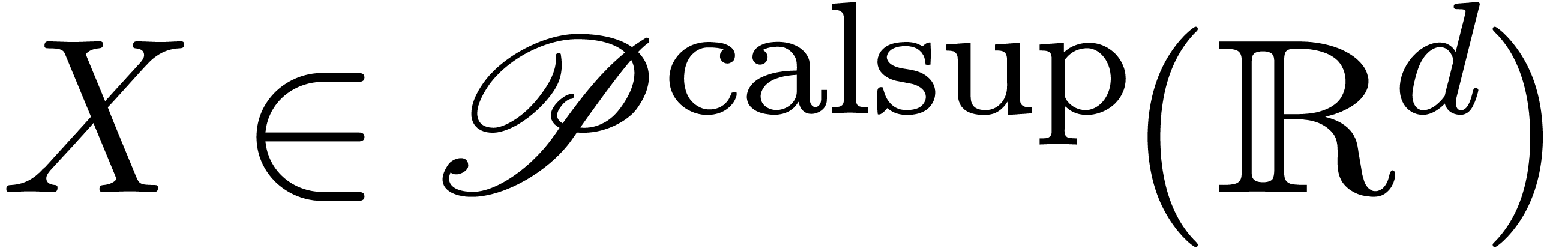

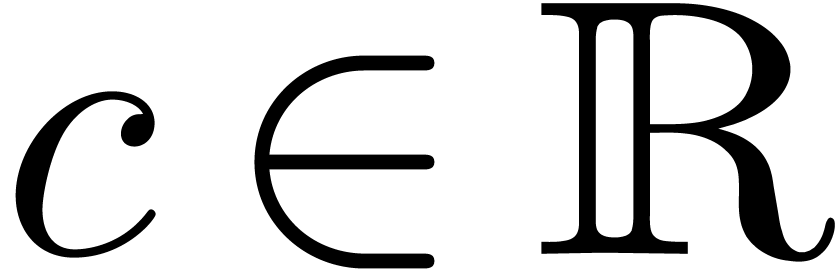

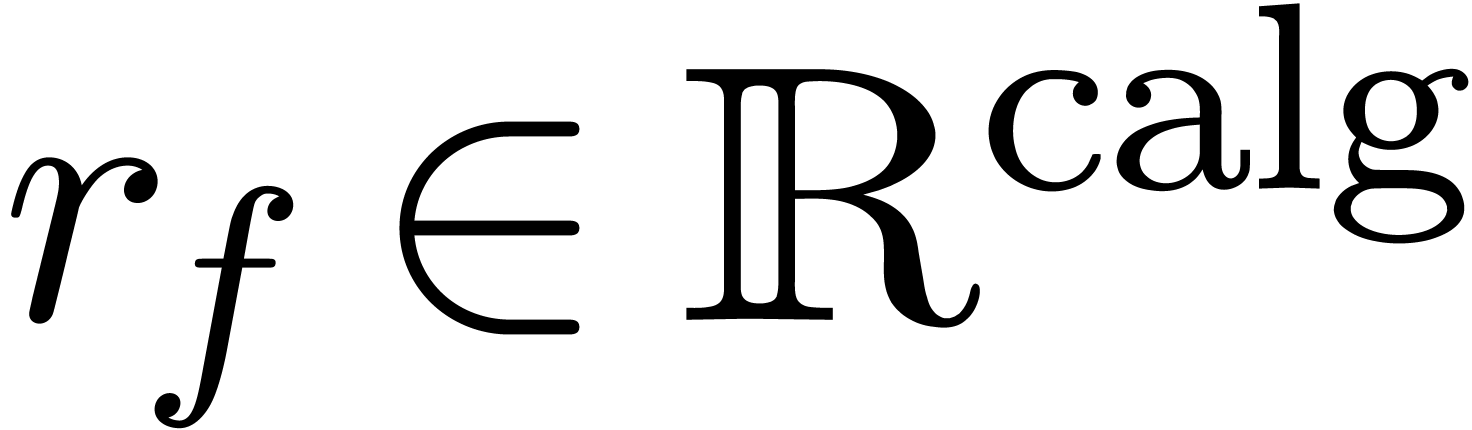

Comme l'ensemble  des nombres réels est

non dénombrable, il est impossible de construire un type de

données susceptible de pouvoir représenter n'importe quel

nombre réel. Toutefois, au moins d'un point de vue

théorique, il serait utile de pouvoir calculer directement avec

des nombres réels, quitte à se restreindre à une

sous-classe de

des nombres réels est

non dénombrable, il est impossible de construire un type de

données susceptible de pouvoir représenter n'importe quel

nombre réel. Toutefois, au moins d'un point de vue

théorique, il serait utile de pouvoir calculer directement avec

des nombres réels, quitte à se restreindre à une

sous-classe de  . Le choix le

plus naturel consiste à prendre la sous-classe des nombres que

l'on peut approcher aussi précisément que

nécessaire par des nombres rationnels :

. Le choix le

plus naturel consiste à prendre la sous-classe des nombres que

l'on peut approcher aussi précisément que

nécessaire par des nombres rationnels :

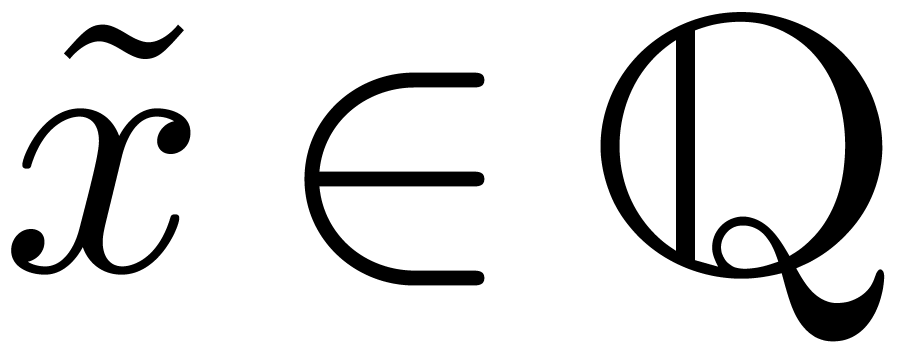

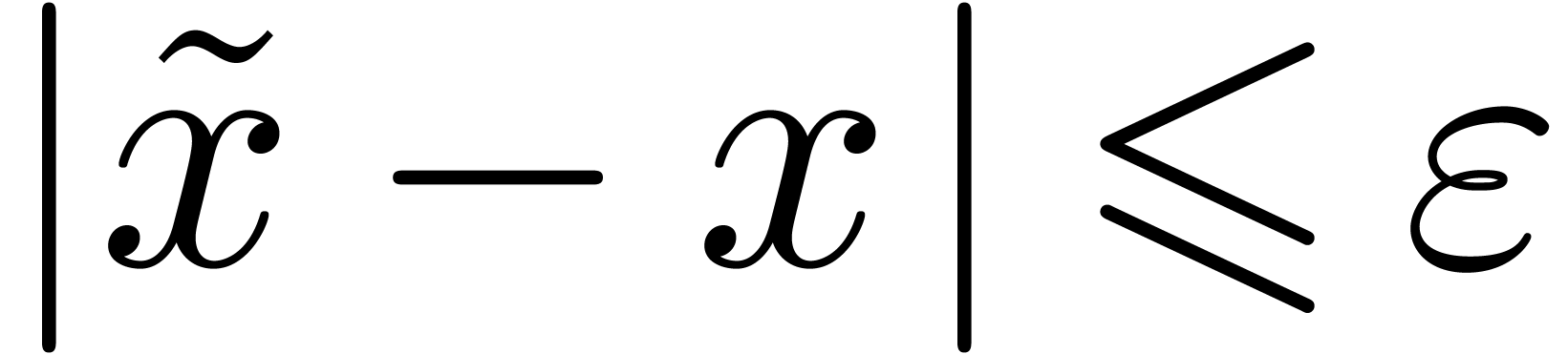

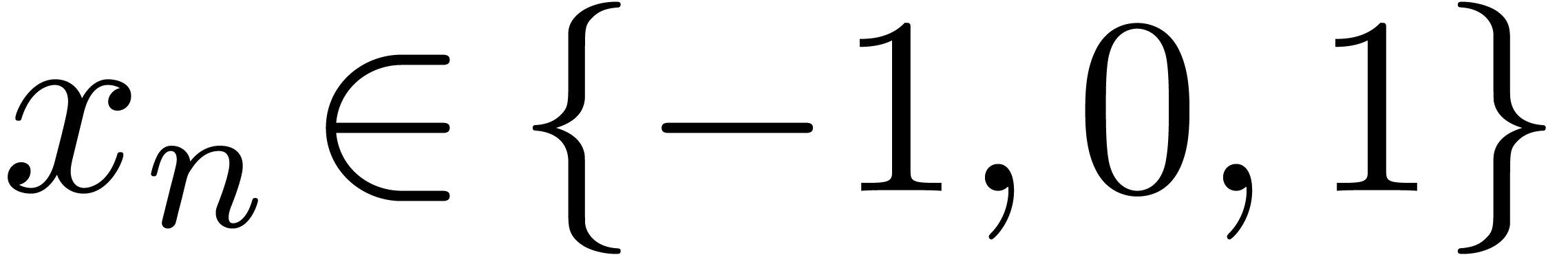

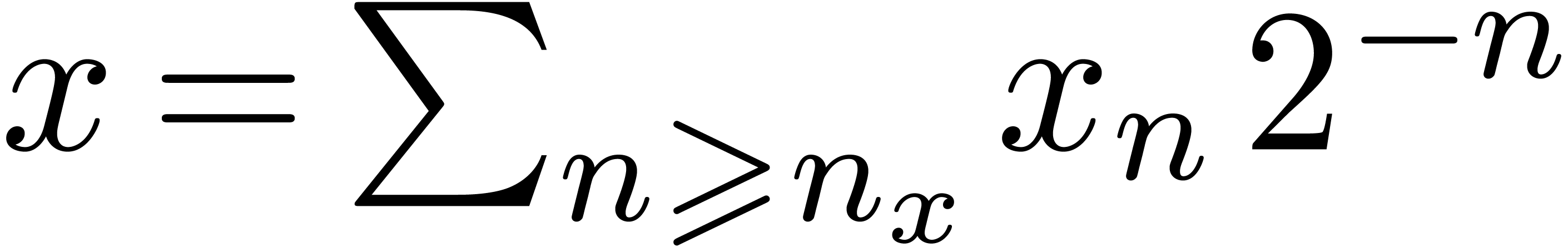

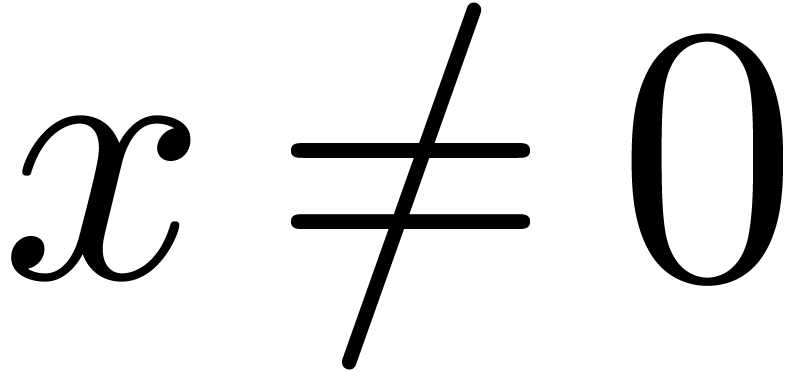

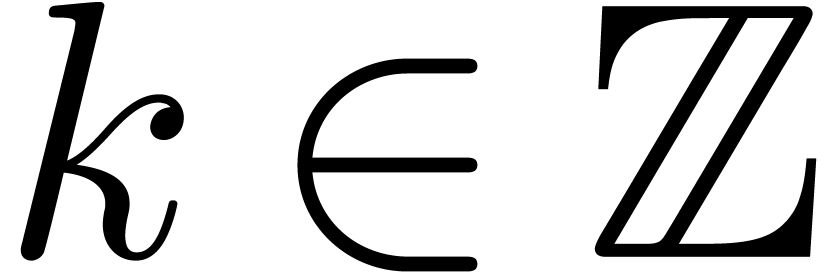

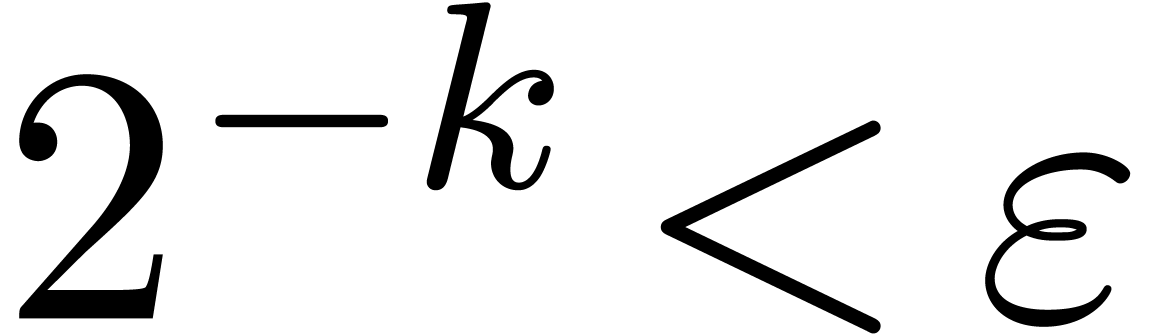

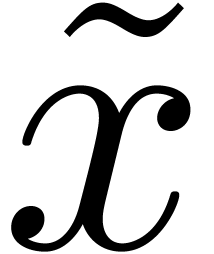

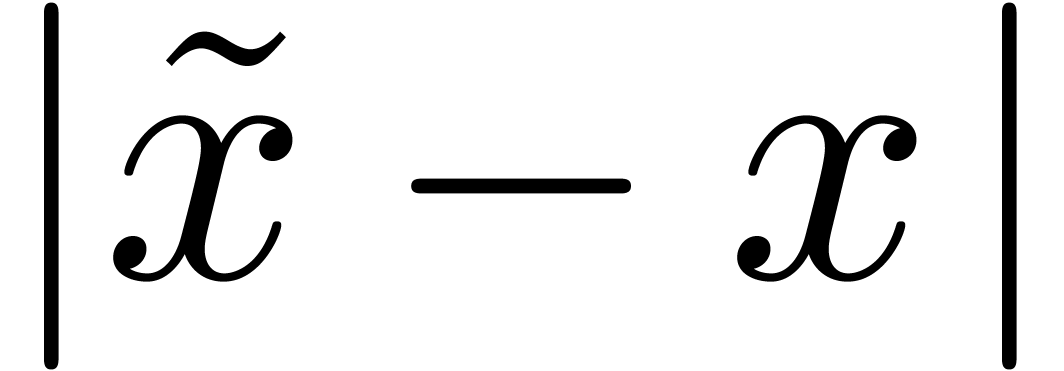

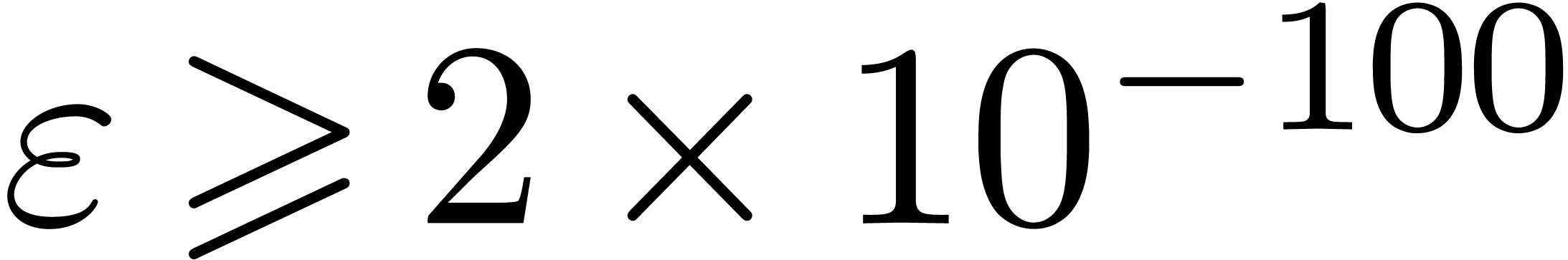

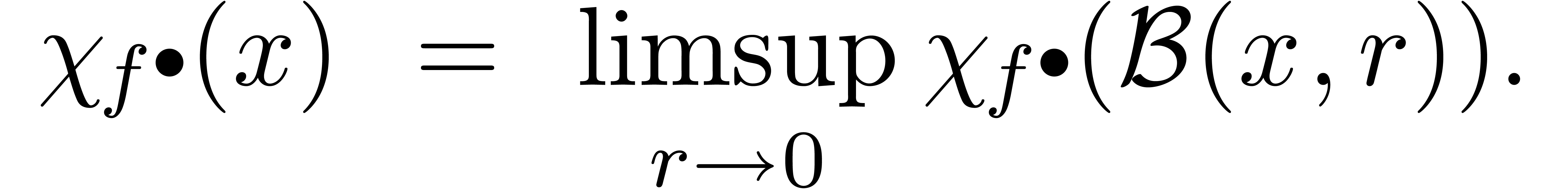

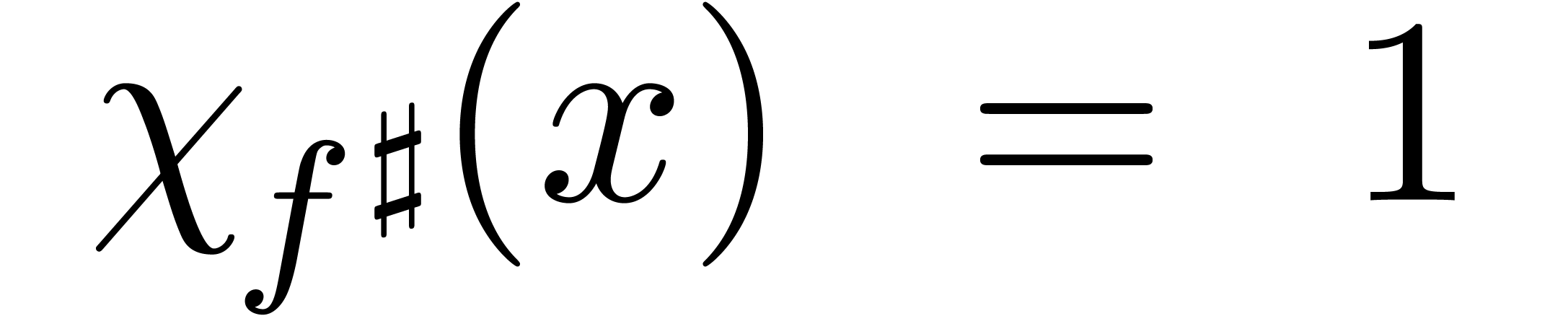

Définition 2.1. Un nombre

réel  est calculable s'il

existe un algorithme qui prend

est calculable s'il

existe un algorithme qui prend  en entrée

et qui produit une

en entrée

et qui produit une  -approximation

-approximation

de

de  avec

avec  . On note

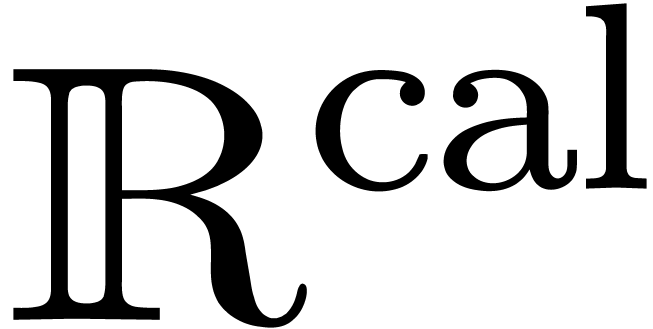

. On note  l'ensemble

des nombres réels calculables.

l'ensemble

des nombres réels calculables.

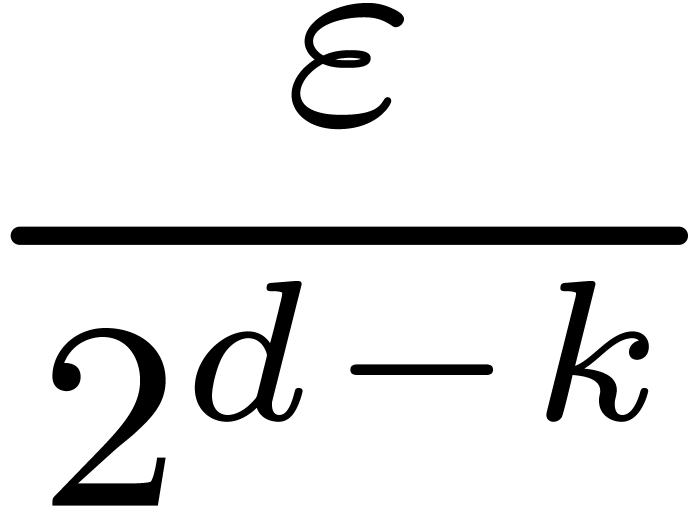

Ici, il est important d'intégrer le fait qu'un nombre est en

réalité un programme ou encore la

promesse de pouvoir trouver une approximation aussi fine que

souhaitée. Bien sûr, la définition admet de

nombreuses variantes, en jouant sur la façon d'approcher  . Par exemple :

. Par exemple :

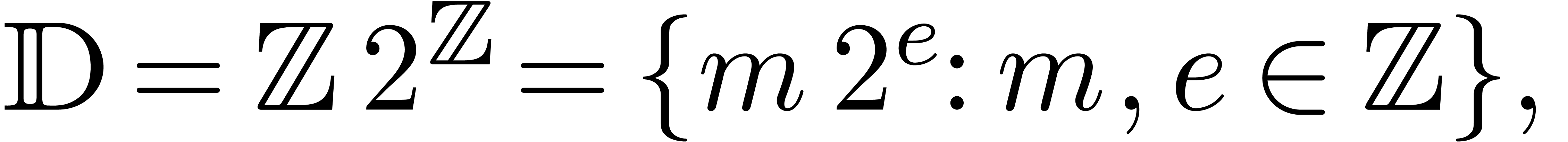

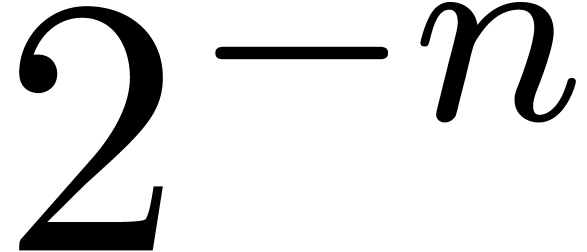

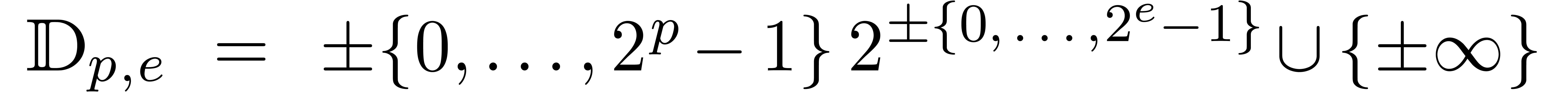

On peut remplacer  par l'ensemble des nombres

flottants

par l'ensemble des nombres

flottants

en autorisant une précision arbitraire pour les mantisses et les exposants.

algorithme qui prend

algorithme qui prend  en entrée et calcule une

en entrée et calcule une  -approximation.

-approximation.

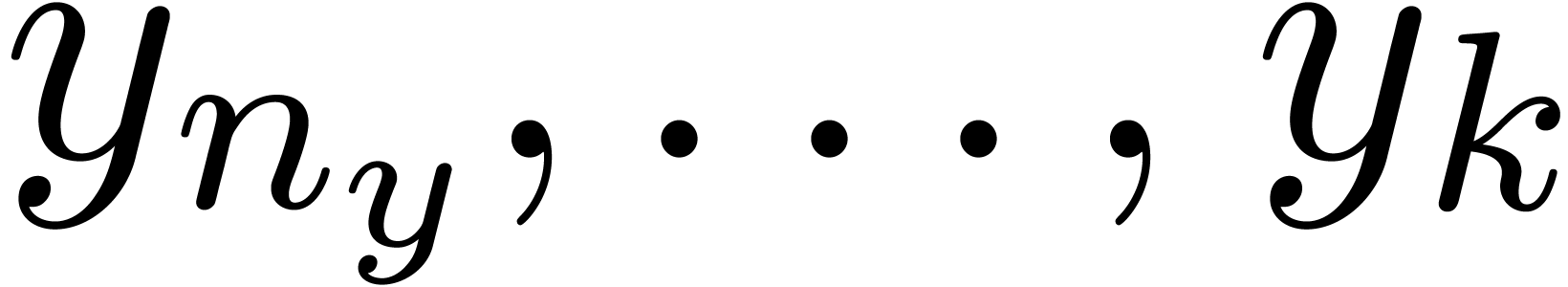

algorithme pour calculer

algorithme pour calculer  ,

,  avec

avec

suites calculables

suites calculables  ,

,  avec

avec

L'analyse calculable est le sujet qui se propose de « réécrire » l'analyse sous cet angle de la calculabilité [1, 93]. La encore, il y a des sujets voisins, comme l'analyse constructive [8].

Une autre approche [71, 72, 69,

70, 21] est de faire « comme si »

l'on pouvait représenter n'importe quel nombre réel et

effectuer des opérations habituelles  en

temps constant. Évidemment, ce modèle ne correspond encore

moins à des ordinateurs concrets que les machines de Turing.

Toutefois, ce modèle simplificateur n'est pas dénué

de sens si on calcule en précision fixe et il n'est pas inutile

d'adopter ce point de vue par moments, en particulier pour la

résolution de systèmes polynomiaux (voir les chapitres 6

et 7).

en

temps constant. Évidemment, ce modèle ne correspond encore

moins à des ordinateurs concrets que les machines de Turing.

Toutefois, ce modèle simplificateur n'est pas dénué

de sens si on calcule en précision fixe et il n'est pas inutile

d'adopter ce point de vue par moments, en particulier pour la

résolution de systèmes polynomiaux (voir les chapitres 6

et 7).

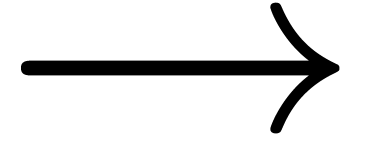

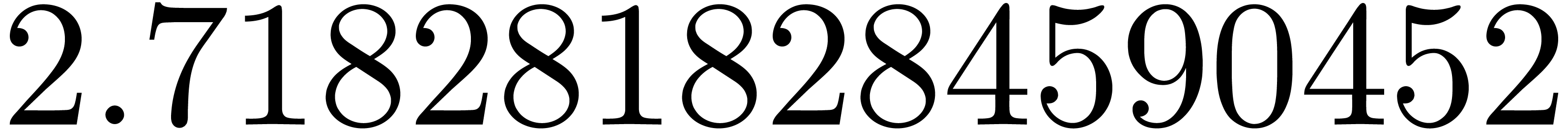

Mmx] |

use "asymptotix"; |

| Mmx] | type_mode? := true; |

Mmx] |

one: Approximator (Floating, Floating) == 1; |

Mmx] |

e == exp one |

:

:

Mmx] |

approximate (e, 1.0e-1000) |

:

:

Le premier théorème de non calculabilité [75] parait naturel aujourd'hui. Or c'est ce théorème qui est à l'origine des machines de Turing et des premiers résultats de non calculabilité !

Théorème 2.2. Il n'existe pas de test

de nullité pour  .

.

Asymmétrie. Soit  .

.

Si  , alors on ne peut pas

forcément le démontrer en temps fini.

, alors on ne peut pas

forcément le démontrer en temps fini.

Si  , alors on peut le

certifier en temps fini.

, alors on peut le

certifier en temps fini.

Restriction à des sous-classes.

Il existe un test de nullité pour  (nombres algébriques réels).

(nombres algébriques réels).

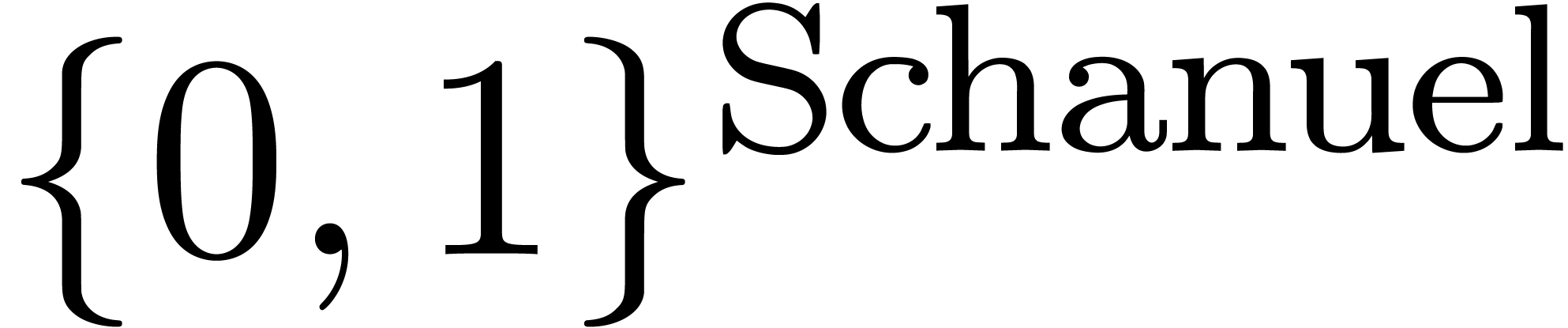

Il existe un test de nullité pour  , modulo la conjecture de Schanuel.

, modulo la conjecture de Schanuel.

Problème ouvert difficile : test de nullité pour les constantes holonomes.

Le deuxième théorème [36, 37, 38] de non calculabilité est un peu plus surprenant, du moins pour moi-même : ce n'est pas la peine de chercher à calculer des fonctions discontinues, puisque c'est impossible !

Théorème 2.3. Toute fonction

calculable  est continue.

est continue.

Démonstration. Considérons une machine de Turing

pour calculer

pour calculer  .

.

Soit  .

.

Sur l'entrée  ,

,  retourne

retourne  avec

avec  .

.

Soit  et

et  avec

avec  , considérons le calcul

fini de

, considérons le calcul

fini de  .

.

Soit  maximal, tel que

maximal, tel que  intervient dans ce calcul.

intervient dans ce calcul.

Alors  pour tout

pour tout  avec

avec

.

.

Le troisième théorème [22] de non

calculabilité est surprenant dans ce sens que les données

ne sont pas des nombres ou fonctions calculables, mais plutôt des

simples vecteurs et polynômes à coefficients dans  . Le théorème pose

clairement des limites à ce que l'on pourra calculer dans la

théorie des systèmes dynamiques.

. Le théorème pose

clairement des limites à ce que l'on pourra calculer dans la

théorie des systèmes dynamiques.

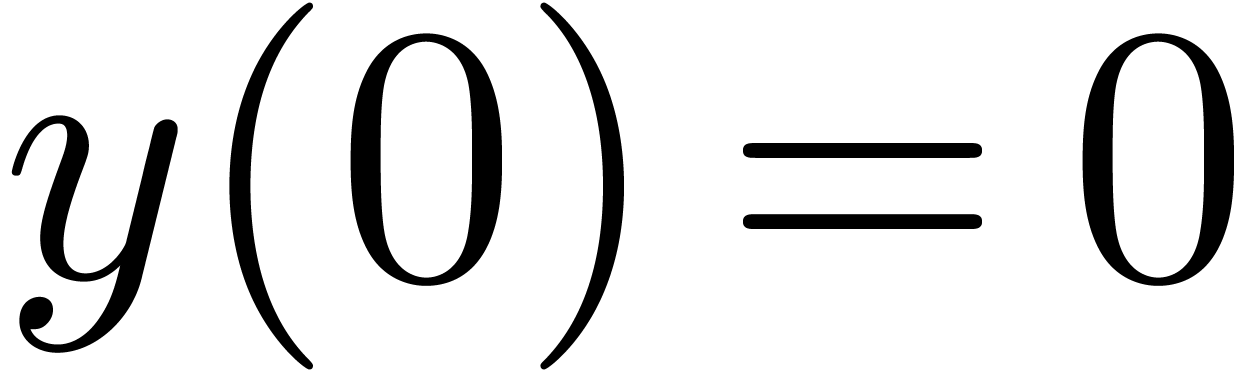

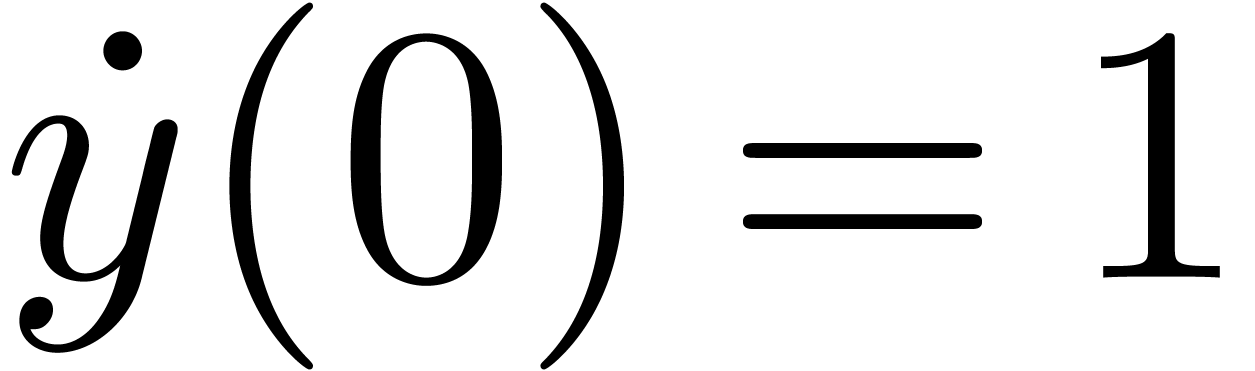

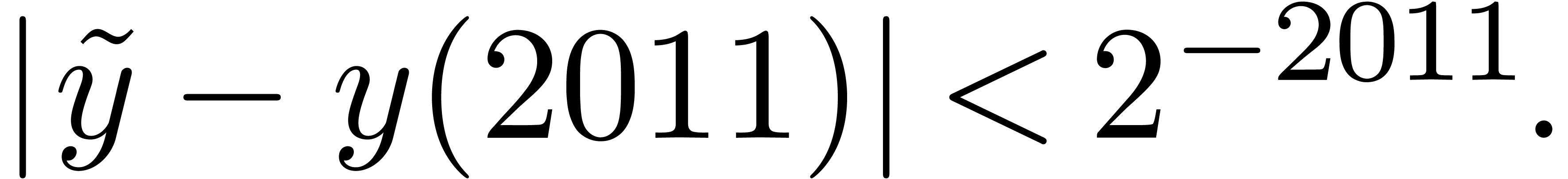

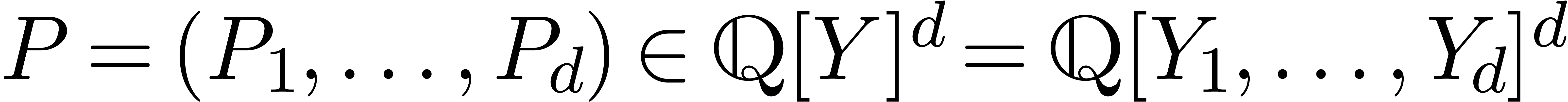

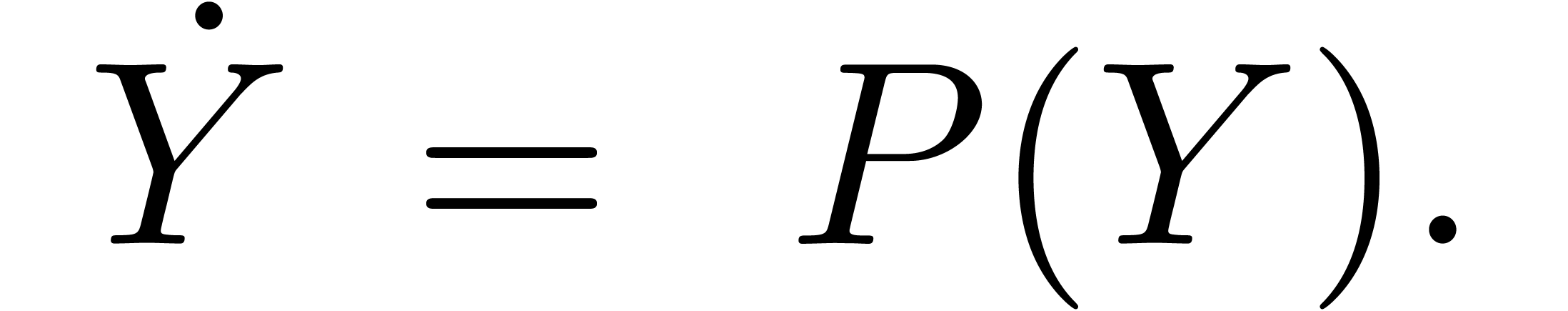

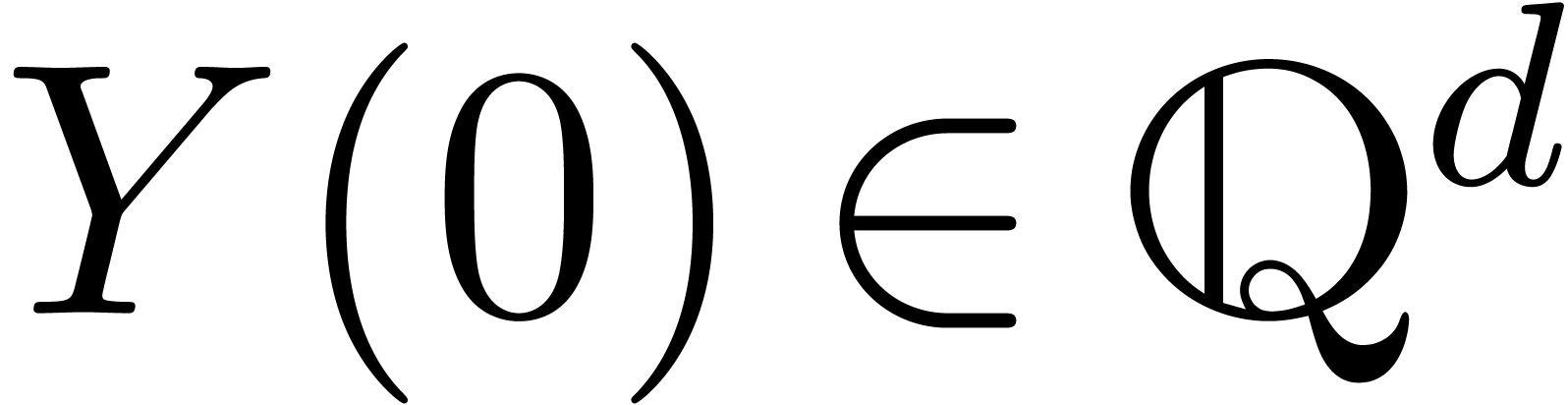

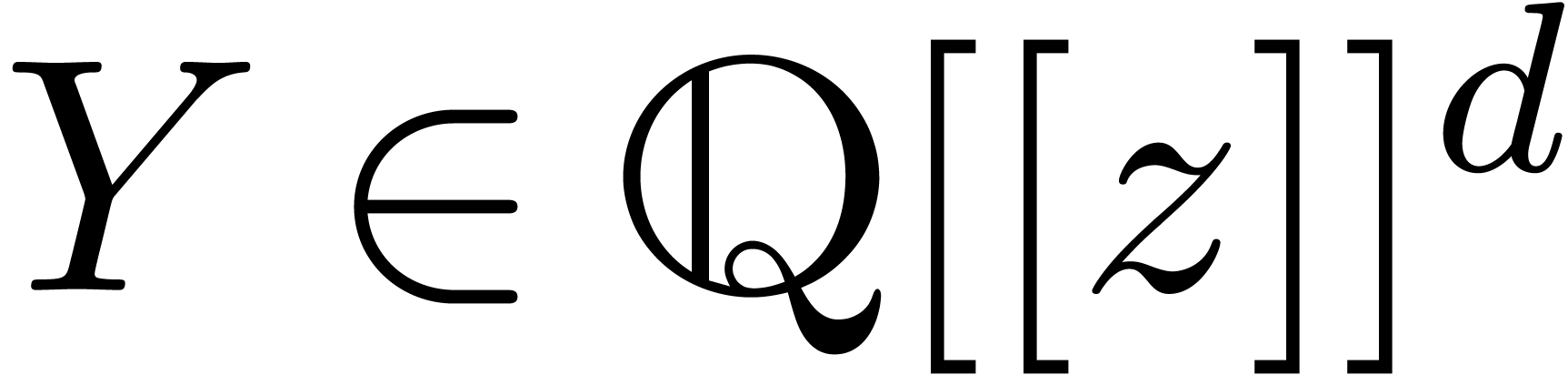

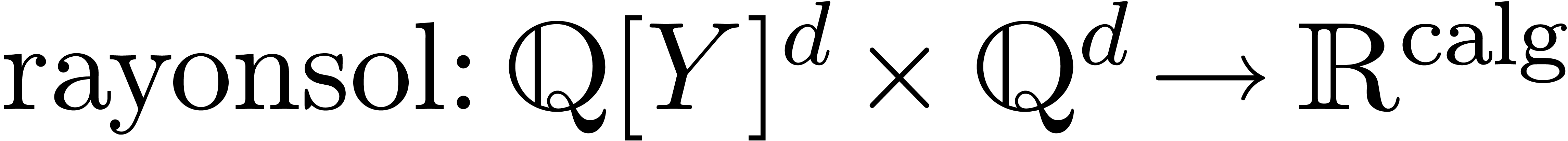

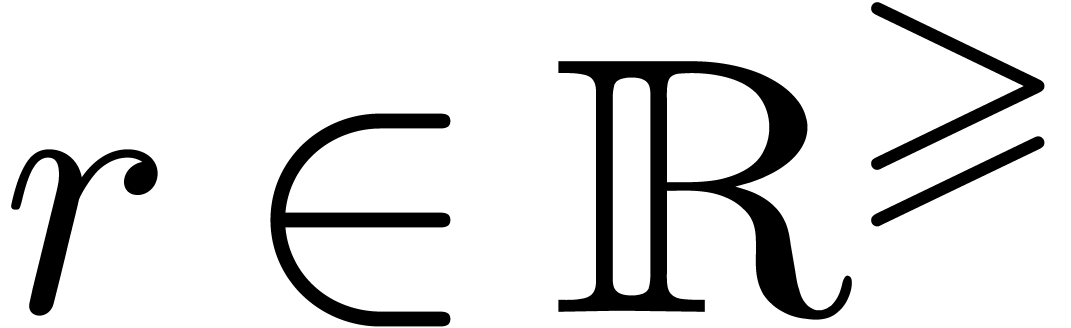

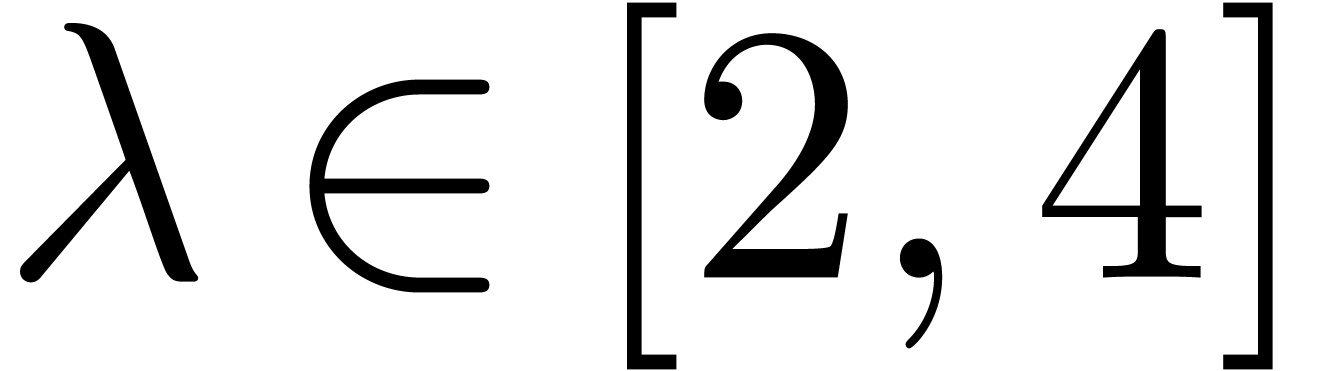

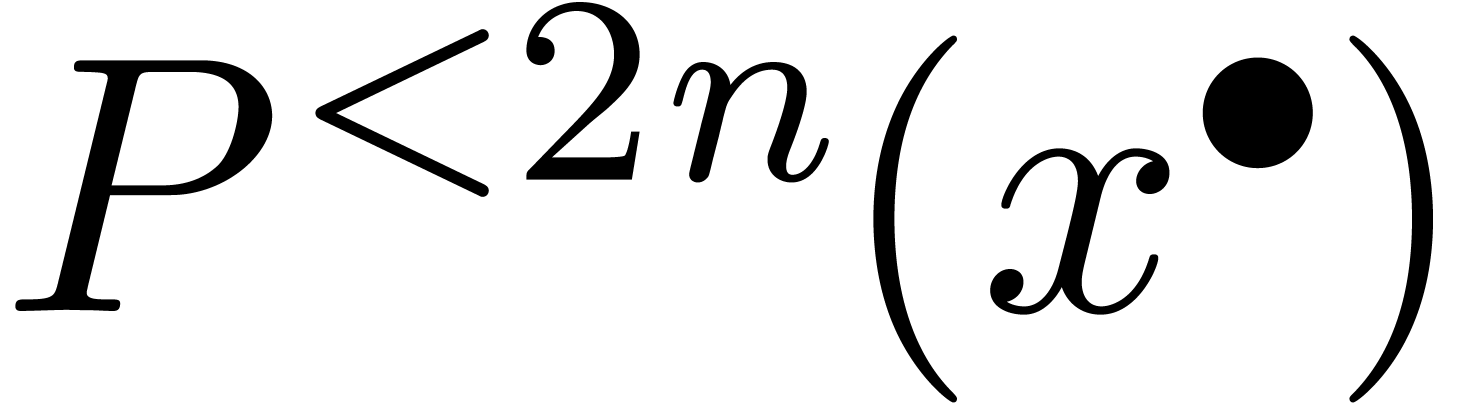

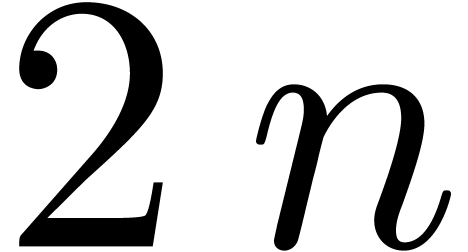

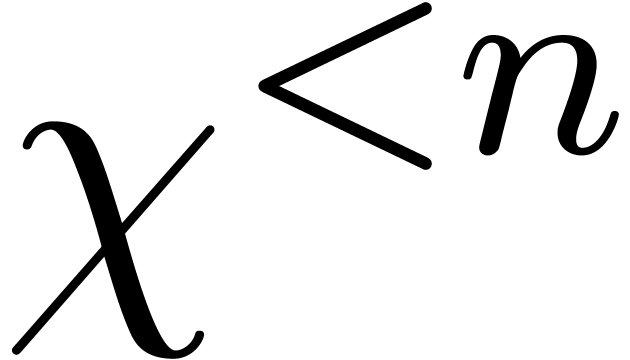

Théorème 2.4. Considérons un système dynamique avec conditions initiales

où  et

et  .

D'après Cauchy, ce système admet une unique solution

.

D'après Cauchy, ce système admet une unique solution  . Cette solution est convergente en

. Cette solution est convergente en

.

.

Il n'existe pas d'algorithme pour calculer le rayon de convergence de

.

.

Comme exercice, le lecteur pourra essayer de déterminer lesquels des problèmes suivants sont calculables :

Racines d'un polynôme unitaire à coefficients dans

Racines réelles d'un polynôme unitaire à

coefficients dans

Racines complexes d'un système polynomial

zéro-dimensionnel sur

Vecteur propres d'une matrice à coefficients dans

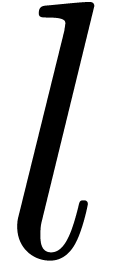

Calcul d'une primitive d'une fonction calculable sur

Calcul de la dérivée d'une fonction  calculable sur

calculable sur

Calcul de la dérivée d'une fonction analytique

calculable sur

Calcul d'une racine de  avec

avec

Remarque 2.5. Subtilité concernant le dernier

problème : il existe une fonction qui prend en entrée une

représentation  d'un

polynôme

d'un

polynôme  avec

avec  , et qui retourne une racine

, et qui retourne une racine  de

de  . Le hic réside

dans le fait que cette fonction peut retourner deux racines distinctes

pour deux représentations différentes du même

polynôme

. Le hic réside

dans le fait que cette fonction peut retourner deux racines distinctes

pour deux représentations différentes du même

polynôme  .

.

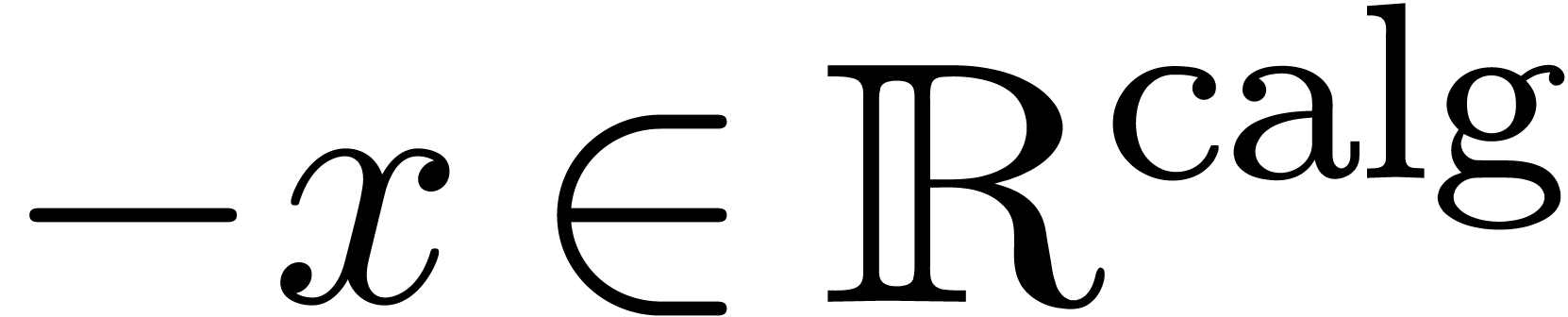

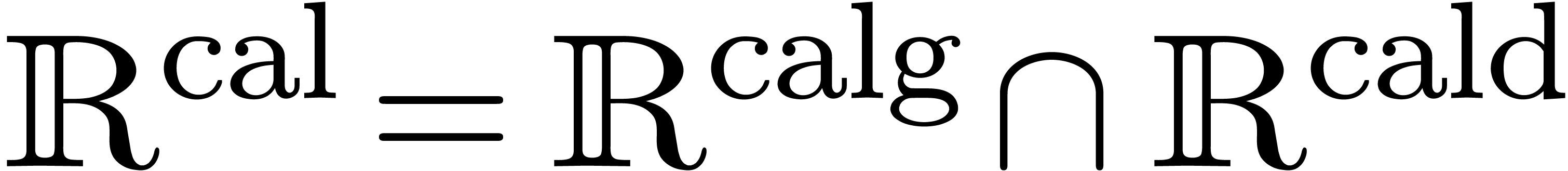

Les théorèmes de non calculabilité de la section 2.2 sont inutilement pessimistes. Par exemple, le

théorème de Turing ne rend pas compte du fait suivant :

étant donné un nombre  ,

on peut démontrer en temps fini que

,

on peut démontrer en temps fini que  ,

si tel est en effet le cas. Pour mieux cerner ce qui reste calculable,

il est utile d'introduire les ensembles de nombres réels

calculables à gauche et à droite, et qui reflètent

mieux l'asymmétrie profonde de l'analyse calculable entre

l'égalité et l'inégalité.

,

si tel est en effet le cas. Pour mieux cerner ce qui reste calculable,

il est utile d'introduire les ensembles de nombres réels

calculables à gauche et à droite, et qui reflètent

mieux l'asymmétrie profonde de l'analyse calculable entre

l'égalité et l'inégalité.

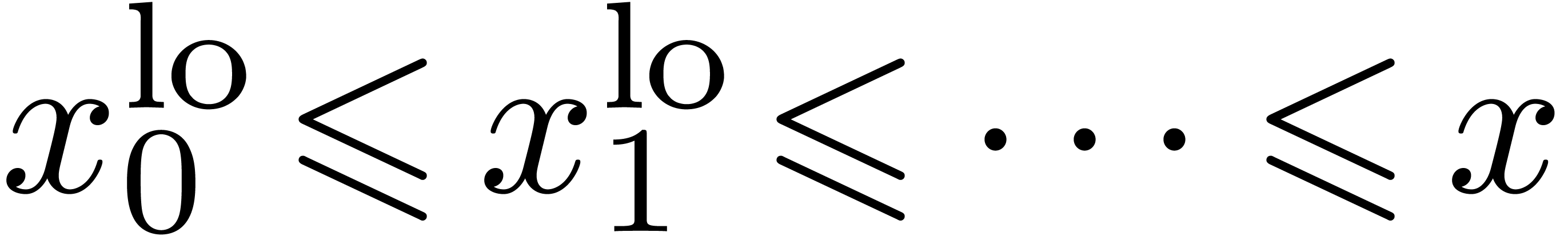

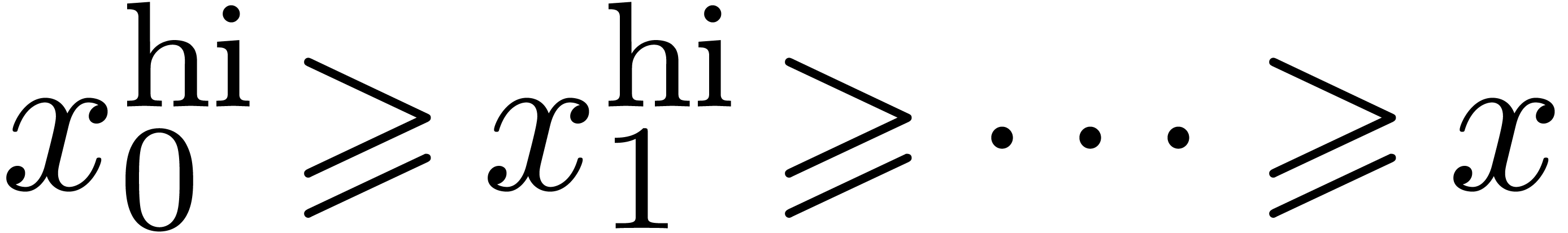

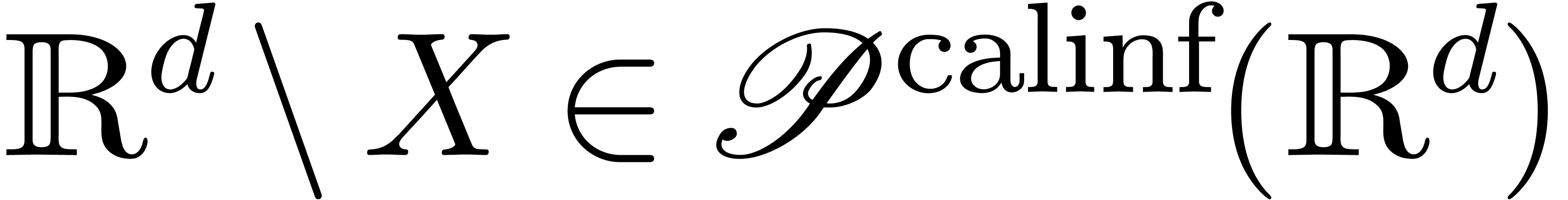

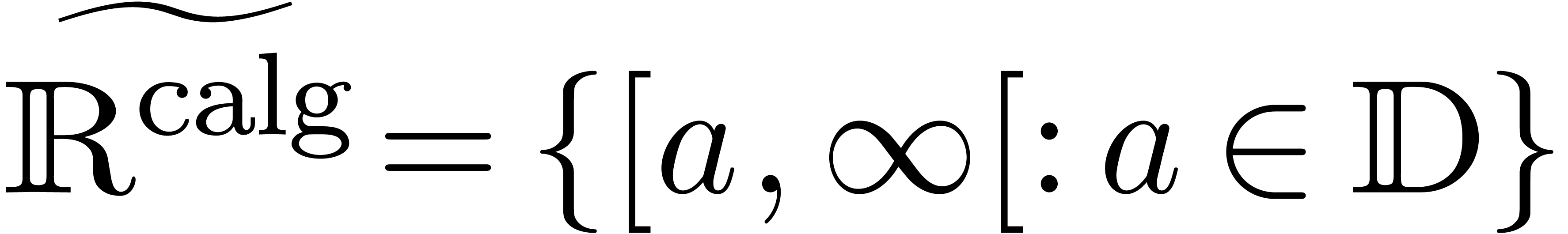

s'il existe

s'il existe  calculable avec

calculable avec  et

et

si

si  .

On a

.

On a

On peut introduire une ribambelle de notions de calculabilité en poursuivant sur cette voie. Par exemple :

s'il existe

s'il existe  calculable avec

calculable avec  ,

où chaque

,

où chaque  est une réunion

finie de « blocks » fermés à

extrémités dans

est une réunion

finie de « blocks » fermés à

extrémités dans

si

si

Il est utile de considérer des ensembles comme  ,

,  ,

,

,

,  , etc. comme des types de données

concrets, pouvant intervenir dans des implantations. On peut

d'ailleurs construire plein d'autres types du même acabit, comme

les booléens à droite

, etc. comme des types de données

concrets, pouvant intervenir dans des implantations. On peut

d'ailleurs construire plein d'autres types du même acabit, comme

les booléens à droite  ou les

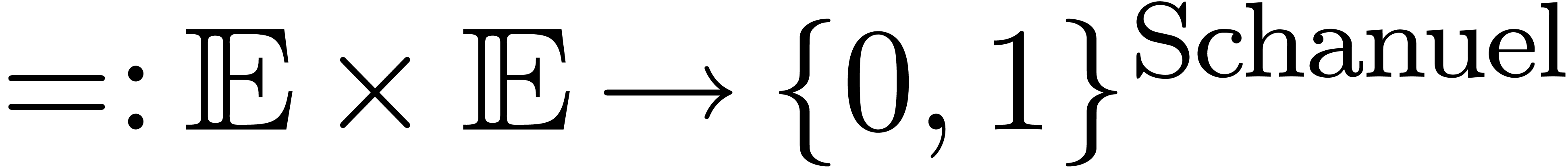

« booléens modulo la conjecture de Schanuel »

ou les

« booléens modulo la conjecture de Schanuel »  .

.

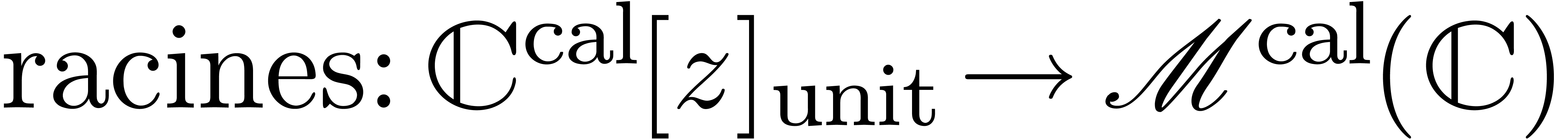

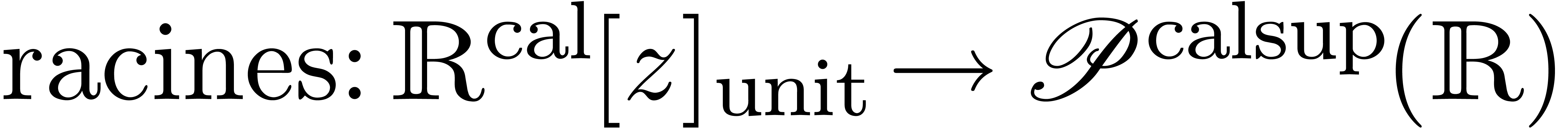

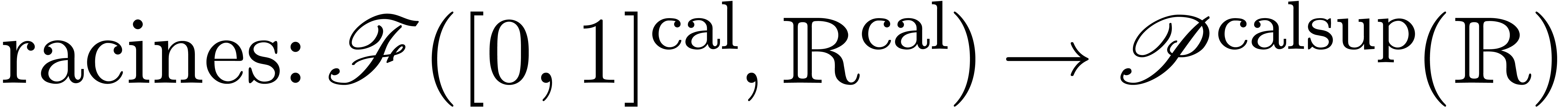

Ces types de données plus fins permettent de transformer les énoncés quelque peu négatives de la section 2.2 en assertions plus positives :

calculable

calculable

calculable implique

calculable implique

calculable

calculable

calculable (

calculable ( pour

multi-ensembles)

pour

multi-ensembles)

calculable

calculable

calculable

calculable

calculable (égalité modulo

conjecture de Schanuel)

calculable (égalité modulo

conjecture de Schanuel)

D'un point de vue logique, les types de données peuvent

être vu comme des « structures effectives » sur un

ensemble  . Chaque

élément de

. Chaque

élément de  admet alors une

représentation dans un ensemble

admet alors une

représentation dans un ensemble  de

représentations. Chaque représentation peut s'encoder

à son tour par un entier dans

de

représentations. Chaque représentation peut s'encoder

à son tour par un entier dans  ,

et donc être manipulée par des machines de Turing.

,

et donc être manipulée par des machines de Turing.

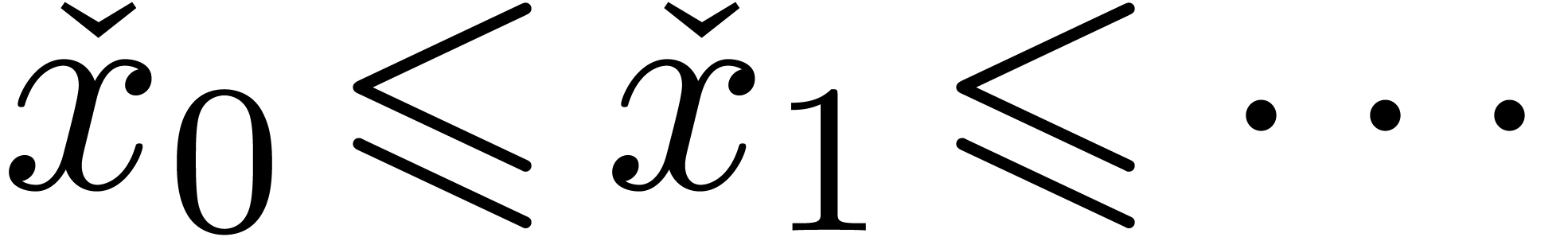

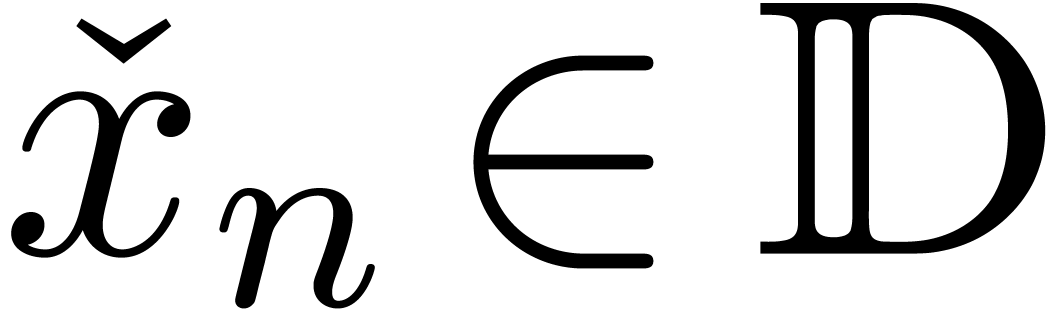

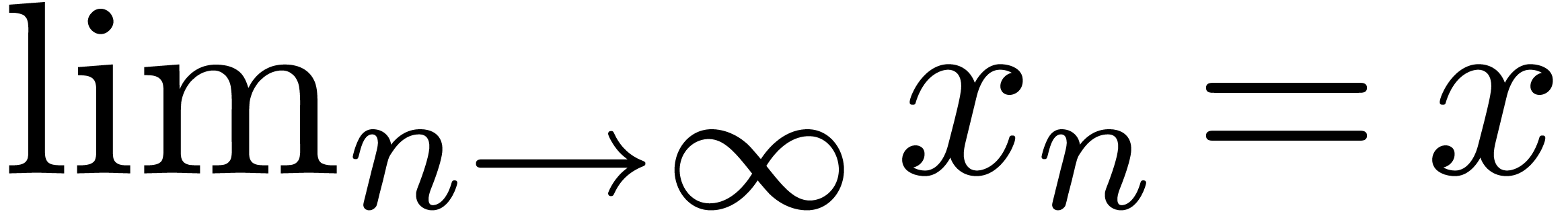

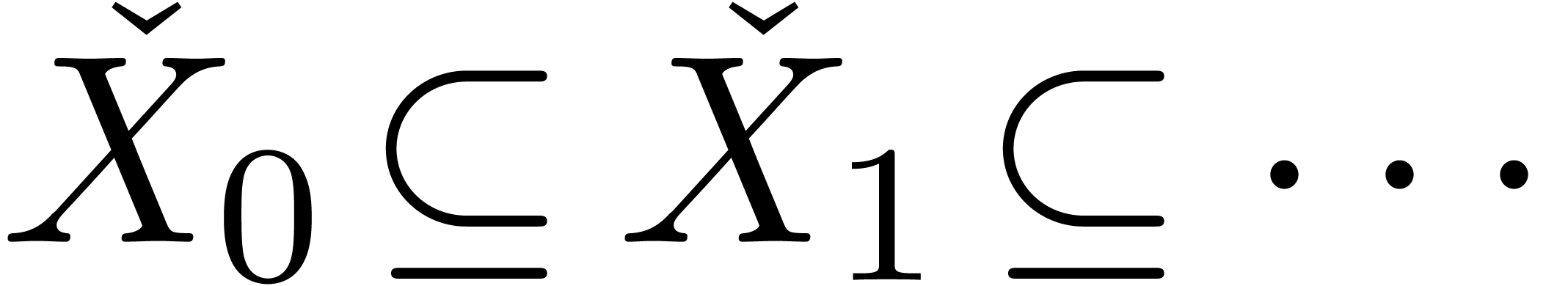

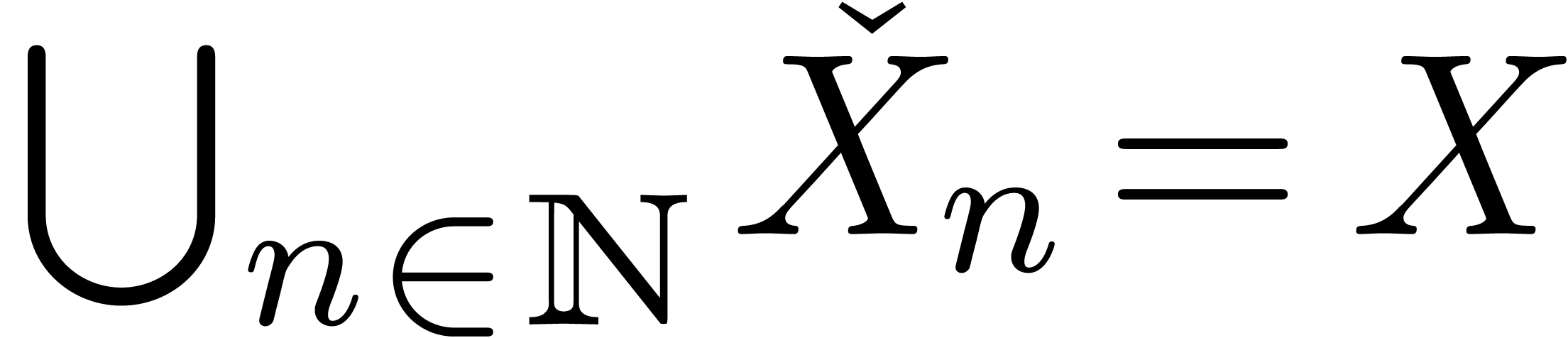

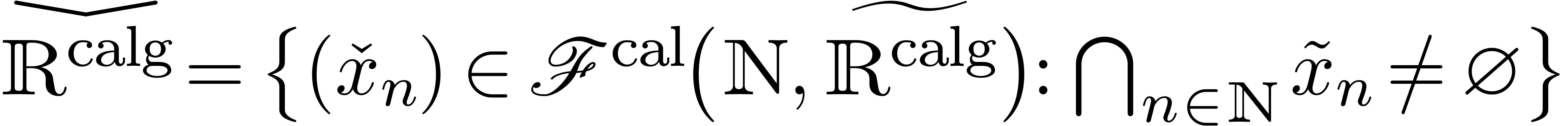

Par exemple, un nombre dans  pourrait être

représenté par une suite calculable croissante :

pourrait être

représenté par une suite calculable croissante :

Il est à noter que, de même que l'on peut définir

plusieurs structures de groupe sur un ensemble  à quatre éléments, on peut définir plusieurs

structures effectives sur

à quatre éléments, on peut définir plusieurs

structures effectives sur  : on a bien sûr

: on a bien sûr

, mais aussi

, mais aussi  et

et  . La représentation

d'un élément de

. La représentation

d'un élément de  pourrait

être une fonction qui retourne un élément de

pourrait

être une fonction qui retourne un élément de  si la conjecture de Schanuel est vraie.

si la conjecture de Schanuel est vraie.

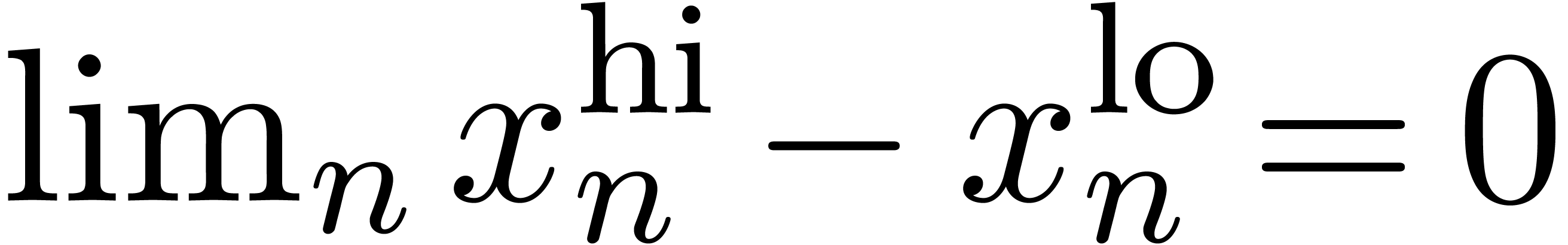

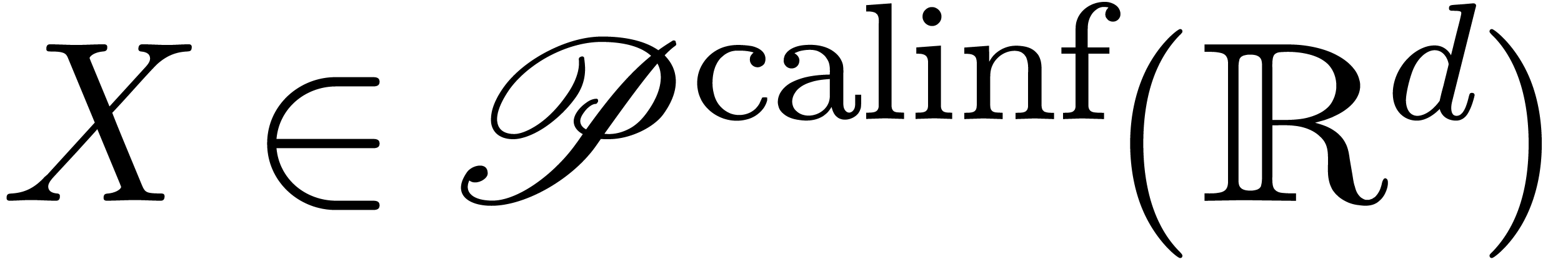

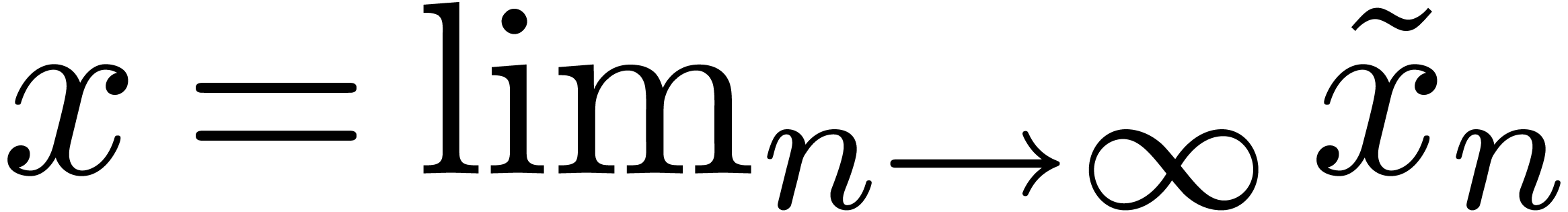

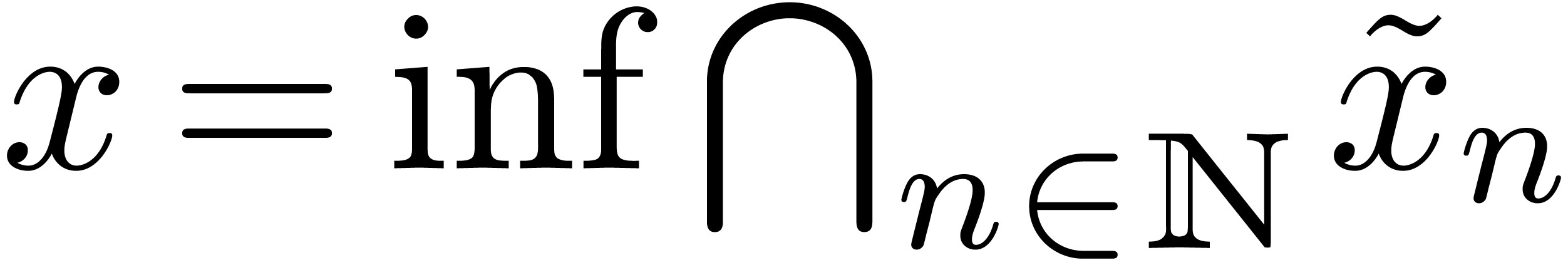

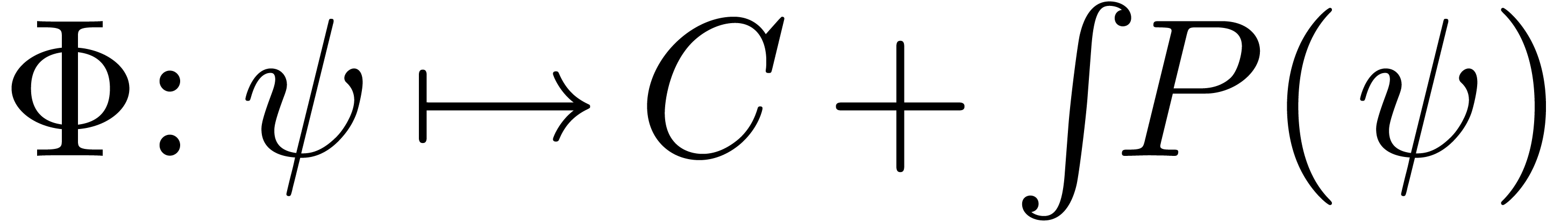

En analyse, les objets que l'on manipule correspondent généralement à des résultats de processus d'approximation. Il s'agit donc de structures effectives d'une nature particulière :

: ensemble abstrait d'approximations

d'éléments dans

: ensemble abstrait d'approximations

d'éléments dans

:

:  est la limite des

approximations

est la limite des

approximations

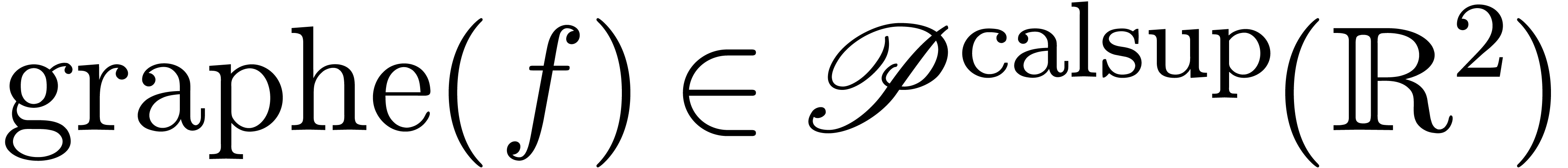

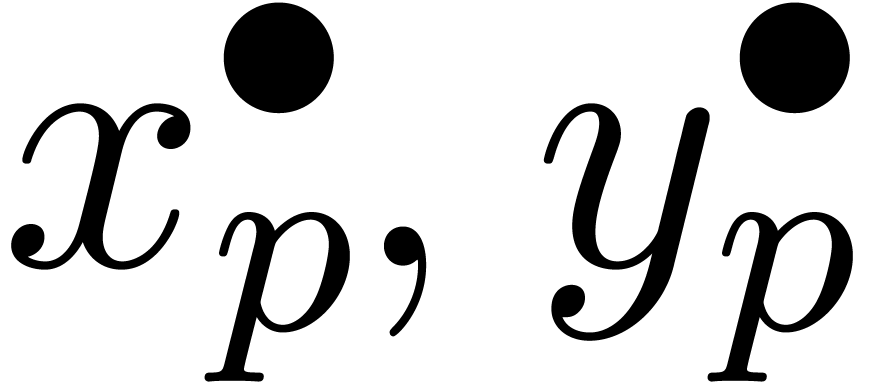

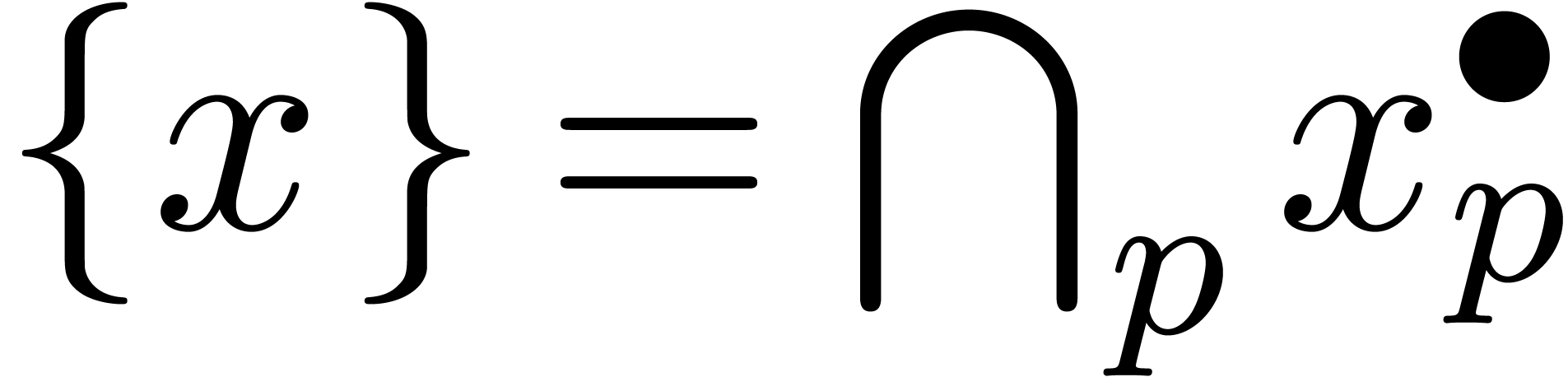

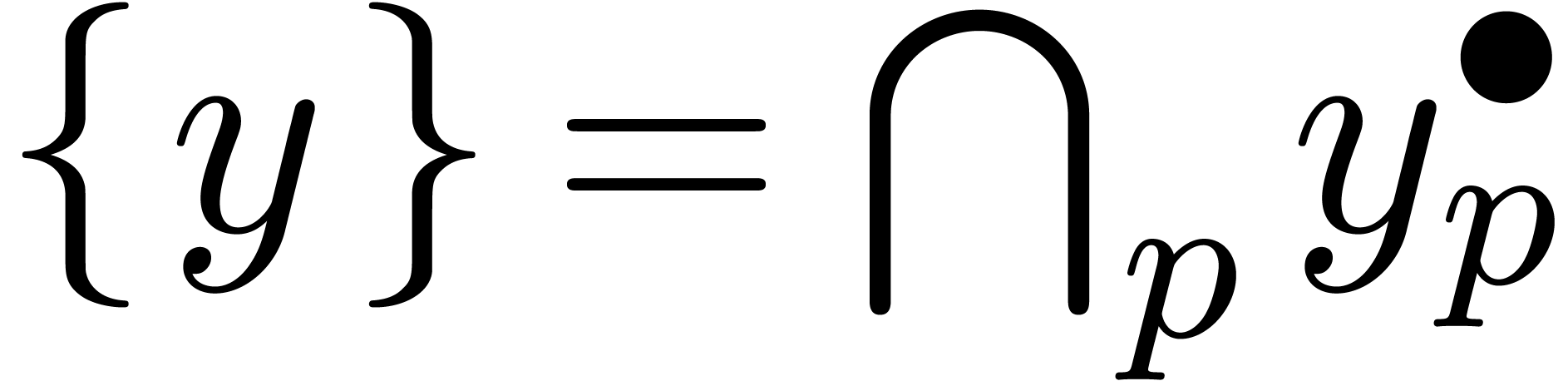

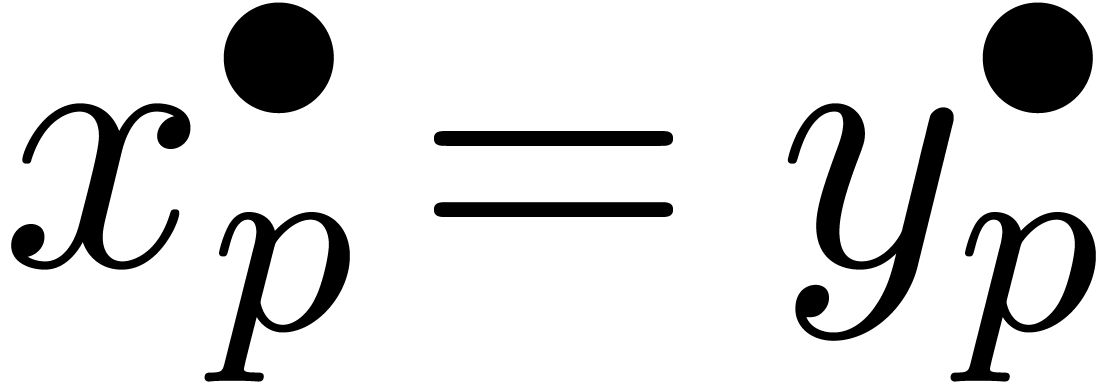

Le plus souvent,  est constitué de parties

de

est constitué de parties

de  (comme des intervalles ou des boules dans le

cas où

(comme des intervalles ou des boules dans le

cas où  ) et la notion

de limite correspond à prendre une intersection. Par exemple :

) et la notion

de limite correspond à prendre une intersection. Par exemple :

si

si

Toutefois, il faut parfois tordre un peu la notion de limite :

si

si

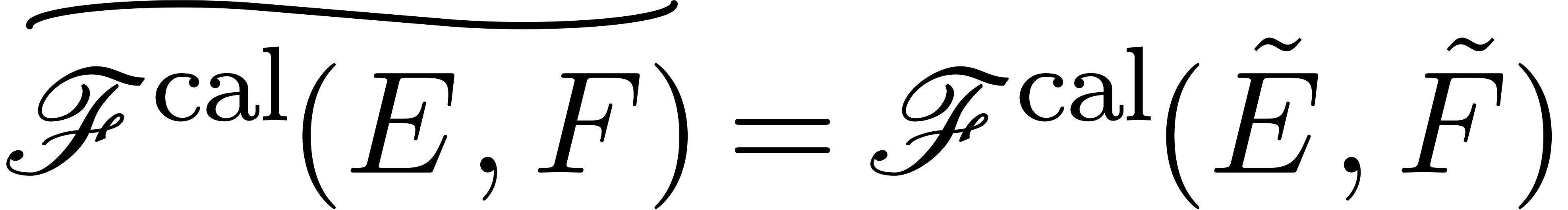

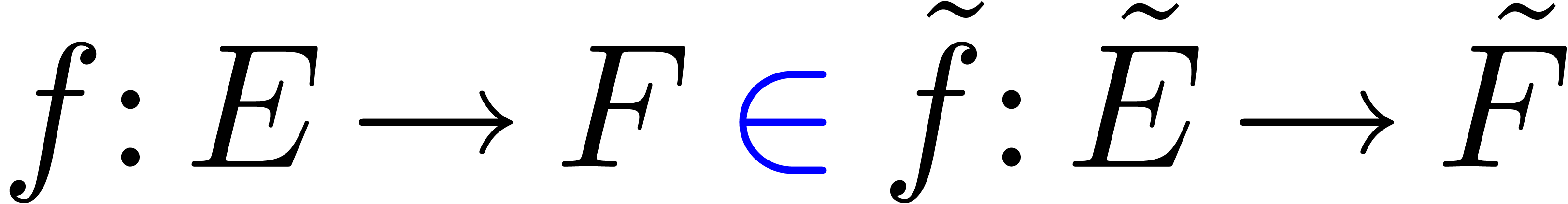

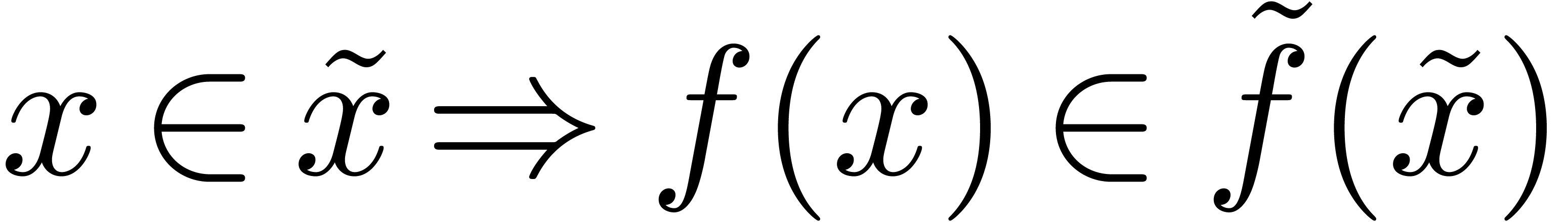

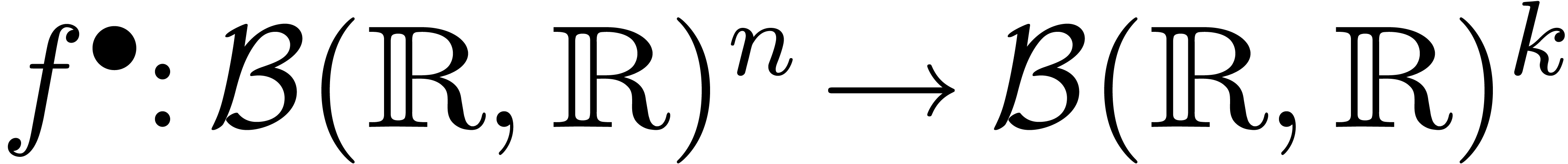

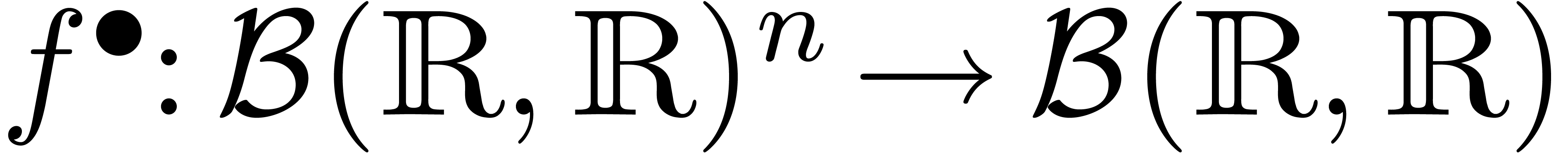

L'intérêt de cette formalisation est une certaine

fonctorialité. Par exemple, si on peut approcher les

éléments de  et de

et de  , il en est de même pour les

éléments de

, il en est de même pour les

éléments de  et les fonctions dans

et les fonctions dans

de

de  vers

vers  :

:

si si |

|

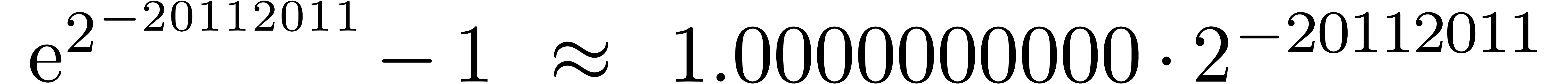

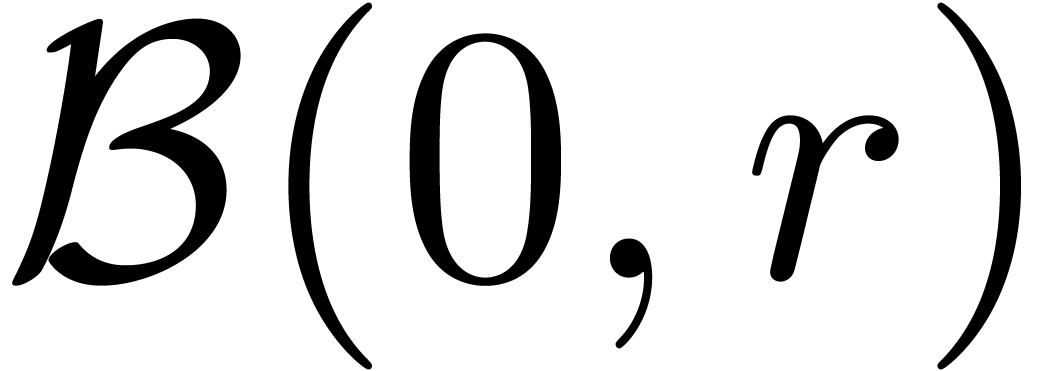

Dans la définition 2.1, nous avions choisi d'approcher les nombres réels par des rationnels. Malheureusement, de telles approximations ne sont pas des plus judicieuses si nous voulons borner de façon automatique les erreurs intervenant dans un calcul complexe.

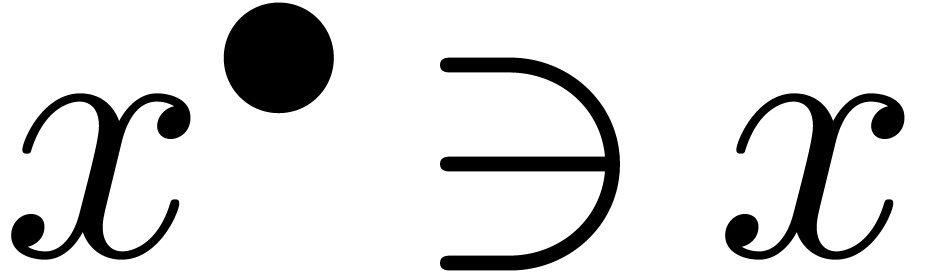

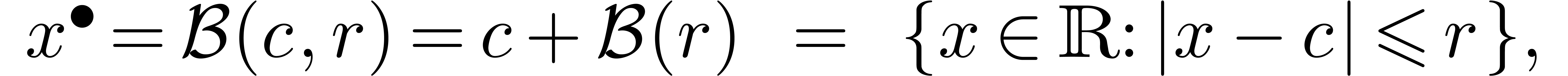

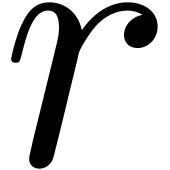

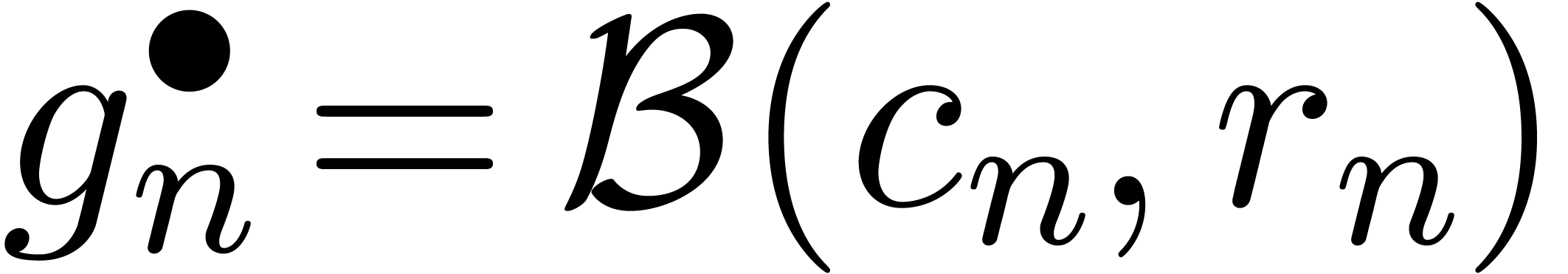

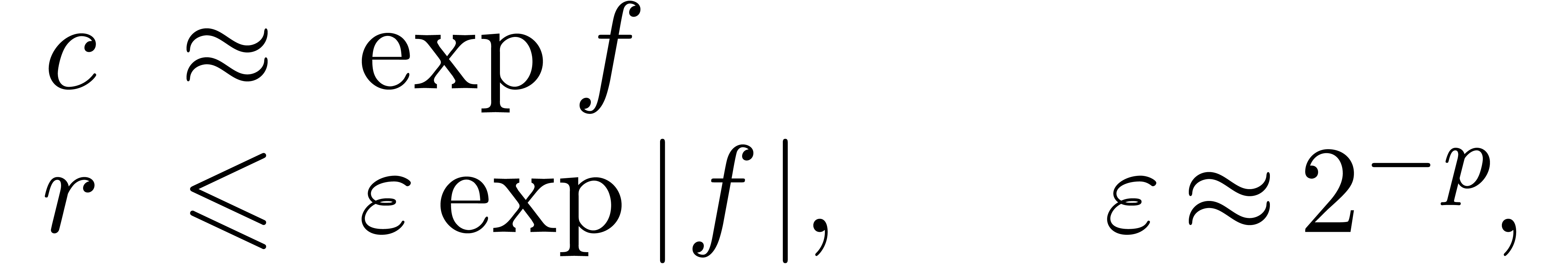

Pour cette raison (voir aussi la section 2.3.4), il est

plus commode d'approcher un nombre réel donné  non pas par d'autres nombres

non pas par d'autres nombres  avec

avec

« petit », mais plutôt par des

boules fermées

« petit », mais plutôt par des

boules fermées  de la forme

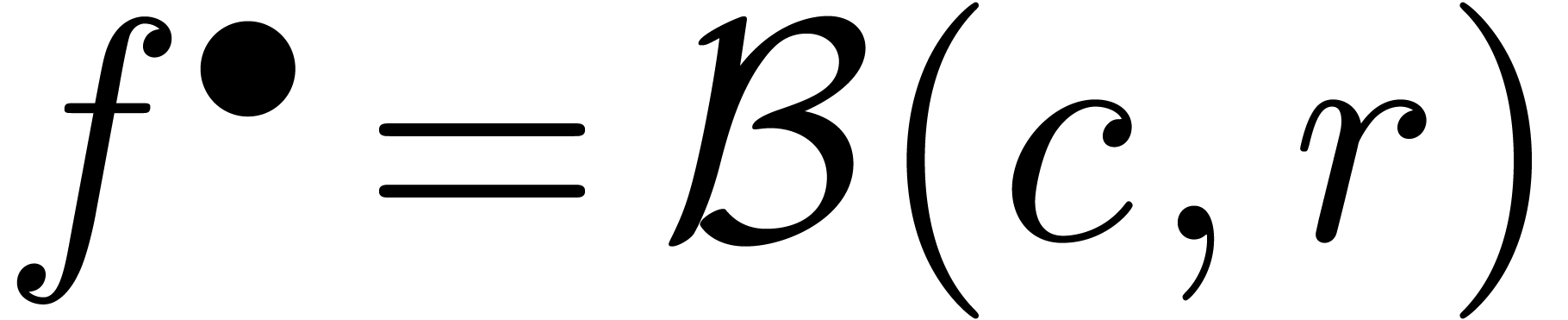

de la forme

avec  et

et  .

Ainsi, lorsque

.

Ainsi, lorsque  est le résultat d'un

calcul par arithmétique de boules, on est sûr que

le « vrai résultat »

est le résultat d'un

calcul par arithmétique de boules, on est sûr que

le « vrai résultat »  est dans

est dans

. On peut donc

interpréter une boule

. On peut donc

interpréter une boule  comme un «

nombre

comme un «

nombre  que l'on ne connait pas, mais pour lequel

on est sûr que

que l'on ne connait pas, mais pour lequel

on est sûr que  ».

».

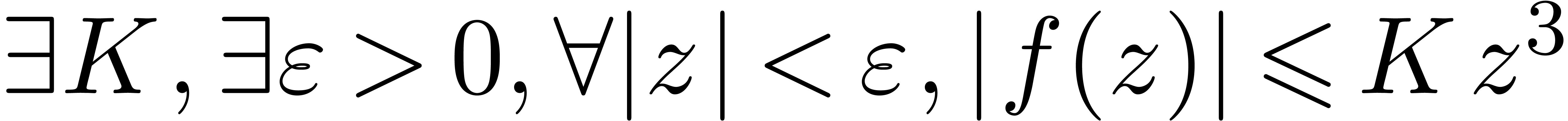

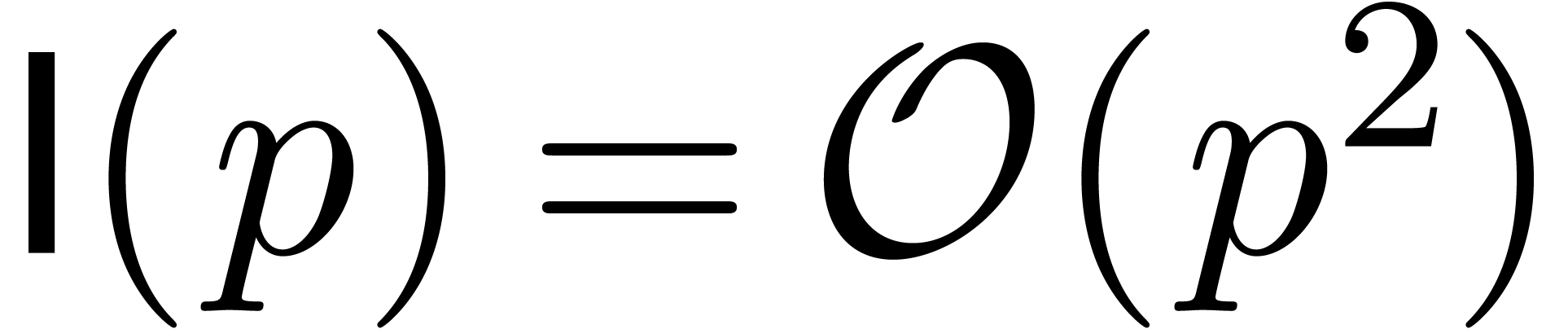

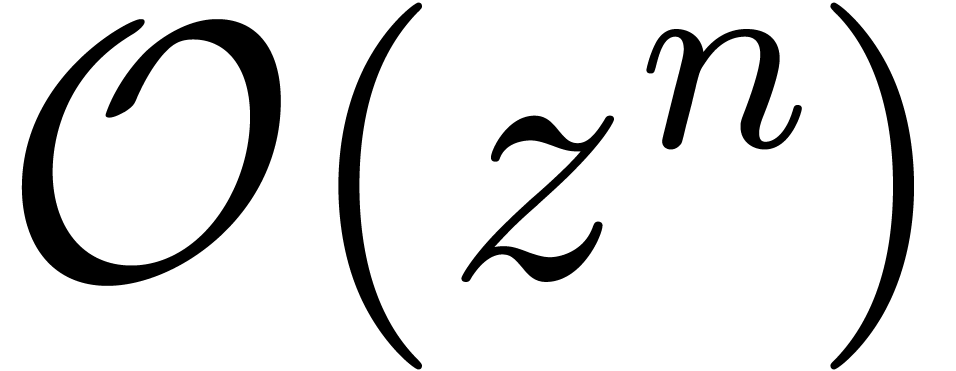

Remarque 3.1. Ce principe de calcul n'est pas tout à fait

nouveau d'un point de vue historique. En effet, on peut observer que les

notations  et

et  de Landau

s'interprètent de la même manière. Par exemple, dans

de Landau

s'interprètent de la même manière. Par exemple, dans

, le terme

, le terme  désigne « une quantité

désigne « une quantité  que

l'on ne connaît pas, mais pour lequel on est sûr que

que

l'on ne connaît pas, mais pour lequel on est sûr que  ».

».

Remarque 3.2. Au lieu d'encadrer les nombres  par des boules, on peut aussi les encadrer par des intervalles

fermées

par des boules, on peut aussi les encadrer par des intervalles

fermées  . Ceci conduit

à l'arithmétique d'intervalles, qui est plus classique et

pour laquelle existe une littérature abondante [54,

2, 57, 40, 9, 63] ; voir la section 3.1.4 pour une comparaison.

L'arithmétique de boules est parfois appelé «

arithmétique d'intervalles par centres et rayons » ou

« arithmétique d'intervalles circulaires ». J'ai

préféré un nom plus court, d'autant plus qu'une

boule complexe (par exemple) n'a rien à voir avec des

intervalles.

. Ceci conduit

à l'arithmétique d'intervalles, qui est plus classique et

pour laquelle existe une littérature abondante [54,

2, 57, 40, 9, 63] ; voir la section 3.1.4 pour une comparaison.

L'arithmétique de boules est parfois appelé «

arithmétique d'intervalles par centres et rayons » ou

« arithmétique d'intervalles circulaires ». J'ai

préféré un nom plus court, d'autant plus qu'une

boule complexe (par exemple) n'a rien à voir avec des

intervalles.

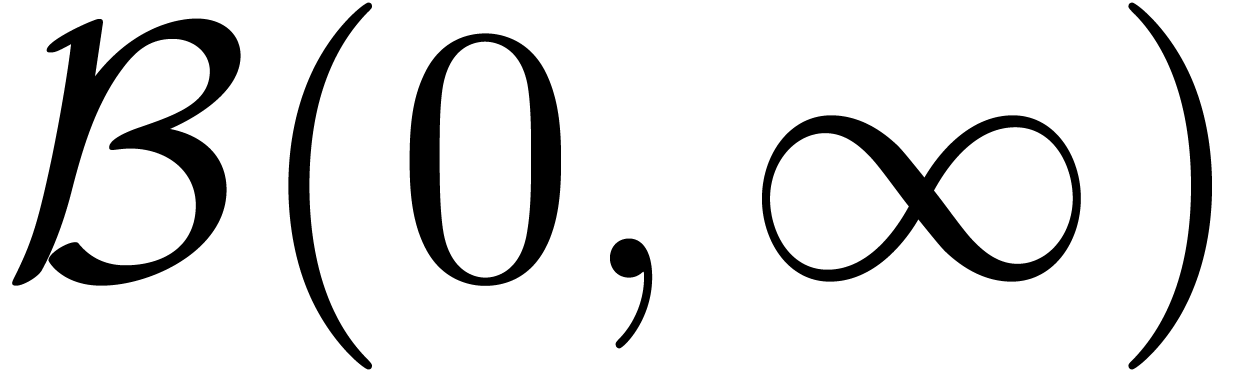

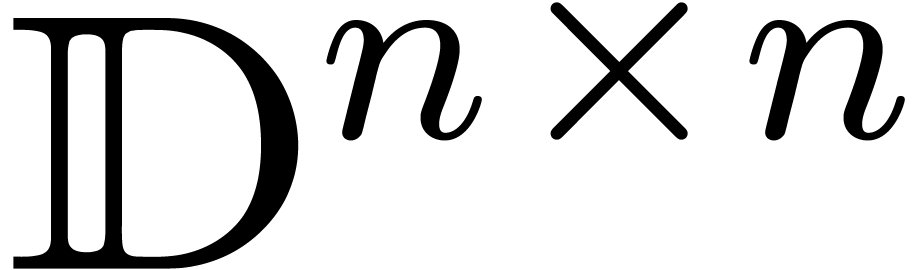

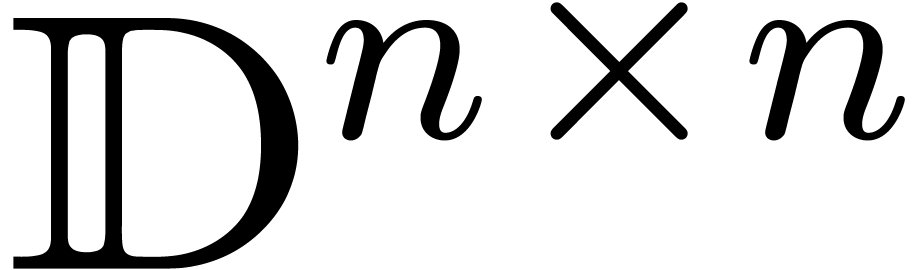

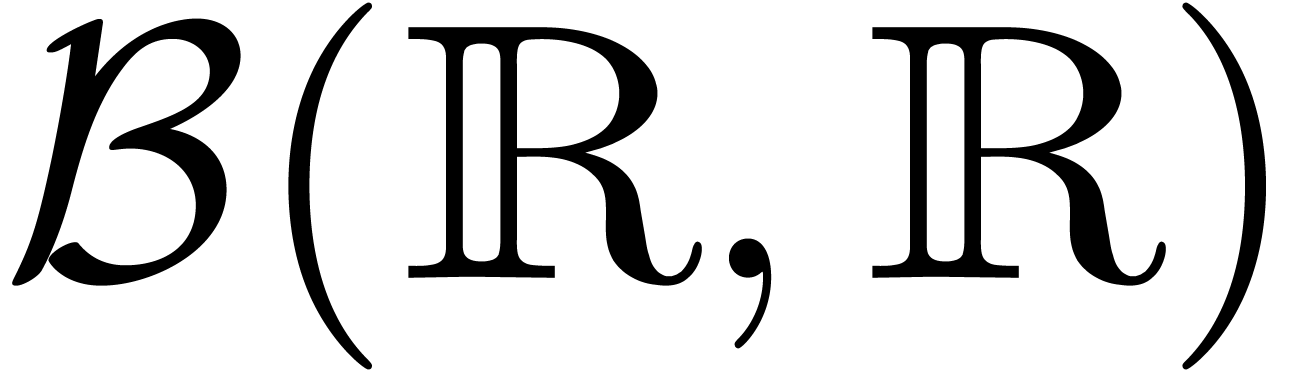

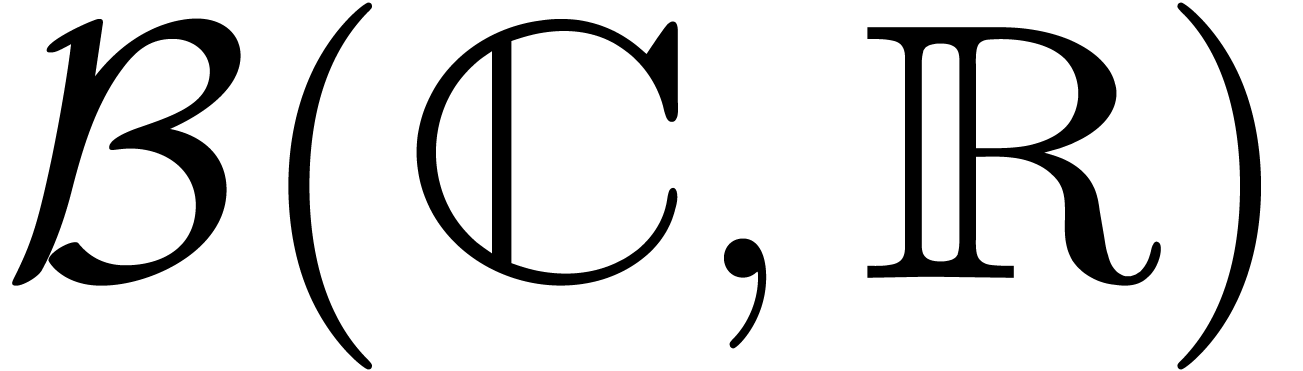

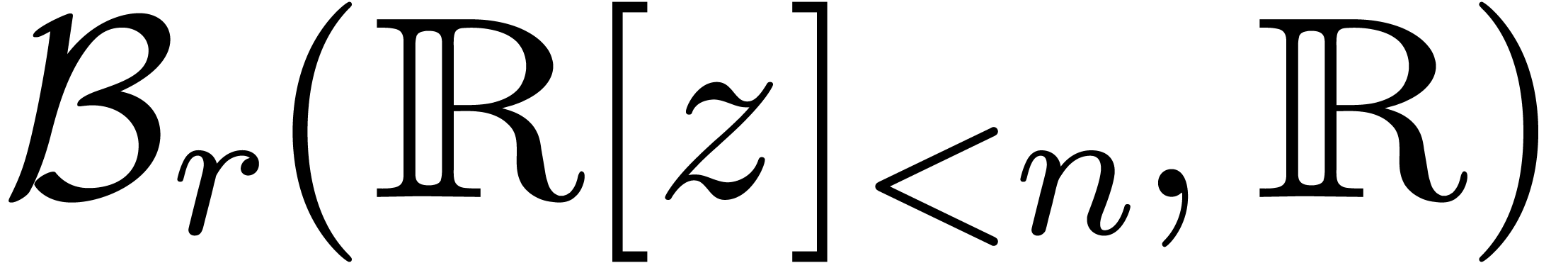

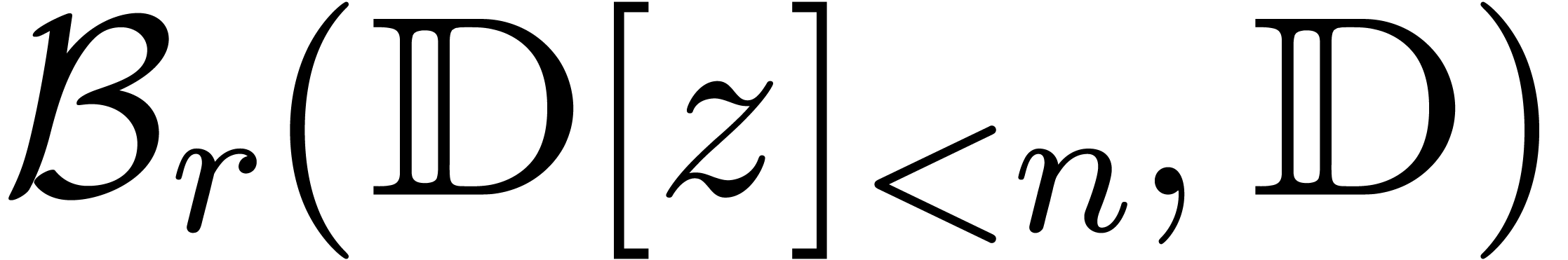

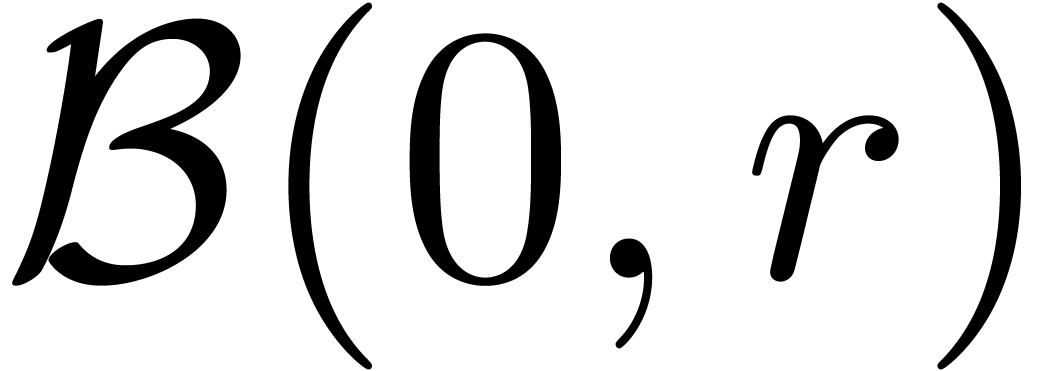

Bien sûr, on peut prendre des boules dans des espaces

métriques plus généraux que  , en commençant par

, en commençant par  . En fait, il n'est même pas impératif

que les rayons des boules vivent dans un espace métrique au sens

classique. Plus tard, on verra par exemple l'utilité de

considerer des boules dont les centres sont des matrices dans

. En fait, il n'est même pas impératif

que les rayons des boules vivent dans un espace métrique au sens

classique. Plus tard, on verra par exemple l'utilité de

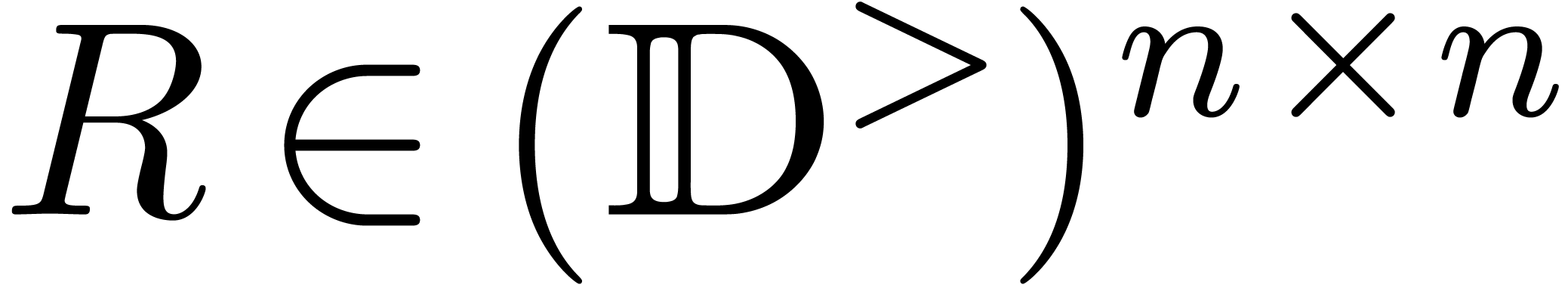

considerer des boules dont les centres sont des matrices dans  et dont les rayons sont également des matrices

à coefficients positifs dans

et dont les rayons sont également des matrices

à coefficients positifs dans  .

.

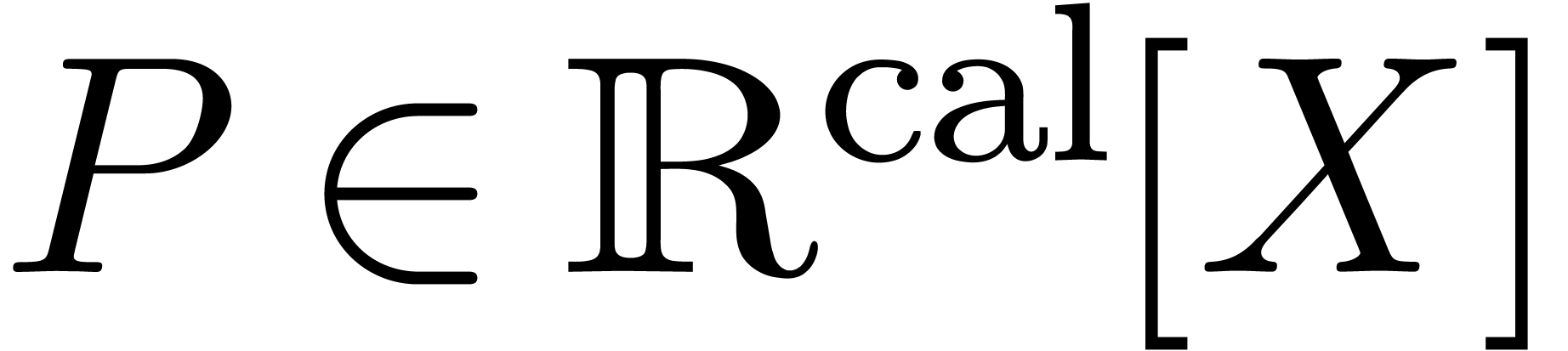

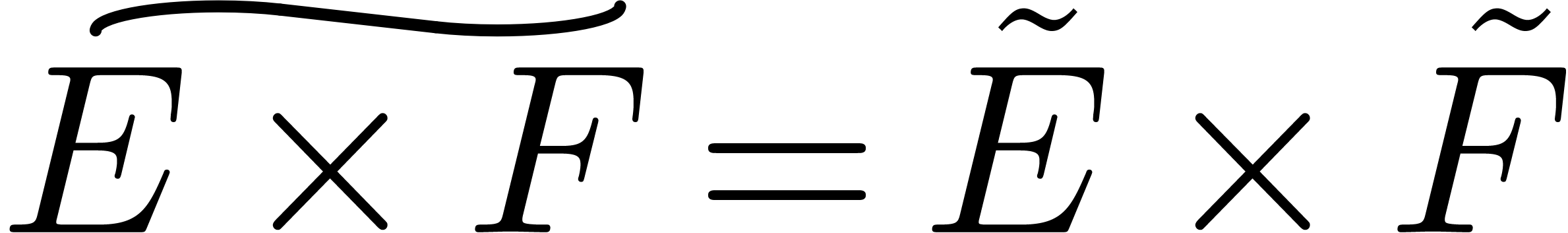

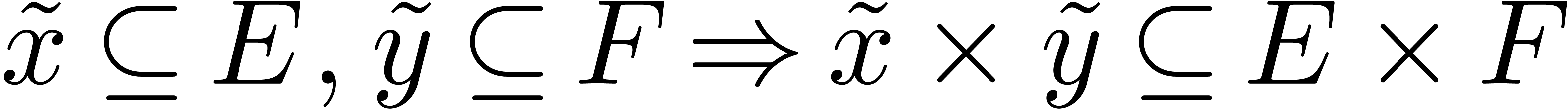

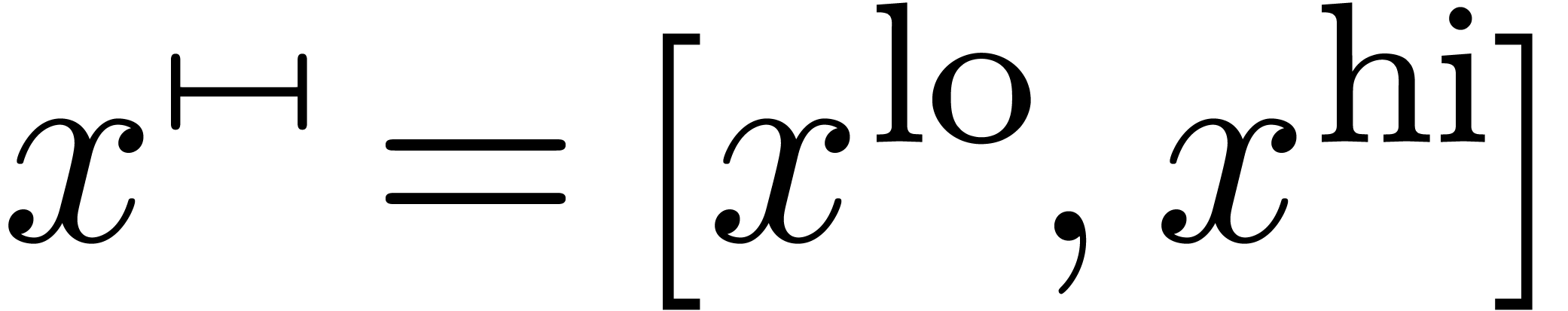

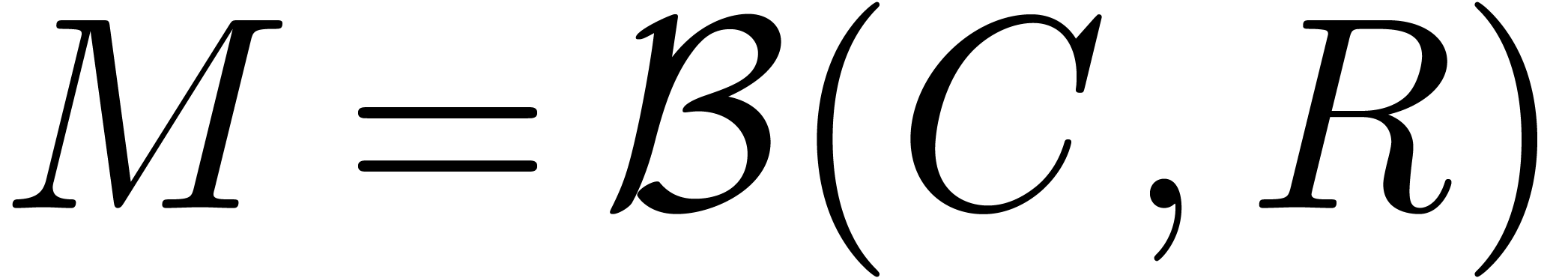

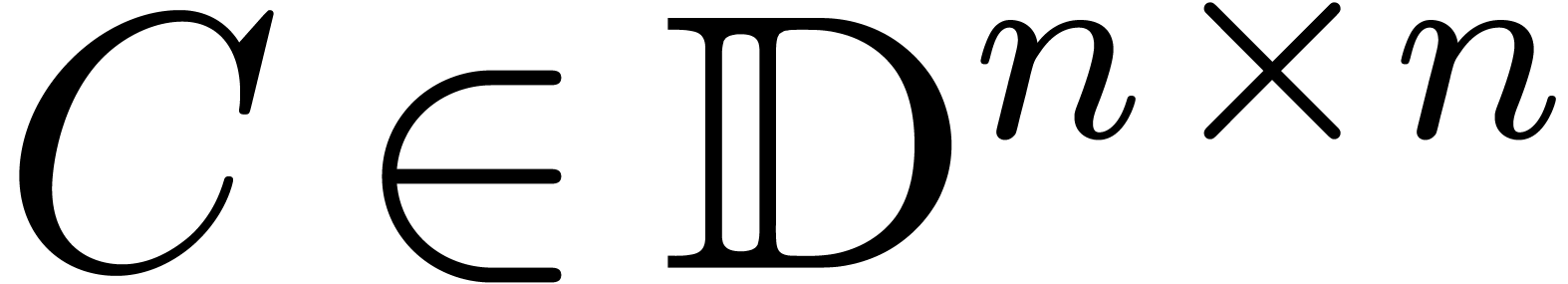

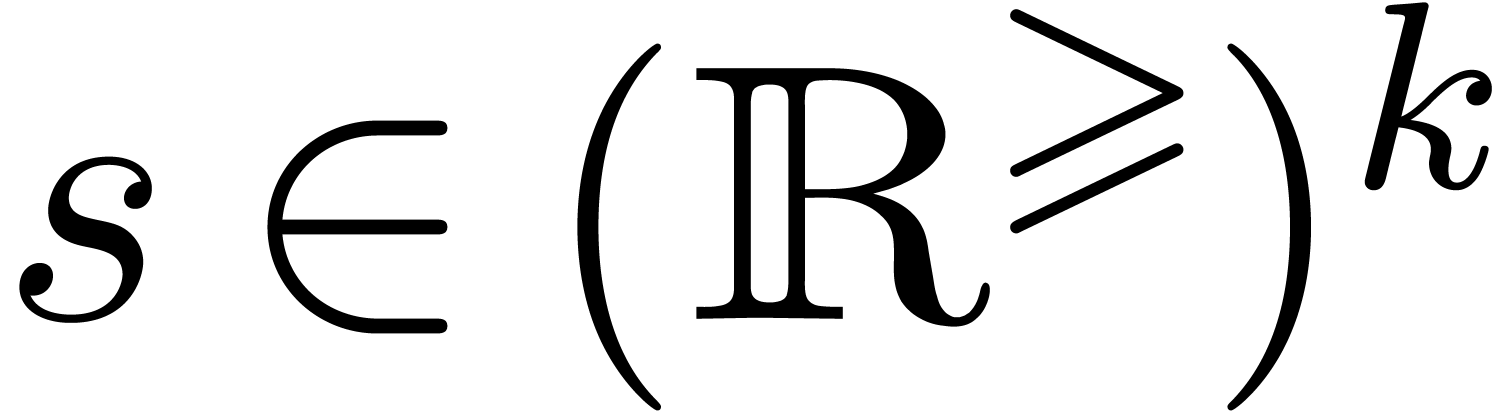

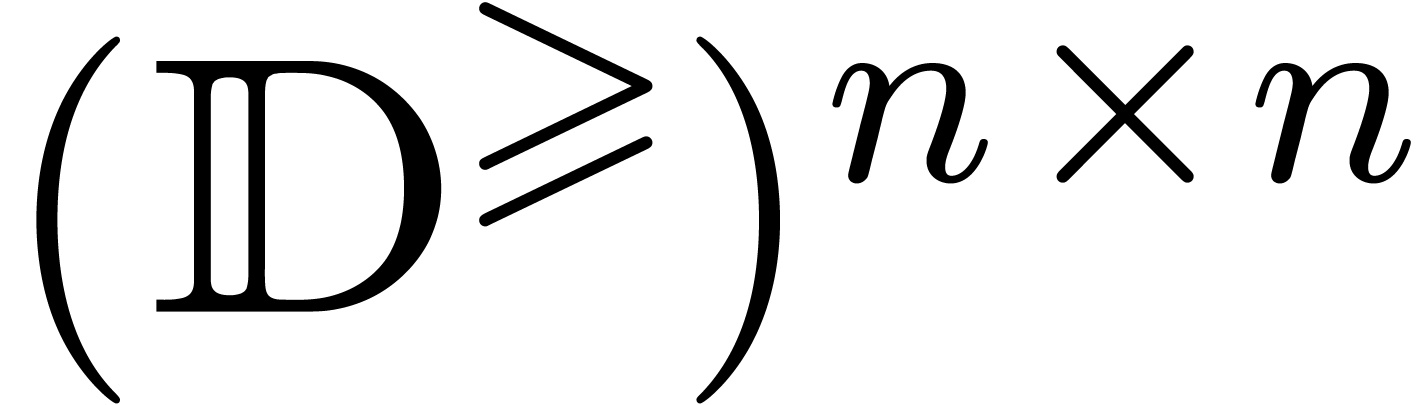

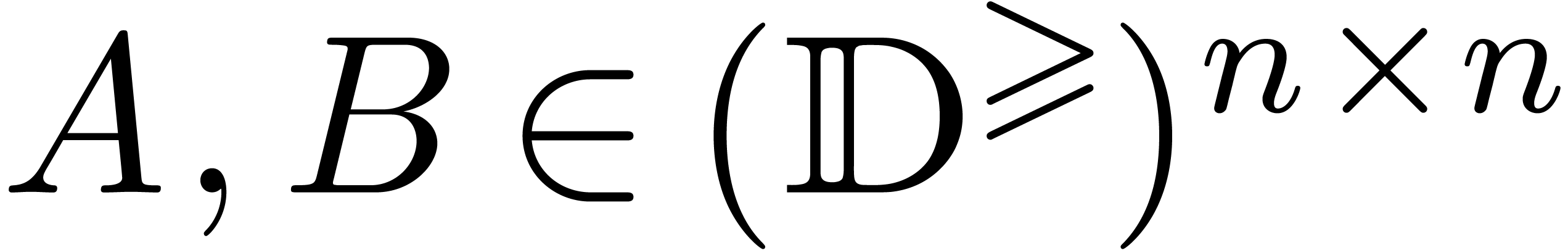

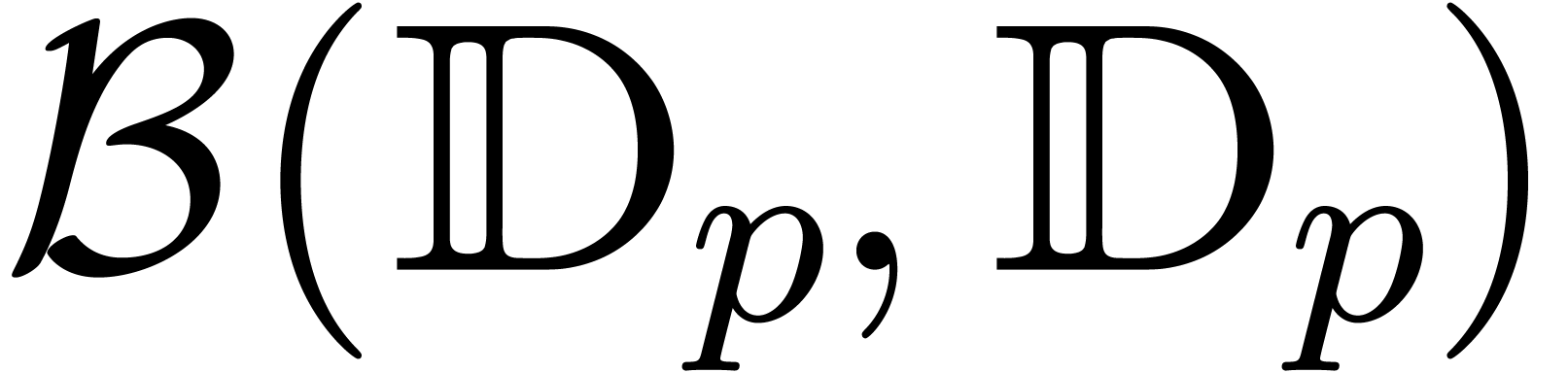

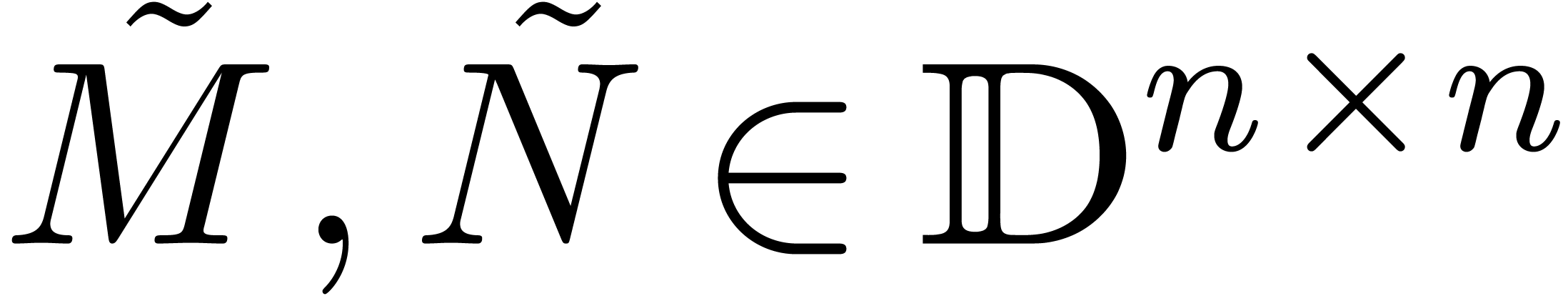

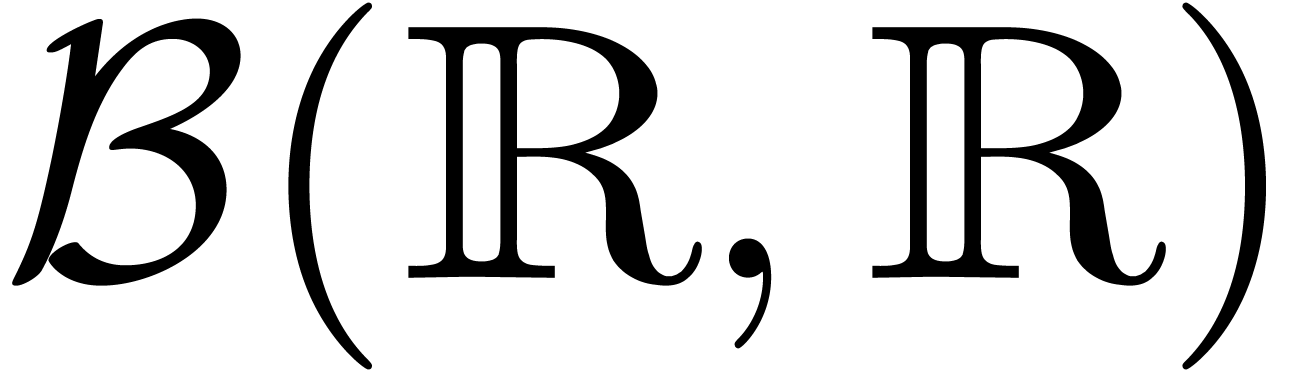

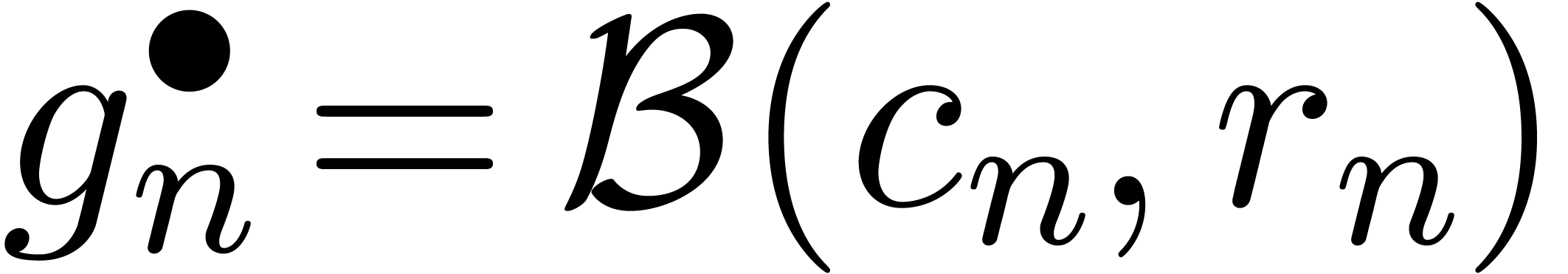

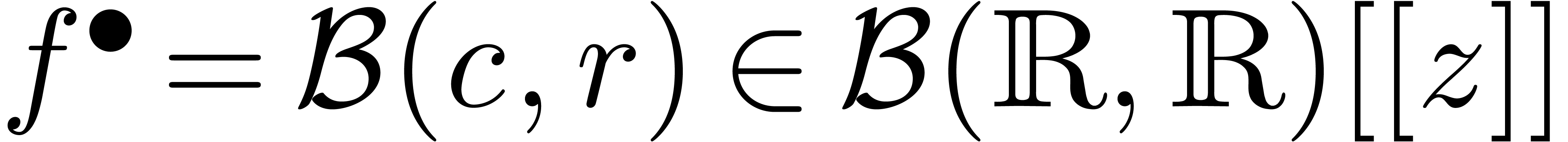

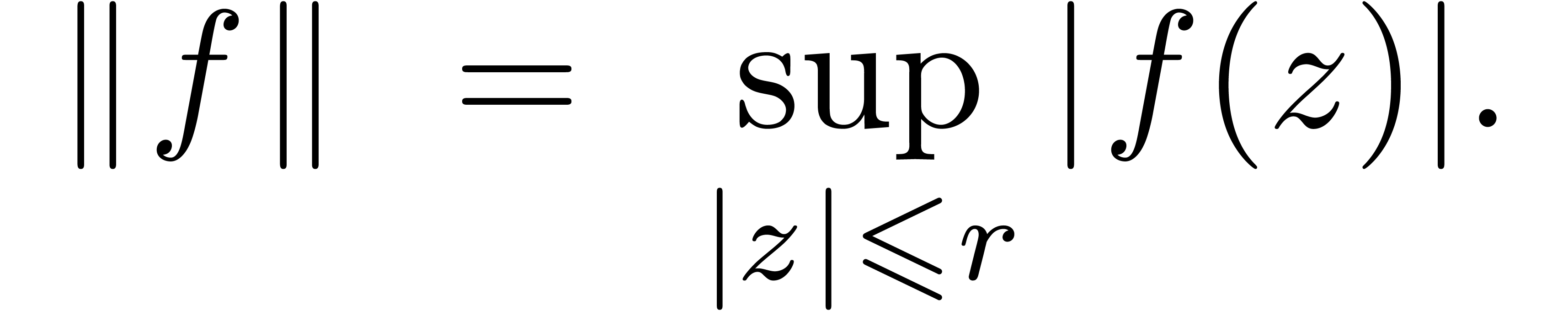

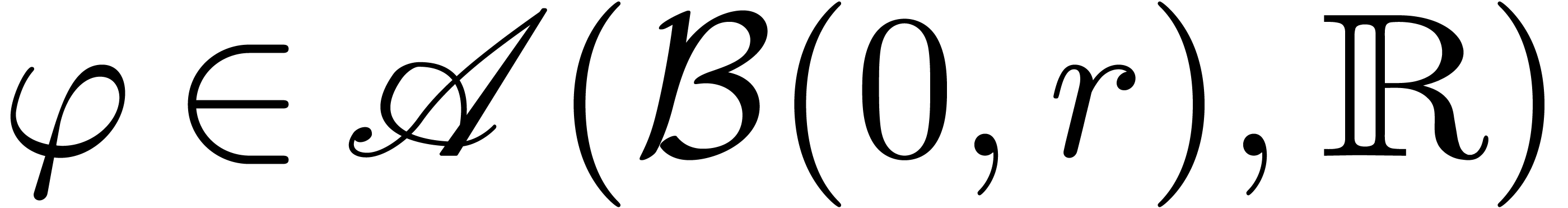

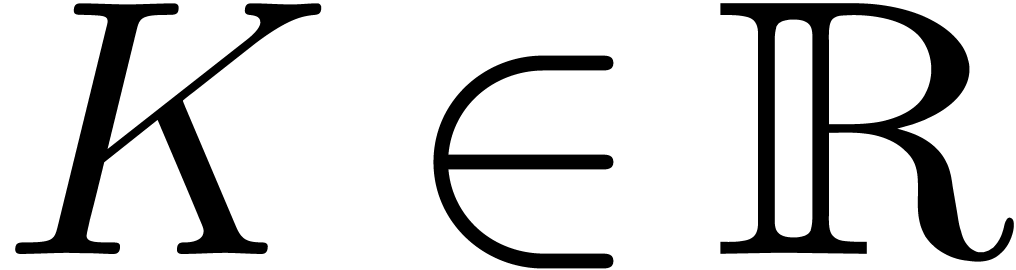

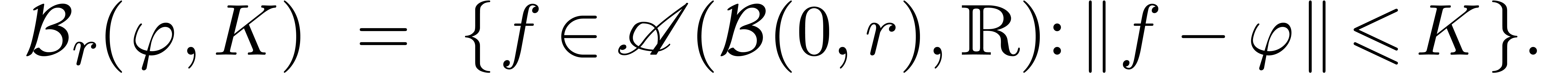

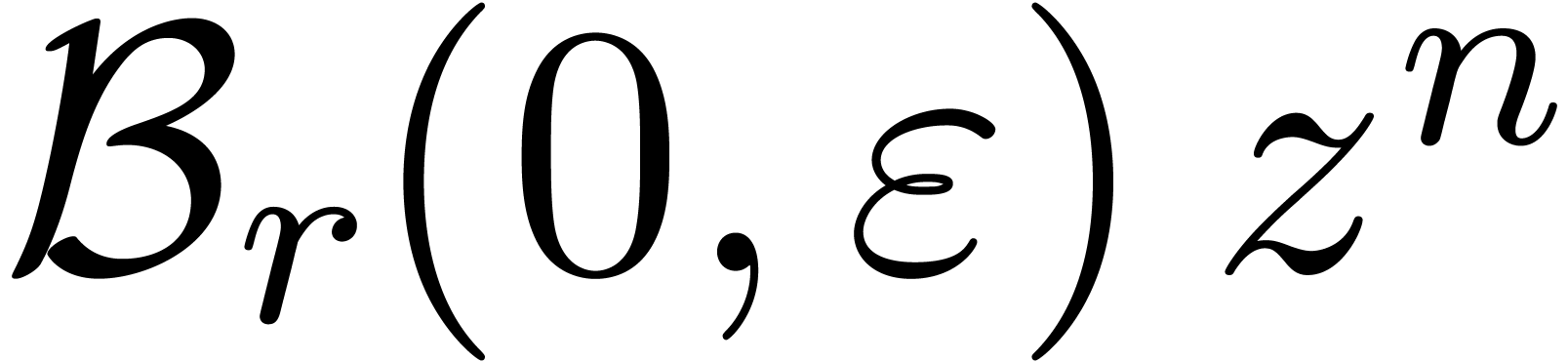

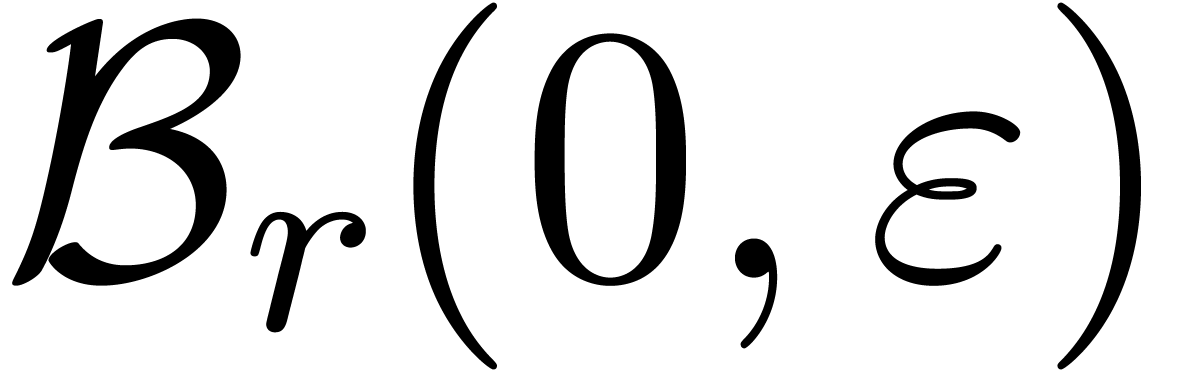

Dans la suite, étant donnés un ensemble  de centres et un ensemble

de centres et un ensemble  de rayons, on notera

par

de rayons, on notera

par  l'ensemble des boules avec des centres dans

l'ensemble des boules avec des centres dans

et des rayons dans

et des rayons dans  .

.

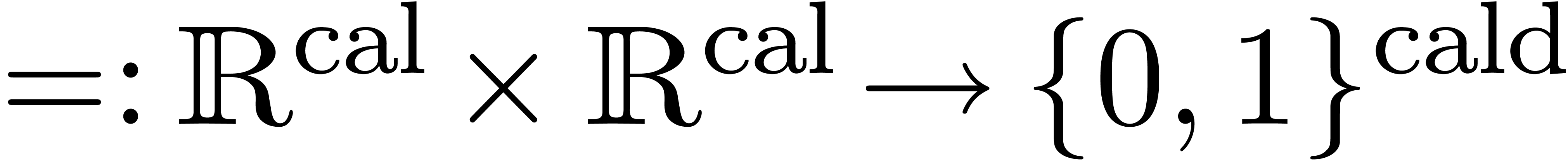

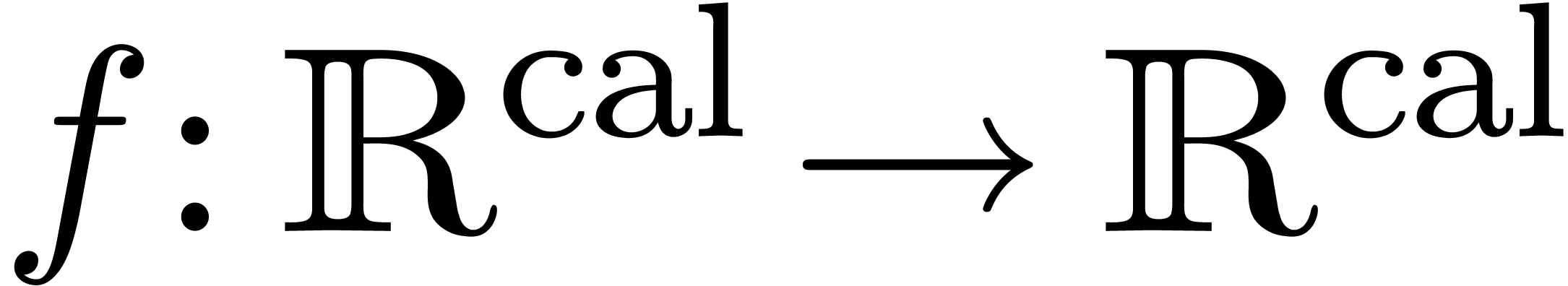

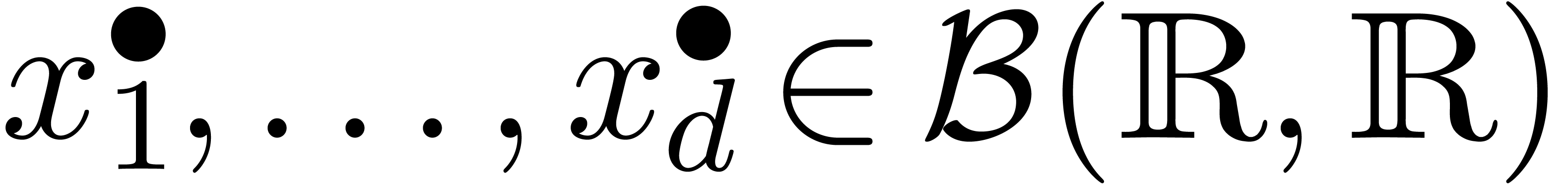

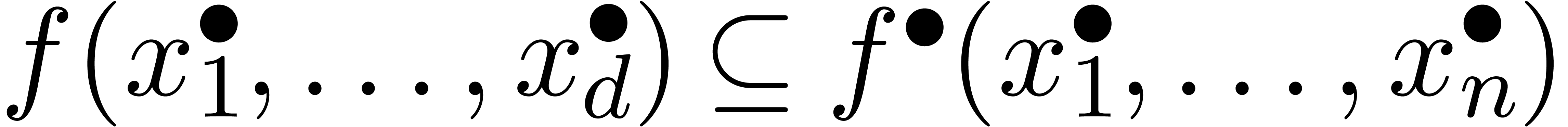

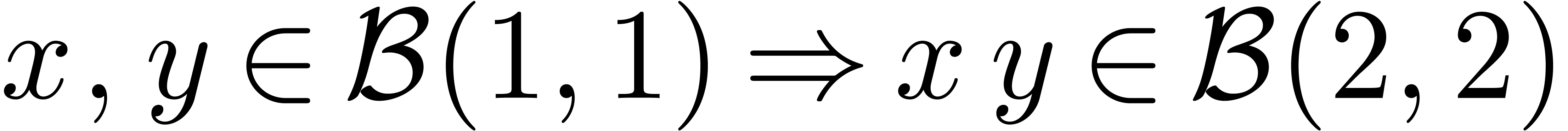

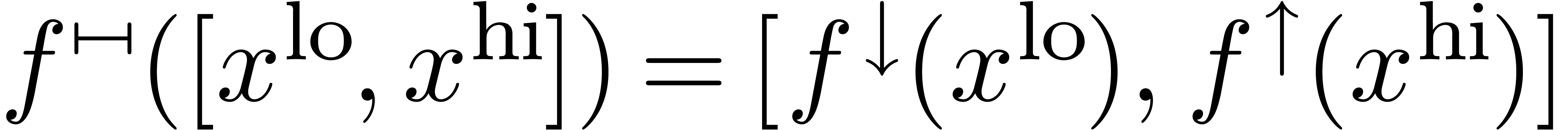

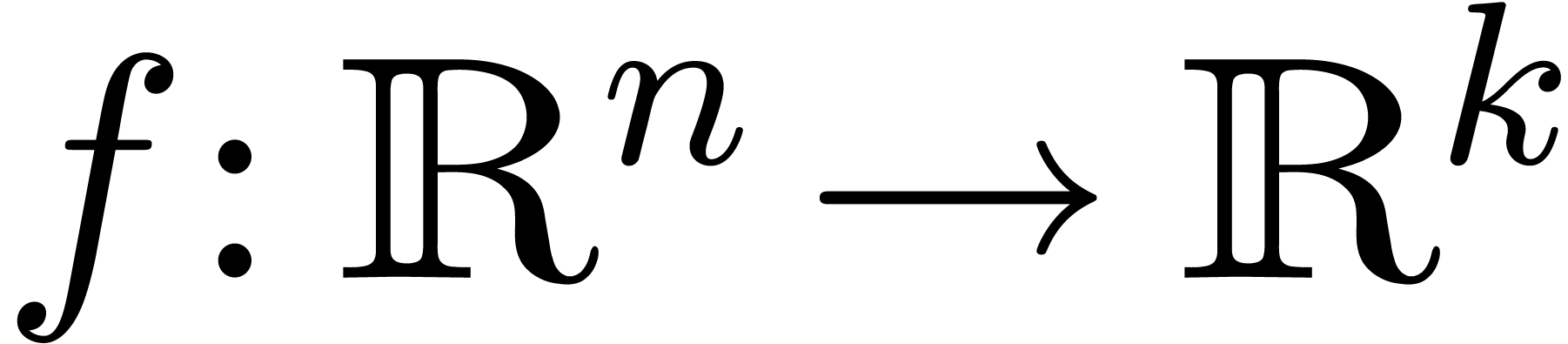

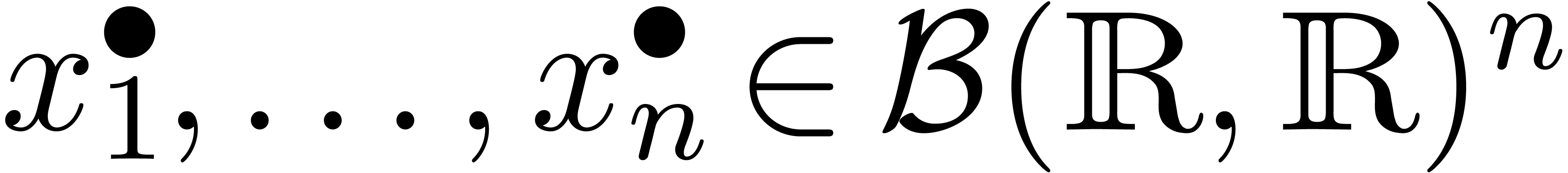

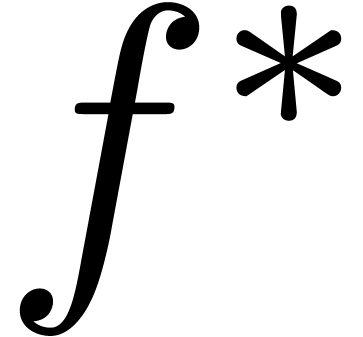

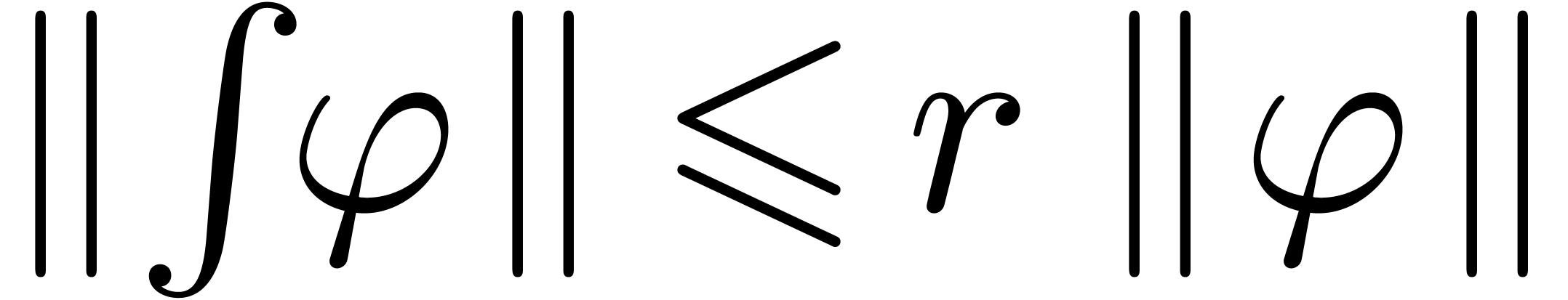

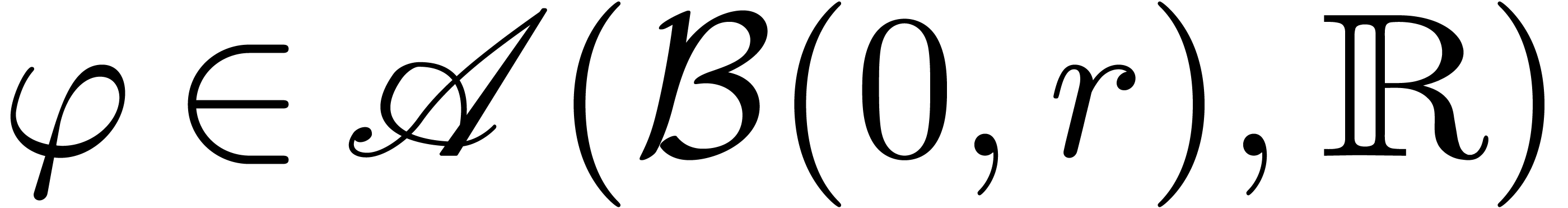

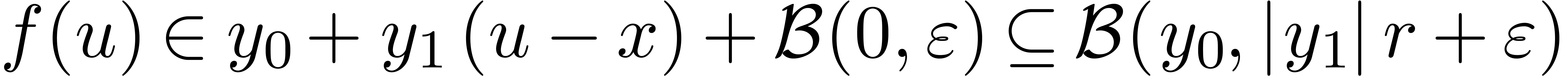

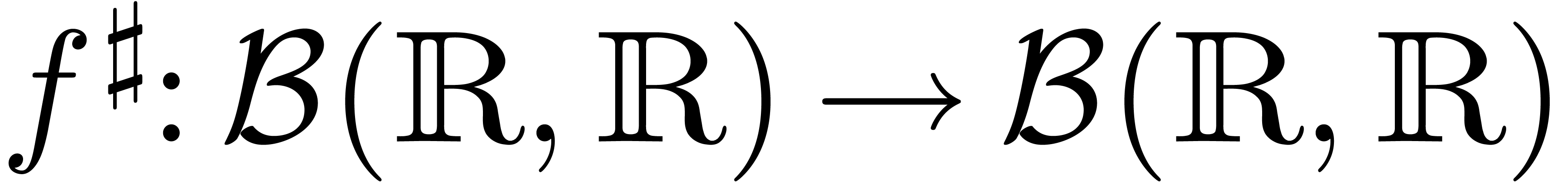

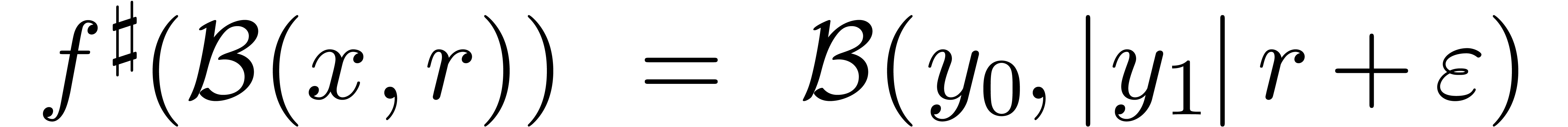

Soit  une fonction. Une fonction

une fonction. Une fonction  est appelée une extension de

est appelée une extension de  si

si

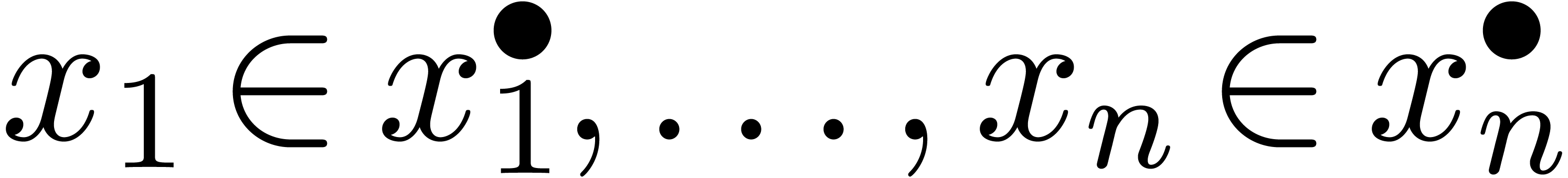

pour tous les  . Ainsi, si

. Ainsi, si

, alors on peut être

sûr que

, alors on peut être

sûr que  ,

conformément à la sémantique décrite dans la

section précédente.

,

conformément à la sémantique décrite dans la

section précédente.

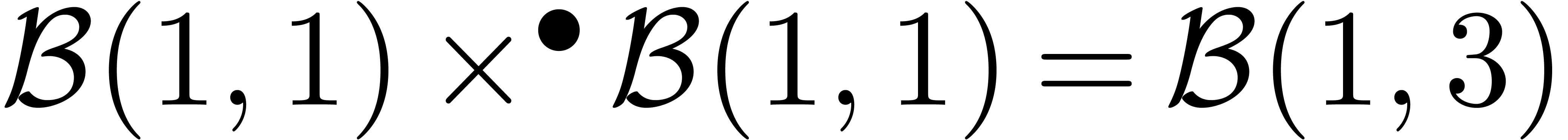

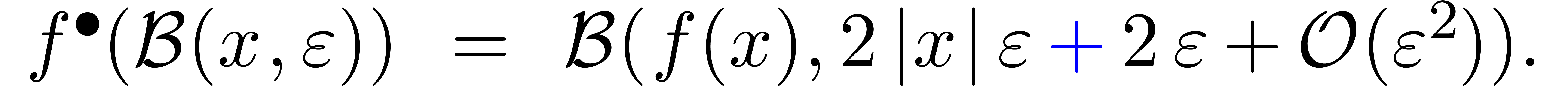

On peut utiliser les formules suivantes pour les opérations élémentaires :

Il est à noter que la dernière formule est simple, mais

pas nécessairement optimale : par exemple, on trouve  , alors que la boule

, alors que la boule  vérifie bien

vérifie bien  .

.

Pour des calculs concrets sur machine, on ne peut prendre les centres et

les rayons dans  . Dans ce

cas, on considère plutôt des centres et des rayons dans

. Dans ce

cas, on considère plutôt des centres et des rayons dans

, voire dans l'ensemble

, voire dans l'ensemble

des nombres flottants avec un mantisse de  bits

et un exposant de

bits

et un exposant de  bits. Dans ce dernier cas, il

est à noter qu'il est impératif de rajouter la

possibilité de prendre des rayons infinis, afin de

représenter le résultat d'un overflow

(dépassement de précision).

bits. Dans ce dernier cas, il

est à noter qu'il est impératif de rajouter la

possibilité de prendre des rayons infinis, afin de

représenter le résultat d'un overflow

(dépassement de précision).

Quand on calcule avec en précisions  et

et

fixes, le résultat exact

fixes, le résultat exact  d'une opération sur des nombres

d'une opération sur des nombres  dans

dans  n'est pas nécessairement dans

n'est pas nécessairement dans  et son approximation

et son approximation  par un

élément dans

par un

élément dans  induit donc une

erreur

induit donc une

erreur  dont il faut tenir compte dans

l'implantation d'une arithmétique de boules.

dont il faut tenir compte dans

l'implantation d'une arithmétique de boules.

La norme IEEE [3, 56] pour le calcul avec des

nombres flottants spécifie que l'approximation  est obtenue en arrondissant le résultat exact

est obtenue en arrondissant le résultat exact  suivant un mode d'arrondi à spécifier. Nous utiliserons

les notations

suivant un mode d'arrondi à spécifier. Nous utiliserons

les notations  pour les modes d'arrondi vers le

haut, vers le bas et au plus près. En notant

pour les modes d'arrondi vers le

haut, vers le bas et au plus près. En notant  , nous notons que

, nous notons que  est

une borne supérieure pour l'erreur quelque soit le mode d'arrondi

choisi. Les formules (3.2), (3.3) et (3.4)

peuvent donc adaptées au cas du calcul en précision

limitée, en les remplaçant par

est

une borne supérieure pour l'erreur quelque soit le mode d'arrondi

choisi. Les formules (3.2), (3.3) et (3.4)

peuvent donc adaptées au cas du calcul en précision

limitée, en les remplaçant par

Il est à noter que la norme IEEE est désormais suivie par

la plupart des constructeurs de micro-processeurs.

On a déjà mentionné le fait que l'arithmétique de boules est classiquement considérée comme une variante de l'arithmétique d'intervalles. Pourquoi choisir l'une ou l'autre ? Voici quelques avantages et inconvénients des deux approches.

Quand les intervalles sont grands, l'arithmétique d'intervalles est généralement plus précises. Pour certaines applications, les intervalles sont grands par nature et donc plus adaptées. Par exemple, lors de la recherche de solutions d'un système d'équations dans une boîte, il est tout à fait adapté d'utiliser une méthode de découpage par dichotomie.

Toute fonction monotone  ,

disons croissante, admet une extension canonique

,

disons croissante, admet une extension canonique  en arithmétique d'intervalles :

en arithmétique d'intervalles :  .

Ceci favorise la standardisation.

.

Ceci favorise la standardisation.

En implantant la norme IEEE, les processeurs modernes privilégient a priori l'efficacité de l'arithmétique d'intervalles. Attention toutefois : changer le mode d'arrondi peut s'avérer très coûteux en temps, auquel cas il faut adapter les algorithmes afin de pouvoir fonctionner avec n'importe quel mode d'arrondi [92, 45].

En précision multiple, les intervalles sont généralement petits, ce qui permet le stockage du centre en précision multiple et le rayon en précision simple. Ceci est deux fois plus efficace en temps et en espace par rapport à l'arithmétique d'intervalles qui oblige à stocker les deux extrémités en précision multiple. Si on cherche à approcher de plus en plus précisément des vrais nombres réels, il est donc plus naturel d'utiliser des boules.

L'arithmétique de boules donne une grande souplesse quant au choix des centres et des rayons. D'une part, ceci peut être utilisé pour améliorer la qualité des estimations (voir la section 3.2.3). D'autre part, ceci peut être utilisé pour améliorer la vectorisation et plus généralement l'efficacité des algorithmes (voir la section 3.4.2).

En mathématiques, les estimations d'erreur

s'établissent généralement via le

calcul  -

- classique. Ce calcul correspond naturellement à

l'arithmétique de boules, ce qui facilite la conception

d'algorithmes certifiés. Ceci s'applique tout

particulièrement à tout argument par perturbation.

classique. Ce calcul correspond naturellement à

l'arithmétique de boules, ce qui facilite la conception

d'algorithmes certifiés. Ceci s'applique tout

particulièrement à tout argument par perturbation.

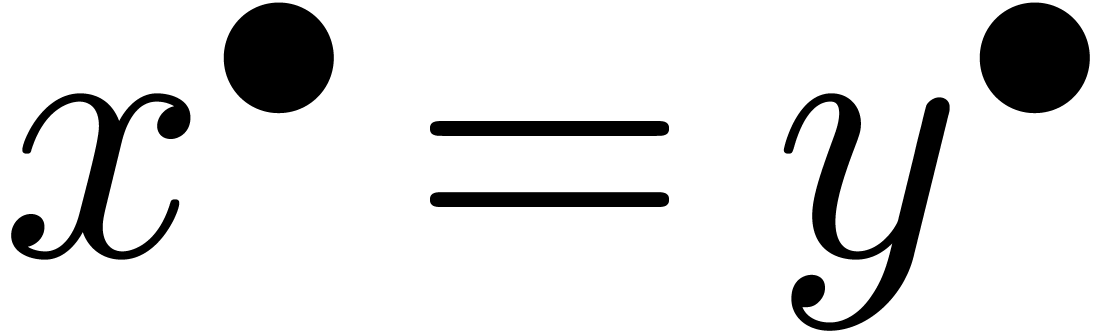

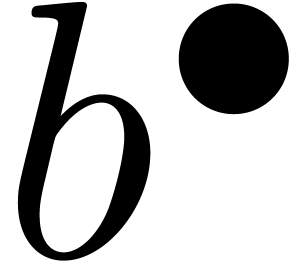

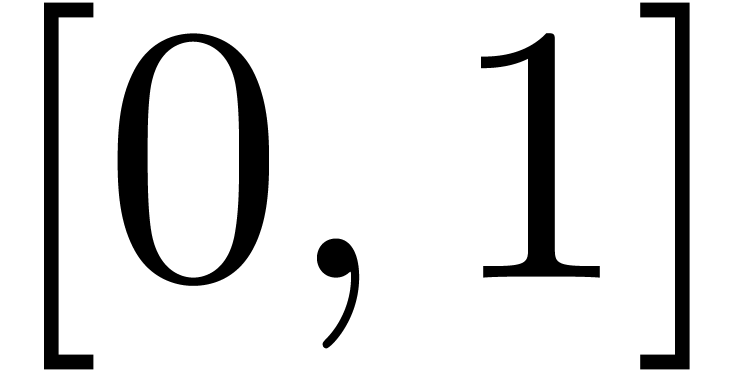

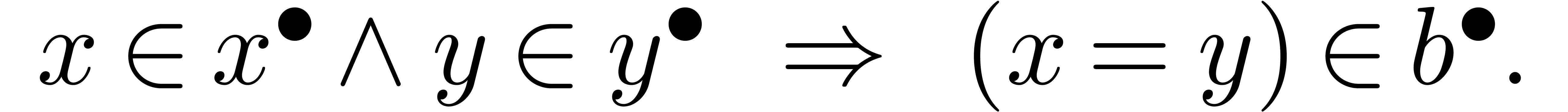

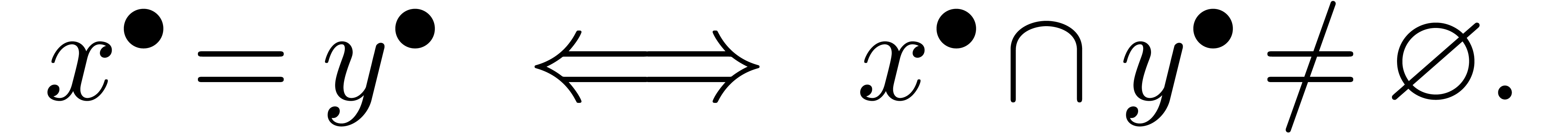

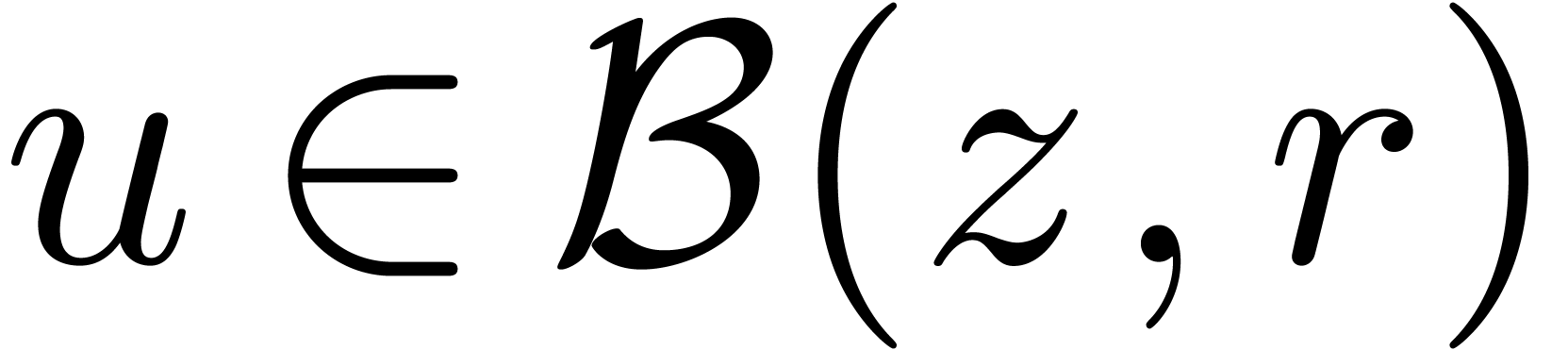

Une question intéressante concerne la sémantique des

prédicats comme  . Si

on interprète les boules comme un ensemble de « valeurs

possibles », alors le résultat d'un test

. Si

on interprète les boules comme un ensemble de « valeurs

possibles », alors le résultat d'un test  devrait être un intervalle

devrait être un intervalle  de

de  avec

avec

En revanche, si on interprète  et

et  comme des approximation d'un vrai nombre réel

à une certaine précision, il est plus naturel de prendre

comme des approximation d'un vrai nombre réel

à une certaine précision, il est plus naturel de prendre

En effet, si  sont des nombres calculables

représentés par des suites calculables

décroissantes de boules

sont des nombres calculables

représentés par des suites calculables

décroissantes de boules  avec

avec  et

et  , alors la

suite

, alors la

suite  à valeurs dans

à valeurs dans  représente le résultat du test d'égalité

représente le résultat du test d'égalité

dans

dans  .

La deuxième définition reflète donc

l'asymmétrie profonde de l'égalité dans l'analyse

calculable.

.

La deuxième définition reflète donc

l'asymmétrie profonde de l'égalité dans l'analyse

calculable.

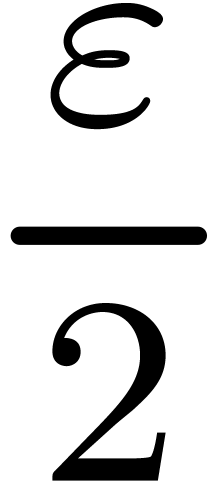

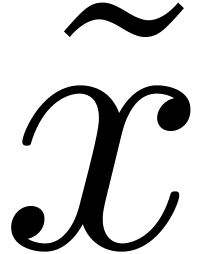

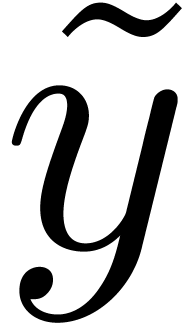

L'arithmétique des boules est basée sur une analyse a posteriori des erreurs : on effectue une opération en arithmétique de boules en utilisant une certaine précision que l'on augmentera jusqu'au moment où le rayon du résultat est suffisamment petit. Parfois, bien que rarement, on peut préférer une estimation a priori de l'erreur [80].

Exemple : calcul d'une  -approximation

de

-approximation

de

Calculer des  -approximations

-approximations

et

et  de

de  et

et

Retourner

Avantage : précision de calcul adaptatif dans le

case

En effet, dans l'arithmétique de boules classique, on calcule

et

et  en utilisant la

même précision, alors que l'on peut simplement utiliser

en utilisant la

même précision, alors que l'on peut simplement utiliser

comme approximation de

comme approximation de  tant que

tant que  . Supposant que

. Supposant que

est un nombre dont l'approximation est

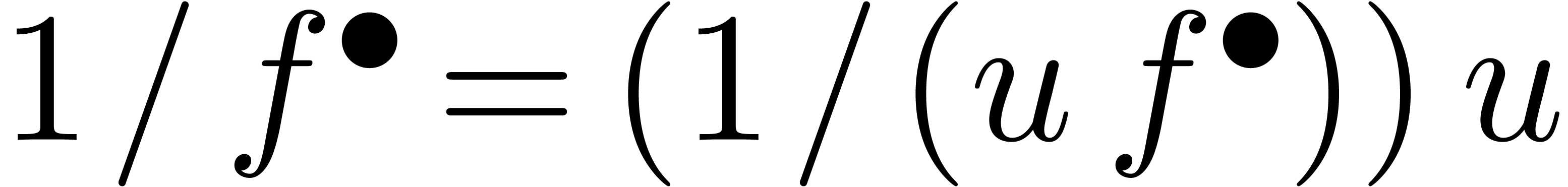

très couteuse en temps, une estimation a priori de

l'erreur est donc plus efficace.

est un nombre dont l'approximation est

très couteuse en temps, une estimation a priori de

l'erreur est donc plus efficace.

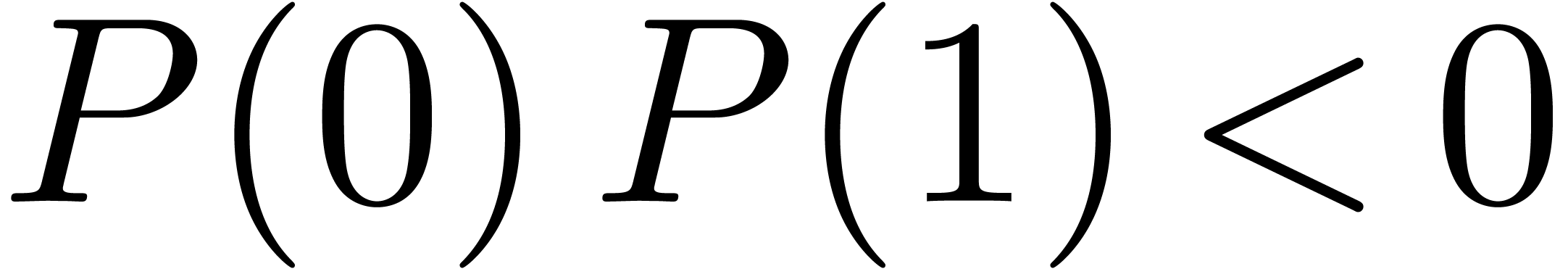

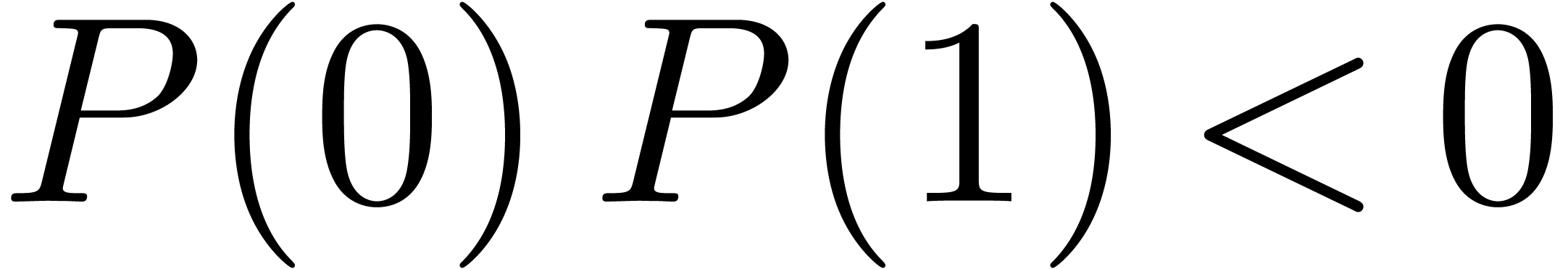

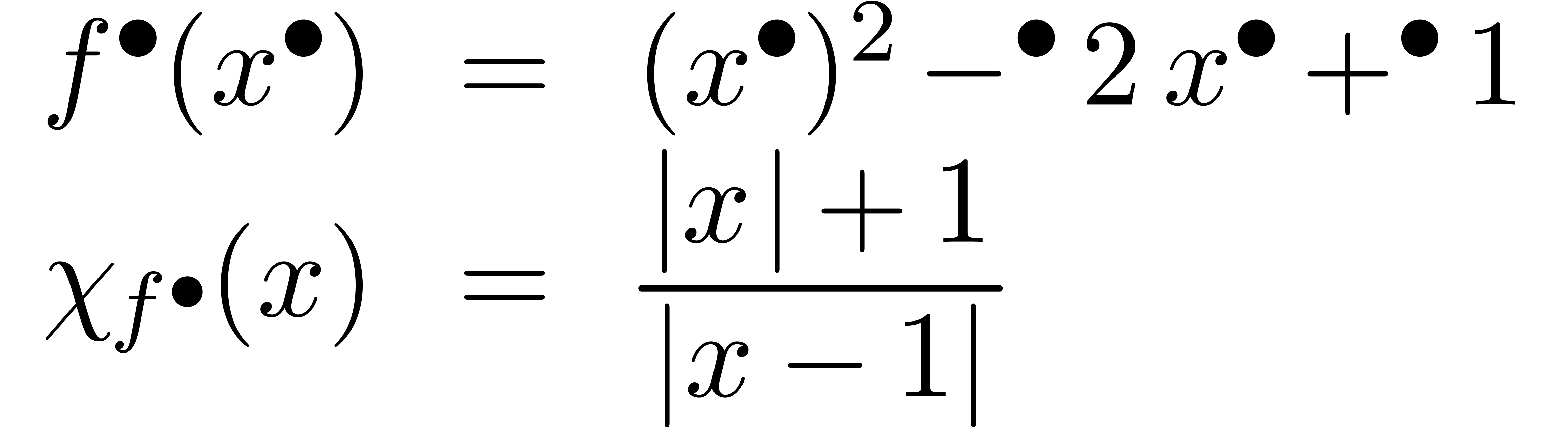

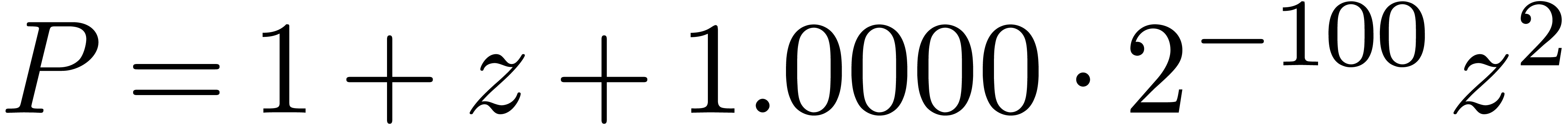

Problème : évaluation de  par Horner en

par Horner en

Calcul d'une  -approximation

de

-approximation

de  pour

pour

tolérance trop petite

tolérance trop petite

Équilibrage des tolérances : calcul d'une  -approximation de

-approximation de  pour tout

pour tout

Problème : nécessite des « dags » (directed acyclic graphs) pour tous les résultats intermédiaires

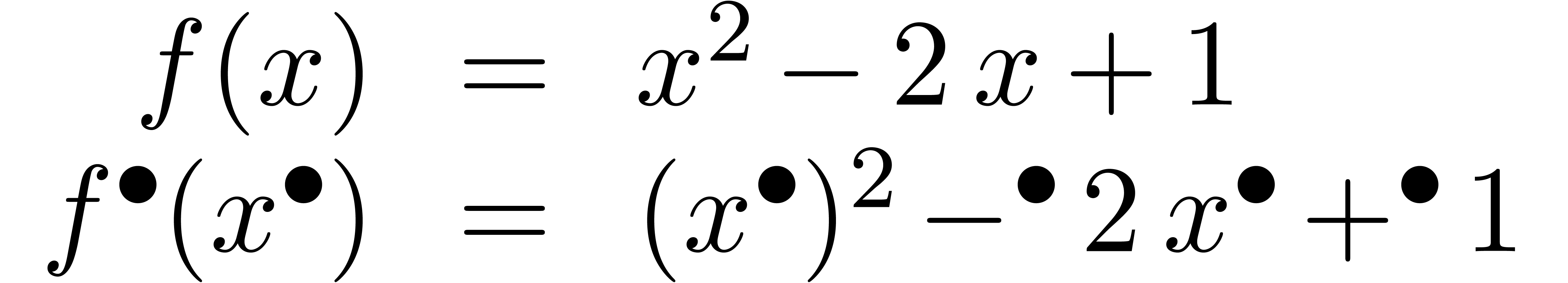

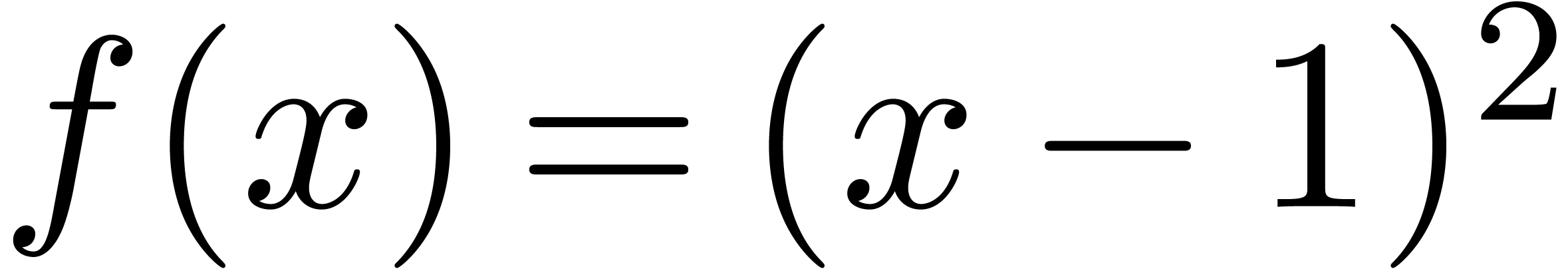

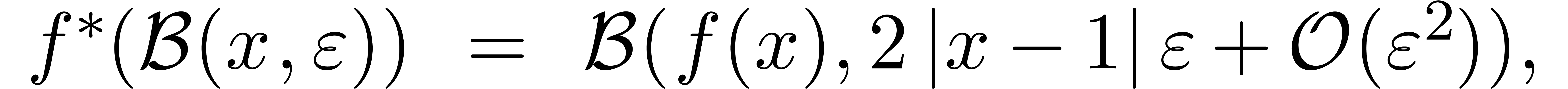

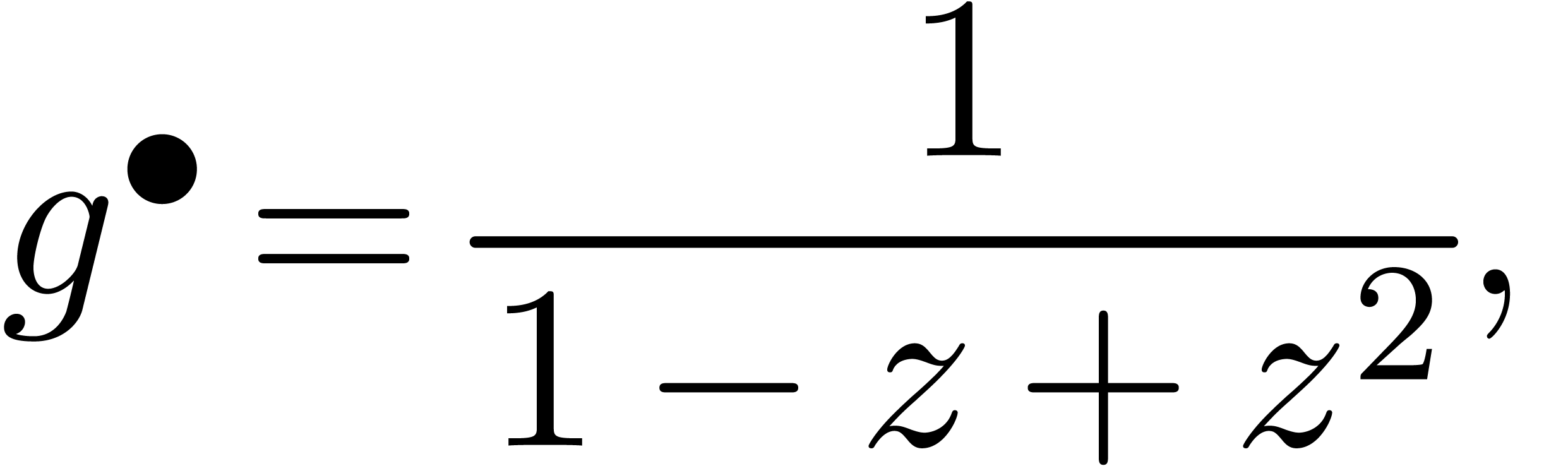

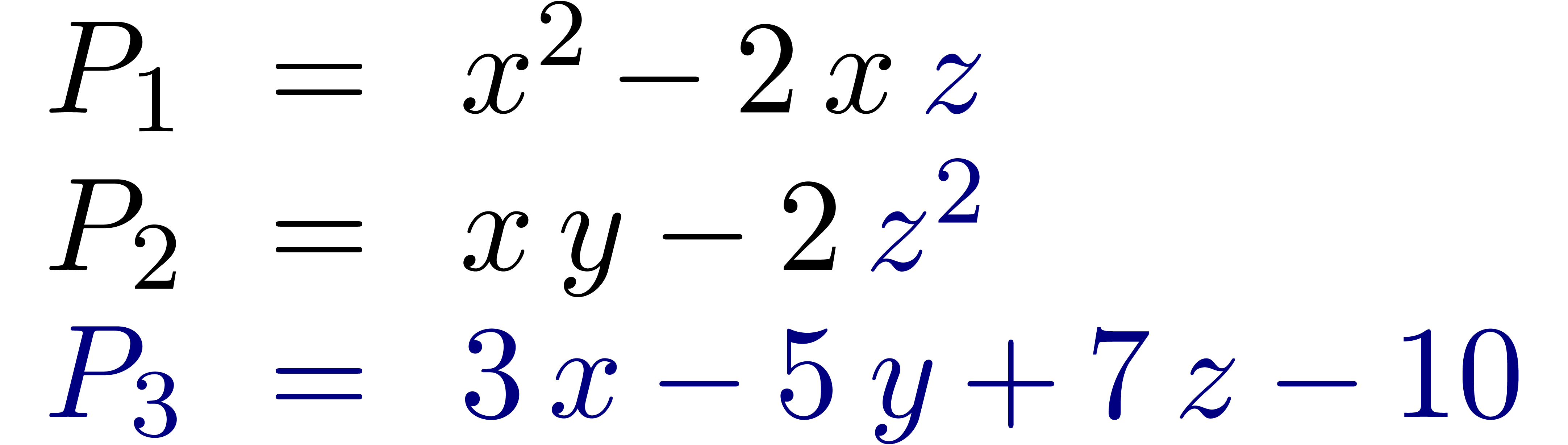

Le problème principal de l'arithmétique de boules concerne

la surestimation des erreurs. Par exemple, l'évaluation de la

fonction  en

en  donne

donne

Plus généralement, ce problème intervient chaque fois qu'il y a des quantités qui s'annulent lors d'un calcul, sans que la méthode de calcul s'en rend compte.

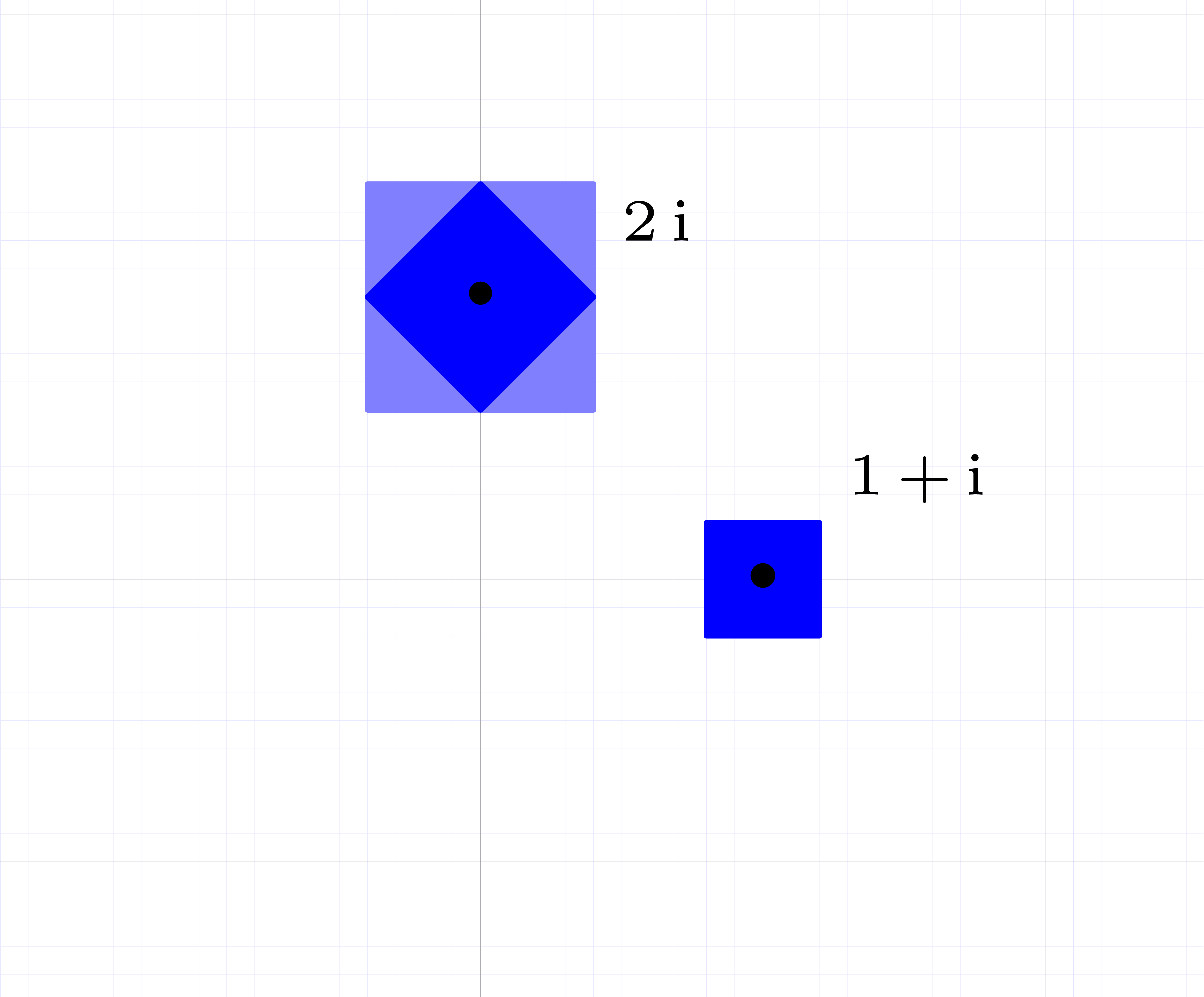

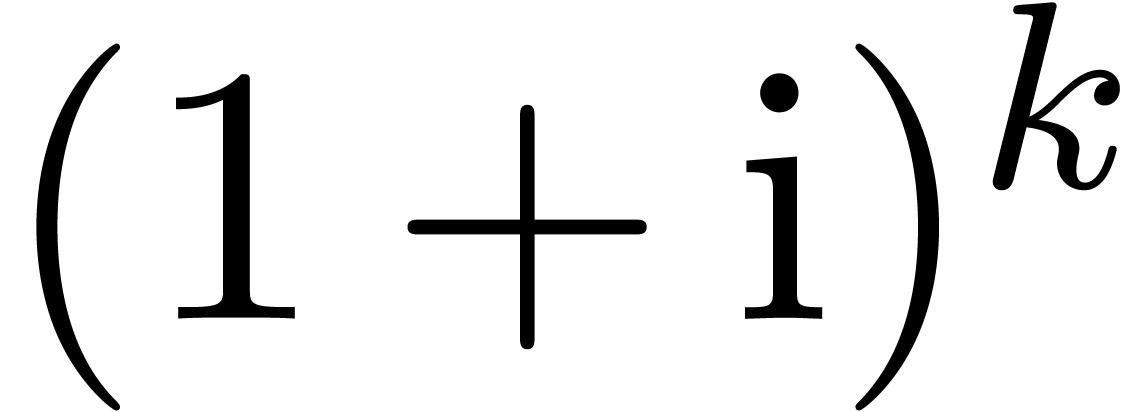

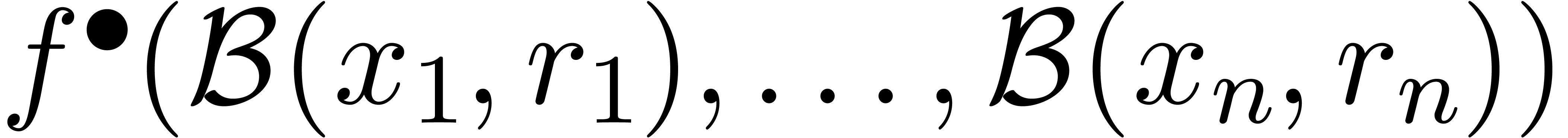

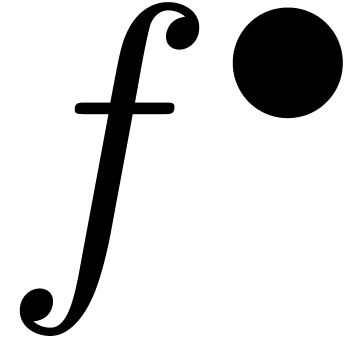

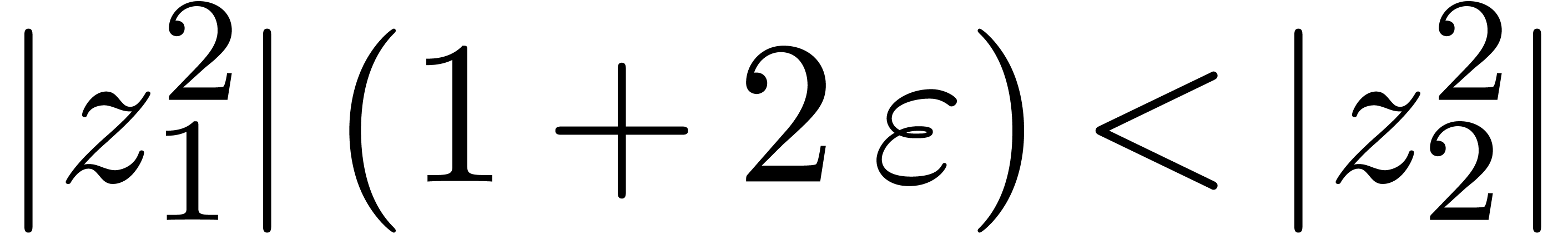

Dans certain cas, la surestimation est due à notre façon

de représenter les encadrements. Par exemple, en

arithmétique d'intervalles standard, on encadre les nombres

complexes par des rectangles de la forme  .

Ces rectangles ont tendance à se tourner lors de la

multiplication par un nombre complexe non réel, comme dans

l'exemple

.

Ces rectangles ont tendance à se tourner lors de la

multiplication par un nombre complexe non réel, comme dans

l'exemple

Ici l'inclusion du résultat dans un autre rectangle de la forme requise implique une perte automatique de précision. On appelle ceci l'effet d'enveloppement. Sur cet exemple précis, l'inconvénient disparaît lorsque l'on utilise l'arithmétique de boules, puisqu'une boule reste une boule si on la tourne. Toutefois, on verra un exemple plus complexe dans la section 5.5.2, où il faudra travailler plus pour résoudre le problème.

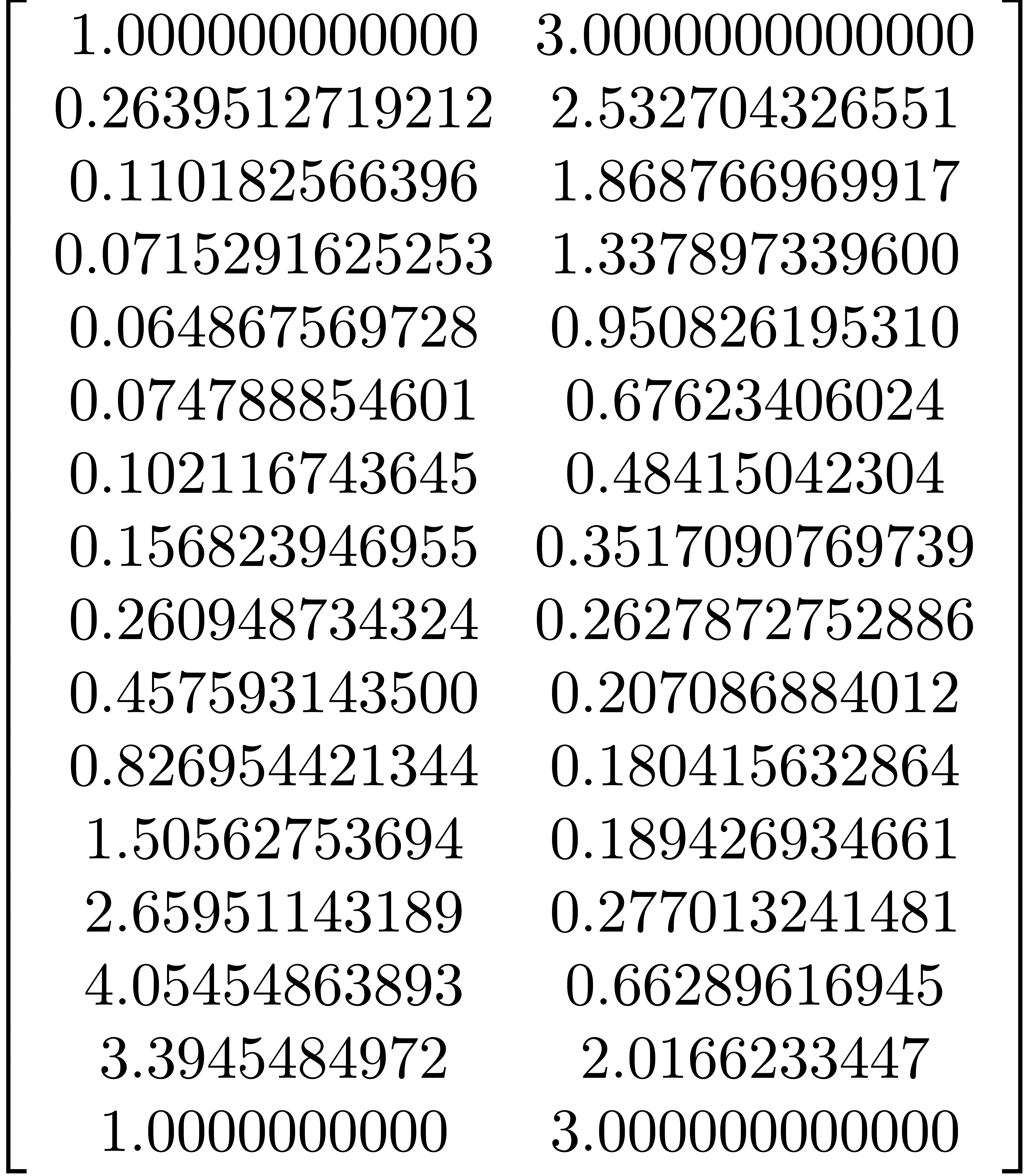

|

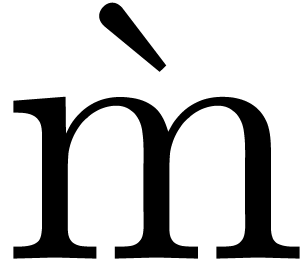

Fig. 3.1. Illustration de l'effet d'enveloppement pour l'exemple (3.5). |

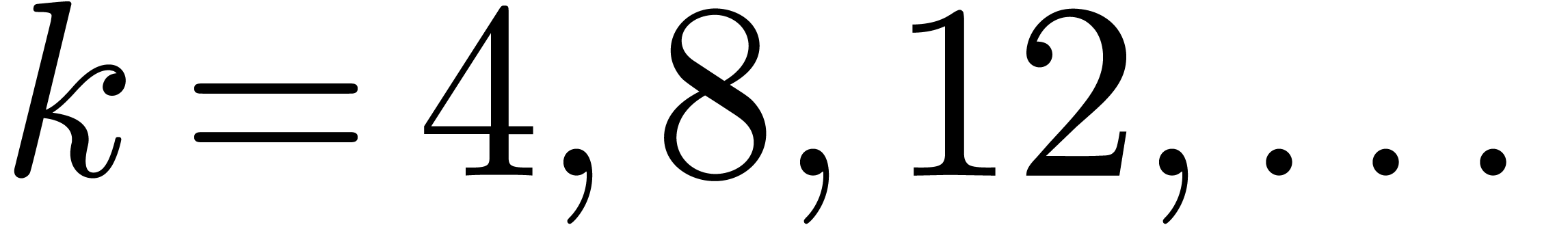

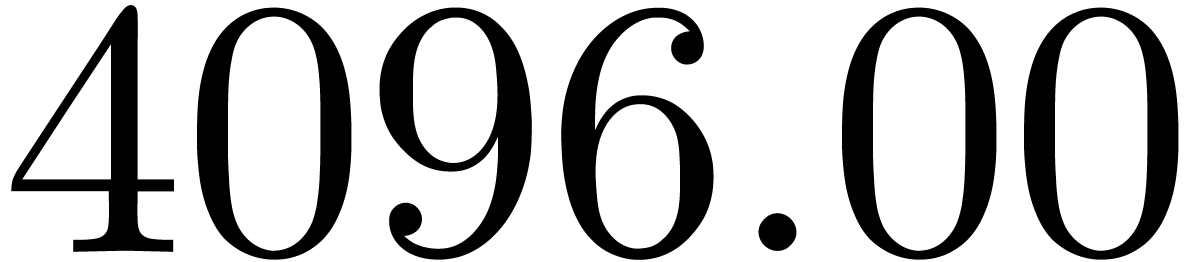

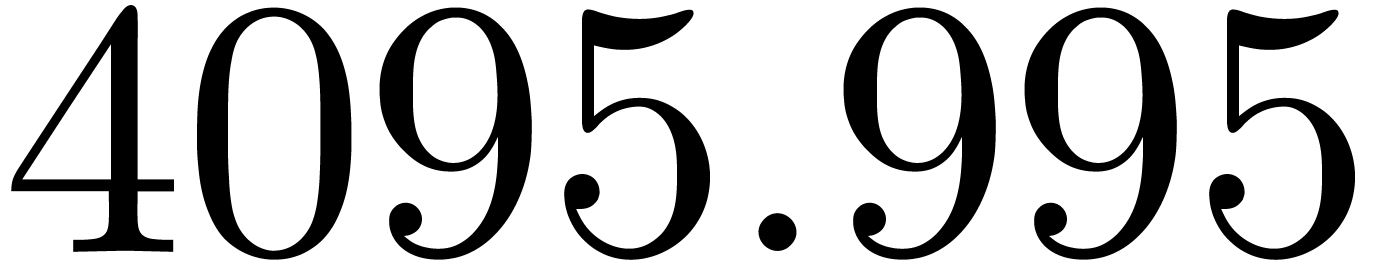

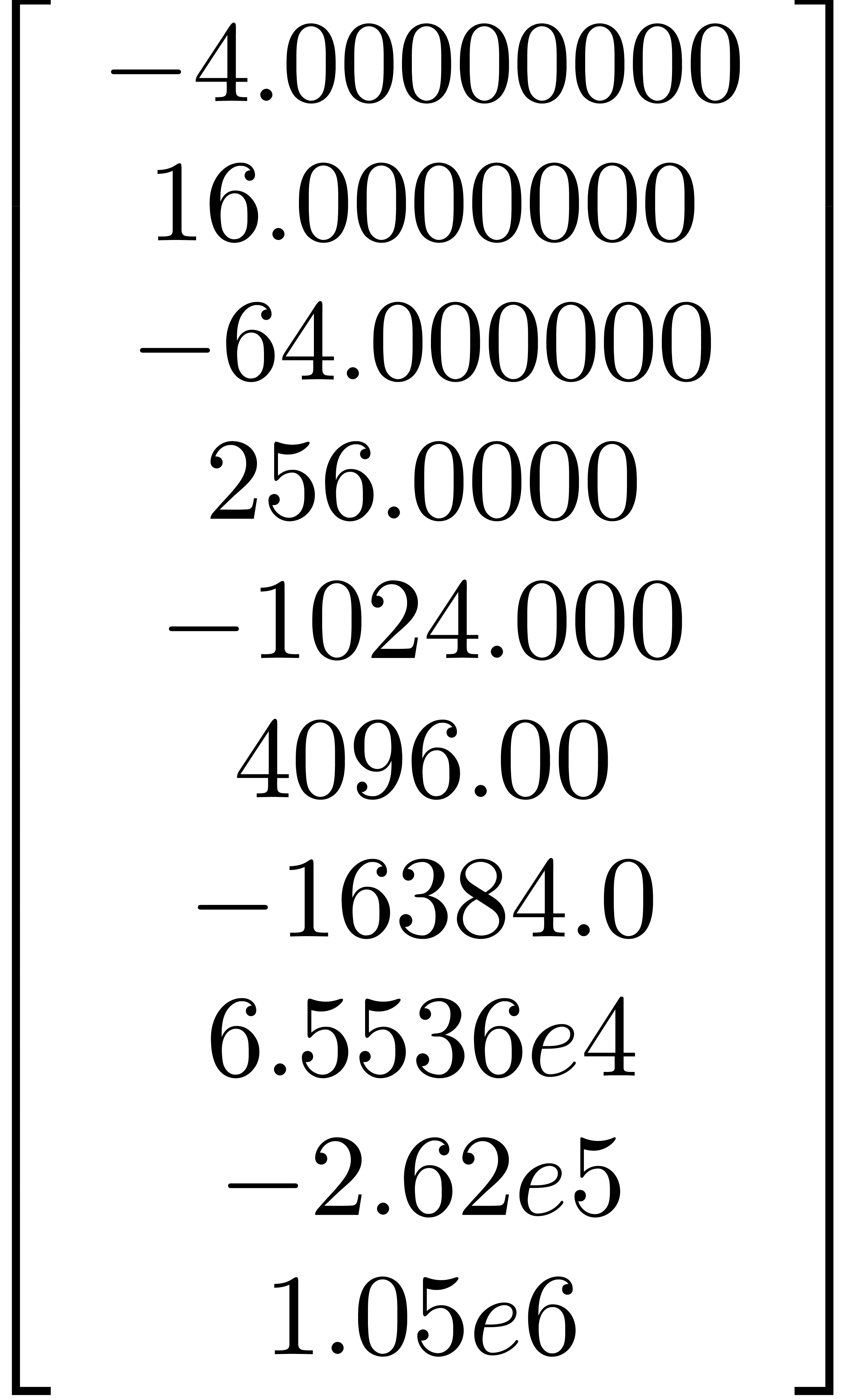

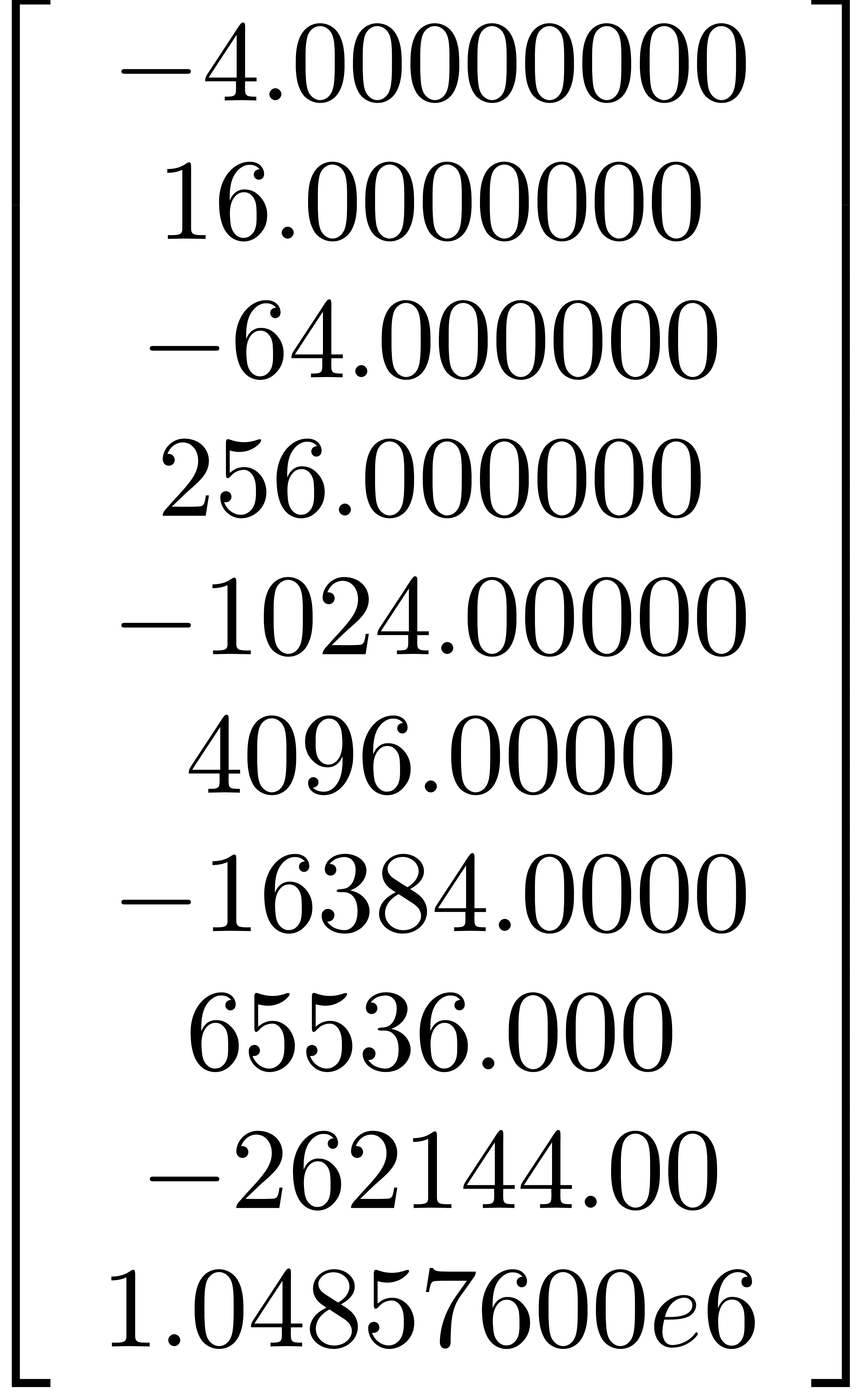

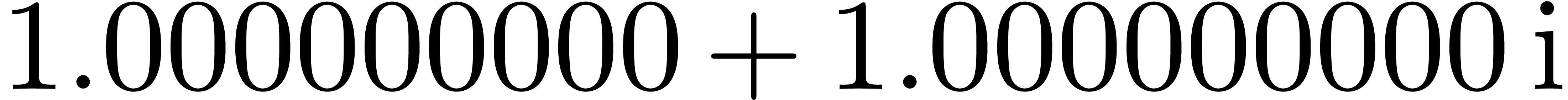

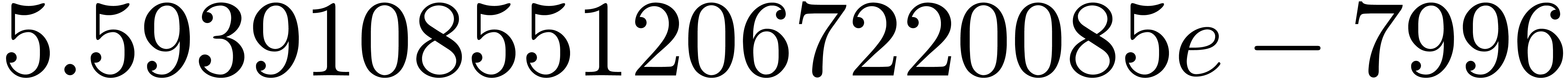

Illustrons la perte de précision lorsque l'on calcule  pour

pour  de façon naïve en

utilisant l'arithmétique d'intervalles. Dans la sortie, on

utilise la notation scientifique. Par exemple

de façon naïve en

utilisant l'arithmétique d'intervalles. Dans la sortie, on

utilise la notation scientifique. Par exemple  désigne un nombre compris entre

désigne un nombre compris entre  et

et  .

.

Mmx] |

use "algebramix"; |

Mmx] |

puissance (z, n) == if n = 1 then z else z * puissance (z, n-1); |

Mmx] |

z == complex (interval (1.0, 1.0000000001),

interval (1.0, 1.0000000001)) |

Mmx] |

[ puissance (z, 4*n) || n in 1 to 10 ] |

Comme on l'avait prédit, la perte de précision n'apparait pas lorsque l'on remplace l'arithmétique d'intervalles par l'arithmétique de boules.

Mmx] |

use "algebramix"; |

Mmx] |

puissance (z, n) == if n = 1 then z else z * puissance (z, n-1); |

Mmx] |

z == ball (complex (1.0, 1.0), 0.0000000001) |

Mmx] |

[ puissance (z, 4*n) || n in 1 to 10 ] |

Une autre technique pour limiter l'effet d'enveloppement consiste

à utiliser des algorithmes qui minimisent la profondeur du

calcul. En effet, dans la section 3.2.2, l'effet est

amplifié par le fait que l'on réinjecte  fois le résultat du calcul précédent dans

l'étape d'après, perdant ainsi

fois le résultat du calcul précédent dans

l'étape d'après, perdant ainsi  bits de précision. Si on utilise un algorithme diviser pour

régner pour calculer des puissances, la perte de précision

se limite à

bits de précision. Si on utilise un algorithme diviser pour

régner pour calculer des puissances, la perte de précision

se limite à  bits. À noter que ce

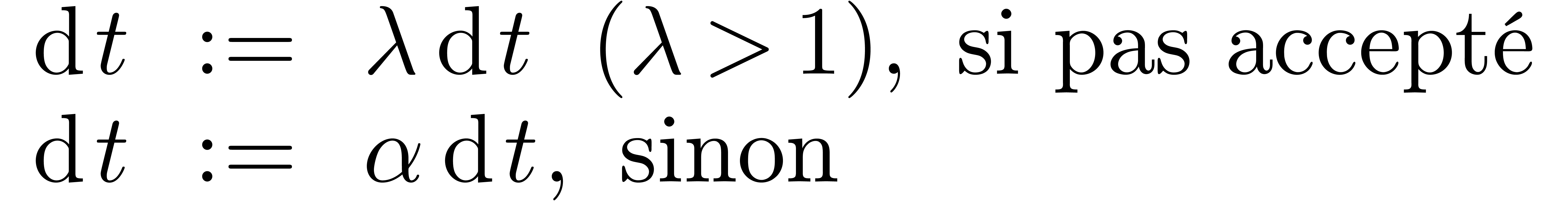

genre d'algorithmes sont intéressants de toute façon, car

ils se parallèlisent généralement mieux et ils se

comportent mieux vis à vis de la mémoire cache.

bits. À noter que ce

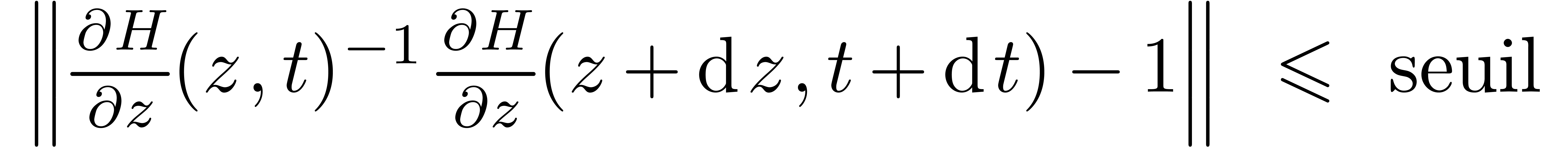

genre d'algorithmes sont intéressants de toute façon, car

ils se parallèlisent généralement mieux et ils se

comportent mieux vis à vis de la mémoire cache.

Mmx] |

use "algebramix"; |

Mmx] |

puissance (z, n) == if n = 1 then z else puissance (z, n quo 2) * puissance (z, n - (n quo 2)); |

Mmx] |

z == complex (interval (1.0, 1.0000000001), interval (1.0, 1.0000000001)) |

Mmx] |

[ puissance (z, 4*n) || n in 1 to 10 ] |

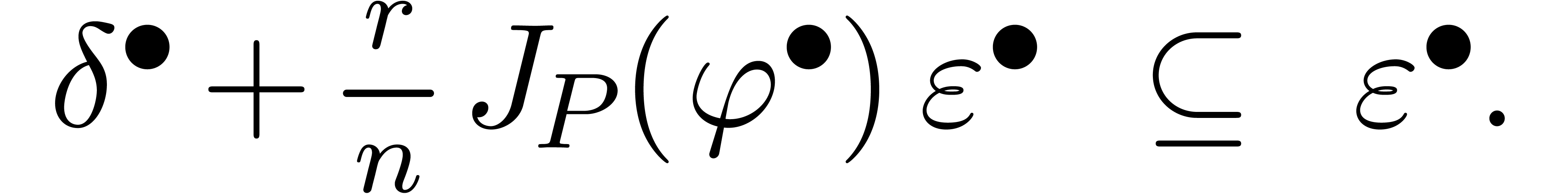

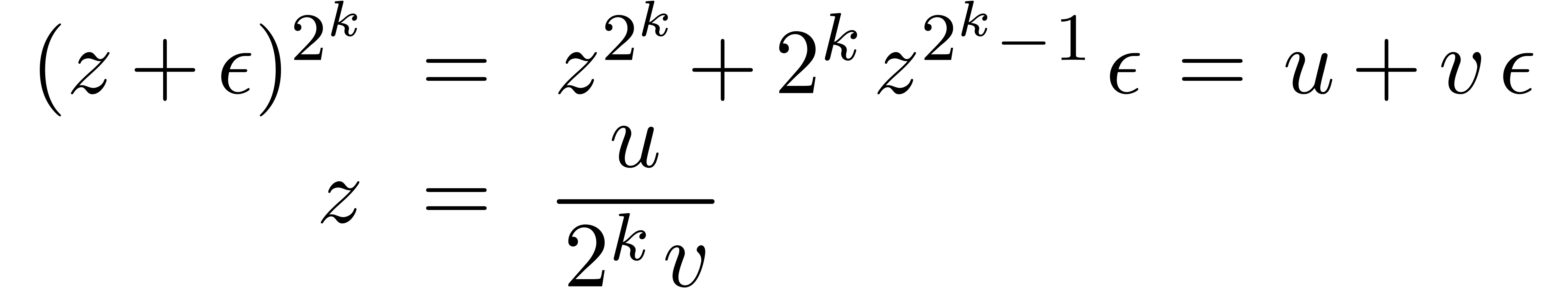

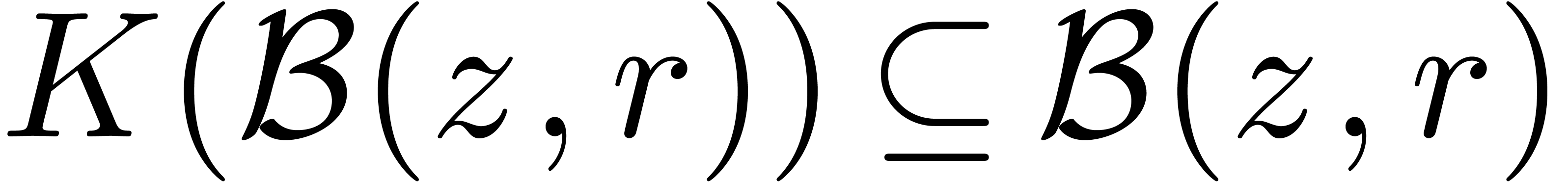

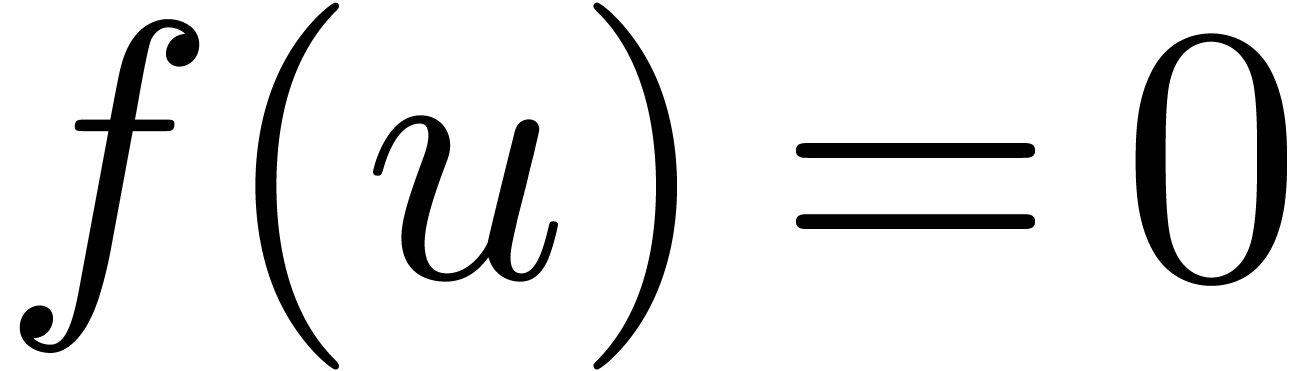

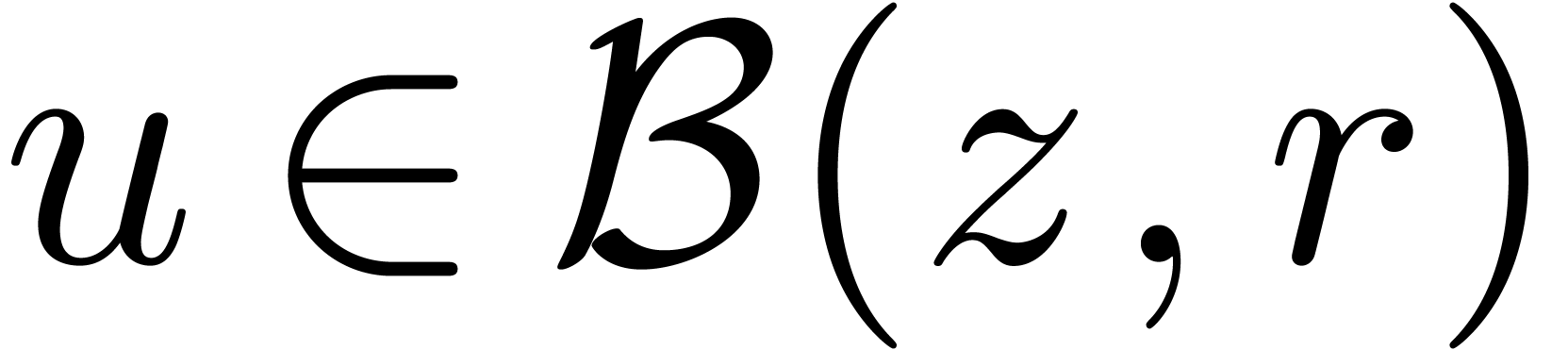

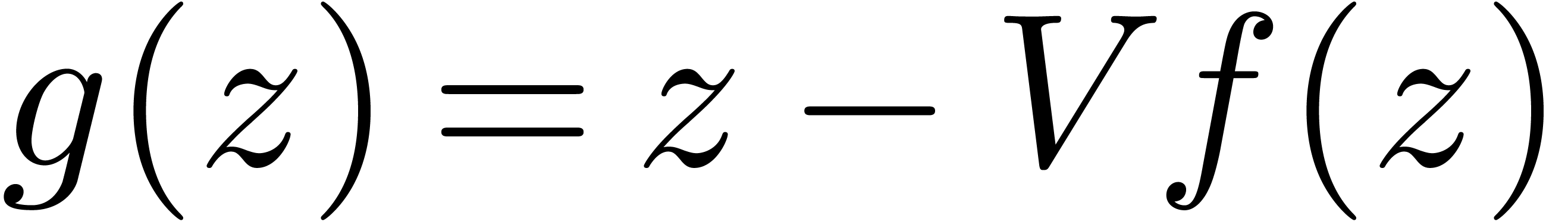

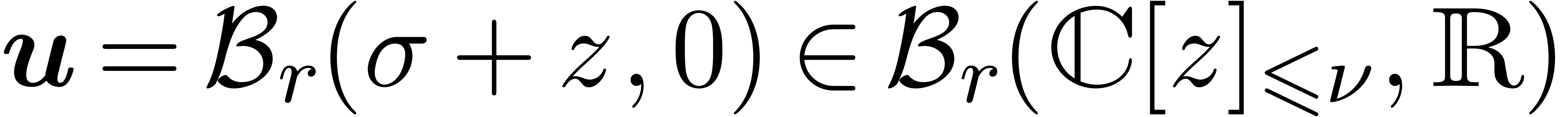

Nous avons déjà souligné l'importance des méthodes perturbatives en calcul analytique. Elles interviennent notamment lorsque l'on cherche à résoudre des équations et que l'on a déjà un moyen pour résoudre l'équation de façon approchée.

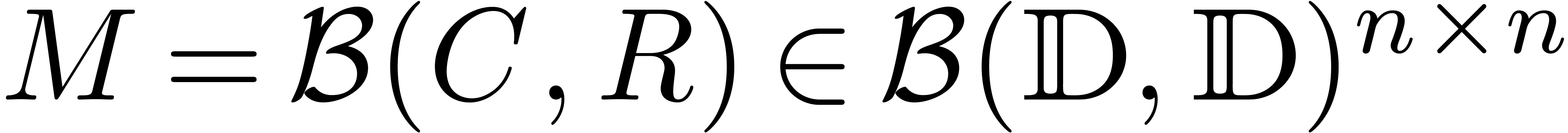

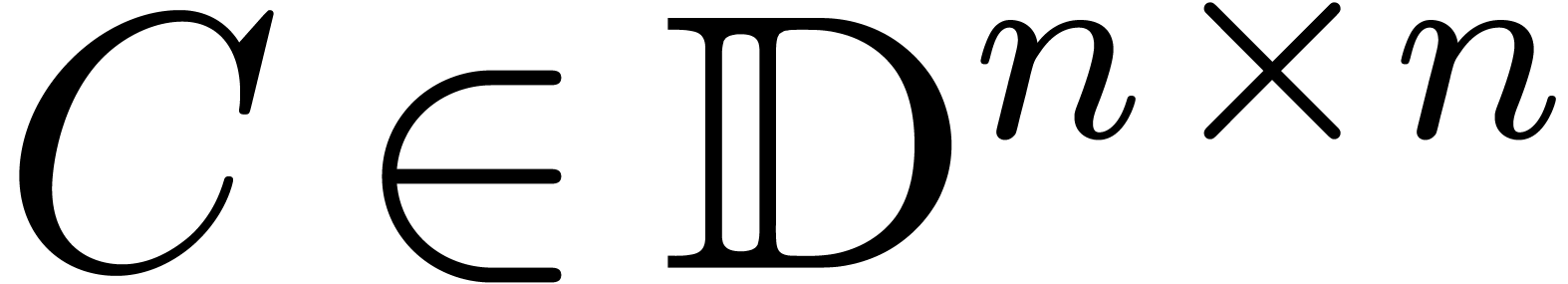

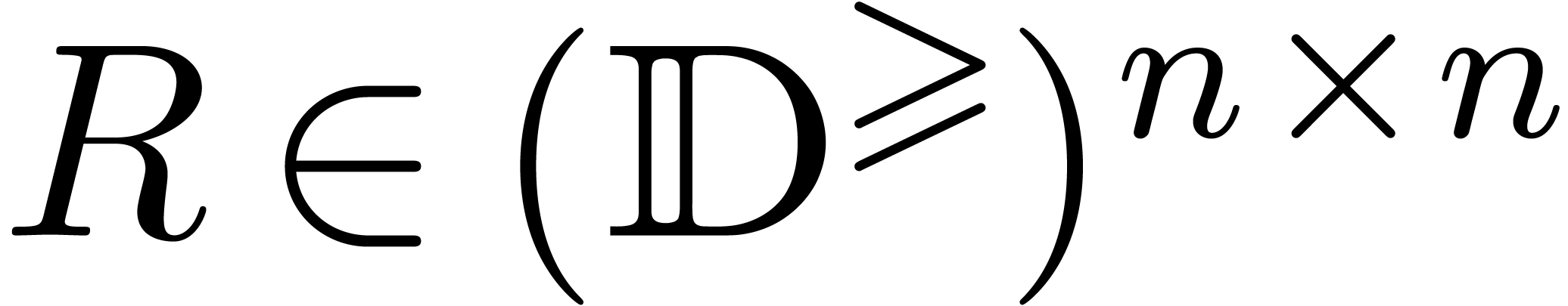

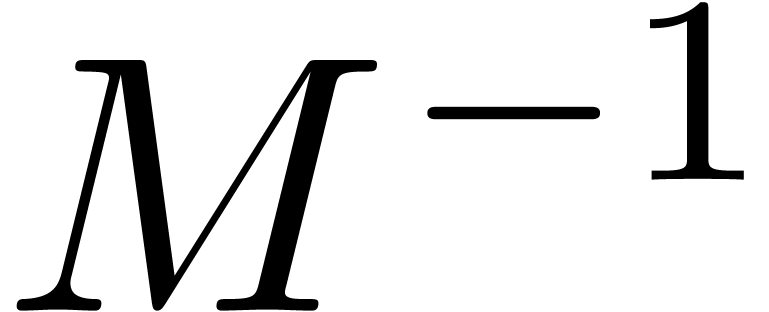

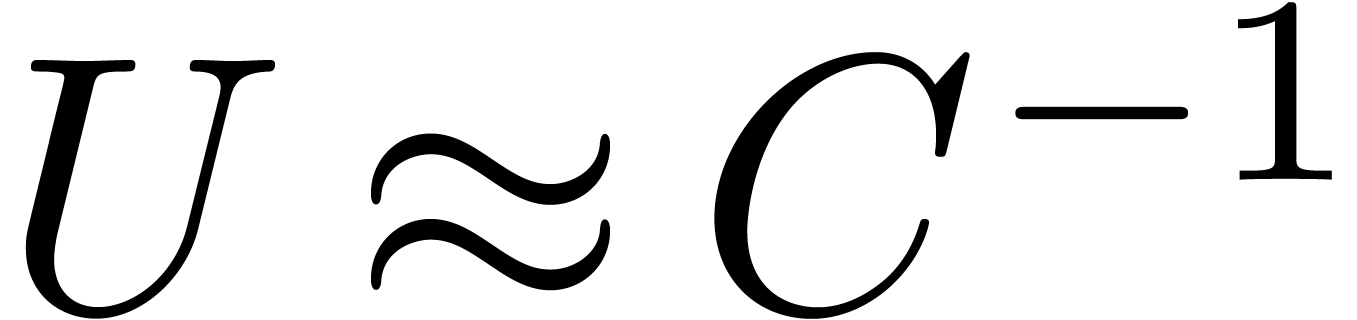

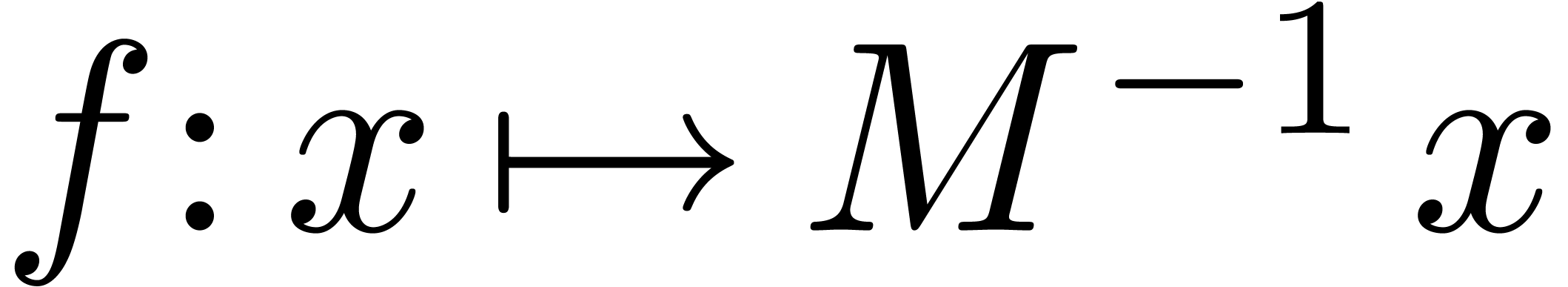

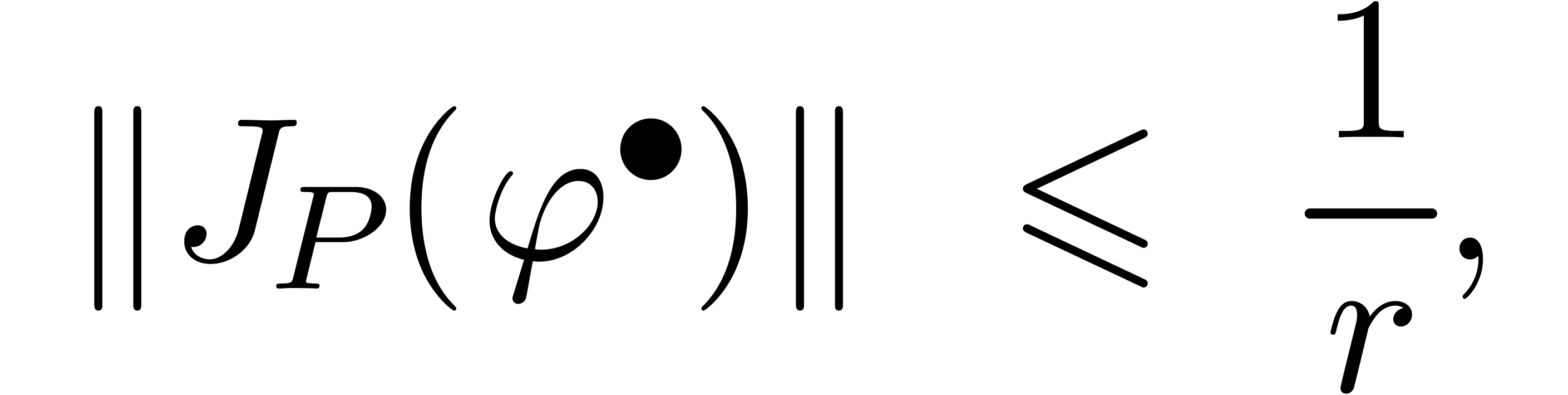

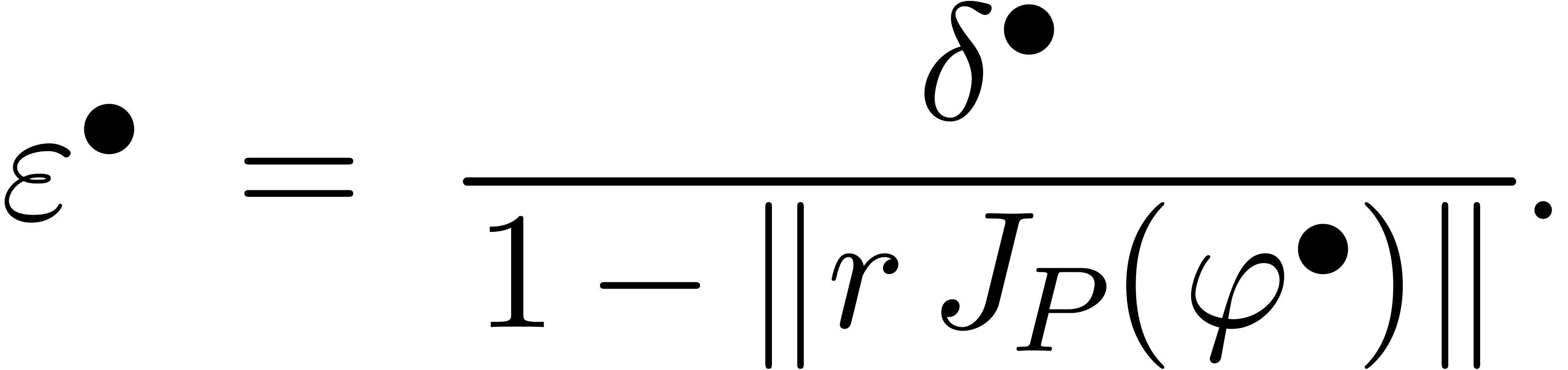

Considérons par exemple l'inversion d'une matrice  , qui correspond à la résolution

de l'équation

, qui correspond à la résolution

de l'équation  . Si

. Si

est une matrice de boules,

réécrite comme une boule de centre

est une matrice de boules,

réécrite comme une boule de centre  et de rayon

et de rayon  , le calcul de

, le calcul de

par pivot de Gauss naïf produit une

surestimation énorme. Or il existe de bons algorithmes

numériques pour inverser le centre

par pivot de Gauss naïf produit une

surestimation énorme. Or il existe de bons algorithmes

numériques pour inverser le centre  de

façon approchée, produisant une matrice

de

façon approchée, produisant une matrice  avec

avec  . Dès lors, il

suffit d'étudier de combien l'inverse de

. Dès lors, il

suffit d'étudier de combien l'inverse de  peut bouger lorsque l'on fait varier

peut bouger lorsque l'on fait varier  .

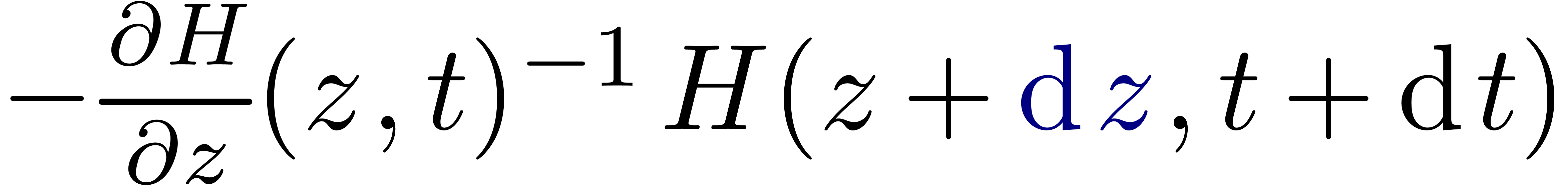

Ceci conduit à l'algorithme suivant :

.

Ceci conduit à l'algorithme suivant :

Algorithme (Hansen)

de

de

Écrire  , avec

, avec

et

et

Inverser numériquement

Calculer

Calculer  . On a :

. On a :

Soit  la matrice avec entrées

la matrice avec entrées

Retourner

Remarque. De manière plus générale, la méthode perturbative appartient à la famille des algorithmes marchant par « prospection-validation ». Dans un premier temps, ces algorithmes cherchent à approcher, voire à diviner la bonne réponse. Lorsque l'on estime avoir accumulé suffisamment d'évidence pour que le résultat soit bon, on lance un nouvel algorithme pour la validation du résultat.

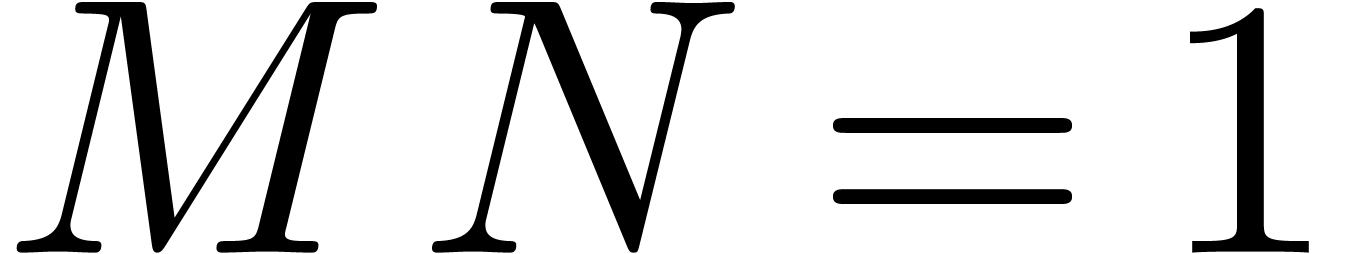

Bien sûr, la méthode perturbative s'applique à d'autres problèmes similaires, comme le calcul de la forme échelon. Montrons d'abord le calcul quand on utilise l'algorithme naïf qui consiste à directement appliquer le pivot de Gauss sur une matrice dont les coefficients sont des intervalles :

Mmx] |

use "analyziz" |

Mmx] |

rnd () == {

x == uniform_deviate (0.0, 1.0);

return interval (x - 0.0000001, x + 0.0000001);

}; |

Mmx] |

M == [ rnd () | j in 1 to 7 || i in 1 to 7 ] |

Mmx] |

row_echelon M |

On observe bien une déperdition de la précision au cours

de l'algorithme. Lorsque les coefficients de la matrice sont

remplacés par des boules,

Mmx] |

use "analyziz" |

Mmx] |

rnd () == {

x == uniform_deviate (0.0, 1.0);

return ball (x, 0.0000001);

}; |

Mmx] |

M == [ rnd () | j in 1 to 7 || i in 1 to 7 ] |

Mmx] |

row_echelon M |

En calcul numérique, la précision relative du résultat est généralement moindre que la précision relative des données. On pourrait appeler la différence entre ces deux précisions la « déperdition de précision ». Cette déperdition admet deux sources tout à fait distinctes :

Une partie de la déperdition est intrinsèque et liée au conditionnement du problème.

L'autre partie est due à l'algorithme de calcul choisi, et on peut espérer la réduire autant que possible en cherchant un bon algorithme.

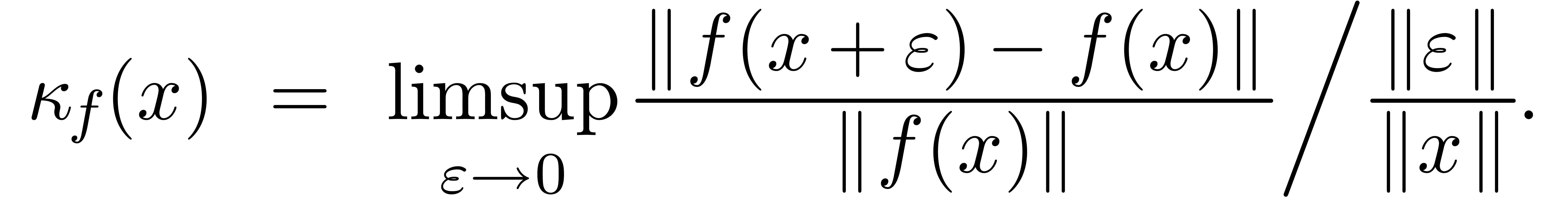

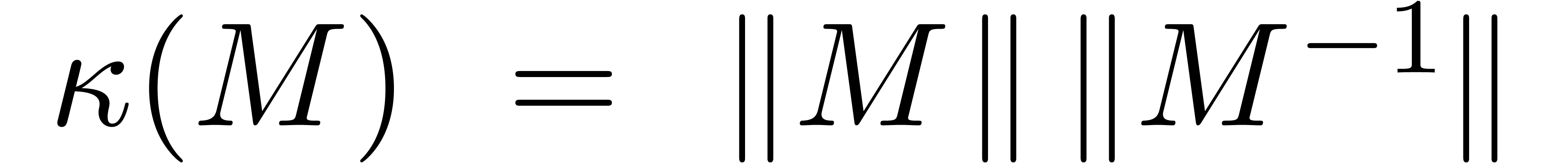

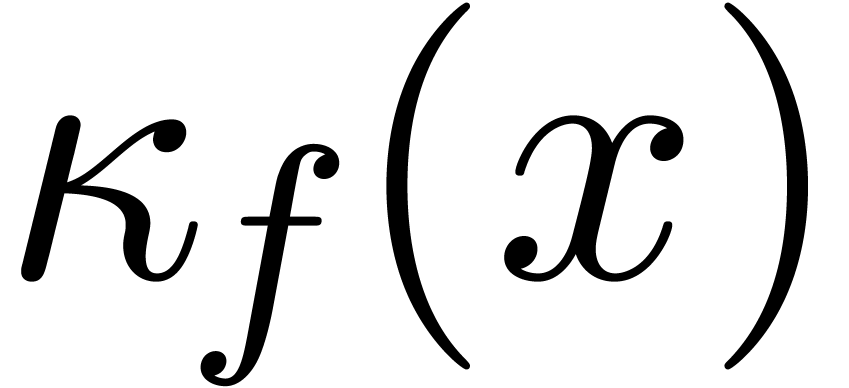

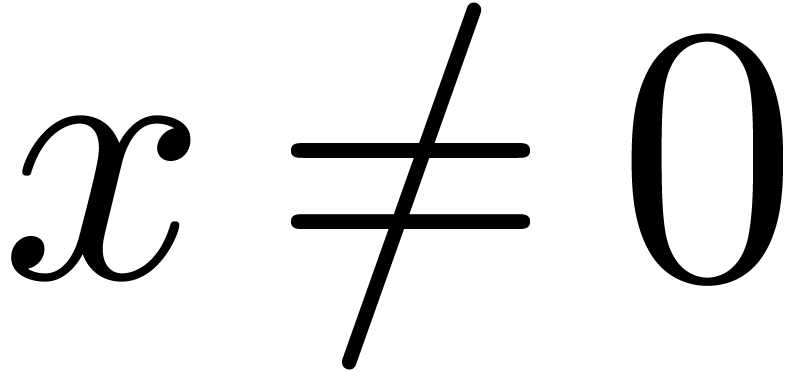

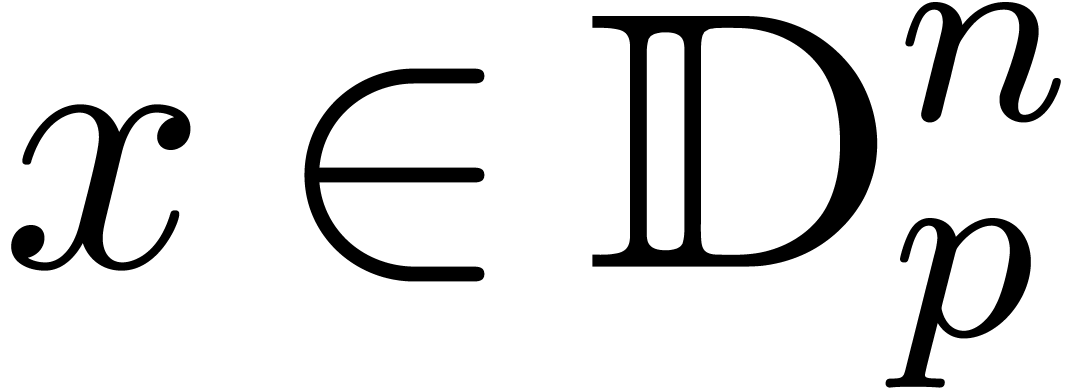

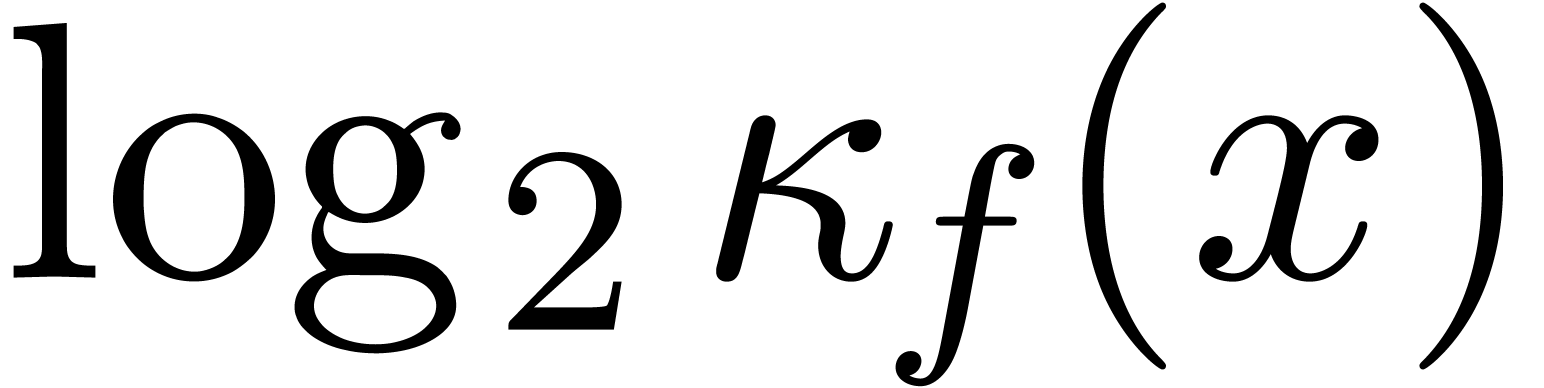

Fixons une norme  sur

sur  et

soit

et

soit  une fonction. On définit le

nombre de conditionnement

une fonction. On définit le

nombre de conditionnement  de

de  en

en  par

par

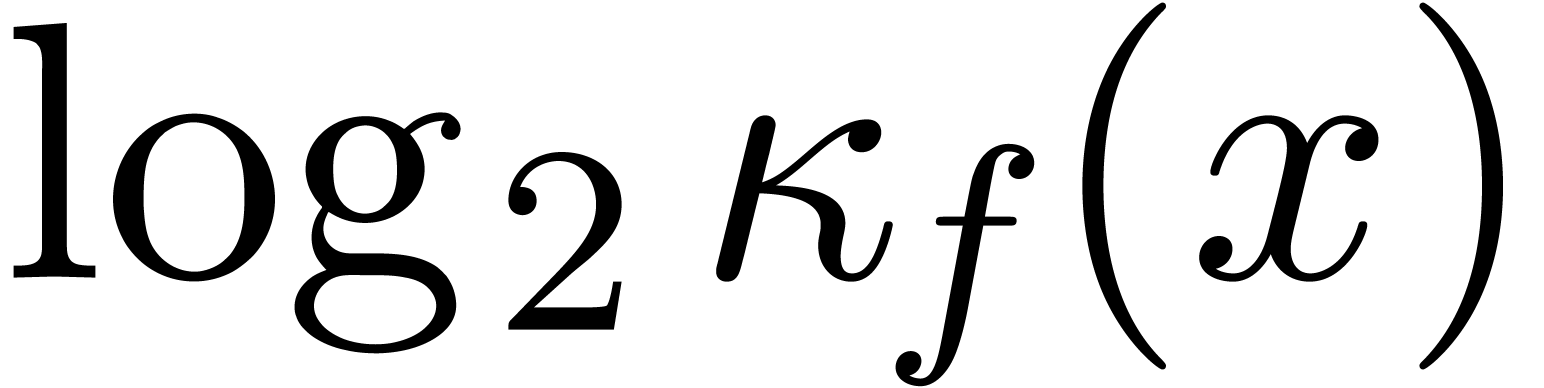

Le logarithme  en base deux mesure donc la

déperdition intrinsèque de précision pour

l'évaluation de

en base deux mesure donc la

déperdition intrinsèque de précision pour

l'évaluation de  en

en  . En algèbre linéaire, on

définit aussi le nombre de conditionnement d'une matrice par

. En algèbre linéaire, on

définit aussi le nombre de conditionnement d'une matrice par

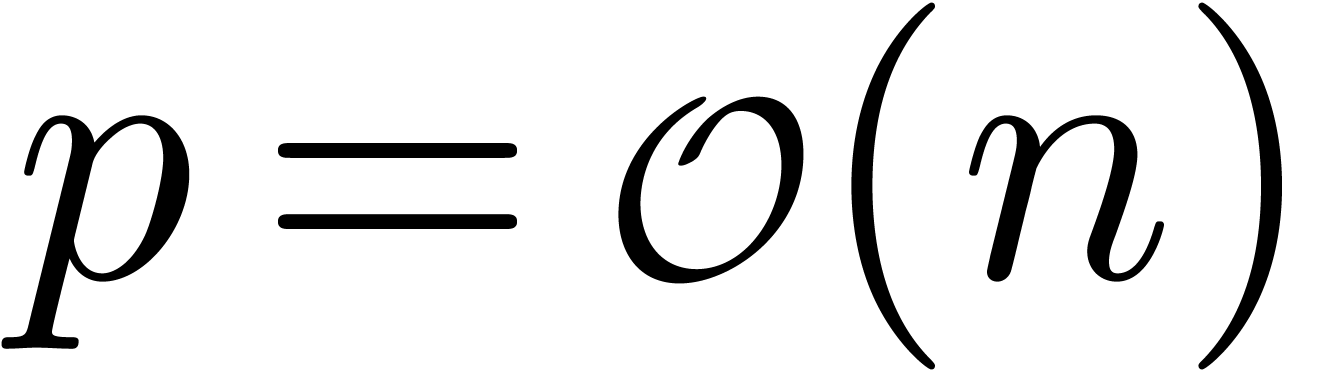

Ceci correspond au maximum des  pour

pour  , où

, où  .

.

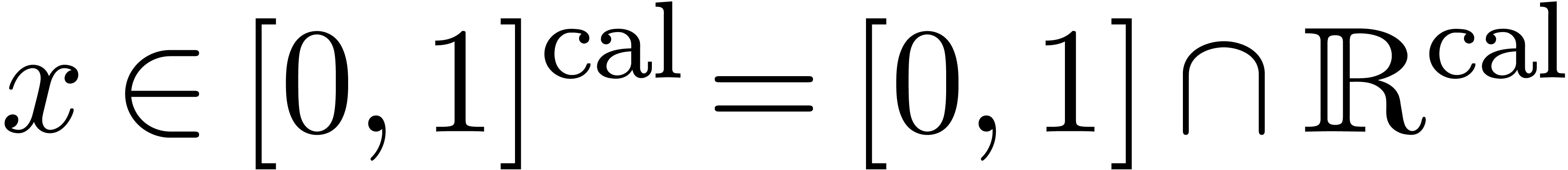

Supposons maintenant que l'on cherche à approcher  par

par  , en

calculant avec une précision de

, en

calculant avec une précision de  bits. On

définit le facteur d'éloignement de

bits. On

définit le facteur d'éloignement de  en

en  par

par

Quand on calcule  en

en  on

perd donc environ

on

perd donc environ  bits de précision de

façon intrinsèque et environ

bits de précision de

façon intrinsèque et environ  bits

additionnels à cause de l'algorithme employé.

bits

additionnels à cause de l'algorithme employé.

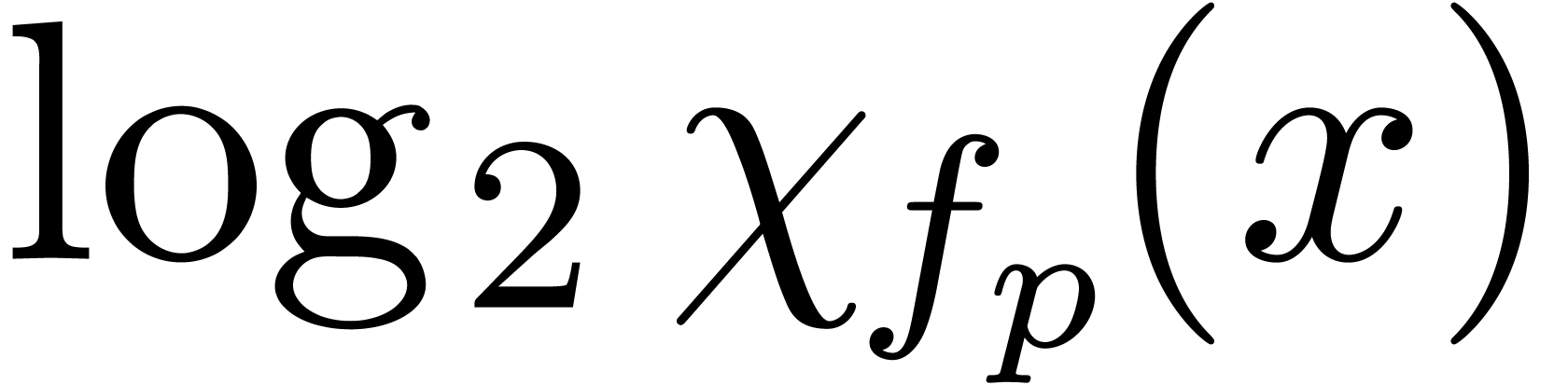

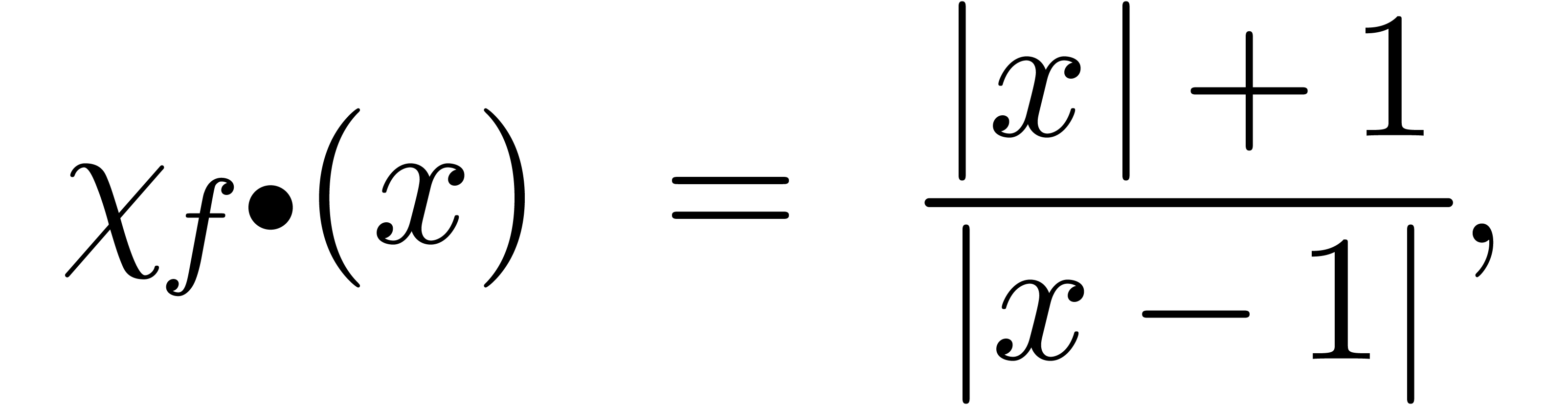

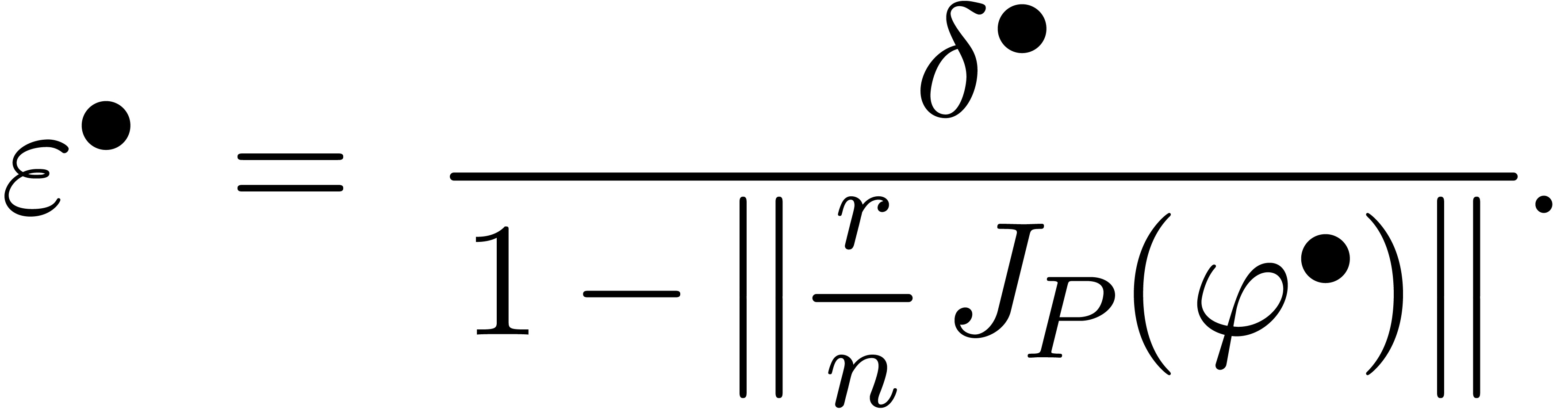

Essayons maintenant de transposer l'esprit de la section précédente à l'arithmétique de boules. Le nombre de conditionnement n'a pas de contre-partie directe. En revanche, on la notion d'une « extension optimale » :

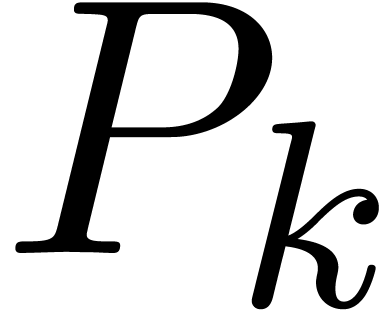

Soit  une fonction. Nous avons déjà

signalé l'existence a priori d'une multitude

d'extensions

une fonction. Nous avons déjà

signalé l'existence a priori d'une multitude

d'extensions  de

de  vérifiant la relation

vérifiant la relation

pour tous les  .

Néanmoins, si on impose la contrainte supplémentaire que

.

Néanmoins, si on impose la contrainte supplémentaire que

est de la forme

est de la forme  pour un

certain

pour un

certain  , alors il existe une

unique extension optimale

, alors il existe une

unique extension optimale  ,

définie par

,

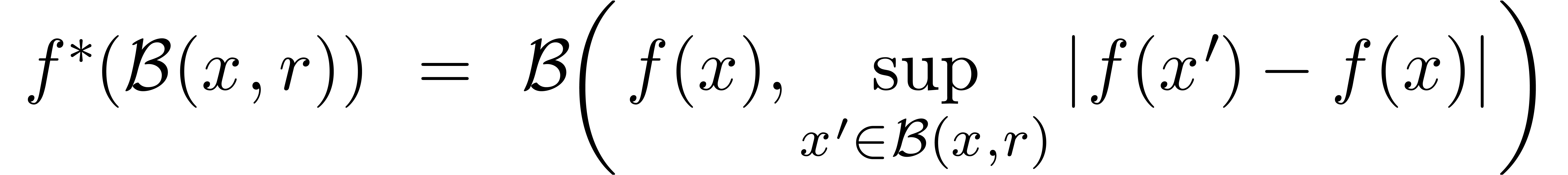

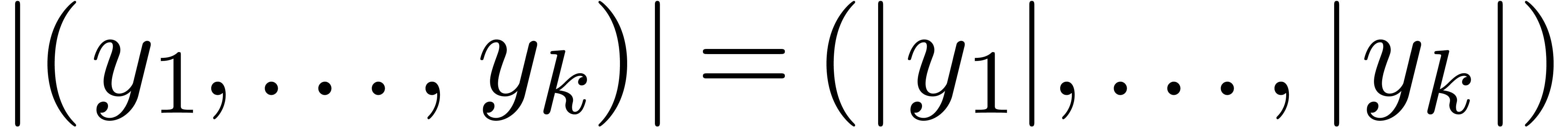

définie par

Ici, on utilise la notation vectorielle. Par exemple  .

.

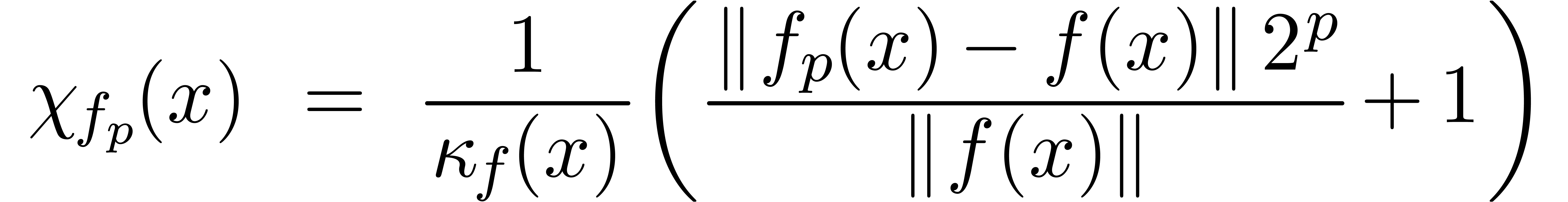

Maintenant, nous pouvons définir la surestimation d'une extension

arbitraire de façon naturelle par rapport

à l'extension optimale

arbitraire de façon naturelle par rapport

à l'extension optimale  .

Plus précisément, étant donnée une boule

.

Plus précisément, étant donnée une boule

, on définit la

surestimation de

, on définit la

surestimation de  en

en  par

par

On définit également la surestimation ponctuelle

de  en

en  par

par

Nous allons voir maintenant que cette surestimation ponctuelle est souvent simple à calculer. De la même manière qu'il est bon pour un algorithme numérique de surveiller le nombre de conditionnement et le facteur d'éloignement, c'est généralement une bonne idée pour un algorithme certifié de surveiller la surestimation. En effet, si la surestimation devient trop importante, il est souvent possible de déclencher un autre algorithme a priori plus couteux, mais plus précis.

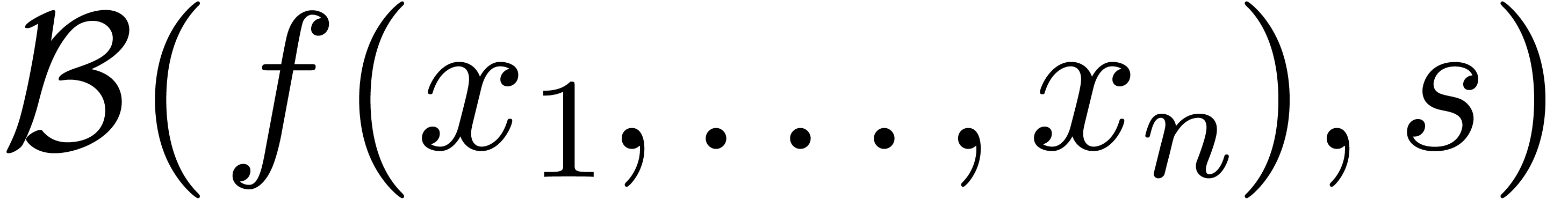

Supposons que l'on ait une expression  construite

à partir de constantes dans

construite

à partir de constantes dans  ,

d'un nombre fini d'indéterminées

,

d'un nombre fini d'indéterminées  et les opérations

et les opérations  .

D'une part, on peut interpréter

.

D'une part, on peut interpréter  comme une

fonction

comme une

fonction  . D'autre part, en

utilisant l'arithmétique de boules standard (3.2–3.4), l'expression

. D'autre part, en

utilisant l'arithmétique de boules standard (3.2–3.4), l'expression  donne naturellement

lieu à une fonction

donne naturellement

lieu à une fonction  .

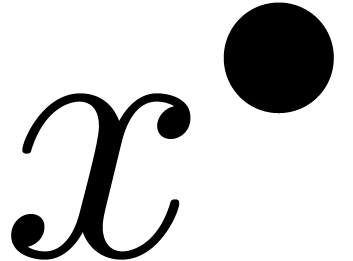

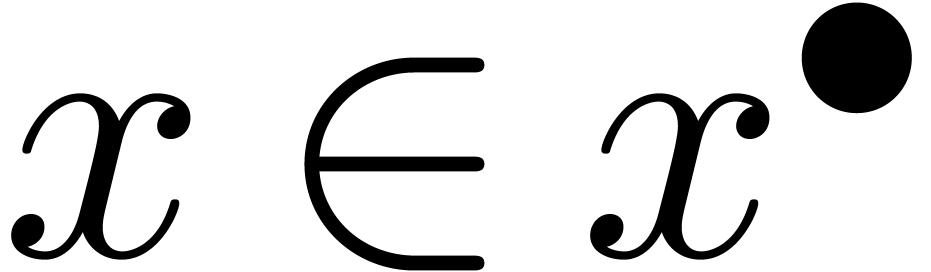

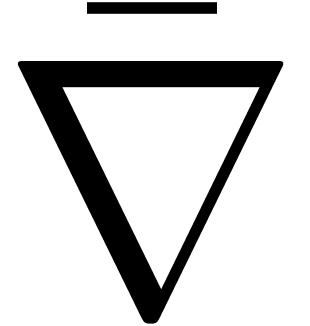

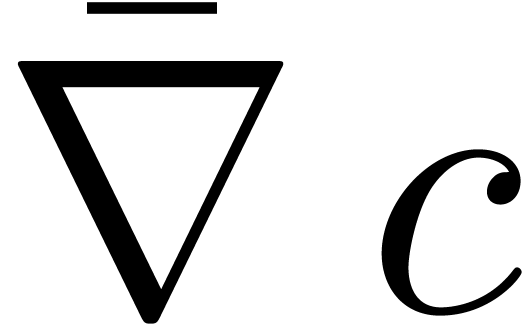

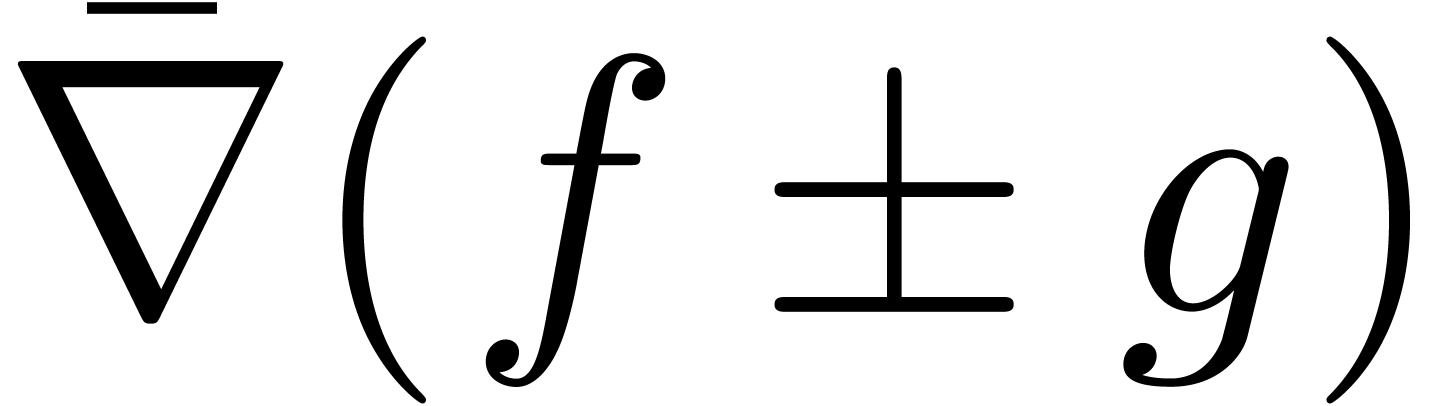

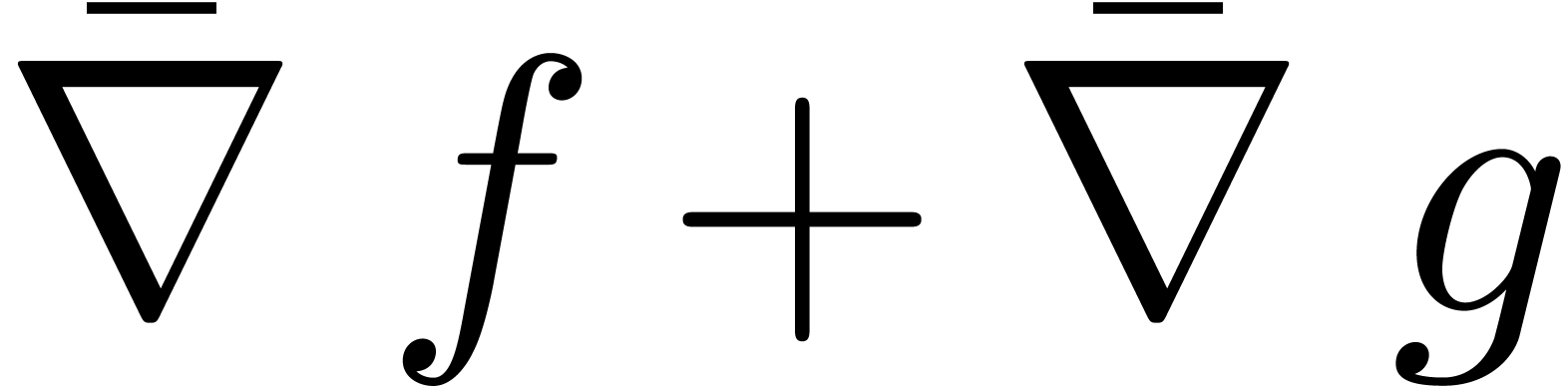

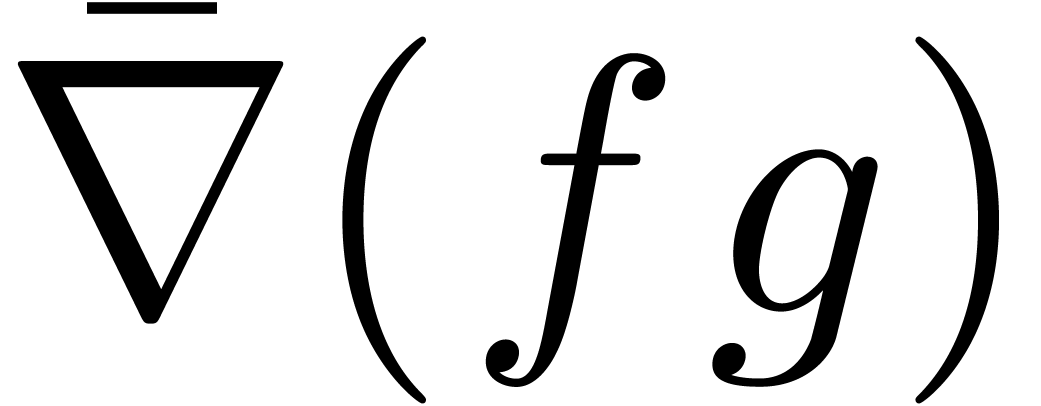

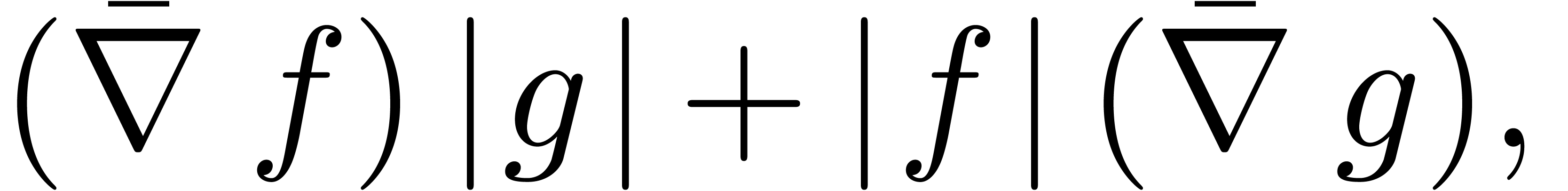

Il n'est pas difficile de montrer que la surestimation ponctuelle de

.

Il n'est pas difficile de montrer que la surestimation ponctuelle de

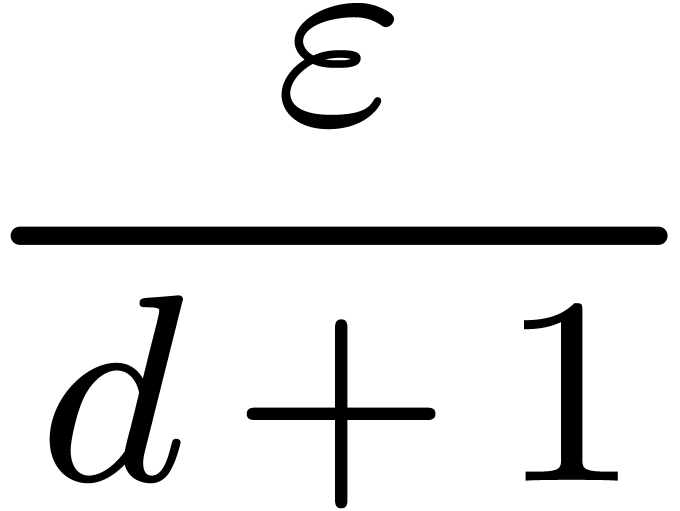

se calcule explicitement par

se calcule explicitement par

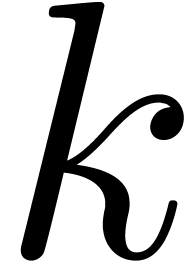

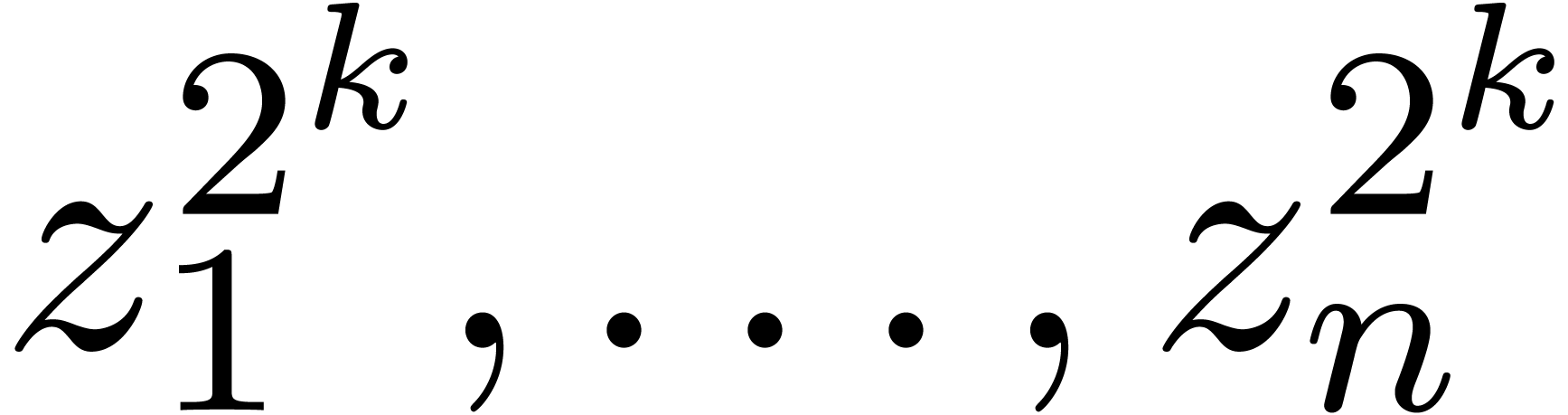

où l'opérateur  de « gradient

majoré » est défini par

de « gradient

majoré » est défini par

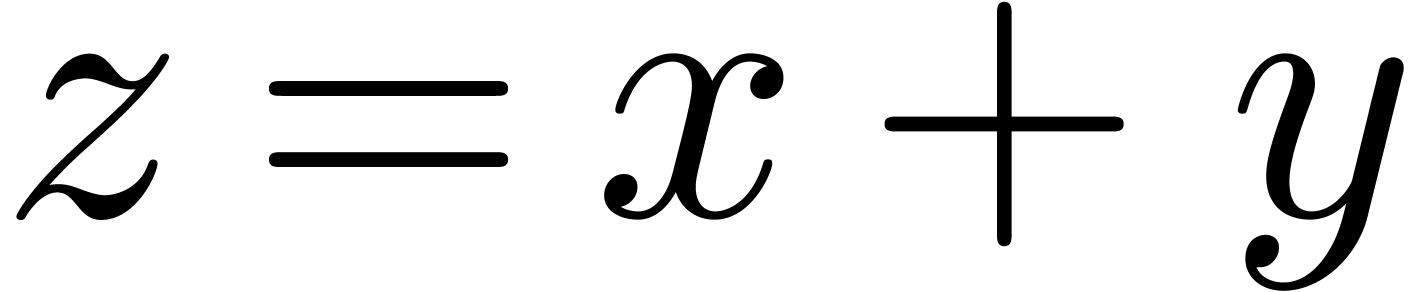

|

|

|

(c∈ℝ) |

|

|

|

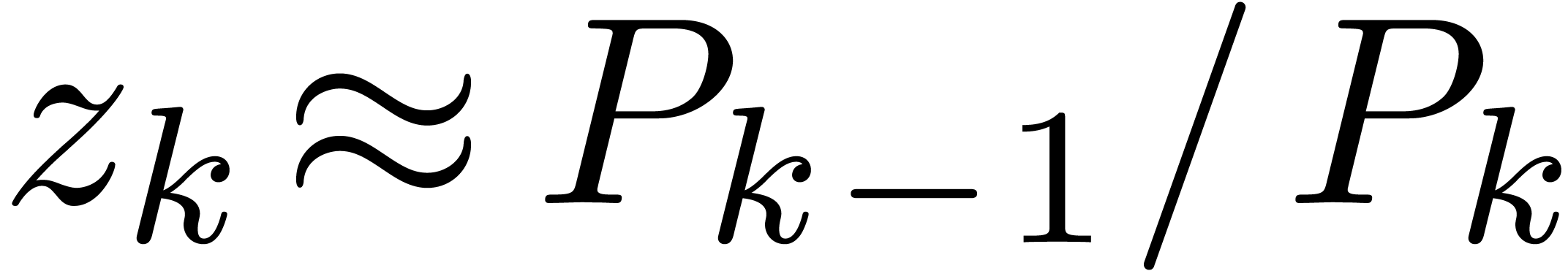

(k∈{1,…,n}) |

|

|

|

|

|

|

|

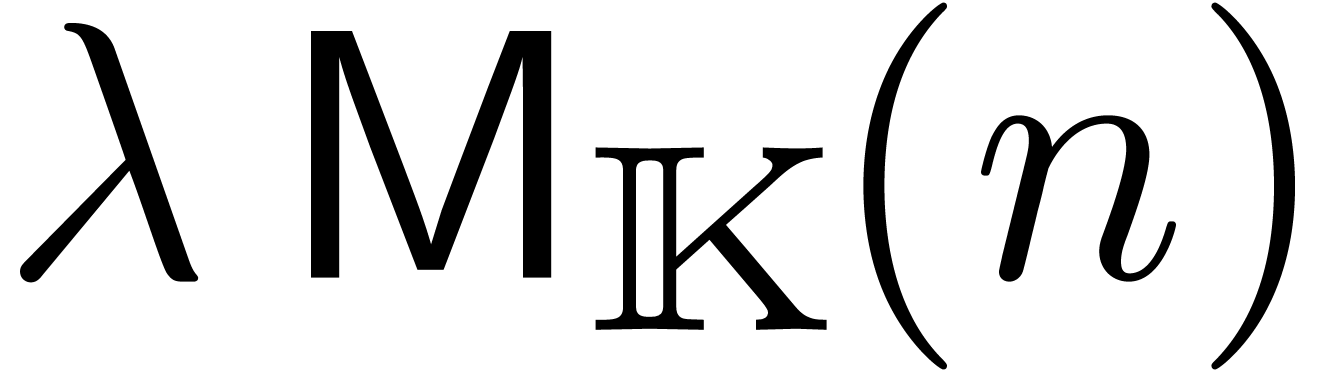

Lorsque  , la formule (3.6) se simplifie en

, la formule (3.6) se simplifie en

Exemple 3.3. Prenons l'exemple

L'extension optimale de  est la même que

pour la fonction

est la même que

pour la fonction  :

:

alors que l'extension standard donne

Par conséquent,

conformément à la formule (3.7).

Cette formule a une conséquence importante pour des algorithmes

par subdivision qui cherchent des zéros de  dans un ensemble donné. En effet, lorsque l'on utilise

l'arithmétique de boules (ou d'intervalles) naïve pour

certifier l'absence de zéros dans des boîtes, on est

forcé de prendre des boîtes

dans un ensemble donné. En effet, lorsque l'on utilise

l'arithmétique de boules (ou d'intervalles) naïve pour

certifier l'absence de zéros dans des boîtes, on est

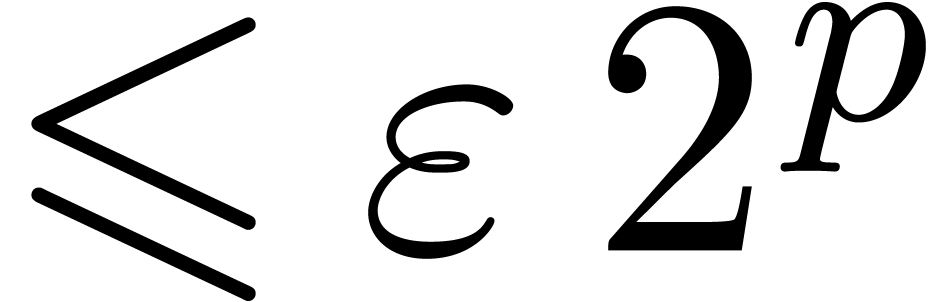

forcé de prendre des boîtes  fois plus petites que nécéssaire. En dimension

fois plus petites que nécéssaire. En dimension  , cela multiplie le coût de

l'algorithme par un facteur

, cela multiplie le coût de

l'algorithme par un facteur  vis à vis un

algorithme théorique optimal. Dans la section 5.4,

nous verrons une méthode systématique pour réduire

la surestimation afin de remédier à ce problème.

vis à vis un

algorithme théorique optimal. Dans la section 5.4,

nous verrons une méthode systématique pour réduire

la surestimation afin de remédier à ce problème.

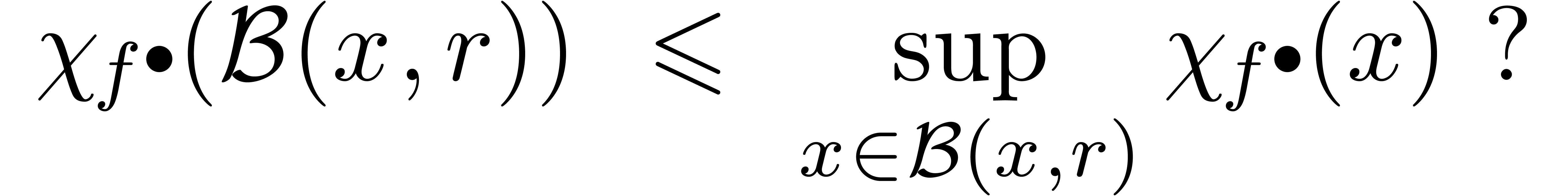

Toujours pour l'arithmétique de boules standard, une problème intéressant est de pouvoir calculer ou au moins estimer la surestimation sur une boule générale par rapport à la surestimation ponctuelle. Voici une question plus précise qui semble abordable :

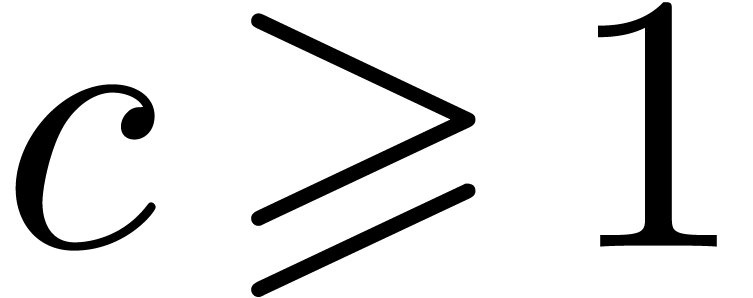

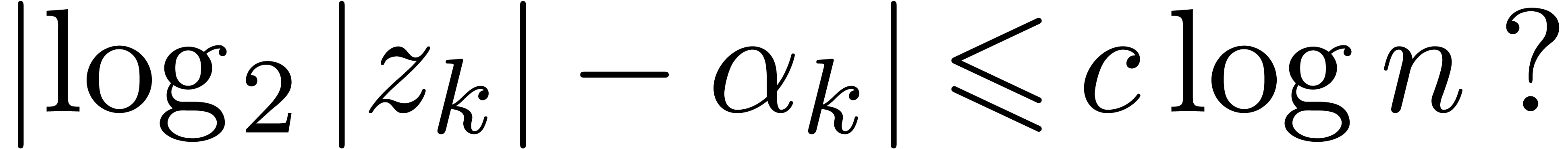

Question. Pour  construite

à partir de

construite

à partir de  , est-ce

que

, est-ce

que

Ayant défini la surestimation d'un algorithme de façon

précise, la question est maintenant comment construire des

algorithmes à la fois efficaces et de bonne qualité (c'est

à dire, avec une surestimation proche de  ). Bien évidemment, il s'agit de deux

objectifs contraires, donc il faudra chercher un compromis.

). Bien évidemment, il s'agit de deux

objectifs contraires, donc il faudra chercher un compromis.

Par exemple, en rendant systématiquement la boule  comme résultat, on obtient un algorithme

très efficace, mais sans intérêt.

Réciproquement, dans de nombreux cas, l'obtention de bornes

optimales est NP complet ou pire [44].

Généralement, les algorithmes qui nous intéressent

introduisent un facteur constant dans la complexité pour calculer

des bornes de qualité acceptable, ou des petits facteurs

logarithmiques ou polynomiaux pour avoir un algorithme avec une

surestimation proche de

comme résultat, on obtient un algorithme

très efficace, mais sans intérêt.

Réciproquement, dans de nombreux cas, l'obtention de bornes

optimales est NP complet ou pire [44].

Généralement, les algorithmes qui nous intéressent

introduisent un facteur constant dans la complexité pour calculer

des bornes de qualité acceptable, ou des petits facteurs

logarithmiques ou polynomiaux pour avoir un algorithme avec une

surestimation proche de  .

.

On rappelle aussi qu'il est souvent possible d'appliquer la stratégie de la « terminaison précoce » : on commence avec un algorithme rapide et a priori de faible qualité. Seulement si la qualité du résultat est jugée insuffisante, on lance des algorithmes plus lents, mais de meilleure qualité.

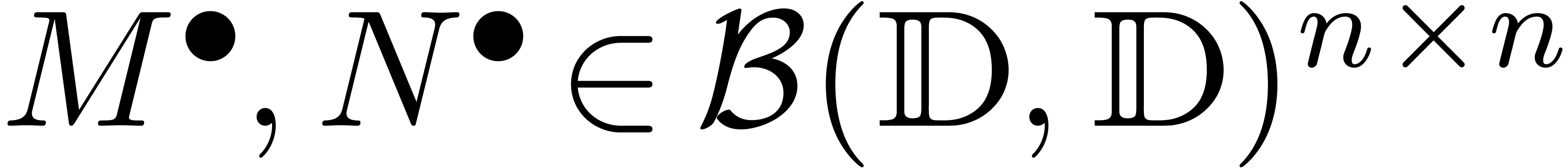

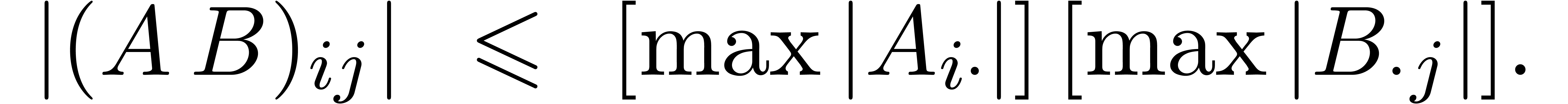

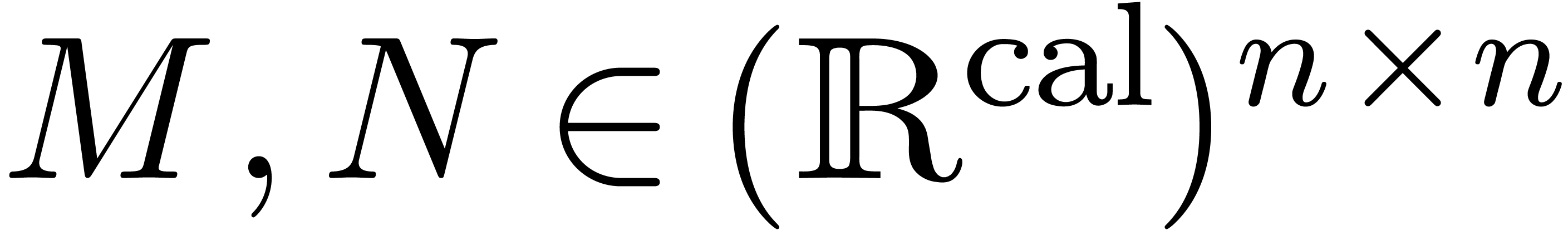

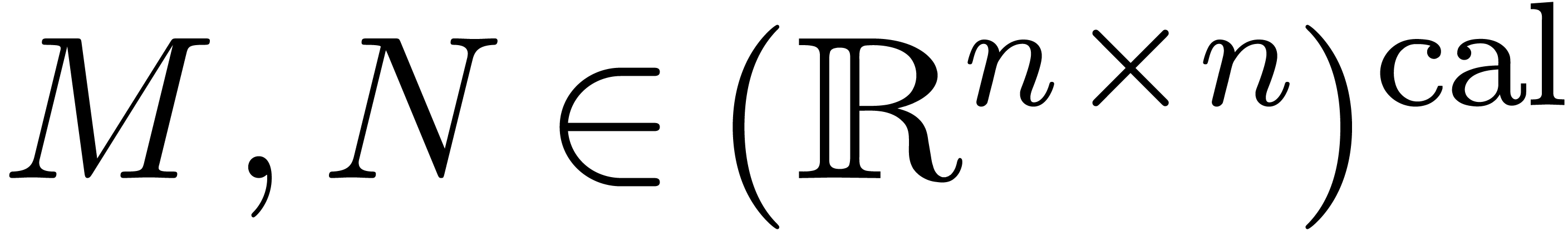

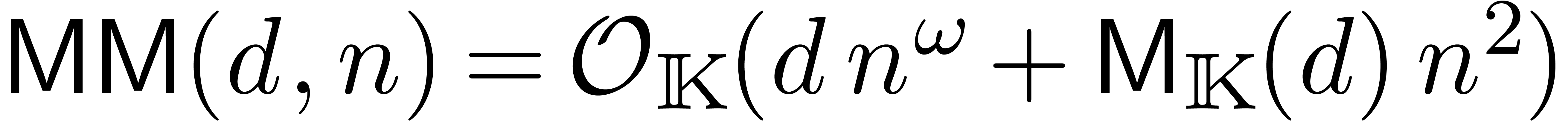

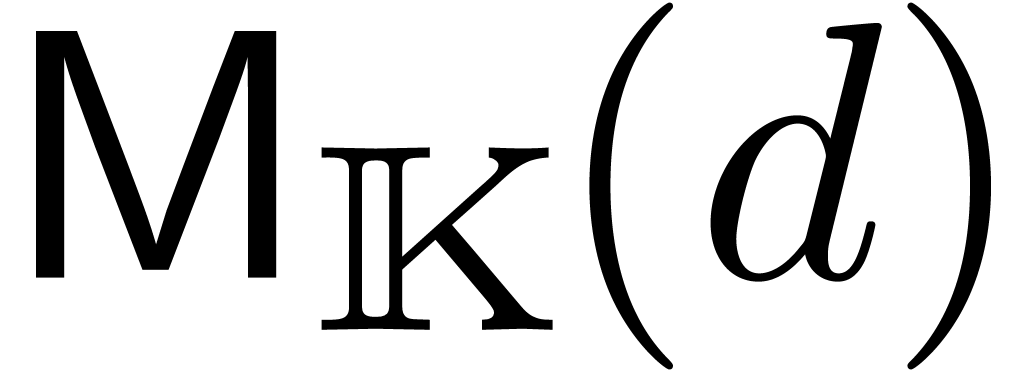

La recherche d'un compromis entre efficacité et qualité

s'illustre bien sur le problème de la multiplication de deux

matrices  .

.

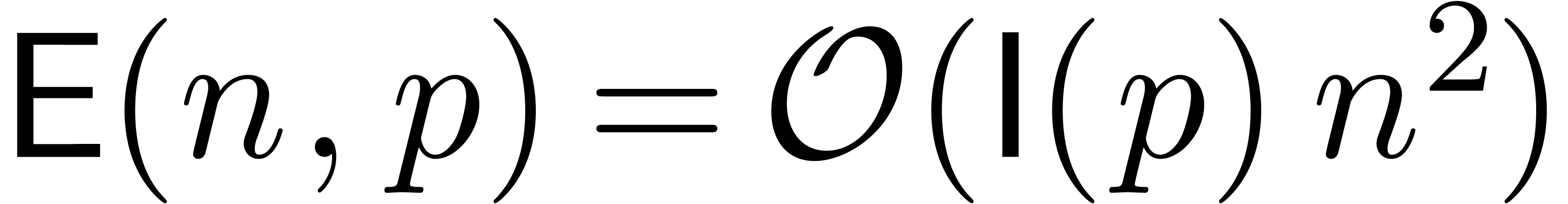

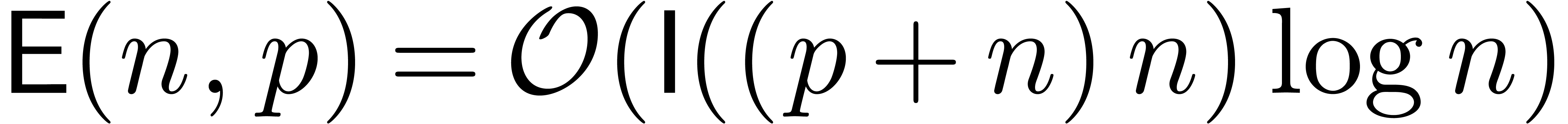

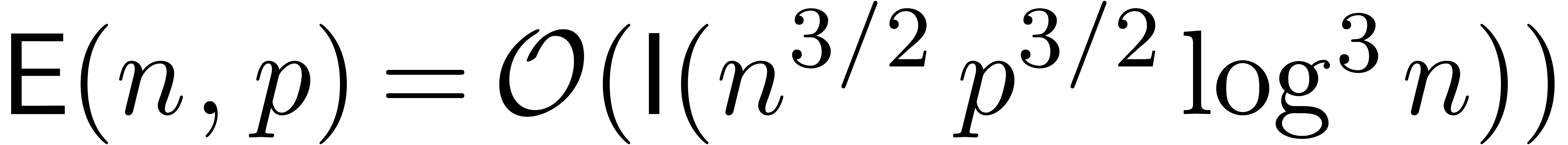

On calcule le produit par l'algorithme classique en utilisant  opérations en arithmétique de

boules. C'est un algorithme de bonne qualité, mais assez

lent.

opérations en arithmétique de

boules. C'est un algorithme de bonne qualité, mais assez

lent.

On réinterprète  comme des

boules avec des centres et des rayons dans

comme des

boules avec des centres et des rayons dans  . Dès lors, on peut utiliser la formule

(3.4) pour la multiplication, quitte à

rajouter le nécessaire pour les erreurs d'arrondi.

. Dès lors, on peut utiliser la formule

(3.4) pour la multiplication, quitte à

rajouter le nécessaire pour les erreurs d'arrondi.

L'avantage principal de cette méthode est que l'on s'appuie

directement sur la multiplication matricielle dans  au lieu de faire toutes les opérations sur

les coefficients un par un dans l'arithmétique des boules.

En effet, la multiplication dans

au lieu de faire toutes les opérations sur

les coefficients un par un dans l'arithmétique des boules.

En effet, la multiplication dans  est

généralement hautement optimisée (en

précision machine, on peut par exemple utiliser des

est

généralement hautement optimisée (en

précision machine, on peut par exemple utiliser des

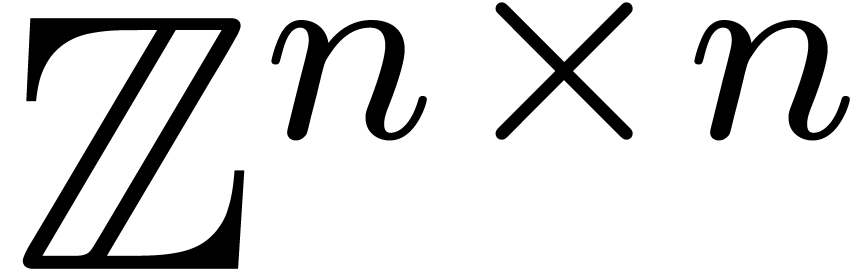

Dans la méthode précédente, on majore le

rayon du produit par la somme de deux produits de matrices dans

. Étant

données deux matrices

. Étant

données deux matrices  ,

il est souvent possible d'obtenir une majoration raisonnable du

produit

,

il est souvent possible d'obtenir une majoration raisonnable du

produit  en faisant seulement

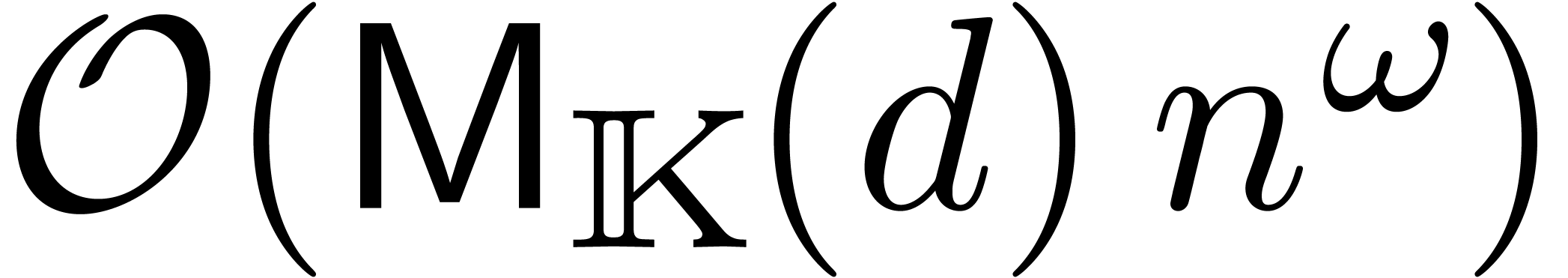

en faisant seulement  opérations.

opérations.

En effet, supposons qu'après préconditionnement, on

peut s'arranger pour que les entrées de chaque ligne de

et de chaque colonne de

et de chaque colonne de  soient du même ordre de grandeur. Dans ce cas, on peut

utiliser la formule

soient du même ordre de grandeur. Dans ce cas, on peut

utiliser la formule

Dans la pratique, il arrive souvent que les entrées d'une

matrice soient localement du même ordre de grandeur, mais

pas globalement, même après

préconditionnement. Dans ce cas, on peut découper la

matrice en petits blocs de matrices  ,

utiliser des majorations brutales sur ces petits blocs et un

algorithme plus naïf pour la matrice toute entière.

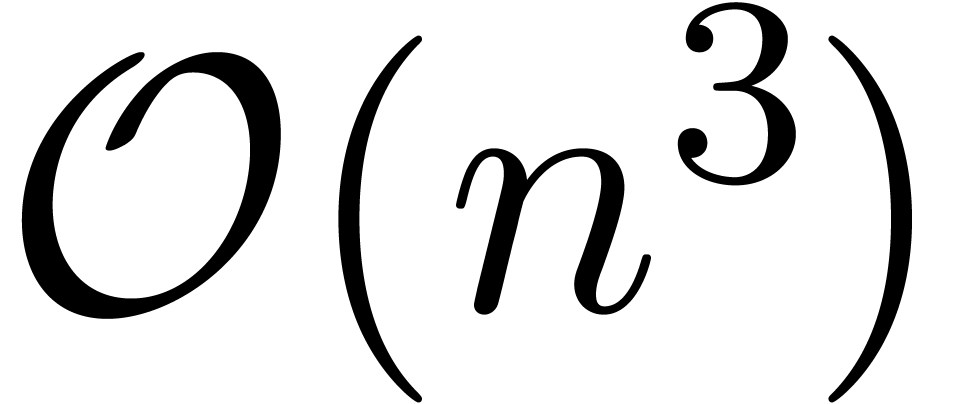

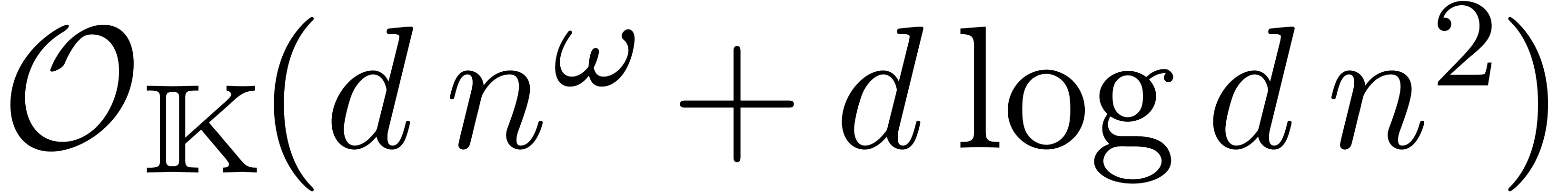

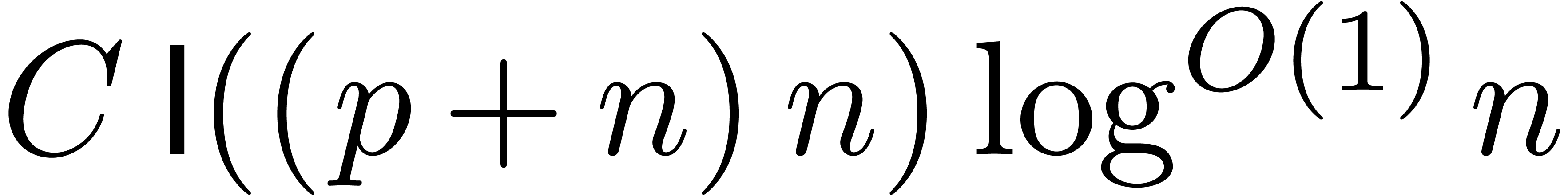

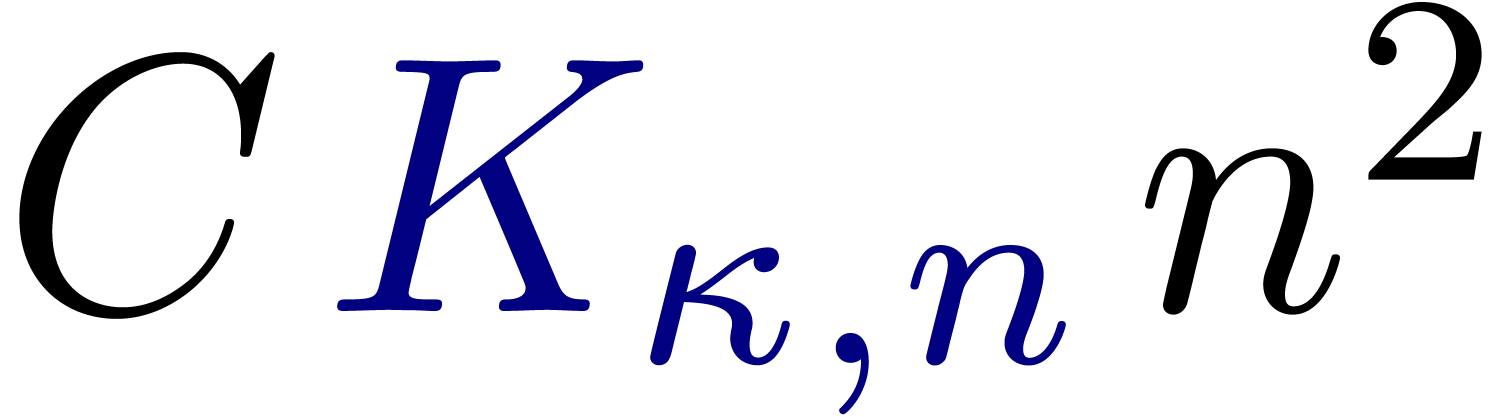

Ceci conduit à un algorithme de coût

,

utiliser des majorations brutales sur ces petits blocs et un

algorithme plus naïf pour la matrice toute entière.

Ceci conduit à un algorithme de coût  supérieur à la multiplication dans

supérieur à la multiplication dans  , avec

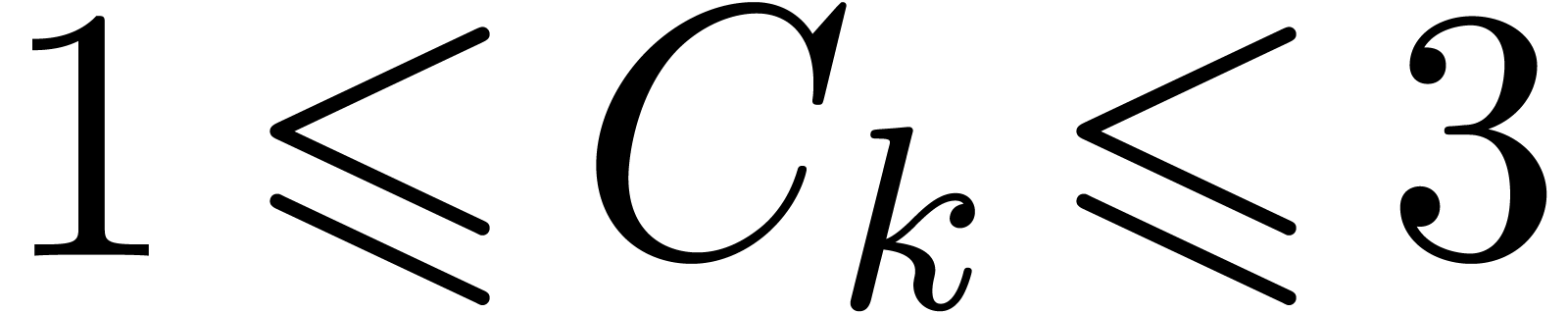

, avec  .

.

De manière générale, on observe aussi que le

coût de certification des calculs tend souvent à devenir

négligeable pour des gros problèmes. Par exemple, pour la

multiplication dans  ,

l'estimation des erreurs se fait généralement en simple

précision. En grande précision, le coût de deux

multiplications en simple précision devient négligeable

devant le coût d'une grosse multiplication dans

,

l'estimation des erreurs se fait généralement en simple

précision. En grande précision, le coût de deux

multiplications en simple précision devient négligeable

devant le coût d'une grosse multiplication dans  . De même, dans des cas bien

conditionnés où on peut utiliser la méthode des

majorations brutales pour la multiplication des matrices, le coût

des

. De même, dans des cas bien

conditionnés où on peut utiliser la méthode des

majorations brutales pour la multiplication des matrices, le coût

des  opérations pour estimer les erreurs

est négligeable devant le coût

opérations pour estimer les erreurs

est négligeable devant le coût  pour

la multiplication des centres.

pour

la multiplication des centres.

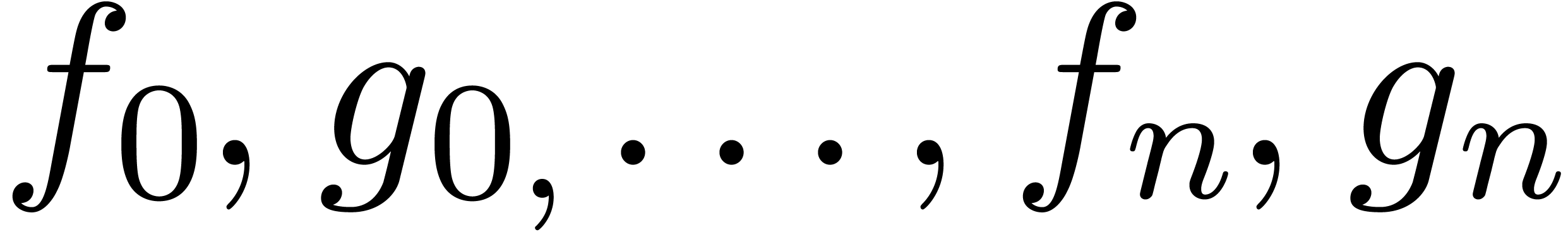

À présent, nous avons vu les types de base pour le calcul

analytique. D'un point de vue haut niveau, nous avons les nombres

calculables de  ,

,  ,

,  ,

etc. Juste en-dessous suit l'arithmétique de boules qui permet le

calcul certifié avec des approximations. Tout en bas, nous avons

le calcul numérique classique avec des nombres en virgule

flottante et l'arithmétique rapide pour les mantisses en

précision arbitraire.

,

etc. Juste en-dessous suit l'arithmétique de boules qui permet le

calcul certifié avec des approximations. Tout en bas, nous avons

le calcul numérique classique avec des nombres en virgule

flottante et l'arithmétique rapide pour les mantisses en

précision arbitraire.

Cette division en quatre niveaux de la « hiérarchie numérique » est pertinente pour la plupart des algorithmes en calcul analytique. Dans le cas d'une multiplication de matrices par exemple, on procède comme suit :

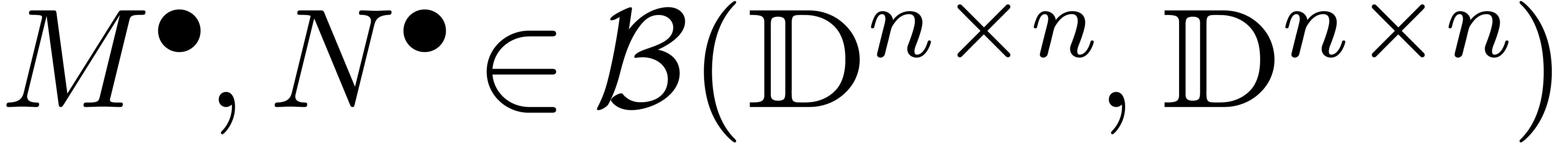

Au niveau conceptuel, nous partons de deux matrices  à multiplier. Une telle matrice est constituée de

à multiplier. Une telle matrice est constituée de  promesses d'approximation. Pour gagner en

efficacité il vaut mieux réécrire

promesses d'approximation. Pour gagner en

efficacité il vaut mieux réécrire  .

.

Pour une précision  donnée, on

approche

donnée, on

approche  et

et  par des

matrices de boules

par des

matrices de boules  , ou

mieux, encore pour des raisons d'efficacité, comme des boules

matricielles

, ou

mieux, encore pour des raisons d'efficacité, comme des boules

matricielles  .

.

L'arithmétique de boules dans  conduit

à l'arithmétique en virgule flottante standard dans

conduit

à l'arithmétique en virgule flottante standard dans

sur les centres et les rayons. Si

sur les centres et les rayons. Si  est petit, on peut utiliser des nombres machines et

des BLAS rapides.

est petit, on peut utiliser des nombres machines et

des BLAS rapides.

Si  est plus grand, et si on cherche à

multiplier efficacement des matrices

est plus grand, et si on cherche à

multiplier efficacement des matrices  ,

il est souvent possible de les préconditionner et ensuite

à les écrire par rapport à un même

exposant :

,

il est souvent possible de les préconditionner et ensuite

à les écrire par rapport à un même

exposant :  . On peut

alors employer un algorithme de multiplication de matrices rapide

dans

. On peut

alors employer un algorithme de multiplication de matrices rapide

dans  .

.

L'algorithmique rapide est un sujet classique en calcul formel. Nous ferons quelques rappels, sans chercher à être exhaustif. Voir par exemple [31, 6] pour deux références classiques.

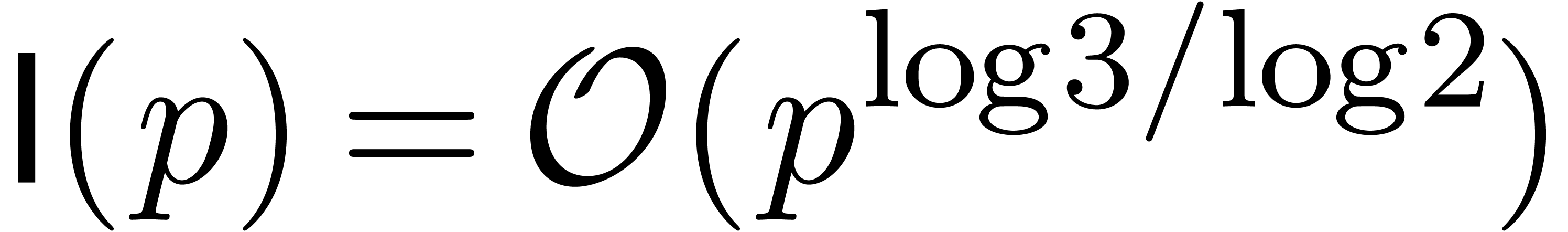

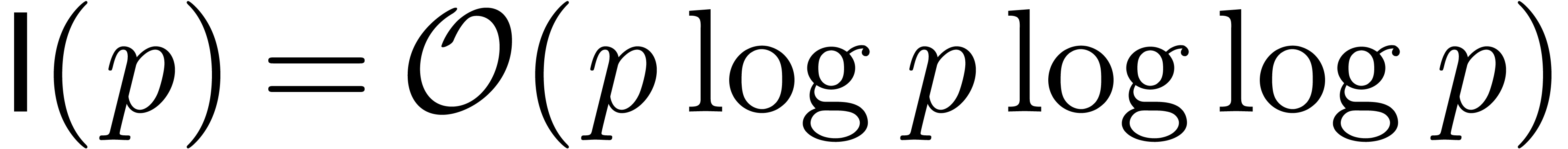

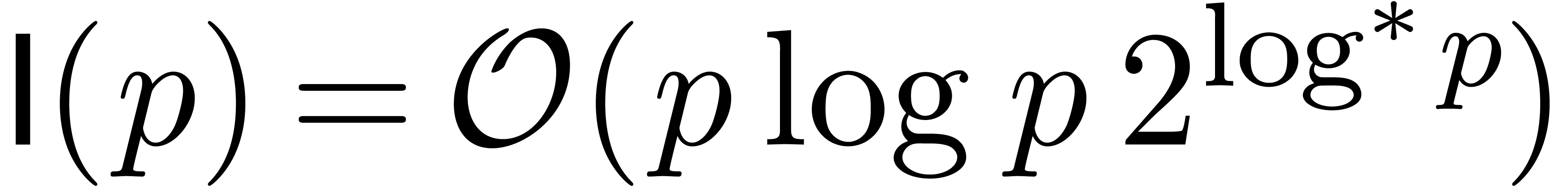

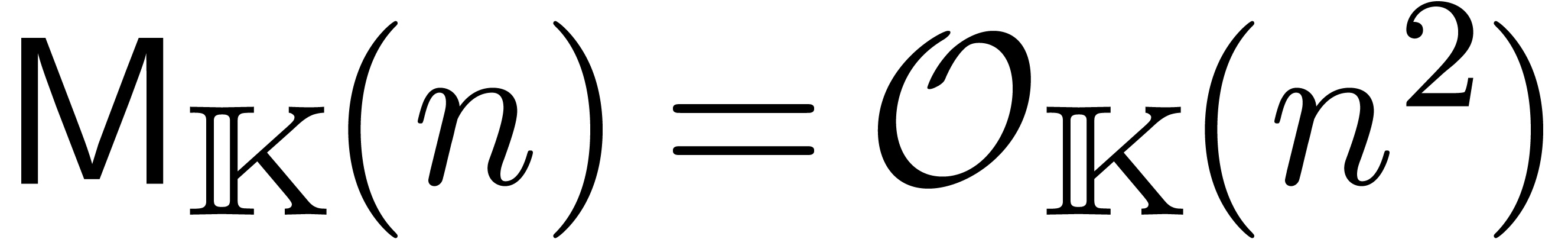

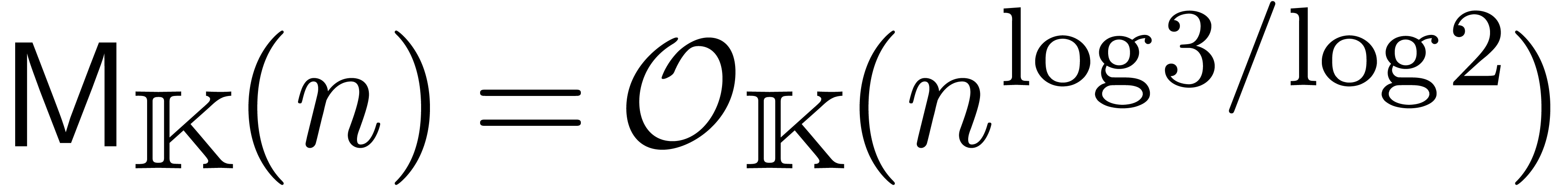

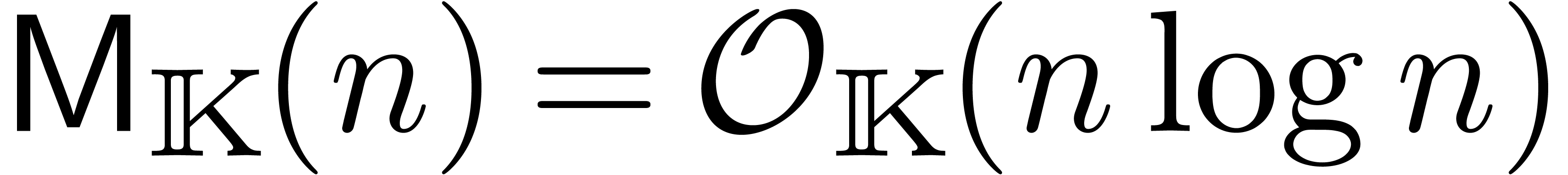

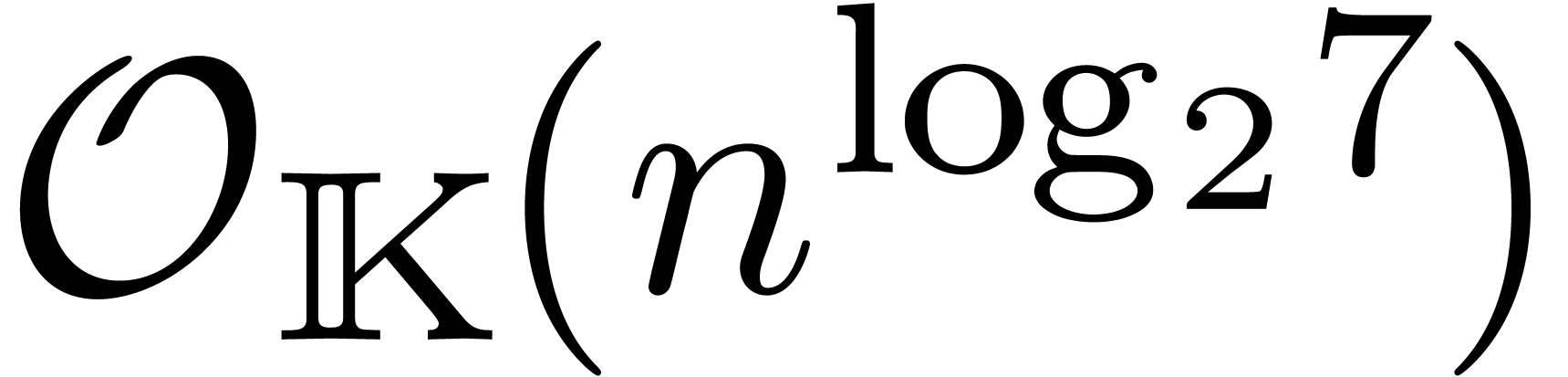

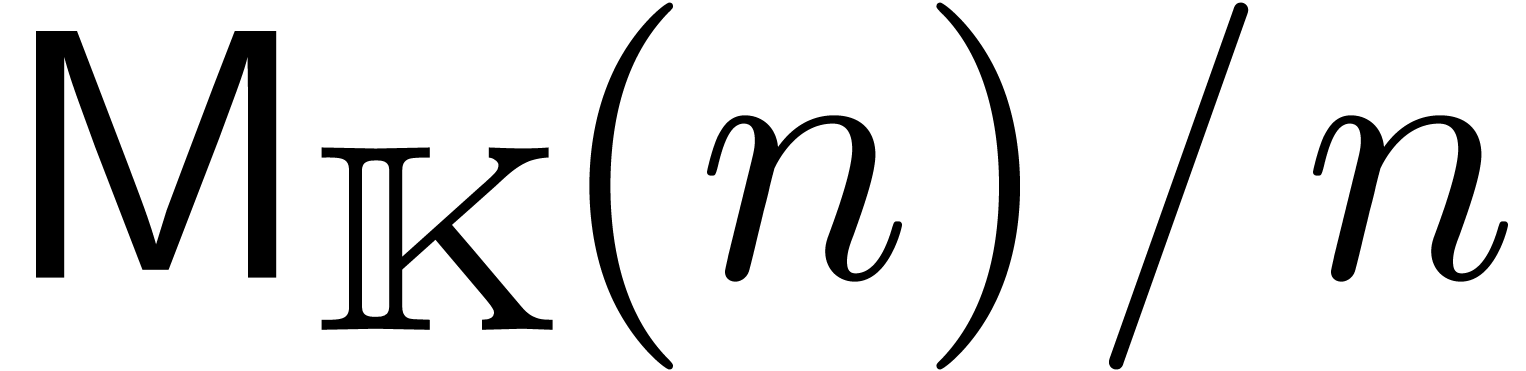

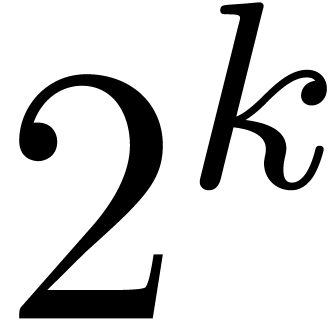

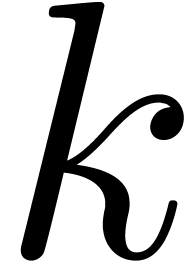

L'opération clef à comprendre pour des analyses en complexité est la multiplication, que ça soit sur les entiers, sur les nombres flottants, les polynômes, les matrices, ou encore les séries. Les complexités d'autres opérations (division, racine carrée, etc.) s'expriment généralement en fonction du coût de la multiplication. Voici quelques complexités classiques concernant la multiplication :

chiffres

chiffres

: multiplication

naïve.

: multiplication

naïve.

: multiplication de

Karatsuba [41].

: multiplication de

Karatsuba [41].

: multiplication de

Schönhage-Strassen [67].

: multiplication de

Schönhage-Strassen [67].

: multiplication de

Fürer [30].

: multiplication de

Fürer [30].

de degré

de degré

: multiplication

naïve (on compte le nombre d'opérations dans

: multiplication

naïve (on compte le nombre d'opérations dans  ).

).

: multiplication de

Karatsuba [41].

: multiplication de

Karatsuba [41].

si

si  admet

suffisamment de racines

admet

suffisamment de racines  -ièmes

de l'unité [19].

-ièmes

de l'unité [19].

: multiplication

naïve.

: multiplication

naïve.

: multiplication de

Strassen [74].

: multiplication de

Strassen [74].

à l'ordre

à l'ordre  (voir la section

4.3)

(voir la section

4.3)

: multiplication

naïve.

: multiplication

naïve.

si

si  admet

suffisamment de racines

admet

suffisamment de racines  -ièmes

de l'unité [83].

-ièmes

de l'unité [83].

avec des coefficients de

avec des coefficients de  chiffres

chiffres

: Kronecker [31].

: Kronecker [31].

avec des coefficients dans

avec des coefficients dans

si la complexité

si la complexité  pour la multiplication est obtenue par

évaluation-interpolation en

pour la multiplication est obtenue par

évaluation-interpolation en  de

points.

de

points.

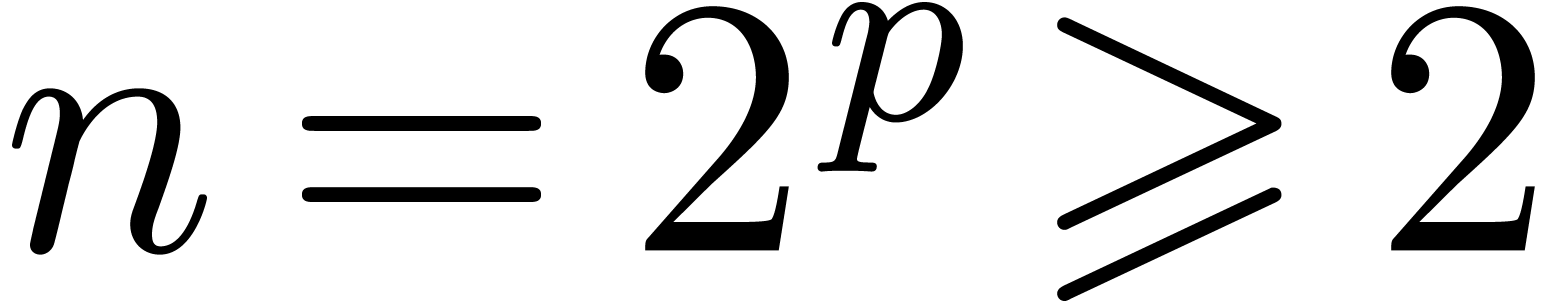

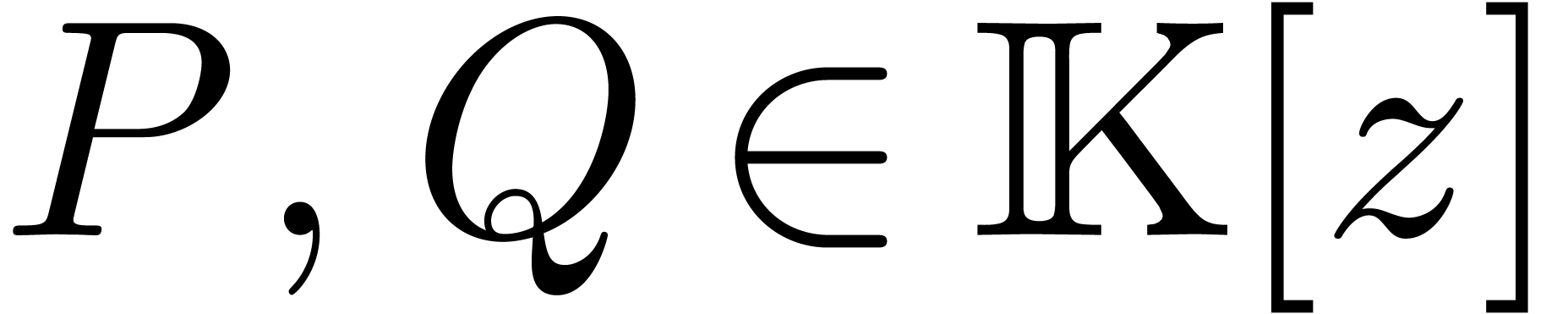

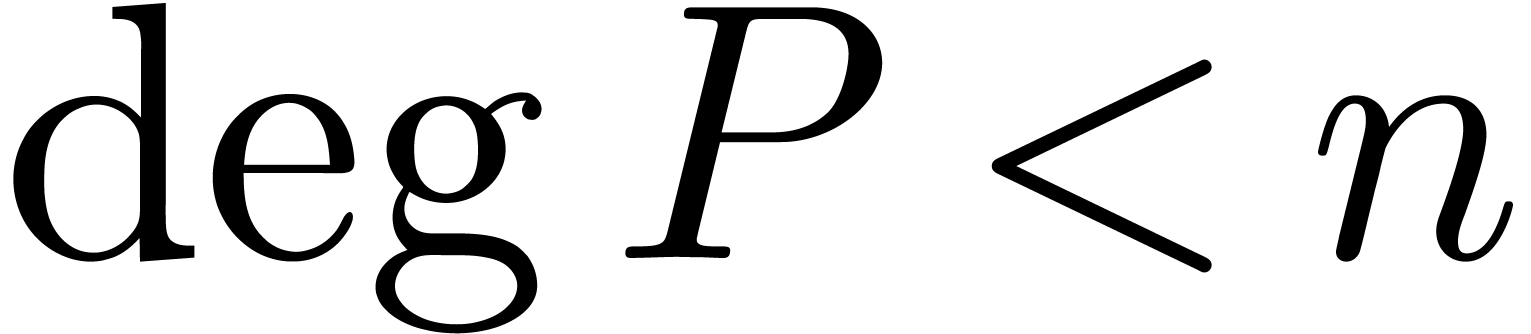

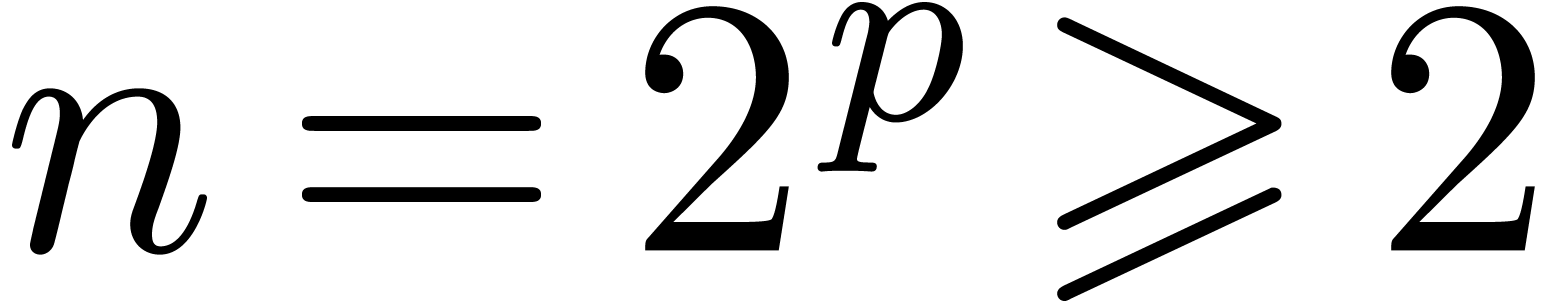

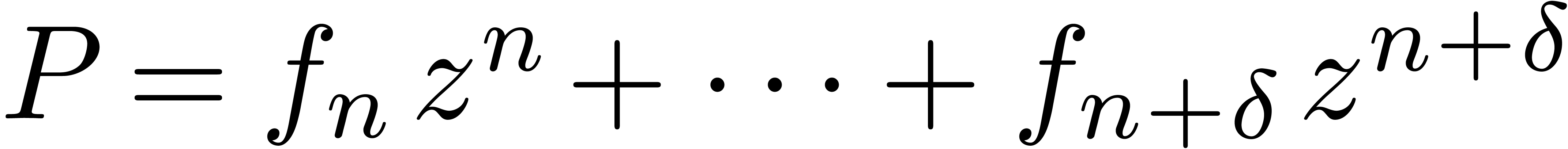

Il existe deux variantes pour multiplier deux polynômes  de degrés

de degrés  .

On peut couper les polynômes en deux à l'exposant

.

On peut couper les polynômes en deux à l'exposant  , ou par exposants pairs-impairs.

L'algorithme pair-impair est généralement plus stable d'un

point de vue numérique :

, ou par exposants pairs-impairs.

L'algorithme pair-impair est généralement plus stable d'un

point de vue numérique :

Multiplication FFT

La multiplication de Karatsuba est un algorithme « multi-modulaire

» classique, procédant par évaluation-interpolation

dans les points  (en projectif). Si

(en projectif). Si  admet une racine primitive de l'unité

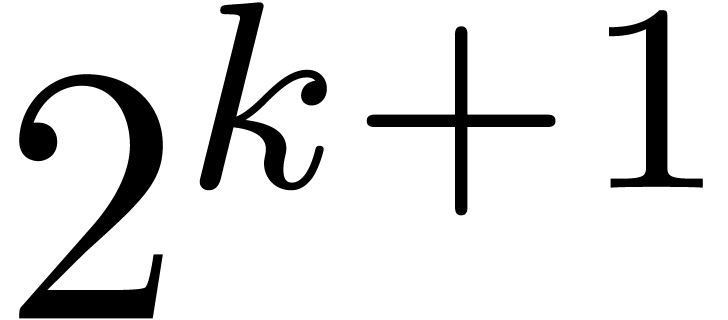

admet une racine primitive de l'unité  d'ordre

d'ordre  (donc

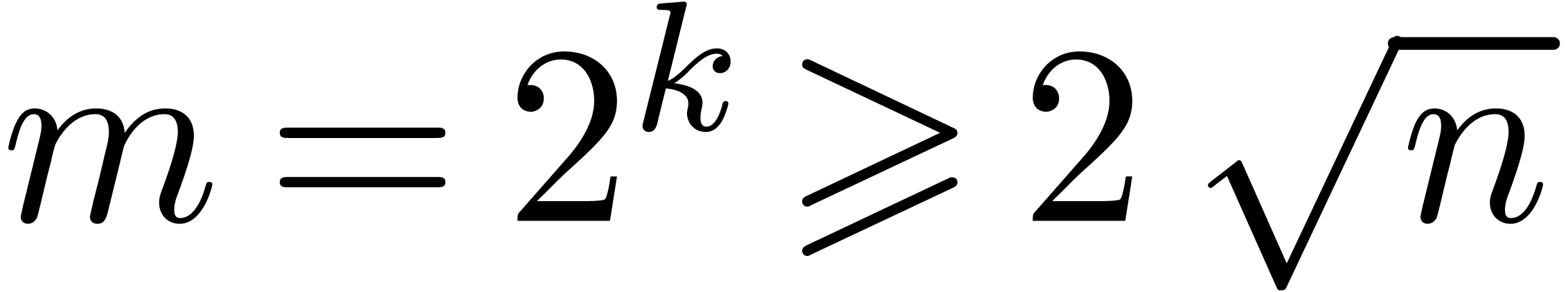

(donc  ), une stratégie multi-modulaire plus

efficace est basée sur la transformation de Fourier

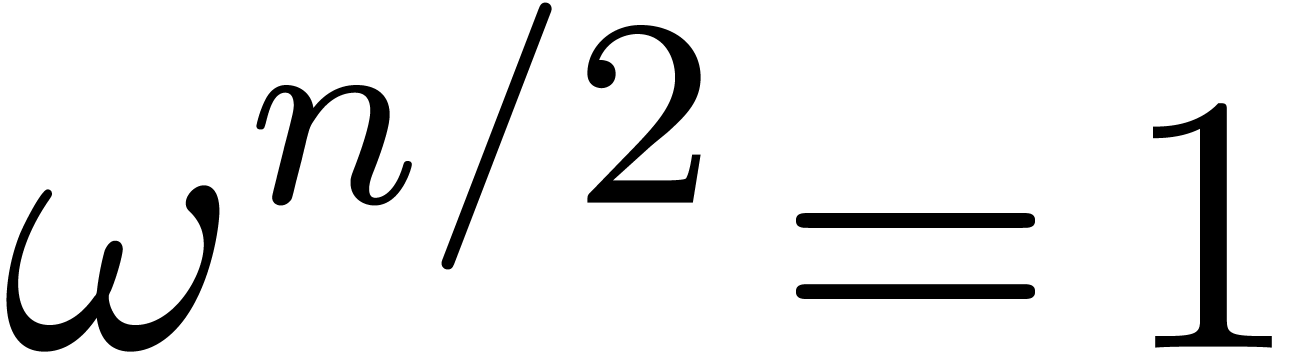

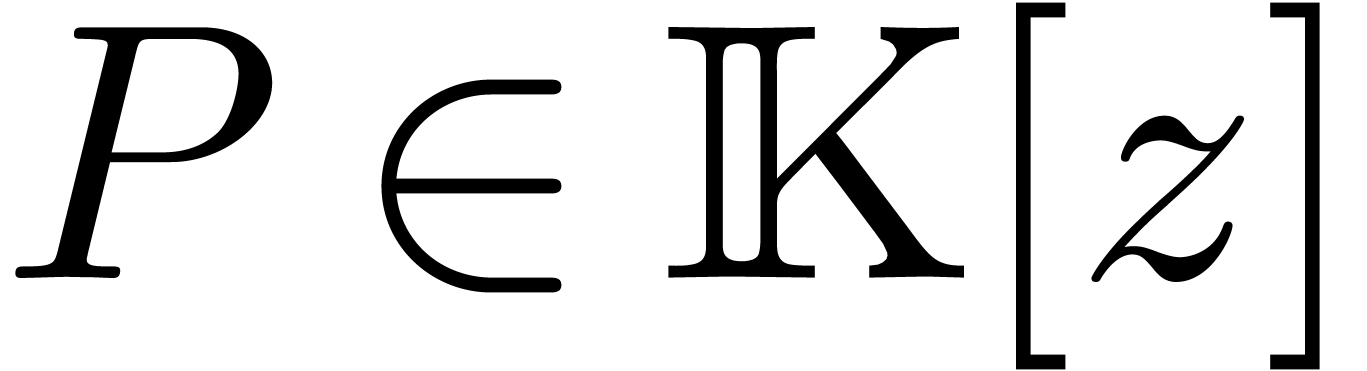

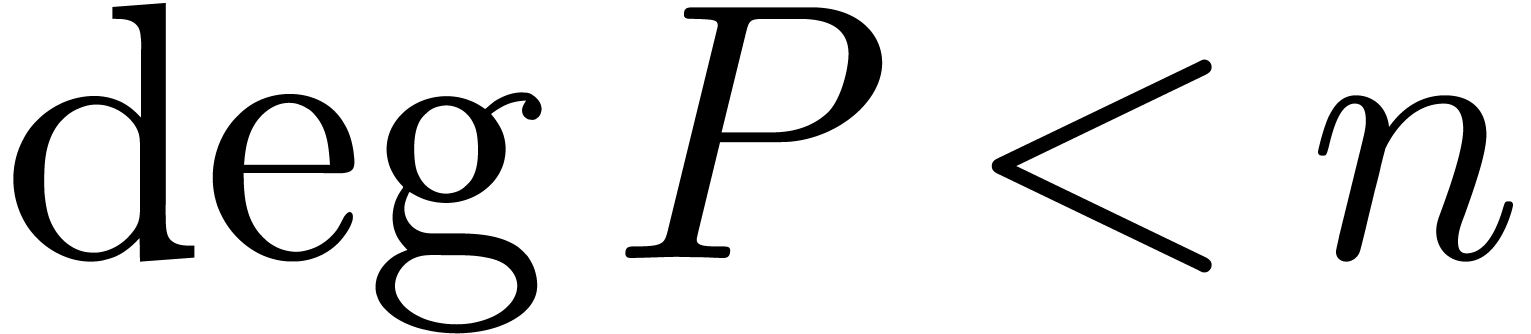

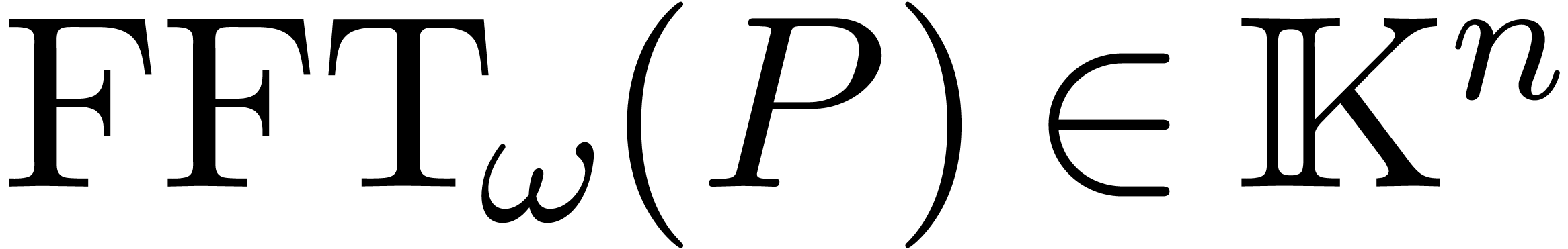

discrète rapide (FFT). Pour un polynôme

), une stratégie multi-modulaire plus

efficace est basée sur la transformation de Fourier

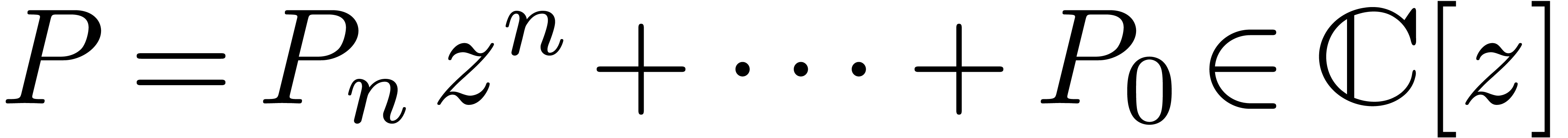

discrète rapide (FFT). Pour un polynôme  avec

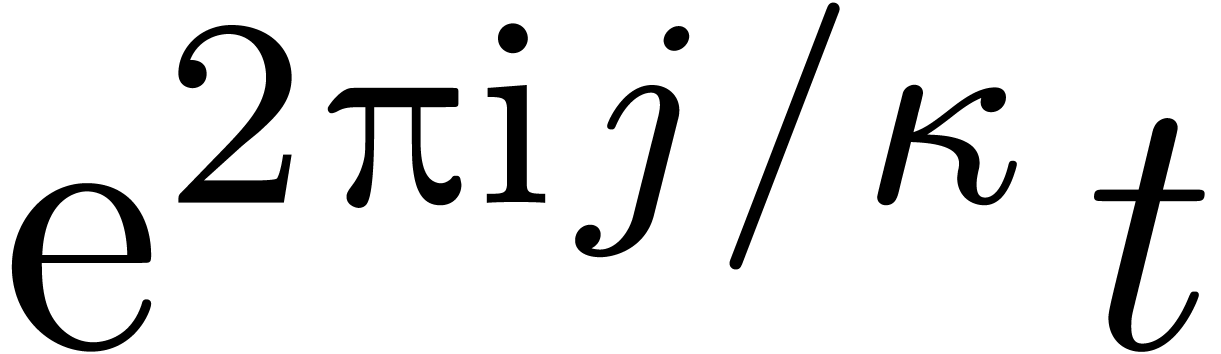

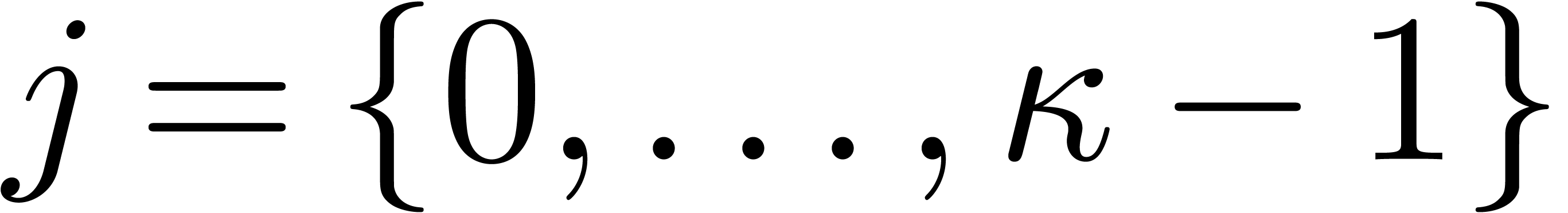

avec  , on définit

, on définit  par

par

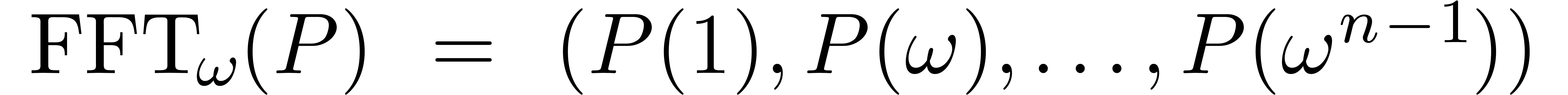

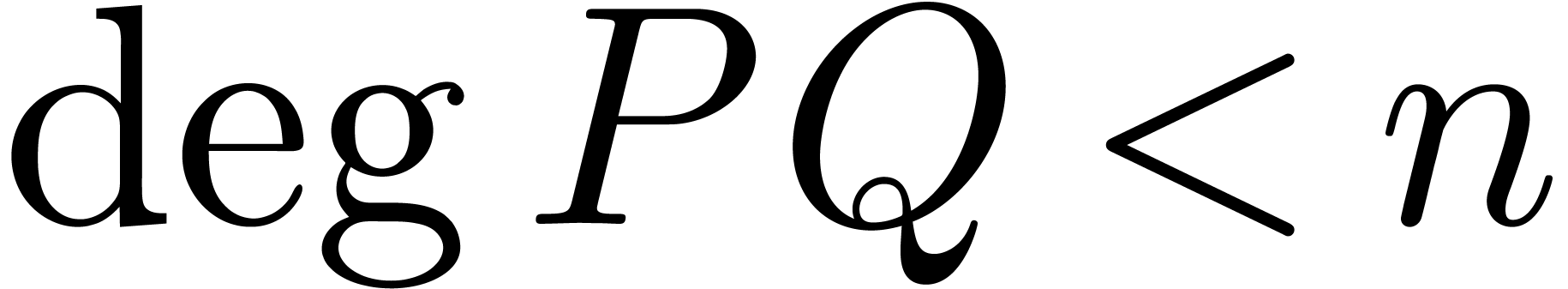

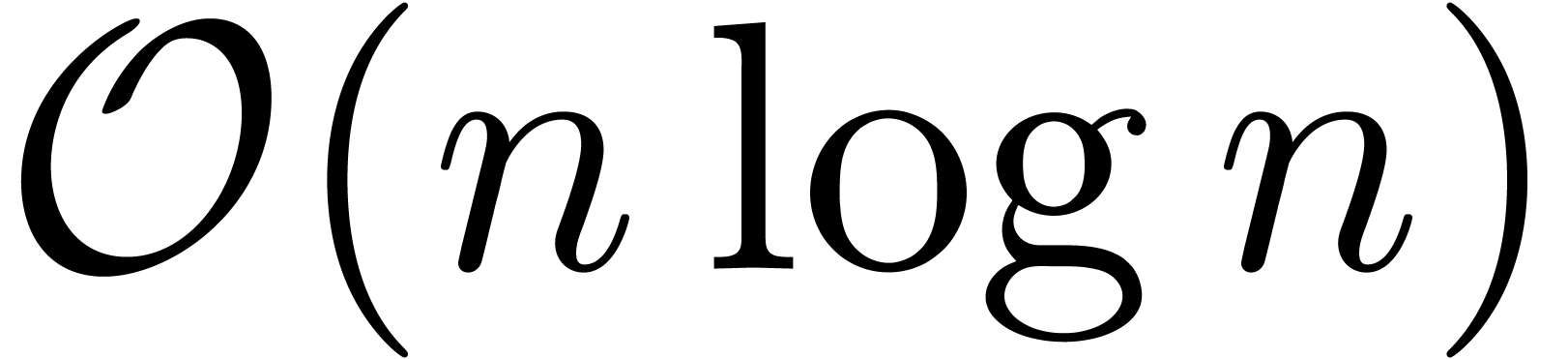

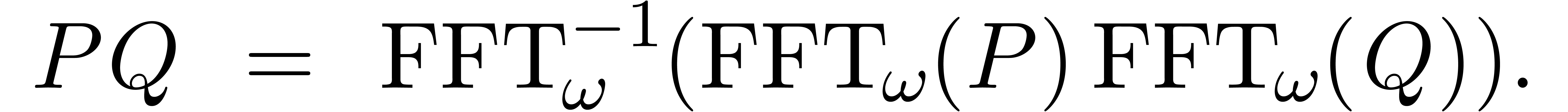

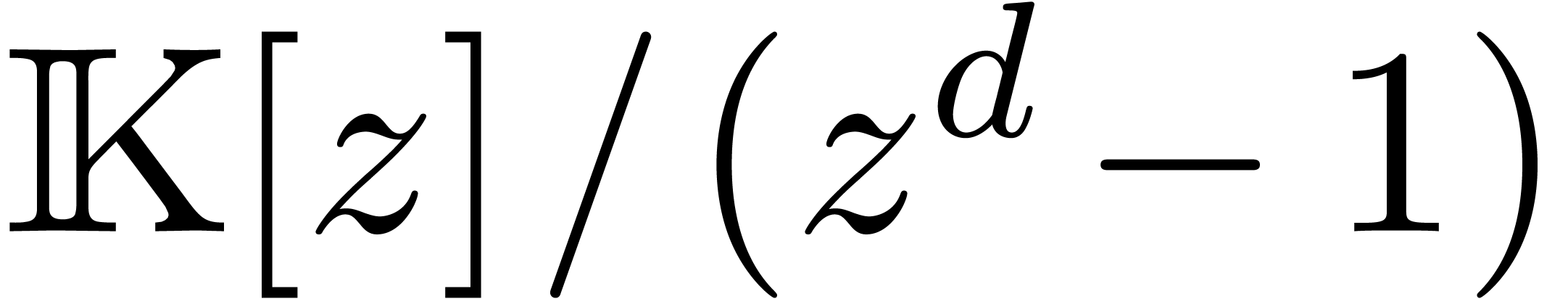

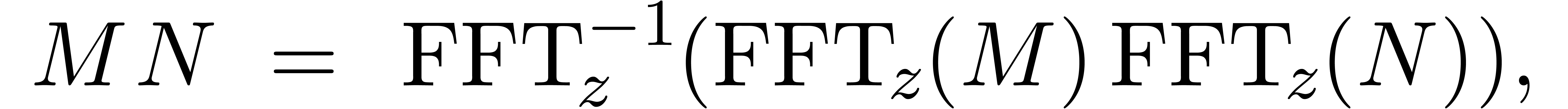

et il est classique [19] que l'on peut calculer  et son inverse

et son inverse  en temps

en temps  . Étant donné deux

polynômes

. Étant donné deux

polynômes  avec

avec  on

peut donc calculer leur produit en temps

on

peut donc calculer leur produit en temps  par la

formule

par la

formule

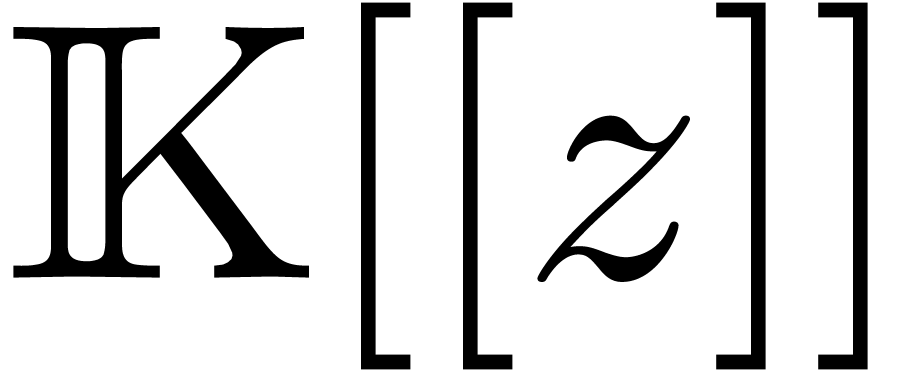

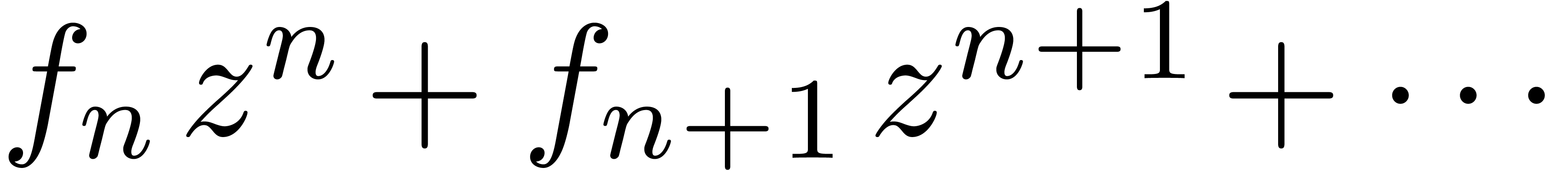

Un point de vue naturel pour calculer avec des séries dans  est de calculer systématiquement avec des

séries à l'ordre

est de calculer systématiquement avec des

séries à l'ordre  .

Pour multiplier deux telles séries, il suffit de multiplier les

séries tronquées en tant que polynômes et de

tronquer le résultat. Toutefois, si on utilise la multiplication

naïve, ceci conduit à faire environ deux fois trop de

travail. C'est un problème ouvert de savoir si on peut faire

mieux en général :

.

Pour multiplier deux telles séries, il suffit de multiplier les

séries tronquées en tant que polynômes et de

tronquer le résultat. Toutefois, si on utilise la multiplication

naïve, ceci conduit à faire environ deux fois trop de

travail. C'est un problème ouvert de savoir si on peut faire

mieux en général :

Question. Est-ce qu'il existe un algorithme de

multiplication tronquée avec de complexité en temps  avec

avec  ?

?

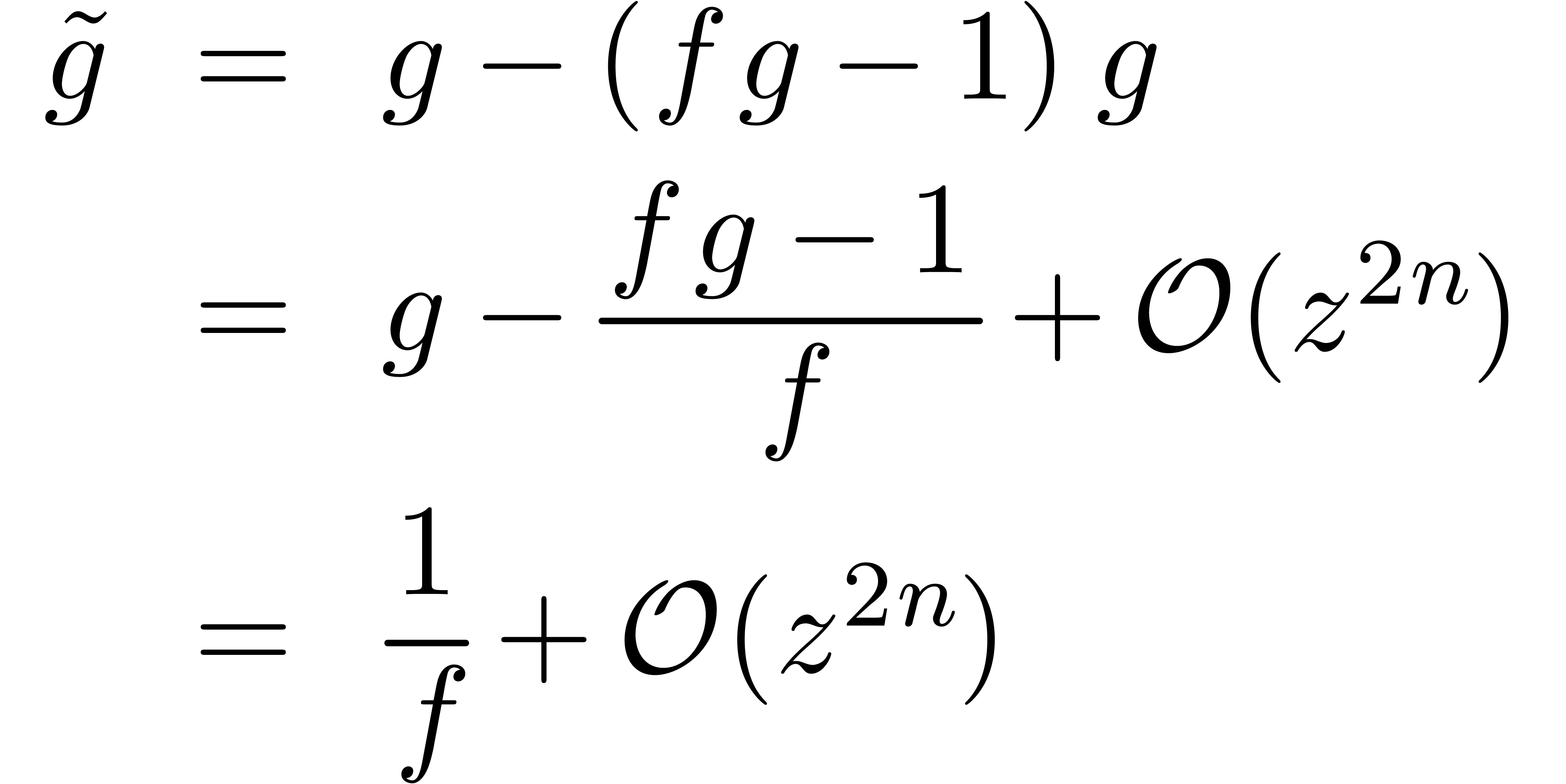

On a déjà signalé le fait que la complexité de la plupart des opérations plus complexes, comme la division, la racine carrée, l'exponentielle, etc. s'expriment en fonction de la complexité de la multiplication. Une technique puissante pour démontrer ceci est la méthode de Newton.

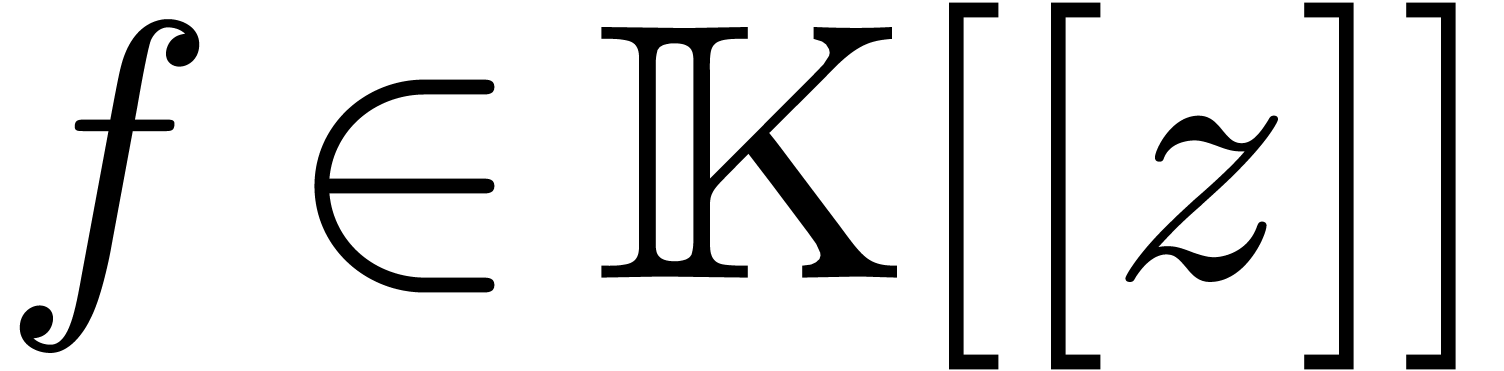

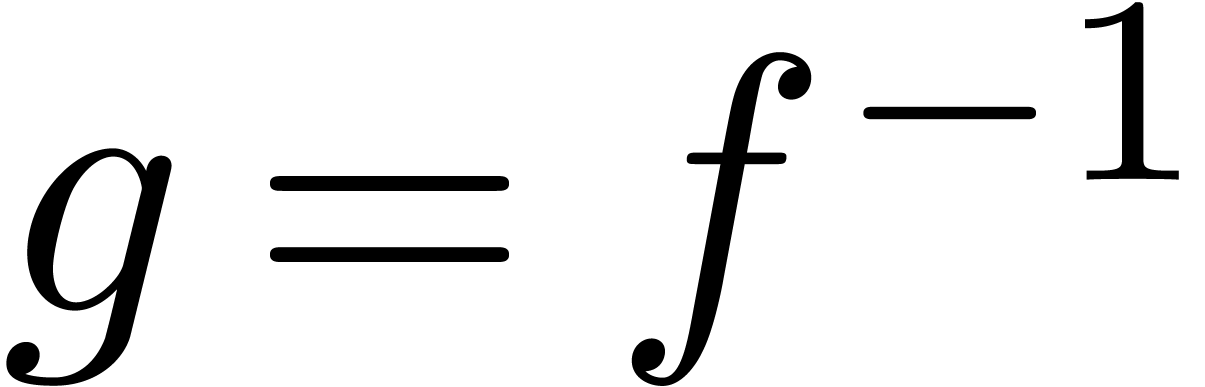

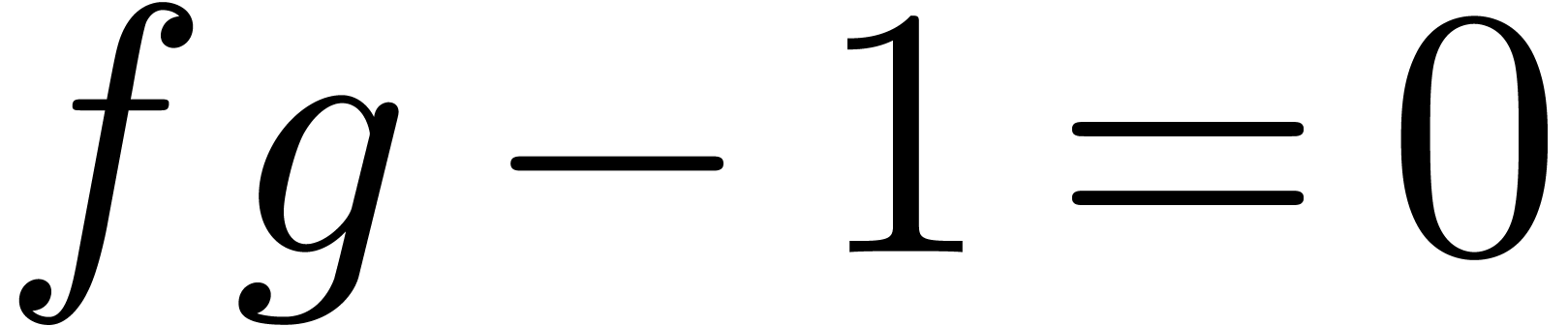

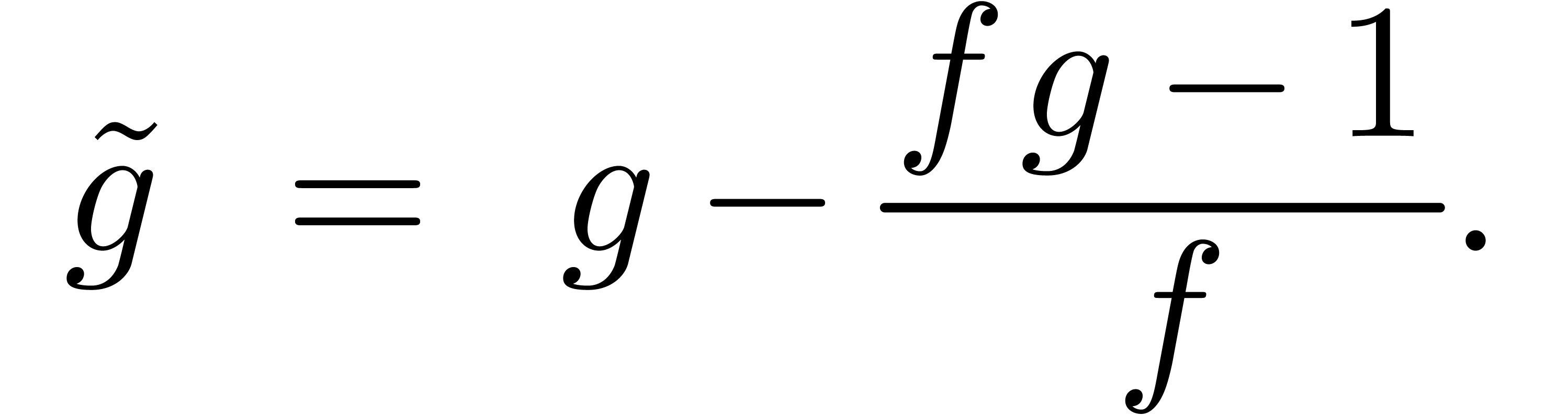

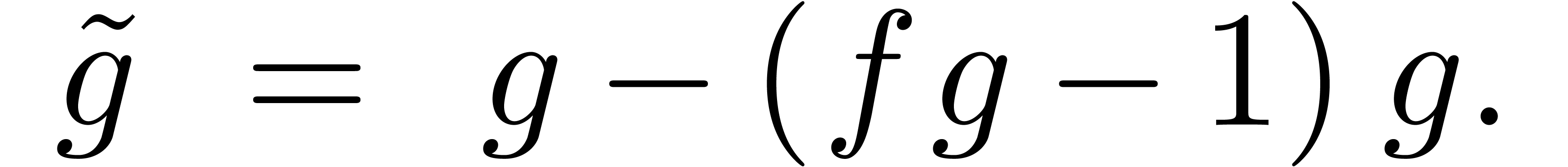

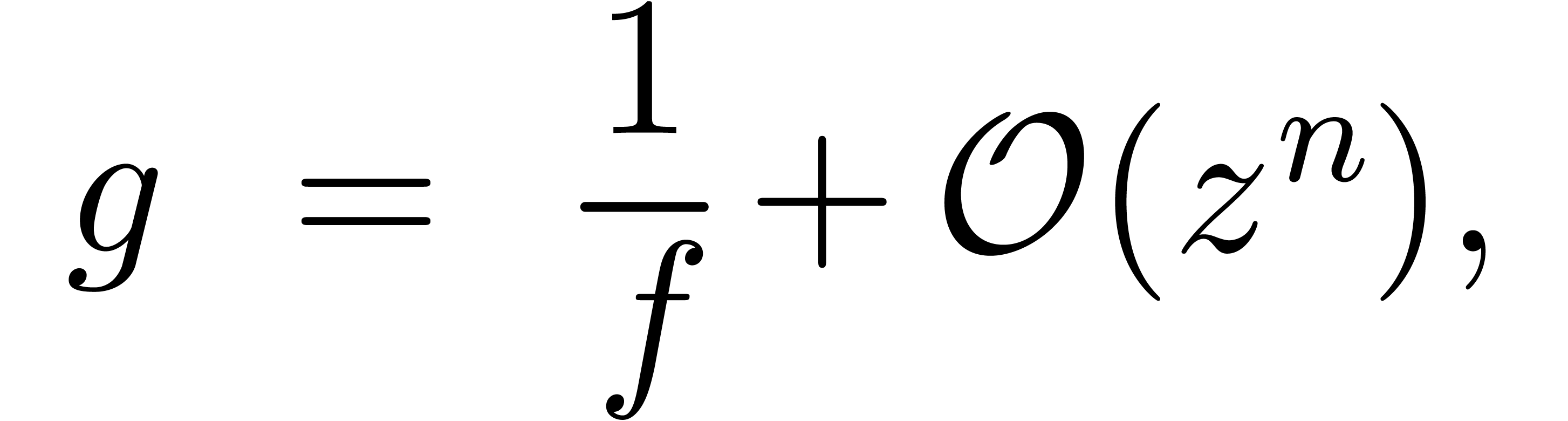

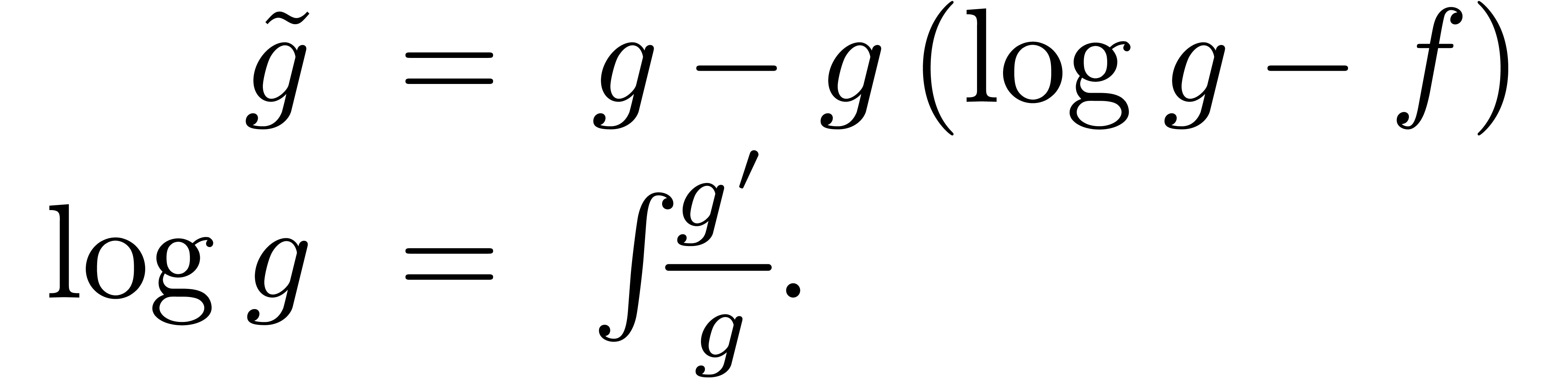

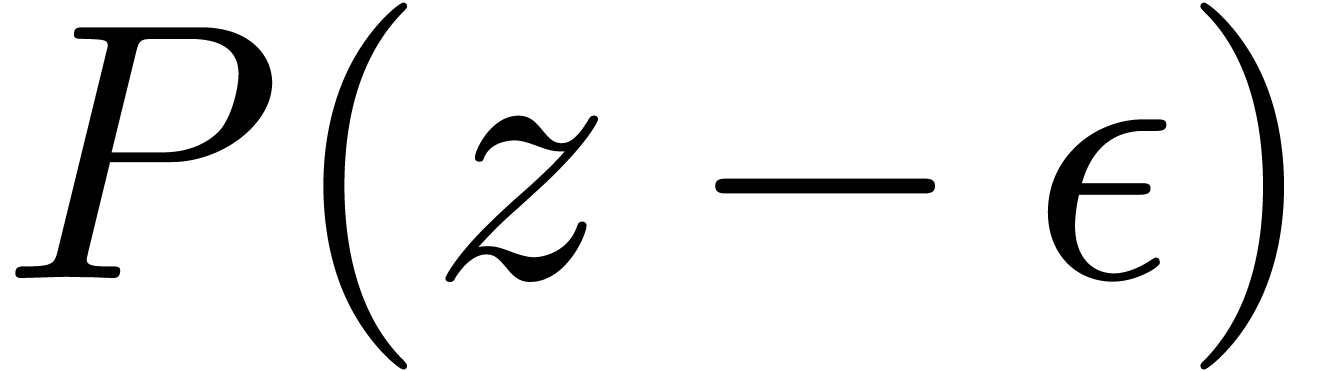

Supposons par exemple que l'on veuille inverser une série  avec

avec  à l'ordre

à l'ordre  . En d'autres mots, étant

donnés les coefficients

. En d'autres mots, étant

donnés les coefficients  ,

on voudrait calculer les coefficients

,

on voudrait calculer les coefficients  de

de  . La méthode de Newton

appliquée à l'équation

. La méthode de Newton

appliquée à l'équation  donne l'itération

donne l'itération

Comme on ne connait pas encore  dans cette

itération, on utilisera plutôt l'itération

dans cette

itération, on utilisera plutôt l'itération

Si  est bon jusqu'à l'ordre

est bon jusqu'à l'ordre  :

:

la nouvelle valeur  sera bonne jusqu'à

l'ordre

sera bonne jusqu'à

l'ordre  , puisque

, puisque

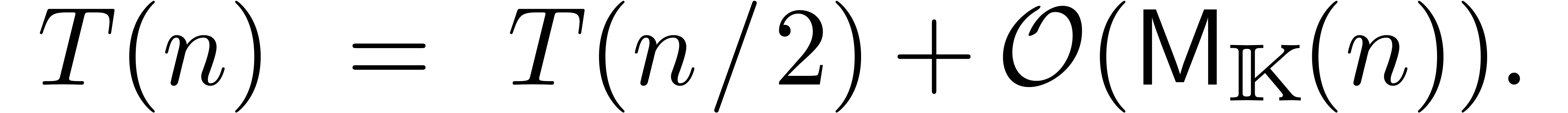

Si  désigne le coût de la division

à l'ordre

désigne le coût de la division

à l'ordre  , ceci donne

, ceci donne

En supposant que  est croissante, on laisse au

soin du lecteur de vérifier que ceci implique

est croissante, on laisse au

soin du lecteur de vérifier que ceci implique  . On déduit aussi aisément que le

calcul du quotient et du reste de la division euclidienne d'un

polynôme

. On déduit aussi aisément que le

calcul du quotient et du reste de la division euclidienne d'un

polynôme  de degré

de degré  par un polynôme

par un polynôme  de degré

de degré  se calcule en temps

se calcule en temps  .

.

L'utilisation de la méthode de Newton dans ce cadre remonte

à Hensel et se généralise pour des équations

polynomiales plus générale (à la fois dans les

séries et les nombres  -adiques

d'ailleurs). Brent et Kung ont remarqué [13, 15] que la même technique peut être

utilisée pour composer des séries formelles, calculer

leurs inverses fonctionnelles, ou résoudre des équations

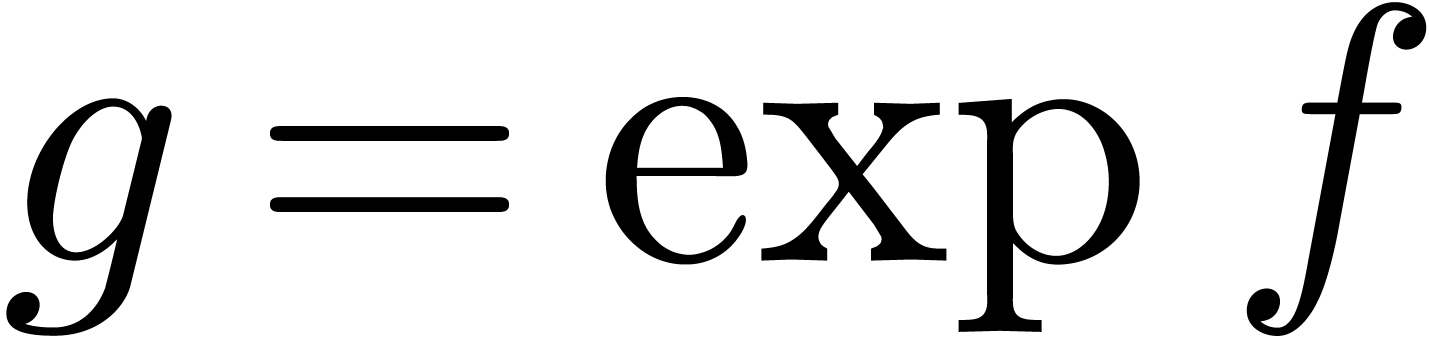

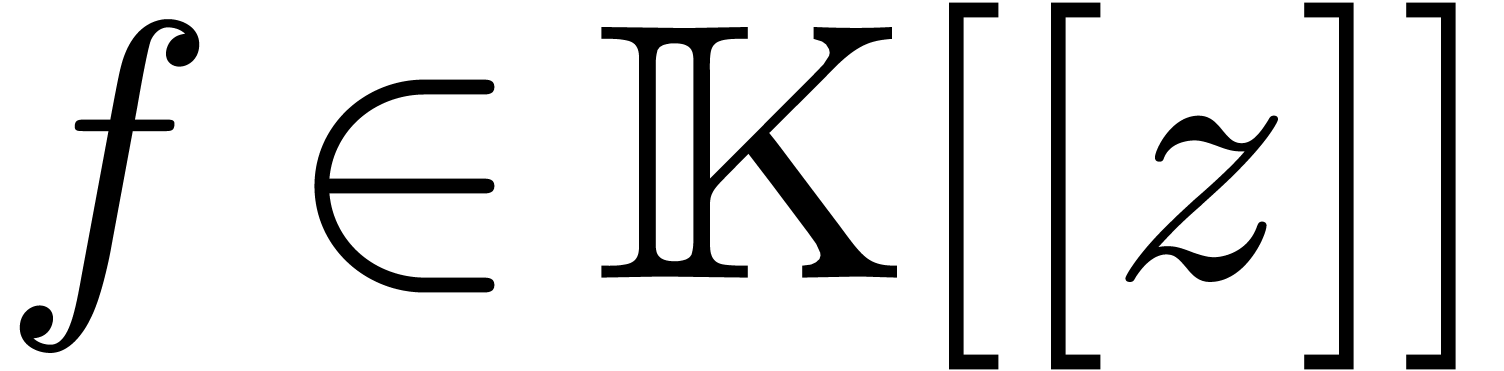

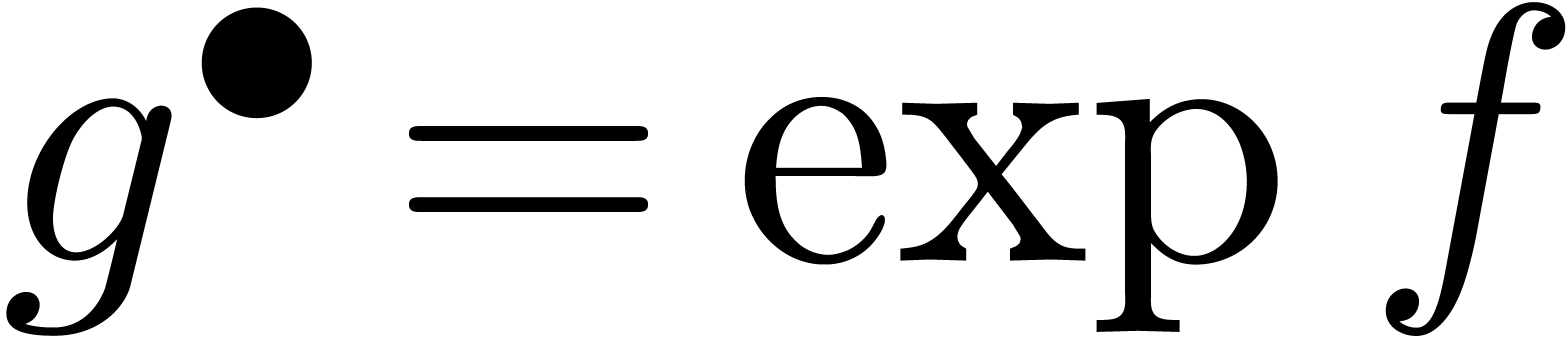

différentielles. Par exemple, l'exponentielle

-adiques

d'ailleurs). Brent et Kung ont remarqué [13, 15] que la même technique peut être

utilisée pour composer des séries formelles, calculer

leurs inverses fonctionnelles, ou résoudre des équations

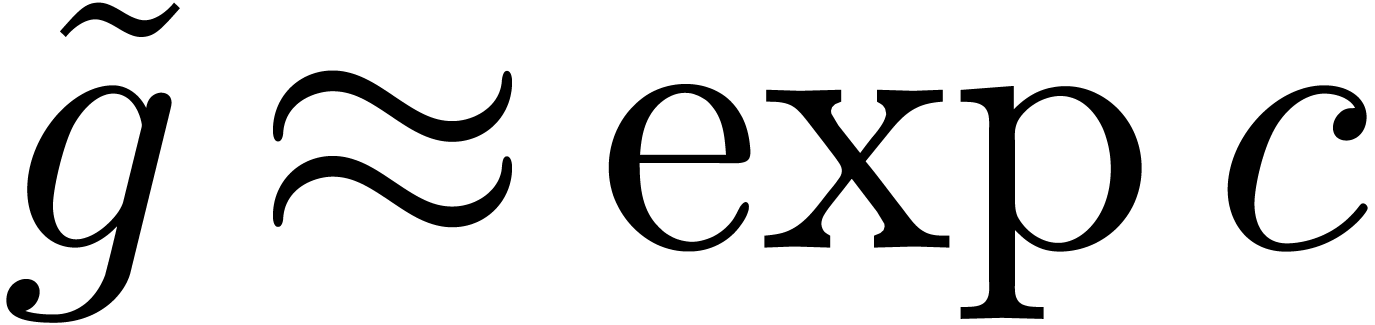

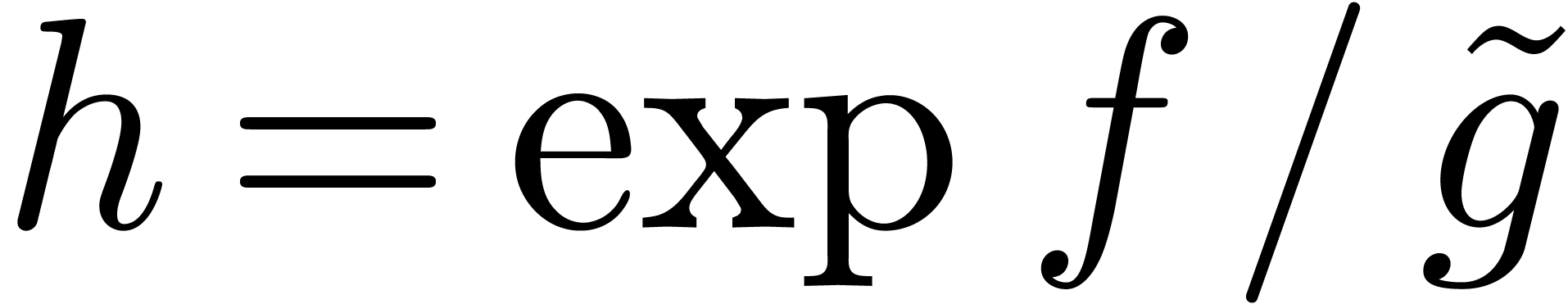

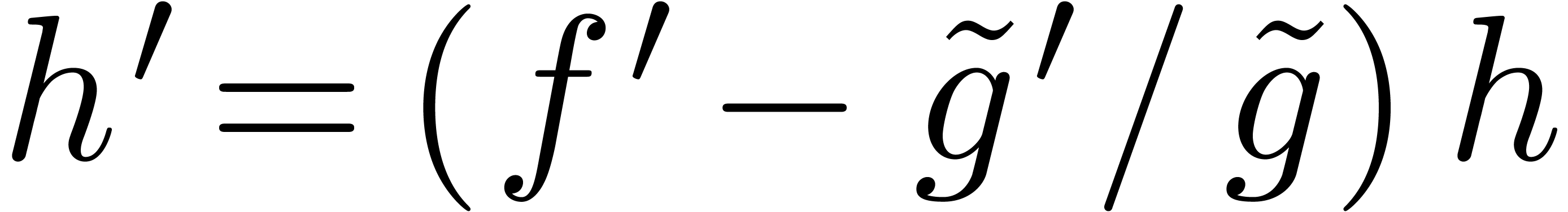

différentielles. Par exemple, l'exponentielle  de

de  avec

avec  se calcule par

l'itération

se calcule par

l'itération

Une méthode efficace pour la résolution d'équations différentielles algébriques plus générales a été proposée par Sedoglavic [68, 10, 86].

Il y a de nombreux autres opérations sur les polynômes (racine carrée, pgcd, ppcm, etc.) qui peuvent se calculer en temps presque linéaire. Nous donnons un dernier exemple qui est utile pour le calcul des zéros d'un polynôme. En effet, si on dispose déjà de bonnes approximations pour les racines, l'évaluation multi-point rapide permet d'appliquer la méthode de Newton pour améliorer toutes ces approximations de façon simultanée.

Algorithme évaluation multi-point rapide

avec

avec

et points

et points

On précalcule tous les polynômes dans l'arbre suivant :

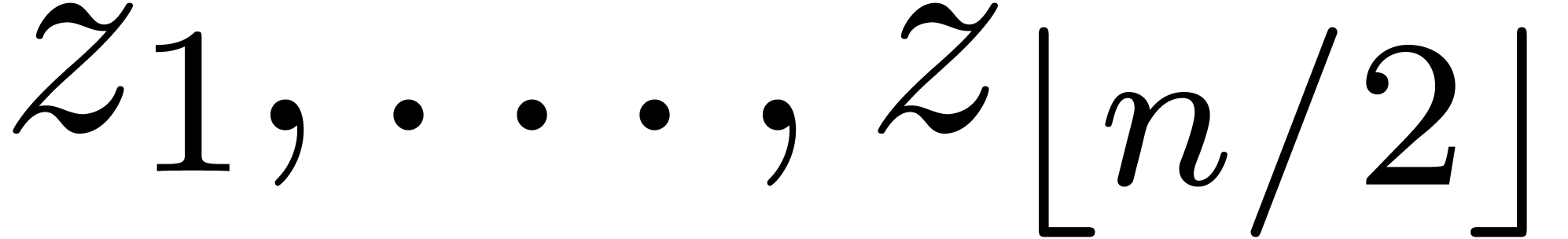

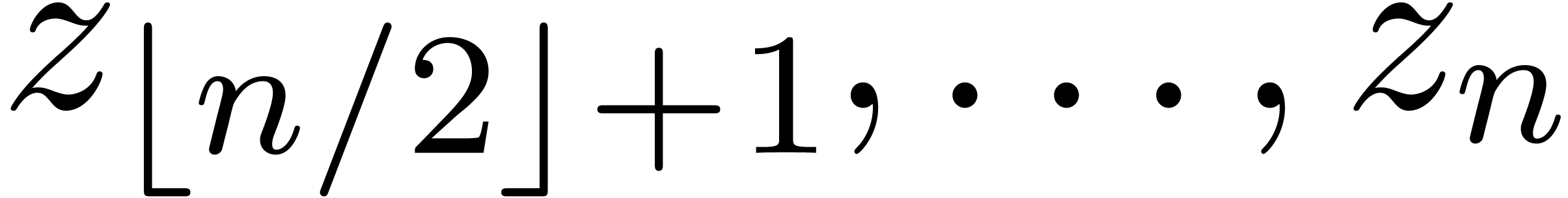

On utilise la méthode dichotomique suivante pour calculer le résultat :

Si  , retourner

, retourner

Sinon, soient  et

et

Evaluer  en

en  et

et  en

en

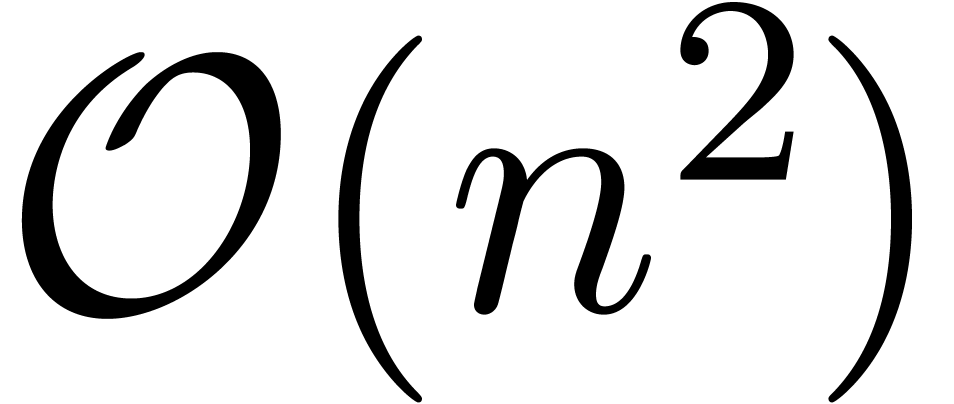

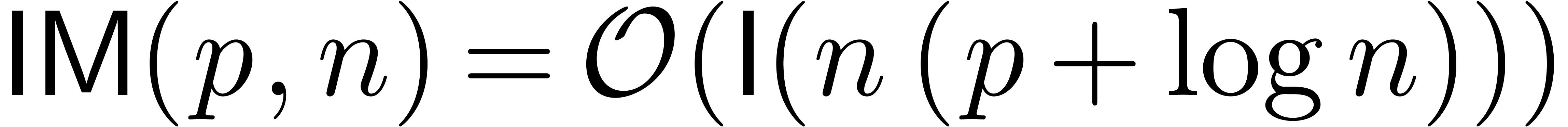

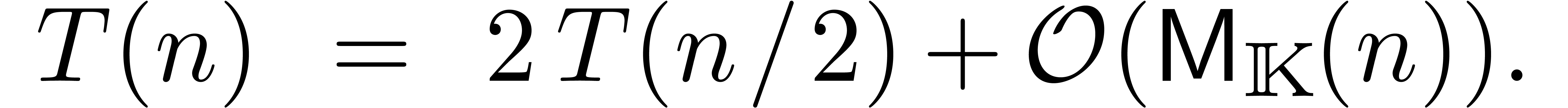

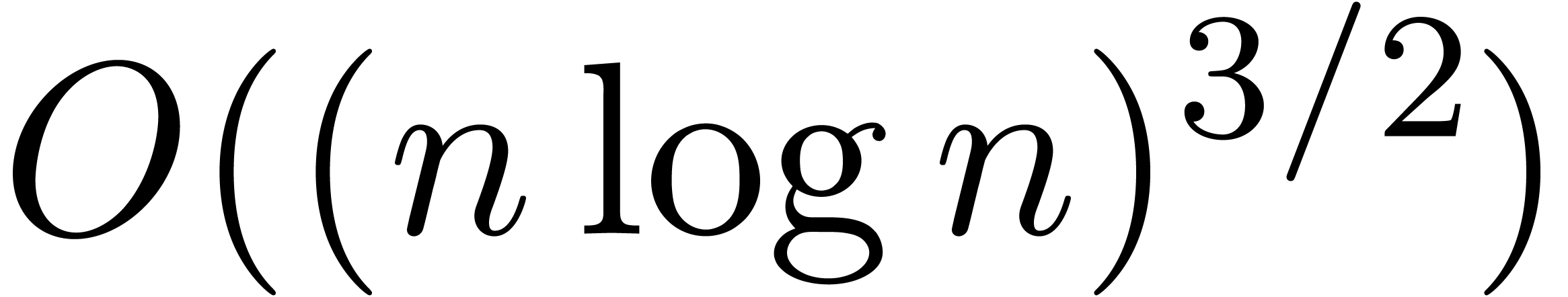

On remarque que la complexité du précalcul et de la dichotomie proprement dite vérifient une estimation du type

En supposant que  est croissante, on laisse au

soin du lecteur de vérifier que ceci implique

est croissante, on laisse au

soin du lecteur de vérifier que ceci implique  . On peut encore gagner un facteur constant sur

l'algorithme présenté ici [11].

. On peut encore gagner un facteur constant sur

l'algorithme présenté ici [11].

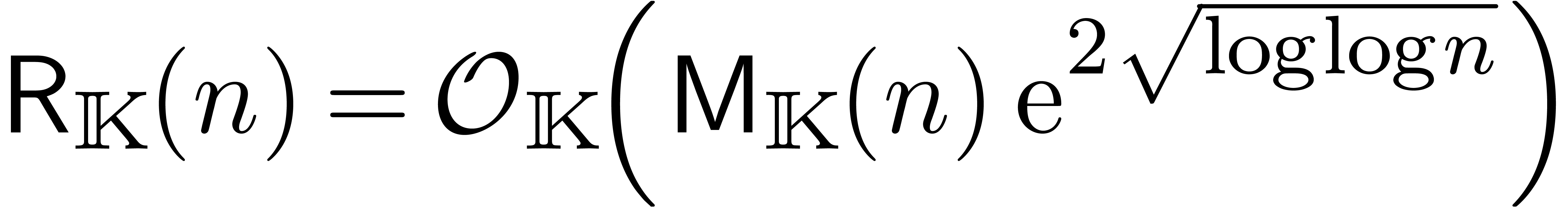

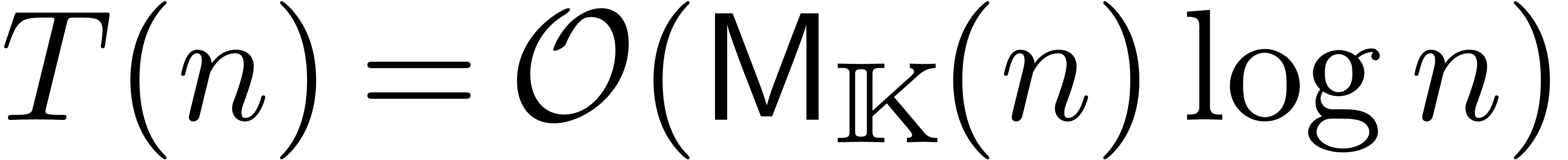

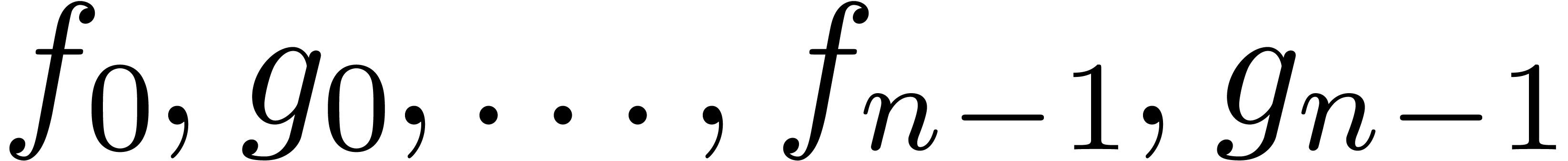

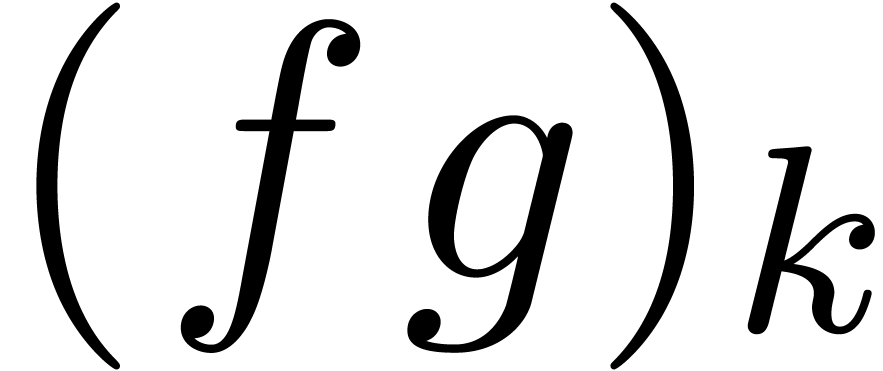

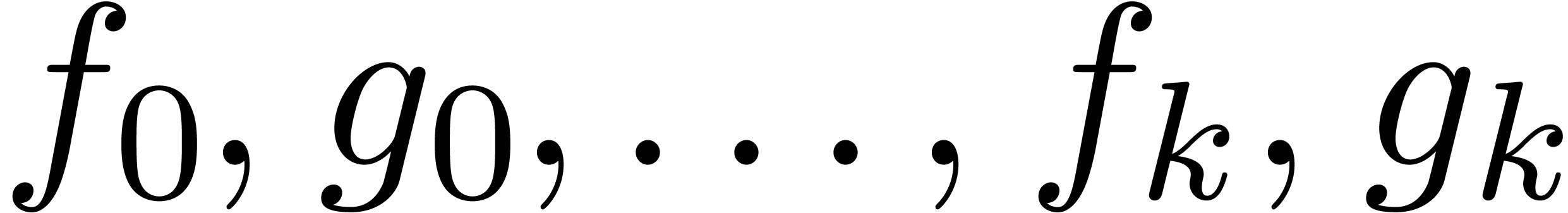

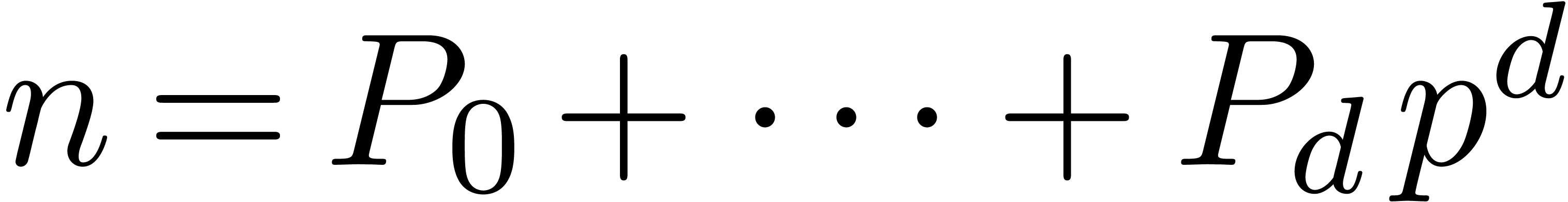

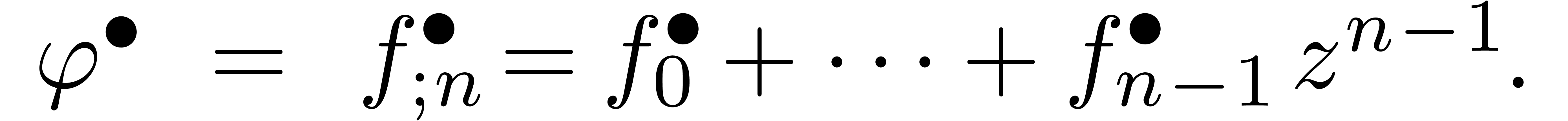

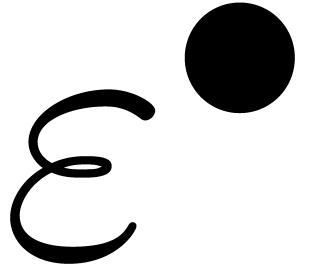

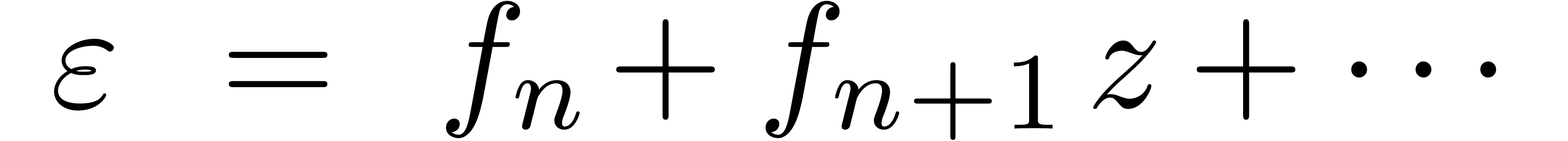

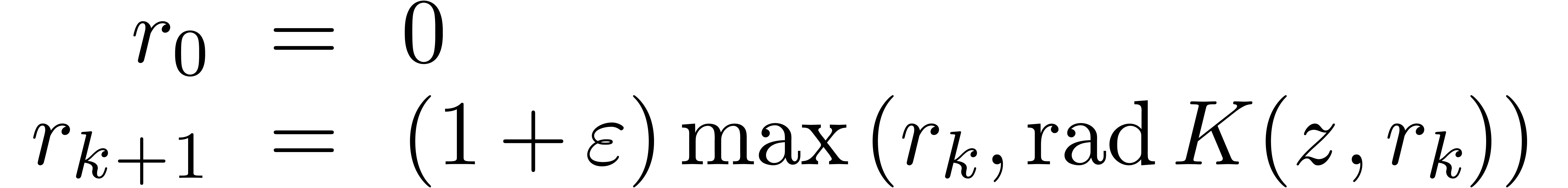

Nous avons vu comment calculer avec des séries en les tronquant

à un certain ordre  .

Une autre approche consiste à considérer les séries

comme des « flots de coefficients » qui sont calculés

un par un. Ce point de vue détendu impose une contrainte sur

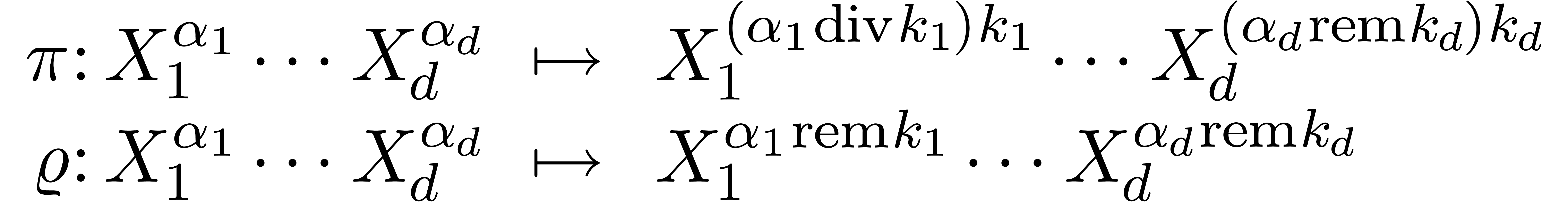

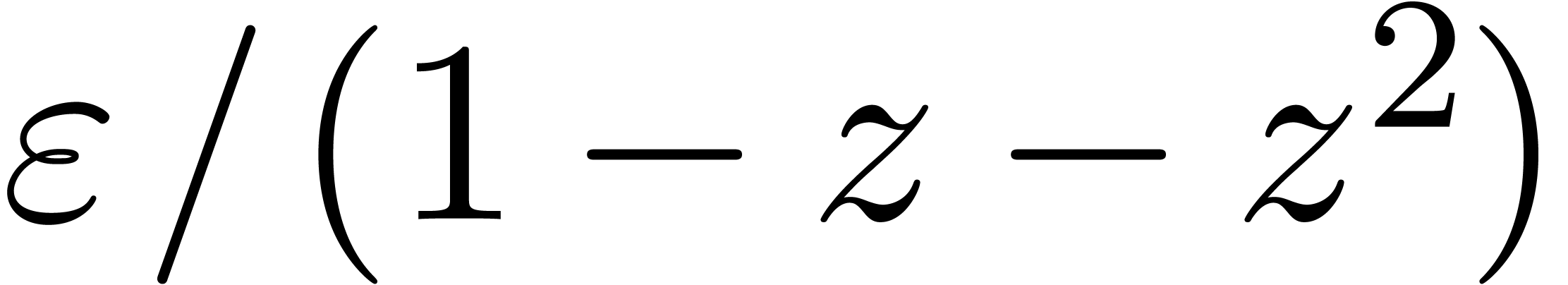

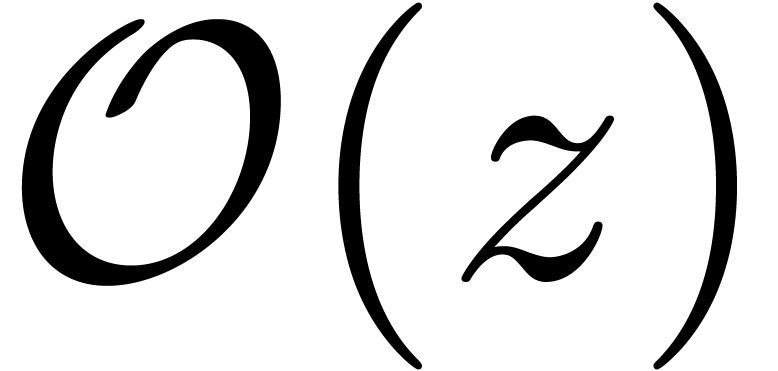

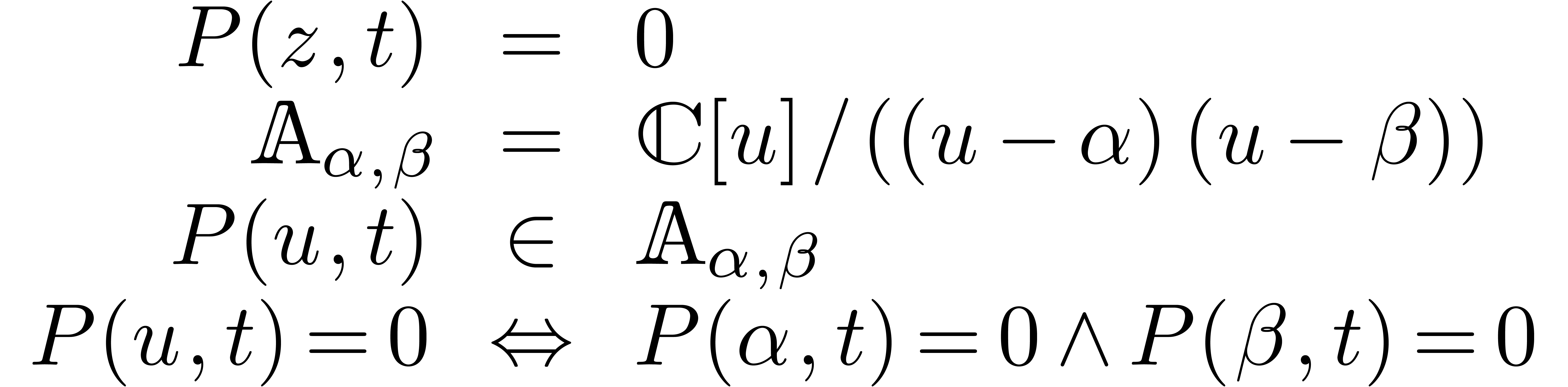

notre façon de concevoir les opérations sur les