donne lieu à un corps de Hardy. Cette

partie a fait l'objet de deux articles [6, 116]

et des travaux sont en cours en collaboration avec

donne lieu à un corps de Hardy. Cette

partie a fait l'objet de deux articles [6, 116]

et des travaux sont en cours en collaboration avec

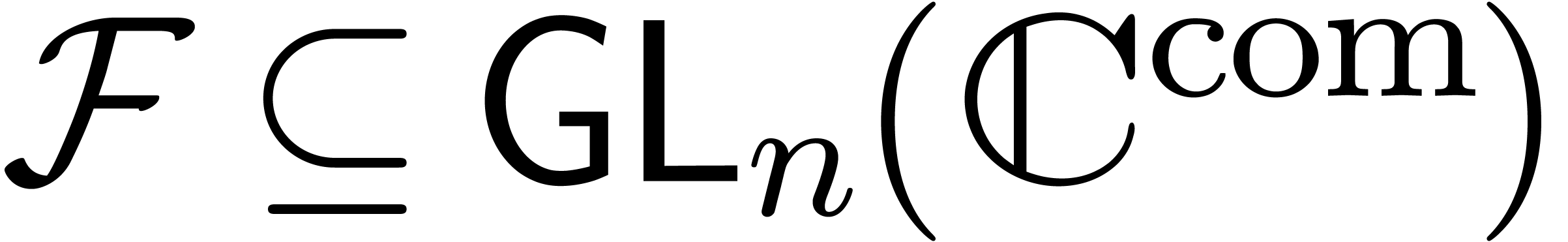

|

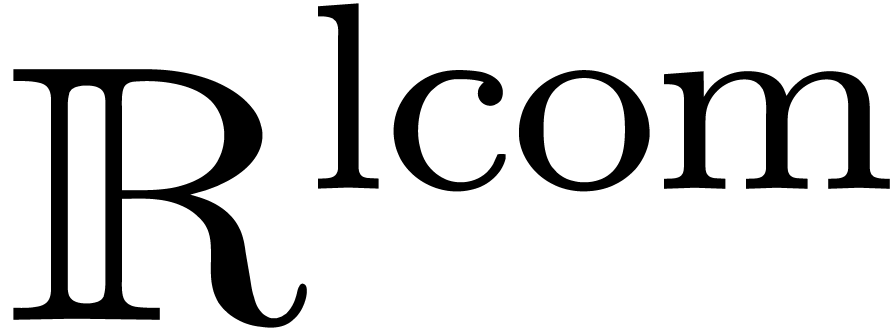

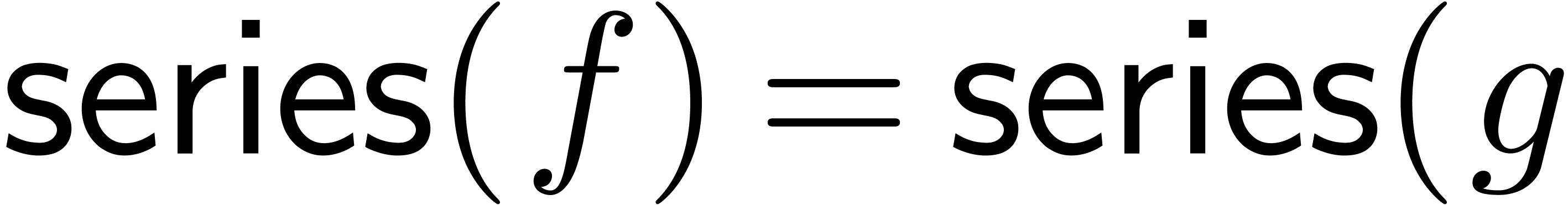

1.1.Séries réticulées 3

1.2.Méthode des polygones de Newton 4

1.3.Théorème des fonctions implicites 5

1.4.Transséries réticulées 6

1.5.Équations différentielles linéaires 7

1.6.Équations différentielles algébriques 8

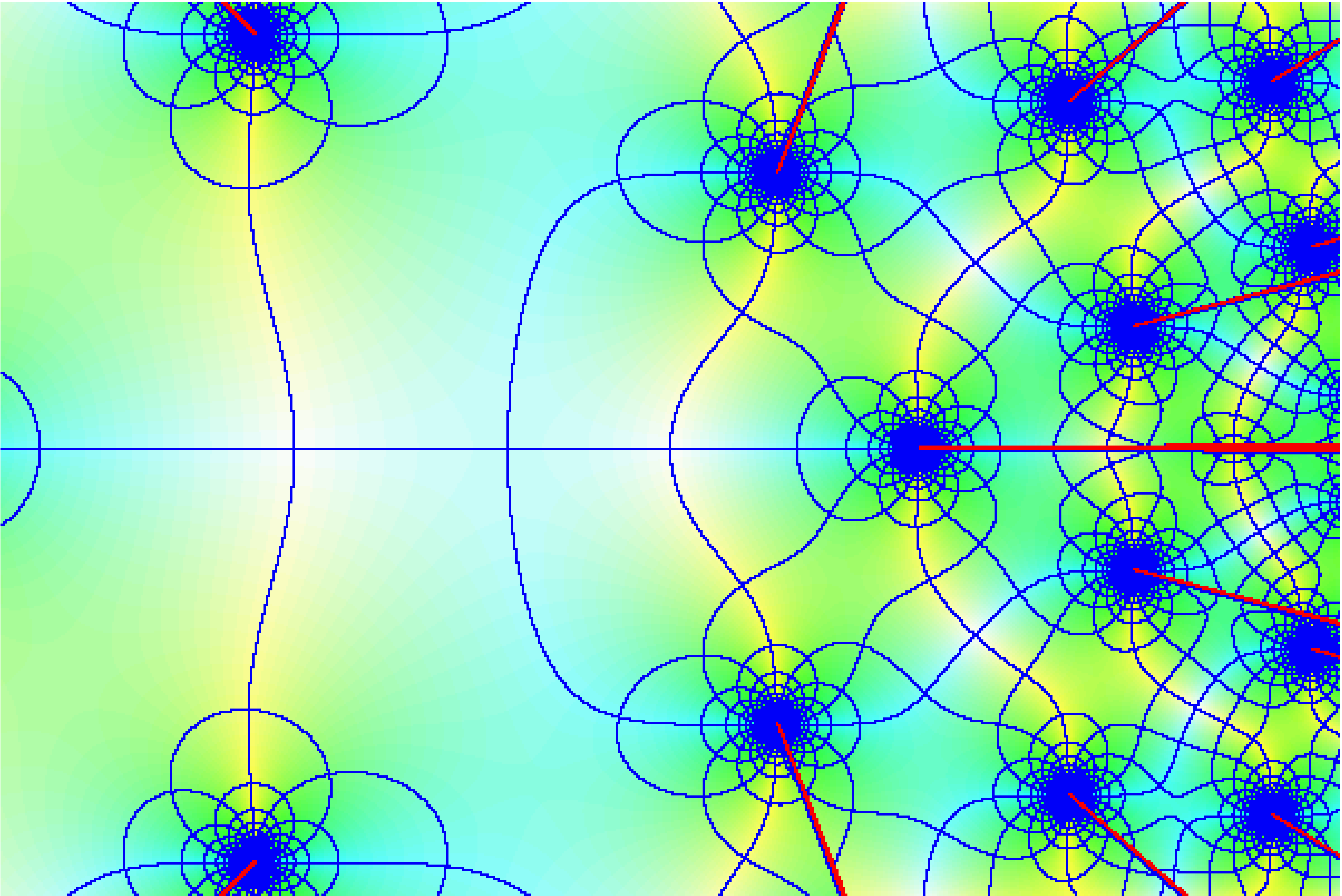

1.7.Transséries complexes 10

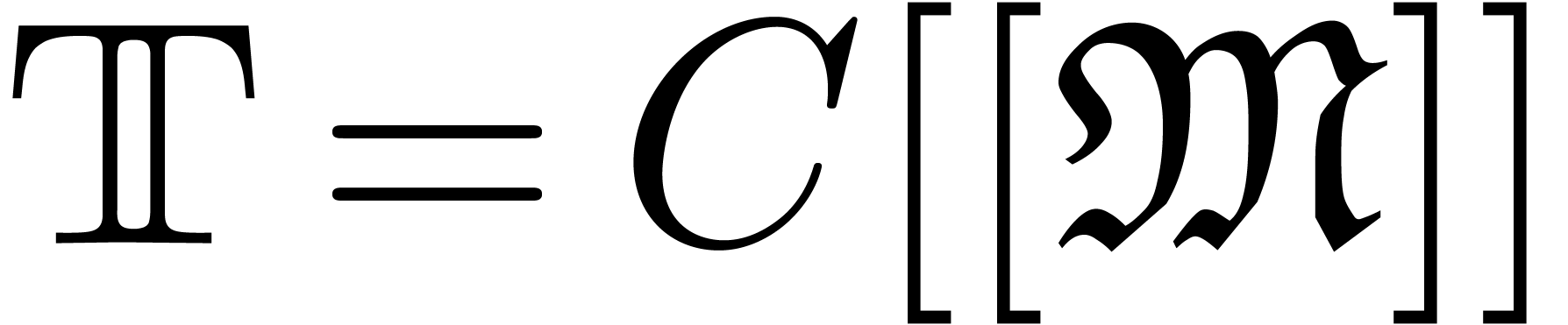

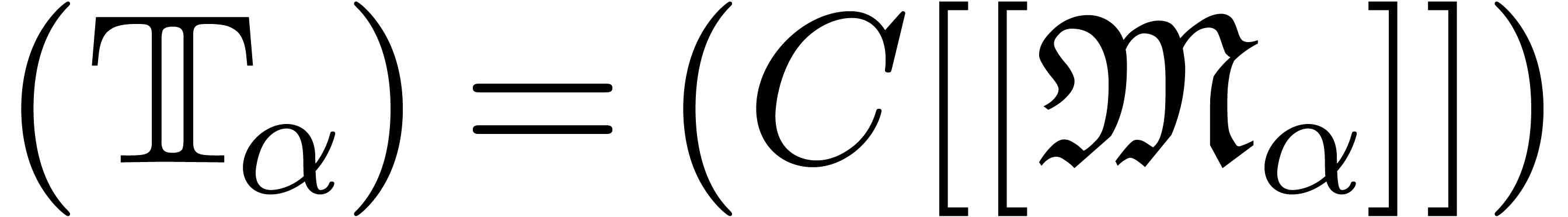

2.1.Corps de transséries 11

2.2.Opérations sur les transséries 12

2.3.Transséries imbriquées 13

2.4.Transséries de forces supérieures 14

2.5.Perspectives 16

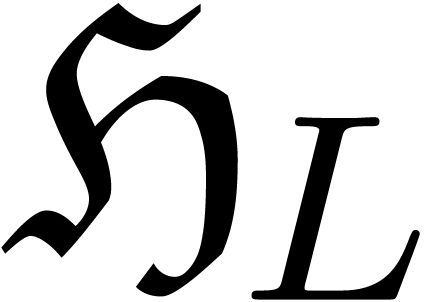

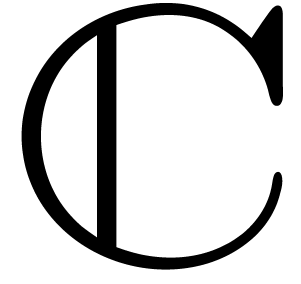

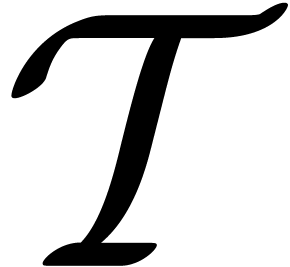

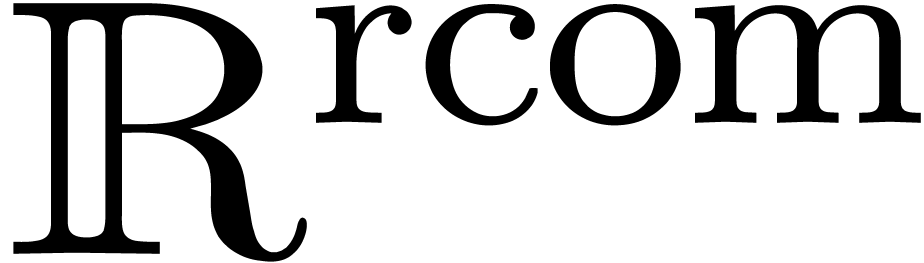

3.1.Corps de Hardy transsériels 17

3.2.Extensions différentiellement algébriques 18

3.3.Équations fonctionnelles 19

3.4.Corps H et corps asymptotiques 21

4.1.Nombres calculables 23

4.2.La hiérarchie numérique 24

4.3.Fonctions analytiques calculables 25

4.4.Tests effectifs de nullité 27

4.4.1.Conjectures de témoin 28

4.4.2.Algorithmes 28

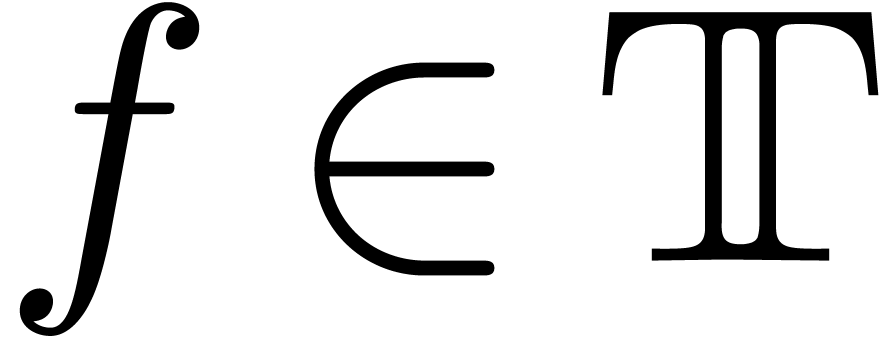

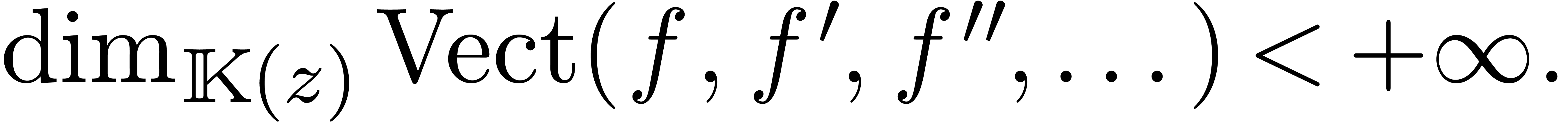

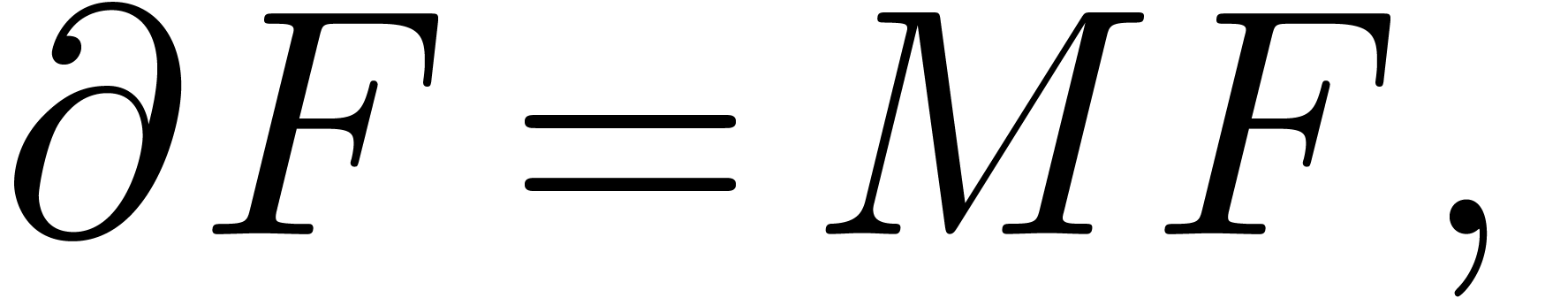

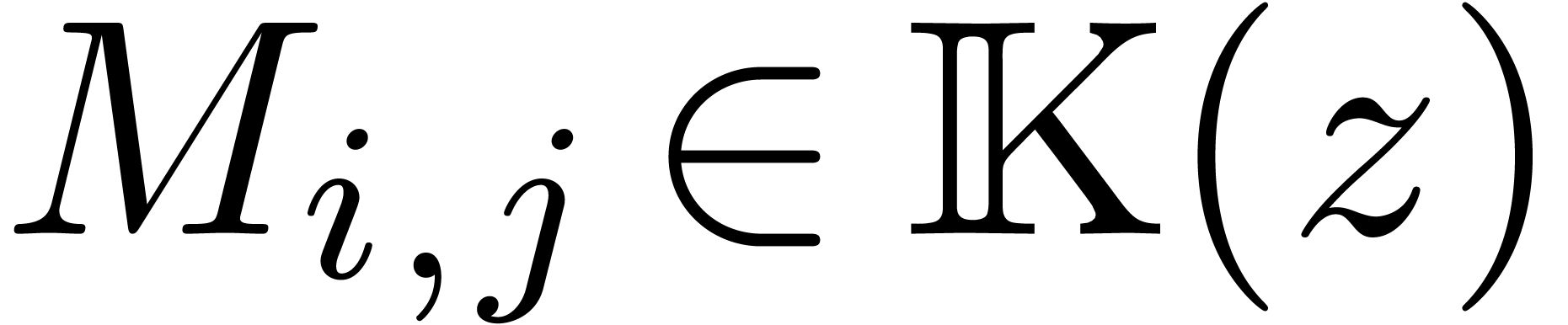

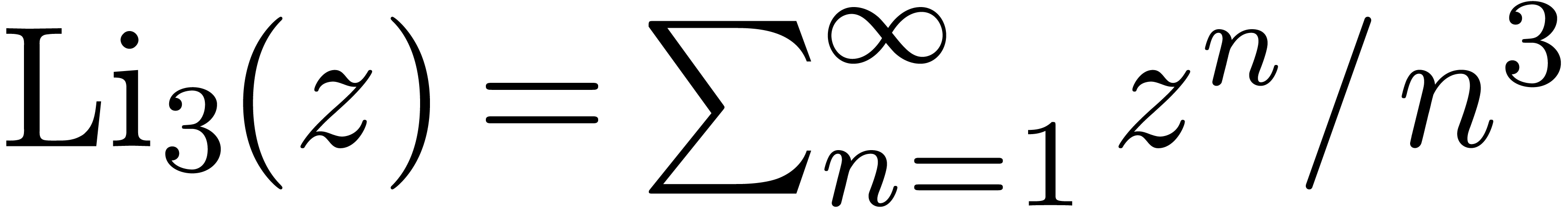

5.1.Fonctions holonomes 30

5.2.Évaluation en des points algébriques 31

5.3.Continuation analytique 32

5.4.Singularités régulières 34

5.5.Accéléro-sommation 35

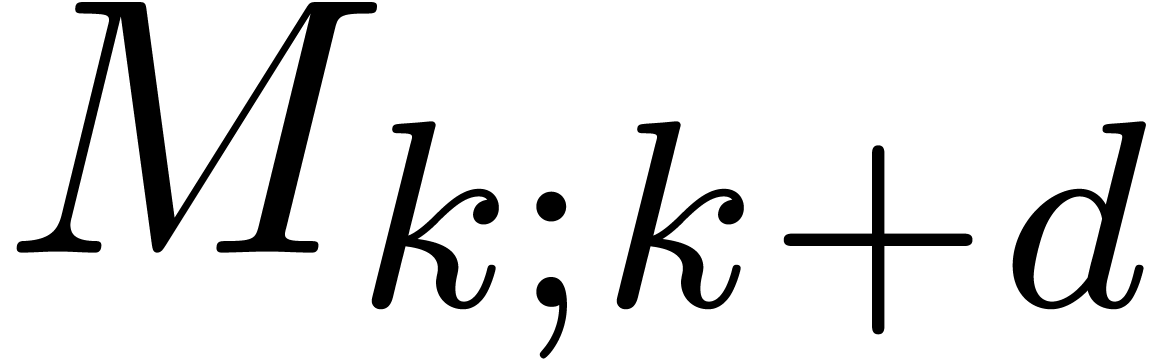

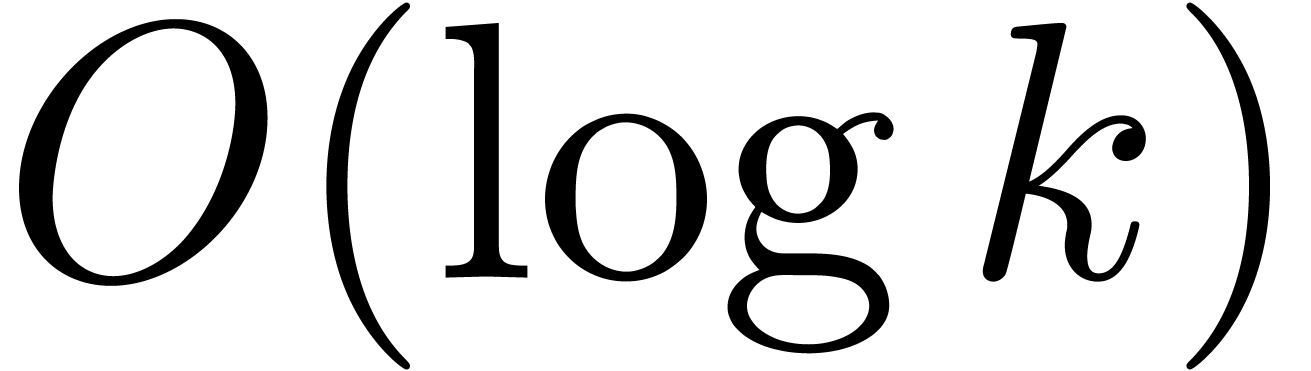

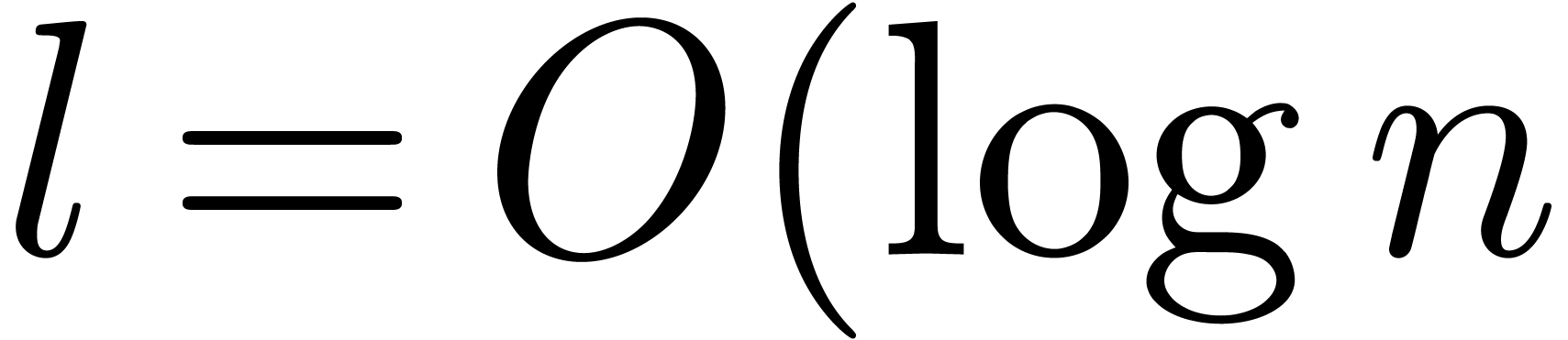

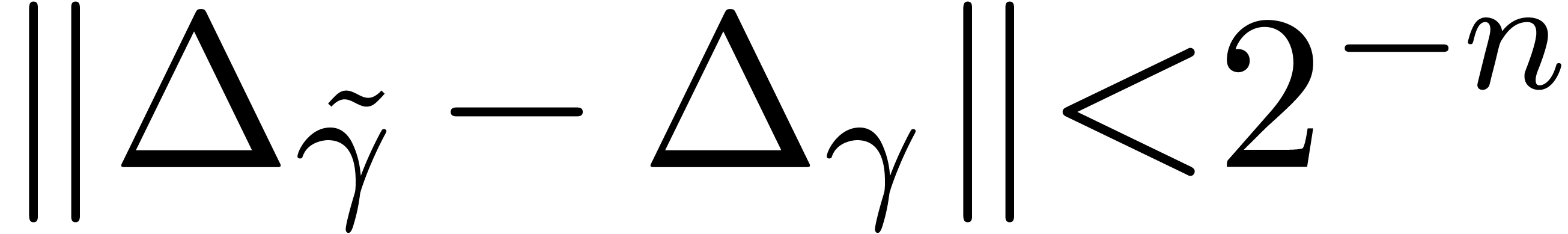

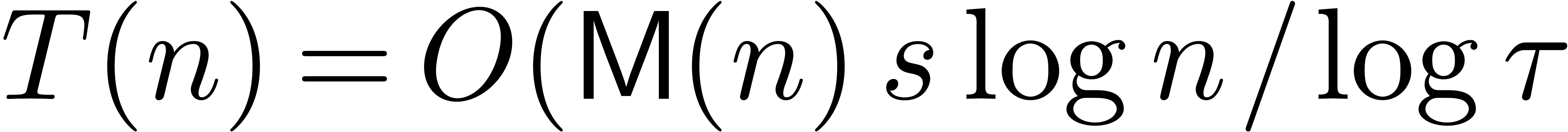

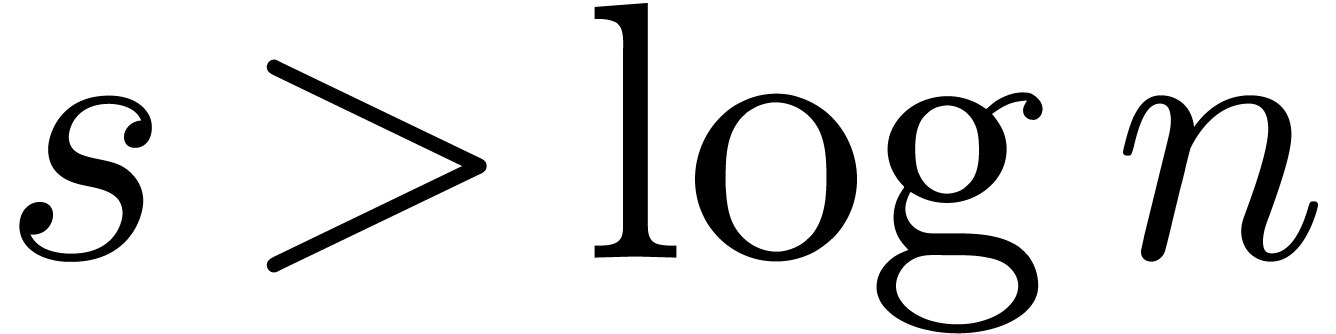

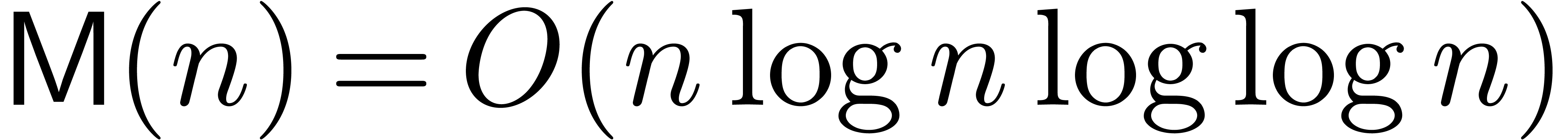

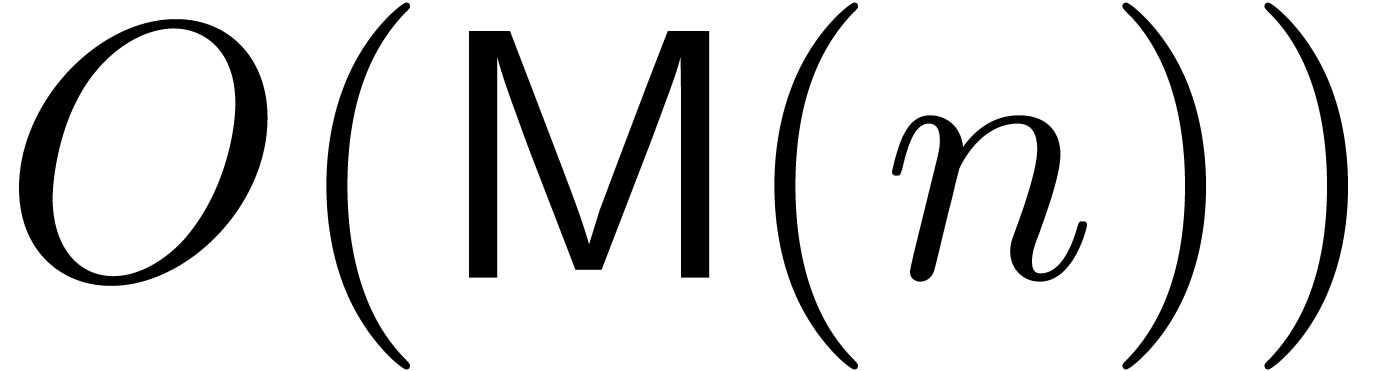

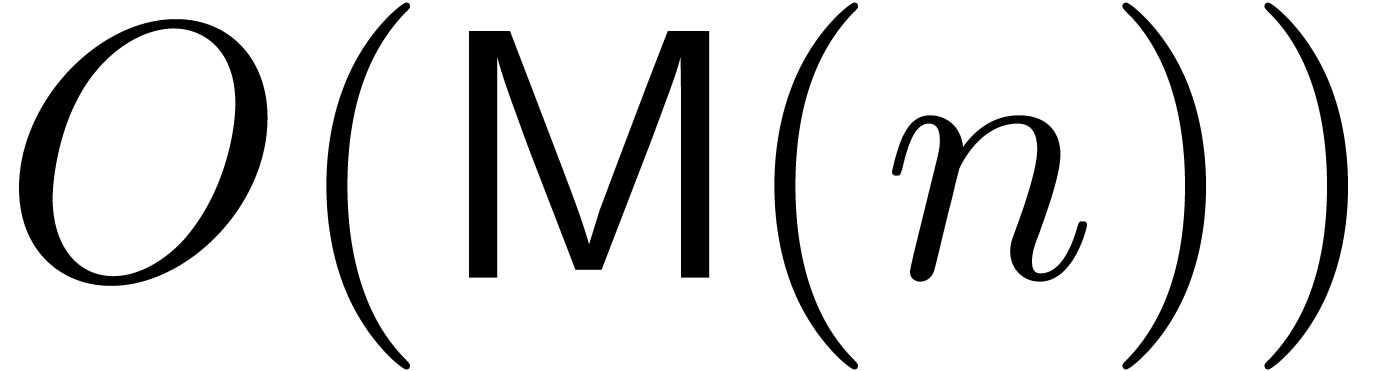

5.6.Algorithmes efficaces pour les séries 37

6.1.Rappels 39

6.2.Factorisation d'opérateurs différentiels 40

6.3.Calcul du groupe de Galois différentiel 41

6.4.Perspectives 42

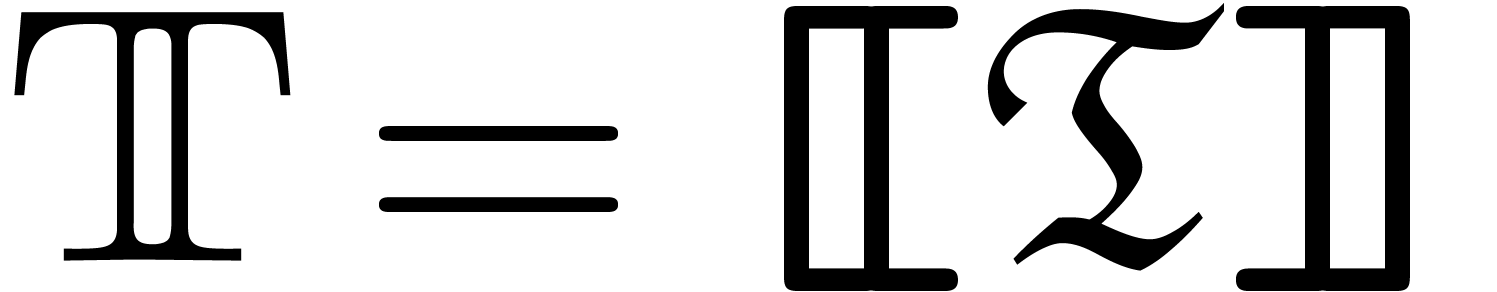

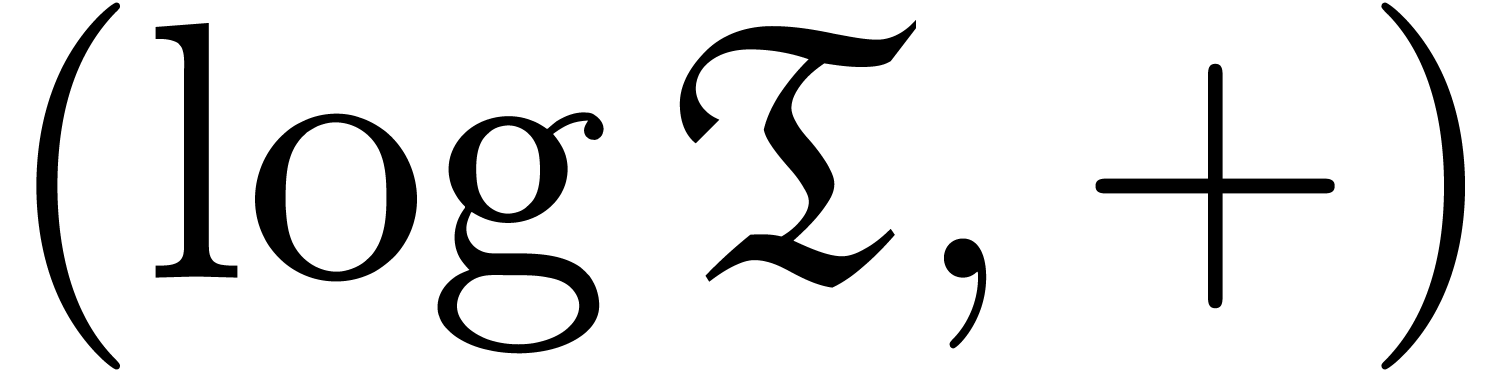

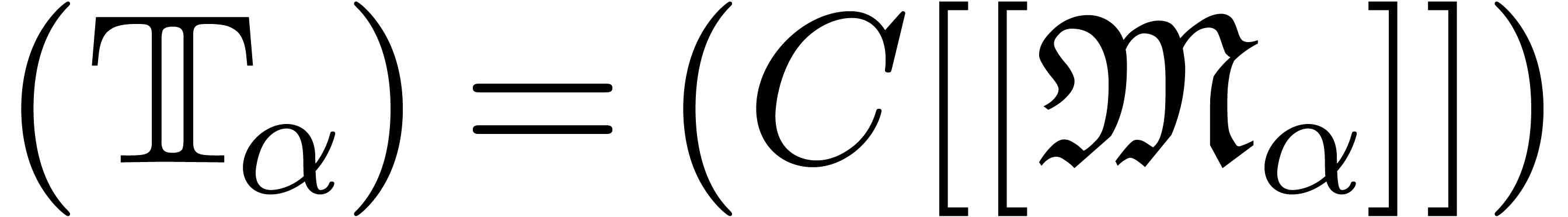

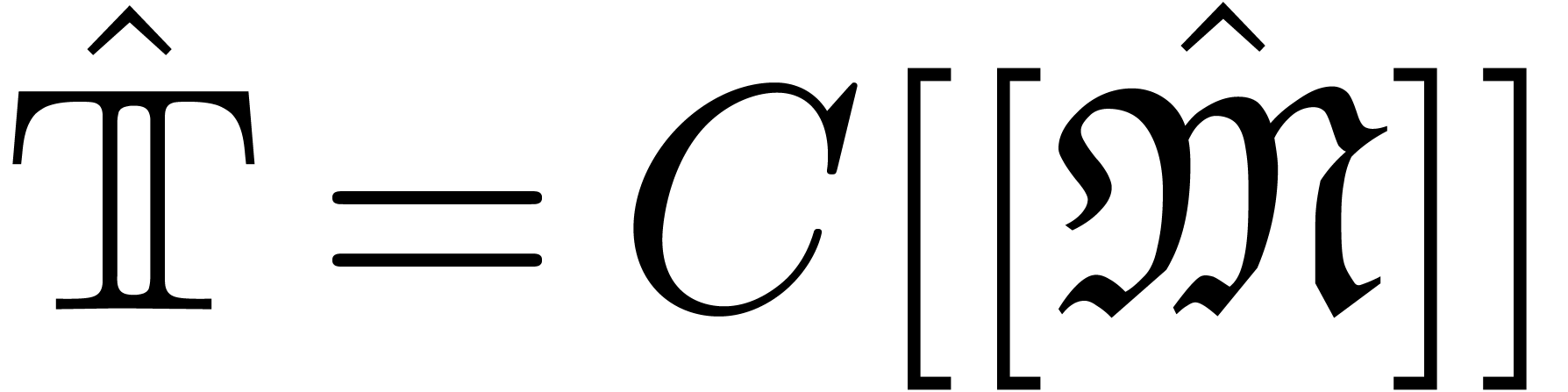

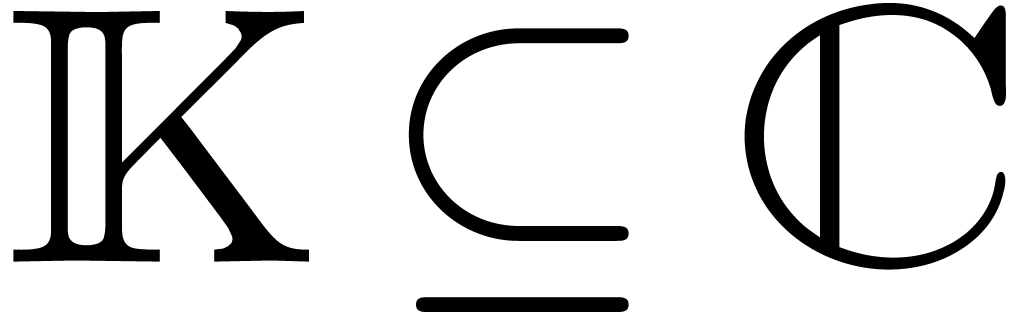

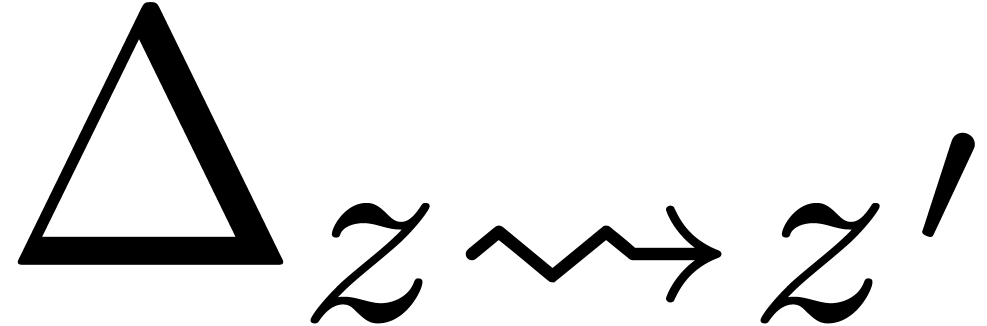

Ce rapport se divise en deux parties principales. Les chapitres 1, 2 et 3 concernent des travaux sur les transséries en prolongement de ma thèse. Les chapitres 4, 5 et 6 forment le départ de mon projet pour automatiser ce qui peut l'être dans l'analyse complexe, et sont au centre de mes intérêts actuels.

Le premier chapitre reprend avec plus de détails et quelques améliorations les résultats de la première partie de ma thèse. Le théorème différentiel des valeurs intermédiaires et la partie concernant les transséries complexes sont plus nouveaux. Ces travaux ont fait l'objet d'un livre [117], de deux articles [103, 105] et quelques prépublications [99, 100].

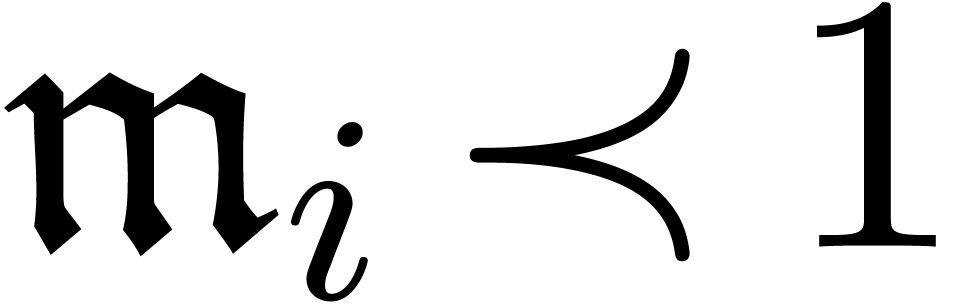

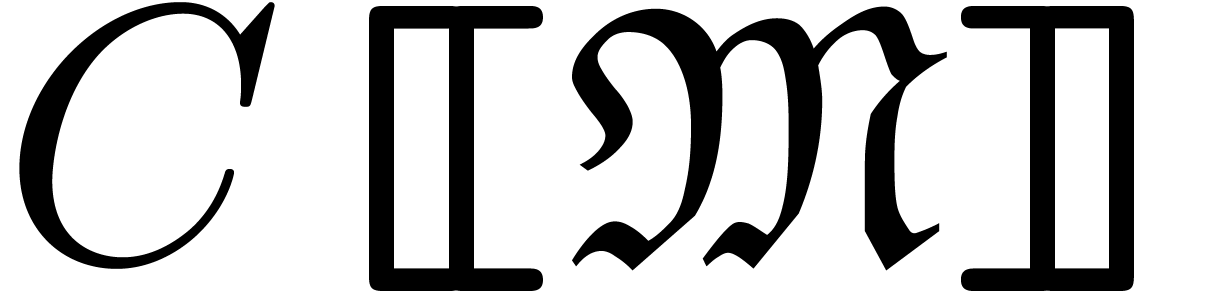

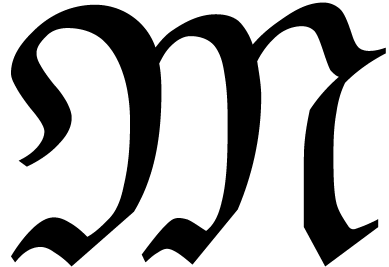

Le chapitre 2 est surtout consacré à la

thèse [79] de mon étudiant

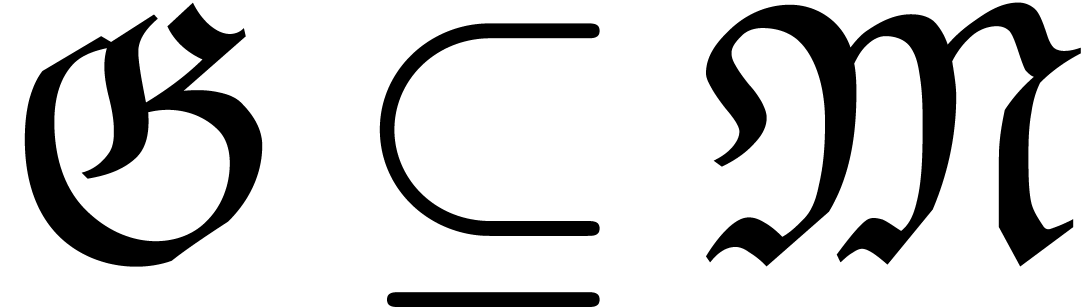

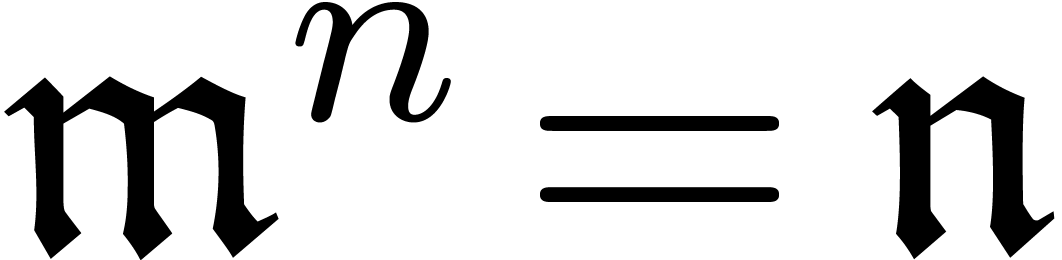

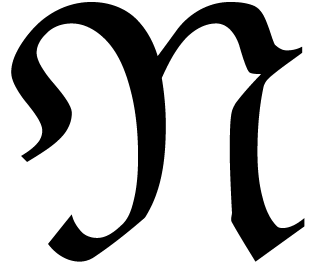

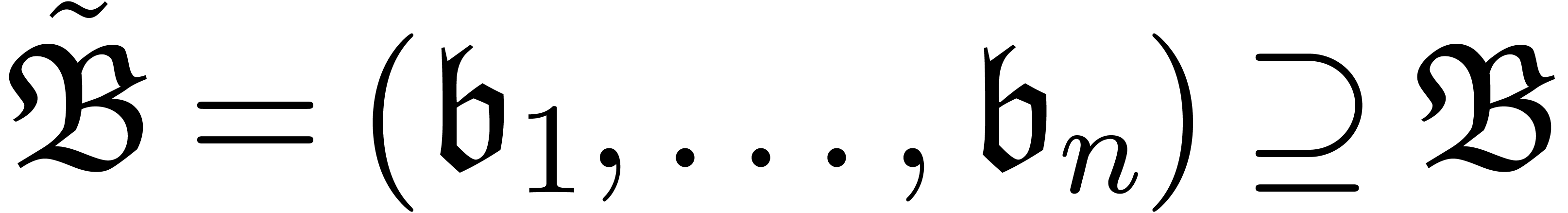

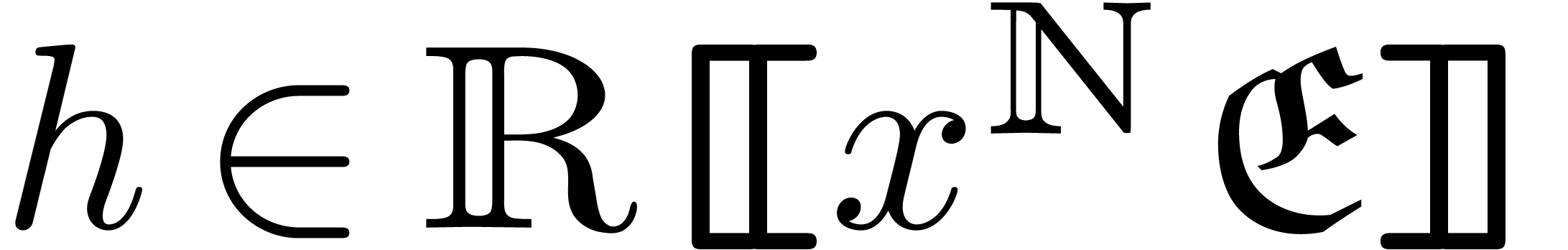

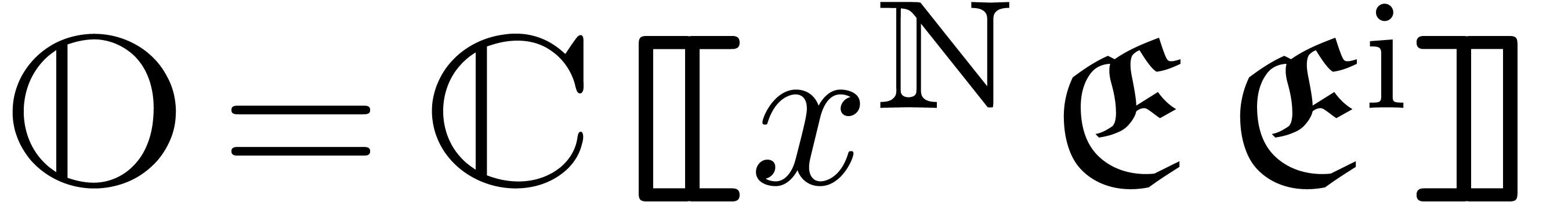

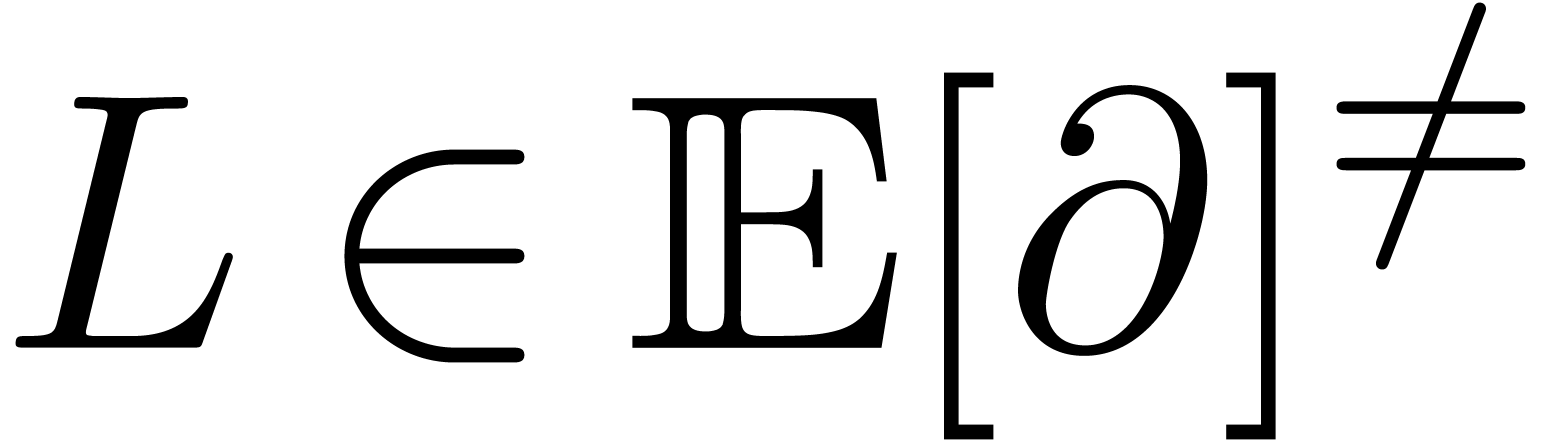

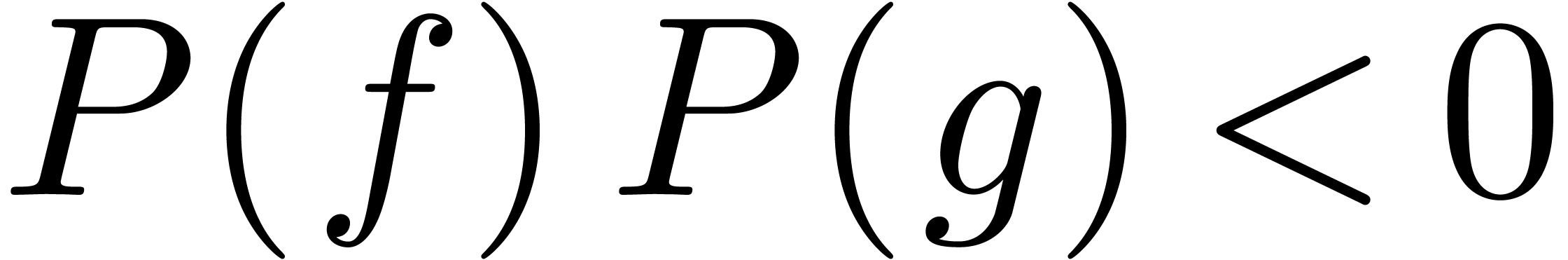

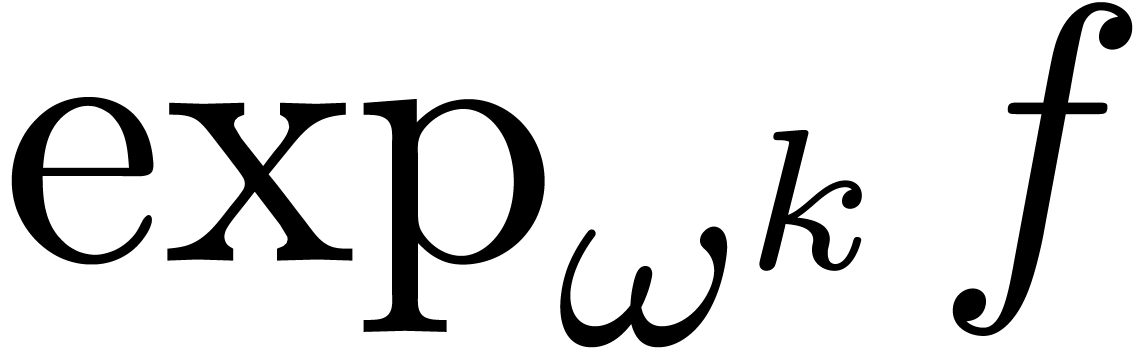

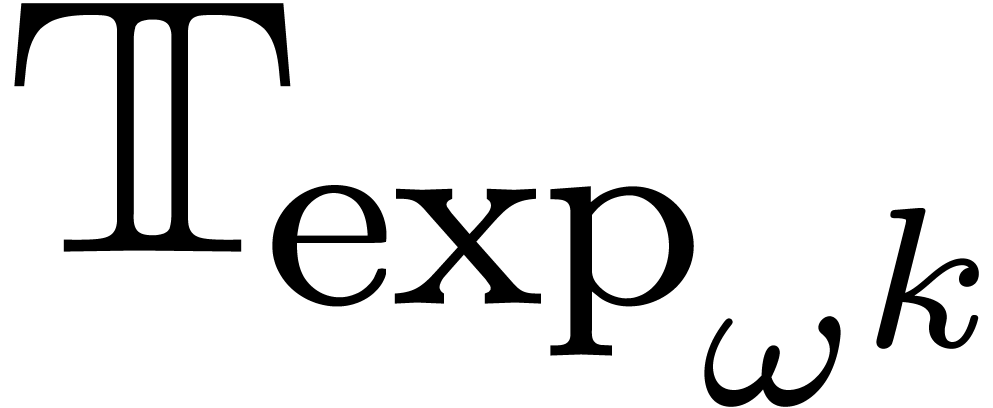

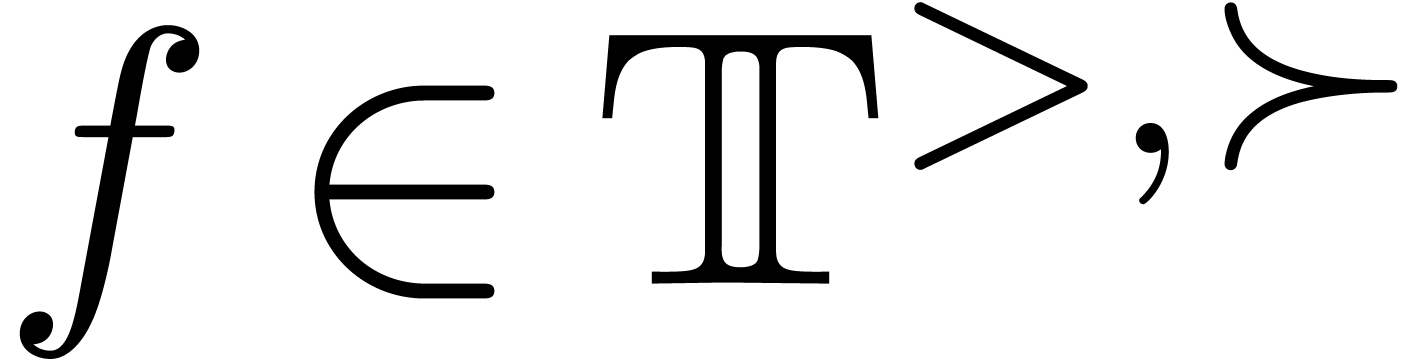

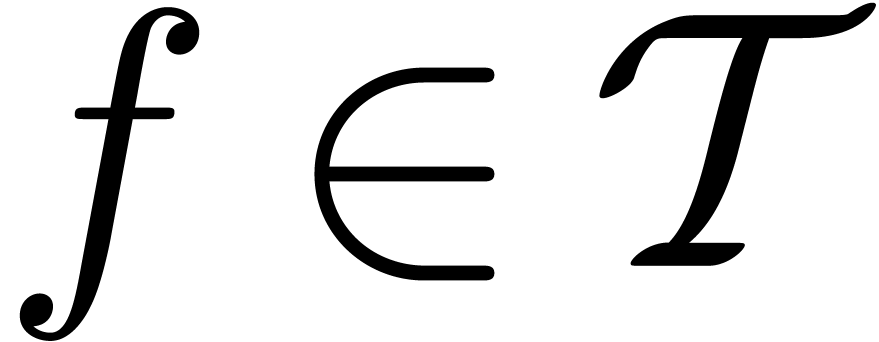

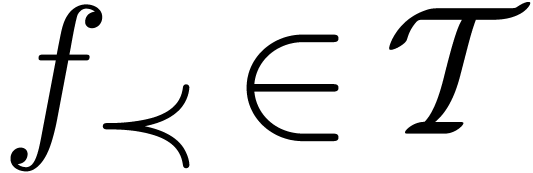

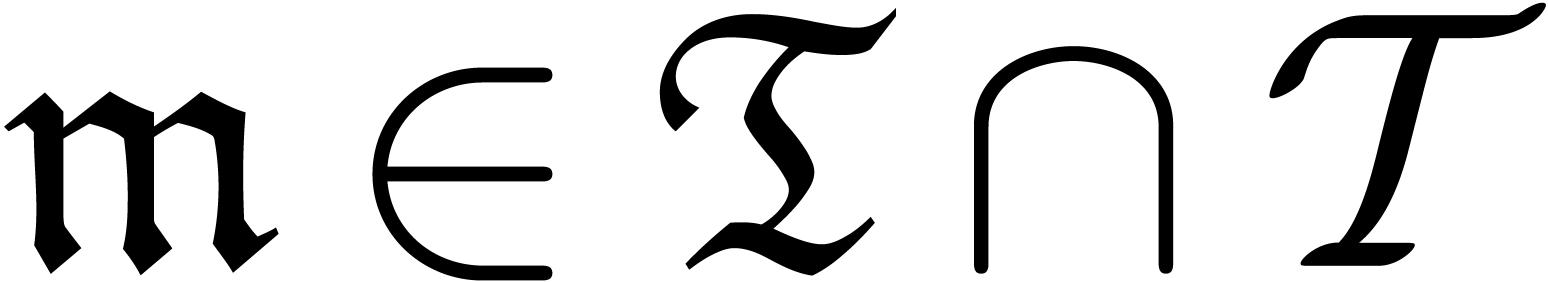

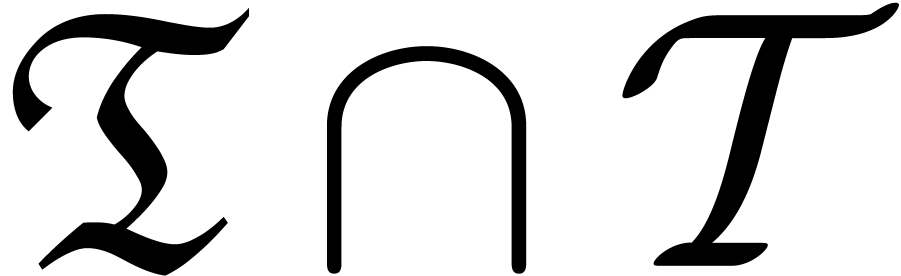

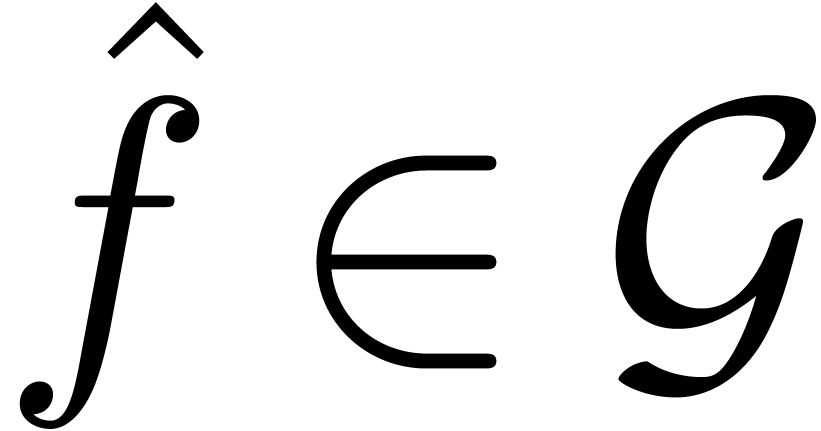

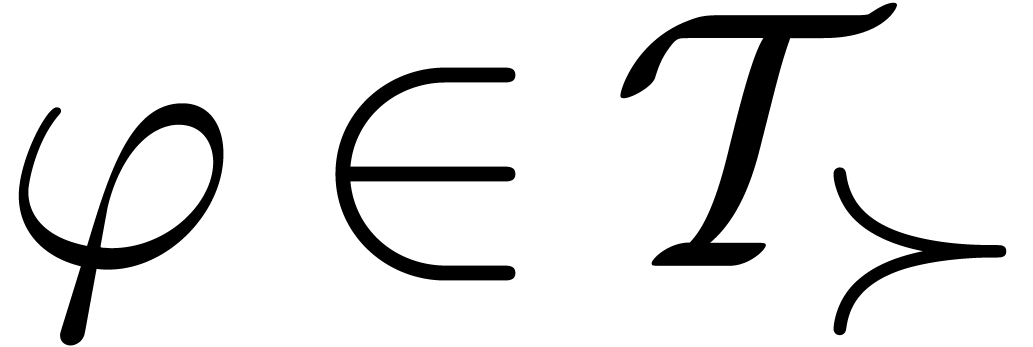

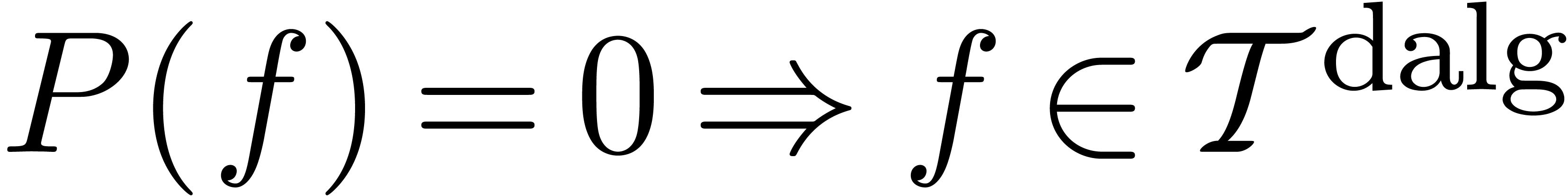

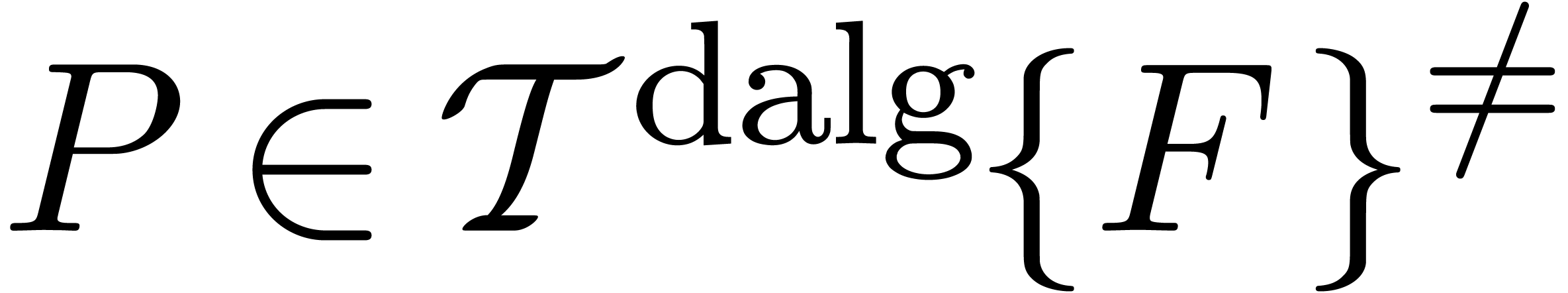

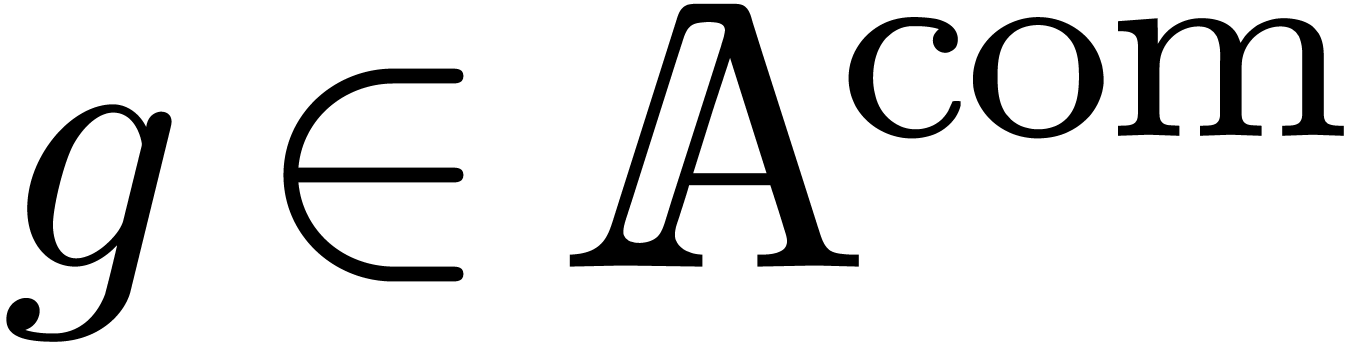

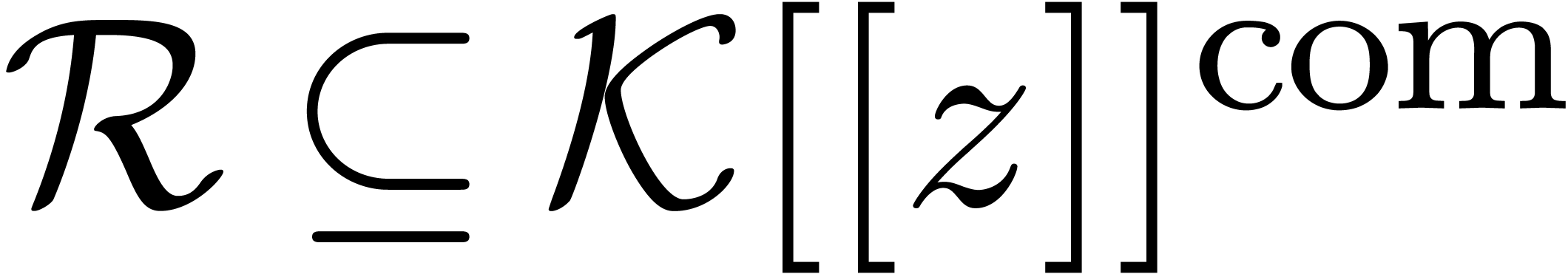

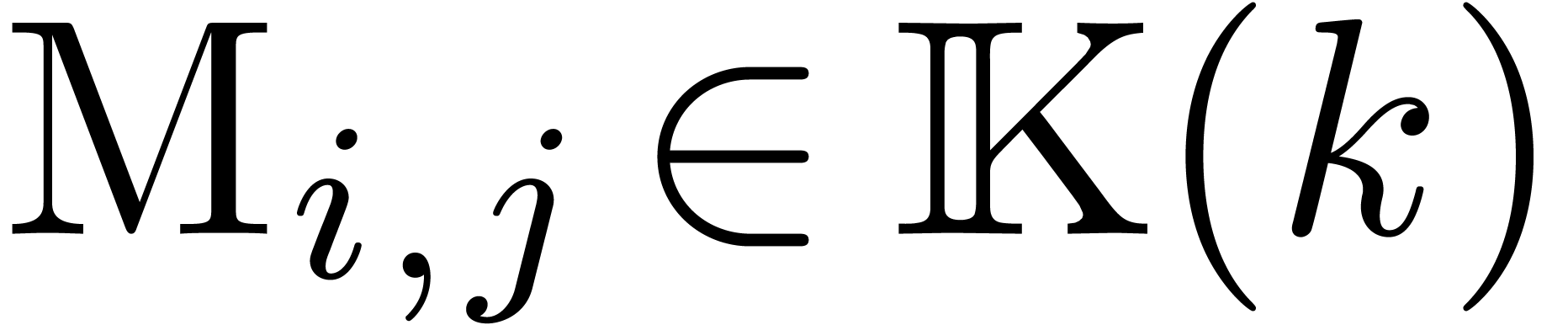

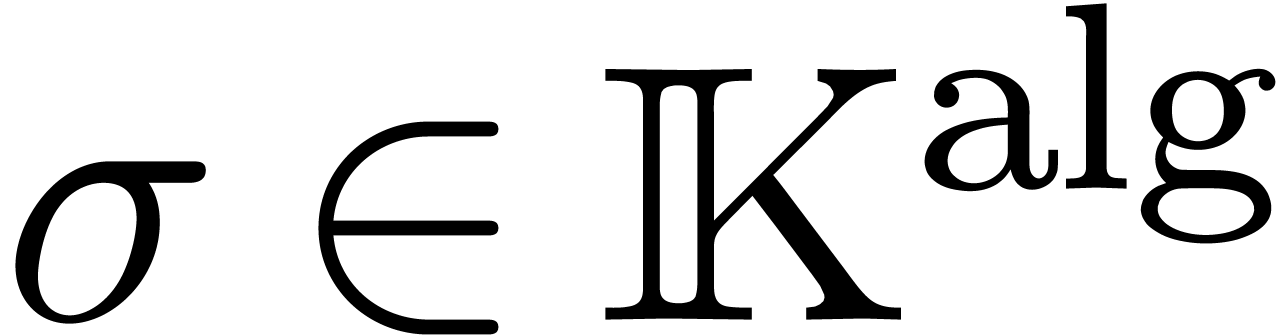

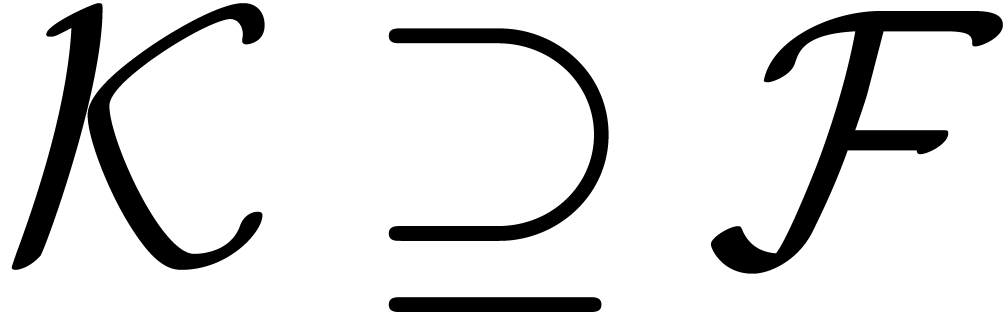

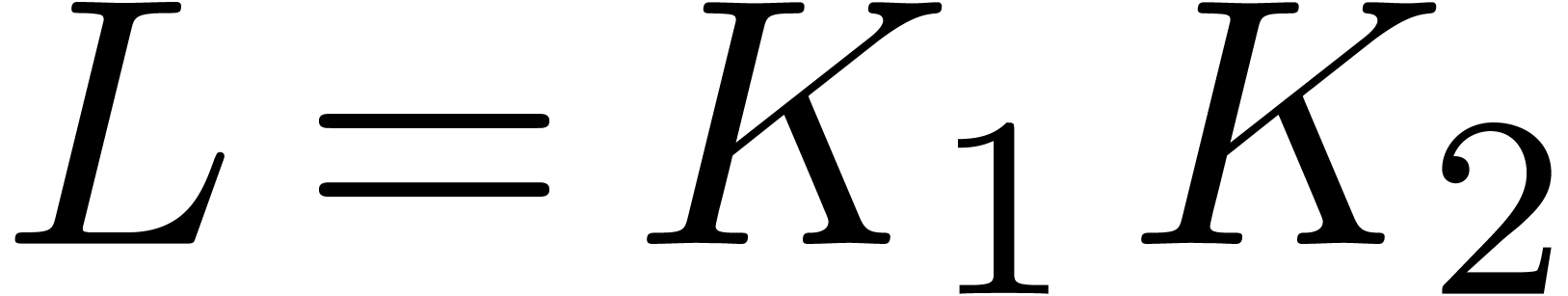

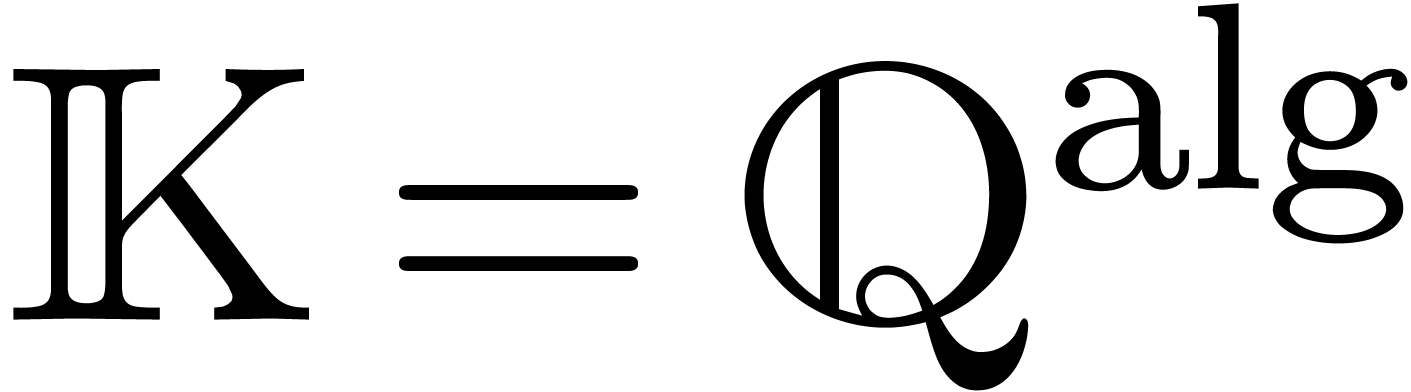

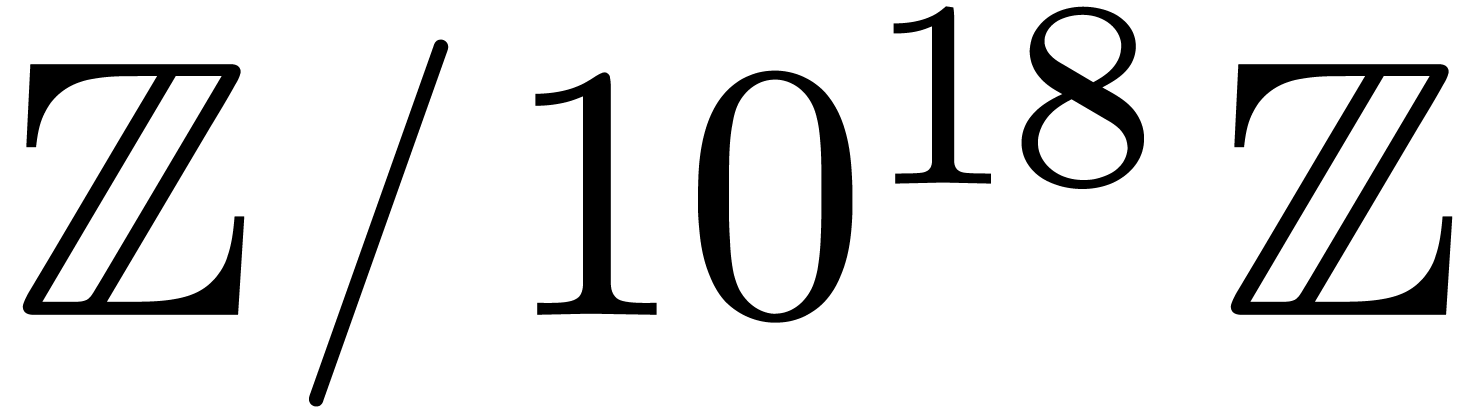

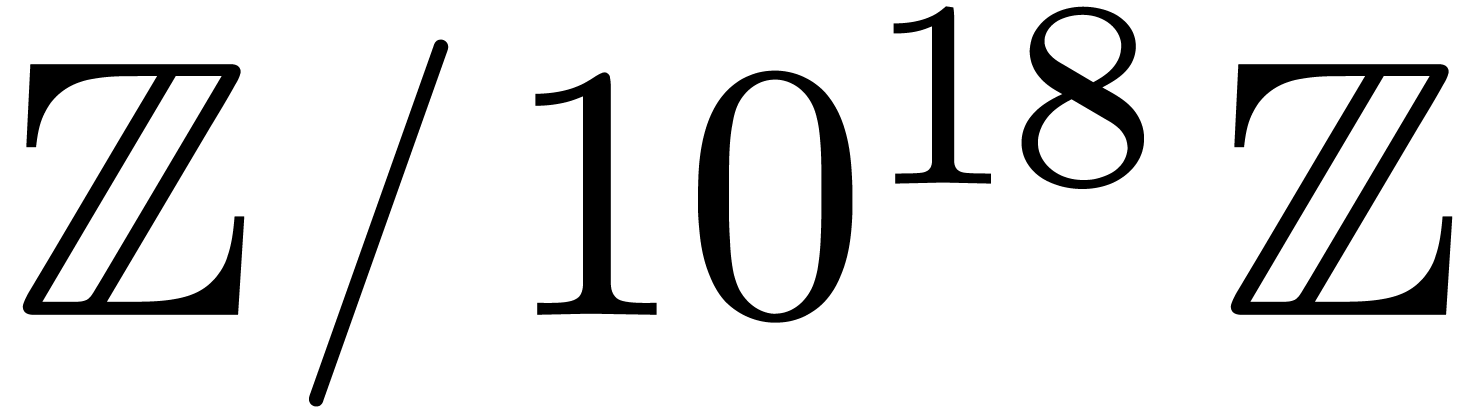

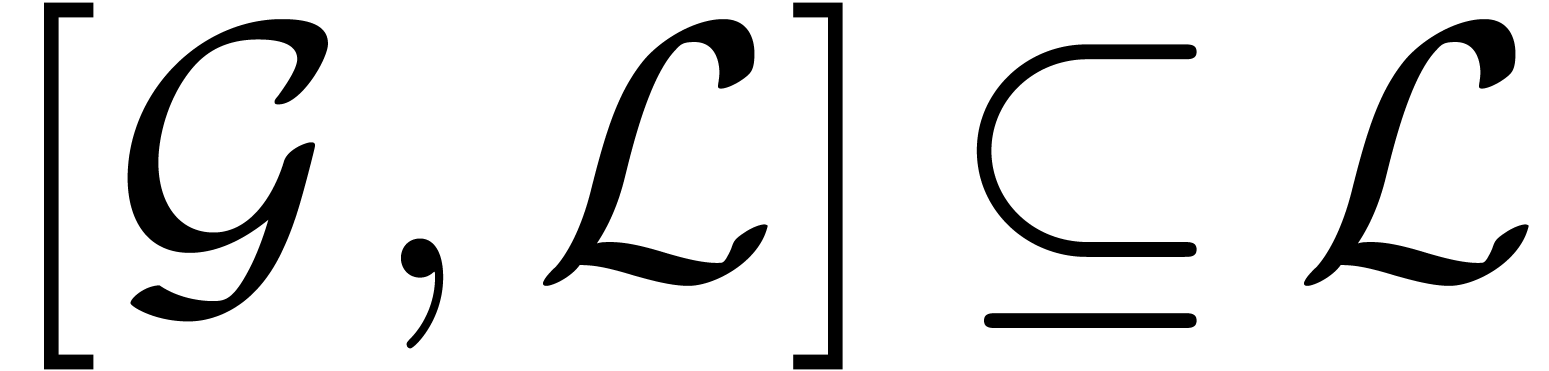

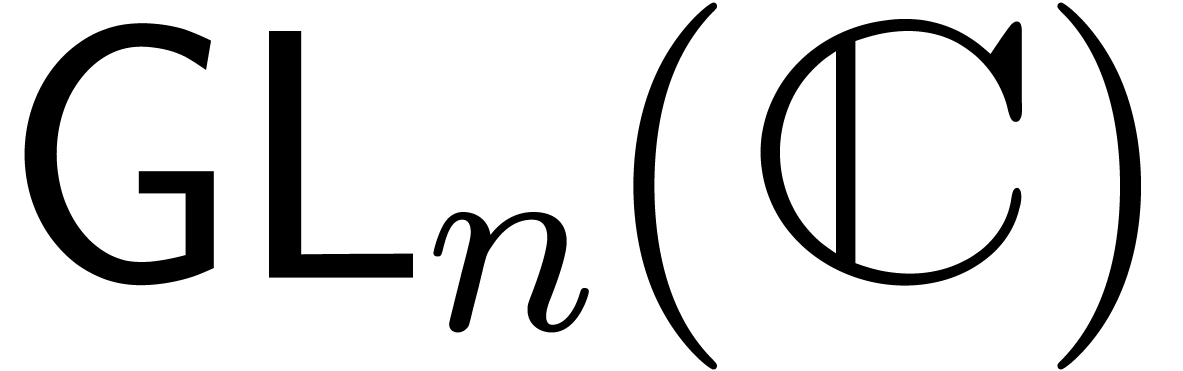

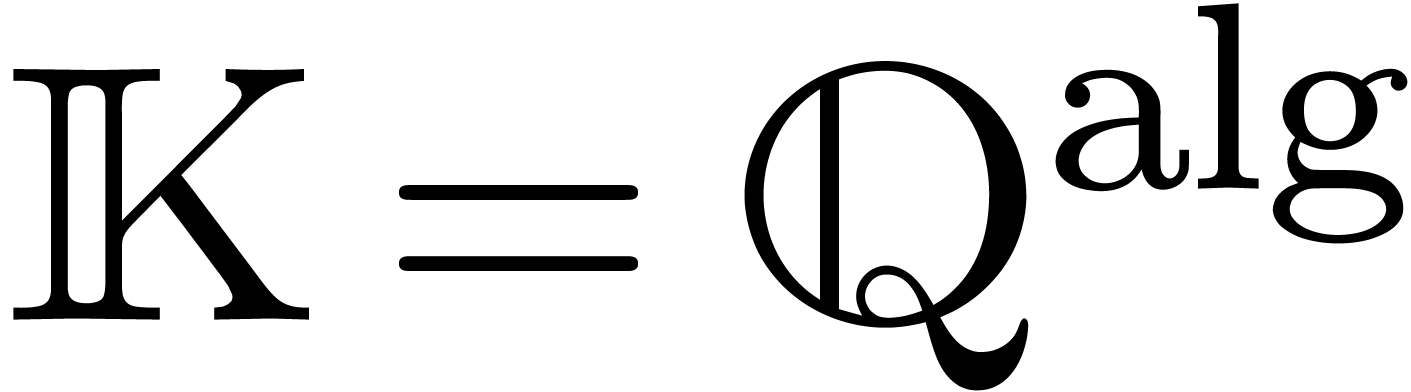

Le chapitre 3 concerne différentes façons

d'incarner des transséries en analyse et les relations avec la

théorie des modèles. On y montre notamment que le corps

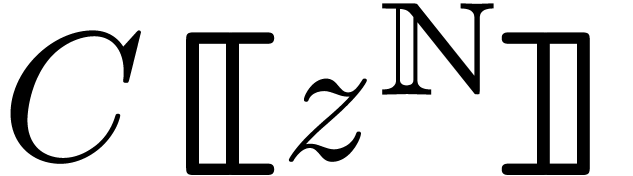

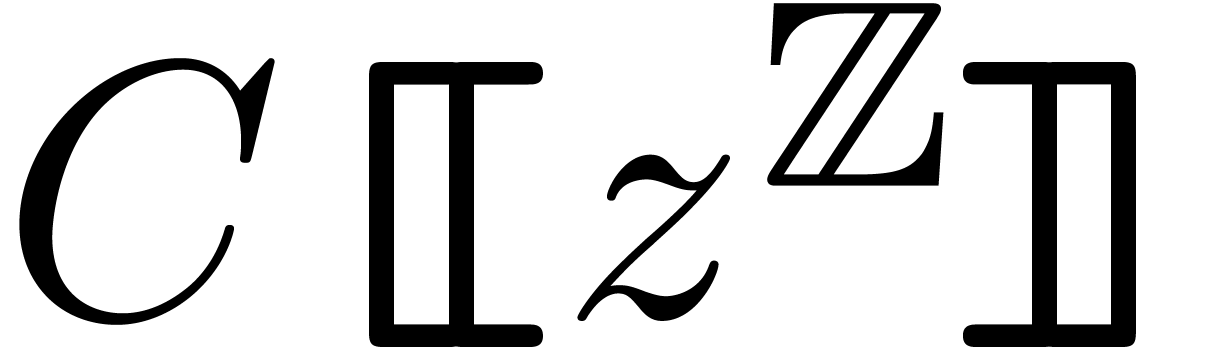

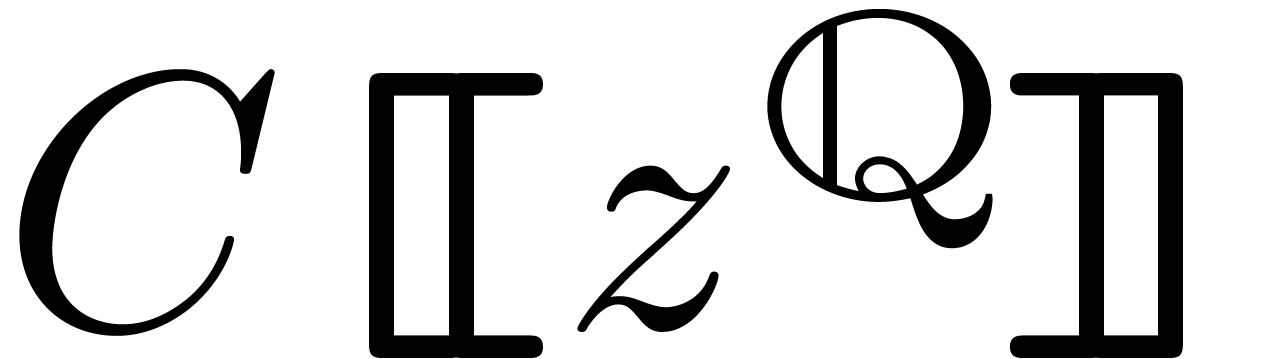

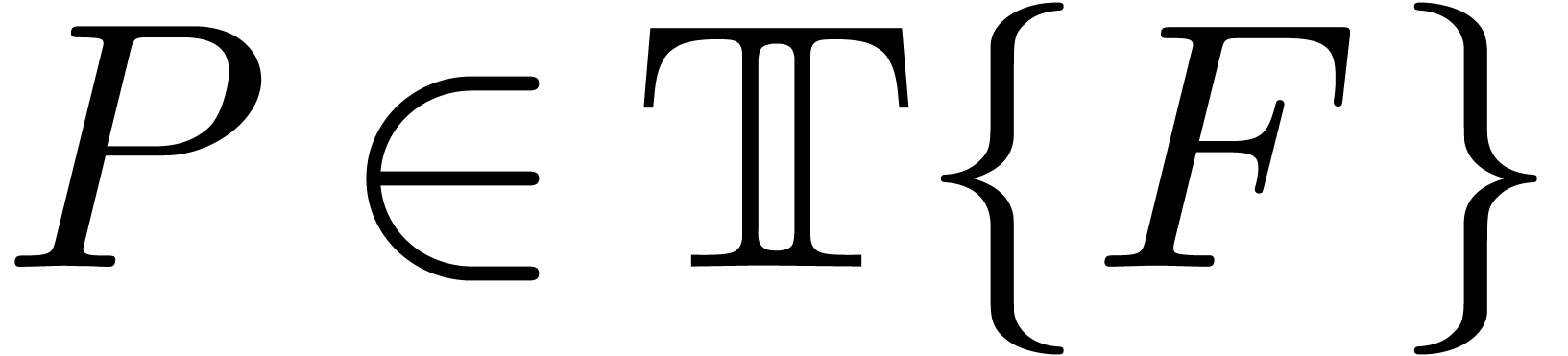

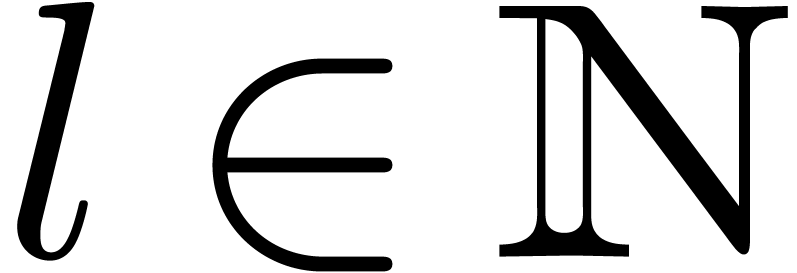

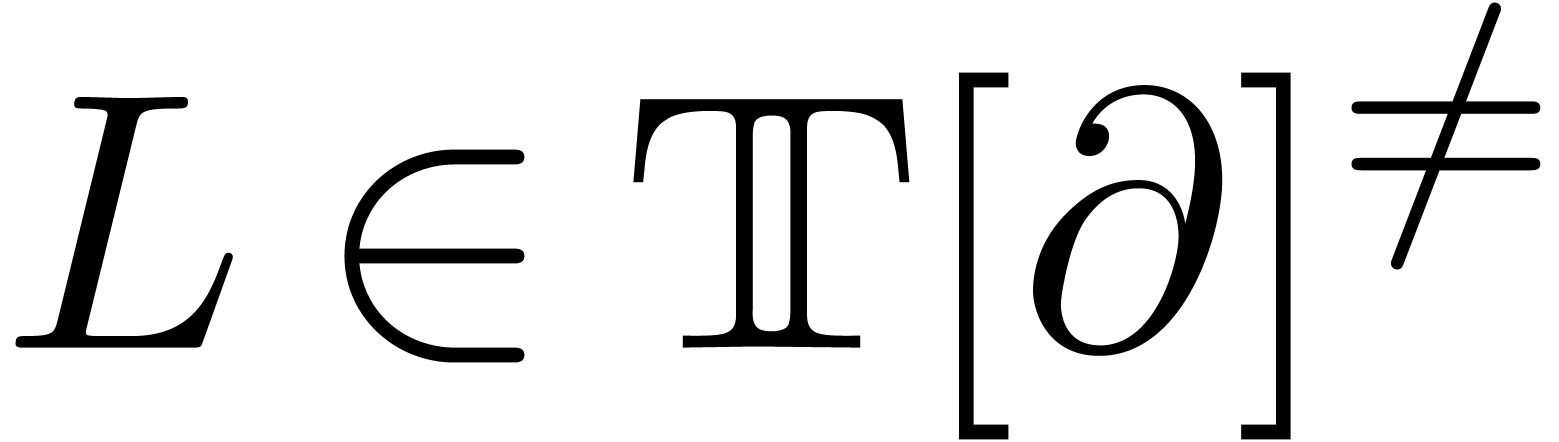

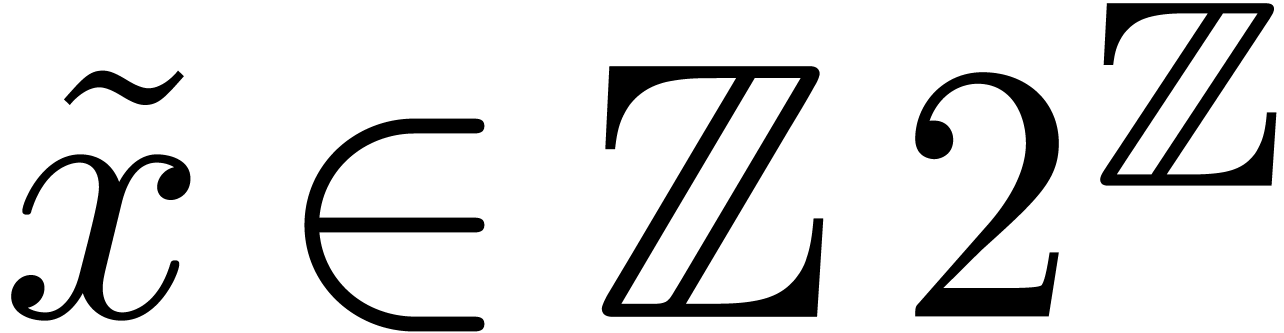

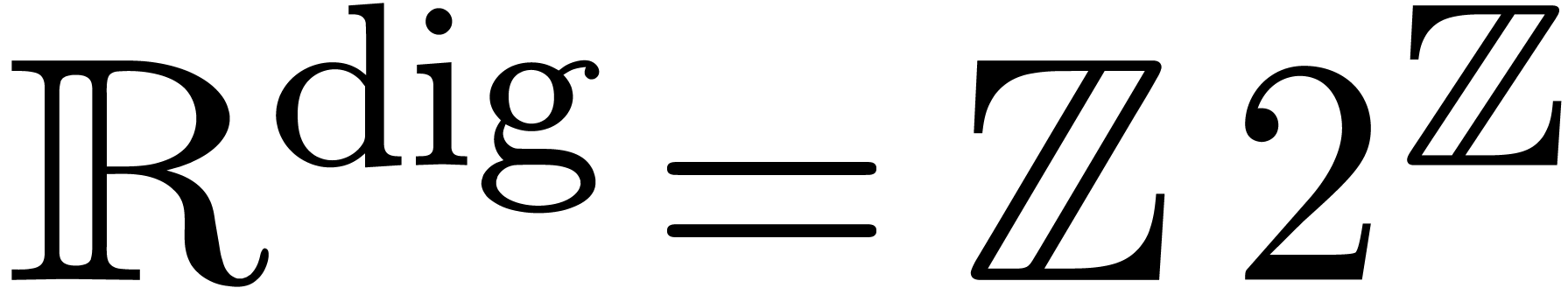

des transséries différentiellement algébriques sur

donne lieu à un corps de Hardy. Cette

partie a fait l'objet de deux articles [6, 116]

et des travaux sont en cours en collaboration avec

donne lieu à un corps de Hardy. Cette

partie a fait l'objet de deux articles [6, 116]

et des travaux sont en cours en collaboration avec

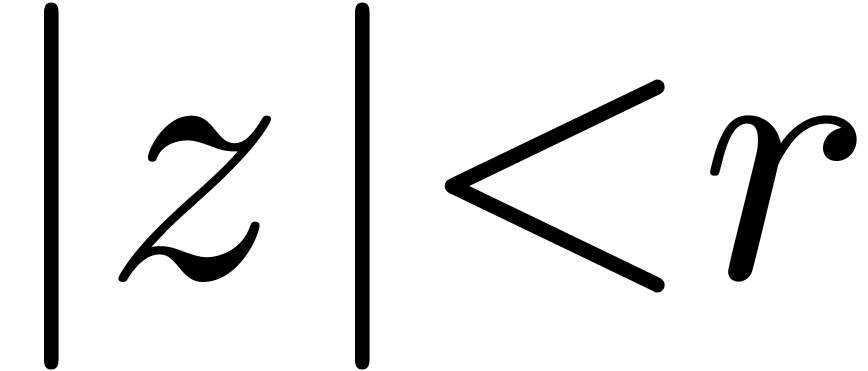

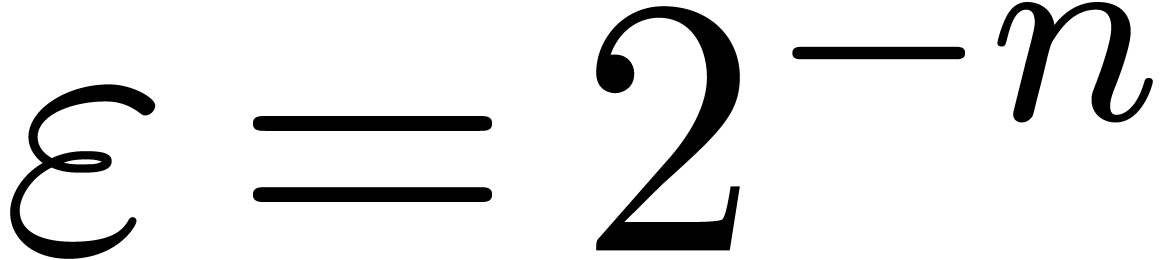

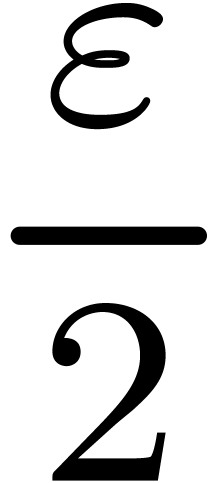

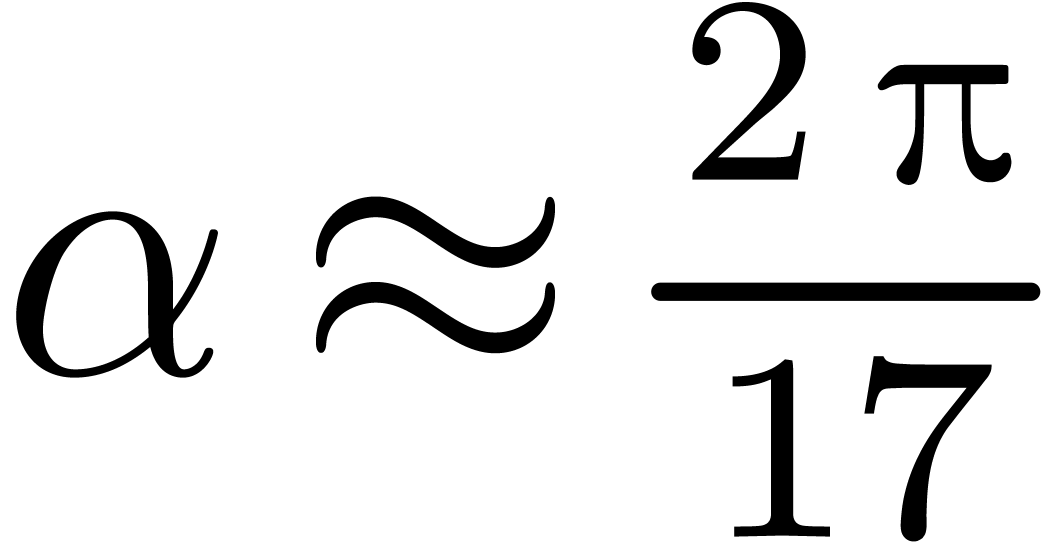

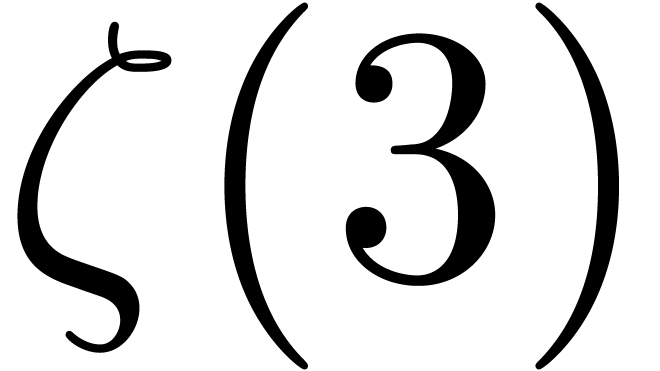

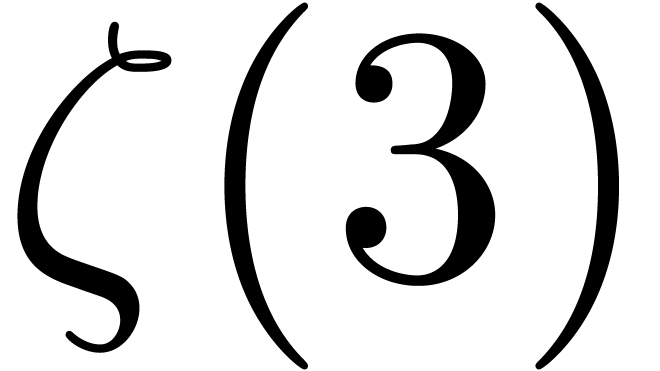

La deuxième partie commence par des résultats théoriques de décidabilité et calculabilité en analyse complexe. On y rappelle quelques théorèmes classiques sur les nombres réels calculables et poursuivons avec la formalisation des fonctions analytiques calculables. On y aborde également l'épineux problème des tests de nullité. Le chapitre 4 a donné lieu à plusieurs articles [110, 119, 120, 106, 113, 112, 114] et quelques prépublications [108, 101, 104].

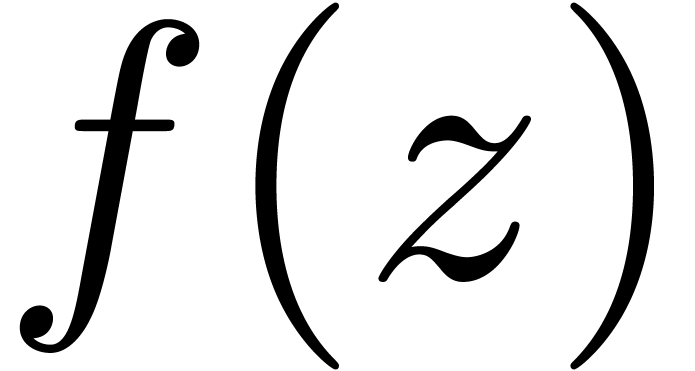

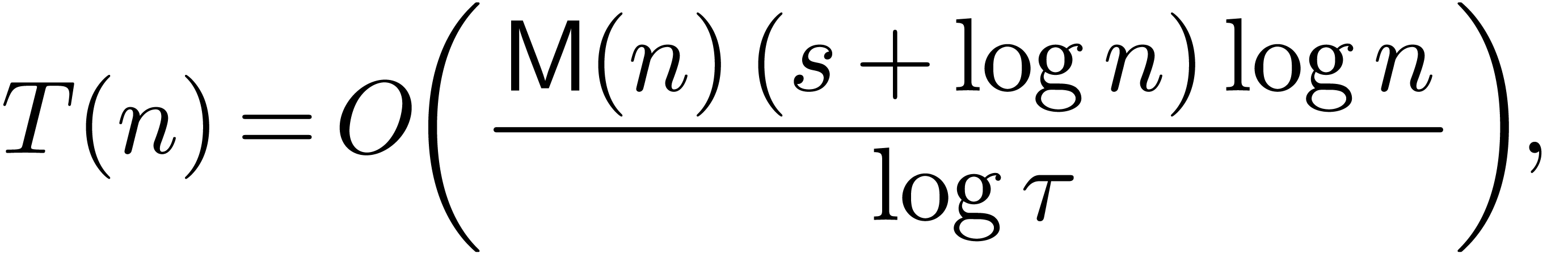

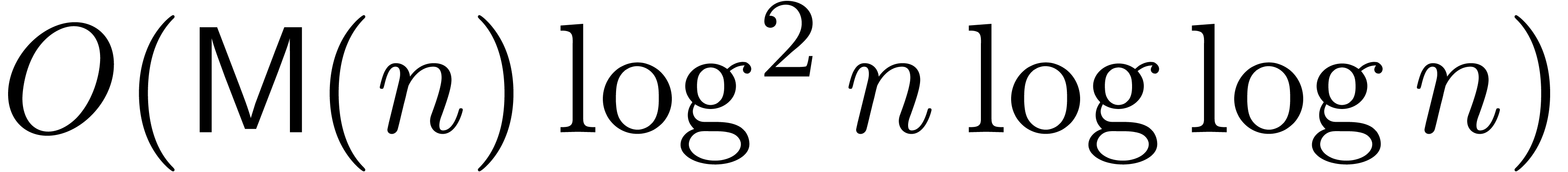

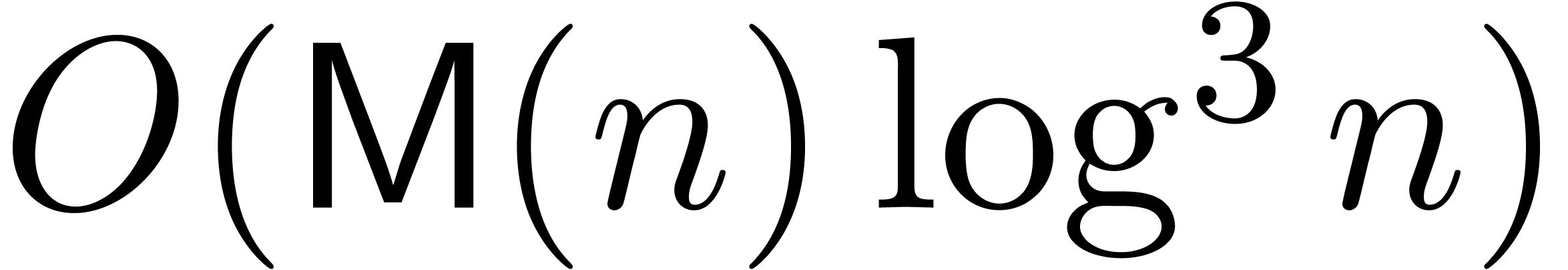

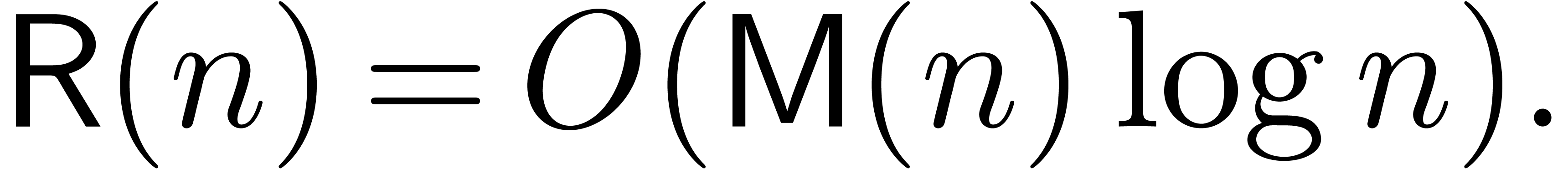

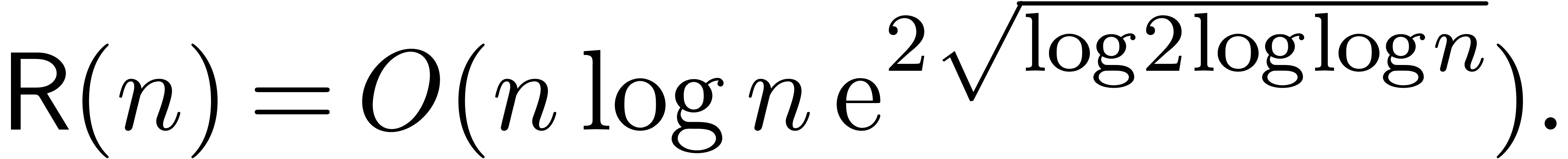

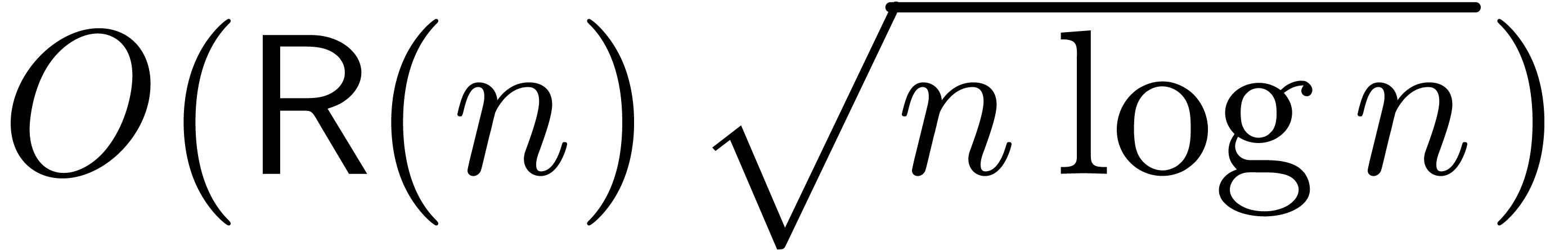

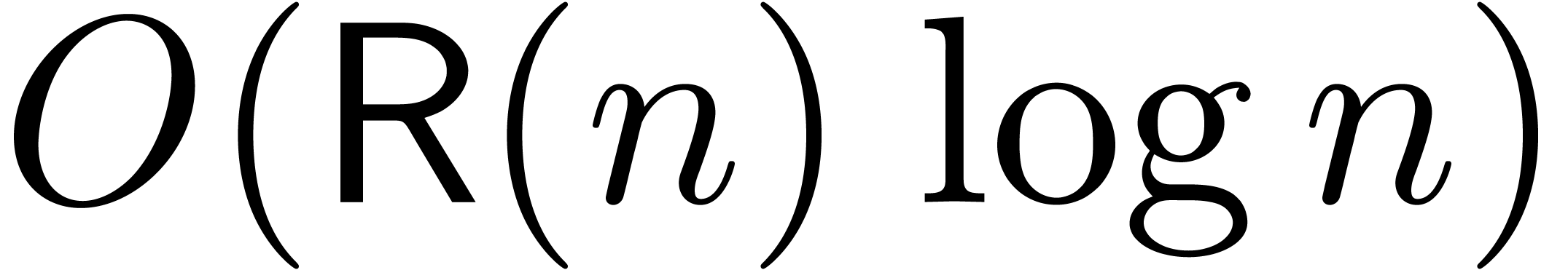

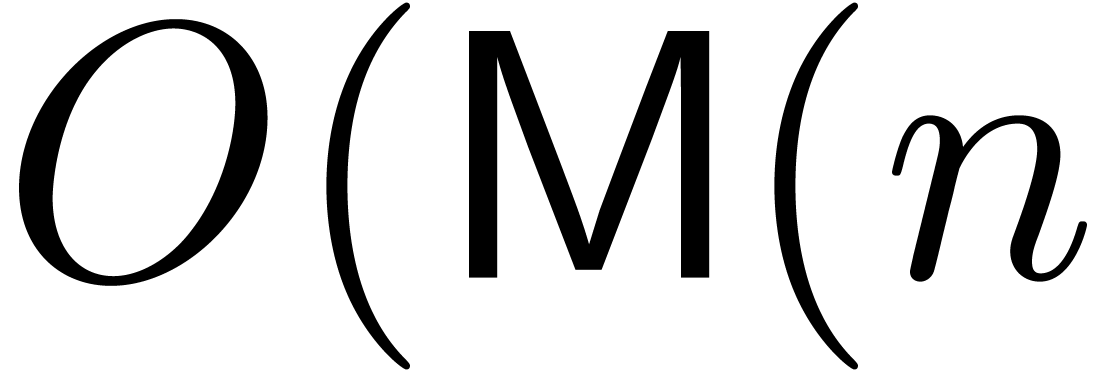

Dans le chapitre 5, on étudiera des algorithmes efficaces pour évaluer différents types de fonctions analytiques. On commencera par les fonctions holonomes, qui couvrent la plupart des fonctions spéciales, et que l'on traitera de façon assez complète, y compris dans des singularités. Ces résultats ont été publiés dans [98, 102, 121]. On considérera ensuite des solutions à des équations différentielles plus générales [97, 107, 109, 122, 115].

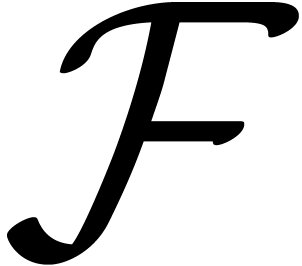

Dans le dernier chapitre, on verra une application a priori surprenante de l'analyse complexe effective à la factorisation d'opérateurs différentiels et le calcul de leurs groupes de Galois différentiels [118].

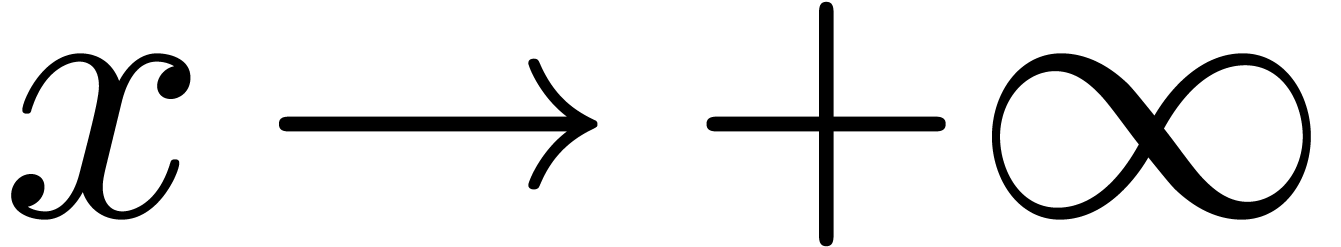

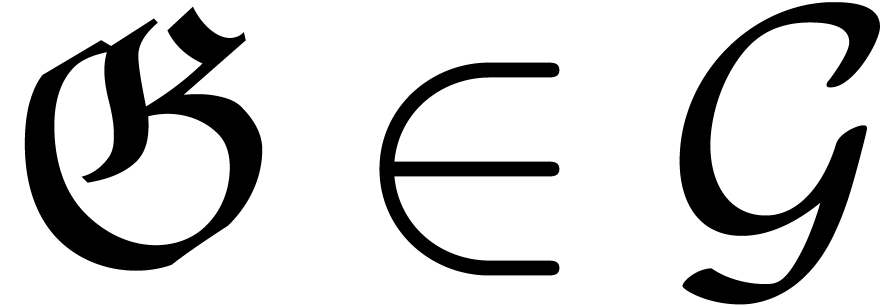

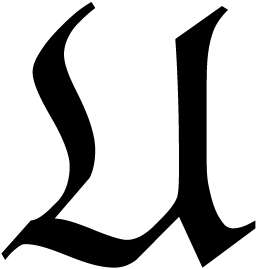

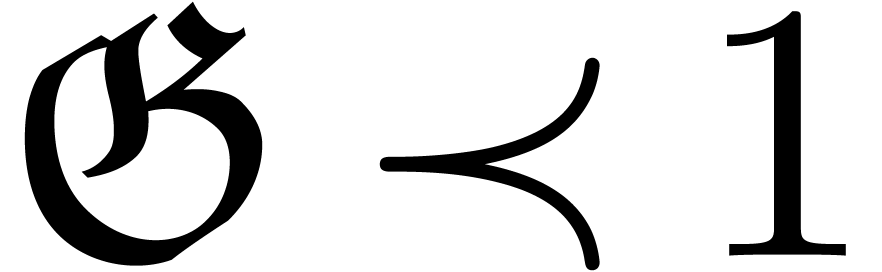

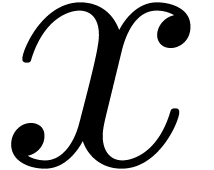

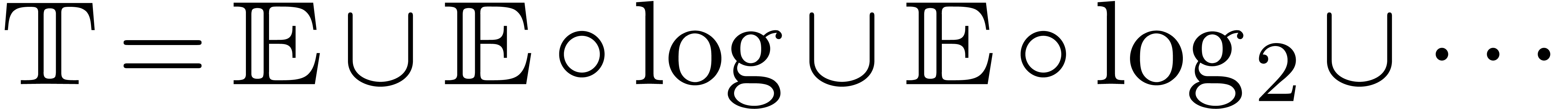

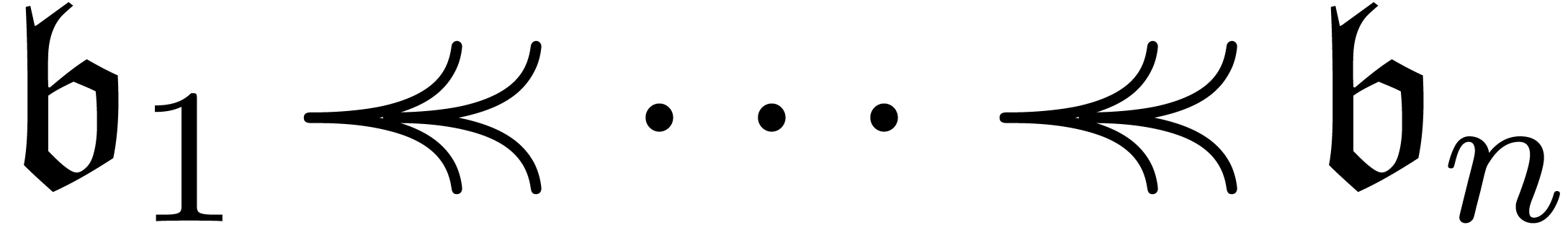

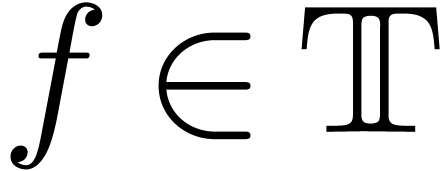

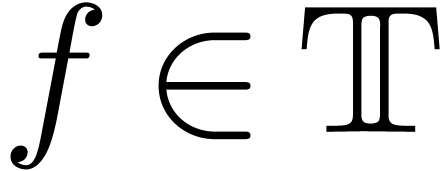

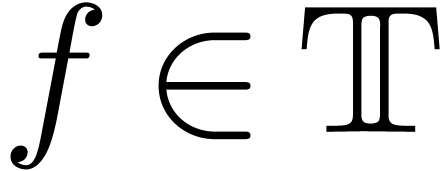

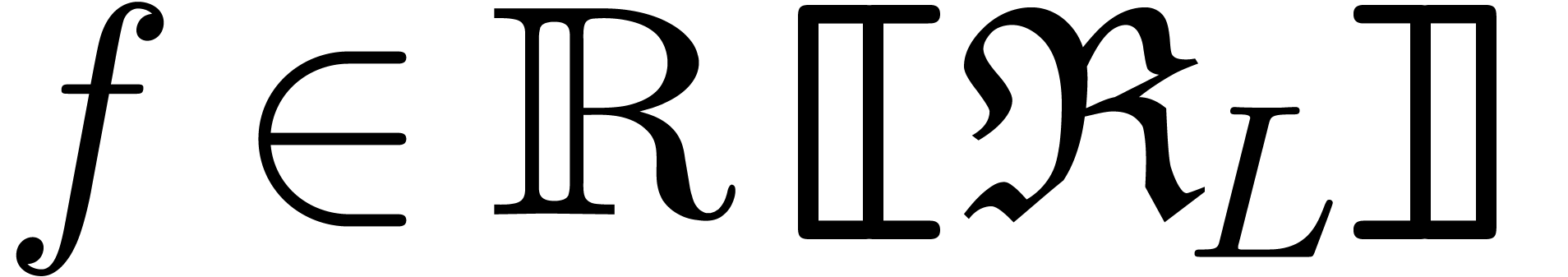

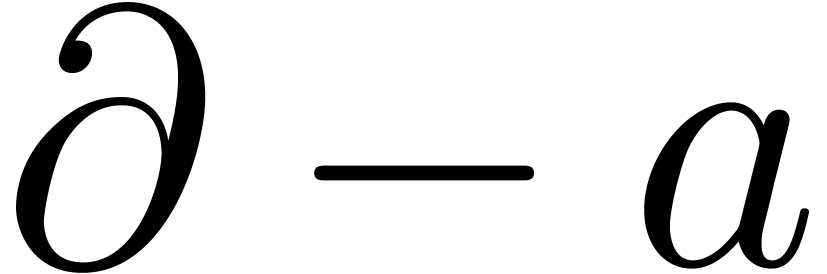

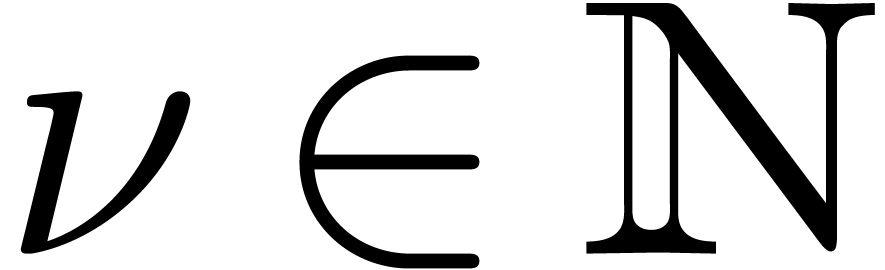

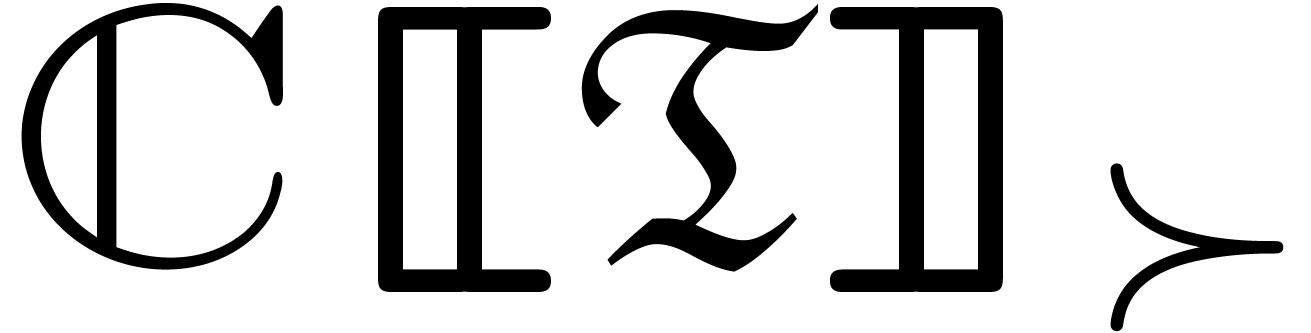

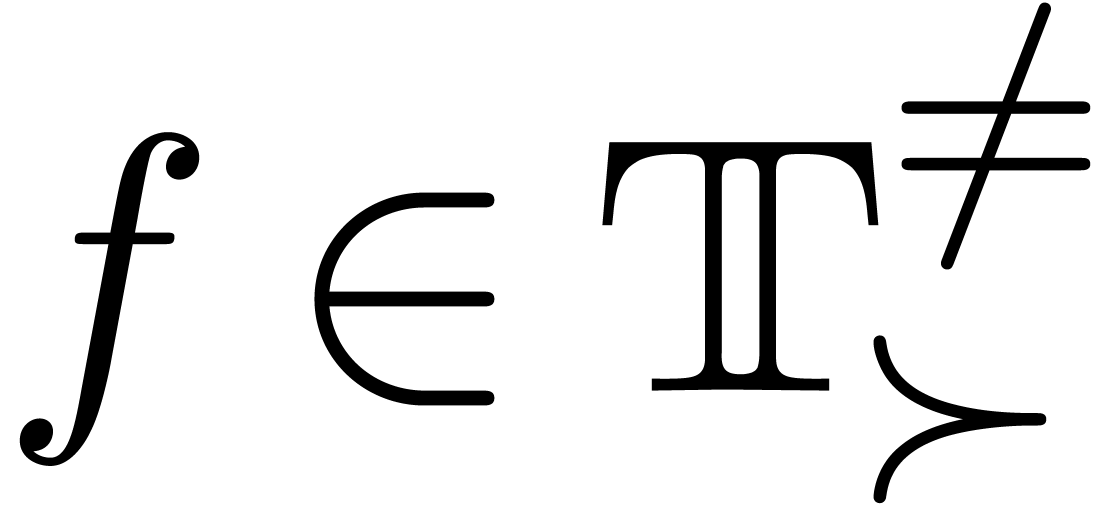

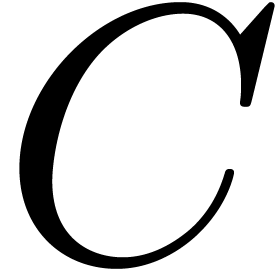

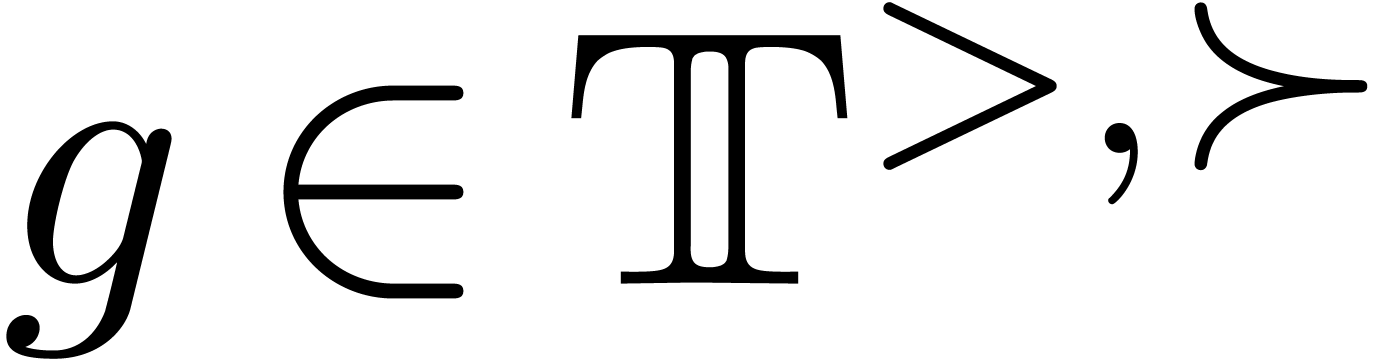

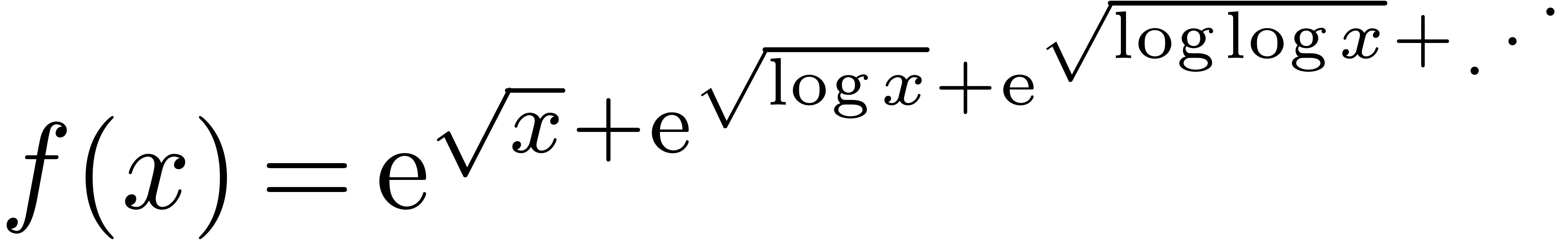

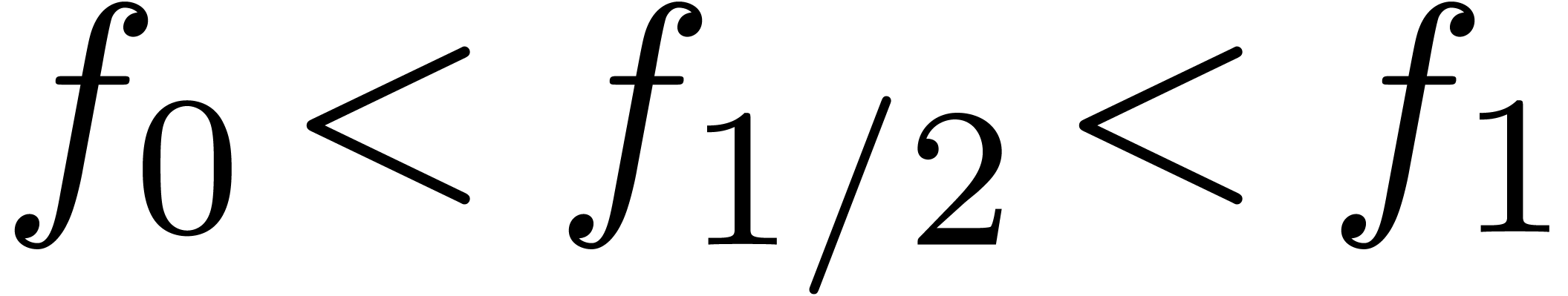

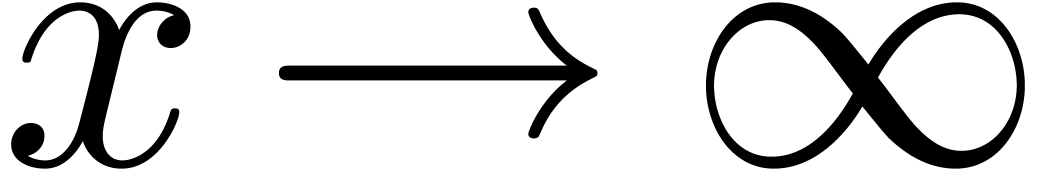

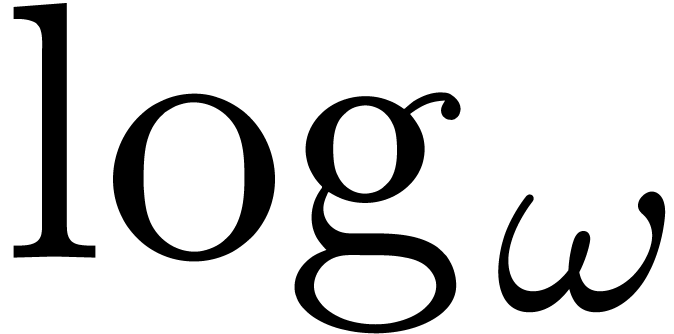

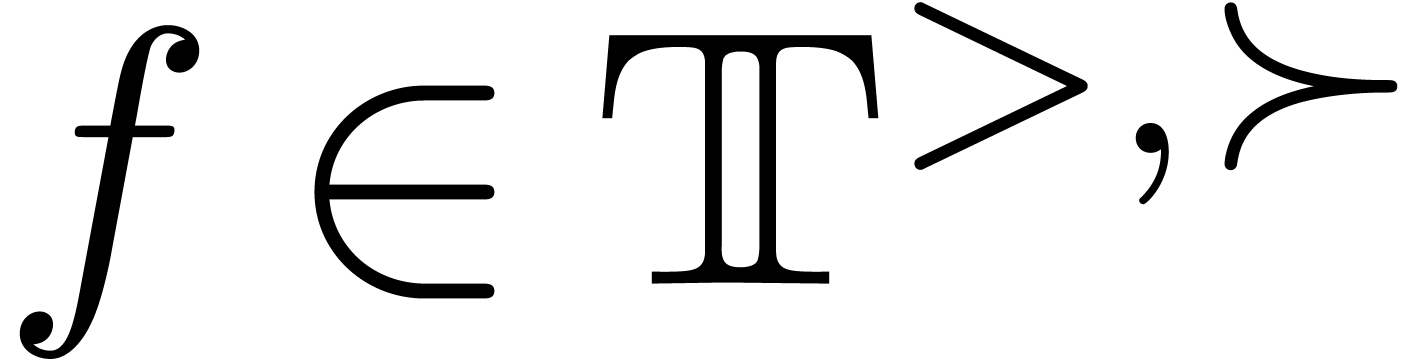

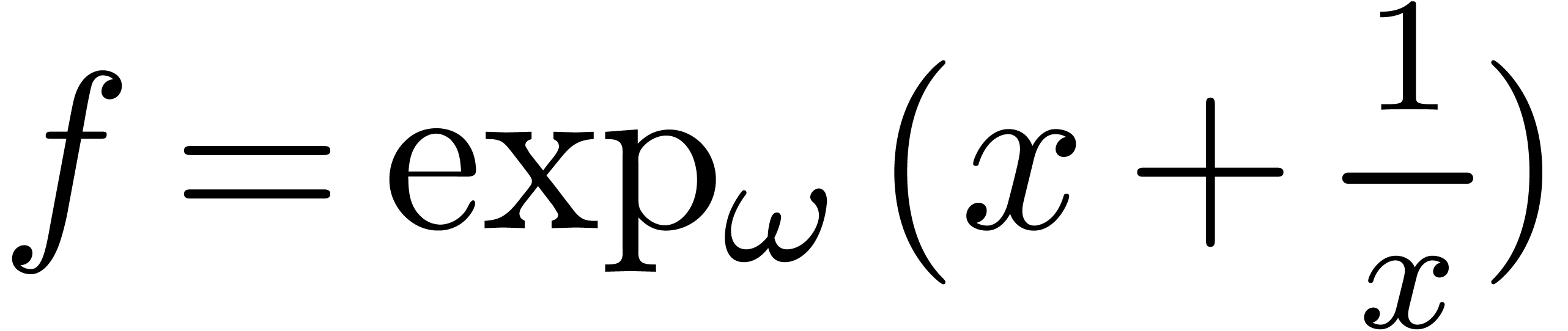

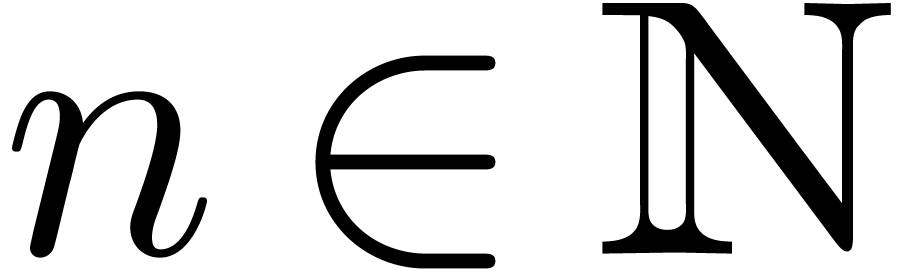

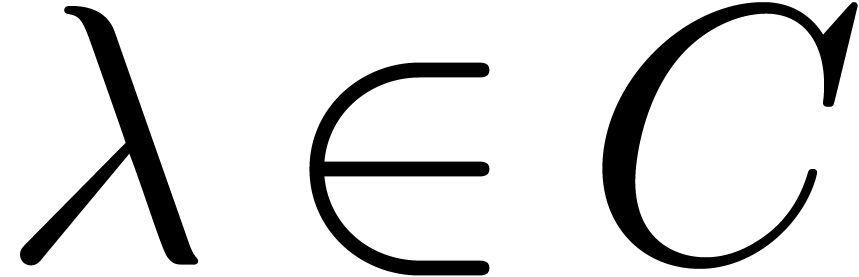

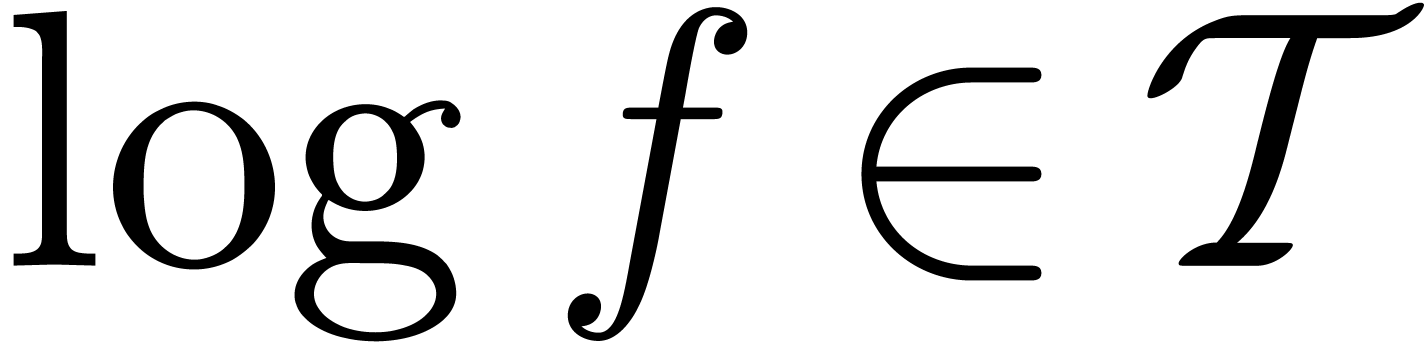

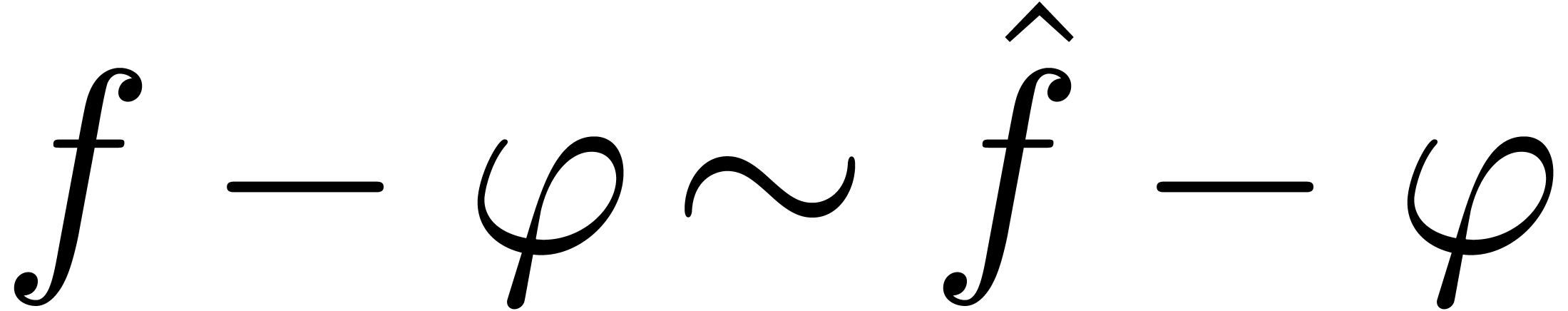

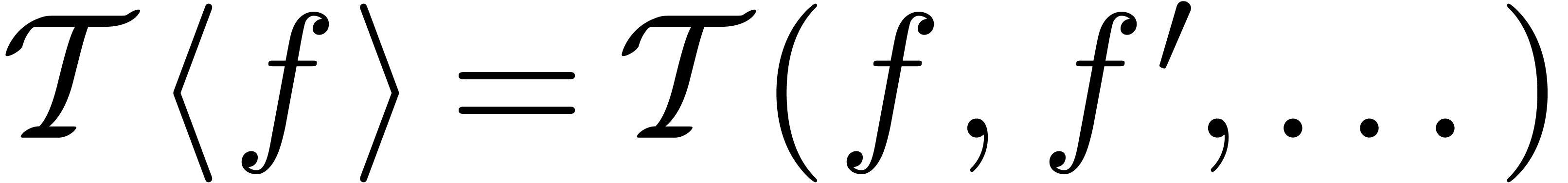

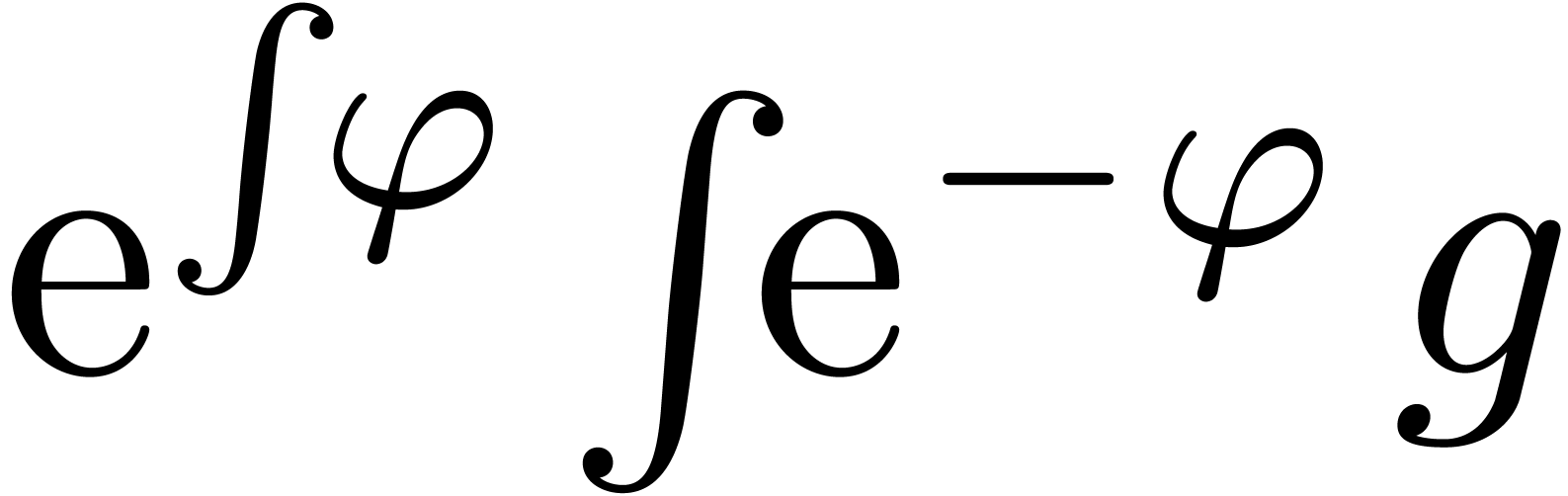

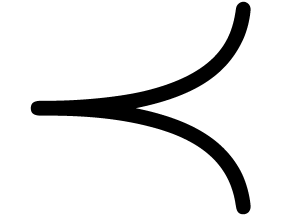

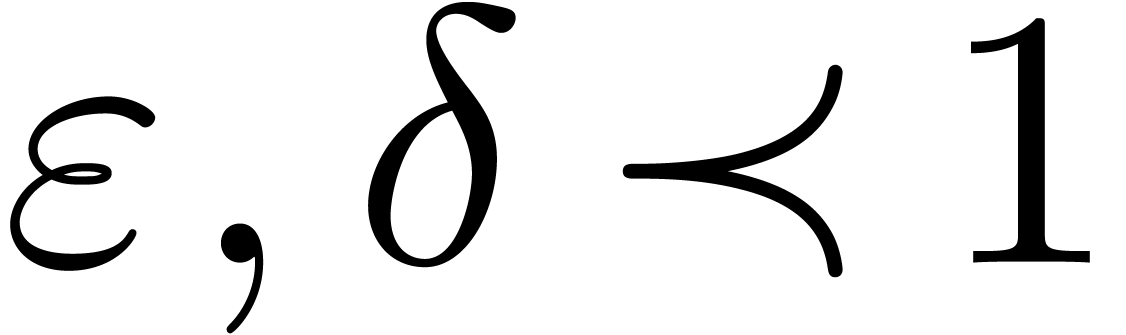

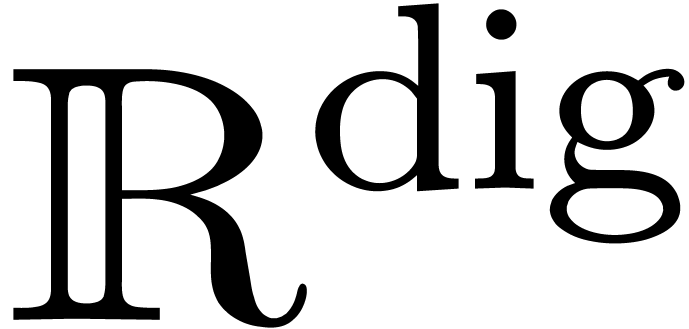

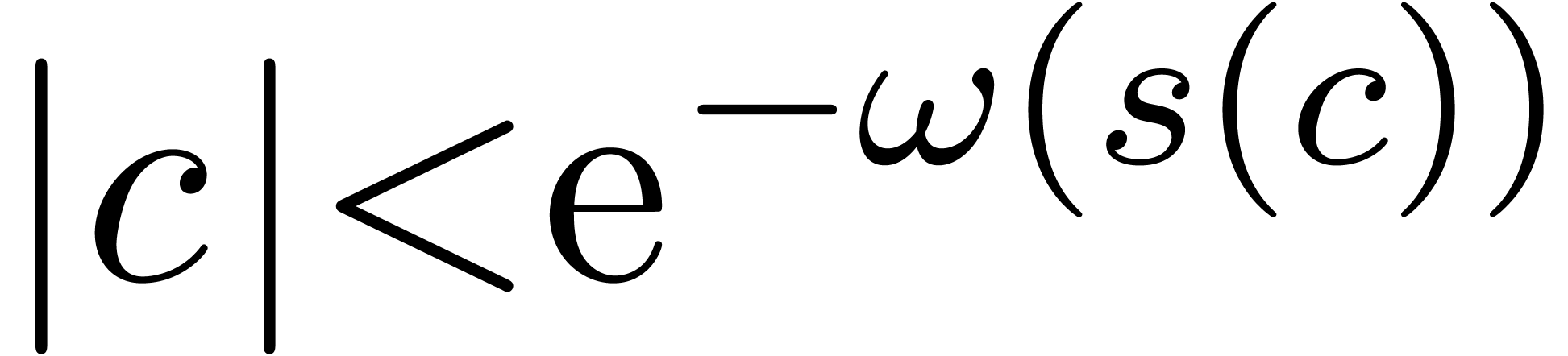

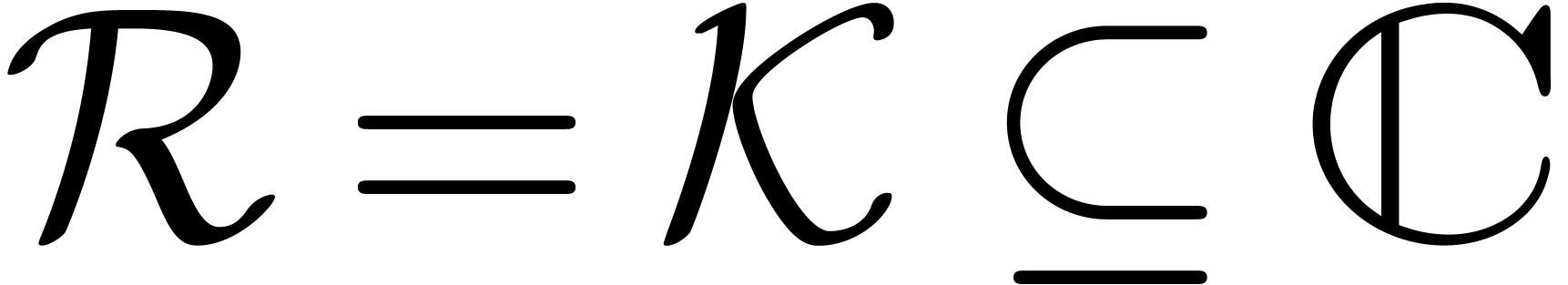

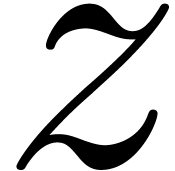

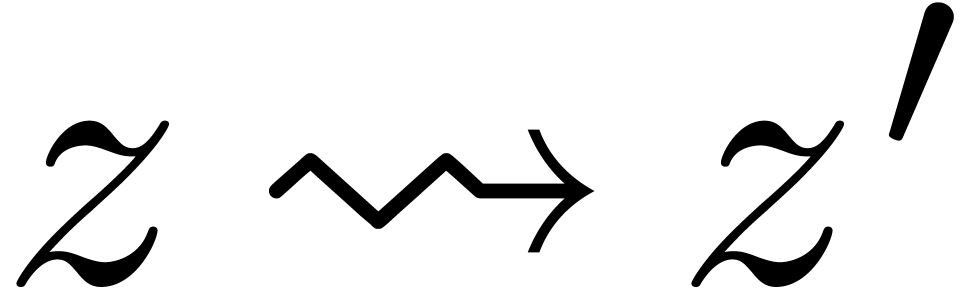

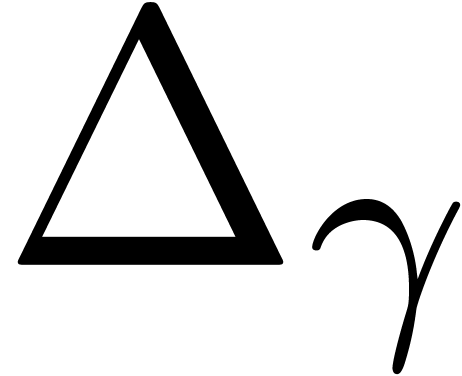

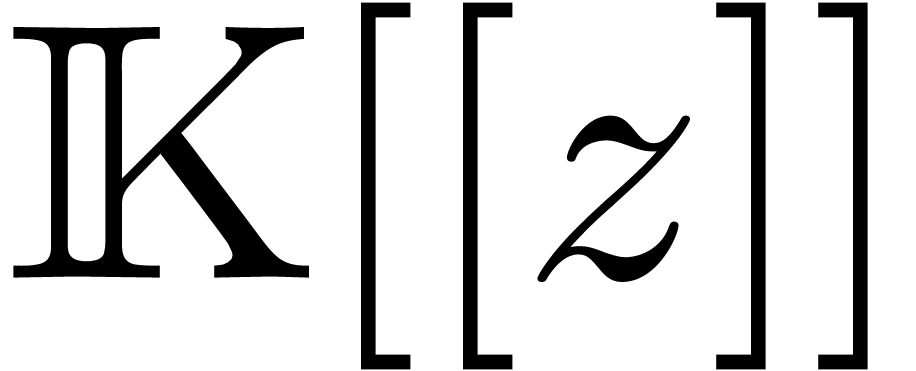

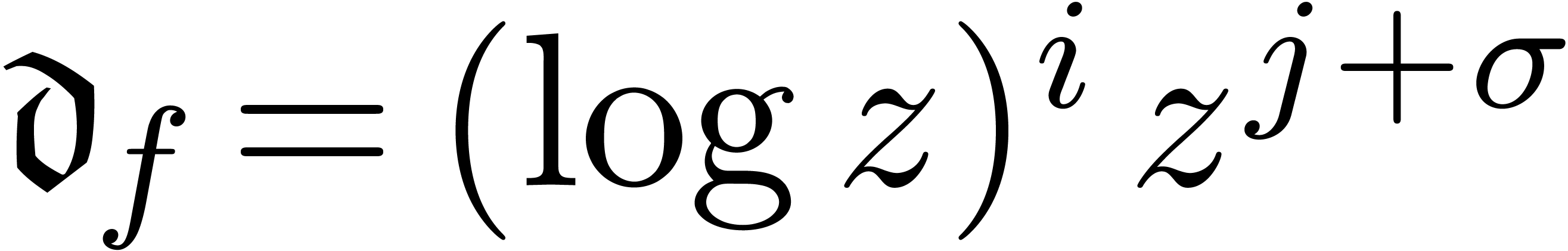

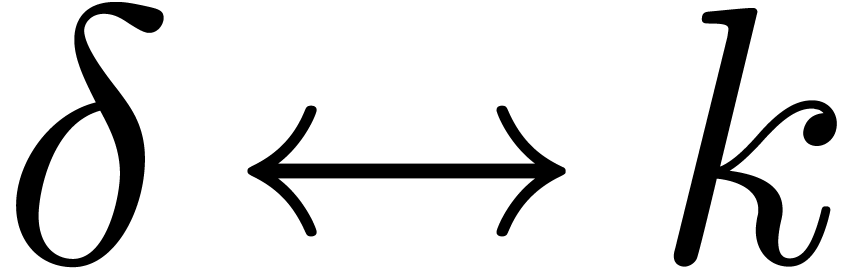

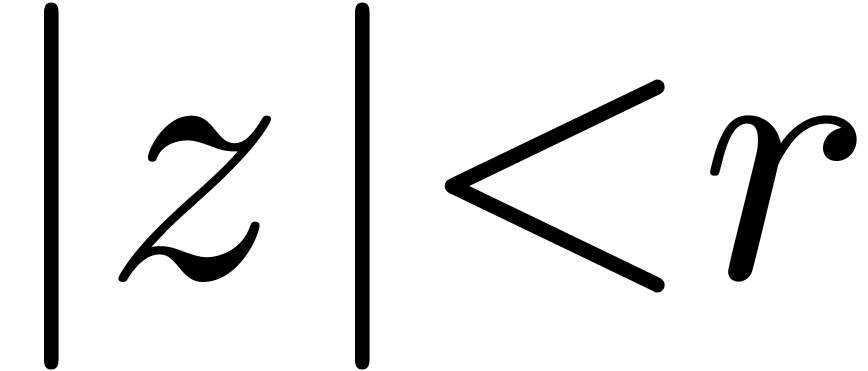

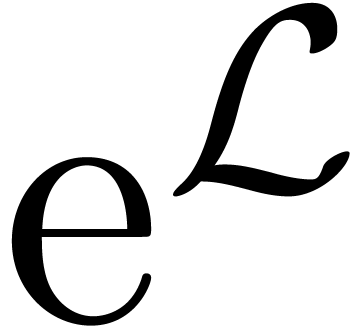

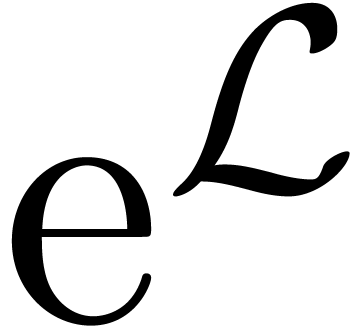

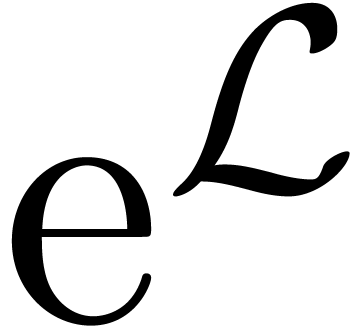

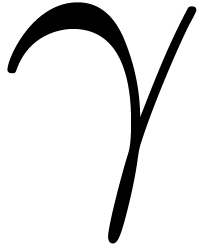

La théorie des transséries vise à modéliser

aussi explicitement que possible des comportements asymptotiques

réguliers à l'infini. Pour la plupart des fonctions

naturelles de l'analyse, il fut déjà remarqué par

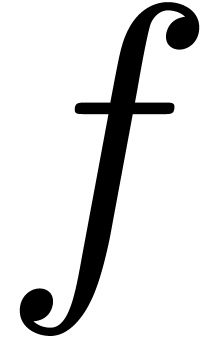

Hardy que les « fonctions  »

fournissent un cadre assez large et souple pour ce genre de

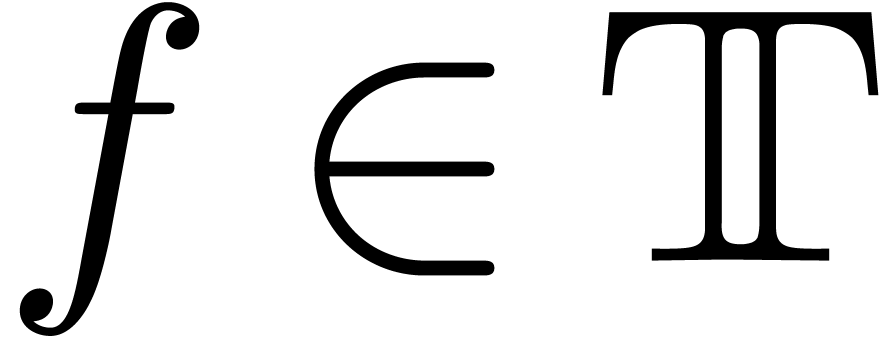

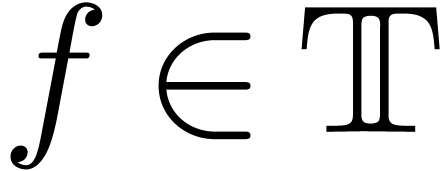

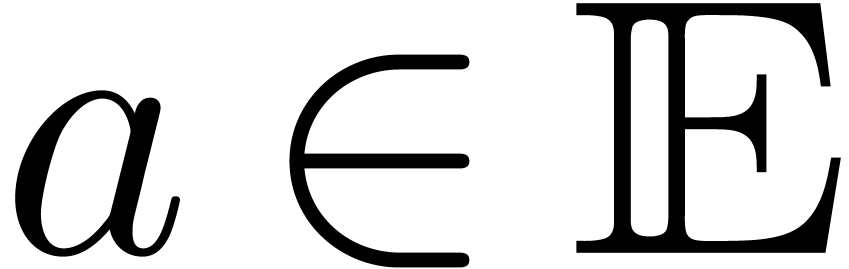

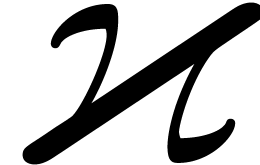

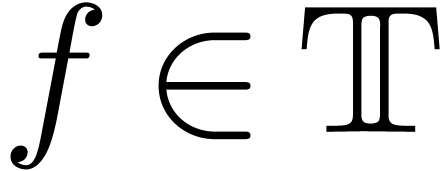

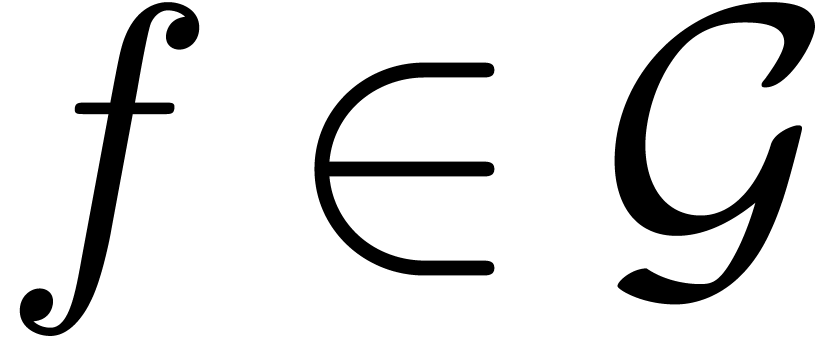

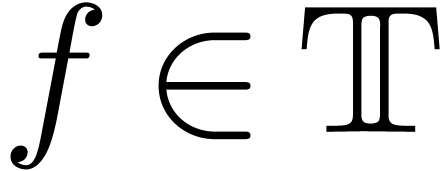

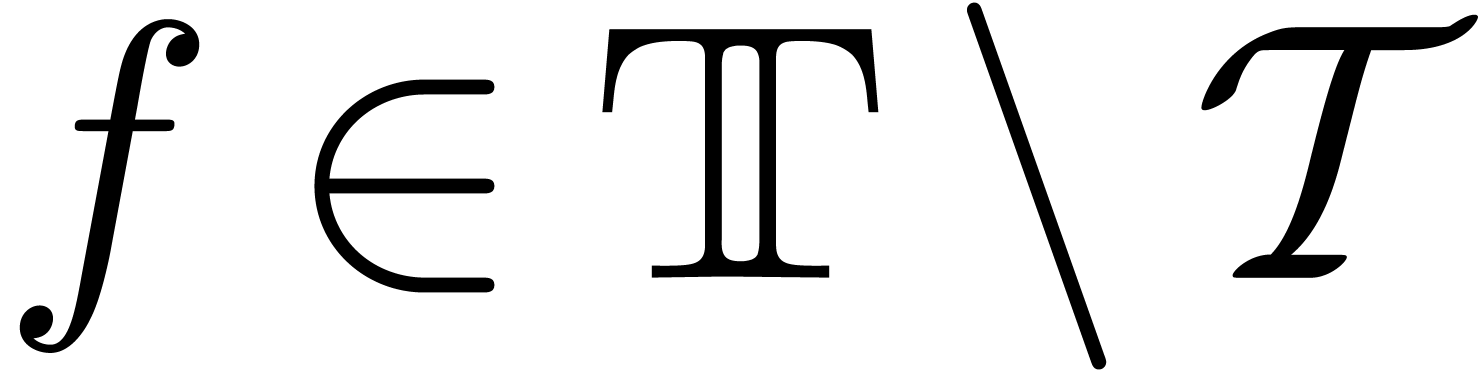

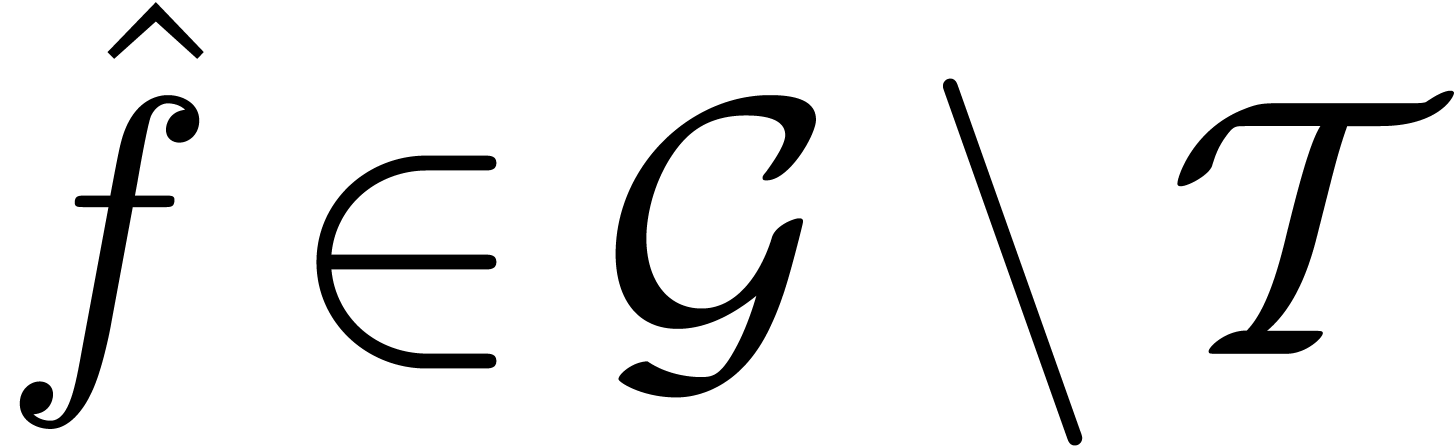

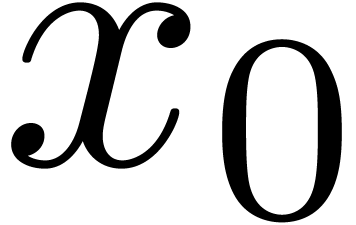

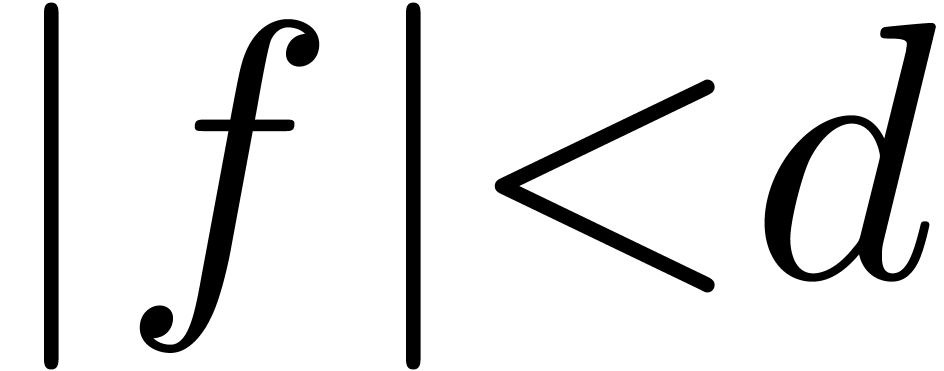

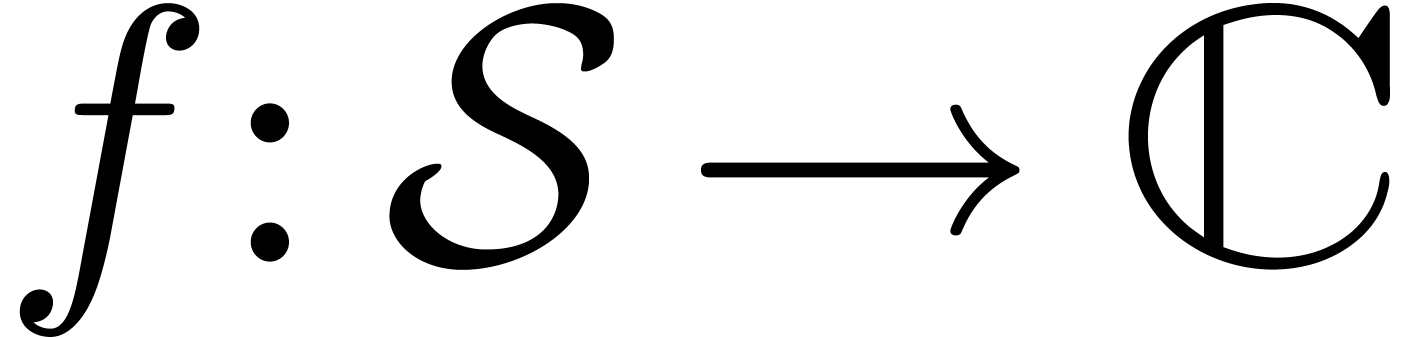

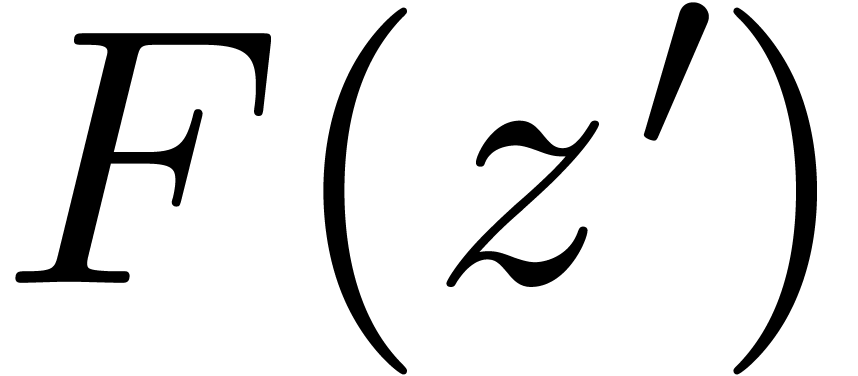

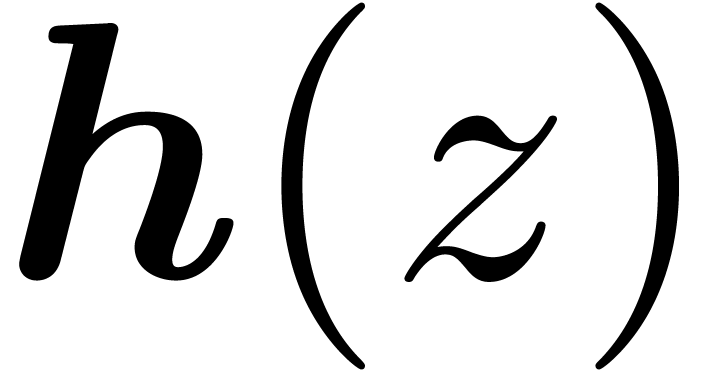

modélisation. Ici, une fonction

»

fournissent un cadre assez large et souple pour ce genre de

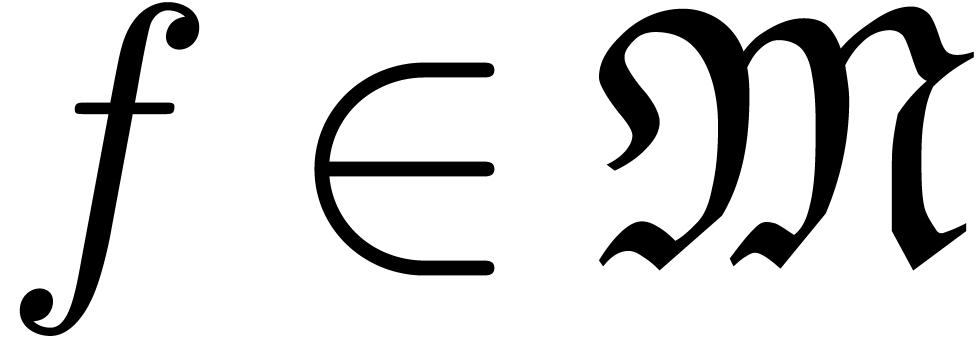

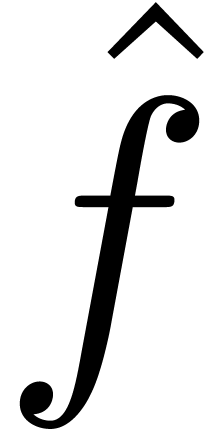

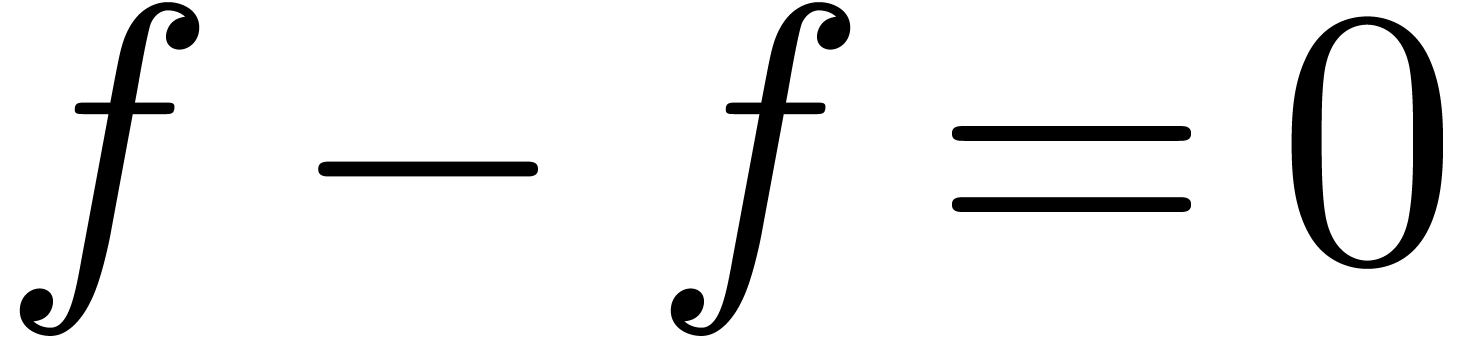

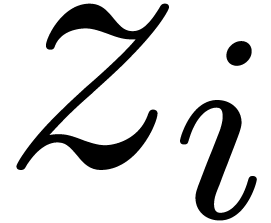

modélisation. Ici, une fonction  est

construite à partir de

est

construite à partir de  et une

indéterminée

et une

indéterminée  infiniment grande,

par les opérations de corps, l'exponentielle, le logarithme et

des fonctions algébriques.

infiniment grande,

par les opérations de corps, l'exponentielle, le logarithme et

des fonctions algébriques.

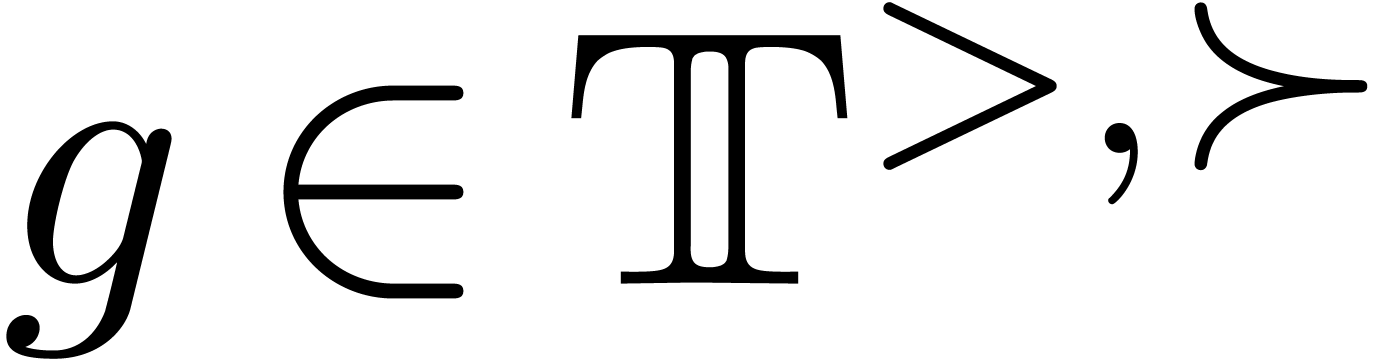

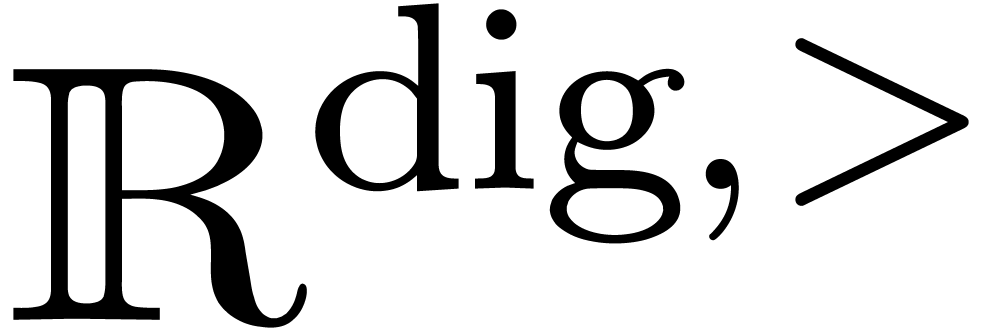

Le corps des fonctions  est totalement

ordonné, valué, et stable par dérivation.

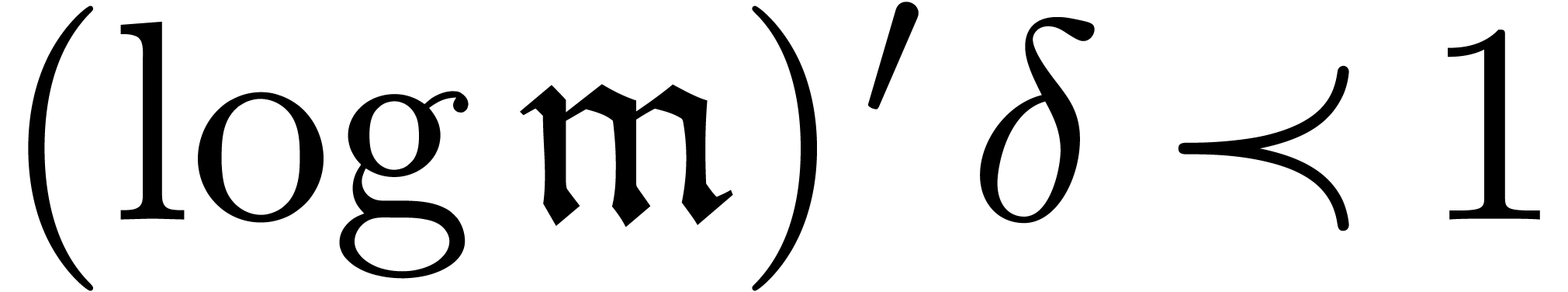

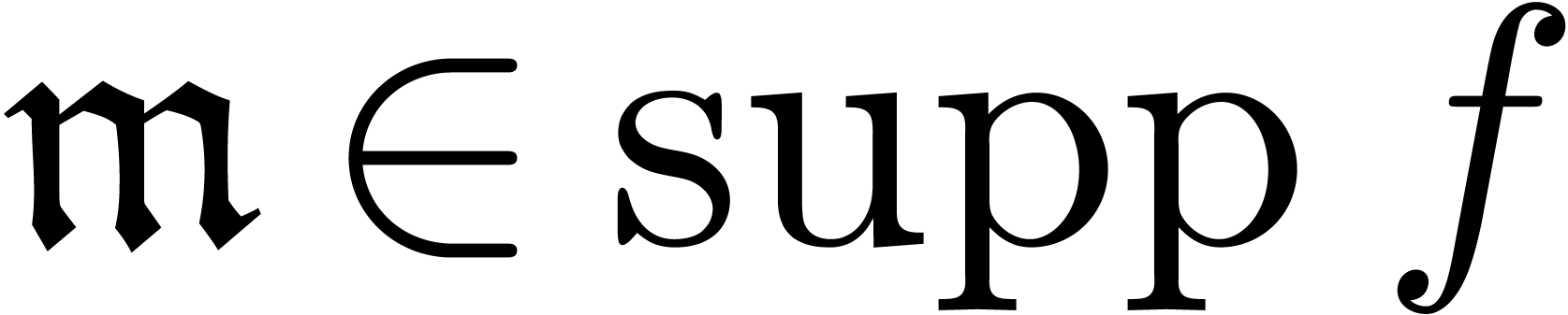

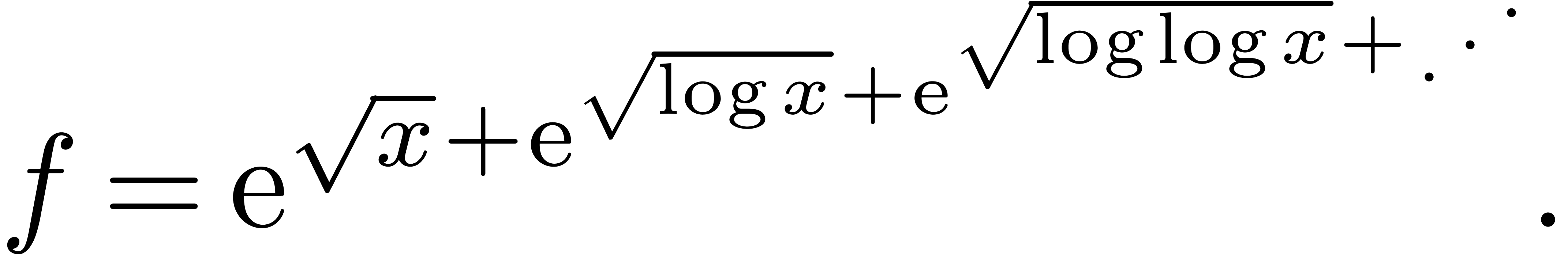

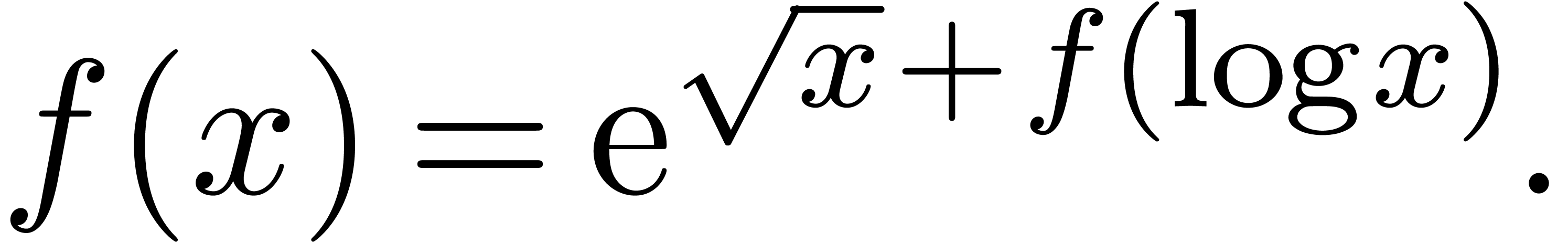

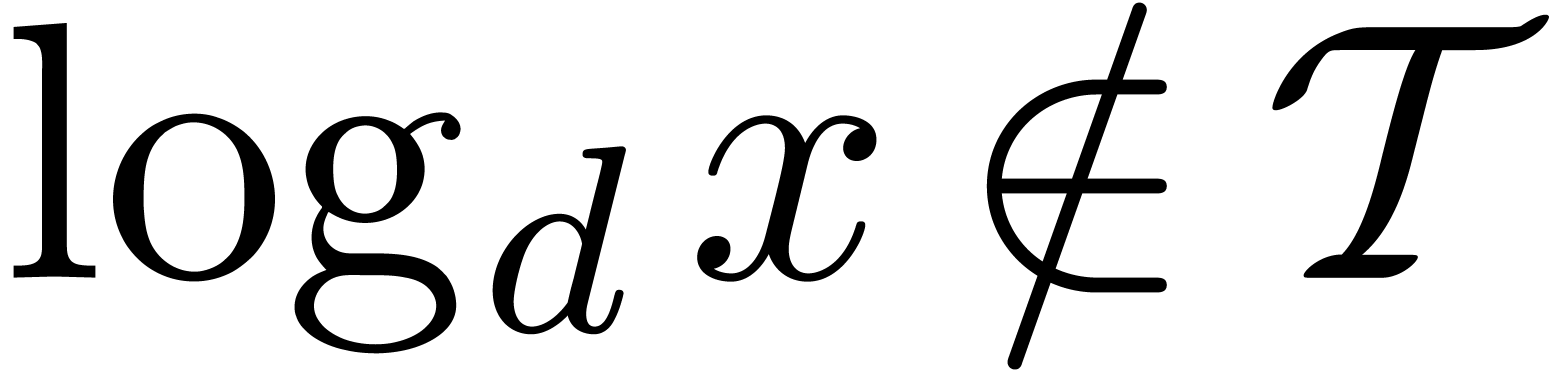

Toutefois, certaines fonctions « naturelles », comme

l'inverse fonctionnelle de

est totalement

ordonné, valué, et stable par dérivation.

Toutefois, certaines fonctions « naturelles », comme

l'inverse fonctionnelle de  ,

ne peuvent pas s'exprimer dans une échelle de fonctions

,

ne peuvent pas s'exprimer dans une échelle de fonctions  [96, Section 1.7.4]. Ce problème vient

essentiellement du fait que les fonctions

[96, Section 1.7.4]. Ce problème vient

essentiellement du fait que les fonctions  sont

données par des expressions finies : en autorisant des sommes

infinies dans la définition, on obtient le corps beaucoup plus

vaste et stable des transséries. En revanche, les

transséries sont de nature purement formelle et leur lien avec

l'analyse est un sujet en soi (voir le chapitre 3).

sont

données par des expressions finies : en autorisant des sommes

infinies dans la définition, on obtient le corps beaucoup plus

vaste et stable des transséries. En revanche, les

transséries sont de nature purement formelle et leur lien avec

l'analyse est un sujet en soi (voir le chapitre 3).

Les transséries sont apparues plus ou moins simultanément dans plusieurs domaines différents :

En théorie des modèles [26, 24, 62, 63, 60], du fait que le corps des transséries forme un modèle pour plusieurs théories intéressantes.

En analyse [37, 38], dans la démonstration de la conjecture de Dulac par Écalle, en raison de la non-oscillation des transséries.

En calcul formel [42, 43, 93, 96], où elles fournissent un bon cadre formel pour automatiser le calcul asymptotique.

En réalité, il existe plusieurs types de transséries, dépendant de leurs types de support. Dans ce chapitre, nous allons étudier le type le plus répandu des « transséries réticulées », qui interviennent dans la résolution d'équations différentielles. Notre exposé suit le livre [117] et l'article [100]. Une partie des résultats des sections 1.1 et 1.4 se trouvent aussi (sous une forme parfois différente) dans [46, 51, 37, 62, 63, 60].

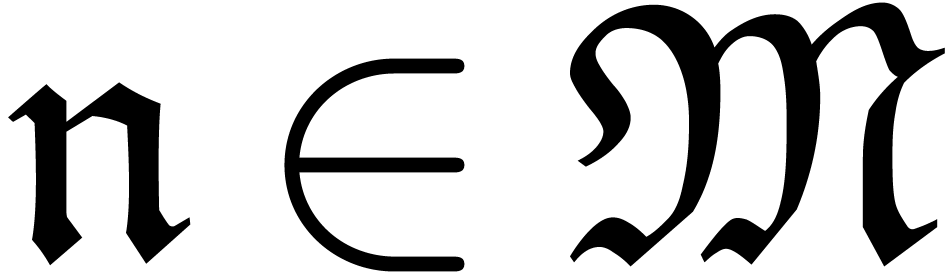

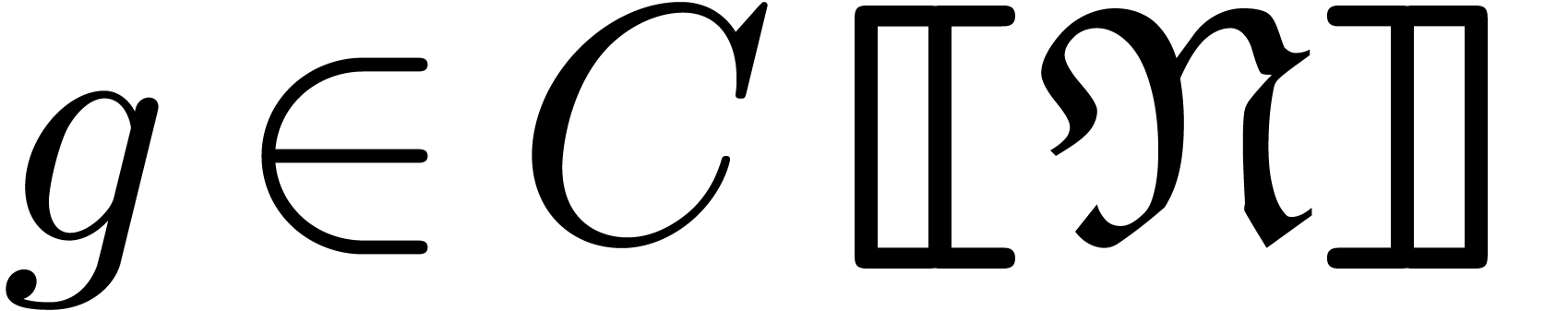

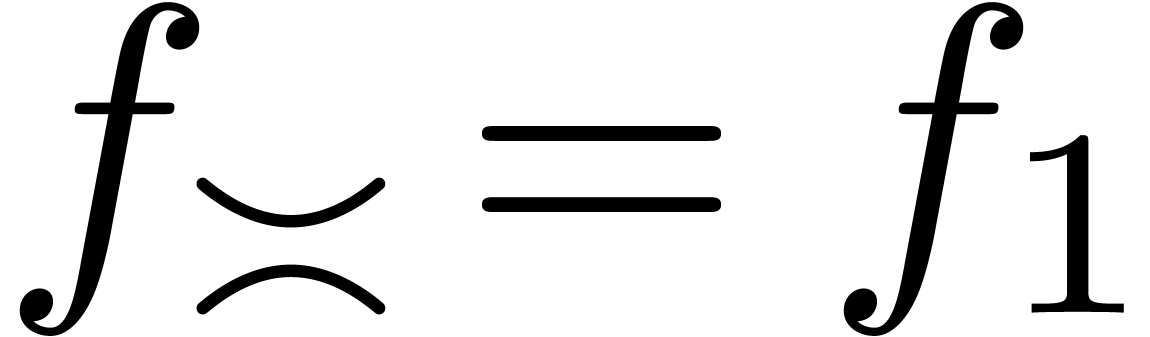

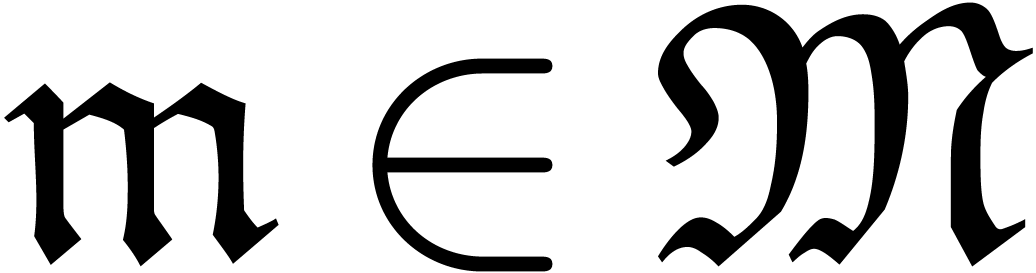

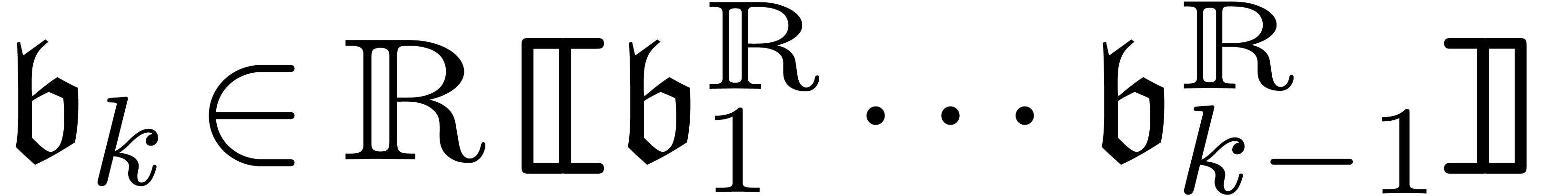

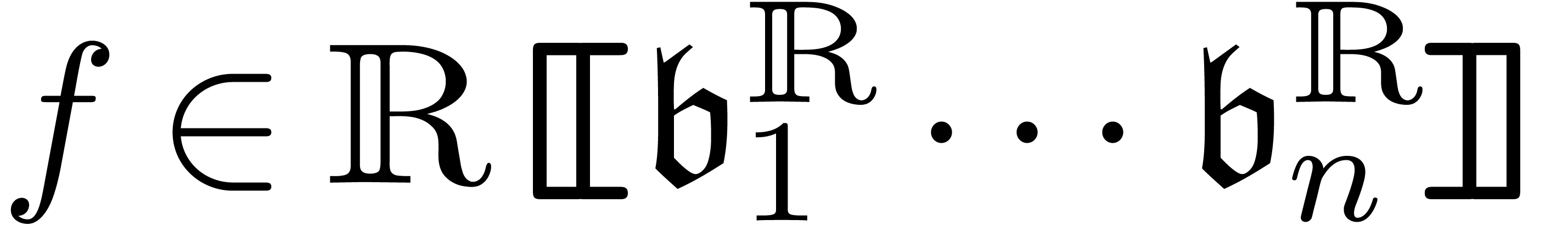

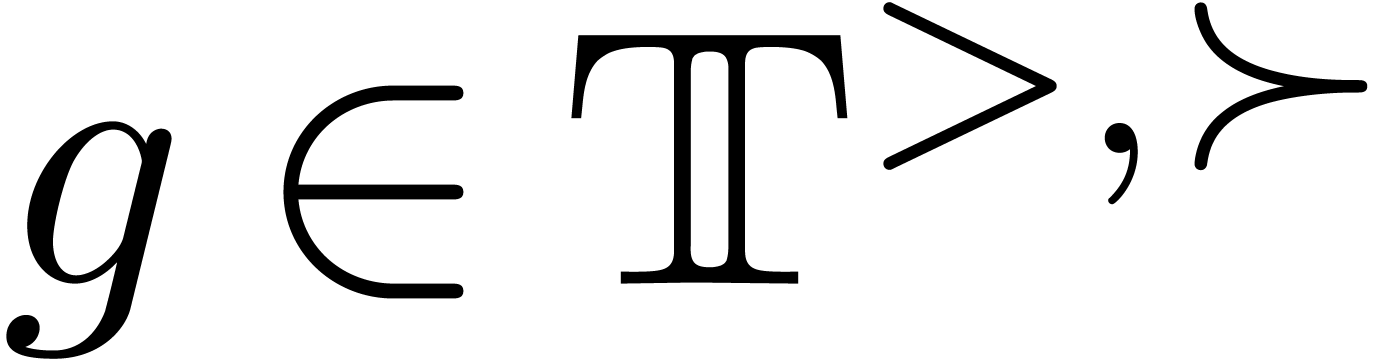

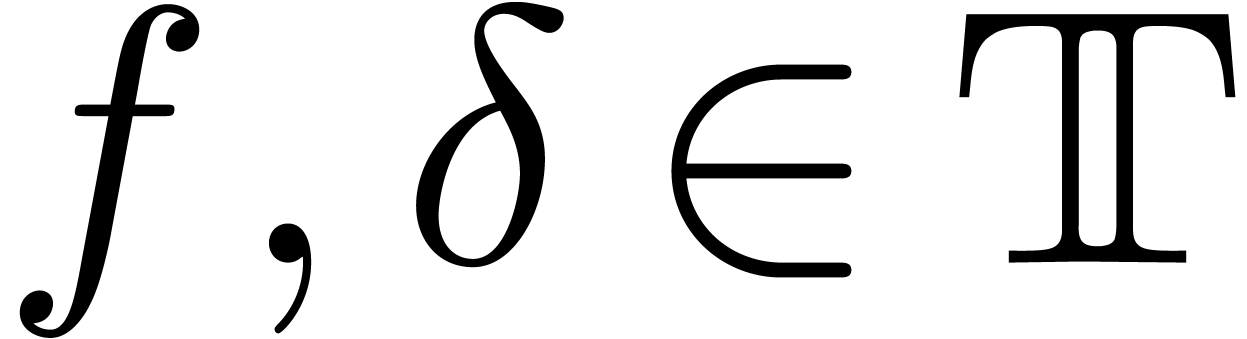

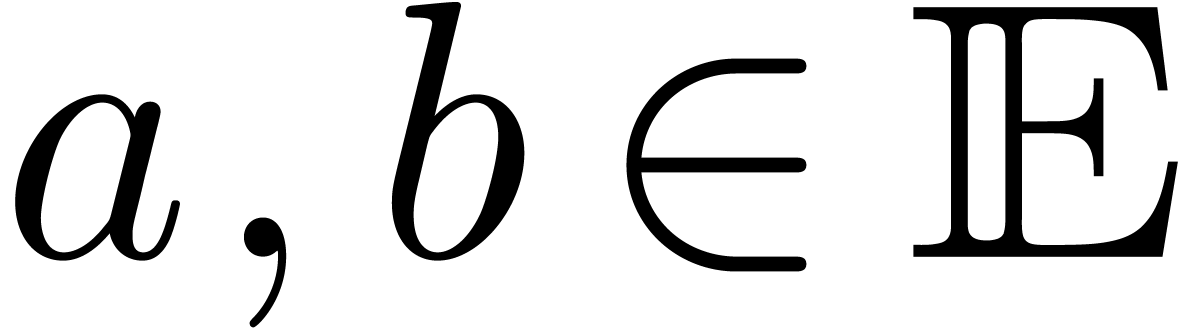

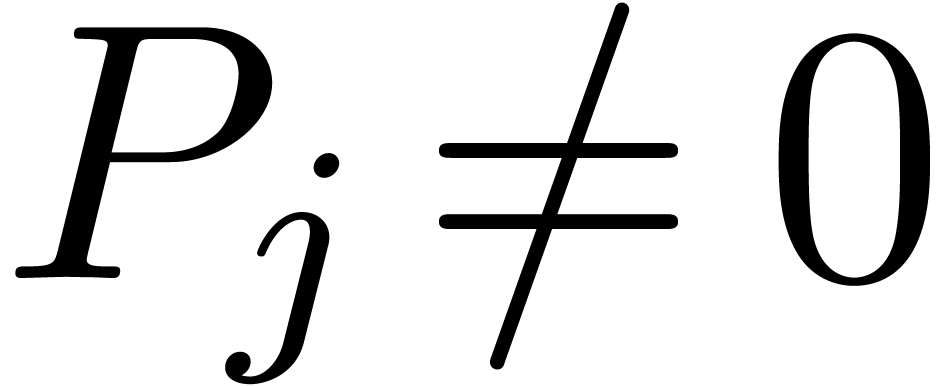

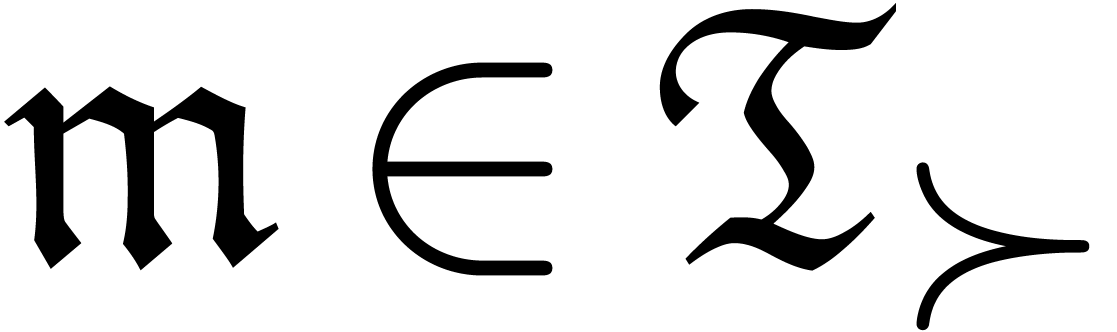

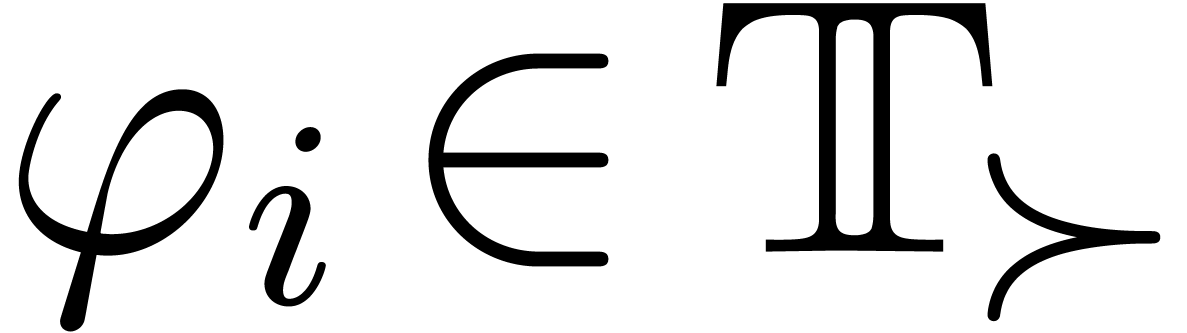

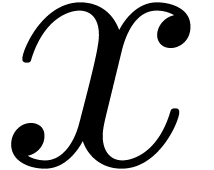

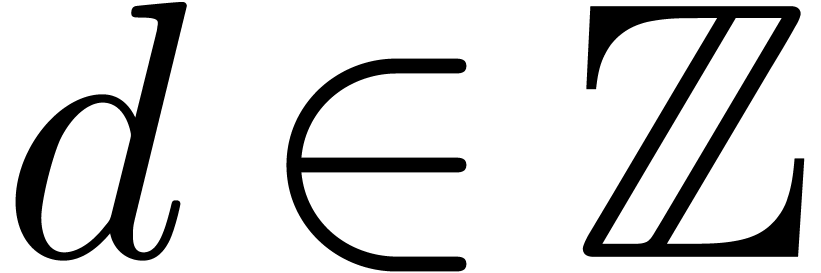

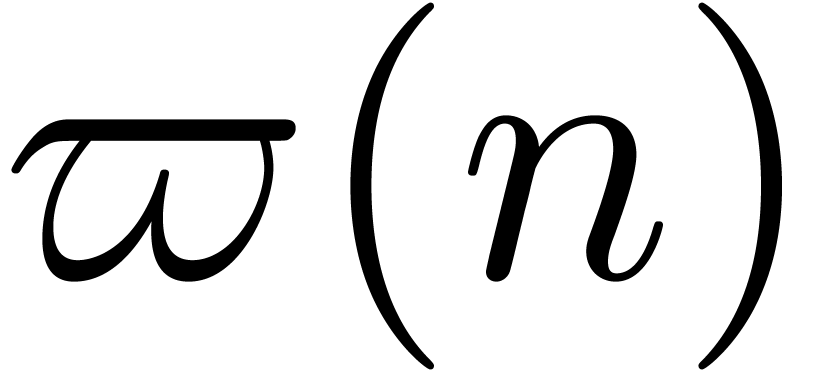

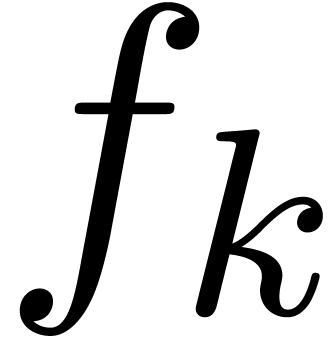

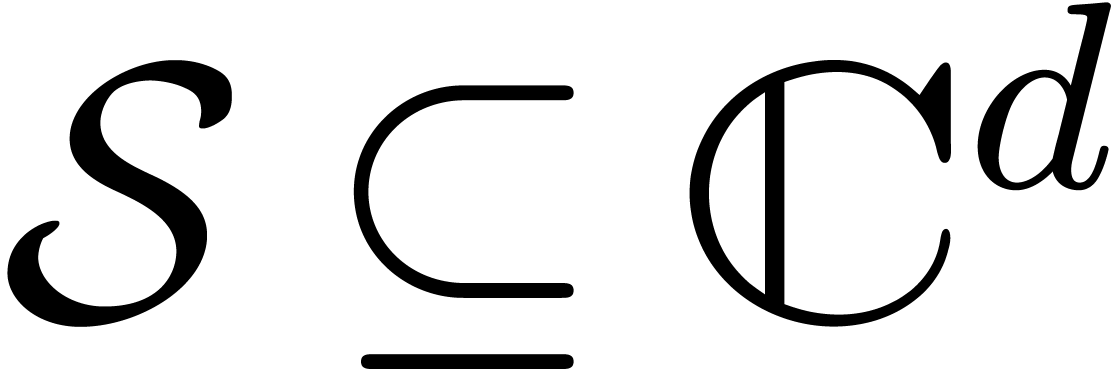

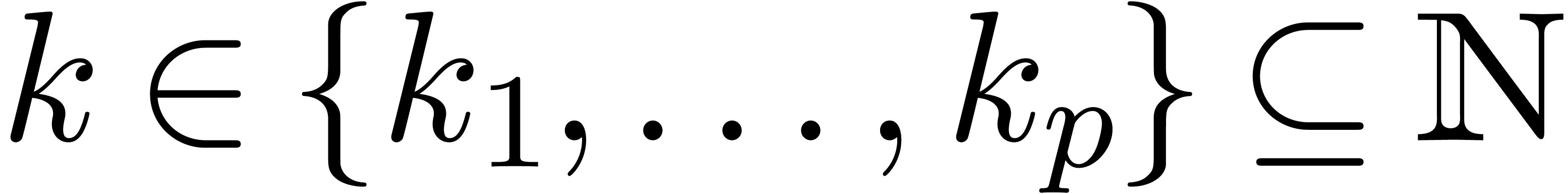

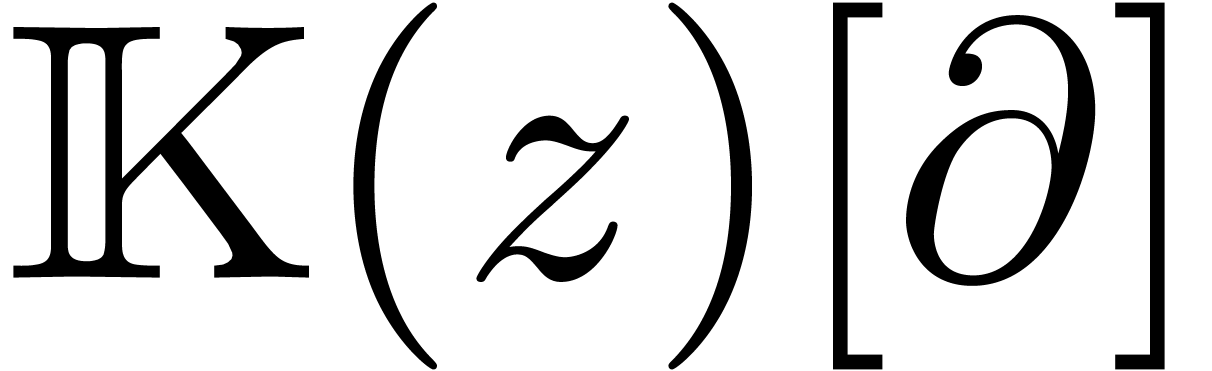

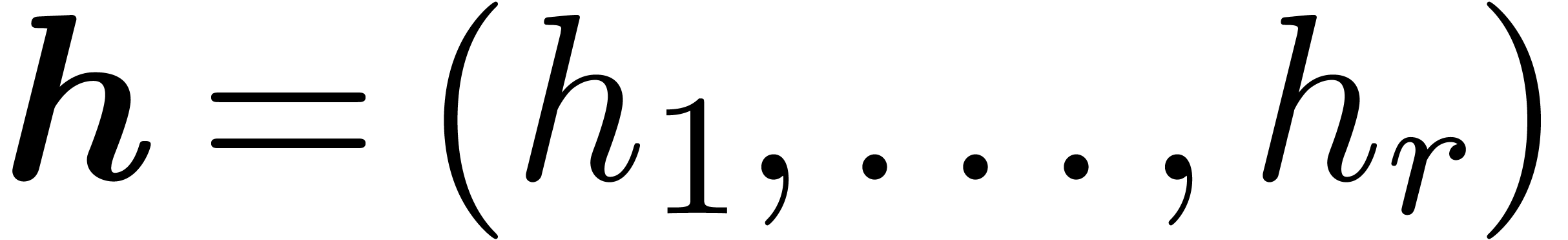

Soit  un anneau de coefficients et

un anneau de coefficients et  un groupe (ou monoïde) commutatif de monômes,

partiellement ordonné par une relation de dominance asymptotique

un groupe (ou monoïde) commutatif de monômes,

partiellement ordonné par une relation de dominance asymptotique

. Un sous-ensemble

. Un sous-ensemble  est réticulé, s'il existe des

ensemble finis

est réticulé, s'il existe des

ensemble finis  et

et  avec

avec

pour tout

pour tout  et

et  . Si l'ordre

. Si l'ordre  est total, on peut toujours prendre

est total, on peut toujours prendre  .

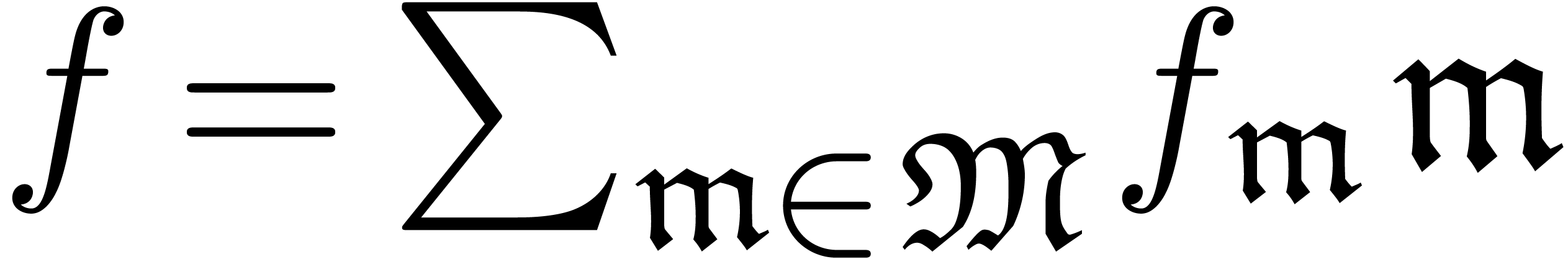

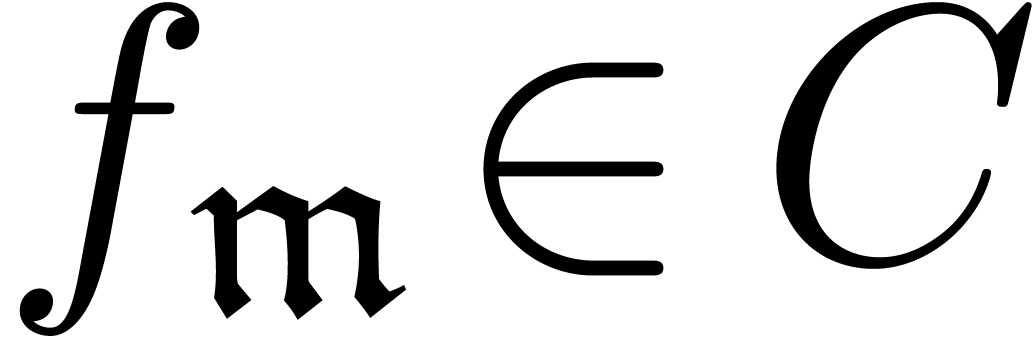

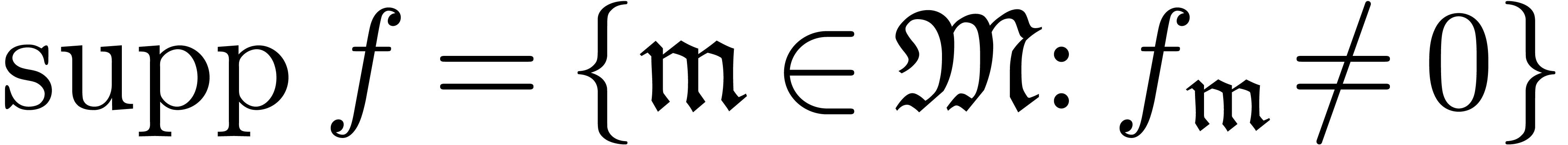

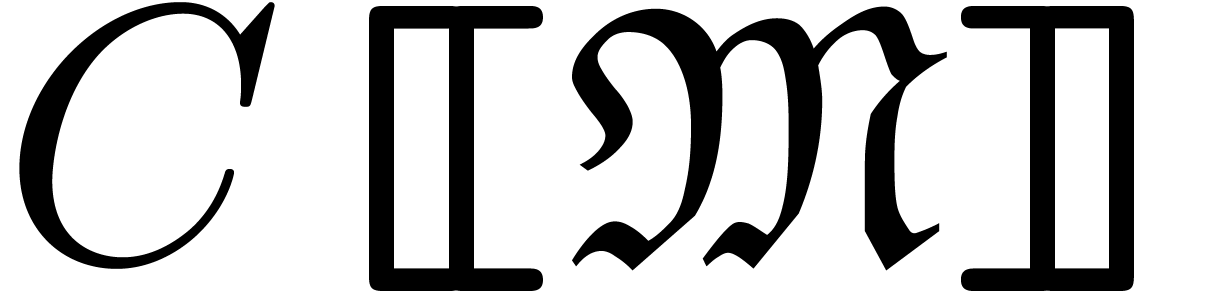

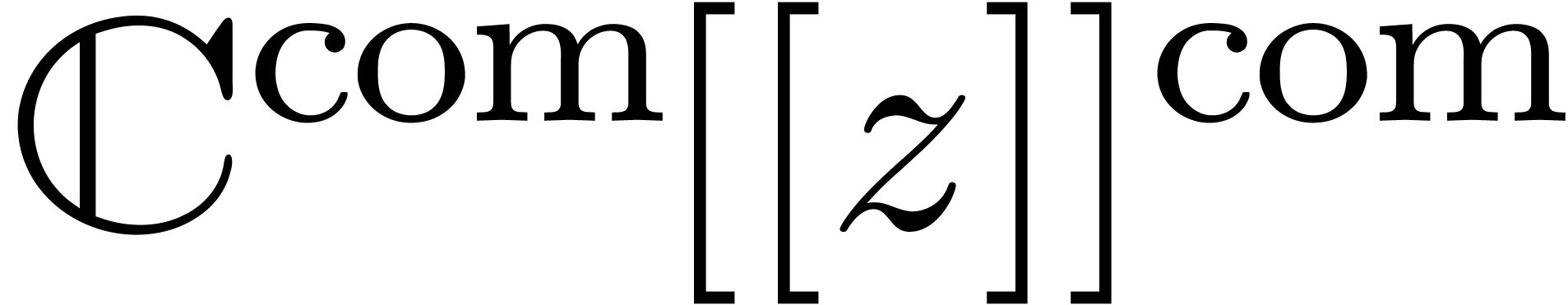

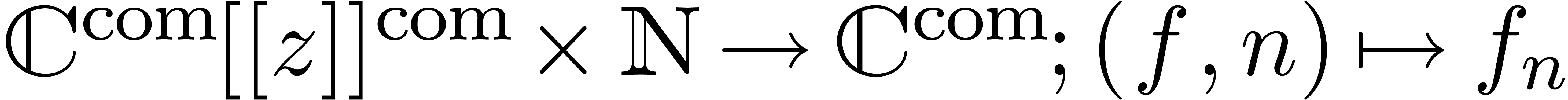

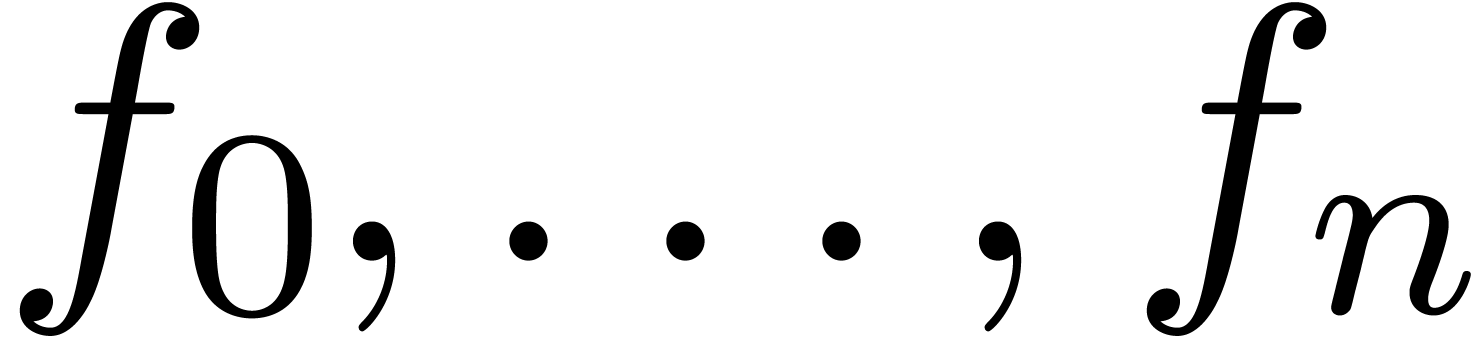

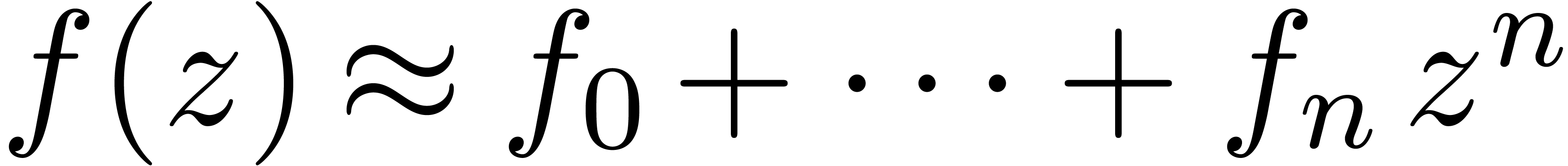

Une série réticulée est une somme formelle

.

Une série réticulée est une somme formelle

avec

avec  ,

dont le support

,

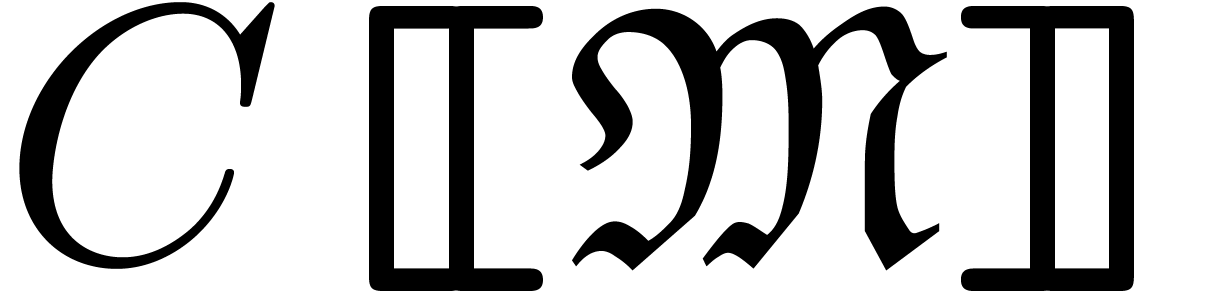

dont le support  est réticulé. On

désigne par

est réticulé. On

désigne par  l'ensemble des séries

réticulées à coefficients dans

l'ensemble des séries

réticulées à coefficients dans  et avec des monômes dans

et avec des monômes dans  .

.

est un anneau.

est un anneau.

Si  est un corps et

est un corps et  est total, alors

est total, alors  est un corps.

est un corps.

Exemple  est un infinitésimal formel, alors

est un infinitésimal formel, alors  ,

,

et

et  sont les anneaux de

séries formelles, de séries de Laurent et de séries

de Puiseux.

sont les anneaux de

séries formelles, de séries de Laurent et de séries

de Puiseux.

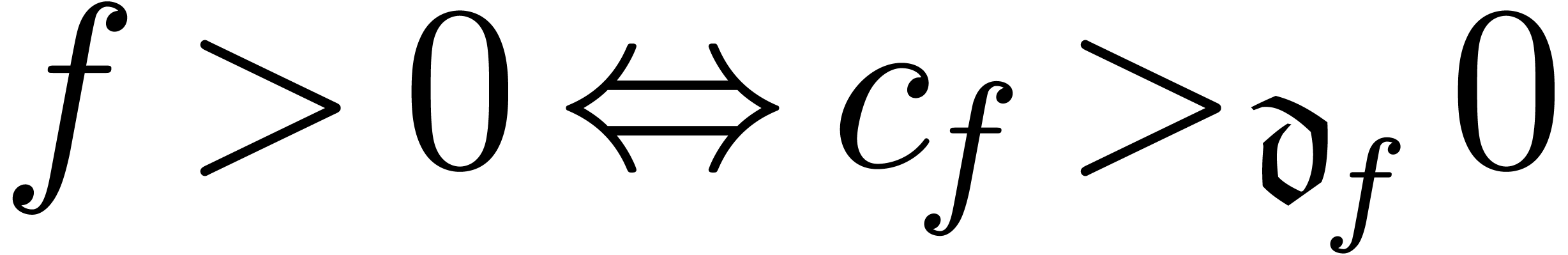

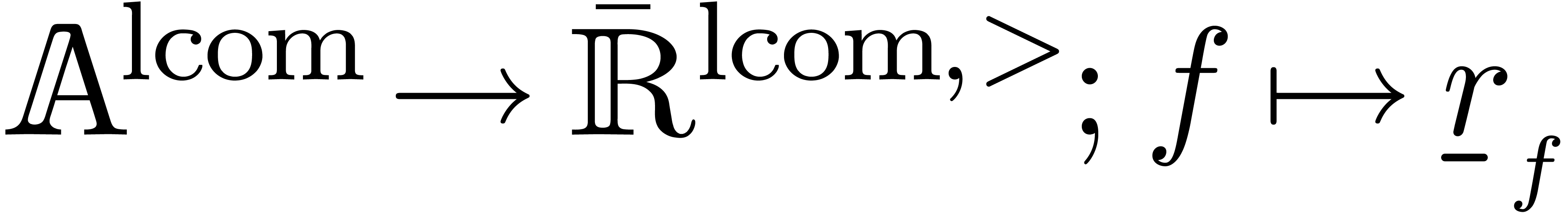

Si  est totalement ordonné, alors chaque

série

est totalement ordonné, alors chaque

série  non nulle admet un unique

monôme dominant

non nulle admet un unique

monôme dominant  et on

désigne par

et on

désigne par  le coefficient

dominant correspondant. Ceci permet d'étendre la relation

le coefficient

dominant correspondant. Ceci permet d'étendre la relation

à

à  tout entier par

tout entier par

. Si

. Si  est un anneau totalement ordonné, alors il en est de même

pour

est un anneau totalement ordonné, alors il en est de même

pour  en déclarant

en déclarant  .

.

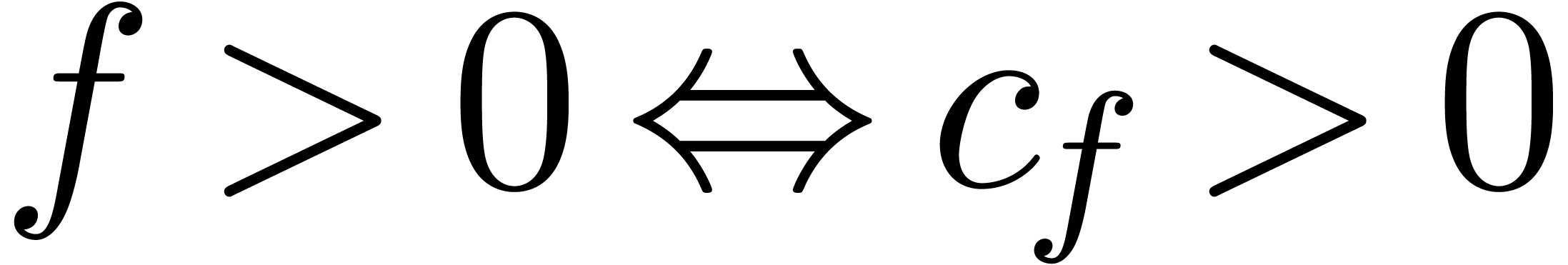

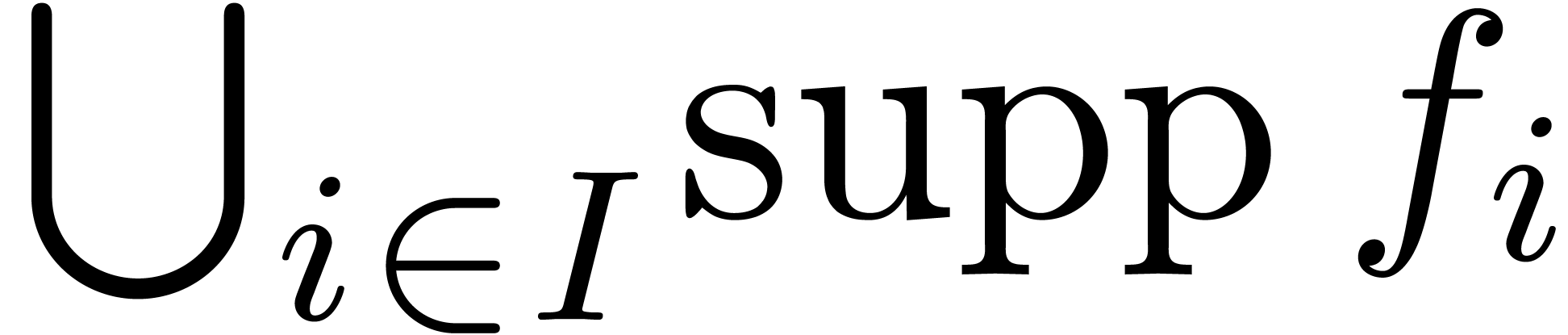

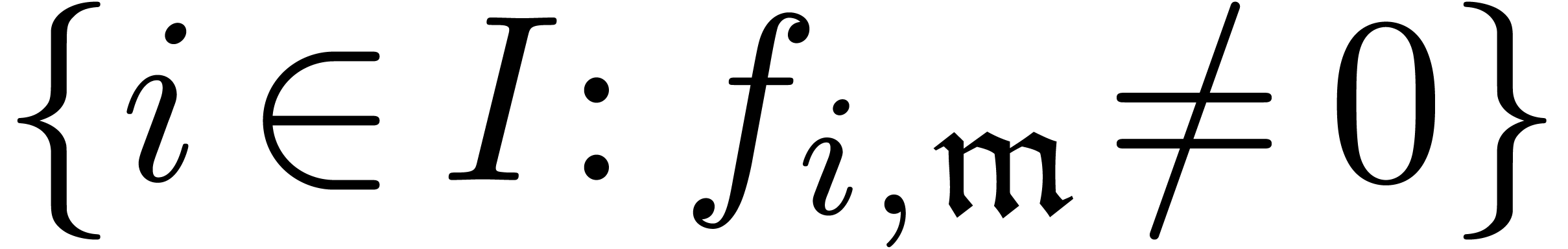

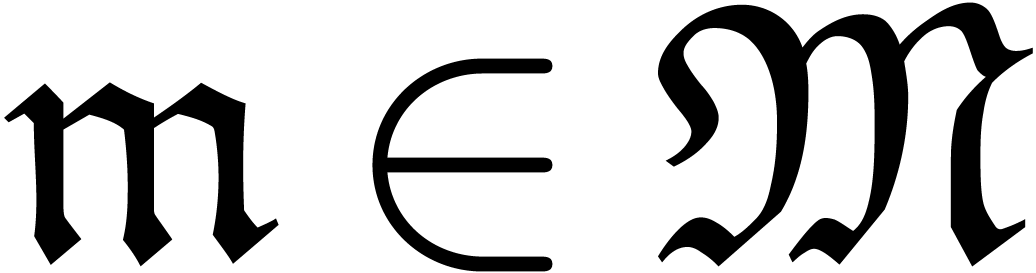

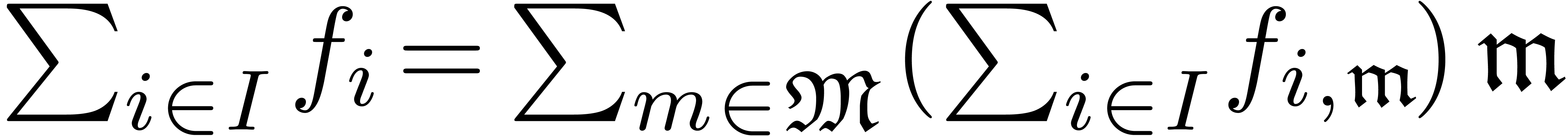

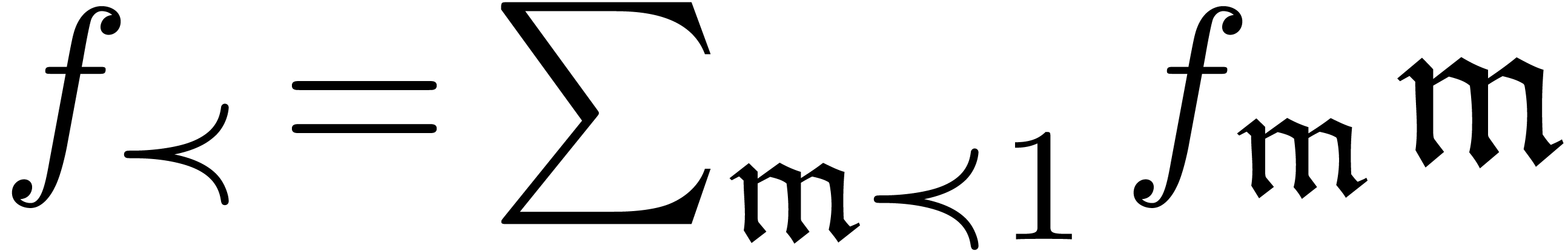

Les séries étant des sommes infinies, il est naturel de

chercher à définir une sommation infinie sur  . Une famille

. Une famille  est

réticulée lorsque

est

réticulée lorsque  est

réticulé et

est

réticulé et  est fini pour tout

est fini pour tout

. Dans ce cas, la somme

. Dans ce cas, la somme  est à nouveau une série

réticulée dans

est à nouveau une série

réticulée dans  .

.

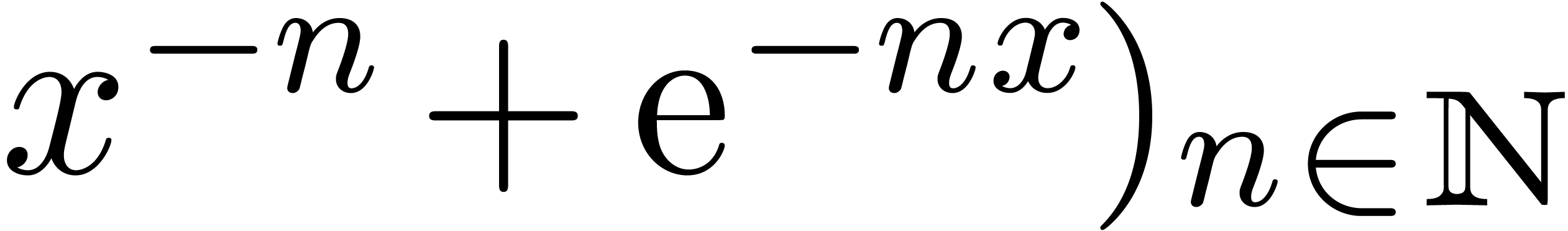

Il est à noter que la sommation forte n'est pas de

nature topologique. Par exemple, pour  ,

la famille (

,

la famille ( est réticulée, bien

qu'elle ne donne pas lieu à une suite de Cauchy dans

est réticulée, bien

qu'elle ne donne pas lieu à une suite de Cauchy dans  . En revanche, la sommation

réticulée vérifie plusieurs axiomes de l'«

algèbre forte » [117, Sections 2.4 et 2.5].

Cette théorie vise à généraliser

l'algèbre en remplaçant l'addition par une sommation

d'arité infinie. Dans la suite, on utilisera l'adjectif «

fort » chaque fois que l'addition doit être repensée

dans ce sens (linéarité forte, dérivation forte,

etc.).

. En revanche, la sommation

réticulée vérifie plusieurs axiomes de l'«

algèbre forte » [117, Sections 2.4 et 2.5].

Cette théorie vise à généraliser

l'algèbre en remplaçant l'addition par une sommation

d'arité infinie. Dans la suite, on utilisera l'adjectif «

fort » chaque fois que l'addition doit être repensée

dans ce sens (linéarité forte, dérivation forte,

etc.).

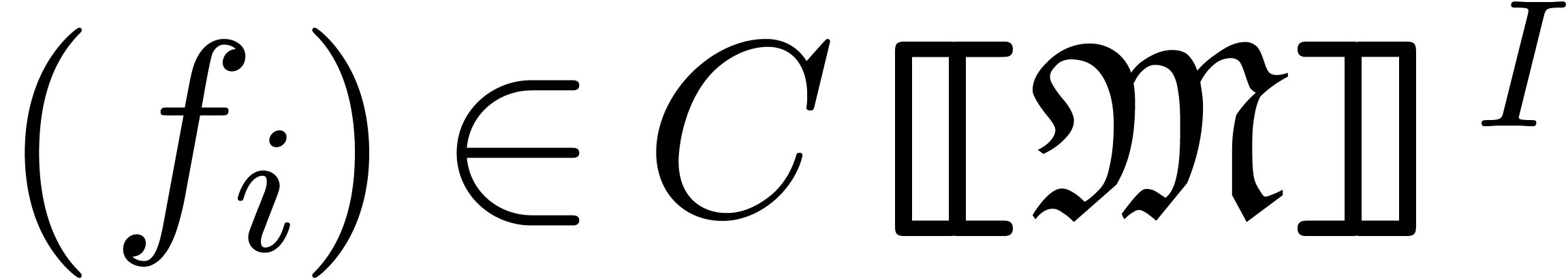

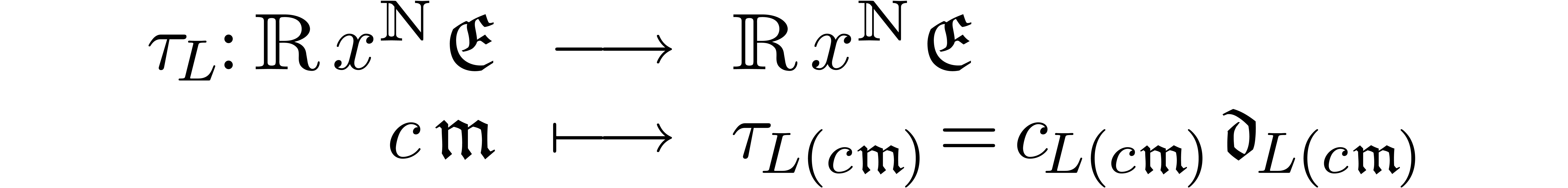

une application qui envoie tout ensemble

réticulé

une application qui envoie tout ensemble

réticulé  vers une famille

réticulée

vers une famille

réticulée  .

Alors

.

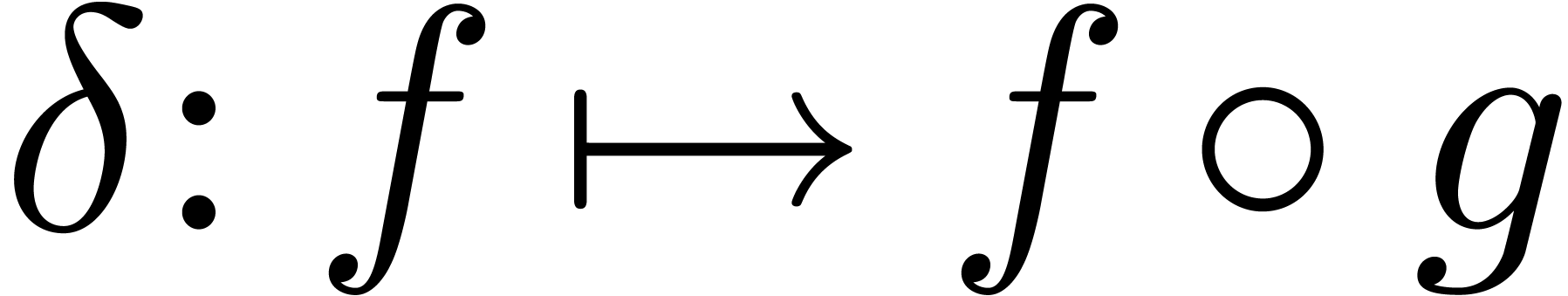

Alors  admet une unique extension

admet une unique extension  fortement linéaire.

fortement linéaire.

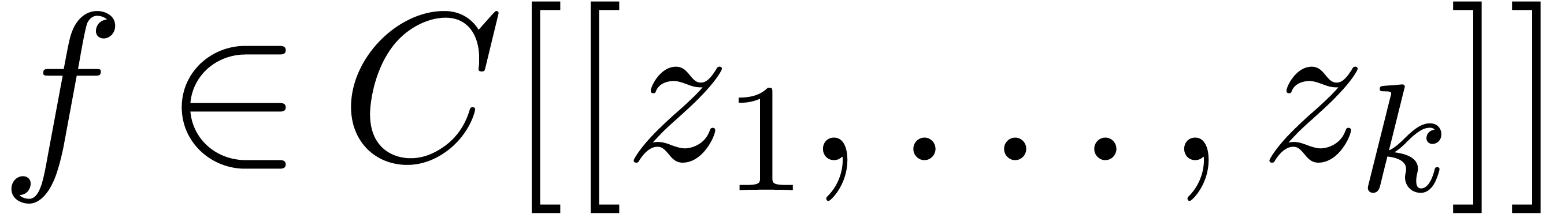

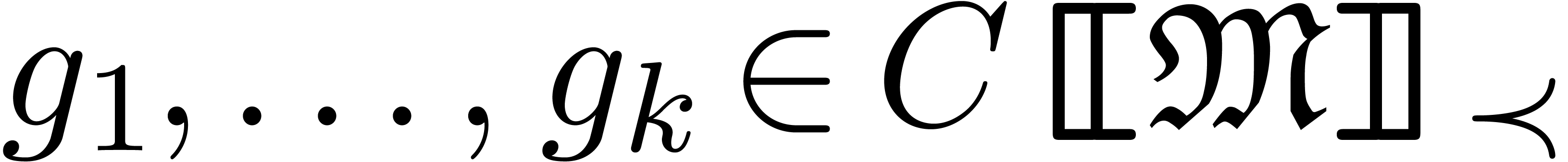

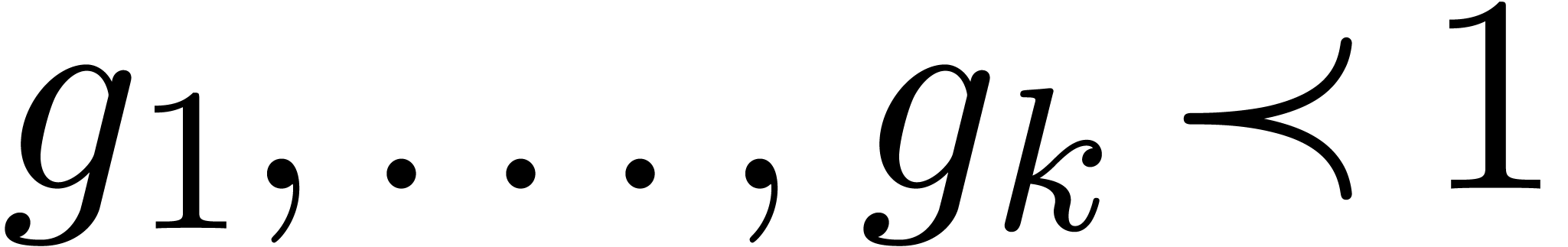

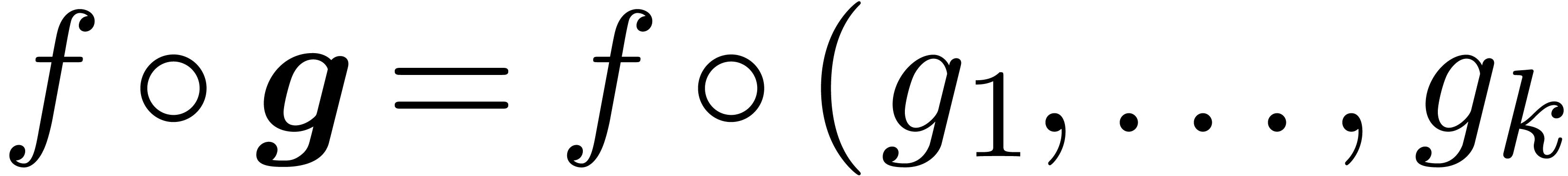

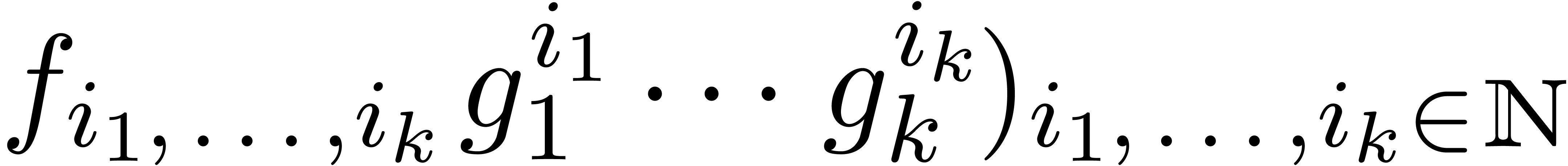

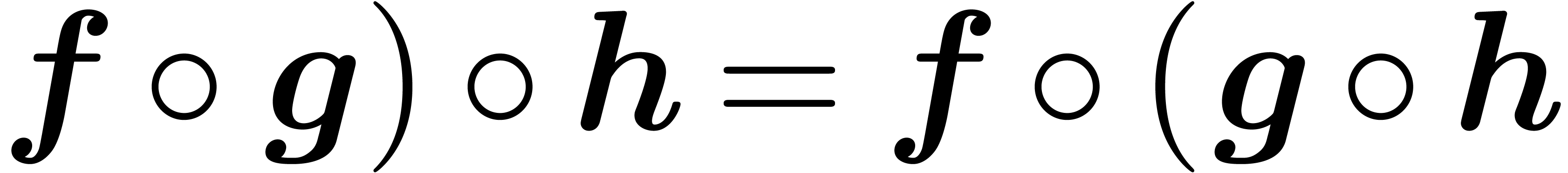

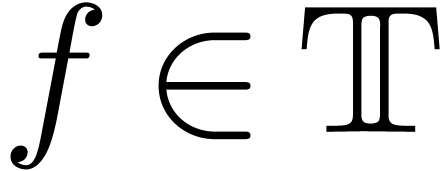

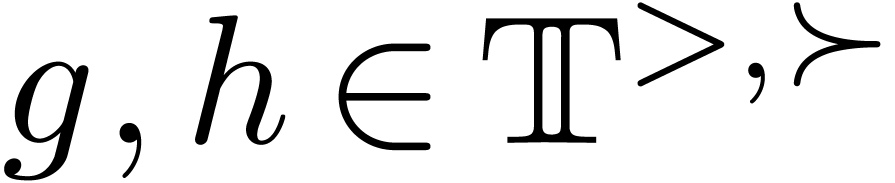

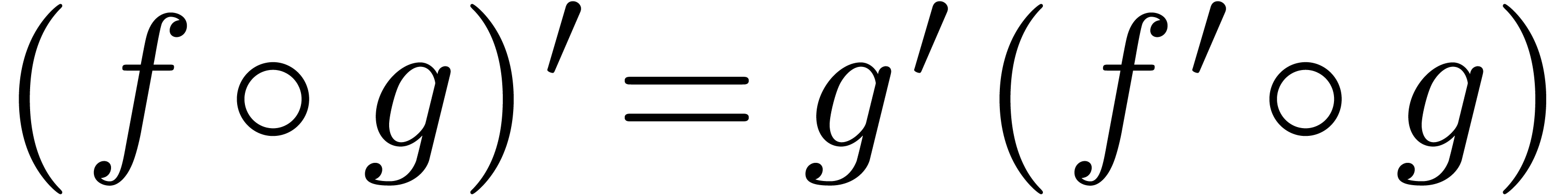

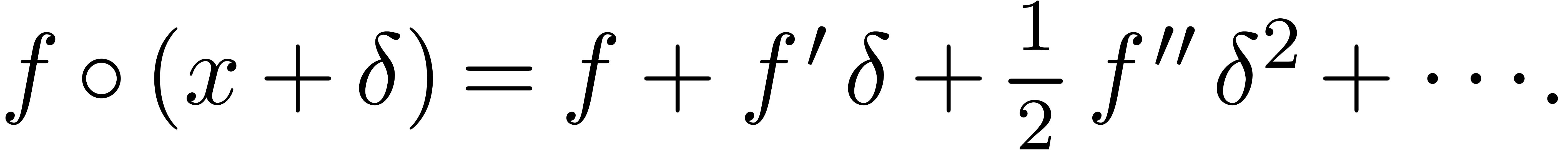

Exemple  et

et  (c.à.d.

(c.à.d.

). Alors la composition

). Alors la composition  ) peut se définir comme la

somme de la famille réticulée (

) peut se définir comme la

somme de la famille réticulée ( . Les propriétés habituelles comme

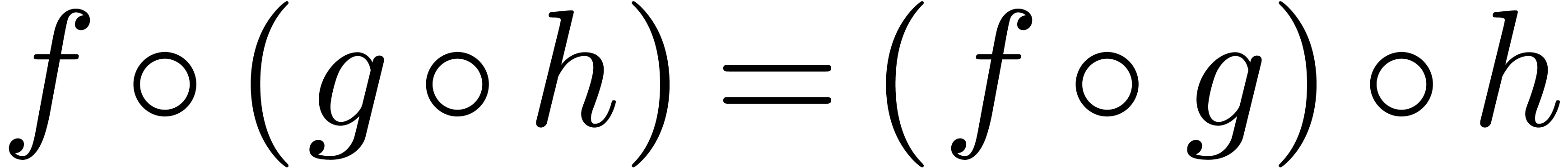

(

. Les propriétés habituelles comme

( ) suivent directement de la

proposition 1.3.

) suivent directement de la

proposition 1.3.

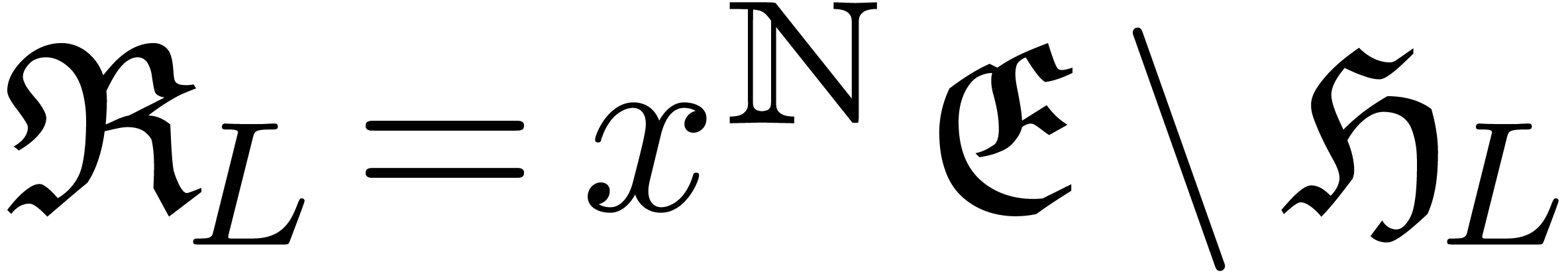

Remarque  est la classe des ensembles permis

pour les supports,

est la classe des ensembles permis

pour les supports,  doit être stable pour

l'union, le produit et l'opération

doit être stable pour

l'union, le produit et l'opération  pour

des parties infinitésimales : si

pour

des parties infinitésimales : si  et

et  , alors

, alors  .

.

Remarque  soit total. Alors chaque

série

soit total. Alors chaque

série  admet une représentation

admet une représentation

On appelle  une représentation

cartésienne de

une représentation

cartésienne de  .

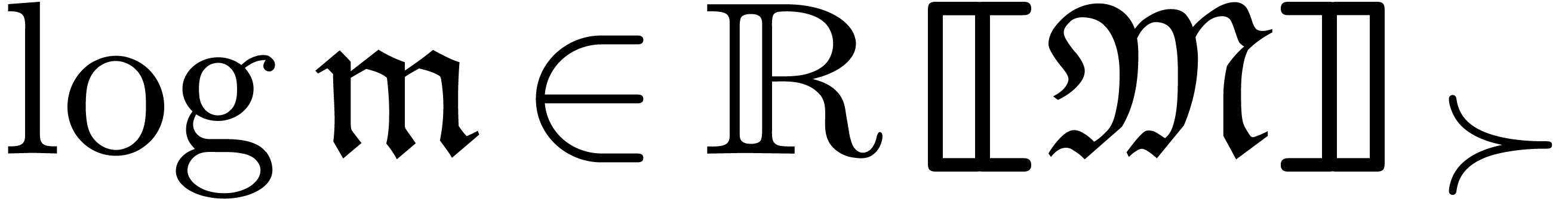

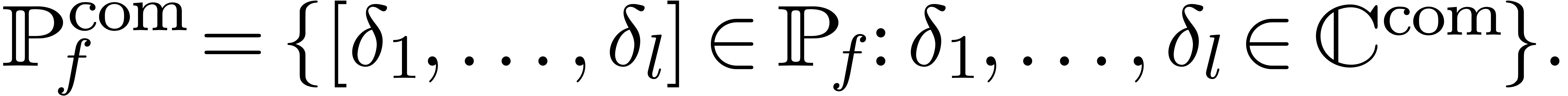

Chaque classe

.

Chaque classe  «

intéressante » de séries (comme les séries

convergentes, calculables, algébriques, etc.) induit

une classe correspondante

«

intéressante » de séries (comme les séries

convergentes, calculables, algébriques, etc.) induit

une classe correspondante  de séries

réticulées, en imposant la restriction

de séries

réticulées, en imposant la restriction  . Lorsque

. Lorsque  est en outre

une communauté locale, alors un grand nombre de

propriétés algébriques de

est en outre

une communauté locale, alors un grand nombre de

propriétés algébriques de  se transfèrent à

se transfèrent à  ; voir [117,

Section 3.5] pour quelques exemples, ainsi que [96].

; voir [117,

Section 3.5] pour quelques exemples, ainsi que [96].

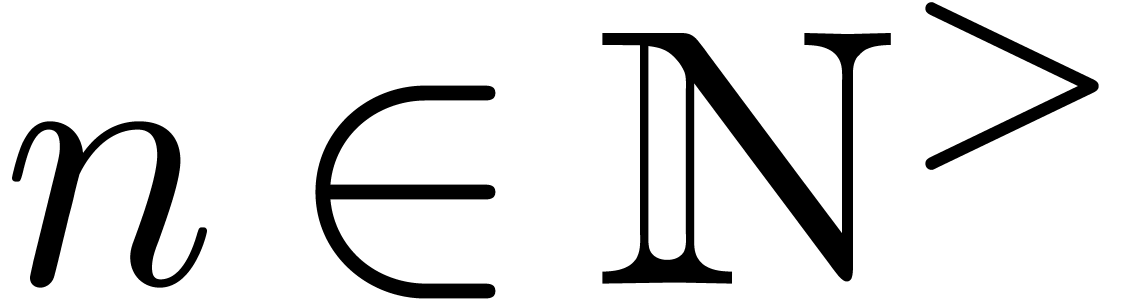

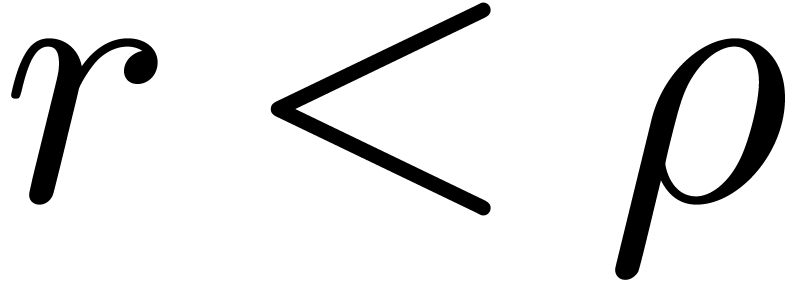

Supposons maintenant que  est un groupe

totalement ordonné et divisible, ce qui signifie que

chaque équation

est un groupe

totalement ordonné et divisible, ce qui signifie que

chaque équation  avec

avec  et

et  admet une solution

admet une solution  . En utilisant la méthode des polygones de

Newton, on montre que

. En utilisant la méthode des polygones de

Newton, on montre que  est algébriquement

clos (resp. réel clos), lorsque

est algébriquement

clos (resp. réel clos), lorsque  l'est. Dans [117, Chapitre 3] nous le faisons dans le cadre

légèrement plus général des

équations asymptotiques, qui permet d'exprimer la

méthode des polygones de Newton d'une façon

particulièrement élégante, et qui se

généralisera par la suite à d'autres types

d'équations.

l'est. Dans [117, Chapitre 3] nous le faisons dans le cadre

légèrement plus général des

équations asymptotiques, qui permet d'exprimer la

méthode des polygones de Newton d'une façon

particulièrement élégante, et qui se

généralisera par la suite à d'autres types

d'équations.

Plus précisément, soit  et

et  et considérons l'équation asymptotique

algébrique

et considérons l'équation asymptotique

algébrique

|

(1.1) |

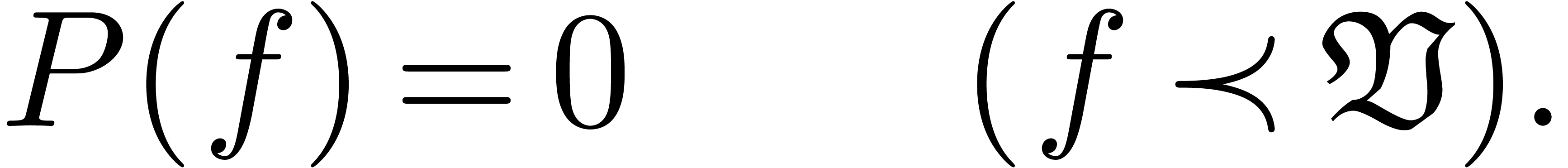

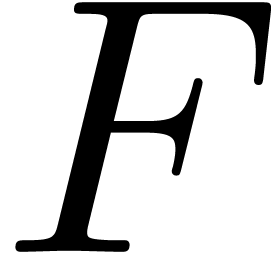

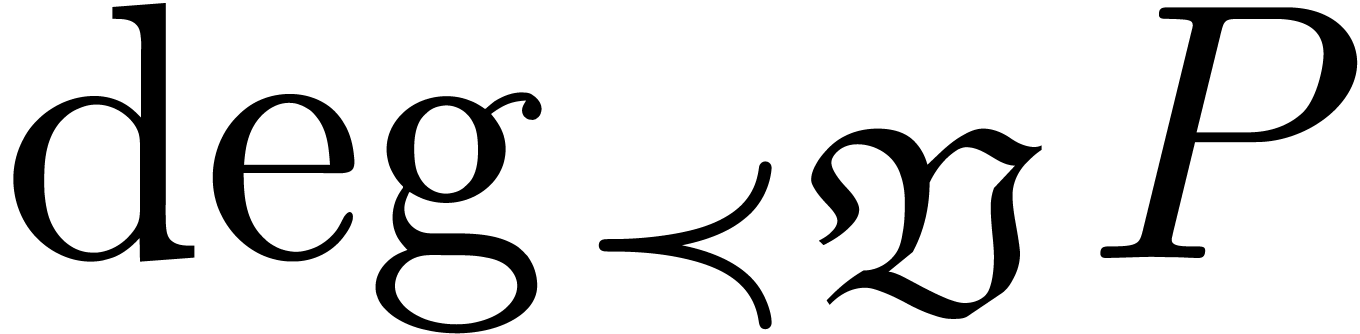

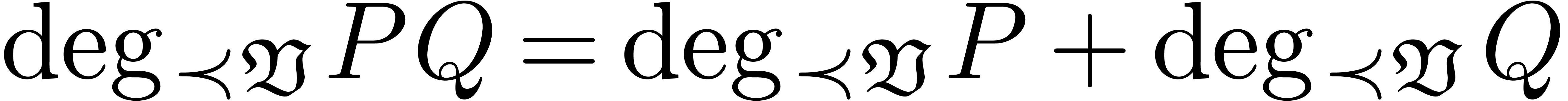

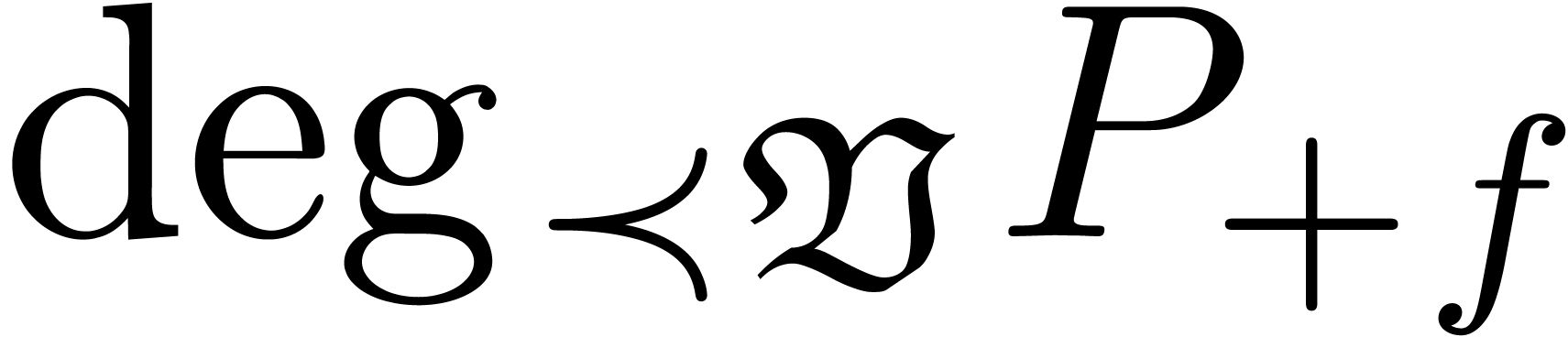

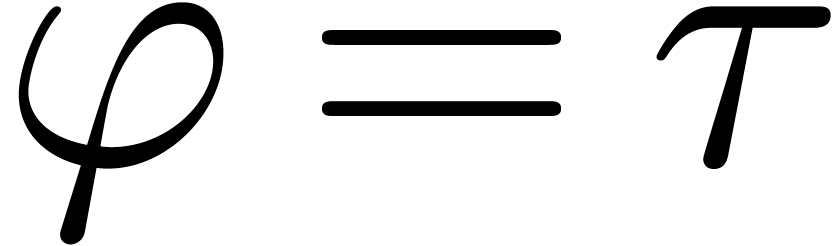

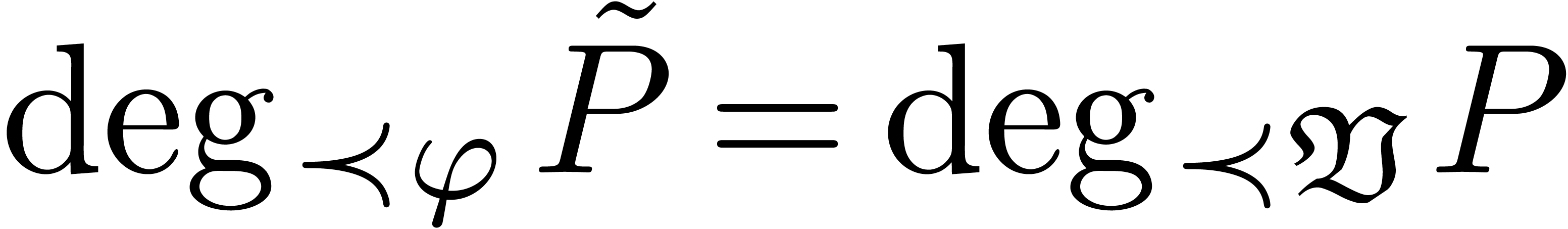

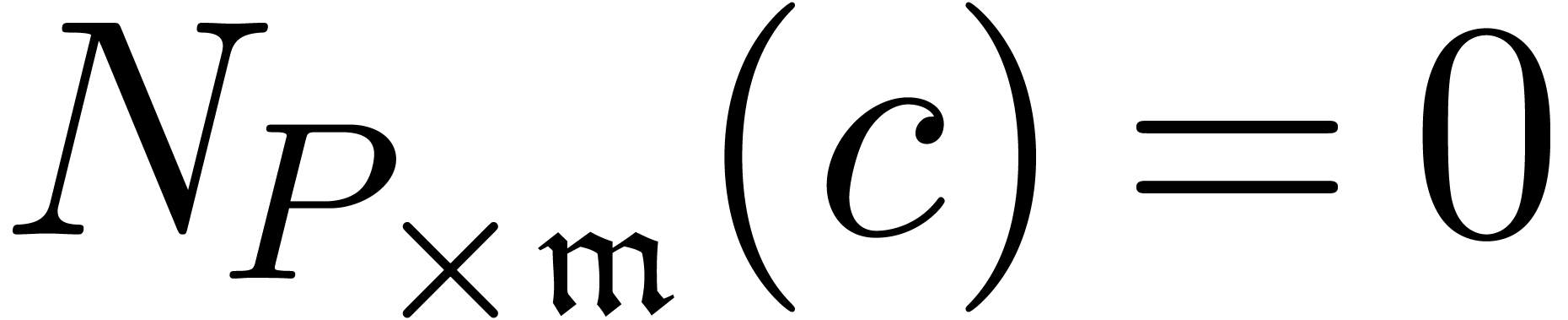

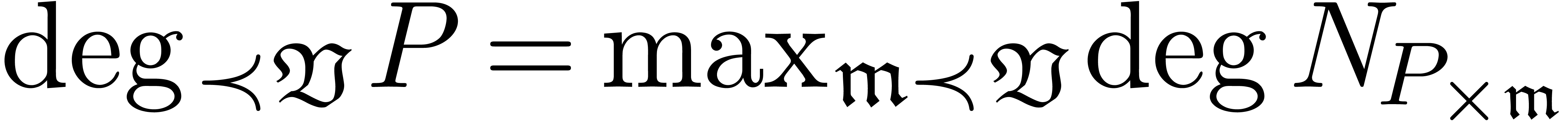

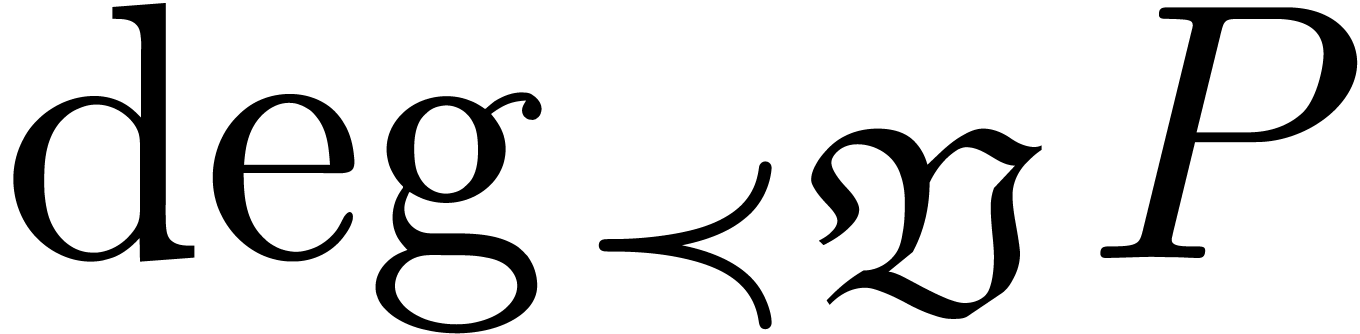

La plus grande puissance de  intervenant dans une

arête du polygone de Newton (et qui vérifie la contrainte

asymptotique) est appelée degré de Newton

intervenant dans une

arête du polygone de Newton (et qui vérifie la contrainte

asymptotique) est appelée degré de Newton  de (1.1). Ce degré se manipule de

façon analogue au degré d'un polynôme. Par exemple,

de (1.1). Ce degré se manipule de

façon analogue au degré d'un polynôme. Par exemple,

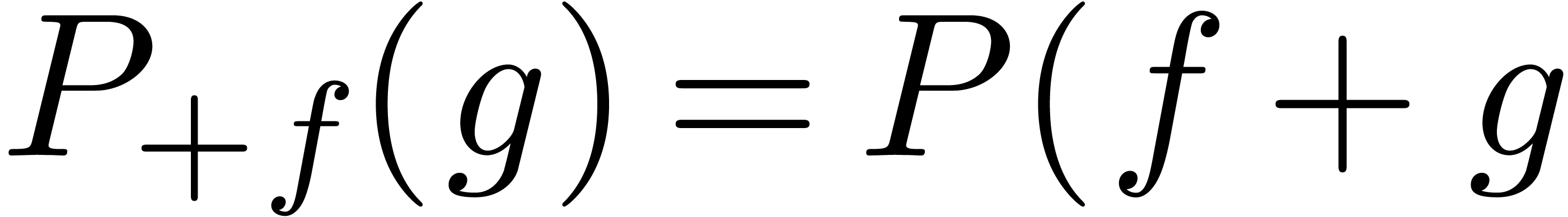

. De façon duale, on

peut aussi interpréter

. De façon duale, on

peut aussi interpréter  avec

avec  ) comme la multiplicité de

) comme la multiplicité de  comme solution à

comme solution à  modulo

modulo  ).

).

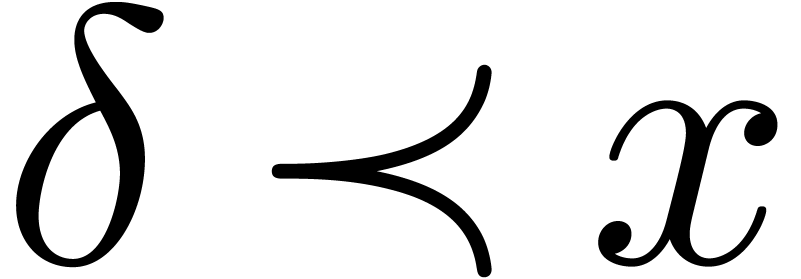

Le méthode de Newton consiste d'abord à déterminer

les termes dominants possibles pour une solution. On appelle terme

débuteur un tel terme  .

Ensuite, on applique un raffinement

.

Ensuite, on applique un raffinement

avec  , ce qui conduit

à une nouvelle équation asymptotique

, ce qui conduit

à une nouvelle équation asymptotique

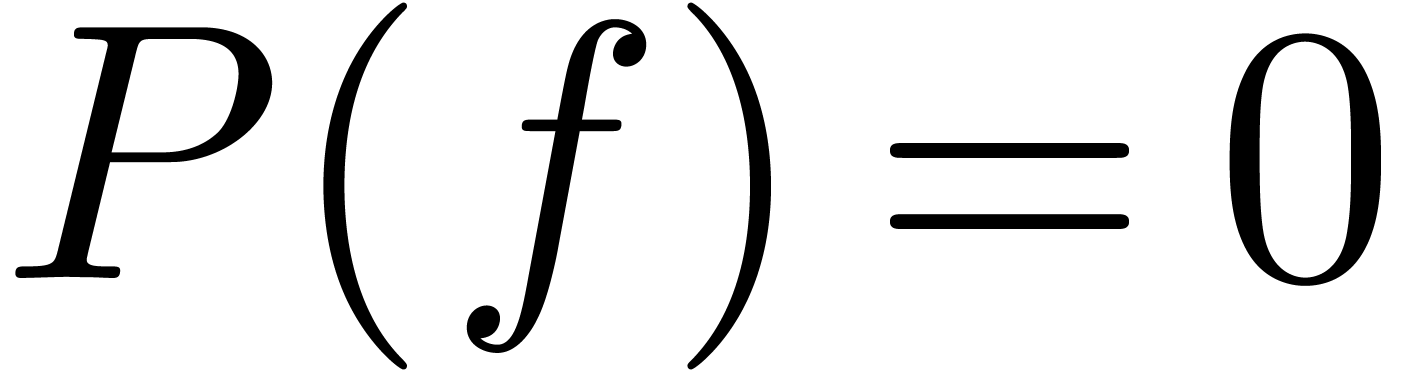

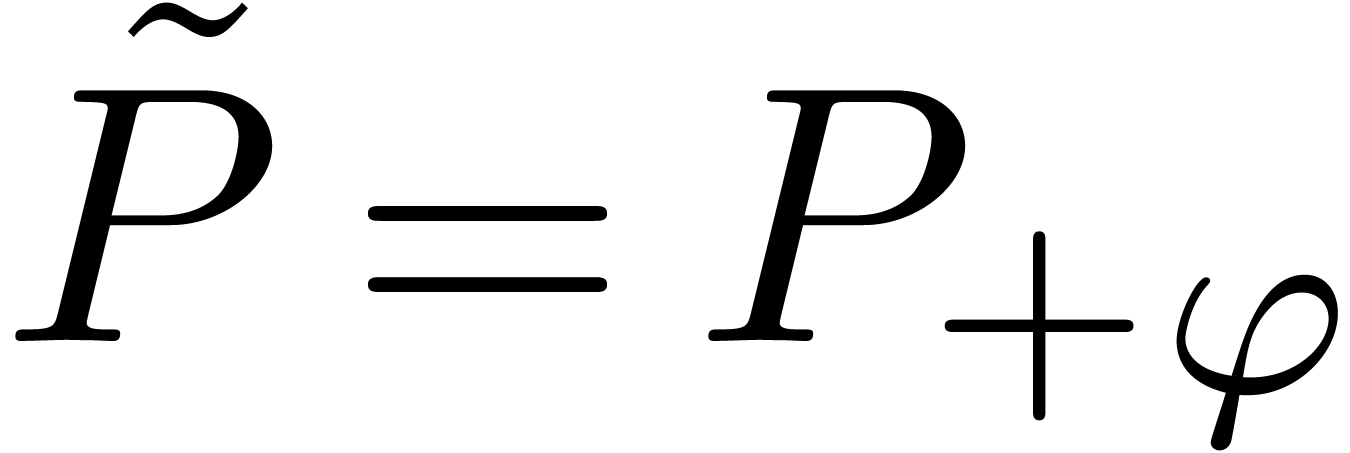

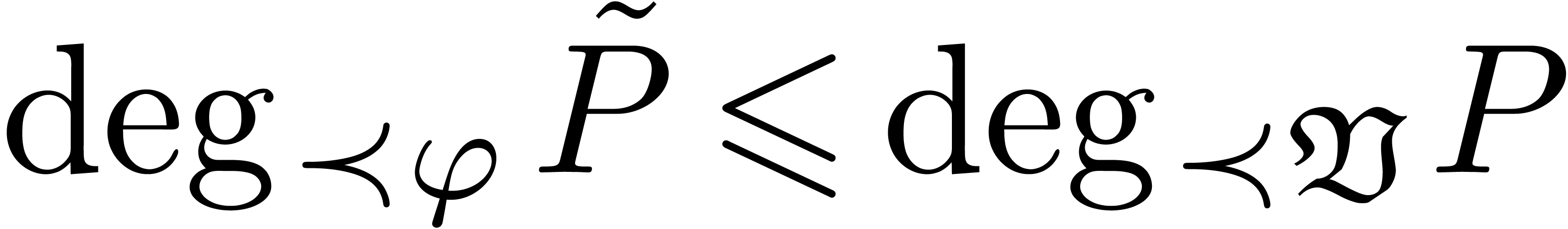

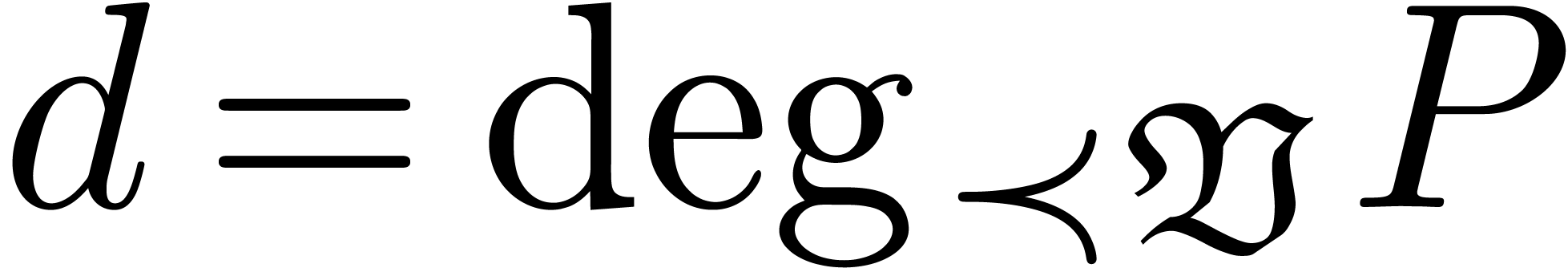

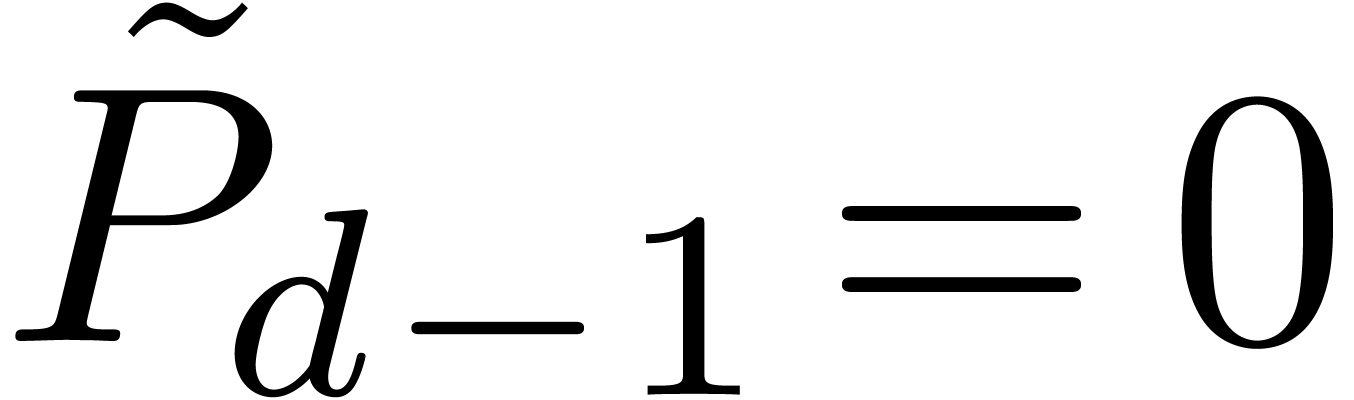

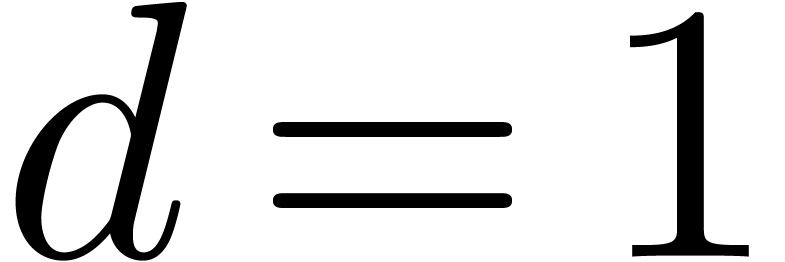

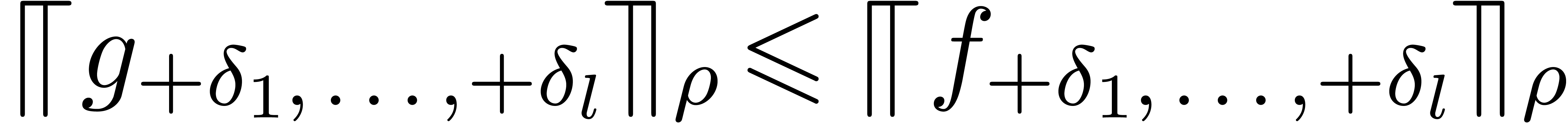

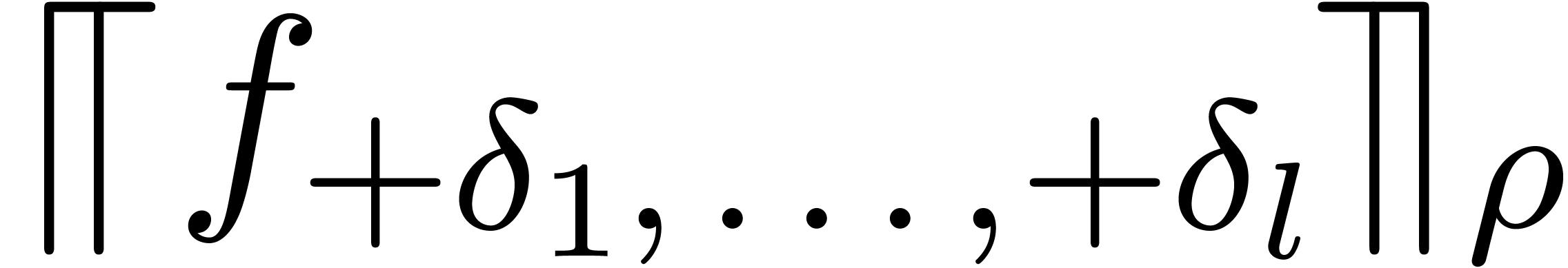

avec  . On montre que

. On montre que  avec égalité si et seulement si

avec égalité si et seulement si  est un terme débuteur de multiplicité

est un terme débuteur de multiplicité

, ce qui arrive notamment

lorsque (1.1) admet une solution de multiplicité

, ce qui arrive notamment

lorsque (1.1) admet une solution de multiplicité

. Dans ce cas, on

résout plutôt l'équation

. Dans ce cas, on

résout plutôt l'équation

qui est quasi-linéaire (c.à.d.  ) et on prend

) et on prend  au lieu de

au lieu de  . Bien que l'on

aura toujours

. Bien que l'on

aura toujours  , le

degré de Newton ne peut que décroître strictement

à l'étape suivante, puisque

, le

degré de Newton ne peut que décroître strictement

à l'étape suivante, puisque  .

Après un nombre fini d'étapes, on se ramène ainsi

au cas

.

Après un nombre fini d'étapes, on se ramène ainsi

au cas  , qui se traite avec

un théorème adapté de fonctions implicites.

, qui se traite avec

un théorème adapté de fonctions implicites.

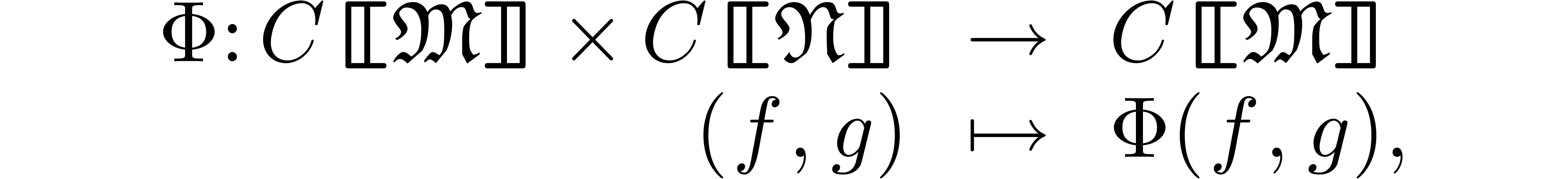

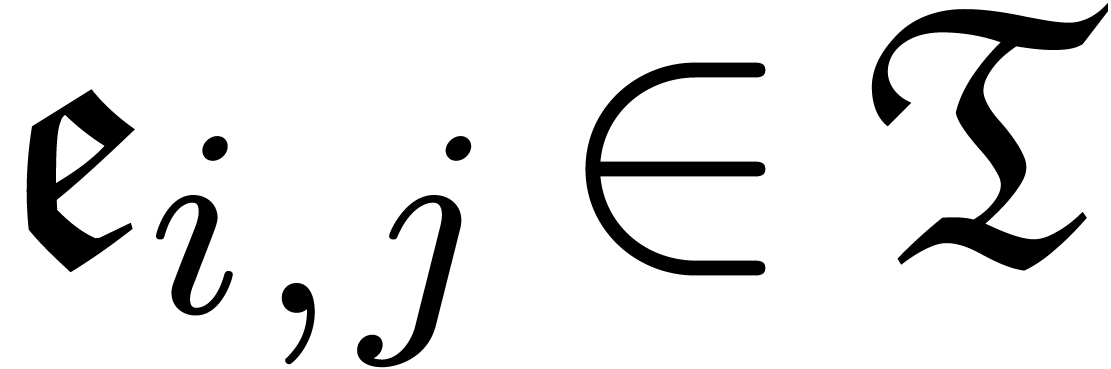

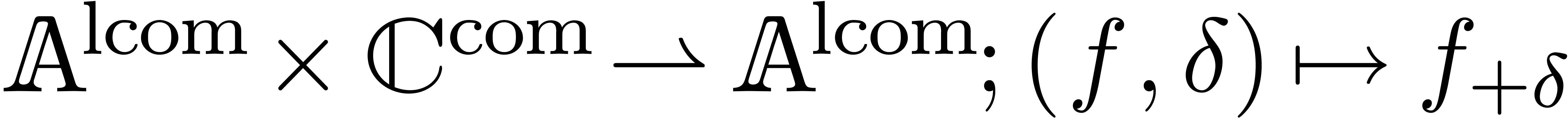

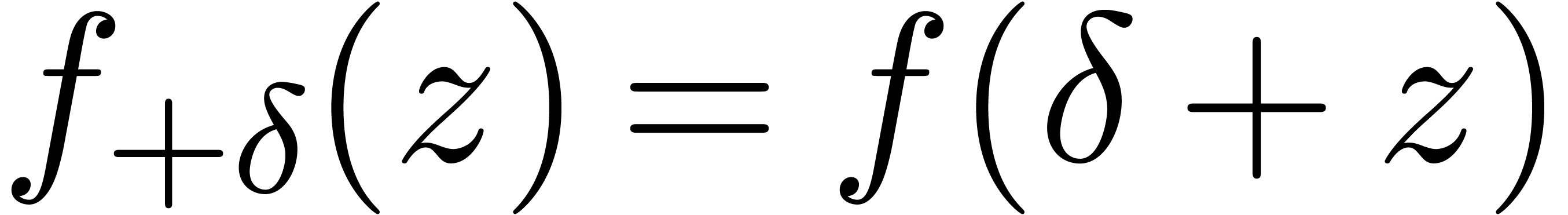

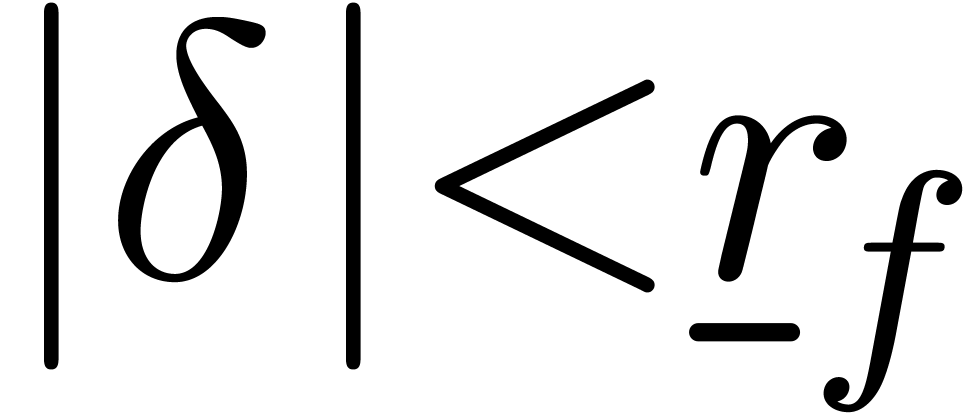

Le théorème des fonctions implicites utilisé pour

démontrer la partie (a) du théorème 1.7 se généralise à des opérateurs

réticulés plus généraux. Soient  et

et  des ensembles de monômes,

inclus dans un groupe de monômes

des ensembles de monômes,

inclus dans un groupe de monômes  .

Grosso modo, un opérateur

réticulé est une application

.

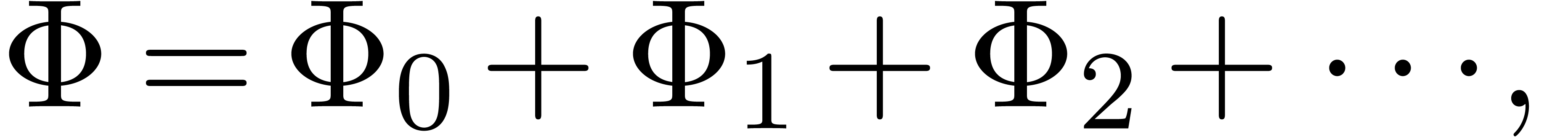

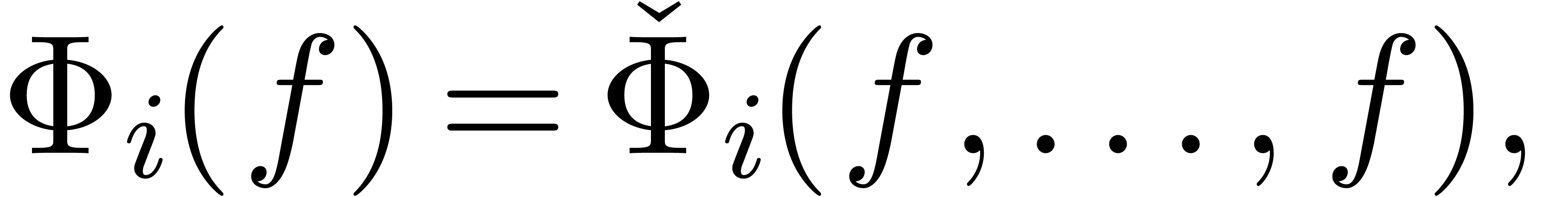

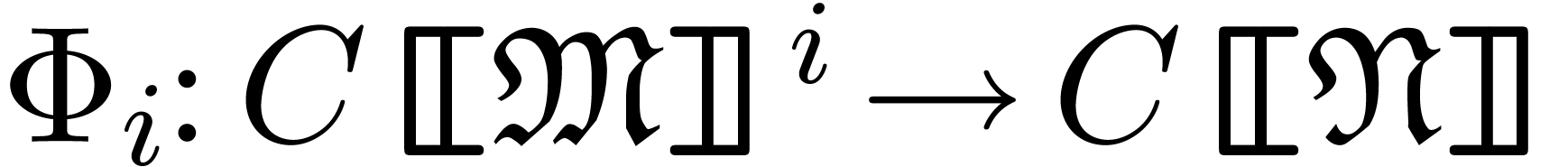

Grosso modo, un opérateur

réticulé est une application  , telle que

, telle que  admet un

développement en série

admet un

développement en série

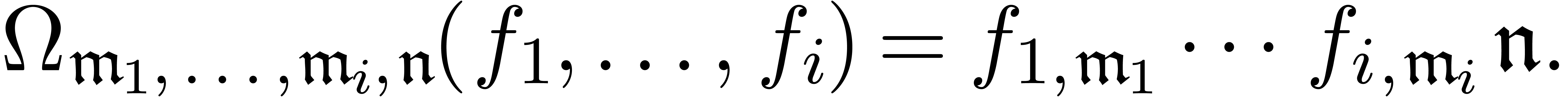

où

pour certains opérateurs fortement multi-linéaires  .

.

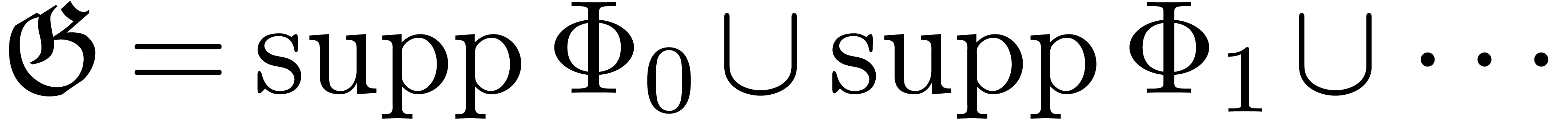

Le support de l'opérateur  est le

plus petit ensemble

est le

plus petit ensemble  avec

avec

pour tous les  . Les

opérateurs

. Les

opérateurs  sont par ailleurs des

combinaisons linéaires fortes d'opérateurs

atomiques

sont par ailleurs des

combinaisons linéaires fortes d'opérateurs

atomiques

Un tel opérateur est dit extensif si  pour tout

pour tout  . On dit que

. On dit que  est extensif si tous les opérateurs

intervenant dans la décomposition atomique sont extensifs.

est extensif si tous les opérateurs

intervenant dans la décomposition atomique sont extensifs.

strictement extensive en  ,

et tel que

,

et tel que

soit réticulé avec  .

Alors pour tout

.

Alors pour tout  , il existe

un unique

, il existe

un unique  avec

avec

et l'opérateur  est

réticulé.

est

réticulé.

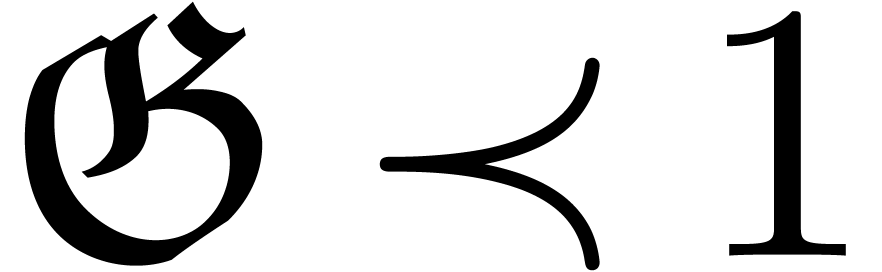

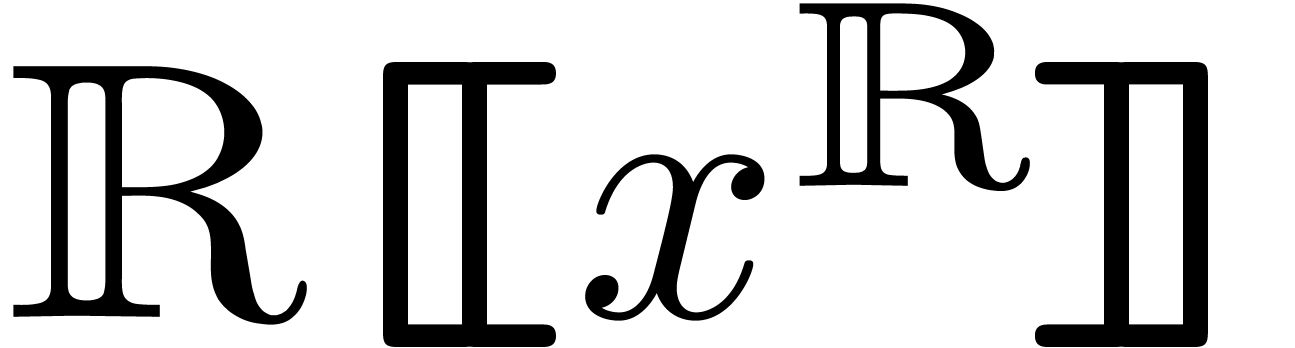

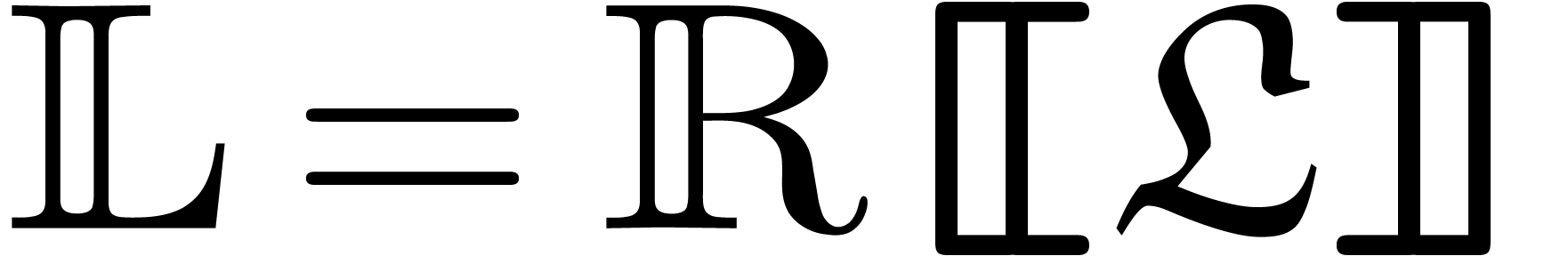

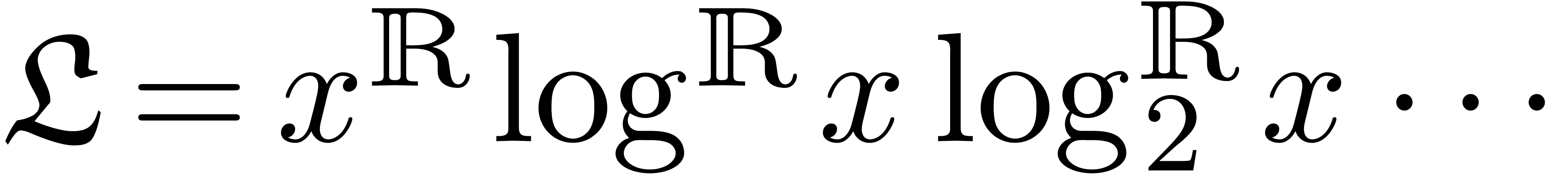

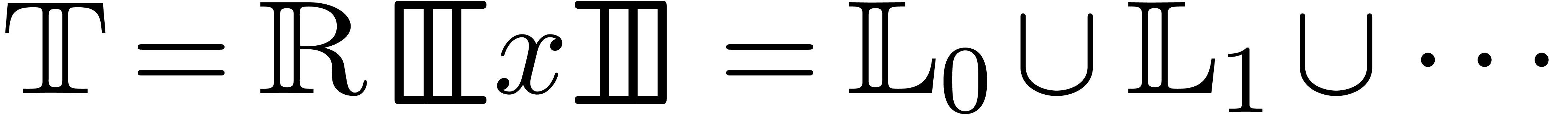

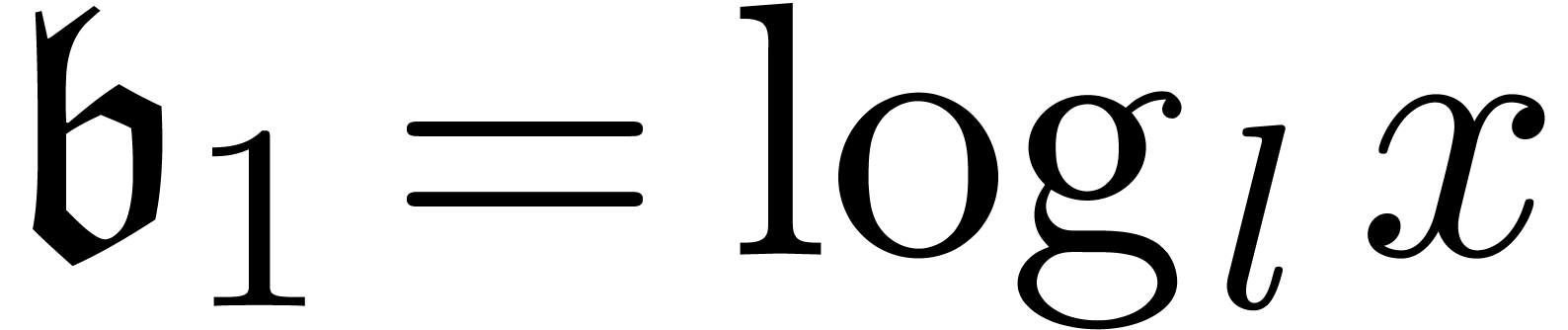

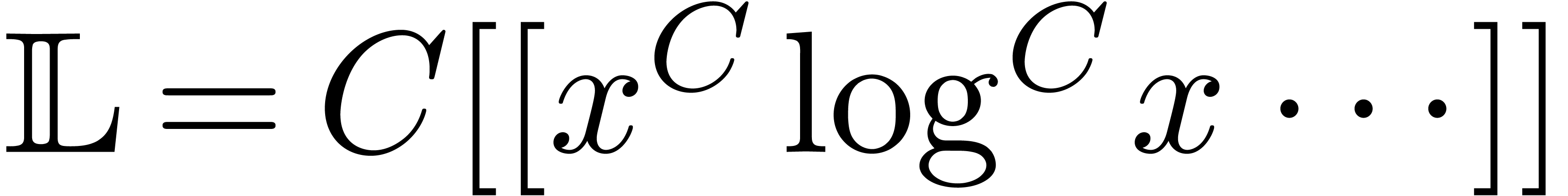

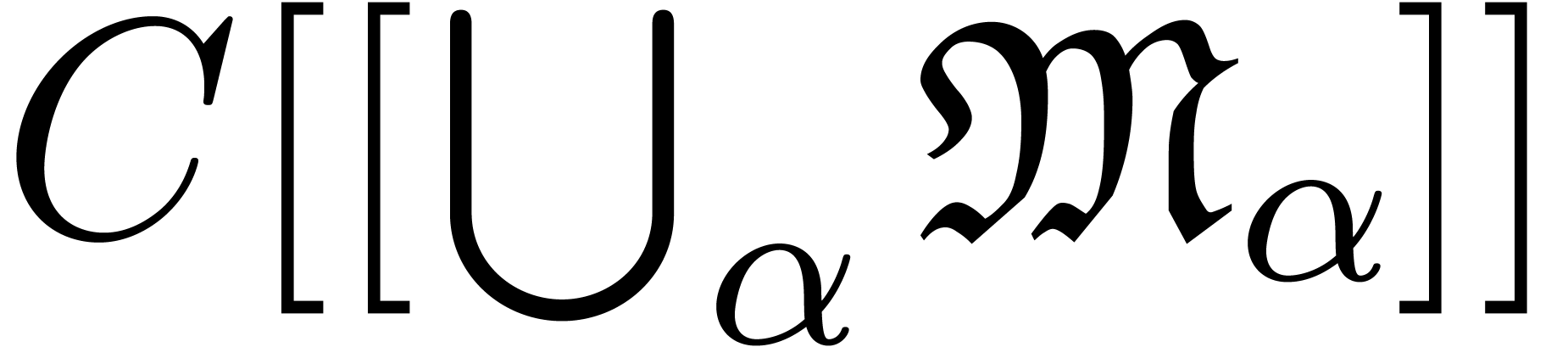

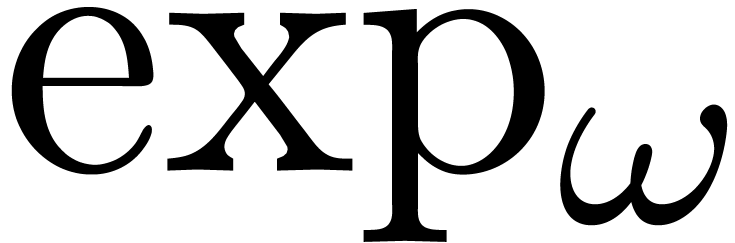

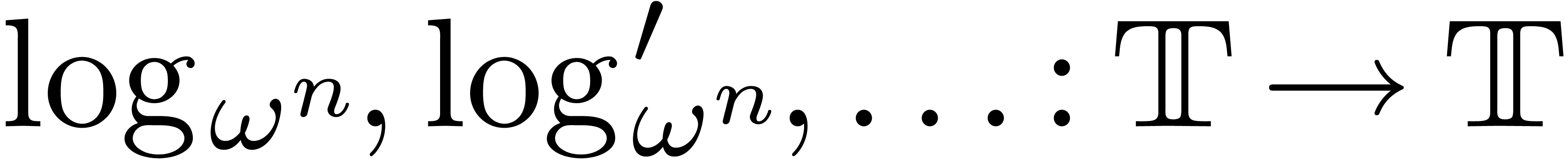

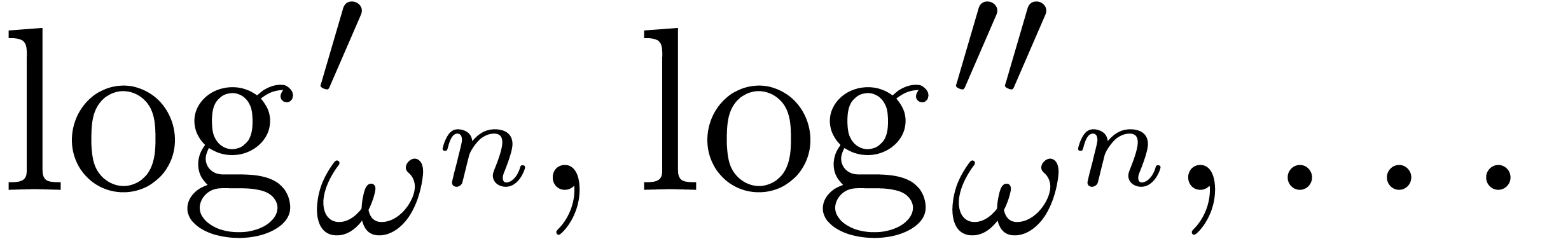

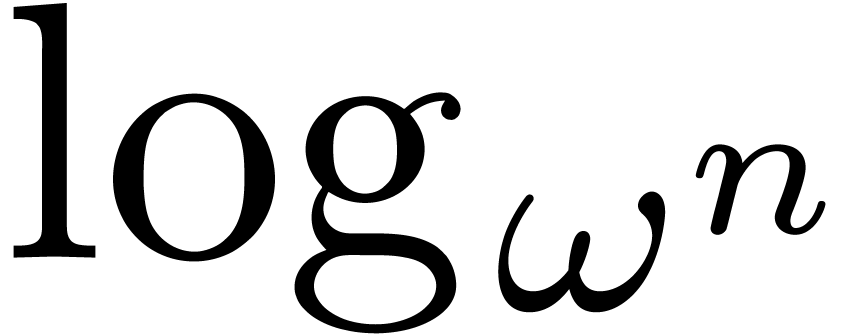

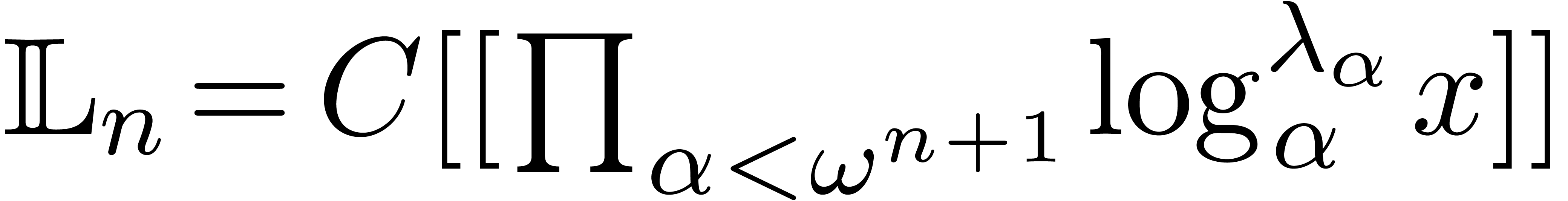

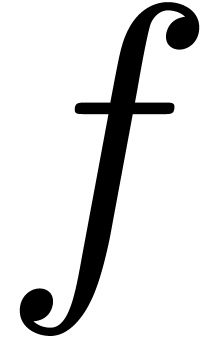

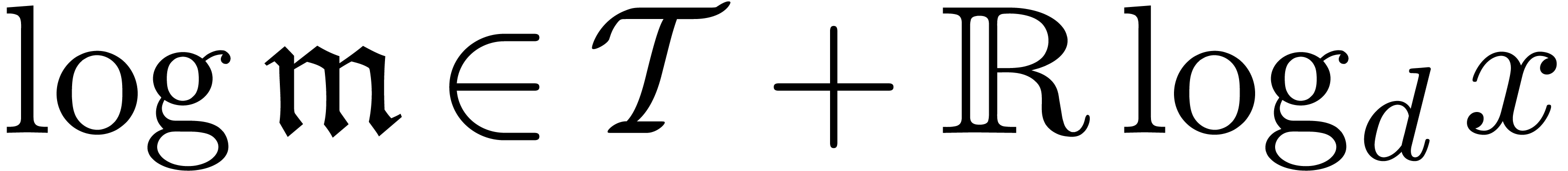

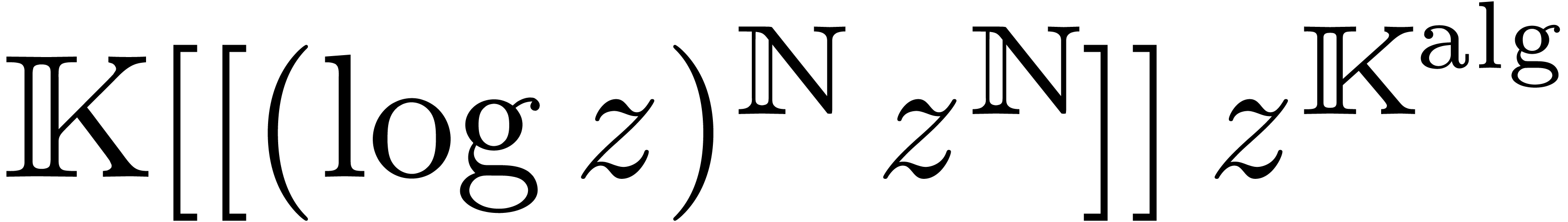

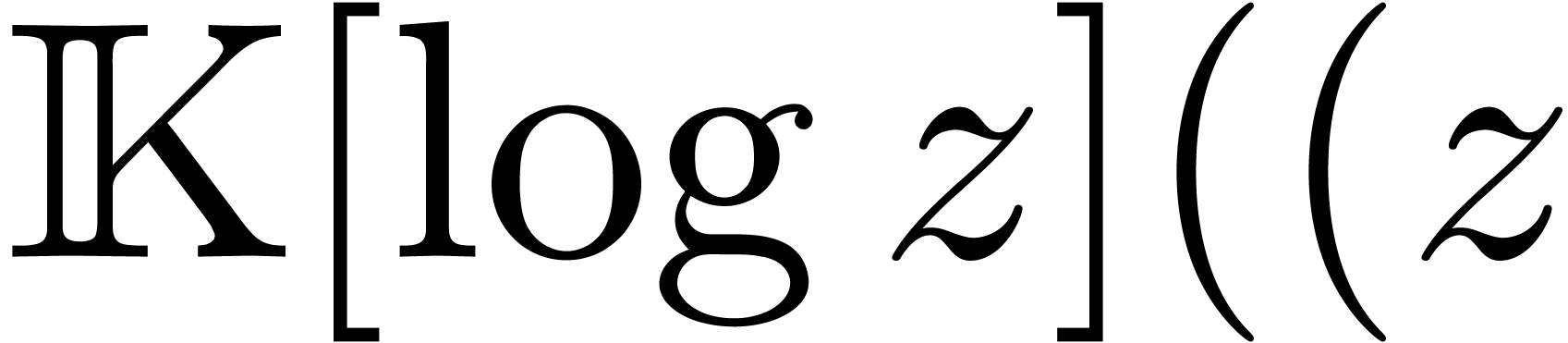

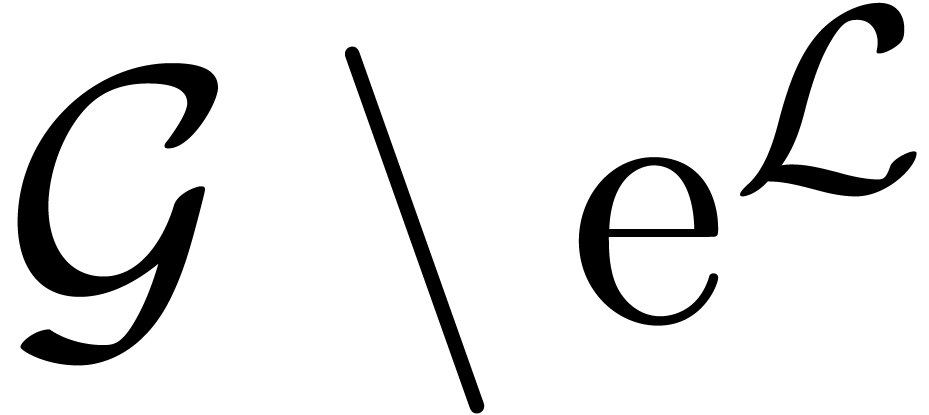

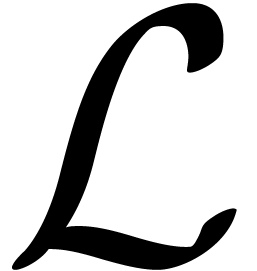

Les transséries sont construites en clôturant  sous le logarithme et l'exponentielle. La première

étape est simple : le corps des transséries

logarithmiques est

sous le logarithme et l'exponentielle. La première

étape est simple : le corps des transséries

logarithmiques est  ,

où

,

où  . On définit

un logarithme sur

. On définit

un logarithme sur  par

par

où  et

et  .

.

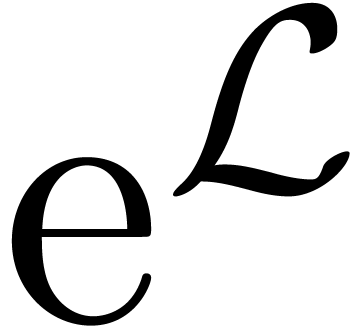

Pour la deuxième étape de clôture par

exponentiation, il faut avant tout décider quels seront les

nouveaux monômes. Or, étant donnée une série

où

où  est totalement

ordonné,

est totalement

ordonné,  admet une

décomposition canonique

admet une

décomposition canonique  ,

avec

,

avec  ,

,  et

et  . Maintenant,

l'idée consiste à imposer que

. Maintenant,

l'idée consiste à imposer que  pour

tout monôme

pour

tout monôme  . Ayant

construit

. Ayant

construit  , avec

, avec  , on peut alors adjoindre un étage

d'exponentielles formelles en prenant

, on peut alors adjoindre un étage

d'exponentielles formelles en prenant  .

Enfin,

.

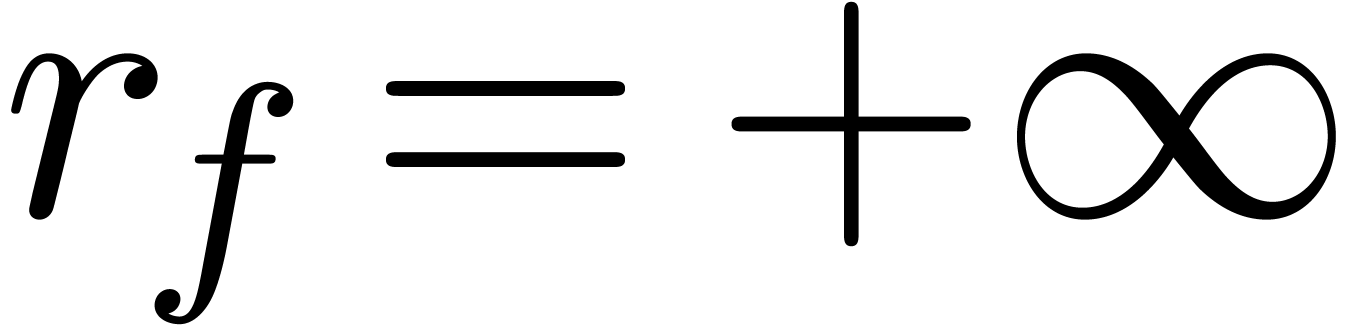

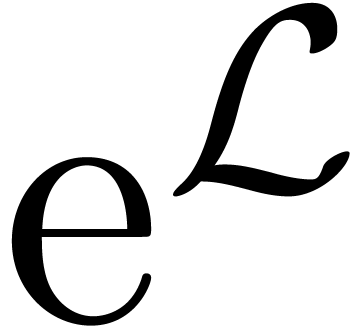

Enfin,  est le corps des transséries en

est le corps des transséries en

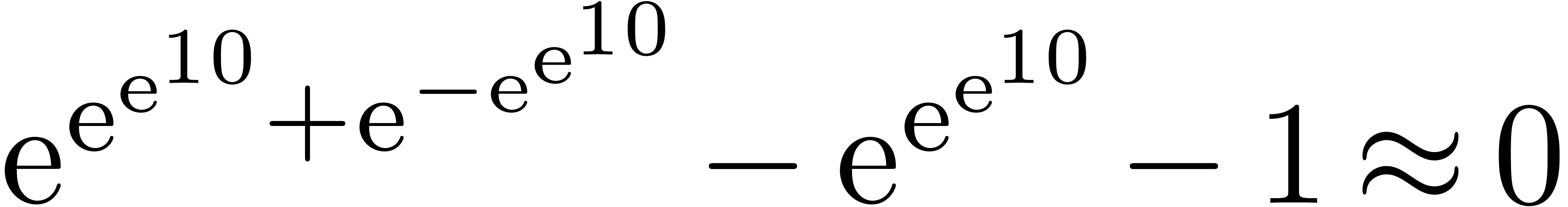

. À cause de la

condition de finitude pour les supports réticulés, on a

. À cause de la

condition de finitude pour les supports réticulés, on a

avec

avec  .

On montre que

.

On montre que  est un modèle de la

théorie des « corps exponentiels ordonnés »

[25] :

est un modèle de la

théorie des « corps exponentiels ordonnés »

[25] :

est un corps exponentiel ordonné.

est un corps exponentiel ordonné.

Remarque  en

partant de

en

partant de  et en clôturant d'abord par

rapport à l'exponentiation et puis par rapport au logarithme. Le

résultat

et en clôturant d'abord par

rapport à l'exponentiation et puis par rapport au logarithme. Le

résultat  de la première

étape s'appelle le corps des transséries

exponentielles. On a

de la première

étape s'appelle le corps des transséries

exponentielles. On a  .

.

Le corps  est valué, avec

est valué, avec  ou

ou  comme groupe des valeurs. Les

différentes classes archimédiennes de

comme groupe des valeurs. Les

différentes classes archimédiennes de  se décrivent de façon particulièrement simple

à l'aide de la relation de platitude

se décrivent de façon particulièrement simple

à l'aide de la relation de platitude  qui est caractérisée par :

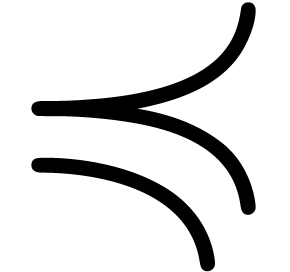

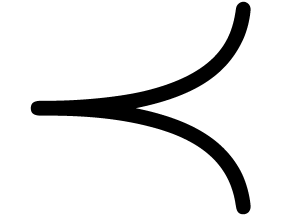

qui est caractérisée par :

De façon plus fine, on peut chercher à développer

les transséries dans des échelles asymptotiques

particulièrement simples et adaptées au calcul effectif.

On dit que  avec

avec  dans

dans

est une transbase lorsque

est une transbase lorsque

pour un certain

pour un certain  .

.

pour

pour  .

.

La démonstration du théorème suivant est très constructive et donne lieu à des algorithmes dans un contexte plus effectif [96] :

une transbase et

une transbase et  . Alors il existe une transbase

. Alors il existe une transbase  avec

avec  .

.

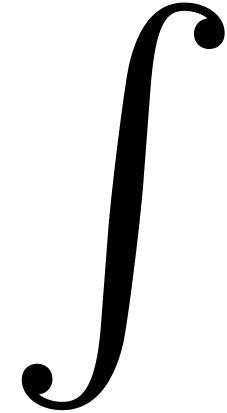

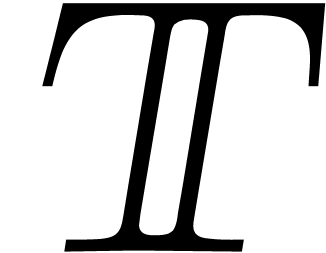

Le corps  est également stable par

dérivation, intégration, composition et inversion

fonctionnelle et cette structure supplémentaire est compatible

avec l'ordre et la sommation réticulée :

est également stable par

dérivation, intégration, composition et inversion

fonctionnelle et cette structure supplémentaire est compatible

avec l'ordre et la sommation réticulée :

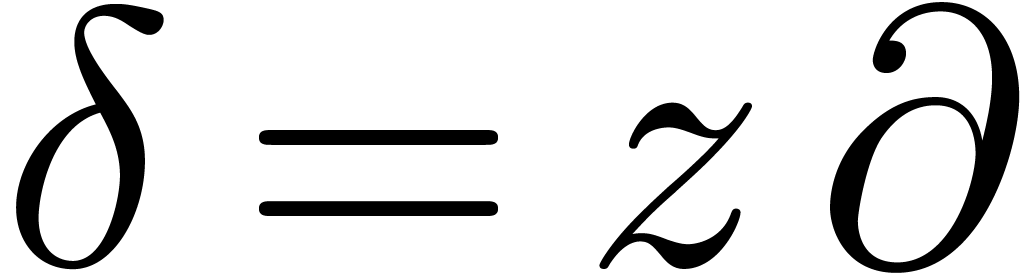

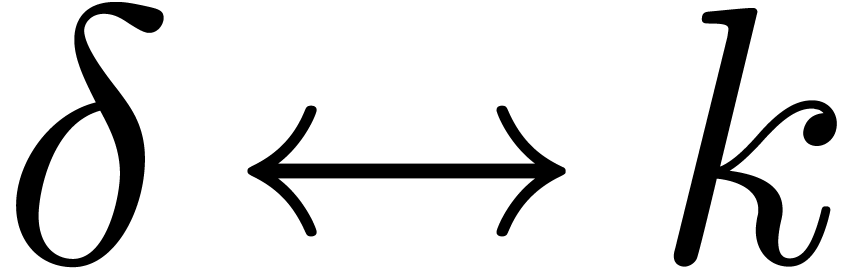

sur

sur

avec

avec  et

et  pour tout

pour tout  . Cette

dérivation vérifie :

. Cette

dérivation vérifie :

pour tout

pour tout  avec

avec

.

.

pour tout

pour tout  .

.

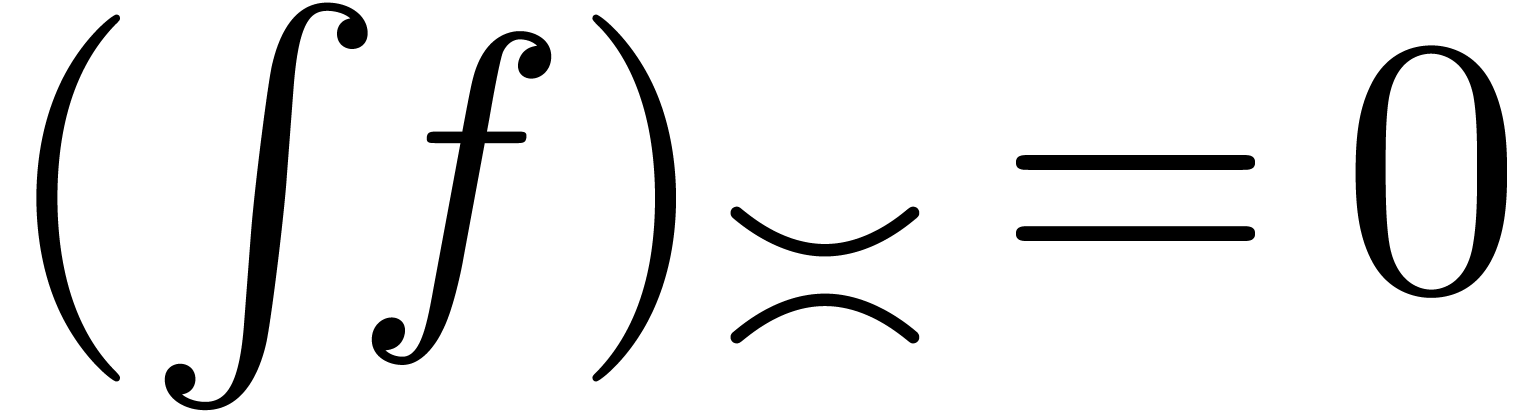

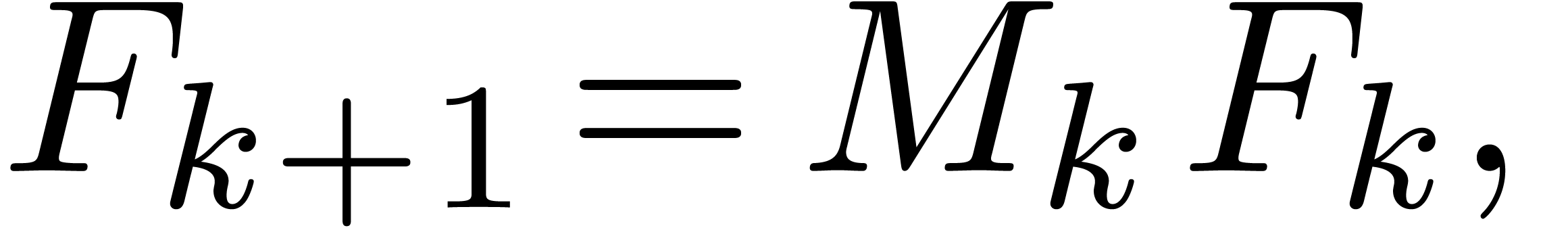

Par ailleurs, il existe une unique intégration forte  avec

avec  et

et  pour tout

pour tout  .

.

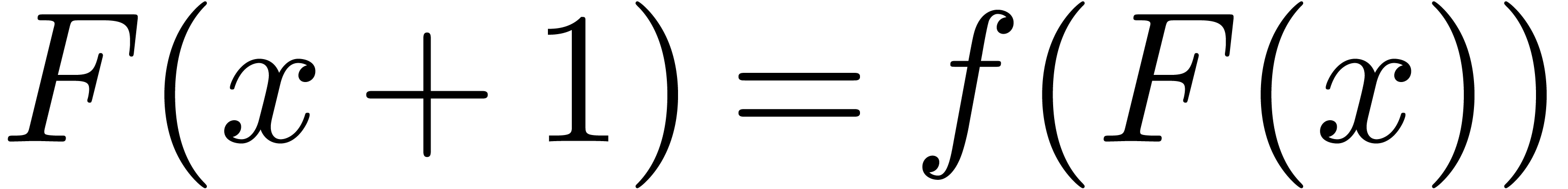

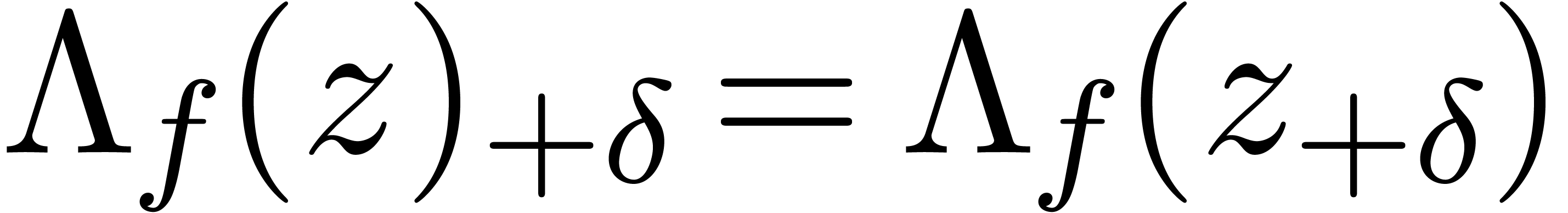

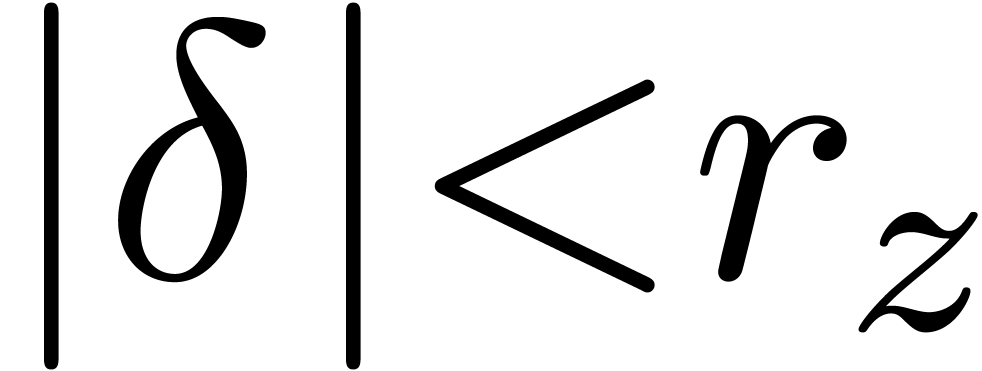

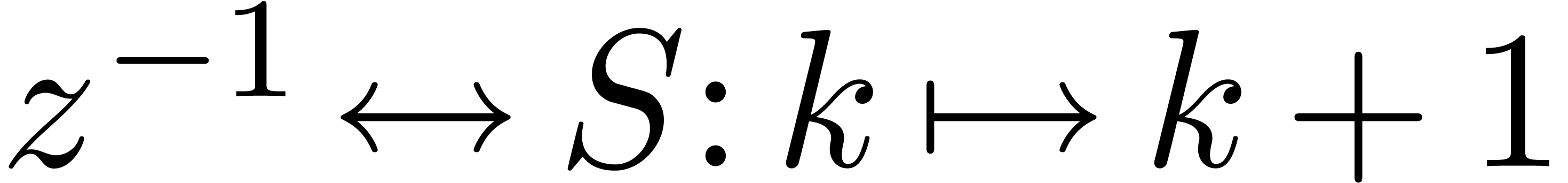

. Alors il existe un

unique opérateur aux différences fort

. Alors il existe un

unique opérateur aux différences fort  avec

avec  et

et  pour tout

pour tout  . Cet opérateur

vérifie :

. Cet opérateur

vérifie :

F1

F1

pour tout

pour tout  .

.

F2

F2

pour tout

pour tout  .

.

Par ailleurs :

pour tout

pour tout  et

et  .

.

pour tout

pour tout  et

et  .

.

Si  vérifient

vérifient  et

et  pour tout

pour tout  ,

alors :

,

alors :

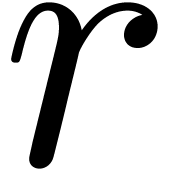

Enfin, tout  admet une inverse fonctionnelle

admet une inverse fonctionnelle

pour

pour  .

.

Remarque

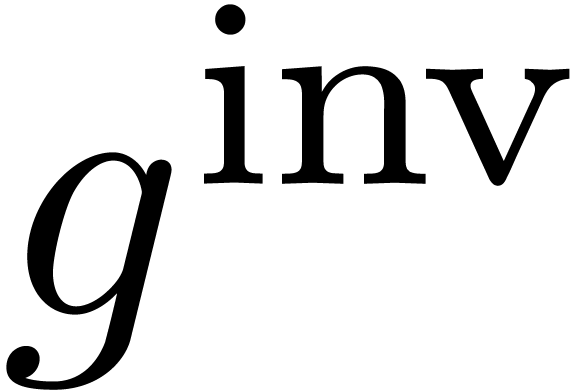

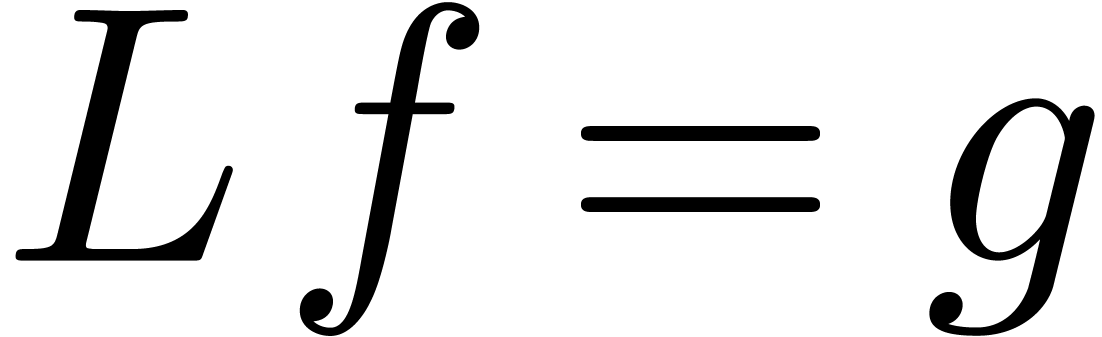

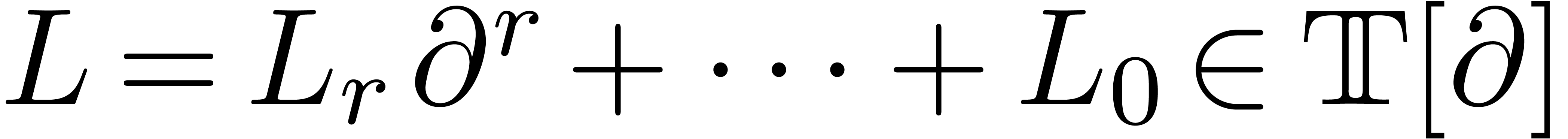

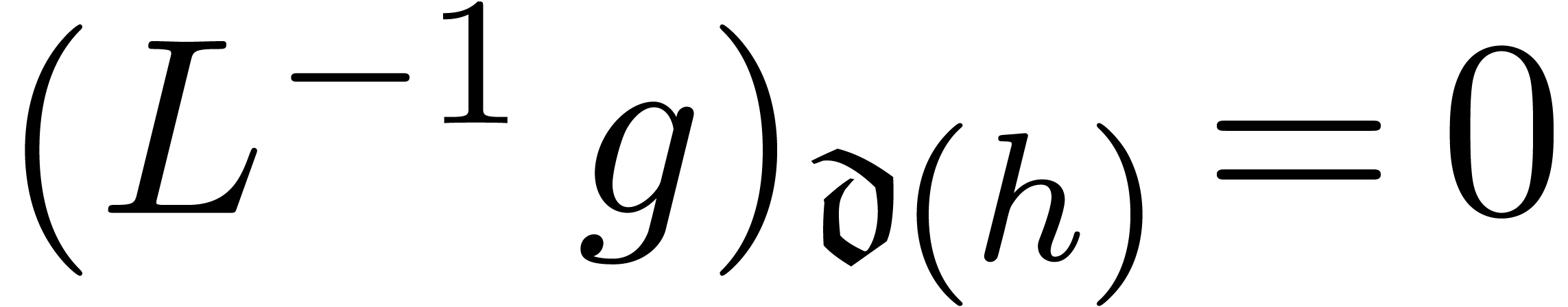

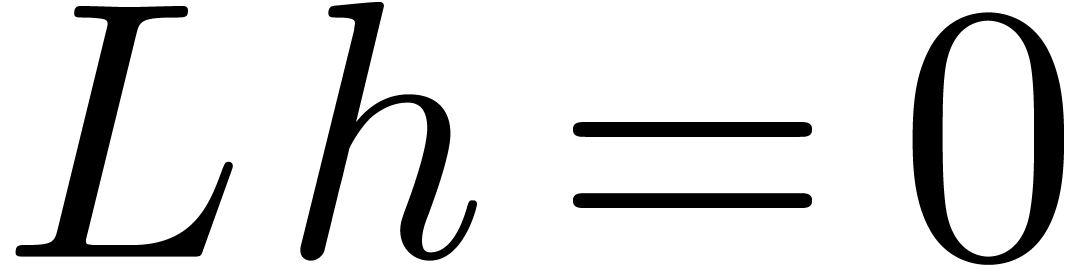

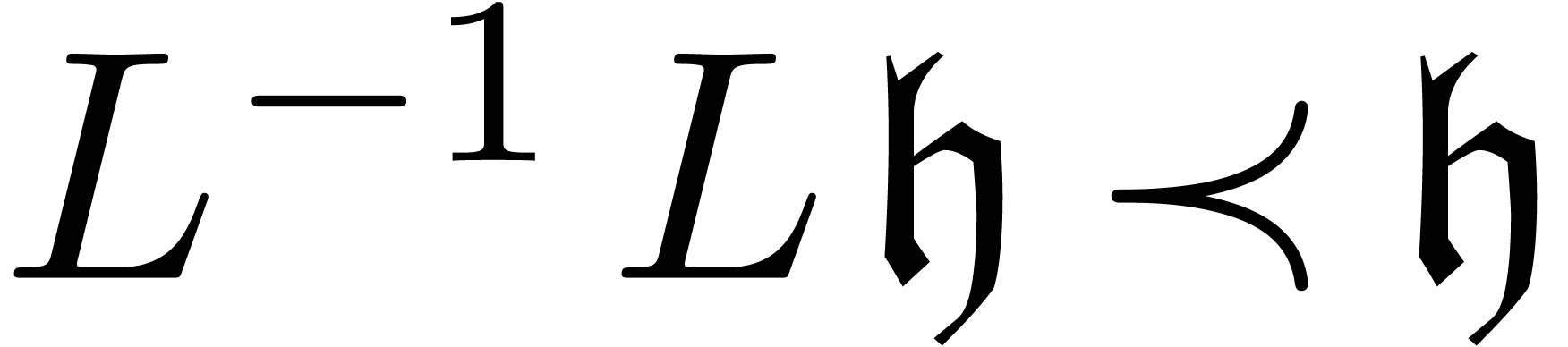

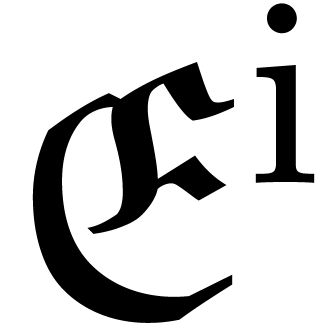

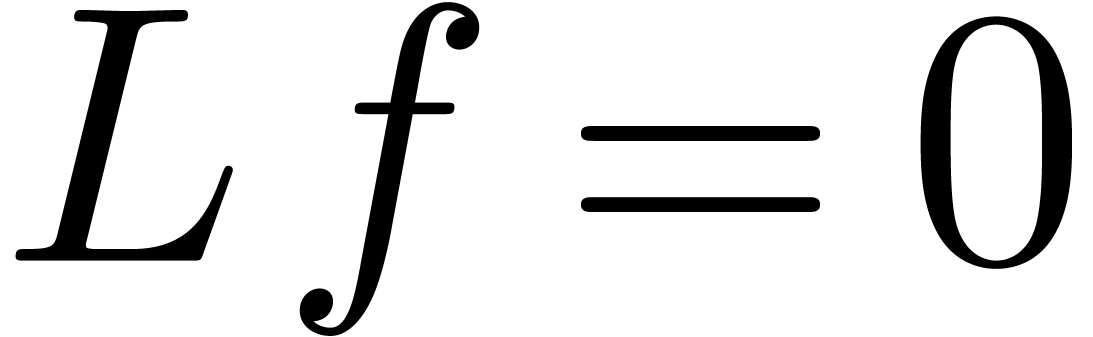

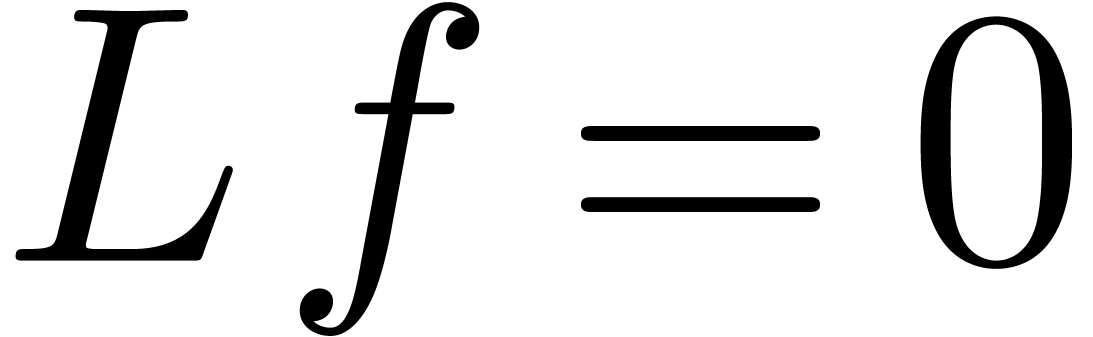

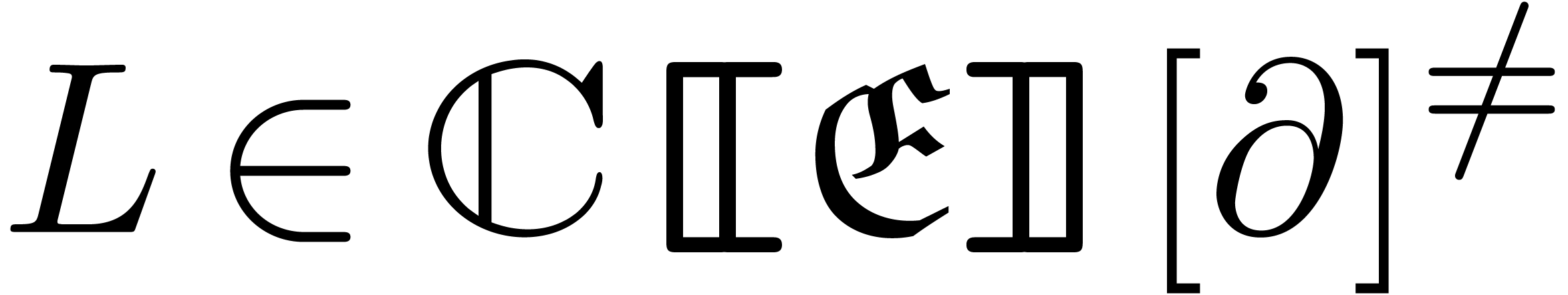

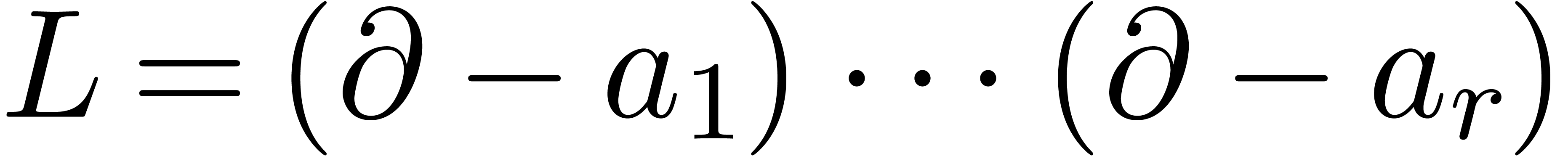

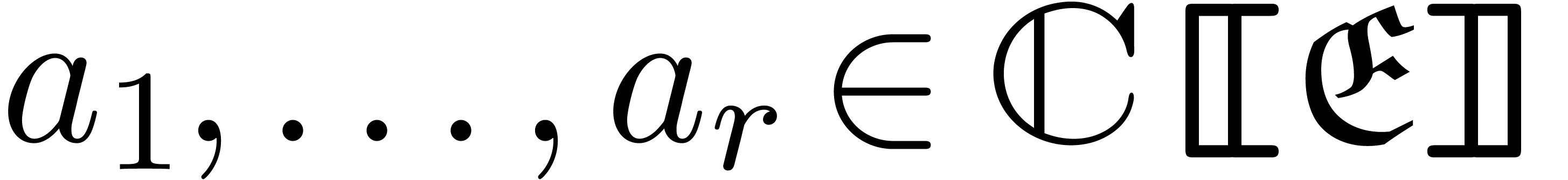

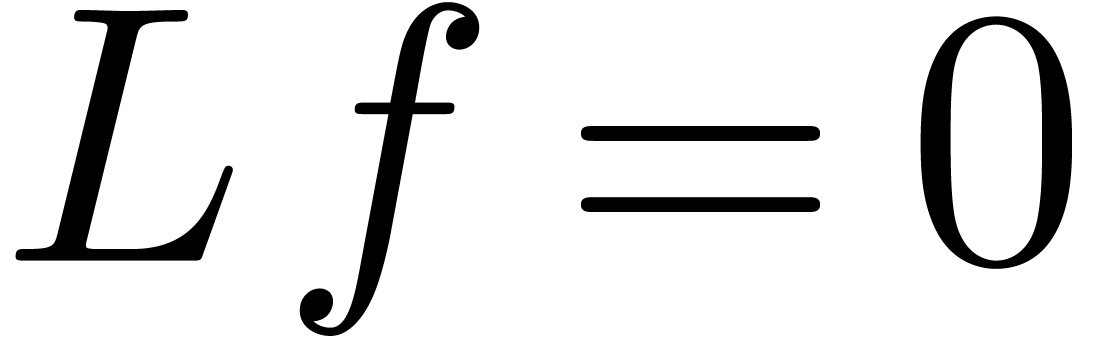

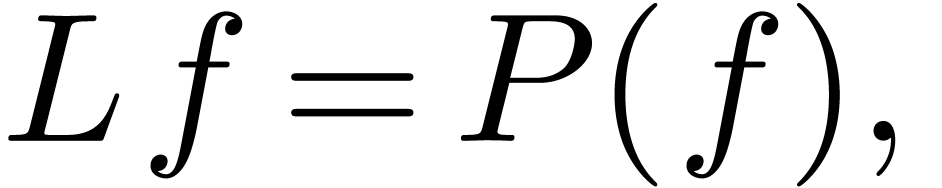

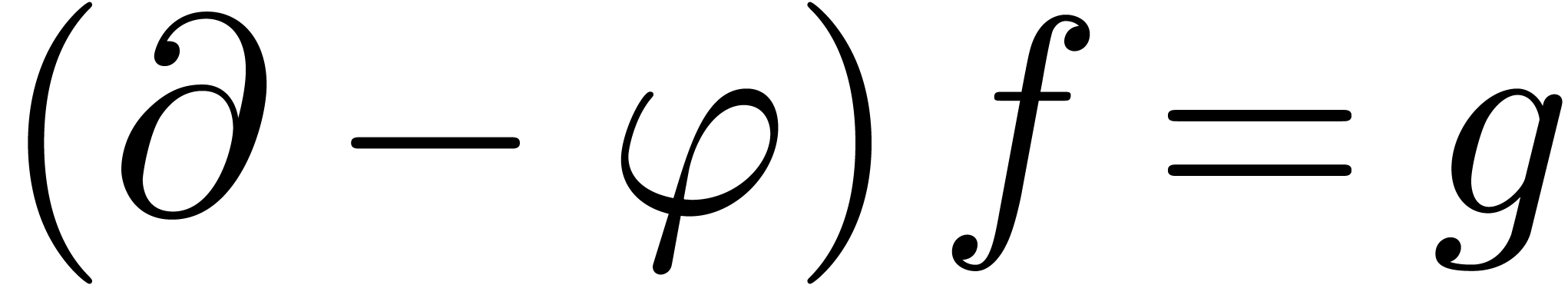

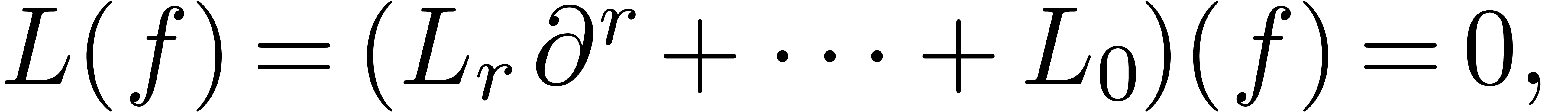

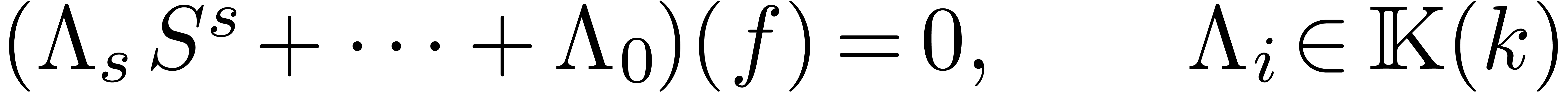

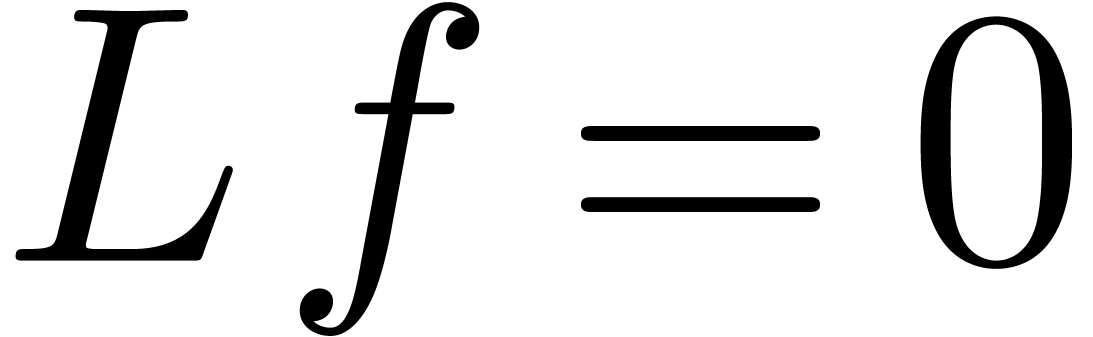

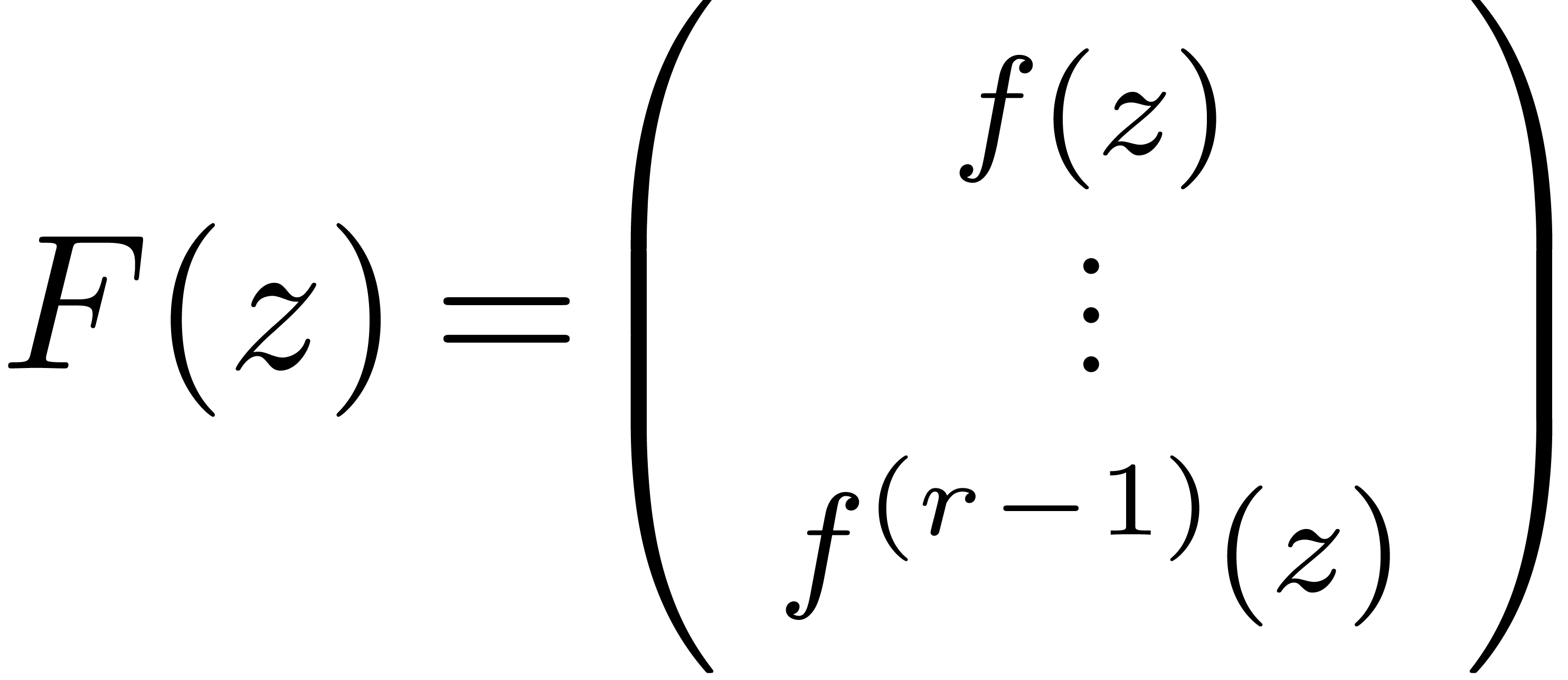

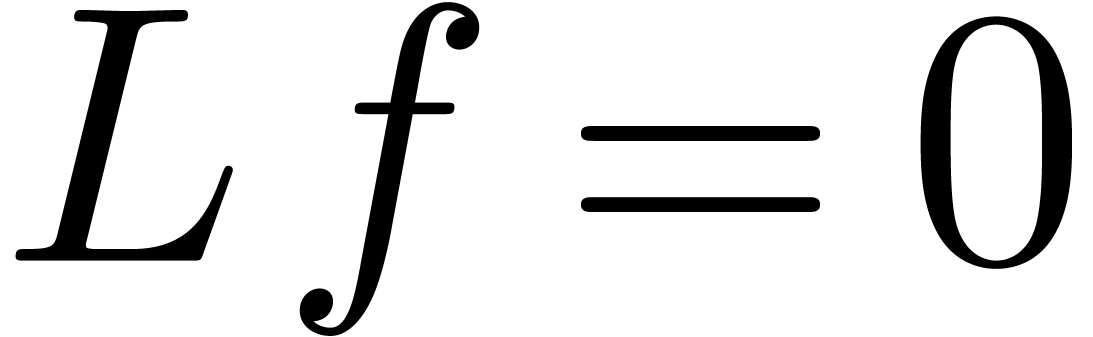

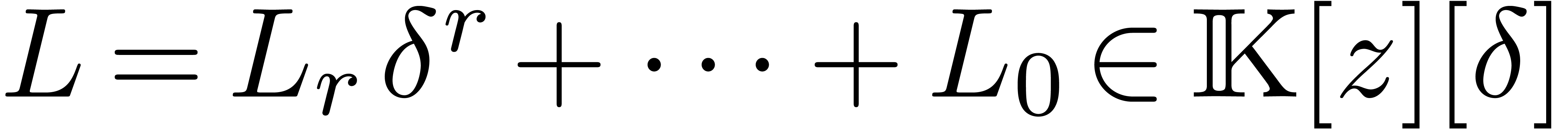

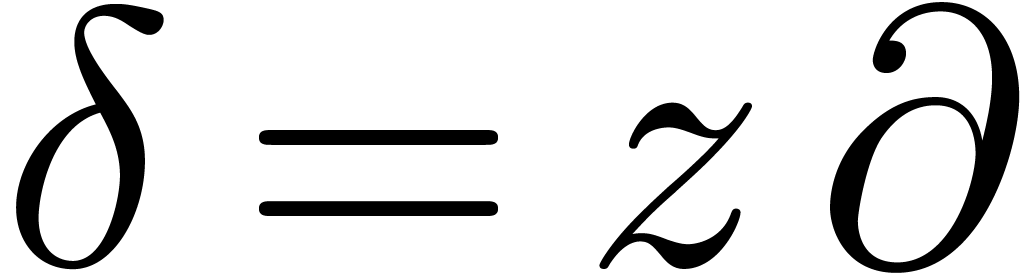

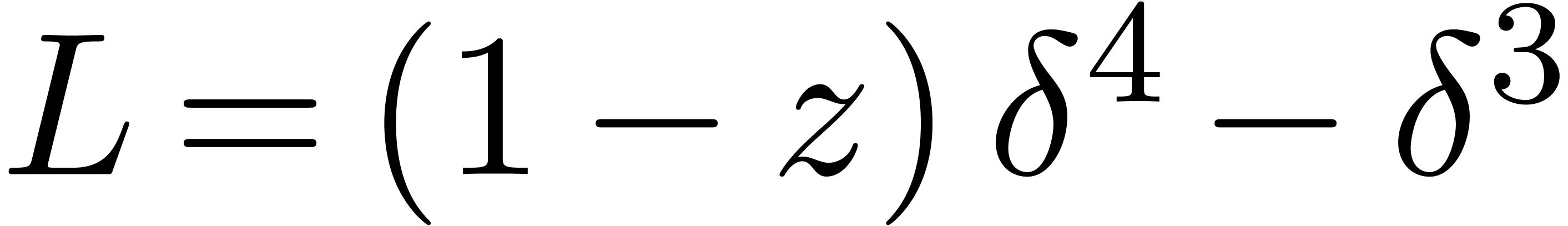

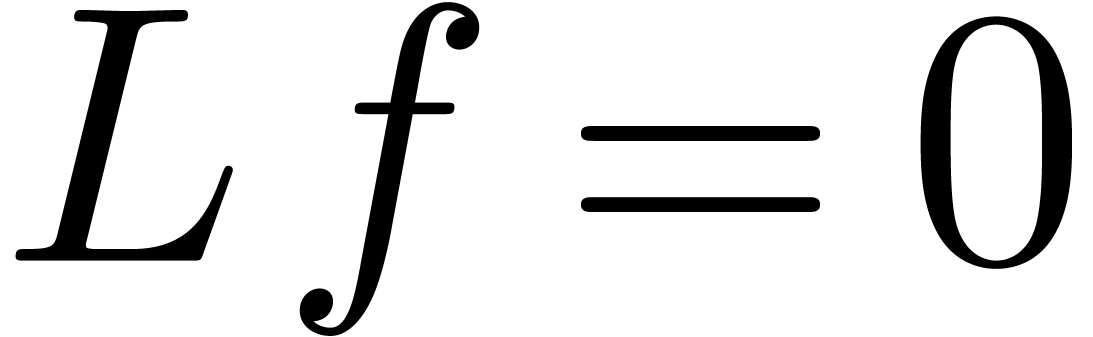

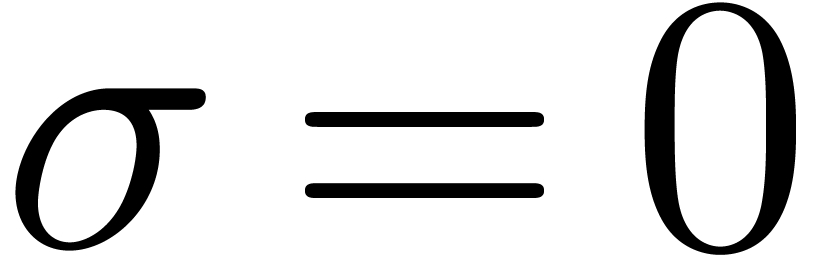

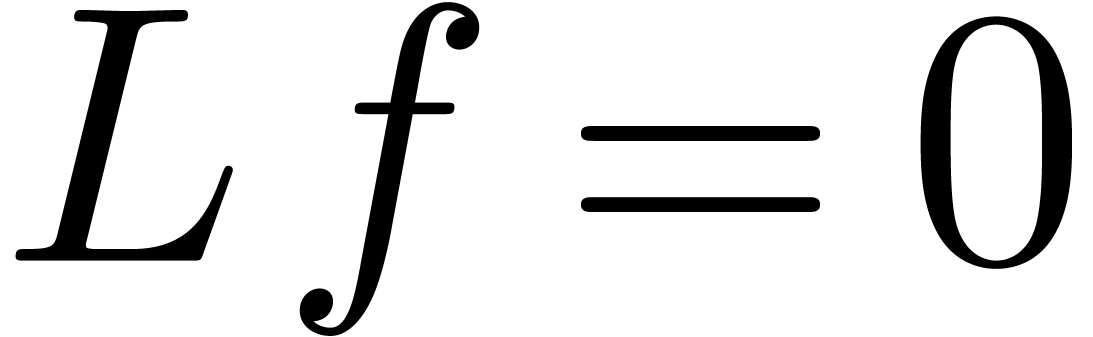

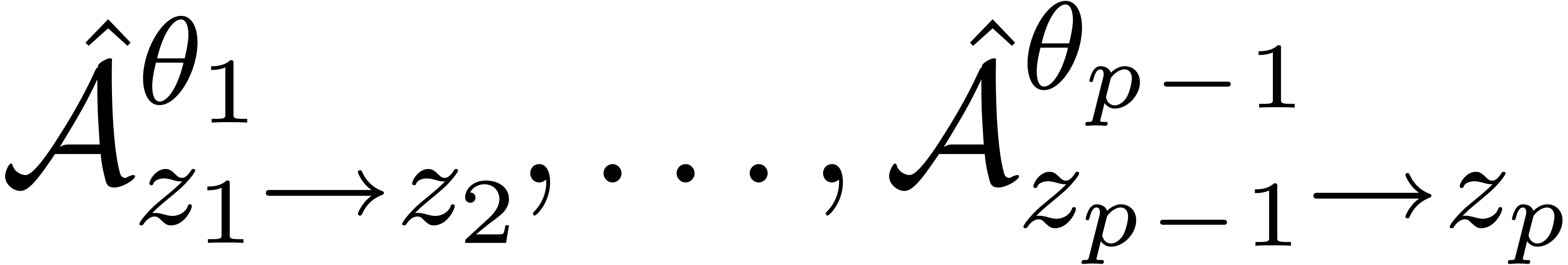

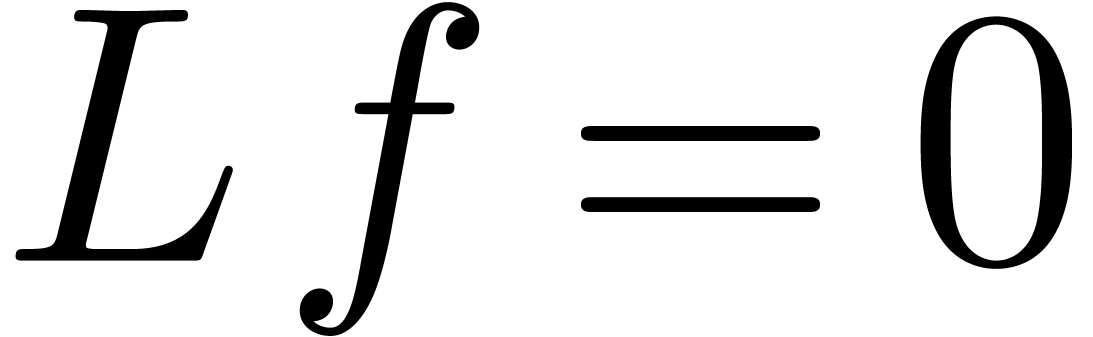

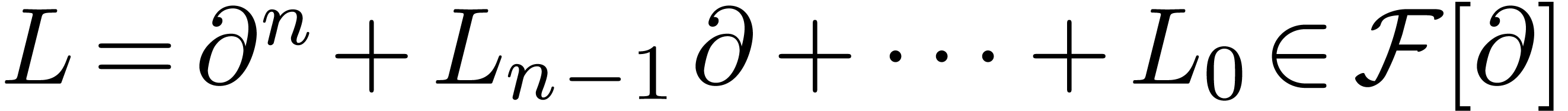

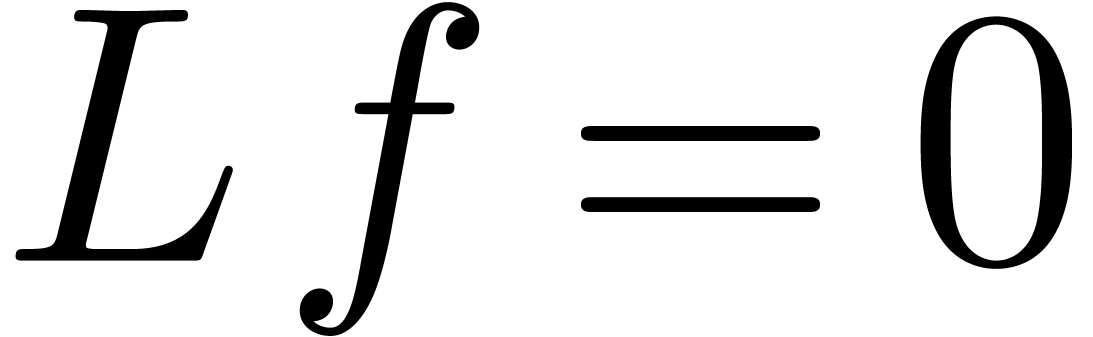

Considérons maintenant la résolution d'une équation

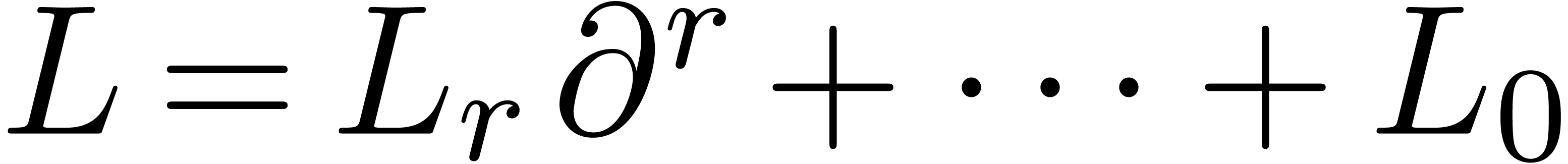

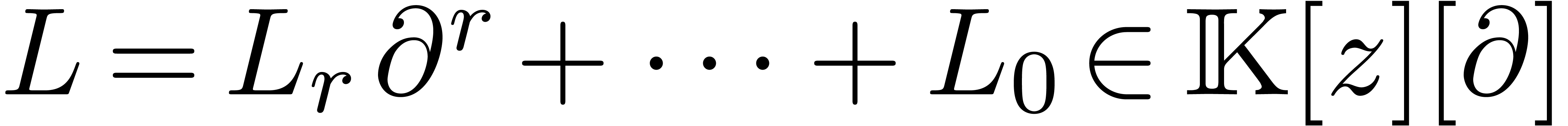

différentielle linéaire  ,

avec

,

avec  et

et  .

Modulo plusieurs montées (i.e.

post-compositions avec

.

Modulo plusieurs montées (i.e.

post-compositions avec  ), on

se ramène d'abord au cas exponentiel où

), on

se ramène d'abord au cas exponentiel où  et

et  . On traite ensuite le cas

homogène

. On traite ensuite le cas

homogène  et inhomogène

et inhomogène  de façon séparée.

de façon séparée.

Cherchons d'abord à trouver une solution dans le cas

inhomogène, ce qui commence par la recherche du terme dominant de

. Pour cela on

considère la trace de

. Pour cela on

considère la trace de  :

:

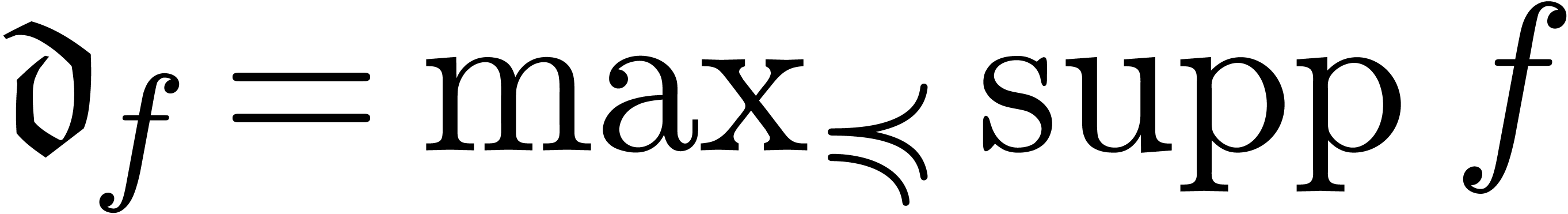

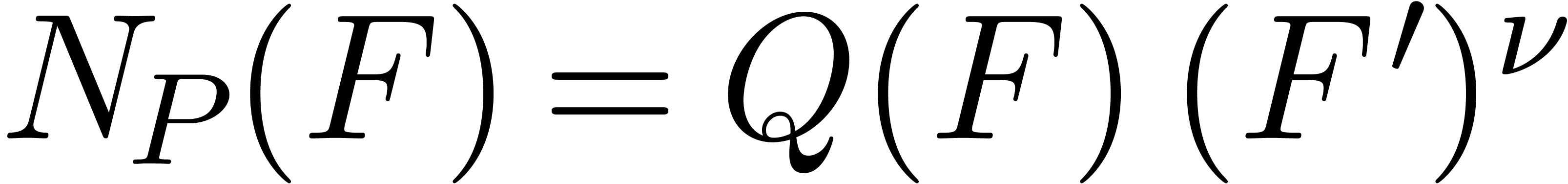

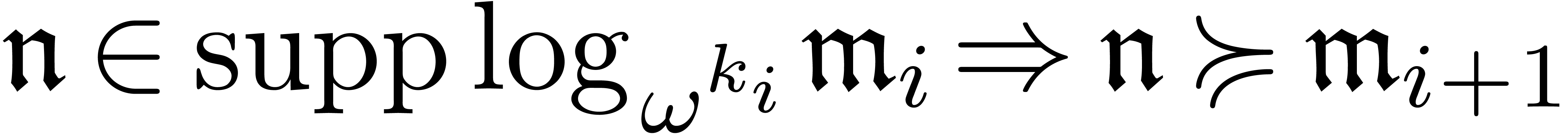

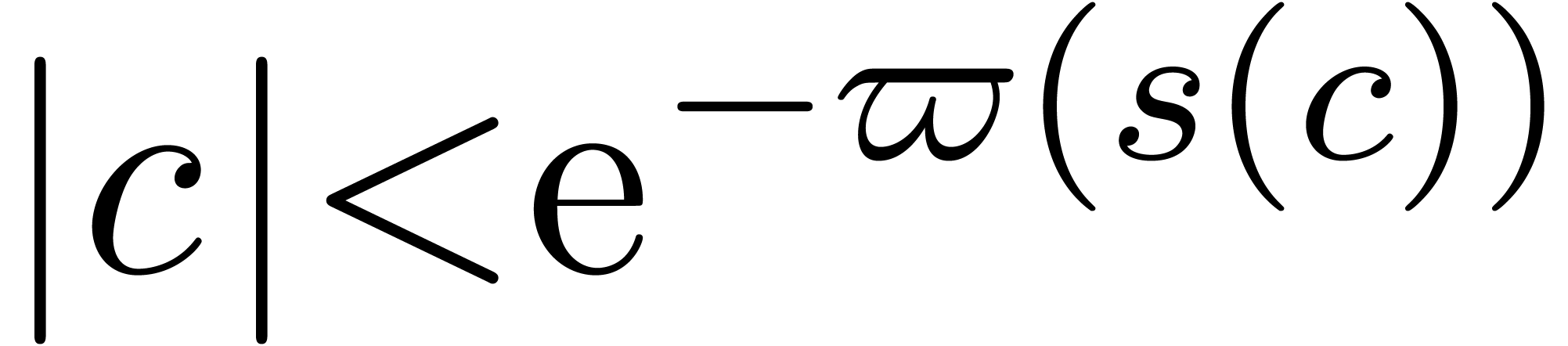

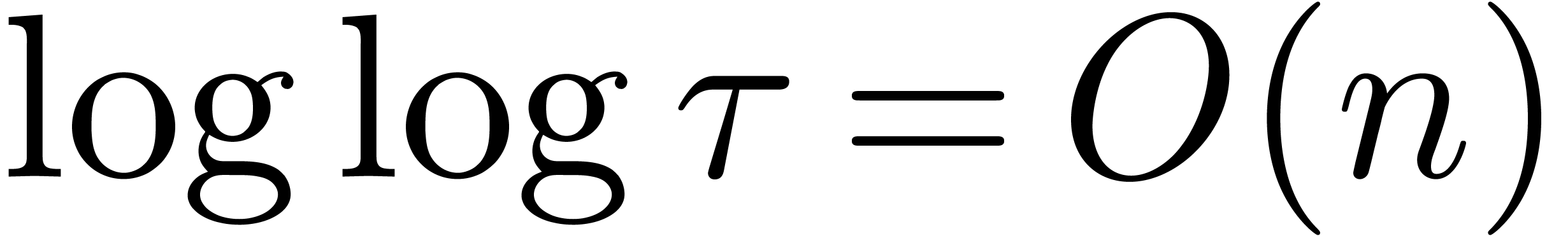

On montre qu'il existe un ensemble  avec

avec  fini tel que la restriction

fini tel que la restriction  est croissante pour

est croissante pour  et surjective. En outre,

et surjective. En outre,

pour tout

pour tout  .

Par la proposition 1.3, l'application

.

Par la proposition 1.3, l'application  s'étend en un isomorphisme fortement linéaire

s'étend en un isomorphisme fortement linéaire  . Écrivant

. Écrivant  ,

on considère ensuite l'opérateur

,

on considère ensuite l'opérateur

Utilisant le théorème 1.8, on montre que  est un opérateur fortement linéaire

avec

est un opérateur fortement linéaire

avec  pour tout

pour tout  .

On appelle

.

On appelle  l'inverse distinguée

de

l'inverse distinguée

de  , car

, car  pour toute solution non triviale à l'équation

homogène

pour toute solution non triviale à l'équation

homogène  .

.

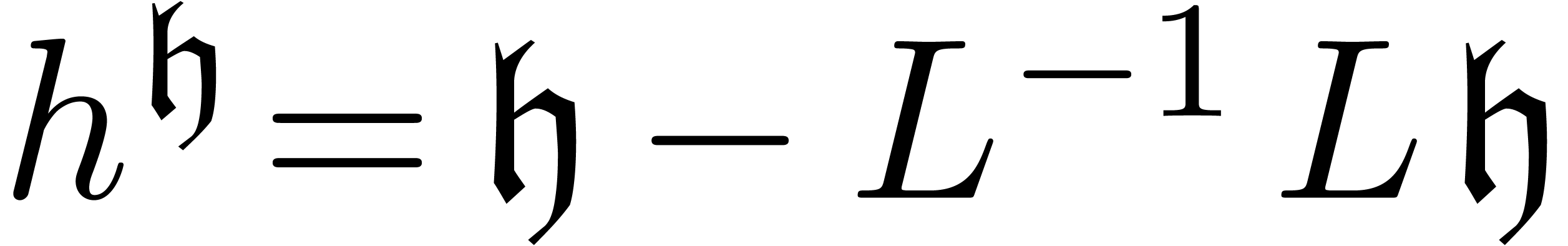

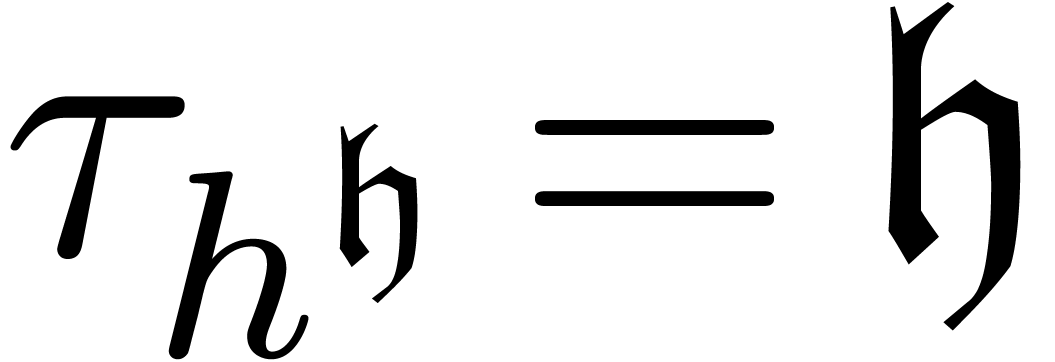

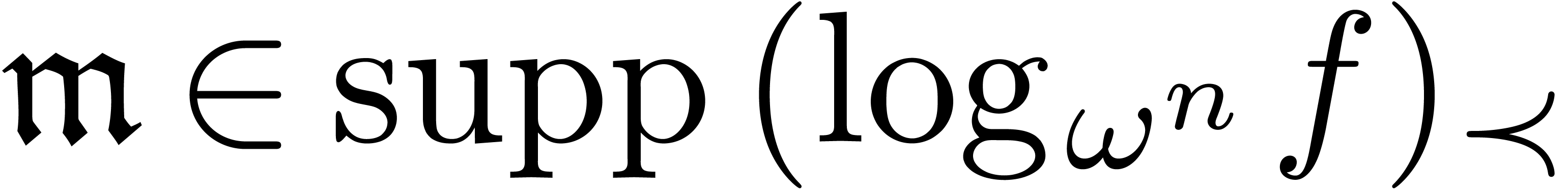

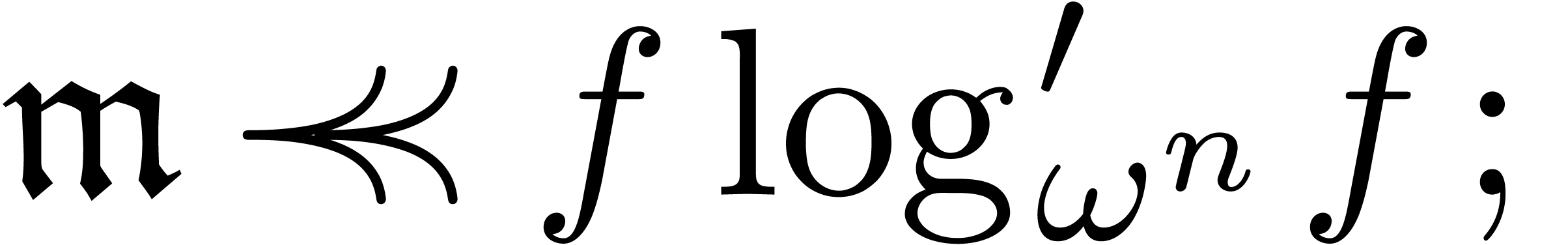

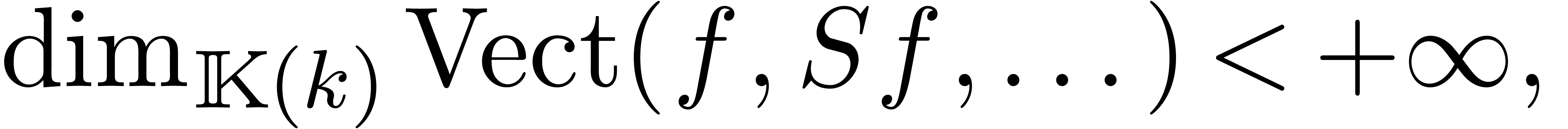

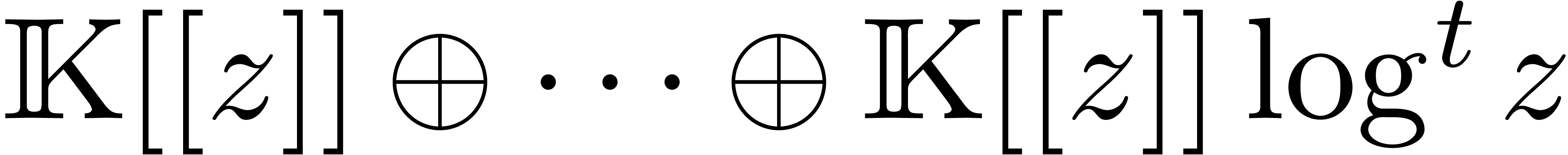

De fait, les solutions  de

de  vérifient nécessairement

vérifient nécessairement  .

Inversement, tout monôme

.

Inversement, tout monôme  vérifie

vérifie

, ce qui conduit à une

solution

, ce qui conduit à une

solution

de l'équation homogène avec  .

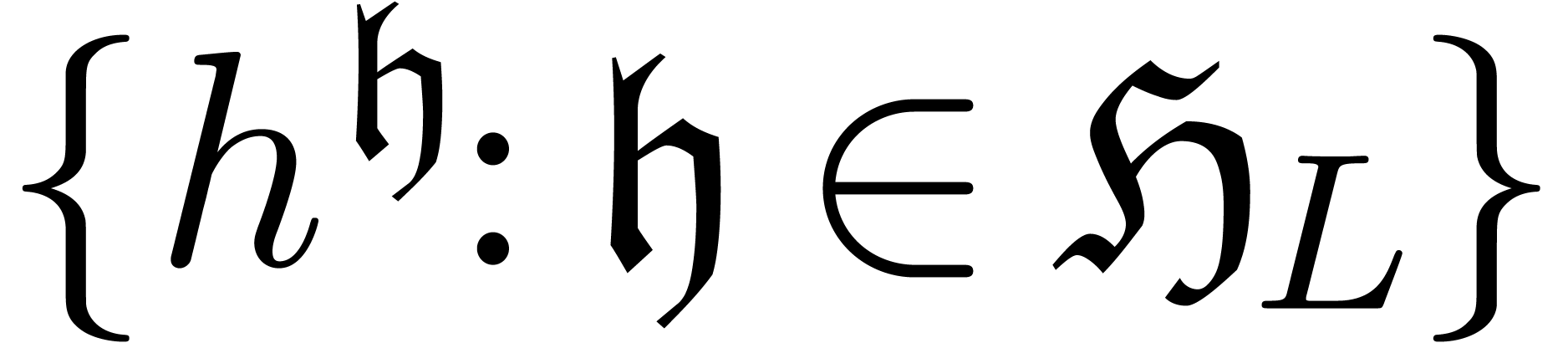

Par conséquent

.

Par conséquent  forme une base, dite

canonique, pour l'espace

forme une base, dite

canonique, pour l'espace  des solutions

à l'équation

des solutions

à l'équation  .

.

Il reste à trouver les éléments de  . Pour cela, on utilise une perturbation de la

méthode des polygones de Newton. D'abord on transforme

l'équation

. Pour cela, on utilise une perturbation de la

méthode des polygones de Newton. D'abord on transforme

l'équation  en une équation

différentielle algébrique

en une équation

différentielle algébrique  en

en  : on fait les substitutions

: on fait les substitutions  ,

,  ,

etc. et on divise par

,

etc. et on divise par  .

Comme on ne cherche que le monôme dominant de

.

Comme on ne cherche que le monôme dominant de  , il suffit de résoudre

l'équation

, il suffit de résoudre

l'équation  modulo

modulo  . Par ailleurs, comme les coefficients de

. Par ailleurs, comme les coefficients de  sont exponentiels,

sont exponentiels,  n'est en

réalité qu'une perturbation de l'équation

n'est en

réalité qu'une perturbation de l'équation  . Dans [117, Section

7.5], nous montrons comment adapter la méthode des polygones de

Newton habituelle afin de trouver

. Dans [117, Section

7.5], nous montrons comment adapter la méthode des polygones de

Newton habituelle afin de trouver  .

Si on étend la recherche aux solutions complexes, ce qui

nécessite la considération de monômes oscillants

.

Si on étend la recherche aux solutions complexes, ce qui

nécessite la considération de monômes oscillants

, alors on peut garantir

l'existence d'une base de

, alors on peut garantir

l'existence d'une base de  solutions :

solutions :

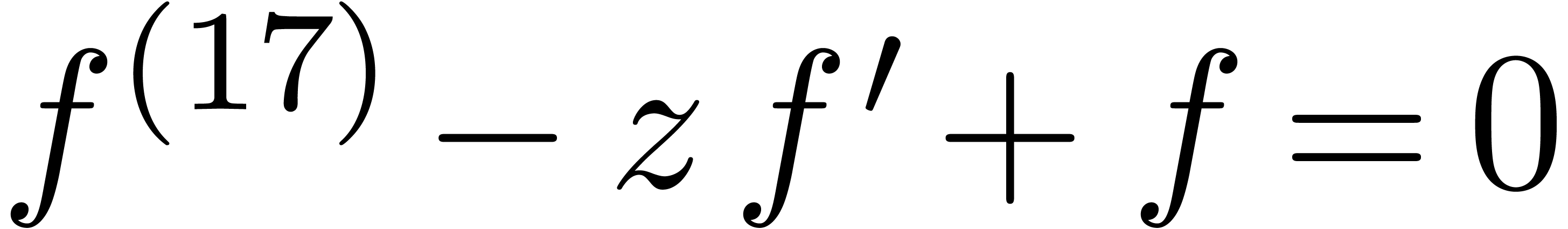

Toute équation différentielle linéaire  avec

avec  admet un

système fondamental de solutions dans

admet un

système fondamental de solutions dans  .

.

Toute équation  avec

avec  d'ordre impair admet au moins une solution non

triviale dans

d'ordre impair admet au moins une solution non

triviale dans  .

.

Ce théorème peut se traduire en termes de factorisations

de l'opérateur  :

:

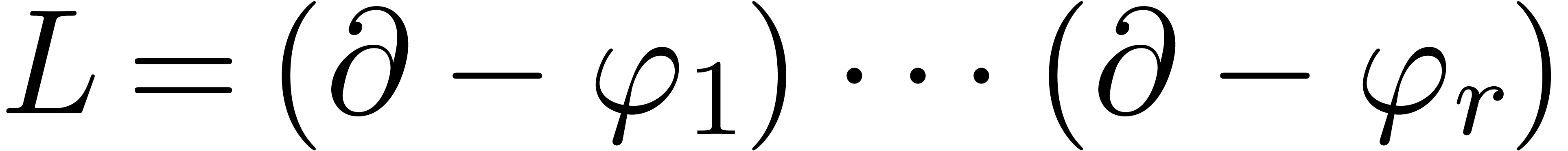

Tout opérateur  admet une

factorisation

admet une

factorisation  avec

avec  .

.

Tout opérateur  est le produit

d'opérateurs de la forme

est le produit

d'opérateurs de la forme  avec

avec  ou

ou  avec

avec  .

.

Remarque  .

.

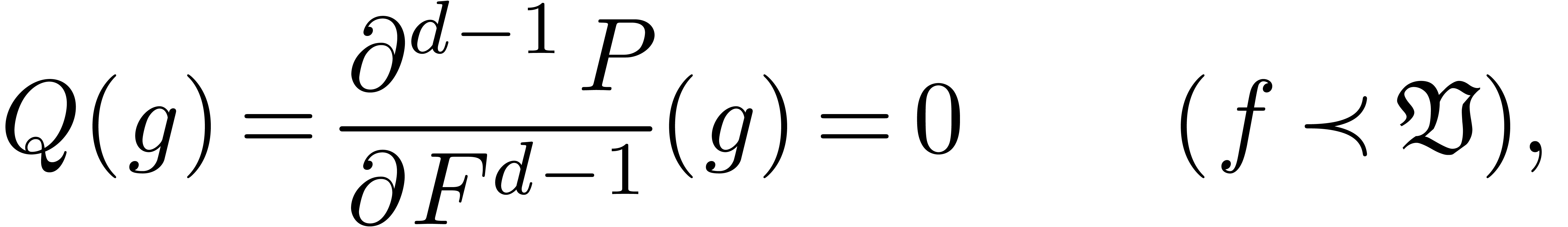

Soient  un polynôme différentiel et

un polynôme différentiel et

et étudions l'équation

différentielle asymptotique

et étudions l'équation

différentielle asymptotique

|

(1.2) |

Afin de généraliser la méthode des polygones de

Newton, il faut d'abord pouvoir trouver les débuts de solutions.

Cela nécessite en particulier la généralisation du

concept de terme débuteur. Modulo des conjugaisons

multiplicatives  avec

avec  , il suffit de pouvoir décider quand

, il suffit de pouvoir décider quand  est un monôme débuteur. Notons par

est un monôme débuteur. Notons par  le terme dominant de

le terme dominant de  en tant

que série dans

en tant

que série dans  et par

et par  l'unique polynôme différentiel avec

l'unique polynôme différentiel avec  pour tout

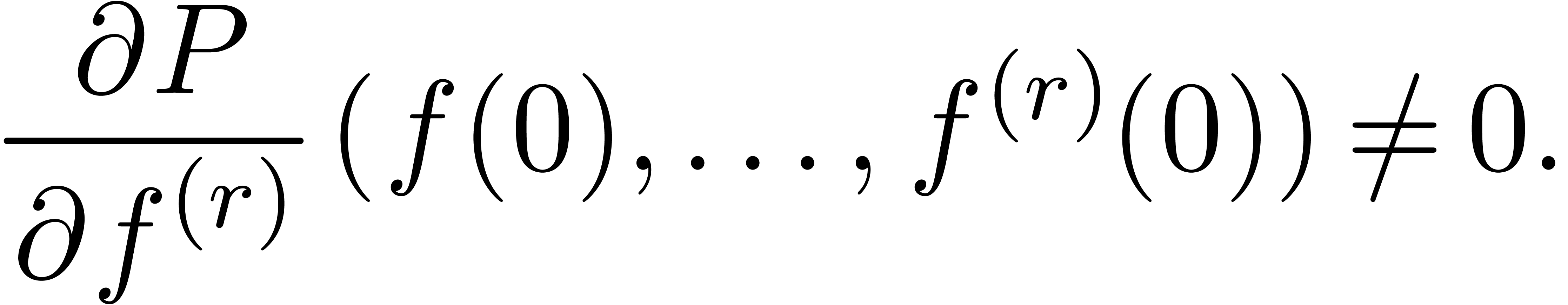

pour tout  . On a :

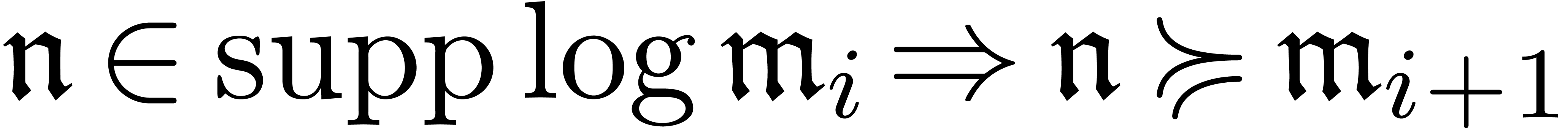

. On a :

. Alors il

existe un

. Alors il

existe un  et un

et un  tels que

tels que

pour tout

pour tout  suffisamment

grand.

suffisamment

grand.

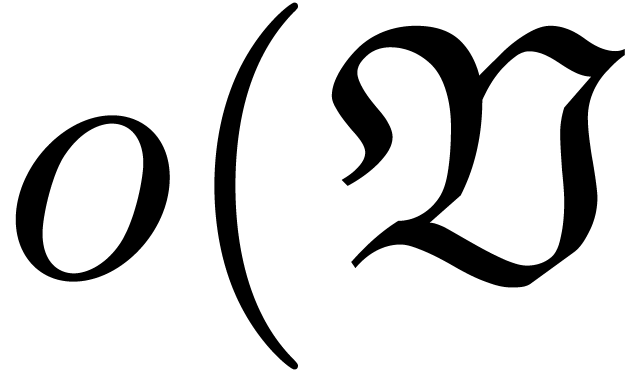

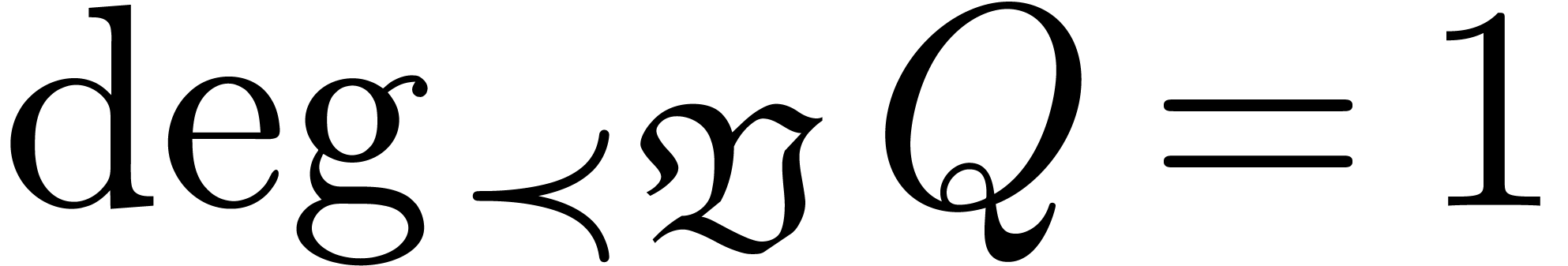

On appelle  polynôme de Newton

différentiel pour la pente

polynôme de Newton

différentiel pour la pente  .

Tout terme

.

Tout terme  avec

avec  est

appelé terme débuteur pour (1.2). On

définit

est

appelé terme débuteur pour (1.2). On

définit  . En

décomposant

. En

décomposant  en composantes

homogènes, les annulations dans (1.2) peuvent

provenir de deux ou plus de termes

en composantes

homogènes, les annulations dans (1.2) peuvent

provenir de deux ou plus de termes  et

et  différents ou d'annulations internes dans un seul

différents ou d'annulations internes dans un seul

. Les deux cas sont

traités par les propositions suivantes :

. Les deux cas sont

traités par les propositions suivantes :

avec

avec  et

et  pour

pour  . Alors il existe un

unique

. Alors il existe un

unique  tel que

tel que  ne soit

pas homogène.

ne soit

pas homogène.

homogène de degré

homogène de degré  et

considérons le polynôme de Riccati

et

considérons le polynôme de Riccati  associé avec

associé avec  . Alors

le monôme

. Alors

le monôme  est un débuteur pour

est un débuteur pour

|

(1.3) |

admet un degré de Newton strictement positif.

La proposition 1.19 admettant une variante constructive et

l'ordre de l'équation (1.3) étant un de moins

que l'ordre de

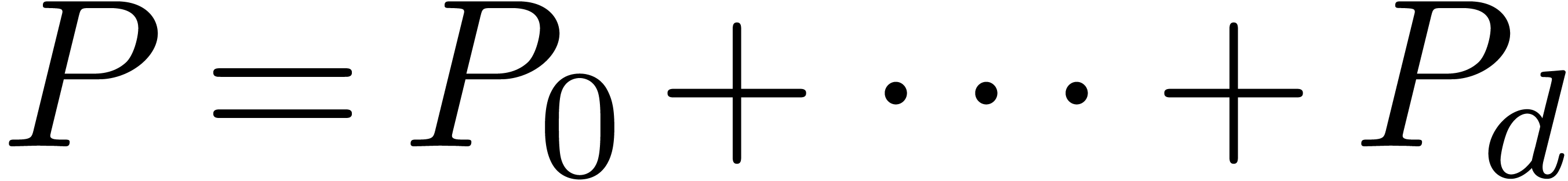

La notion d'« algorithme théorique » étant un

peu vague, on peut chercher à capturer les fruits de notre

méthode dans des théorèmes de structure plus

précis. Tout d'abord, on peut borner le nombre de nouveaux

logarithmes et exponentielles dont on a besoin pour exprimer les

solutions [117, Section 8.8]. Deuxièmement, pendant

tout le processus de résolution, on conserve la

propriété pour les supports d'être

réticulé : lorsque l'on cherche des solutions dans des

corps de transséries bien ordonnés plus grands (voir le

chapitre 2), on ne trouvera pas davantage de solutions. En

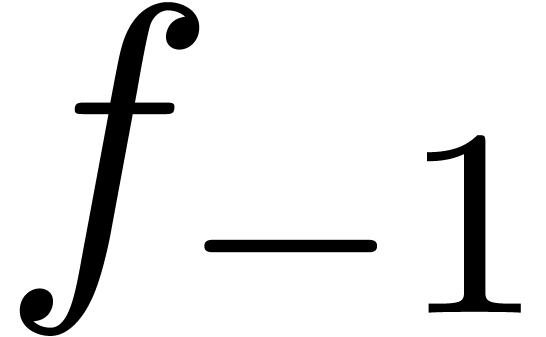

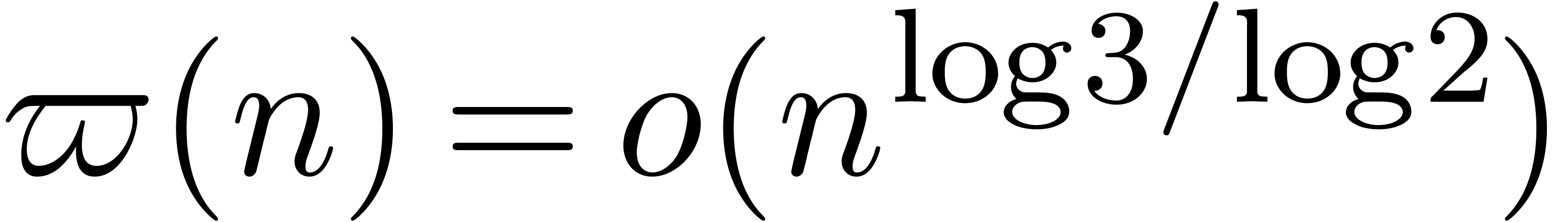

particulier, des séries comme  ou

ou  ) sont différentiellement

transcendantes sur

) sont différentiellement

transcendantes sur  (voir aussi [44]).

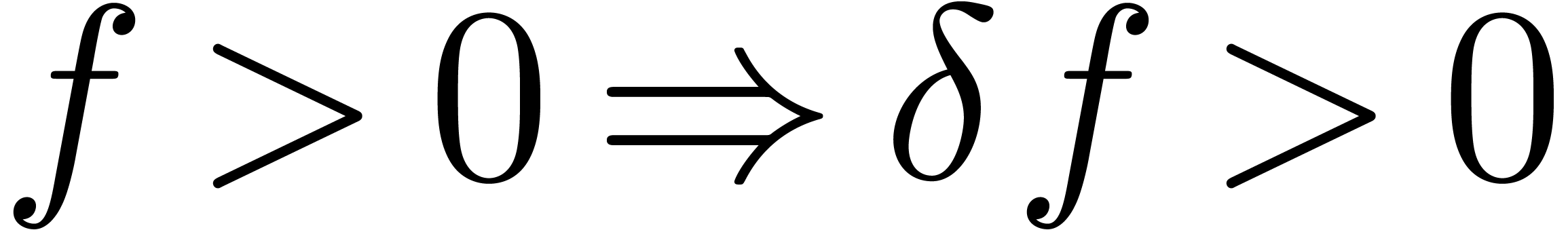

Le théorème de structure le plus intéressant est le

suivant :

(voir aussi [44]).

Le théorème de structure le plus intéressant est le

suivant :

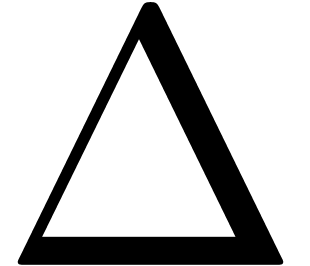

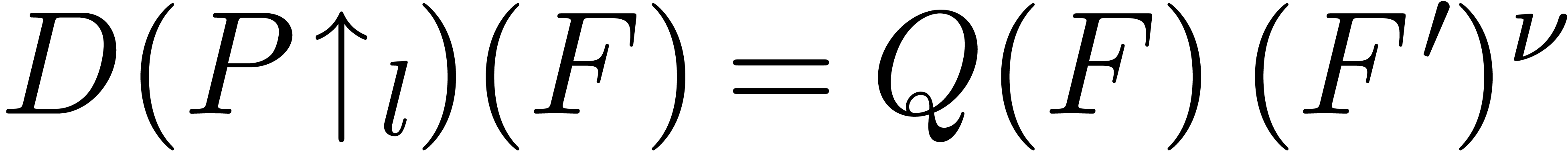

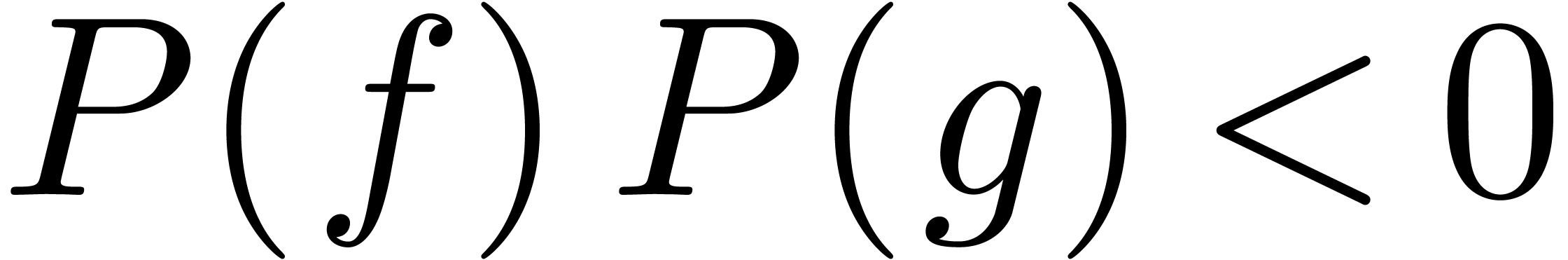

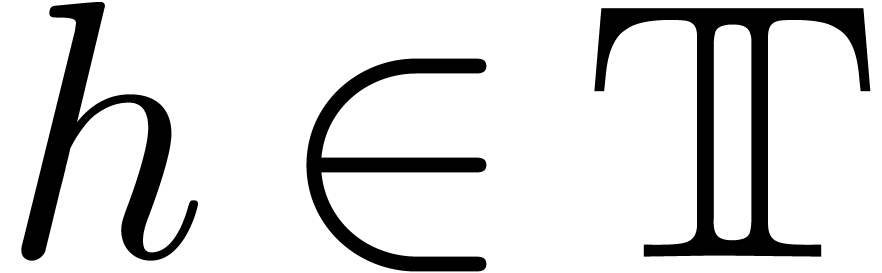

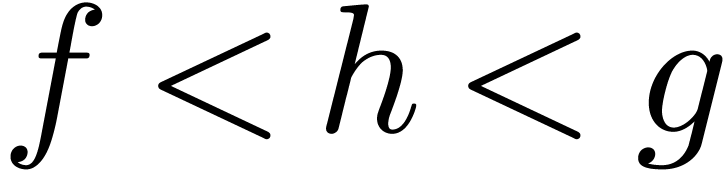

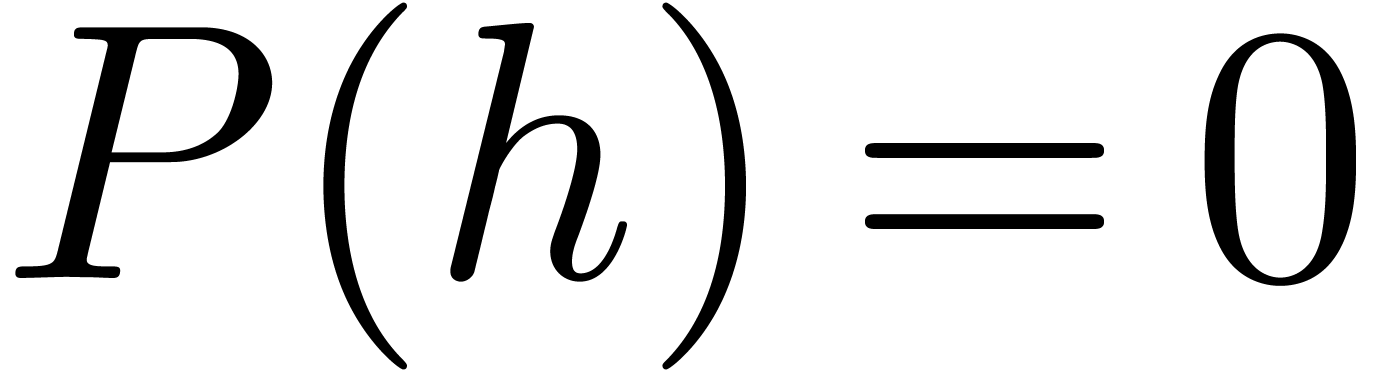

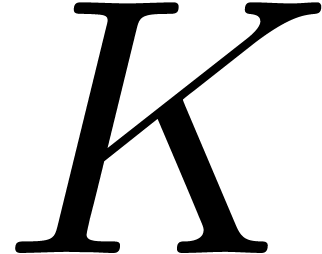

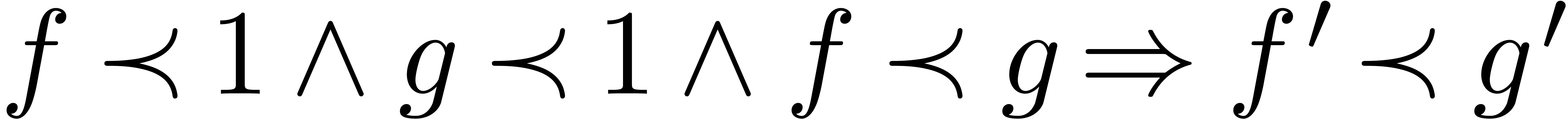

et

et

tels que

tels que  et

et  . Alors il existe un

. Alors il existe un  avec

avec  et

et  .

.

Démonstration. La démonstration s'appuie

sur une étude précise de la complétion  de

de  avec des coupures de Dedekind.

Dans [117, Chapitre 9] on donne deux classifications des

éléments de

avec des coupures de Dedekind.

Dans [117, Chapitre 9] on donne deux classifications des

éléments de  et on étudie le

comportement de polynômes différentiels autour des points

dans

et on étudie le

comportement de polynômes différentiels autour des points

dans  . En déroulant la

méthode des polygones de Newton, cela permet en particulier de

conserver la propriété de changement de signe

. En déroulant la

méthode des polygones de Newton, cela permet en particulier de

conserver la propriété de changement de signe  sur des intervalles dans

sur des intervalles dans  de plus

en plus petits.

de plus

en plus petits.

de degré impair admet une racine dans

de degré impair admet une racine dans

.

.

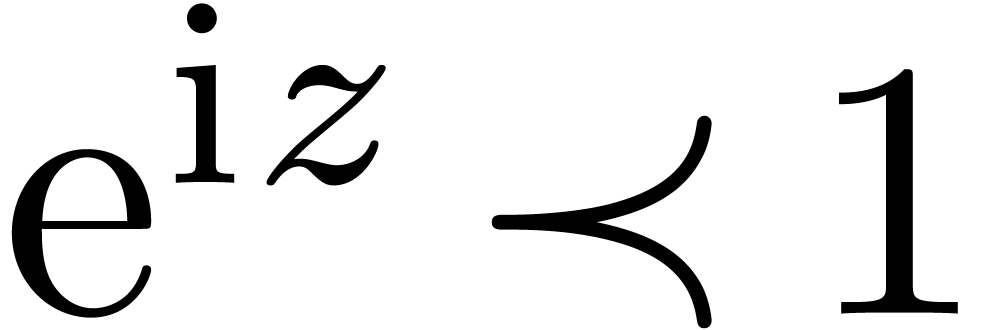

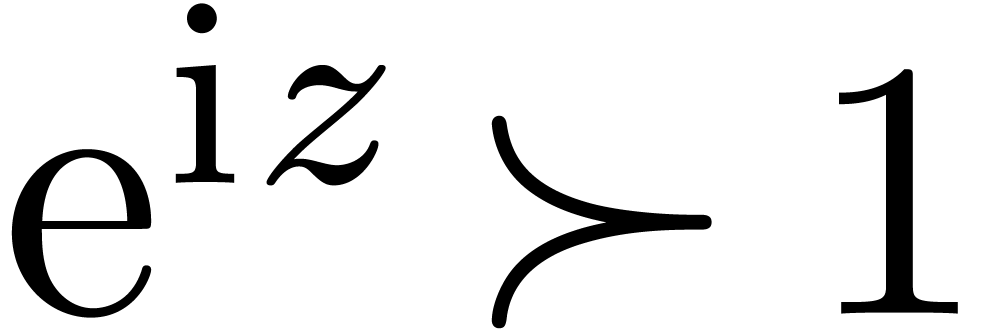

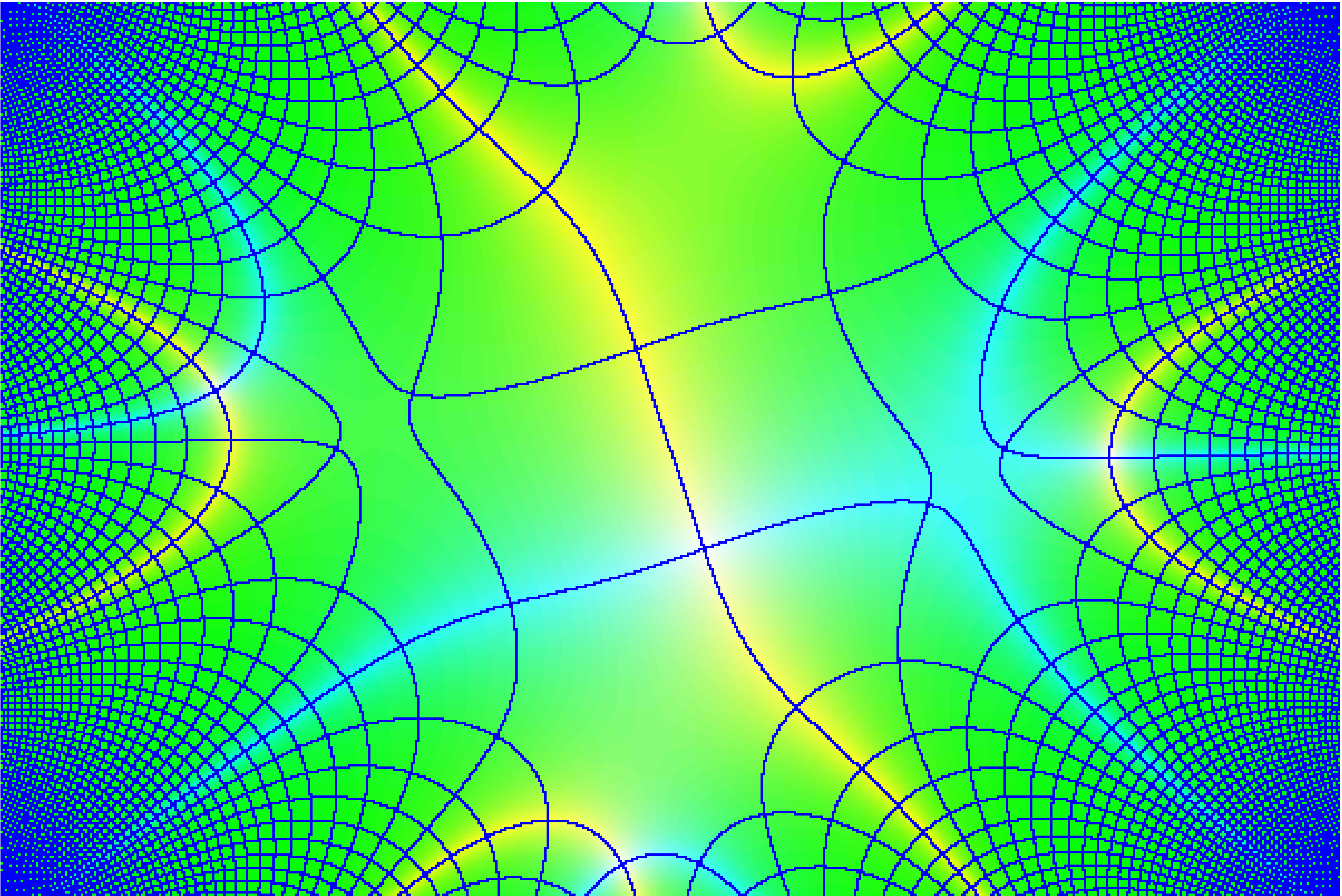

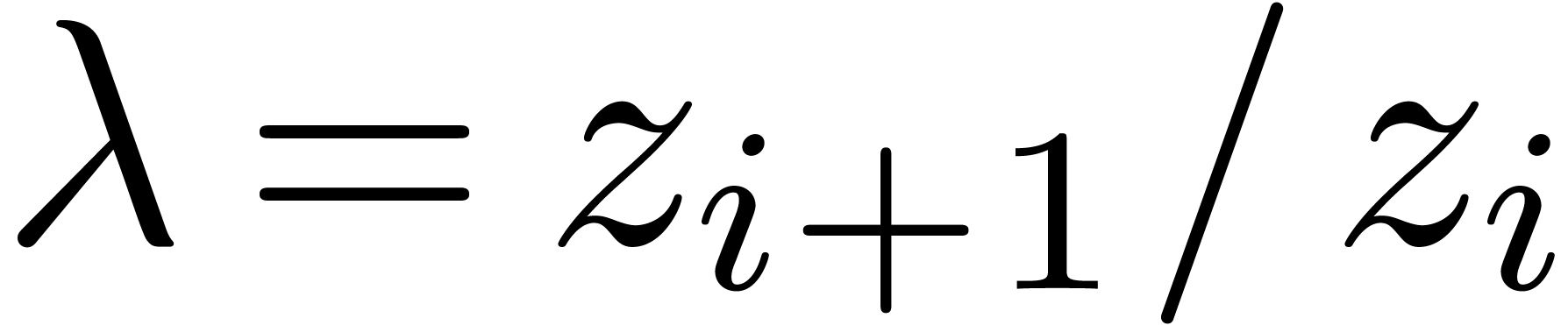

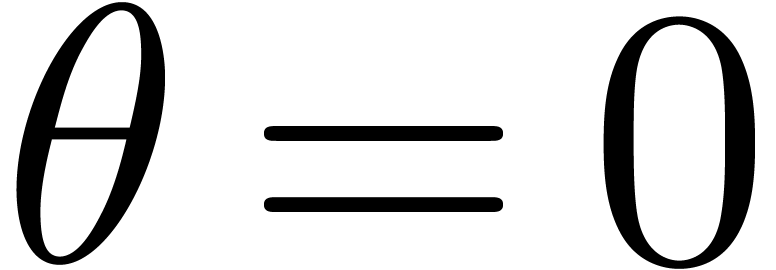

Il est naturel de chercher une contre-partie complexe à la

théorie des transséries. Bien que cela nous fait

clairement perdre la structure de corps totalement ordonné, on

peut espérer conserver l'essentiel, à savoir l'ordre

asymptotique  et sa compatibilité avec la

dérivation. Toutefois, une telle construction n'a aucune chance

d'être canonique : il faudrait par exemple décider si

et sa compatibilité avec la

dérivation. Toutefois, une telle construction n'a aucune chance

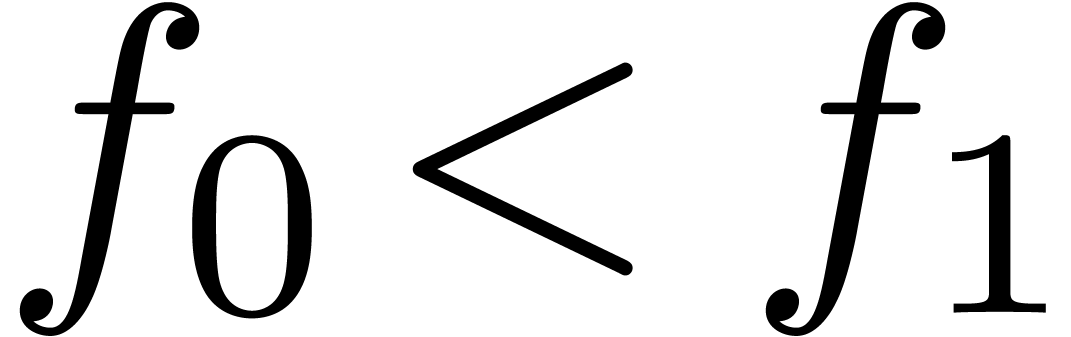

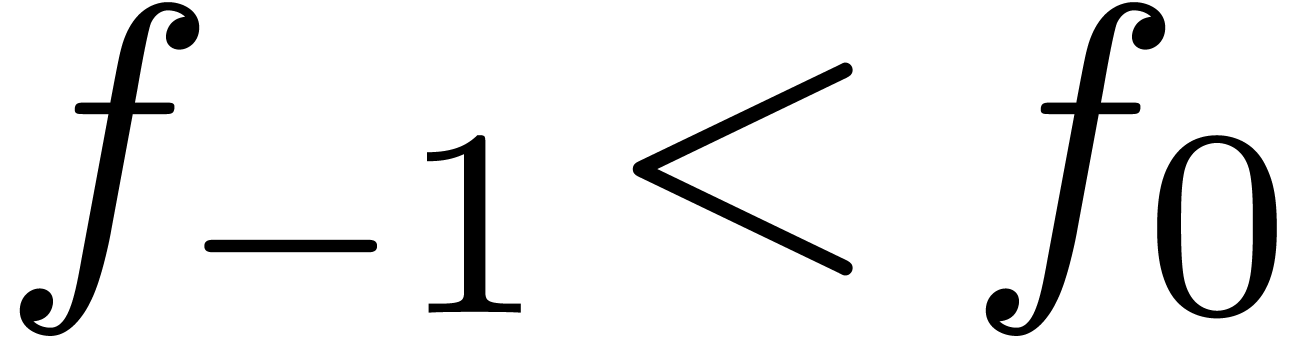

d'être canonique : il faudrait par exemple décider si  ou

ou  , et

aucun des deux choix n'est à privilégier sur l'autre. Dans

[100, Section 2] nous montrons comment

généraliser la construction de la section 1.4

au cas complexe, modulo une infinité de choix du genre

, et

aucun des deux choix n'est à privilégier sur l'autre. Dans

[100, Section 2] nous montrons comment

généraliser la construction de la section 1.4

au cas complexe, modulo une infinité de choix du genre  ou

ou  .

.

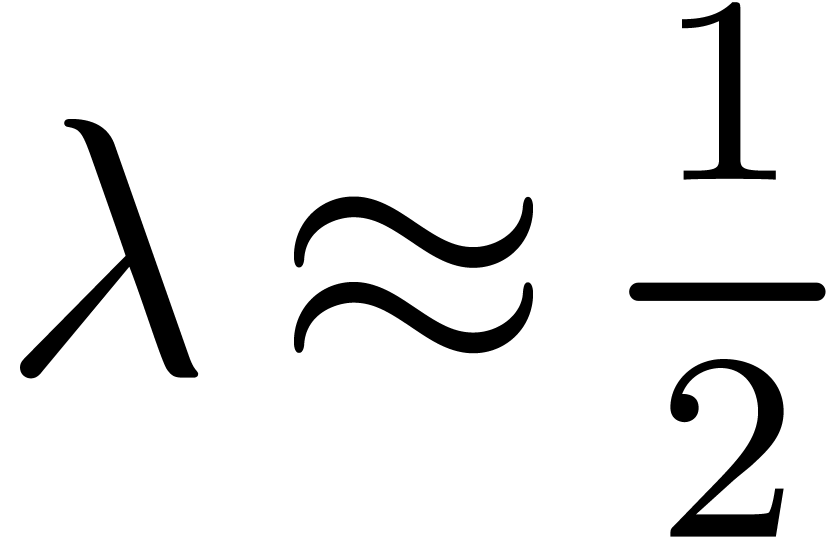

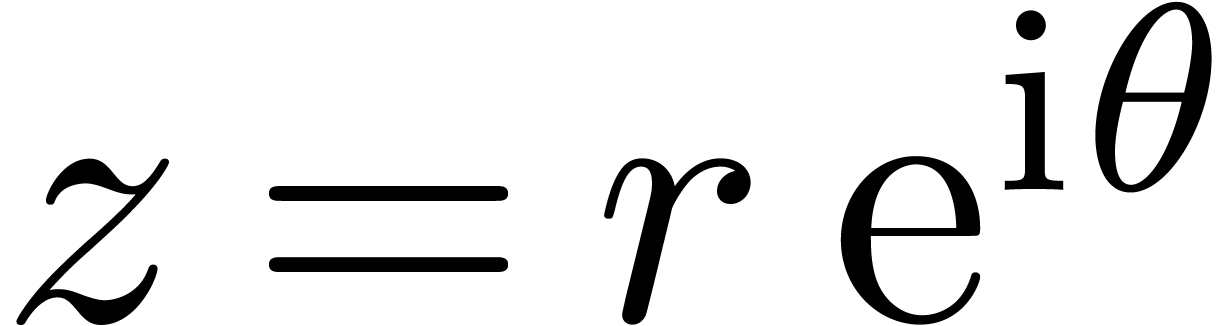

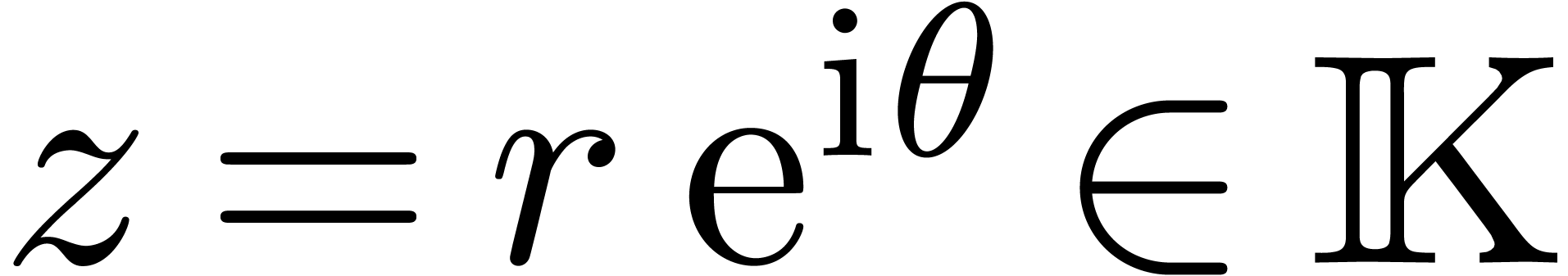

Plus précisément, on aura  ,

où

,

où  est un

est un  -espace

vectoriel totalement ordonné pour l'action

-espace

vectoriel totalement ordonné pour l'action  ainsi qu'un

ainsi qu'un  -espace vectoriel

(non ordonné). Comme dans le cas réel, l'ordre sur

-espace vectoriel

(non ordonné). Comme dans le cas réel, l'ordre sur  vient d'un ordre total sur

vient d'un ordre total sur  via le logarithme

via le logarithme  .

Bien que l'ordre total sur

.

Bien que l'ordre total sur  ne puisse provenir

d'une structure de corps totalement ordonné sur

ne puisse provenir

d'une structure de corps totalement ordonné sur  , on peut exiger que la positivité d'un

élément

, on peut exiger que la positivité d'un

élément  soit décidable

à partir de son coefficient dominant

soit décidable

à partir de son coefficient dominant  . L'ordre sur

. L'ordre sur  est donc

caractérisé par le choix d'un ordre total

est donc

caractérisé par le choix d'un ordre total  sur

sur  pour chaque

pour chaque  ,

après quoi

,

après quoi  . L'ordre

. L'ordre

vérifie

vérifie  pour tout

pour tout

et est caractérisé par un angle et

une direction

et est caractérisé par un angle et

une direction  .

.

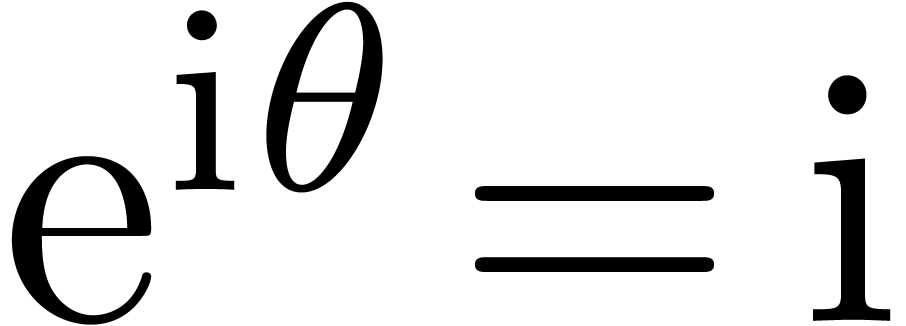

Les résultats des sections 1.5 et 1.6 se généralisent au cadre complexe et donnent lieu aux théorèmes suivants :

avec

avec  admet un

système fondamental de solutions dans

admet un

système fondamental de solutions dans  .

.

admet au moins

admet au moins  solutions, en comptant avec multiplicités.

solutions, en comptant avec multiplicités.

En particulier, le corps  est Picard-Vessiot

clos, ce qui le rend idéal pour la résolution

récursive d'équations différentielles

linéaires. En revanche, le théorème 1.25

n'implique pas que

est Picard-Vessiot

clos, ce qui le rend idéal pour la résolution

récursive d'équations différentielles

linéaires. En revanche, le théorème 1.25

n'implique pas que  soit

différentiellement clos, car l'espace des solutions d'une

équation d'ordre

soit

différentiellement clos, car l'espace des solutions d'une

équation d'ordre  n'a pas forcément

la bonne dimension

n'a pas forcément

la bonne dimension  . Par

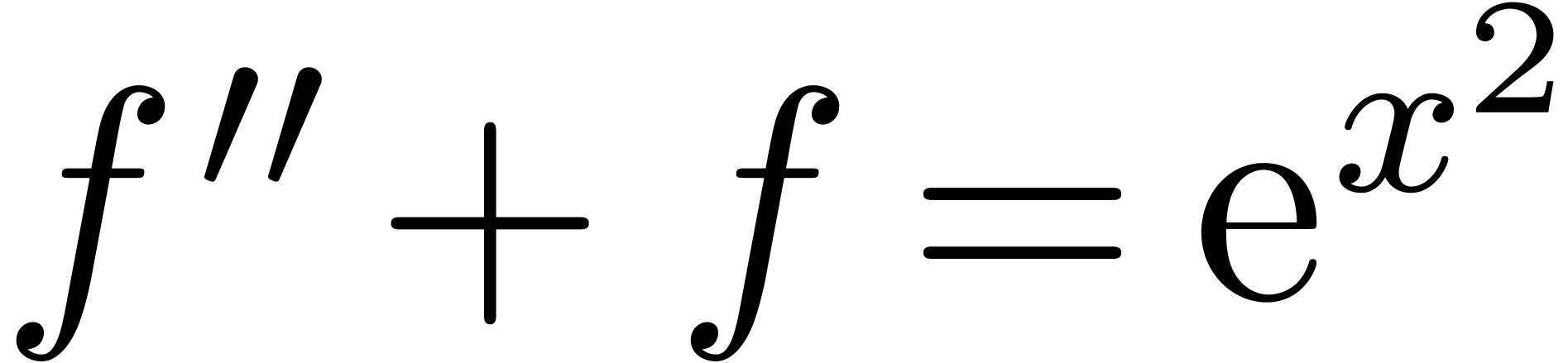

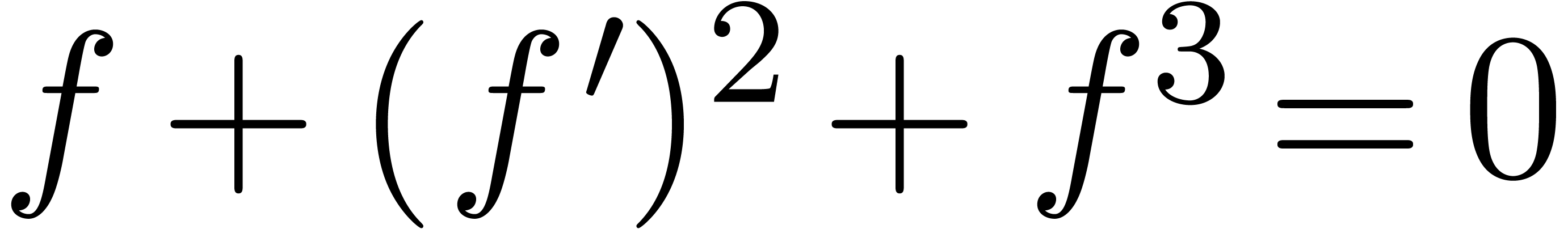

exemple, l'équation elliptique

. Par

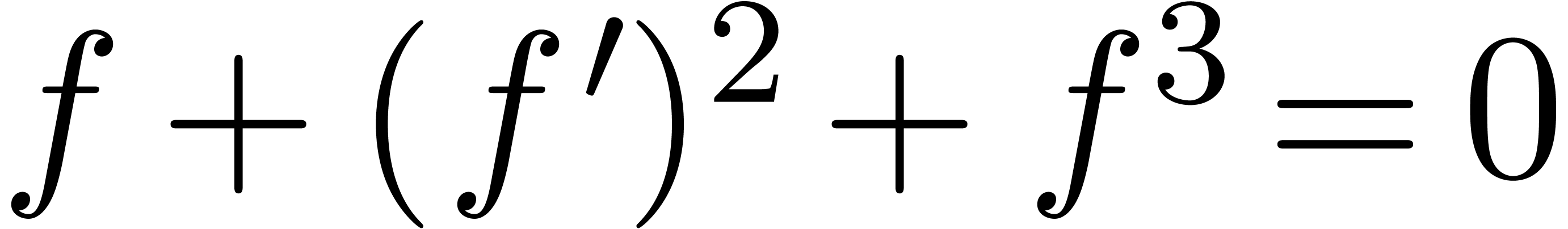

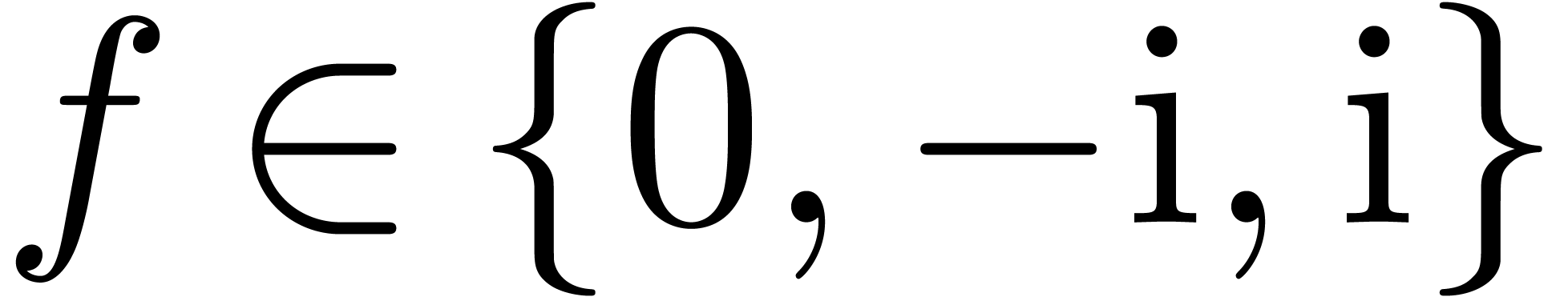

exemple, l'équation elliptique

|

(1.4) |

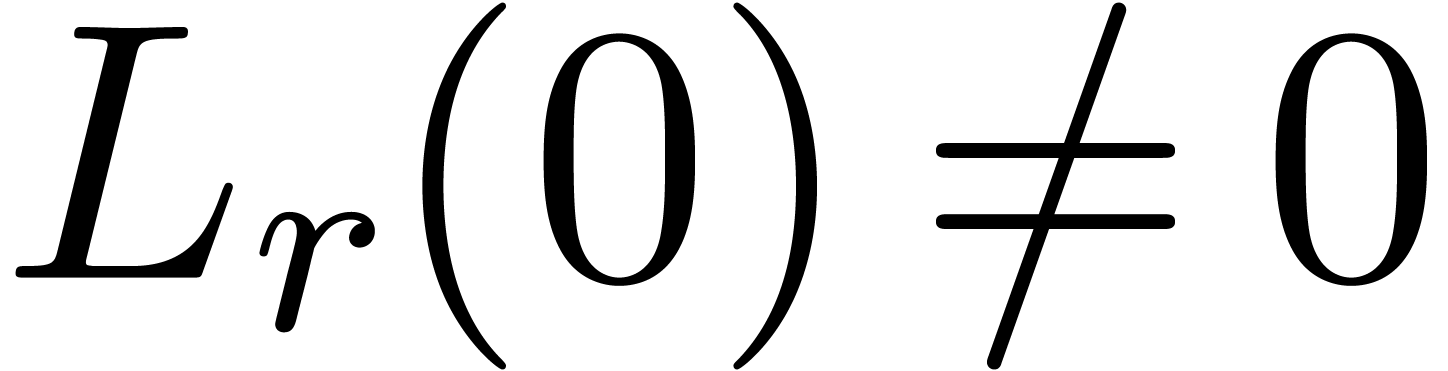

n'admet que les trois solutions triviales  .

Toutefois, le théorème 1.12 garde un certain

intérêt en soi et intervient par exemple dans un nouveau

test à zéro (voir le théorème 4.8).

.

Toutefois, le théorème 1.12 garde un certain

intérêt en soi et intervient par exemple dans un nouveau

test à zéro (voir le théorème 4.8).

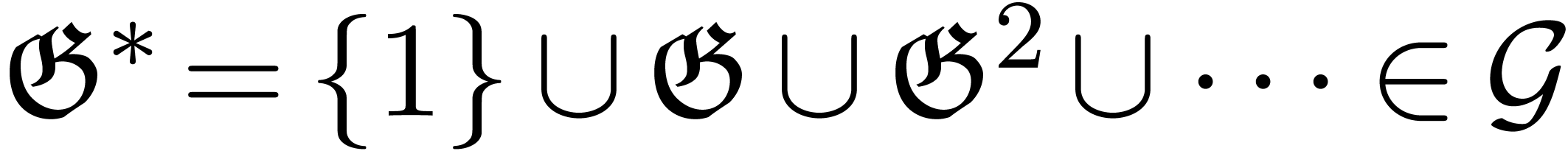

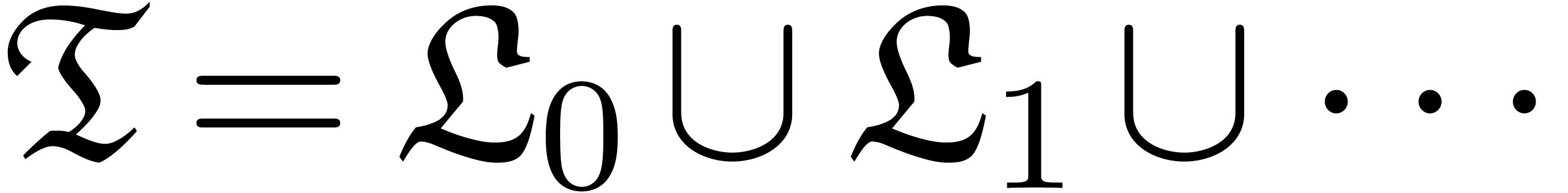

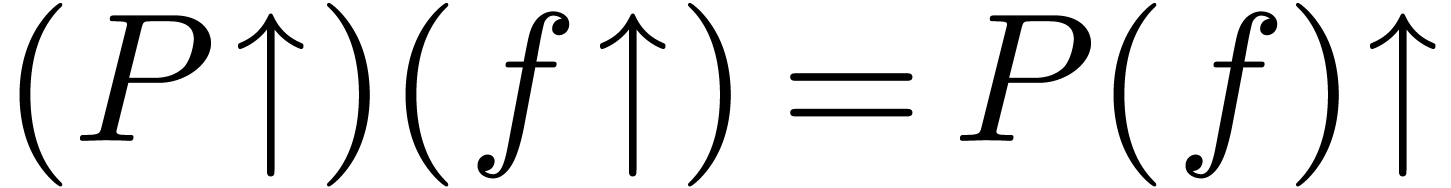

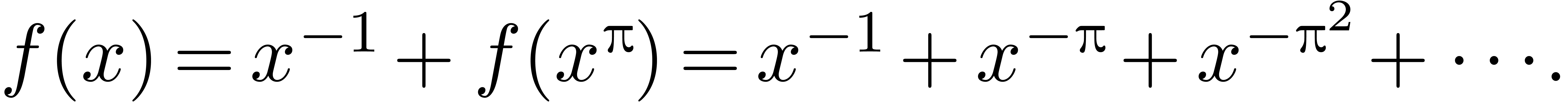

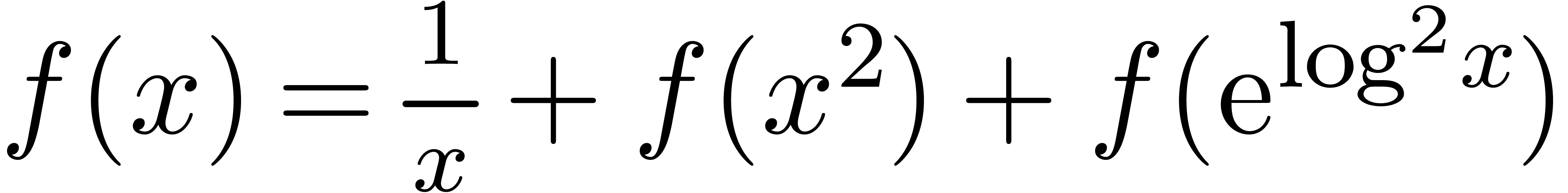

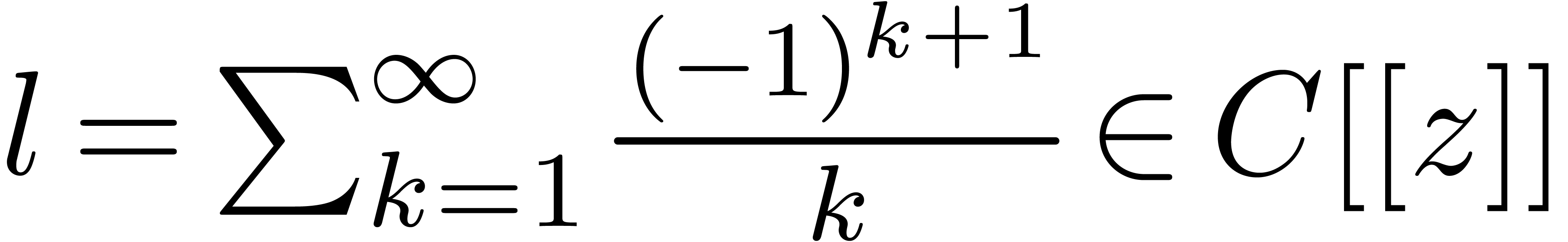

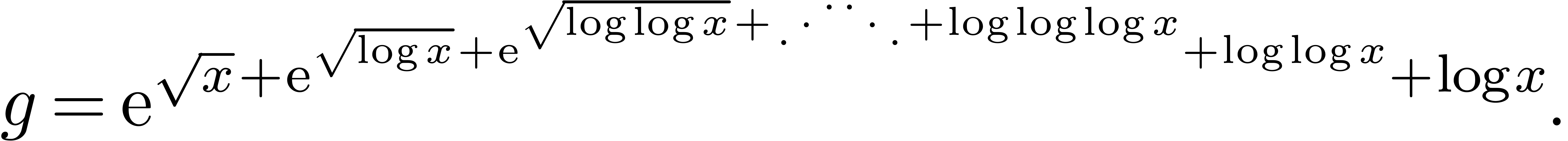

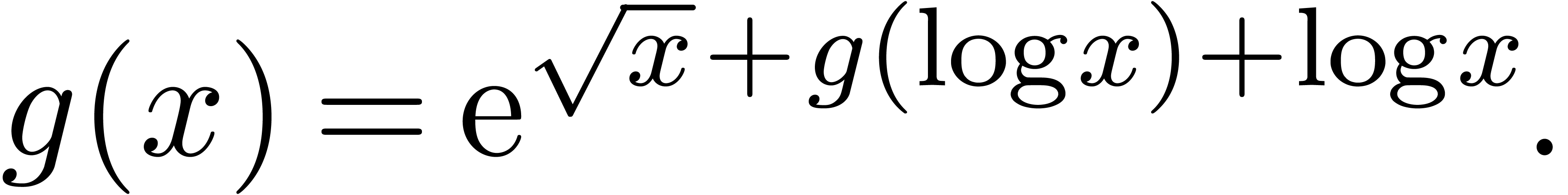

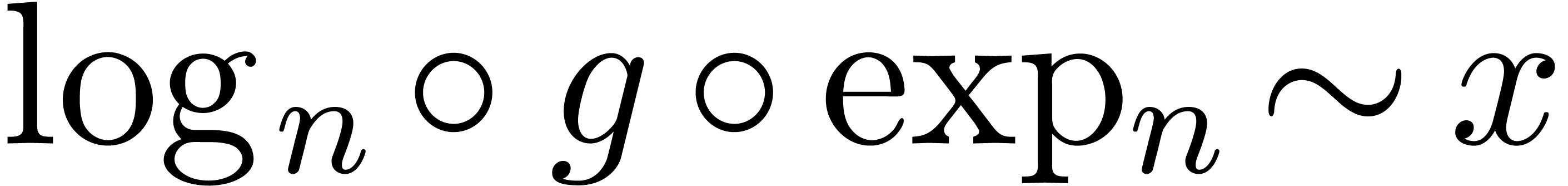

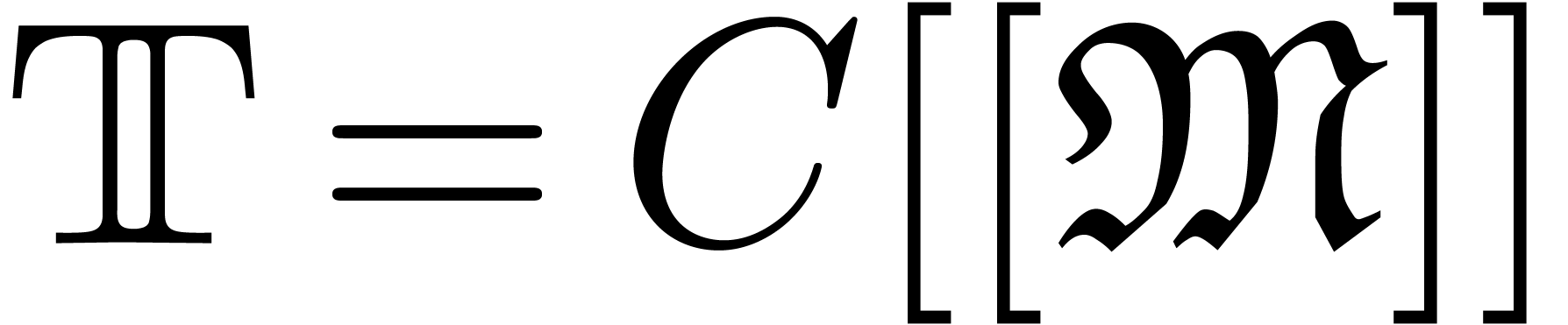

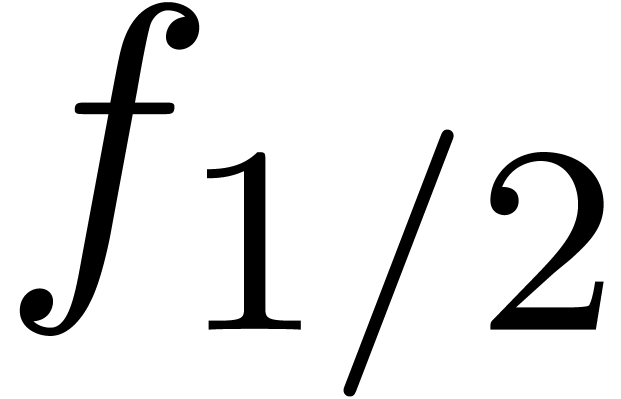

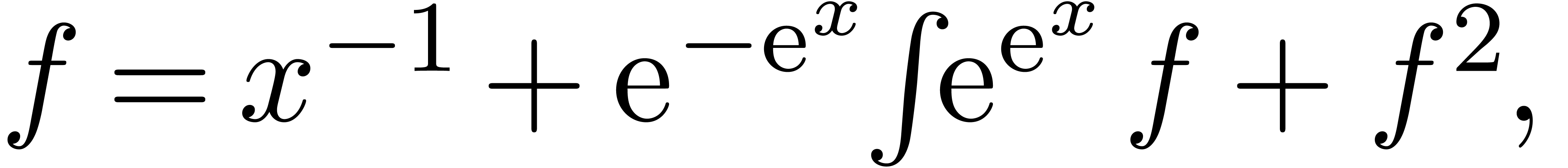

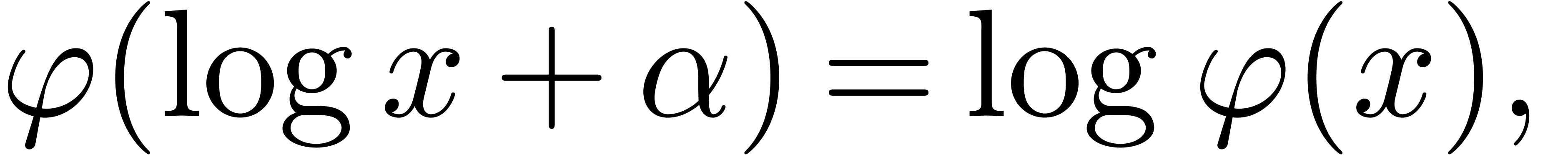

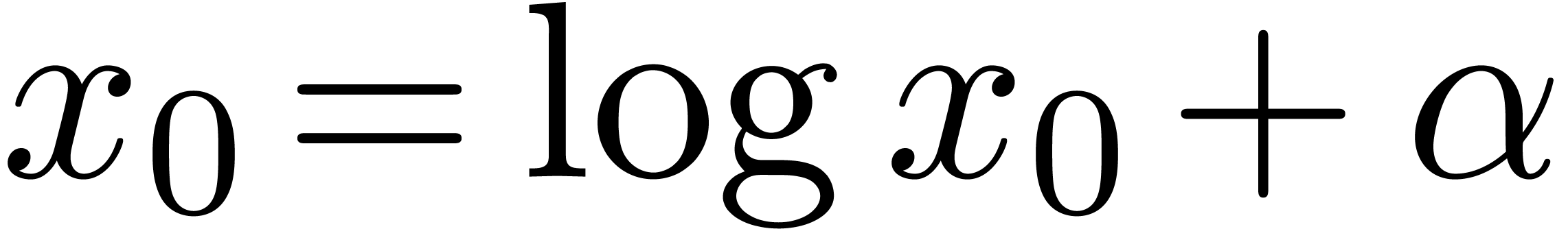

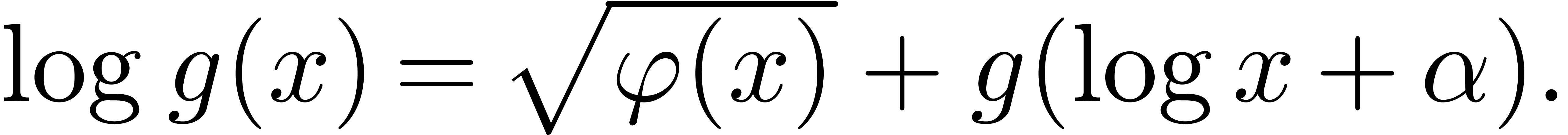

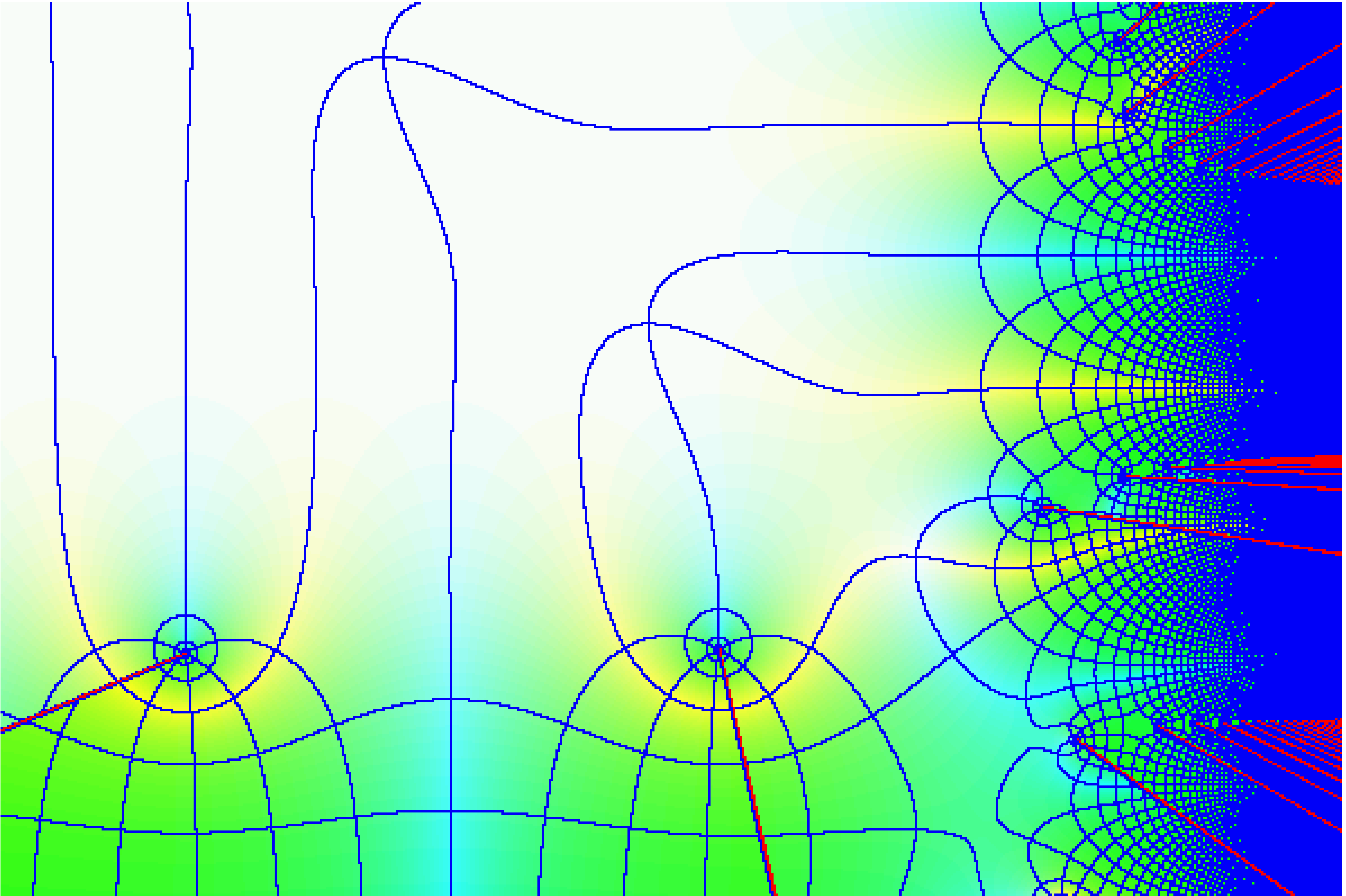

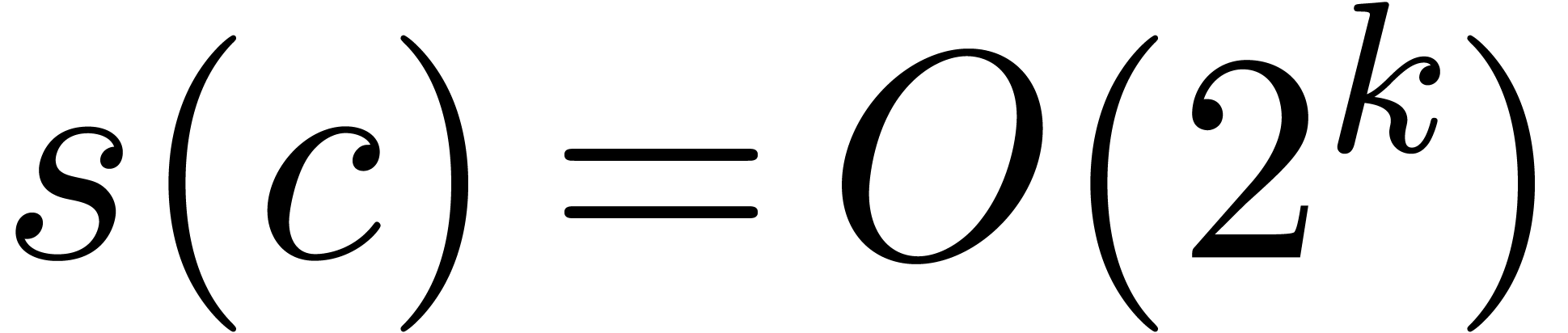

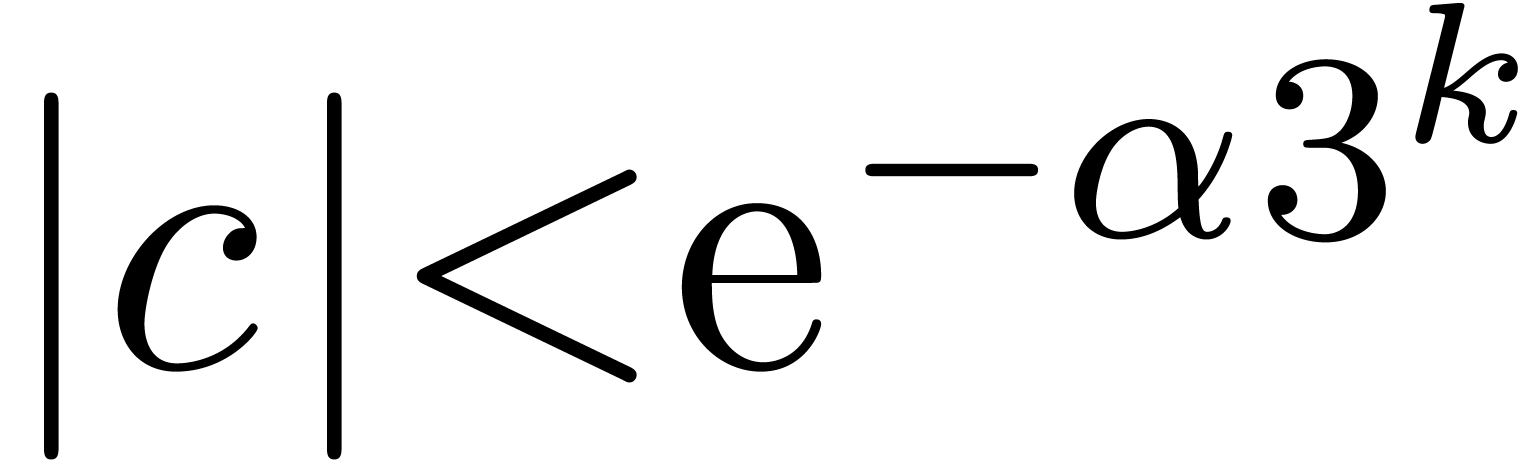

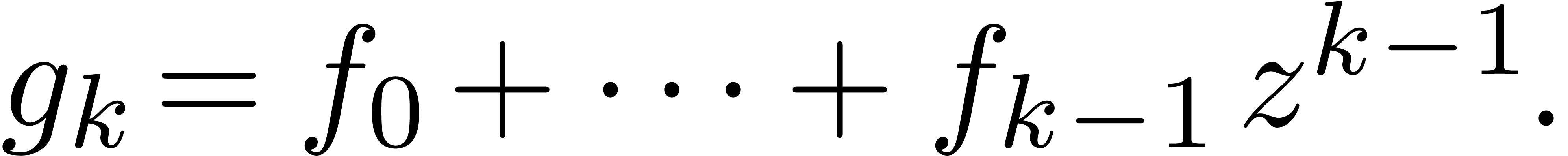

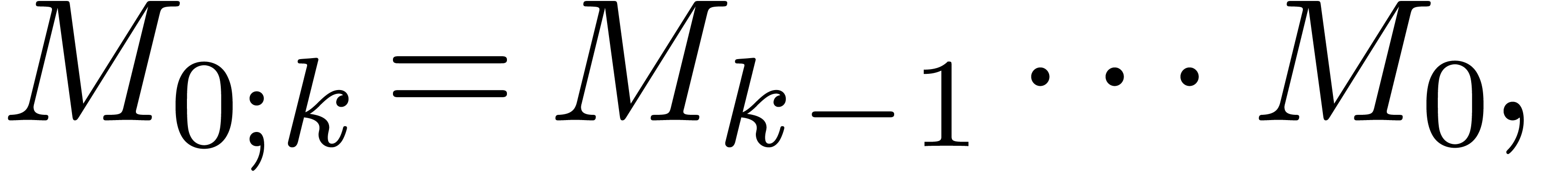

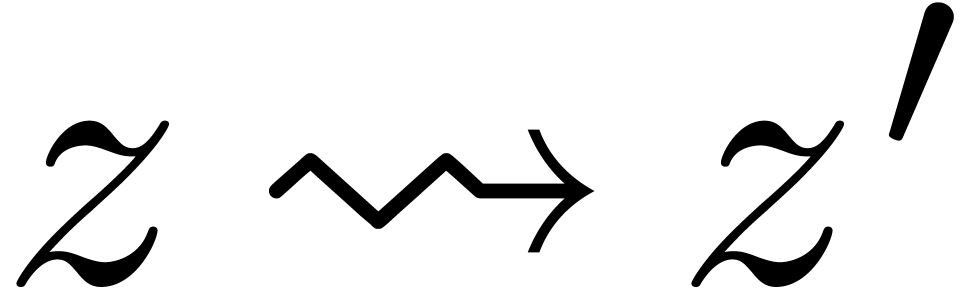

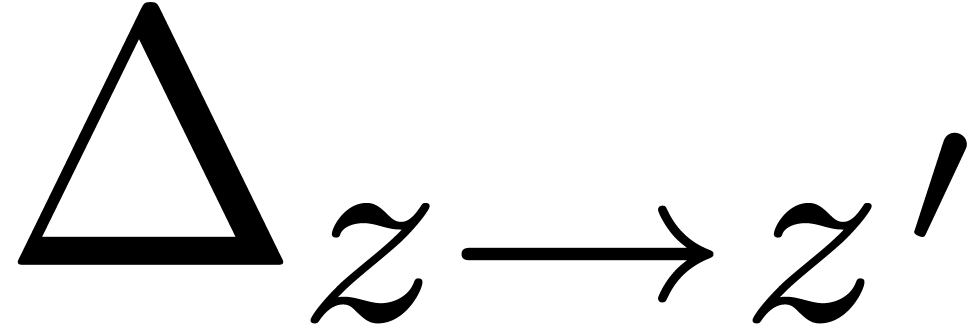

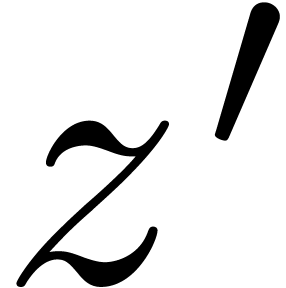

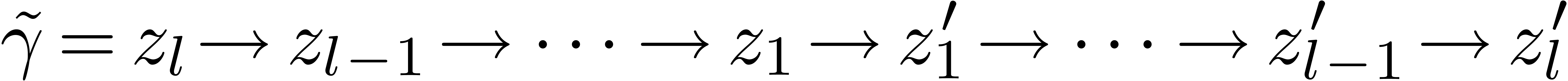

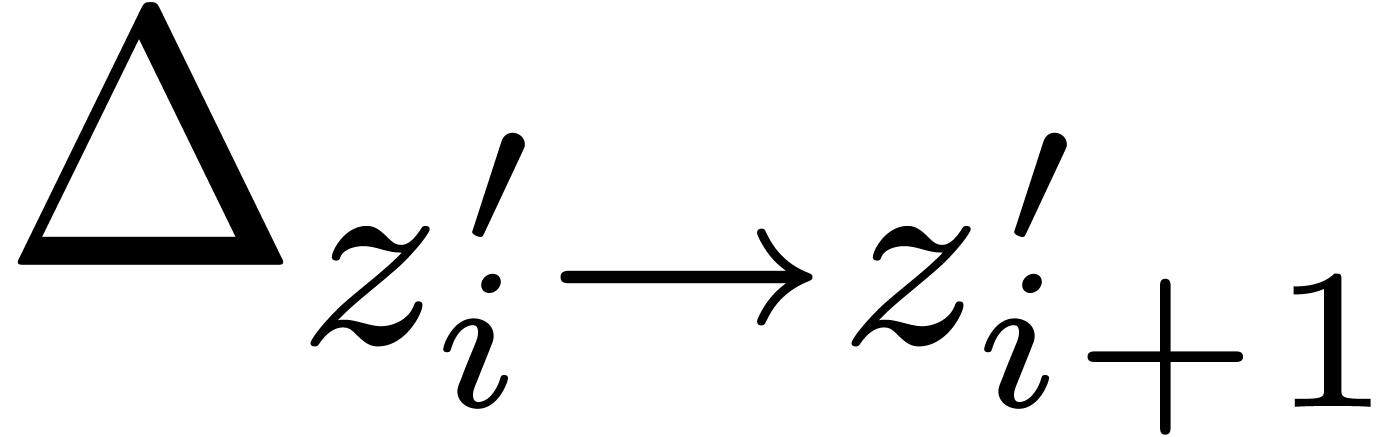

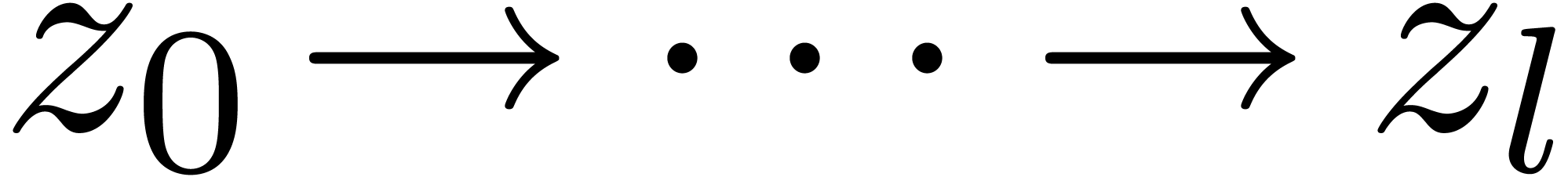

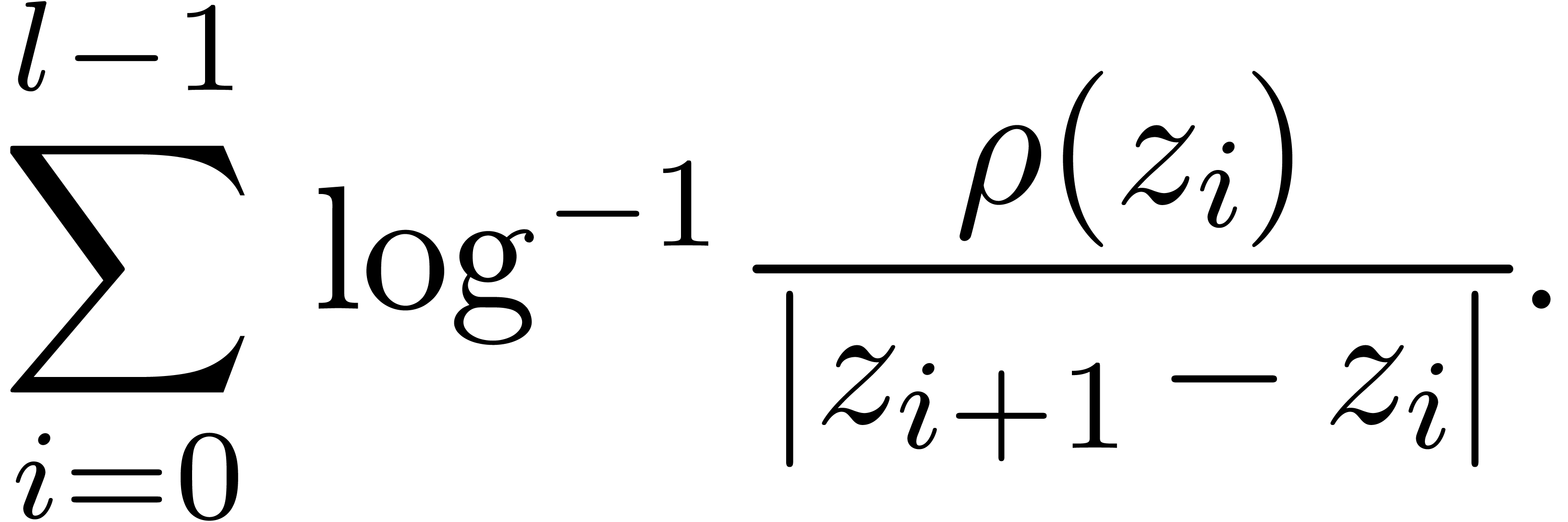

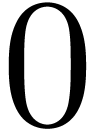

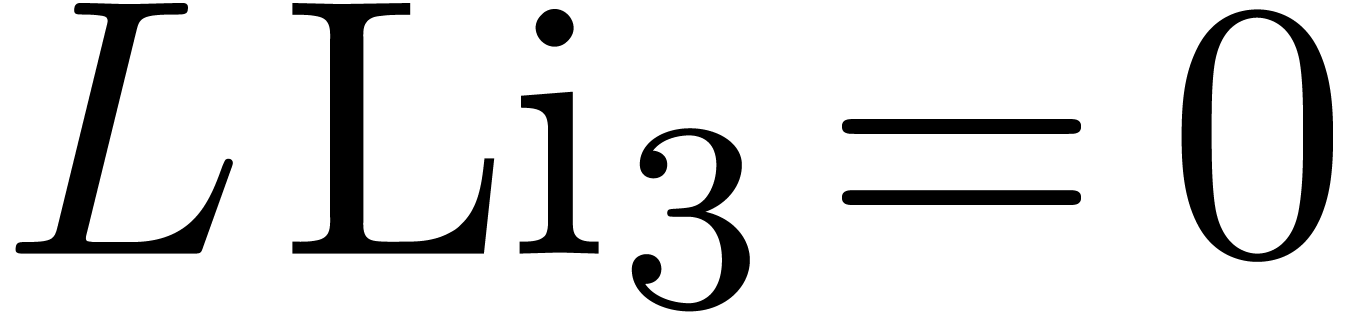

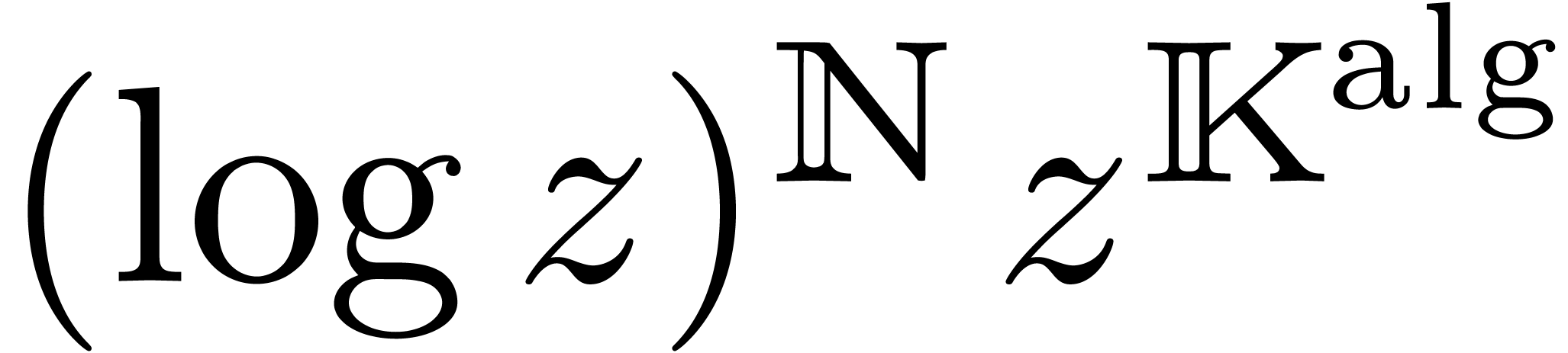

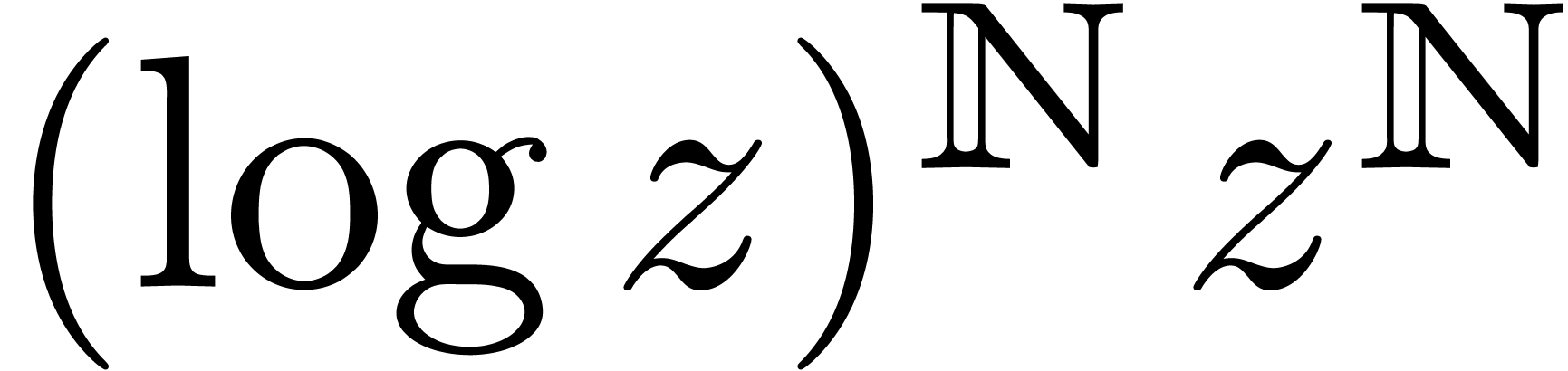

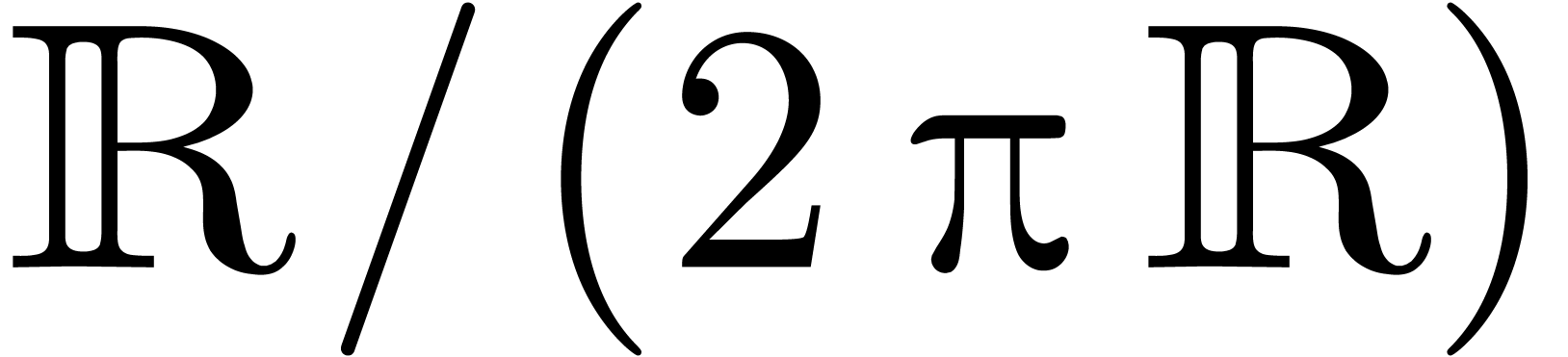

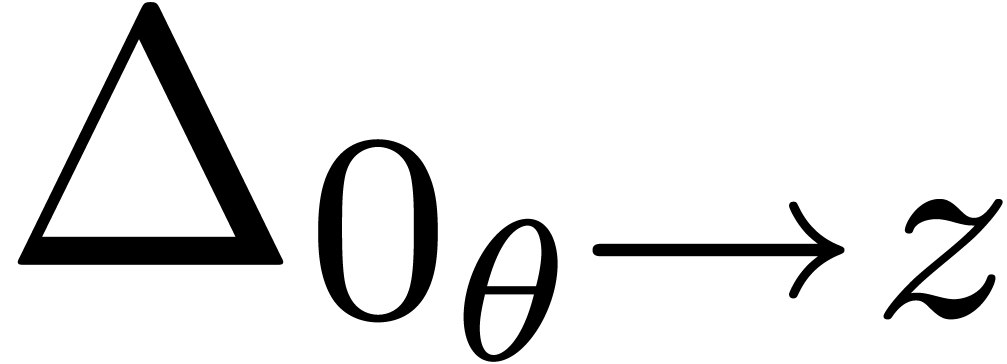

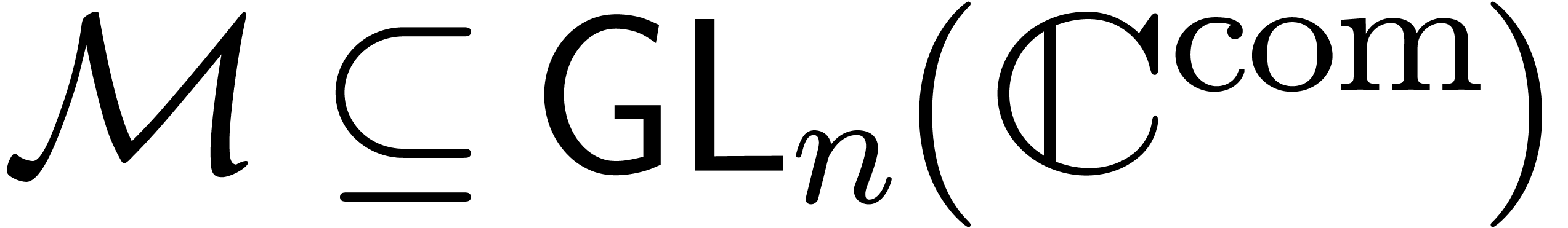

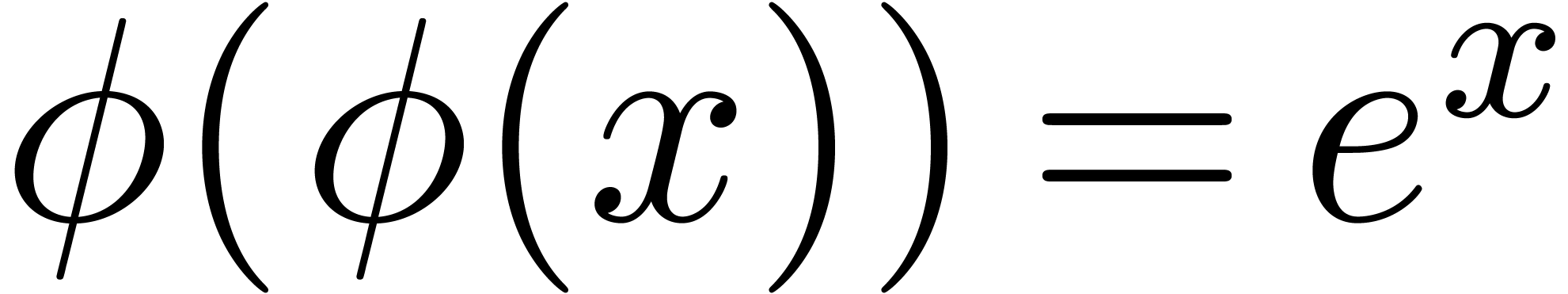

On a vu dans le chapitre précédent comment résoudre des équations différentielles à l'aide de transséries réticulées. Les solutions d'équations fonctionnelles simples admettent des solutions dont les supports ne sont pas réticulés, comme

L'élaboration d'une théorie complète pour ce genre d'équations fonctionnelles plus générales comprend les étapes suivantes :

Faire l'inventaire des différents types d'équations fonctionnelles que l'on aimerait pouvoir résoudre et les types de solutions en transséries correspondants.

Construire les corps de transséries correspondant aux différents cadres, et les munir des opérations habituelles.

Généraliser la méthode des polygones de Newton et le théorème 1.22 des valeurs intermédiaires.

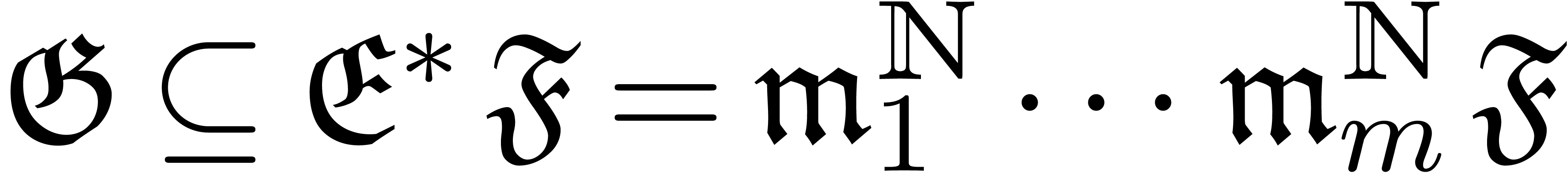

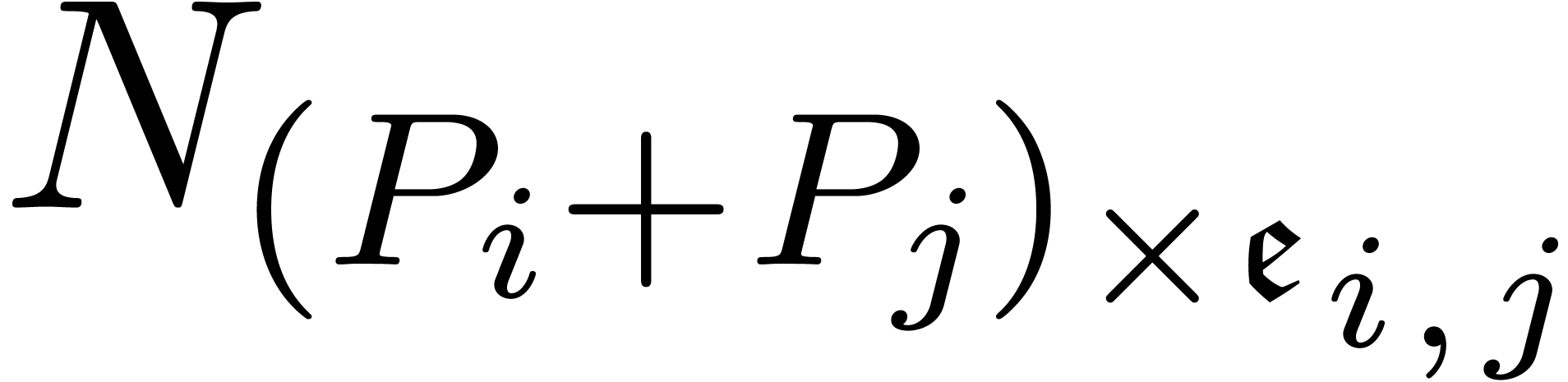

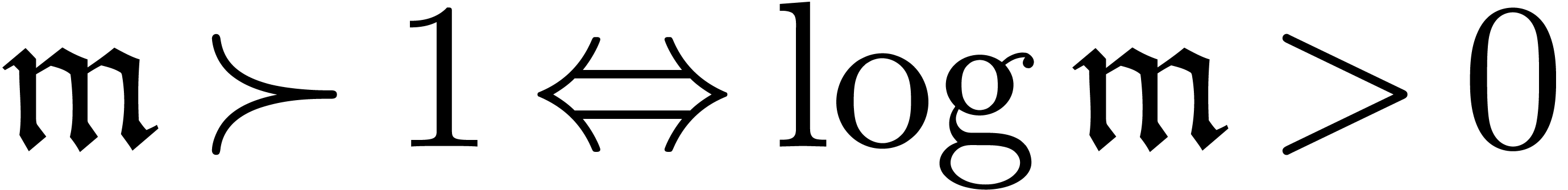

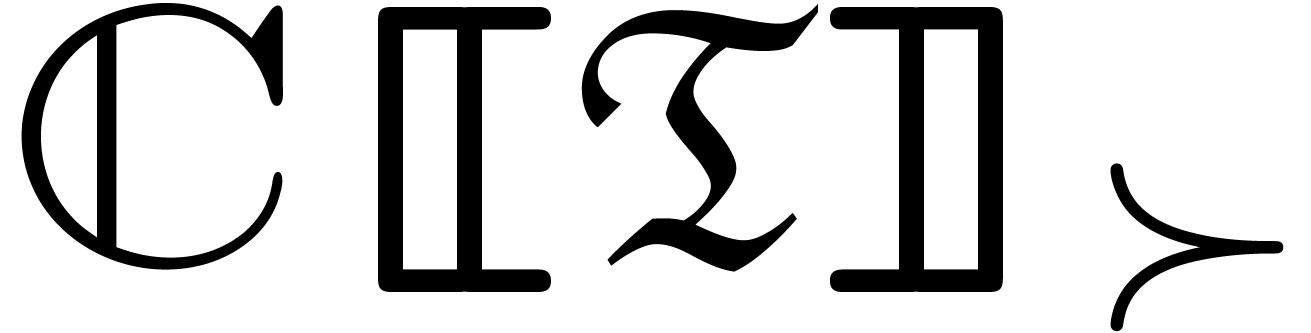

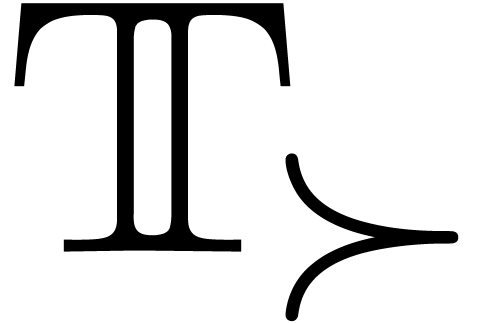

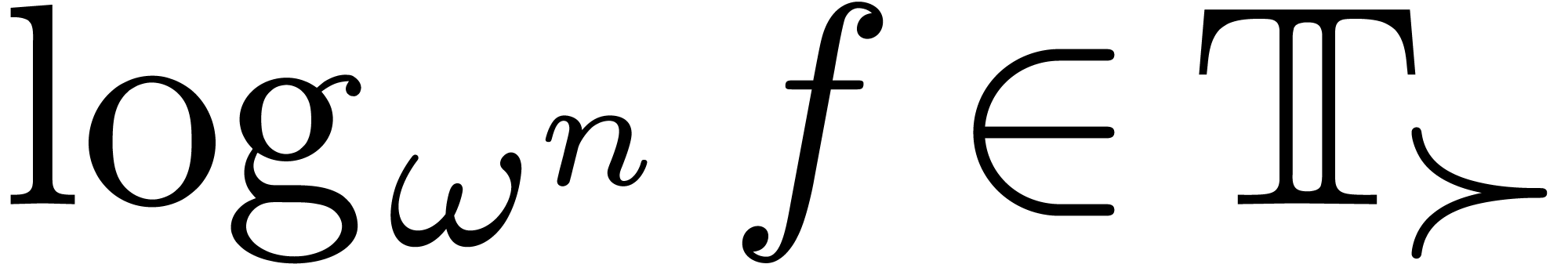

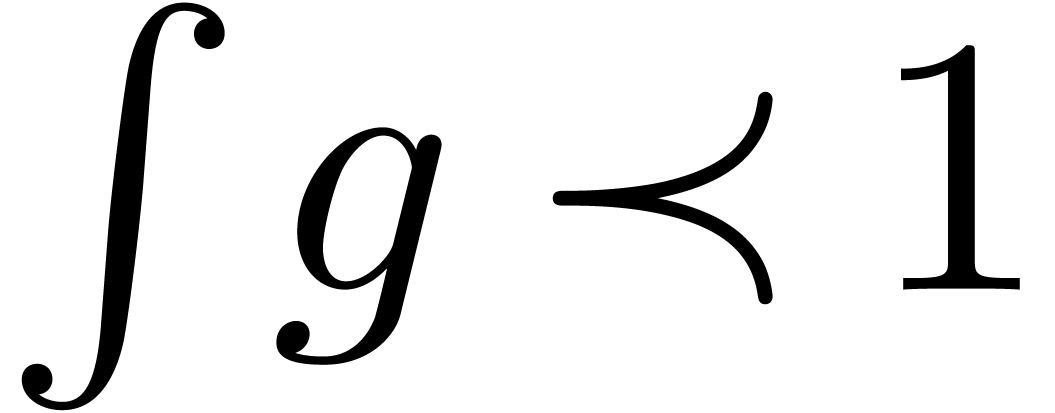

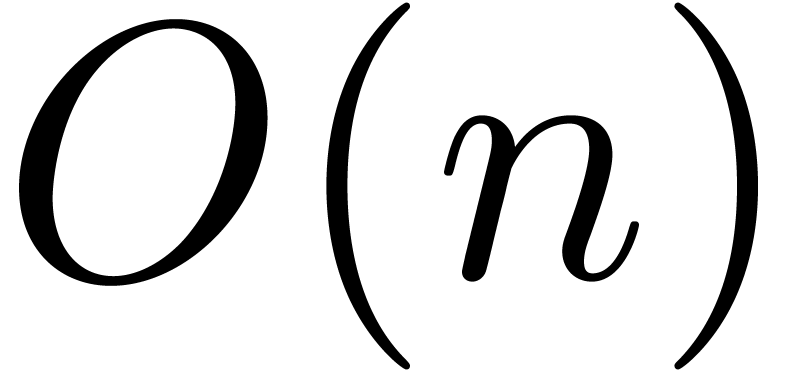

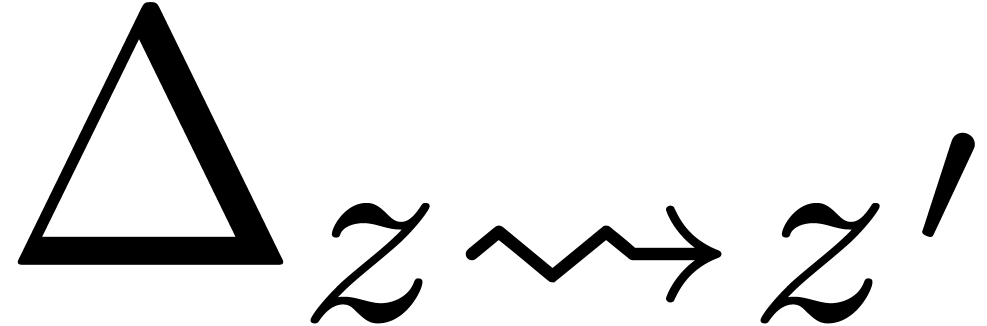

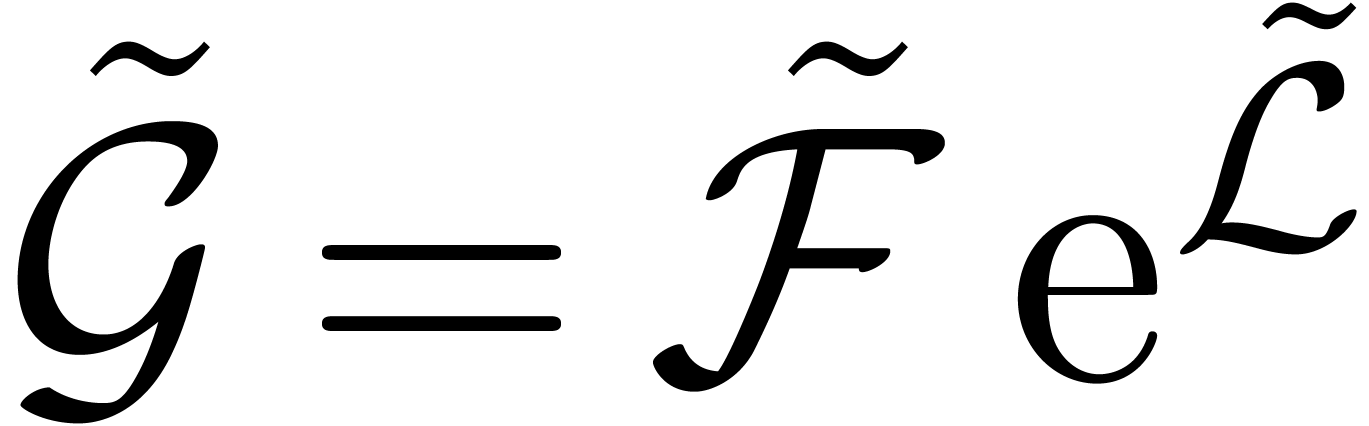

L'inventaire donne lieu au tableau suivant :

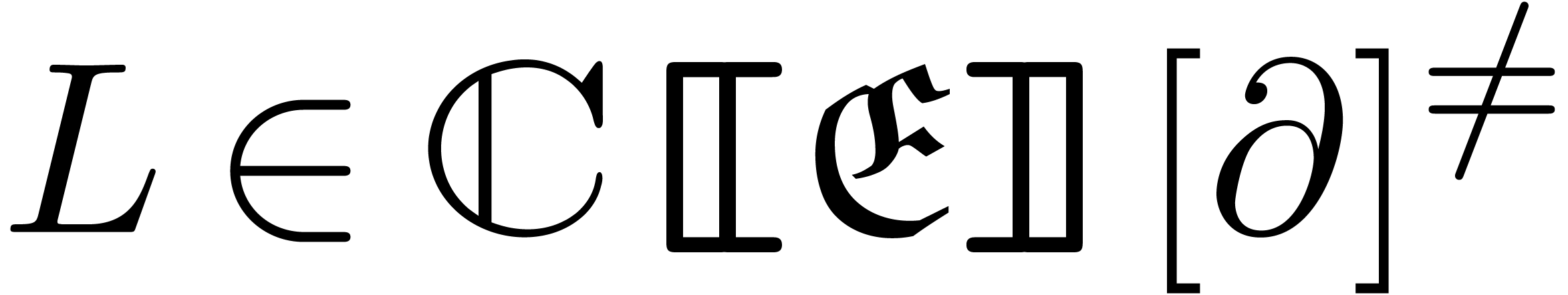

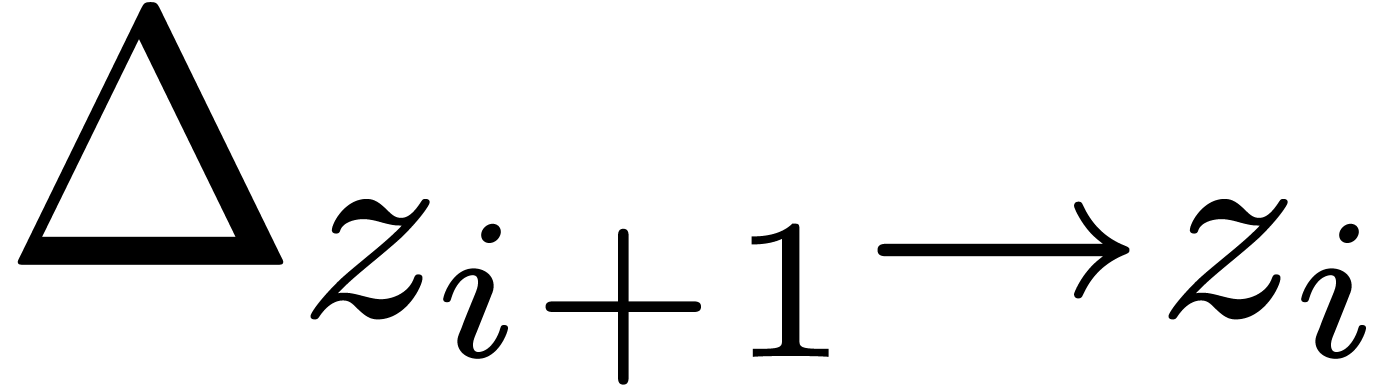

| Type d'équations | Exemple | Type de transséries |

| différentielles |  |

réticulées |

| fonctionnelles modérées |  |

bien ordonnées |

| de composition |  |

de forces supérieures |

| fonctionnelles générales |  |

imbriquées |

Les deux autres étapes demandent un travail considérable, qui fut commencé dans [96] et continué en collaboration avec mon étudiant M. Schmeling [79]. À l'heure actuelle, une bonne partie de l'étape 2 a été complétée dans [79] et, dans des notes non publiées, je suis parvenu à généraliser la méthode des polygones de Newton pour la résolution d'équations différentielles aux différences algébriques modérées.

Ce chapitre correspond grosso modo à un résumé de [79]. Les résultats des sections 2.1, 2.3 et 2.2 sont surtout le fruit de mon travail en prolongement de [96, Chapitre 2], bien que rédigés avec soin dans [79, Chapitres 1–5]. Le sujet original de M. Schmeling portait davantage sur les transséries de forces supérieures ; la section 2.4 résume les résultats de [79, Chapitres 6–9], qui furent obtenus en collaboration avec lui. Il est à remarquer que le livre [37] contient de nombreux autres résultats intéressants concernant les transséries de forces supérieures.

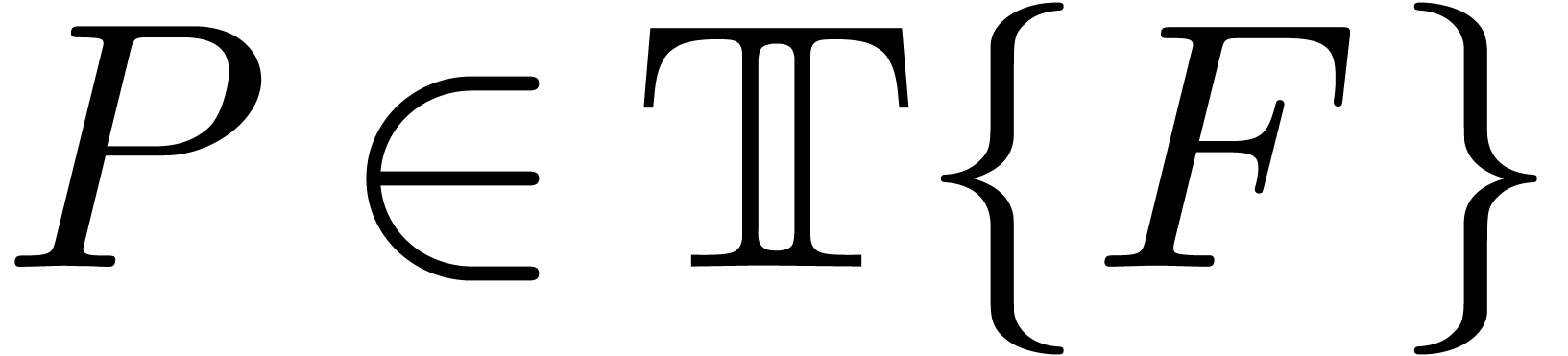

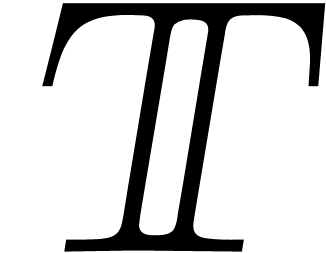

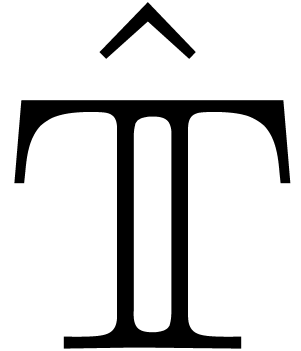

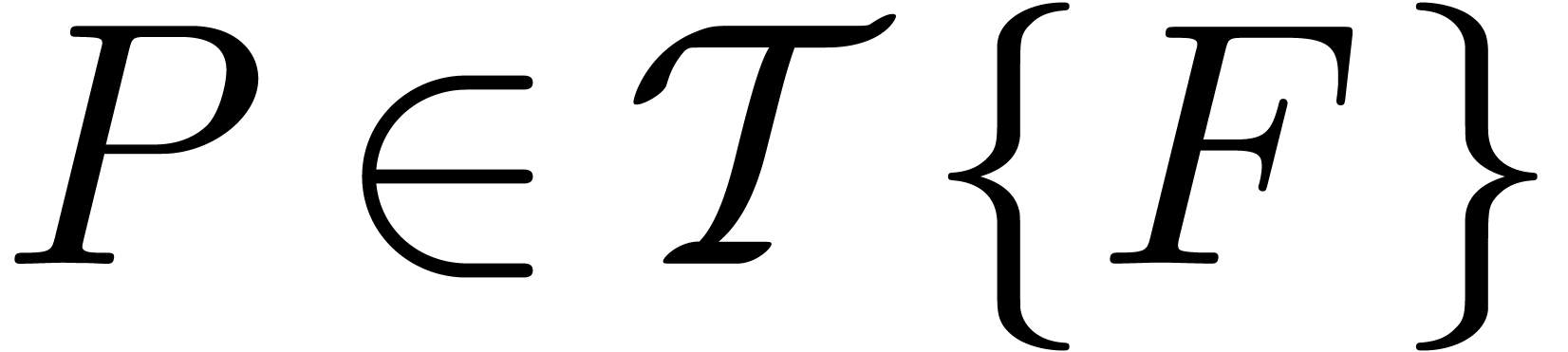

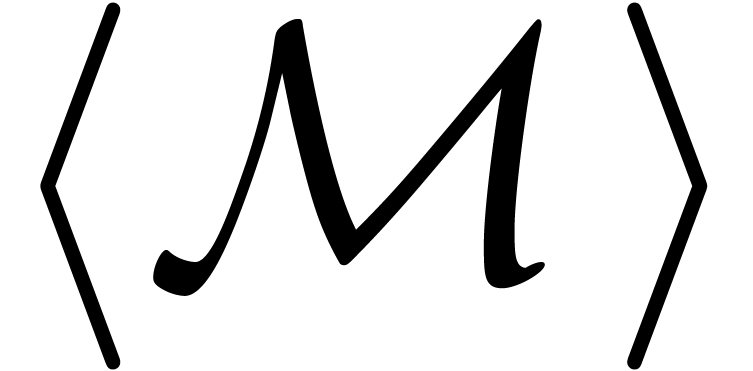

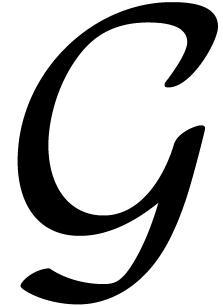

La construction des corps de transséries adéquats pour la

résolution d'équations fonctionnelles étant assez

complexe, il est utile d'adopter un traitement plus axiomatique et

déterminer d'abord les propriétés souhaitables d'un

corps de transséries. Cette approche est également utile

en théorie de modèles, si on souhaite plonger les

modèles d'une théorie avec des opérations comme

dans des corps de transséries.

dans des corps de transséries.

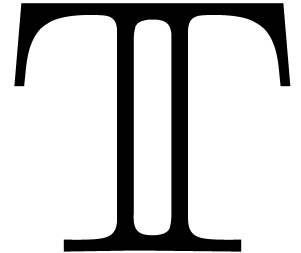

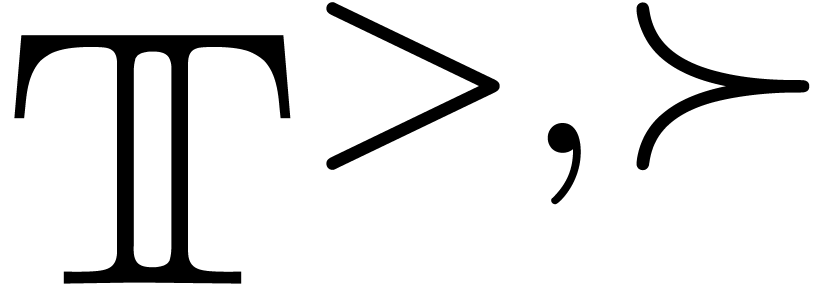

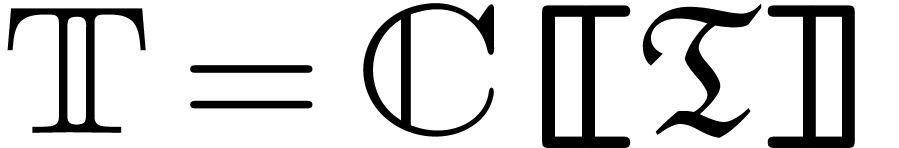

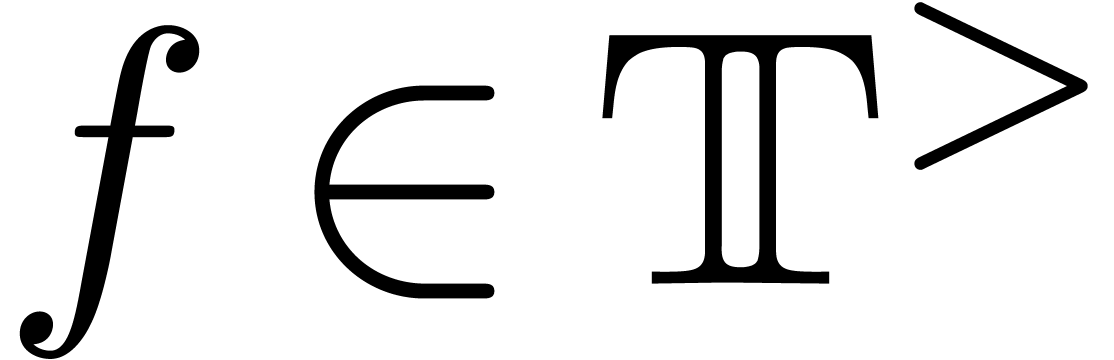

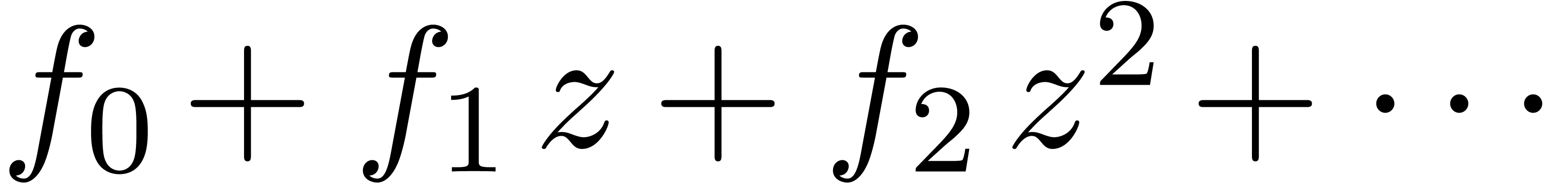

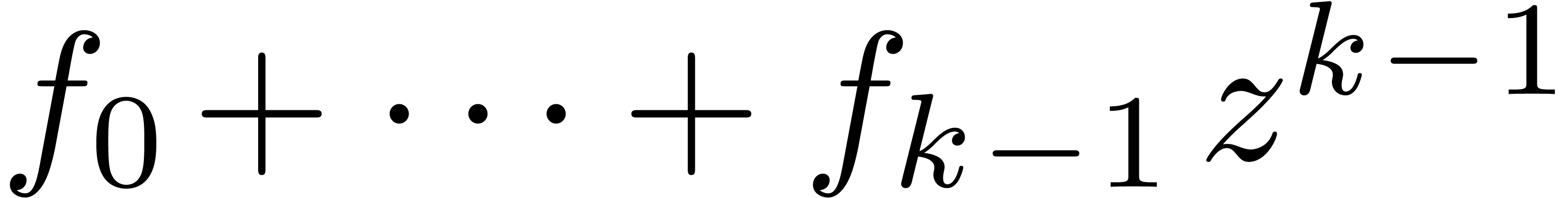

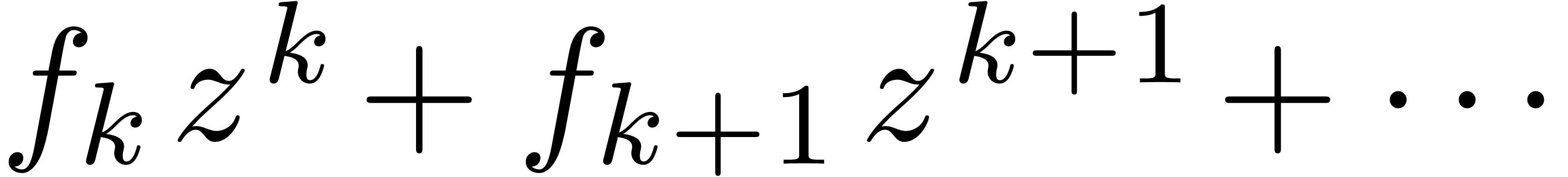

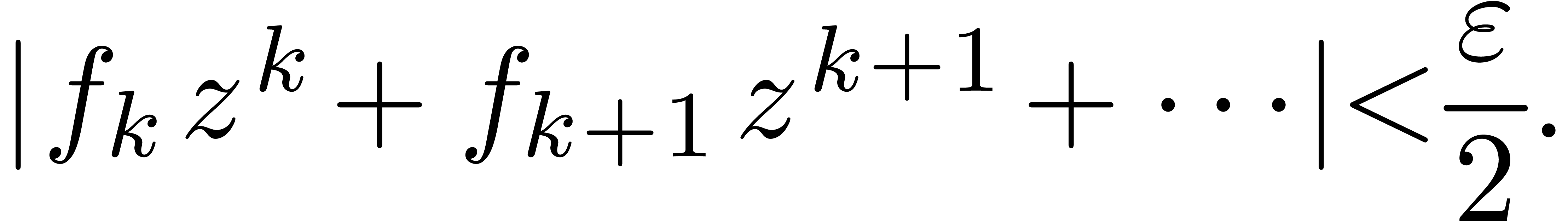

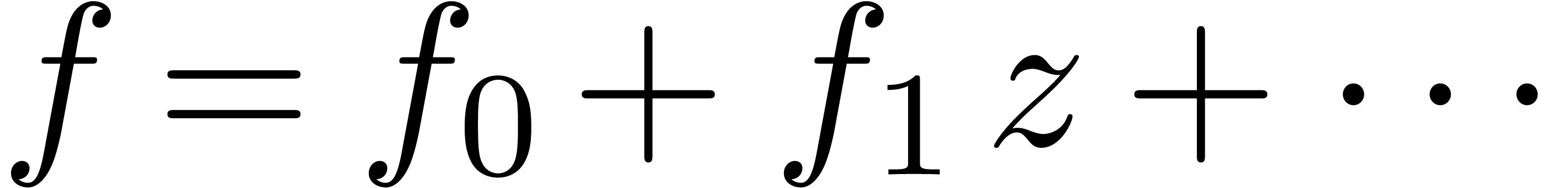

Fondamentalement, un corps de transséries est un corps totalement

ordonné de séries généralisées de la

forme  avec une ou quelques opérations

transcendantes supplémentaires comme l'exponentielle (ou le

logarithme). Le problème est donc de déterminer des

axiomes raisonnables qui expriment la compatibilité entre la

structure forte et les opérations transcendantes. Dans un premier

temps, on se limite à l'exponentielle (ou le logarithme) comme

seule opération transcendante. Pour les transséries de

forces supérieures de la section 2.4, il faudra

rajouter les itérateurs de l'exponentielle.

avec une ou quelques opérations

transcendantes supplémentaires comme l'exponentielle (ou le

logarithme). Le problème est donc de déterminer des

axiomes raisonnables qui expriment la compatibilité entre la

structure forte et les opérations transcendantes. Dans un premier

temps, on se limite à l'exponentielle (ou le logarithme) comme

seule opération transcendante. Pour les transséries de

forces supérieures de la section 2.4, il faudra

rajouter les itérateurs de l'exponentielle.

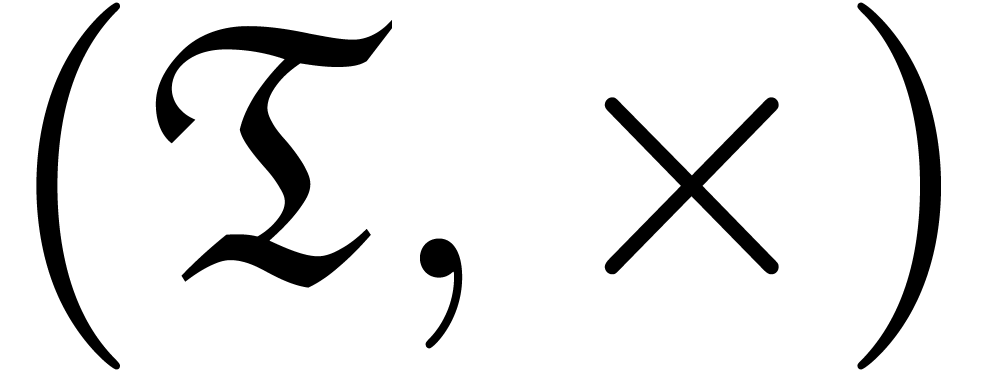

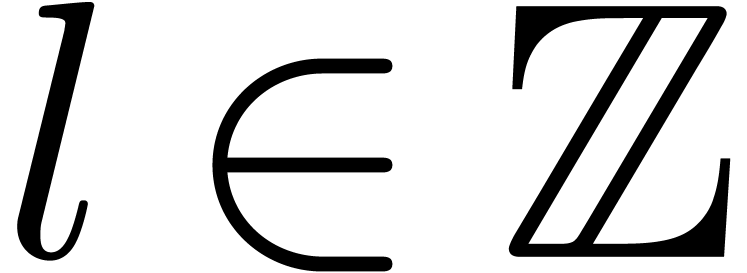

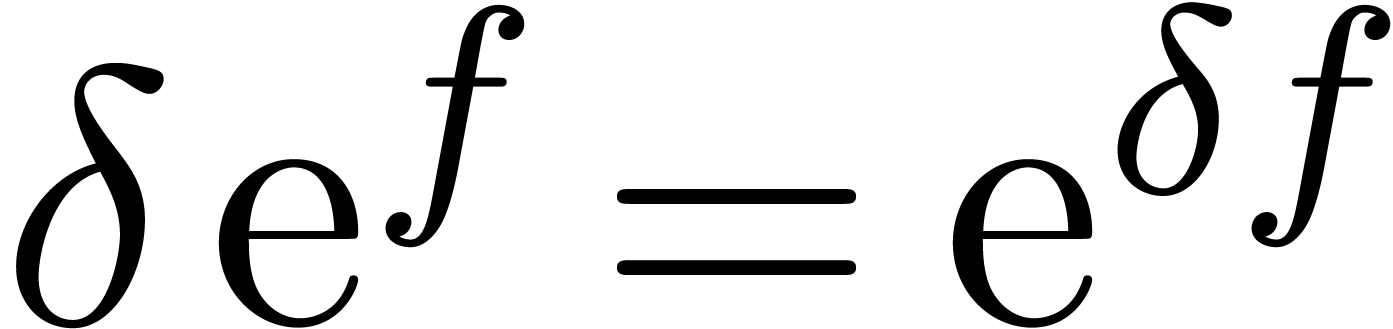

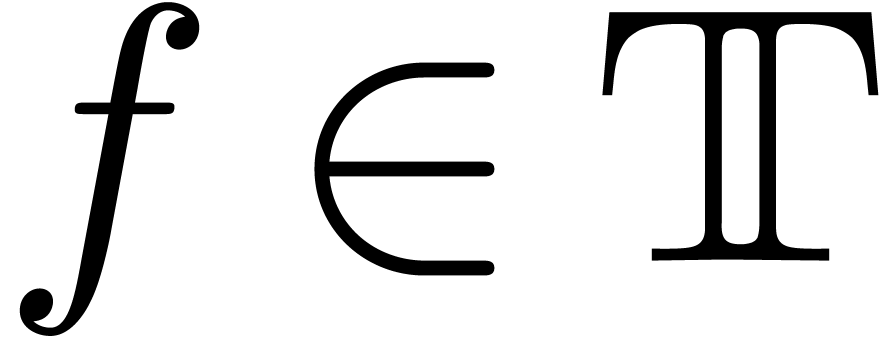

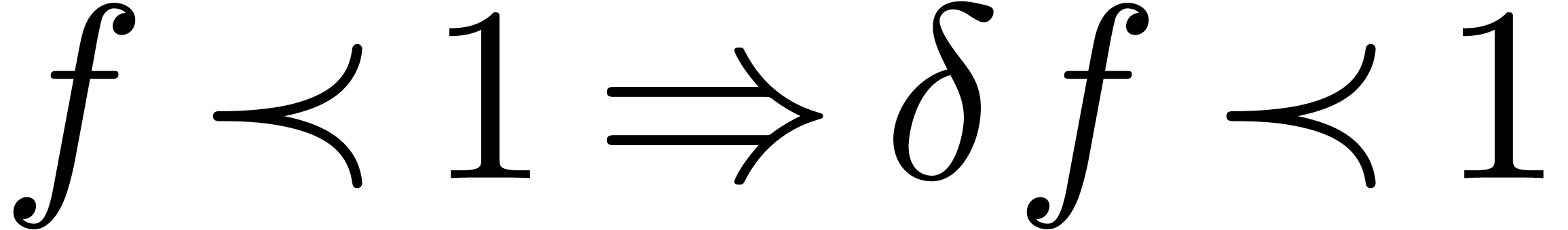

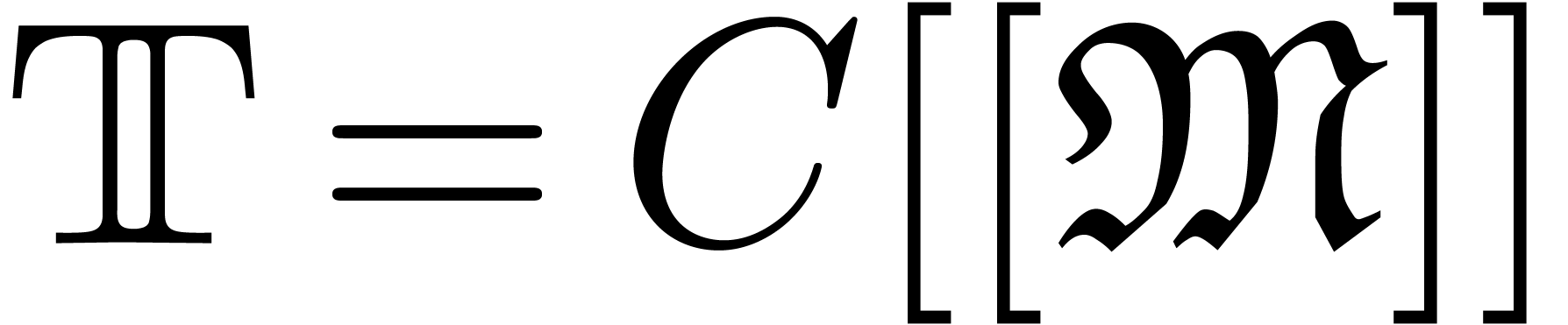

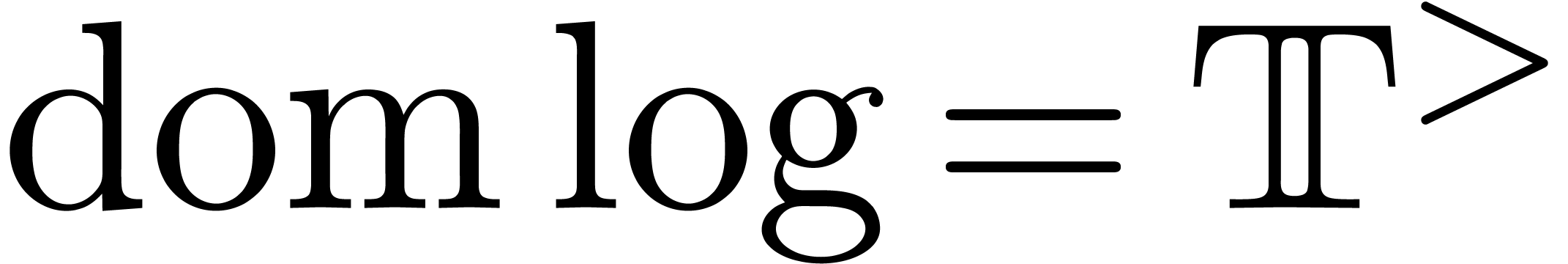

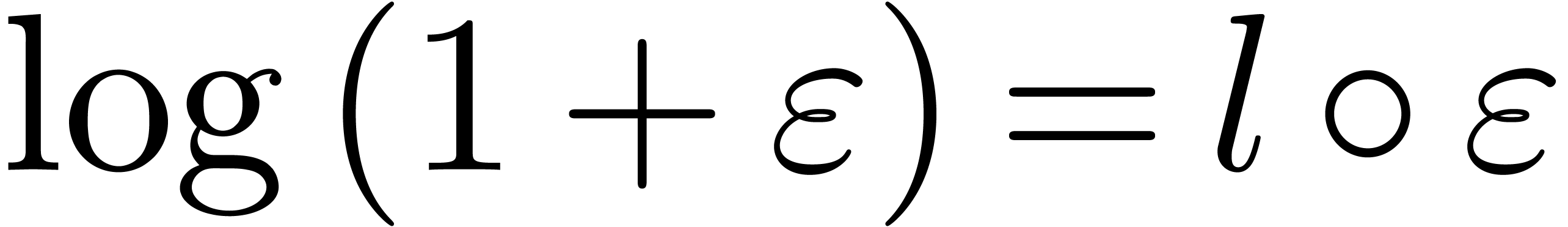

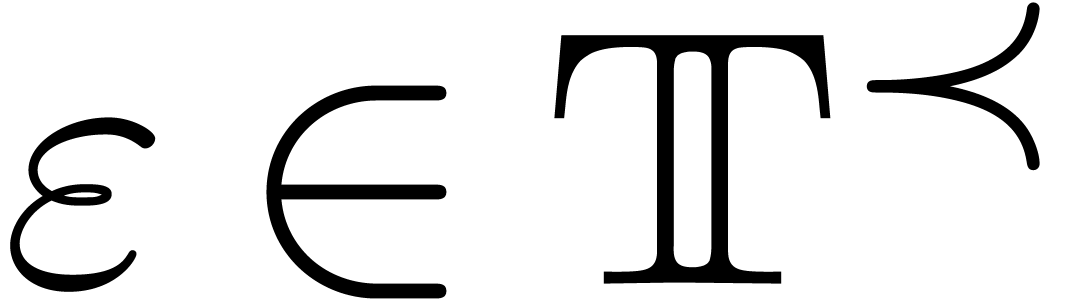

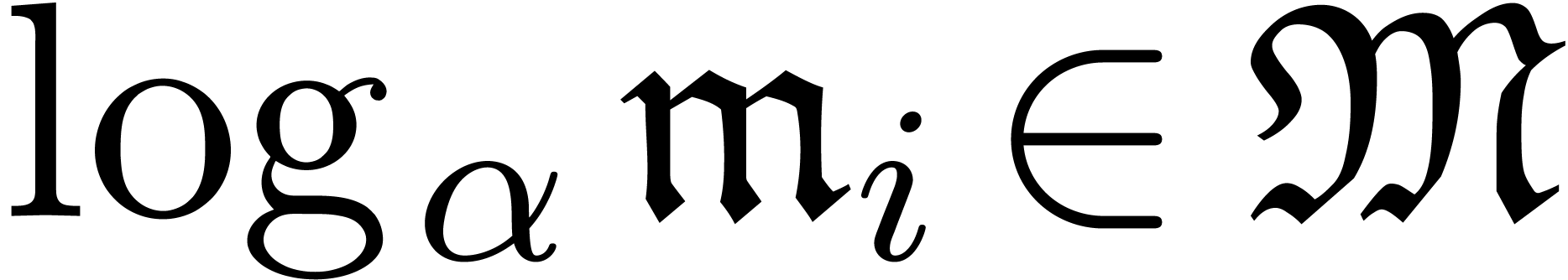

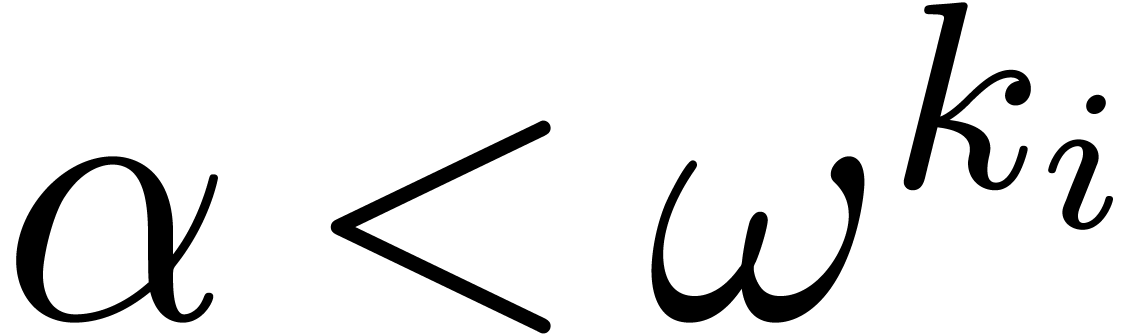

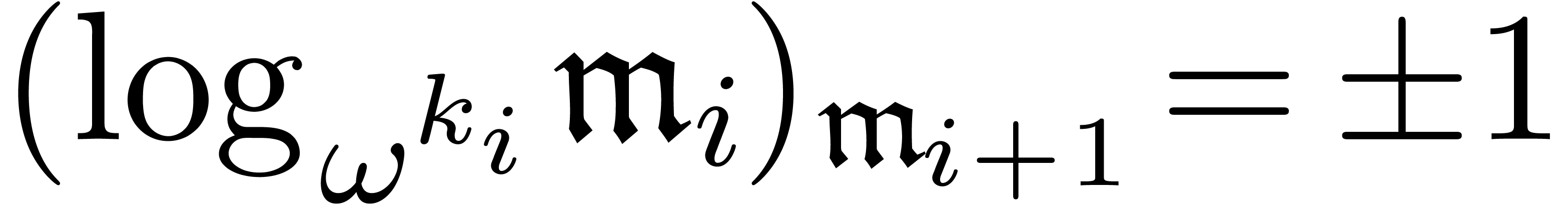

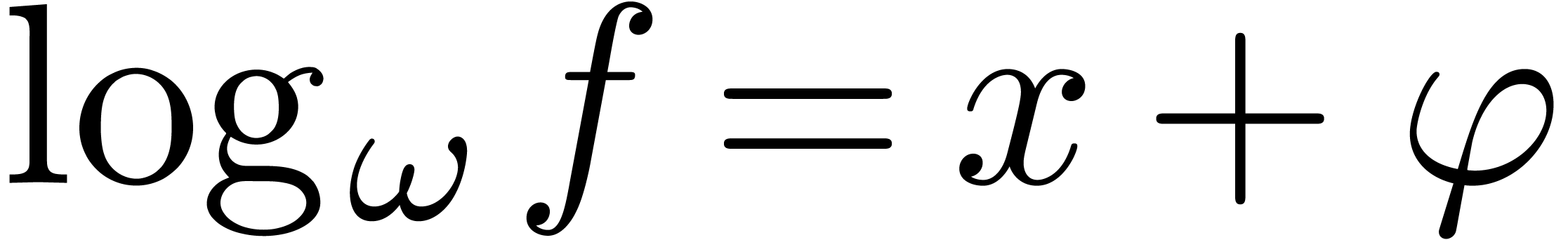

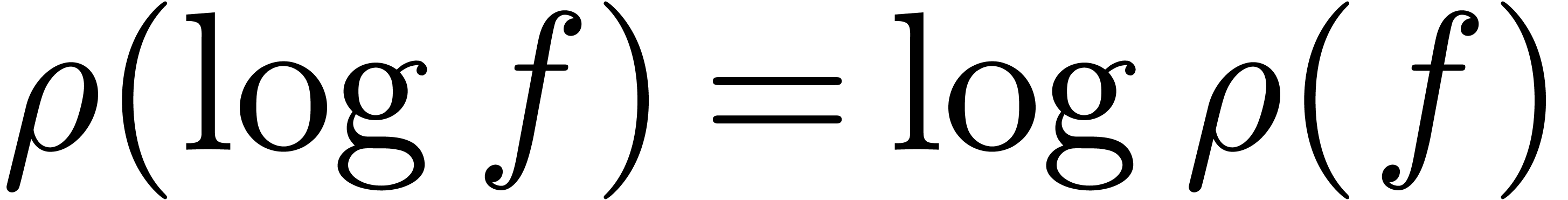

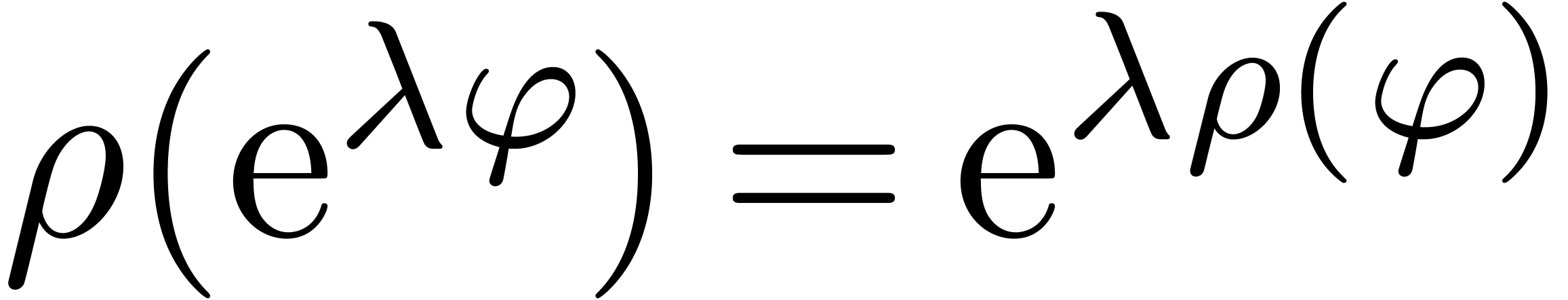

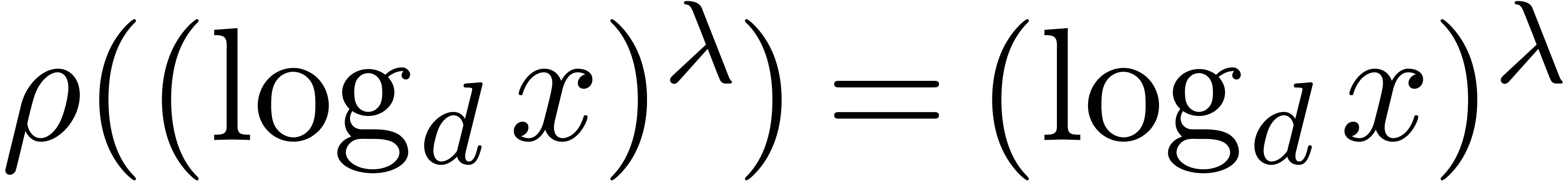

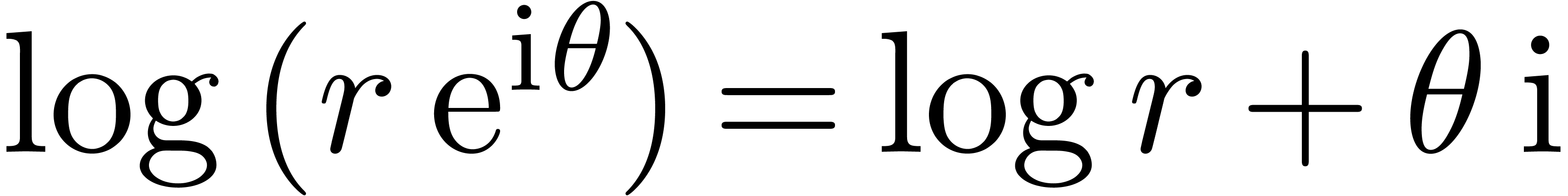

Les axiomes de compatibilité entre une fonction exponentielle partielle et la structure sérielle d'un corps de transséries s'expriment le plus facilement en fonction du logarithme :

.

.

, pour tout

, pour tout  , où

, où  .

.

Pour  , on a

, on a

.

.

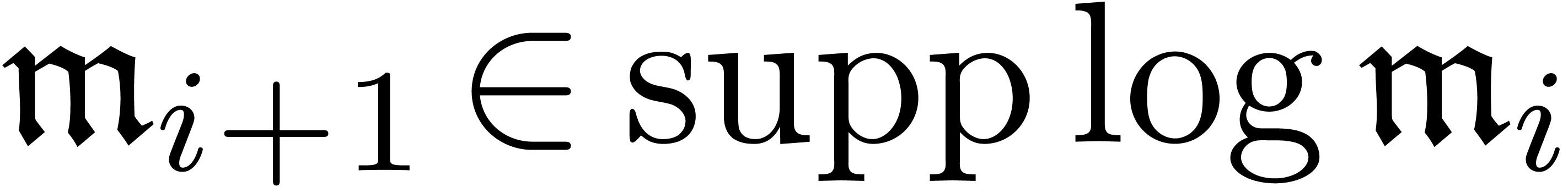

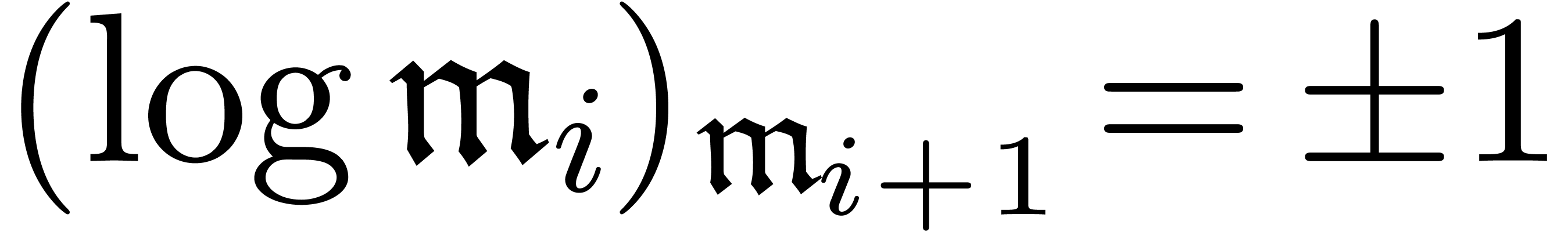

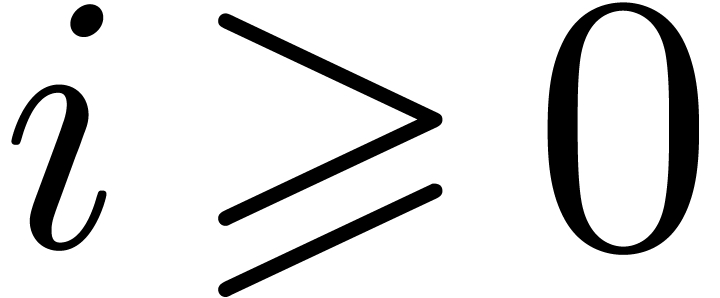

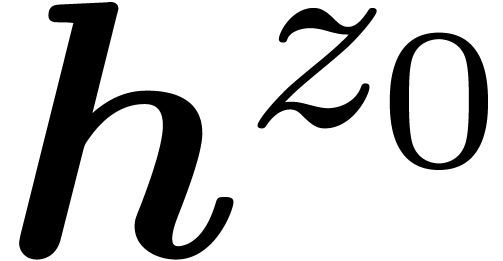

Soit  une suite de monômes, avec

une suite de monômes, avec  pour tout

pour tout  .

Alors

.

Alors  et

et  ,

pour tout

,

pour tout  suffisamment grand.

suffisamment grand.

L'axiome T2 exprime le fait que le logarithme se développe

par la formule de Taylor autour de  .

L'axiome T3 caractérise les monômes dans

.

L'axiome T3 caractérise les monômes dans  en fonction de l'exponentielle.

en fonction de l'exponentielle.

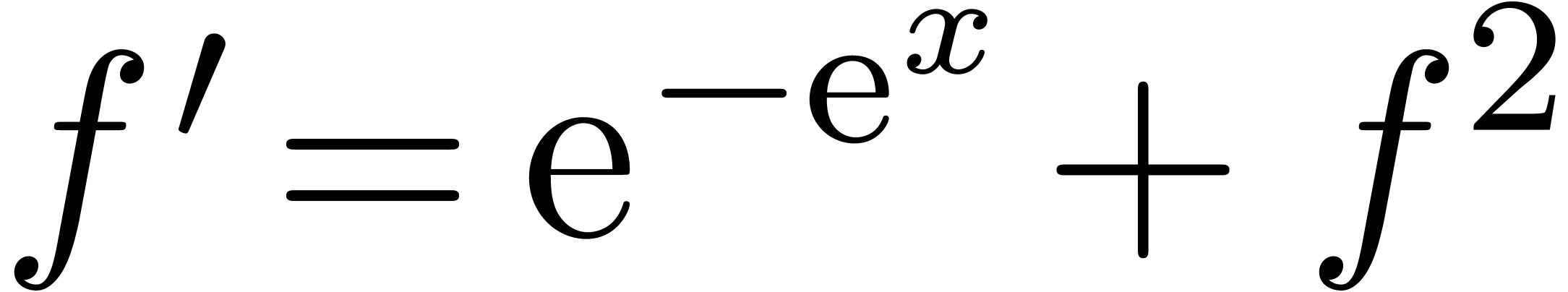

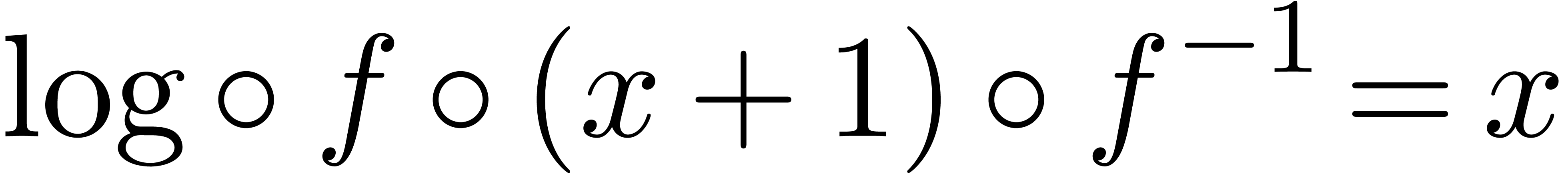

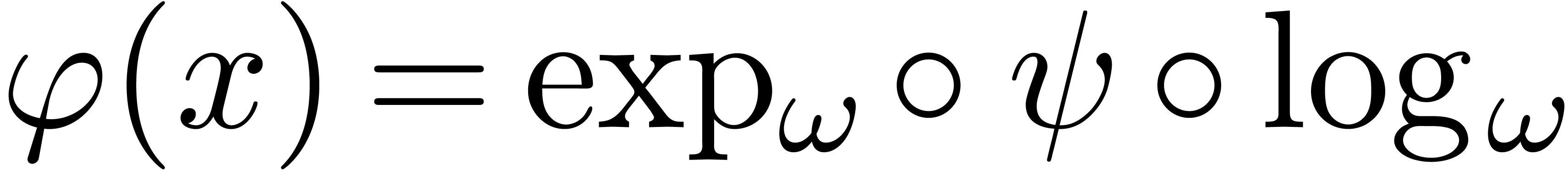

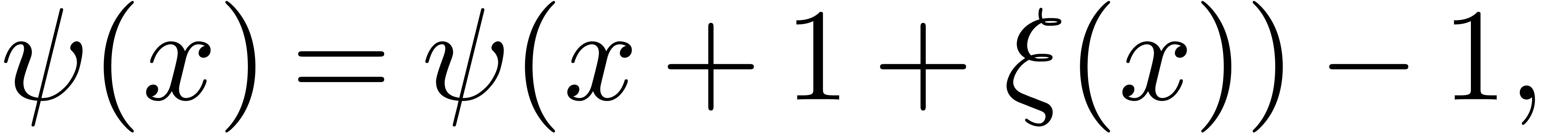

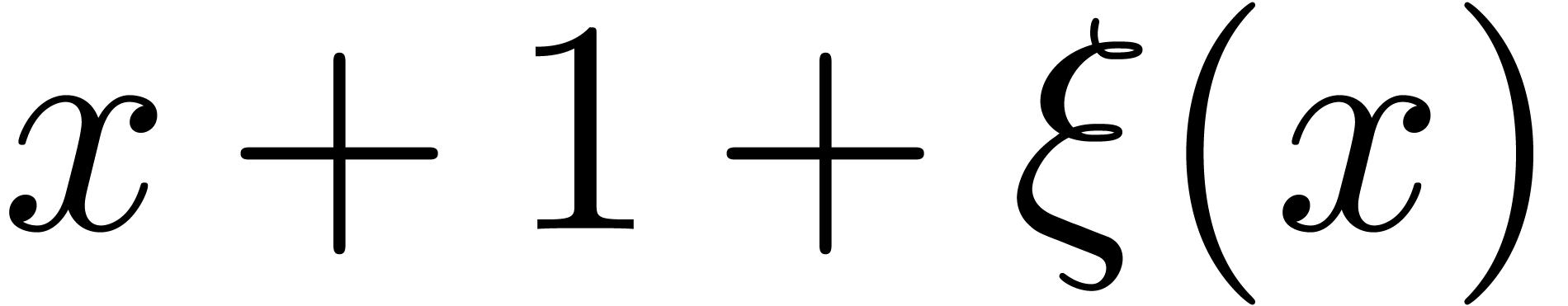

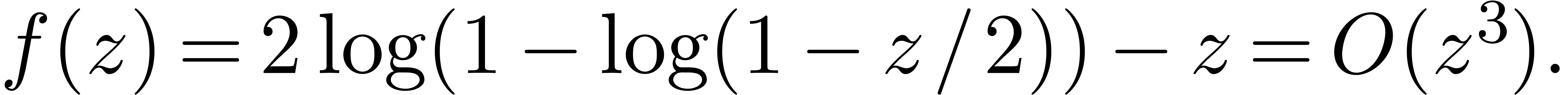

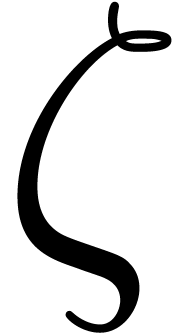

L'axiome T4 est plus subtil. Par exemple (voir aussi la section 2.3), il existe des corps de transséries qui contiennent des transséries imbriquées comme

Une telle transsérie intervient comme solution de l'équation fonctionnelle

|

(2.1) |

En revanche, l'axiome T4 écarte des « transséries mal imbriquées » comme

Ceci est d'abord souhaitable lorsque l'on veut définir des dérivations sur des corps de transséries. Par ailleurs [96, Section 2.7.1], les solutions à l'équation fonctionnelle

s'expriment en fonction des solutions de (2.1).

Partant d'un « corps exp-log totalement ordonné »

, les théorèmes

suivants permettent la construction de corps de transséries de

plus en plus grands :

, les théorèmes

suivants permettent la construction de corps de transséries de

plus en plus grands :

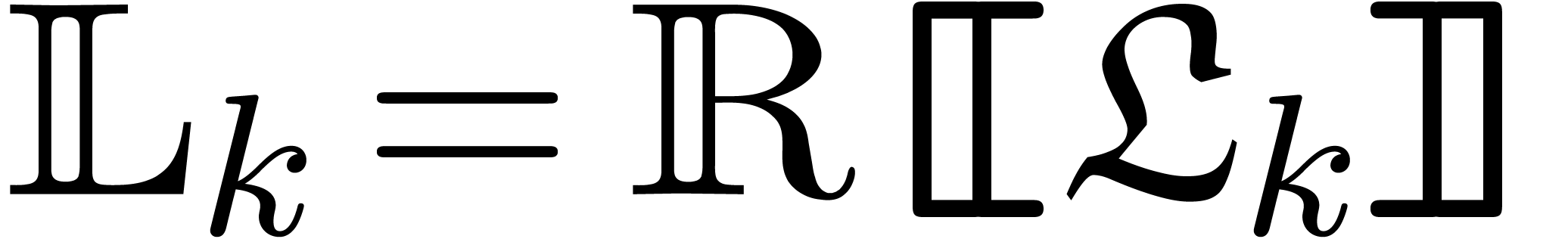

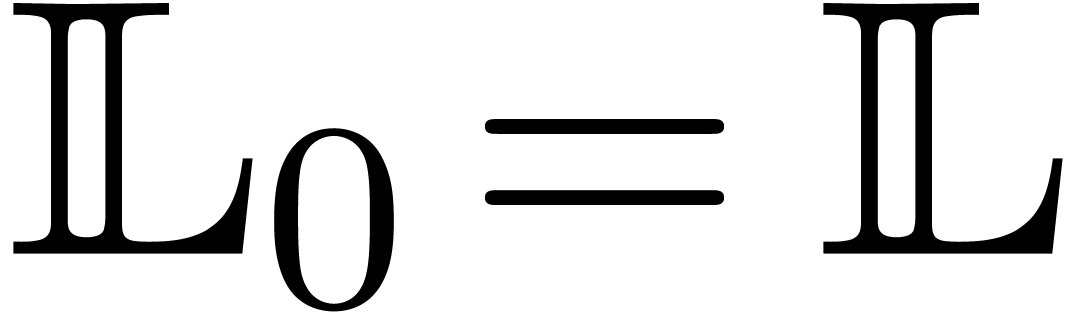

est un corps de

transséries.

est un corps de

transséries.

un corps de

transséries. Alors il en est de même pour son extension

exponentielle

un corps de

transséries. Alors il en est de même pour son extension

exponentielle  .

.

une suite croissante

de corps de transséries. Alors

une suite croissante

de corps de transséries. Alors  est

également un corps de transséries.

est

également un corps de transséries.

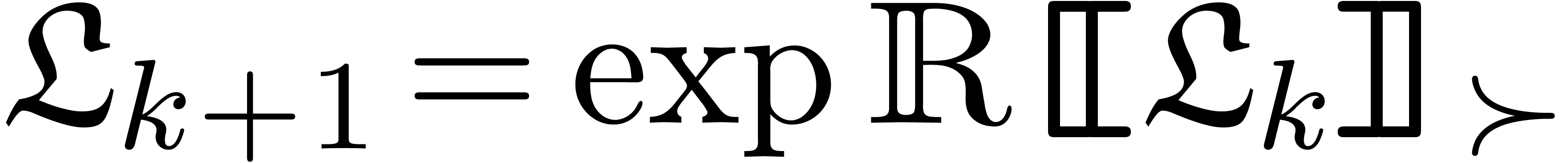

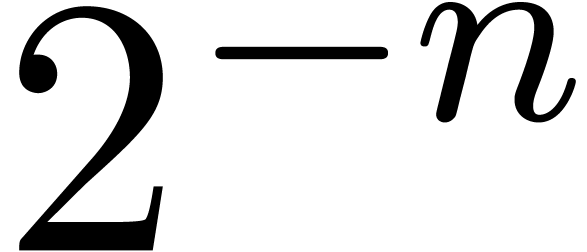

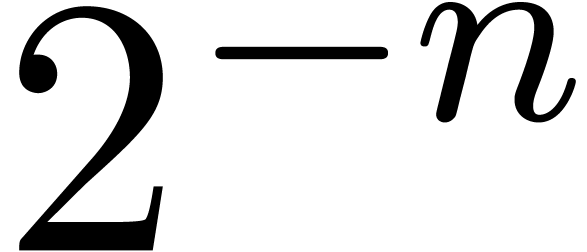

En appliquant les deux derniers théorèmes

itérativement et de façon alternée sur un corps de

transséries  donné, on peut

espérer construire sa clôture exponentielle

donné, on peut

espérer construire sa clôture exponentielle  . Malheureusement, cette procédure ne

termine jamais [96, Proposition 2.2]. Toutefois, si on

prend la précaution de se limiter à considérer des

séries dont la cardinalité du support est bornée

par un

. Malheureusement, cette procédure ne

termine jamais [96, Proposition 2.2]. Toutefois, si on

prend la précaution de se limiter à considérer des

séries dont la cardinalité du support est bornée

par un  fixé, alors la procédure

termine toujours [79, Proposition 3.3.1].

fixé, alors la procédure

termine toujours [79, Proposition 3.3.1].

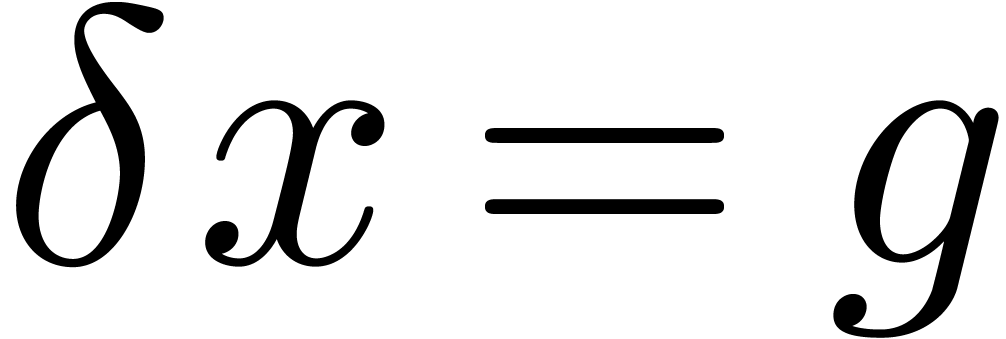

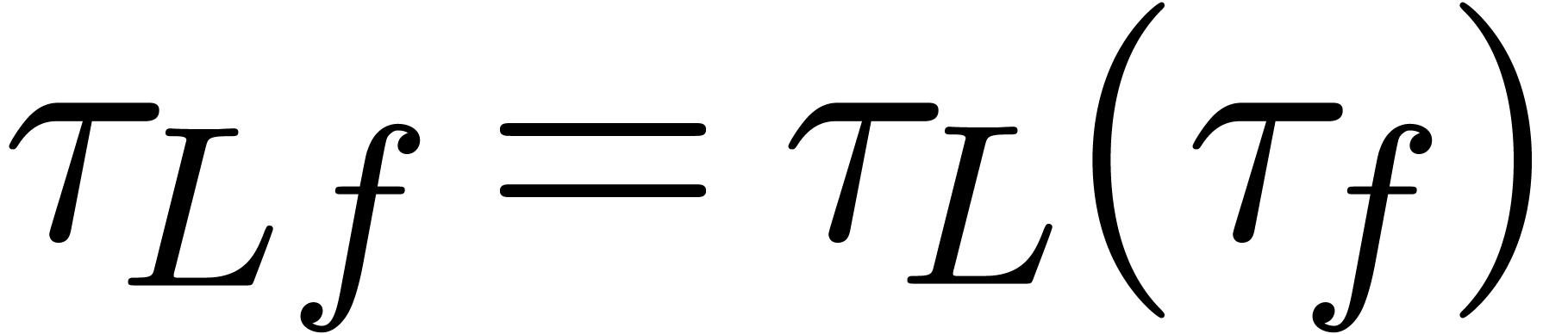

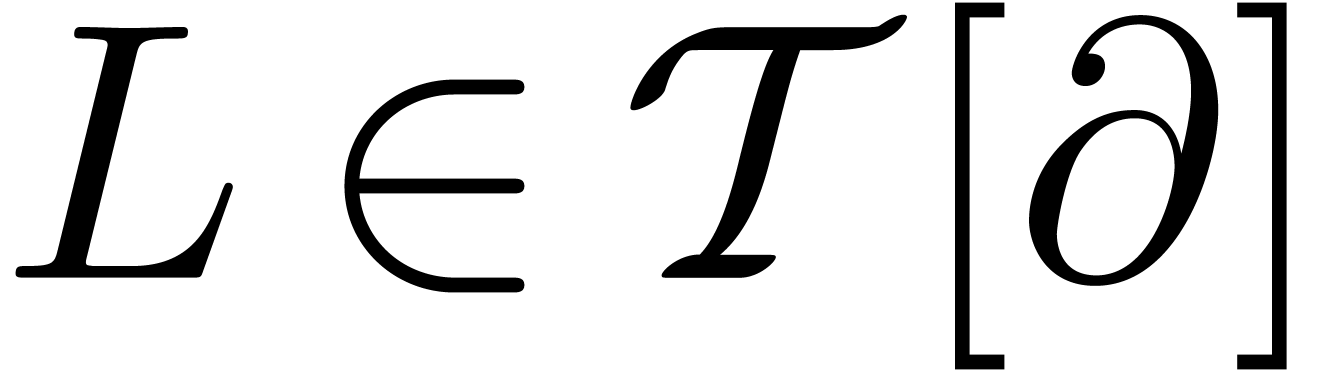

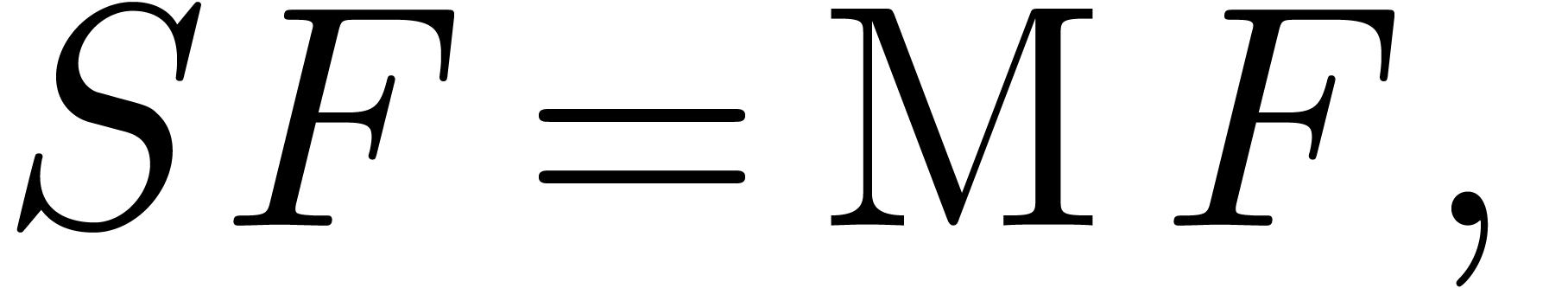

Lorsqu'un corps de transséries  est muni

d'une dérivation

est muni

d'une dérivation  (ou d'un

opérateur

(ou d'un

opérateur  de post-composition), on peut

se demander comment étendre

de post-composition), on peut

se demander comment étendre  à

à

. Bien sûr, on suppose

que

. Bien sûr, on suppose

que  (resp.

(resp.  ) soit compatible avec la structure

transsérielle de

) soit compatible avec la structure

transsérielle de  : c'est une

dérivation forte, qui vérifie

: c'est une

dérivation forte, qui vérifie  pour

tout

pour

tout  .

.

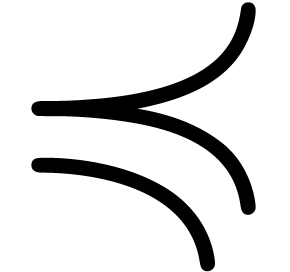

Comme la dérivée d'un transmonôme n'est pas

forcément un transmonôme, il n'est pas évident a

priori que le caractère bien ordonné des supports

soit préservé par des extensions de  . Pour montrer cela, on utilise une

représentation en arbre des termes dans

. Pour montrer cela, on utilise une

représentation en arbre des termes dans  , dont les feuilles sont dans

, dont les feuilles sont dans  :

:

La dérivée d'un tel terme s'exprime alors comme une somme

indexée par tous les chemins dans cet arbre de la racine à

une feuille. Par une combinatoire fine sur ces chemins, on parvient

à étendre  à

à  . De même, les post-compositions

correspondent à des arbres étiquetés à

l'intérieur des représentations en arbre.

. De même, les post-compositions

correspondent à des arbres étiquetés à

l'intérieur des représentations en arbre.

une

dérivation sur un corps de transséries

une

dérivation sur un corps de transséries  . Alors il existe une unique extension de

. Alors il existe une unique extension de  en une dérivation

en une dérivation  sur

sur

.

.

un

opérateur de post-composition entre deux corps de

transséries

un

opérateur de post-composition entre deux corps de

transséries  et

et  . Alors il existe une unique extension de

. Alors il existe une unique extension de  en un opérateur de post-composition

en un opérateur de post-composition  .

.

Le corps  , muni de sa

dérivation et composition, est stable pour la résolution

d'équations fonctionnelles modérées, où on

ne compose les fonctions inconnues que par des transséries

, muni de sa

dérivation et composition, est stable pour la résolution

d'équations fonctionnelles modérées, où on

ne compose les fonctions inconnues que par des transséries  d'exponentialité zéro

(c.à.d. que

d'exponentialité zéro

(c.à.d. que  pour tout

pour tout  suffisamment grand). Toutefois, des

instabilités apparaissent dès que l'on considère

des équations plus générales. D'une part, il existe

des équations comme

suffisamment grand). Toutefois, des

instabilités apparaissent dès que l'on considère

des équations plus générales. D'une part, il existe

des équations comme

|

(2.2) |

dont les solutions en transséries imbriquées

|

(2.3) |

se faufilent dans des coupures au milieu de  . D'autre part, il existe des équations

d'itération dont les solutions dépassent tous les

éléments de

. D'autre part, il existe des équations

d'itération dont les solutions dépassent tous les

éléments de  (voir la section

suivante).

(voir la section

suivante).

Soit  un corps de transséries. Dans un

premier temps, il est commode de construire des extensions de

un corps de transséries. Dans un

premier temps, il est commode de construire des extensions de  par des transséries imbriquées au cas par

cas. Considérons deux suites

par des transséries imbriquées au cas par

cas. Considérons deux suites  et

et  . On dira que

. On dira que  est une paire diagonale si

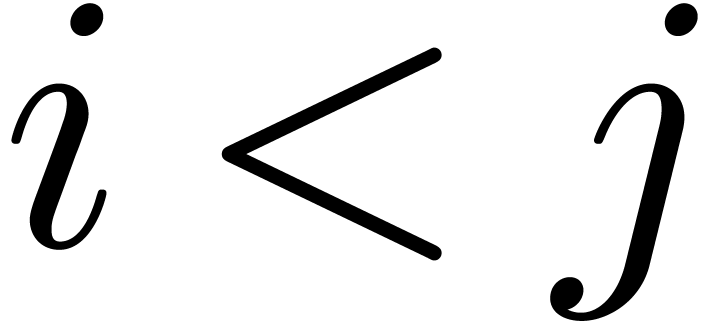

est une paire diagonale si

pour tout

pour tout  et

et  pour tout

pour tout  .

.

Pour tout  et

et  ,

il existe un

,

il existe un  tel que tout

tel que tout  vérifie

vérifie

Une telle paire détermine une suite  de

transmonômes imbriqués formels

de

transmonômes imbriqués formels

sur

sur  s'étend à

s'étend à

et donne lieu à un corps de transséries  .

.

Dans un deuxième temps, il sera plus utile de faire un

théorème d'extension plus uniforme, par exemple en

rajoutant toutes les coupures monomiales au sens de [117,

Section 9.3.1] en une seule fois. En utilisant la croissance des

opérateurs de post-composition, cela permettra sans doute

d'obtenir un analogue imbriqué des théorèmes 2.4 et 2.5. Par ailleurs, la construction du

théorème 2.6 permet de rajouter les

monômes  seulement une fois, alors que

l'approche par des coupures permettrait l'itération du

procédé.

seulement une fois, alors que

l'approche par des coupures permettrait l'itération du

procédé.

Détaillons un peu plus cette dernière observation et

cherchant la solution générale de l'équation (2.2) dans les transséries. En effet, supposons que

( ) est la paire correspondant

à la solution (2.3). On peut considérer une

deuxième suite

) est la paire correspondant

à la solution (2.3). On peut considérer une

deuxième suite

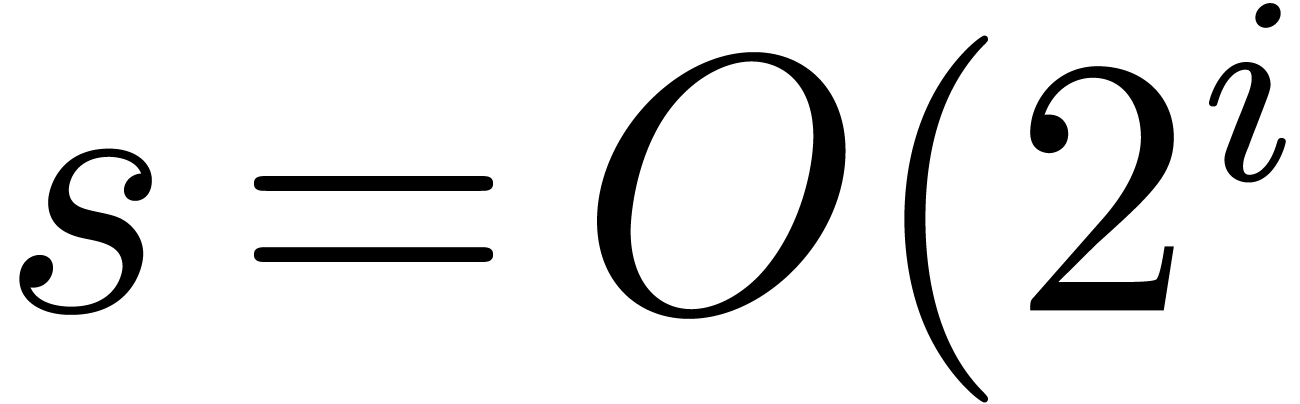

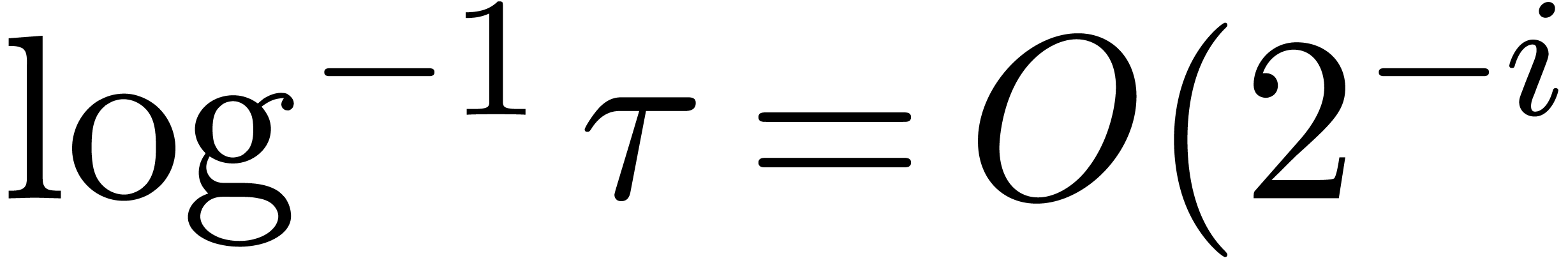

ayant les mêmes expressions en diagonale que les  , mais avec

, mais avec  dans

dans

On peut vérifier que  porte à

nouveau la structure d'un corps de transséries dans lequel (2.3) admet deux solutions

porte à

nouveau la structure d'un corps de transséries dans lequel (2.3) admet deux solutions  et

et  avec

avec  . En

répétant le procédé, on peut obtenir

d'autres solutions

. En

répétant le procédé, on peut obtenir

d'autres solutions  ,

,  , etc. dans des corps

de plus en plus grands, avec

, etc. dans des corps

de plus en plus grands, avec  ,

,

, etc. En définitive,

on construit ainsi une famille croissante (

, etc. En définitive,

on construit ainsi une famille croissante ( )

de solutions de (2.2), indexée par un nombre

surréel

)

de solutions de (2.2), indexée par un nombre

surréel  [22].

[22].

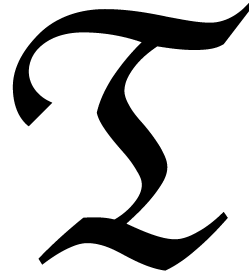

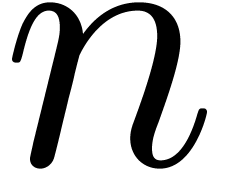

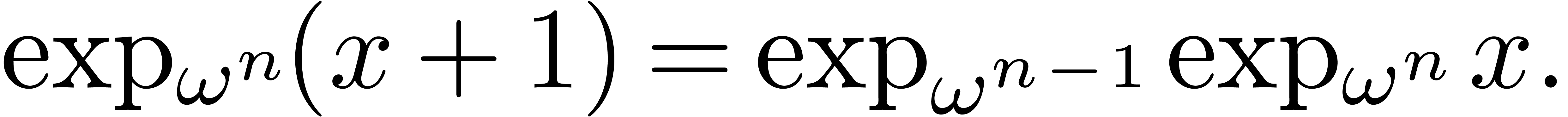

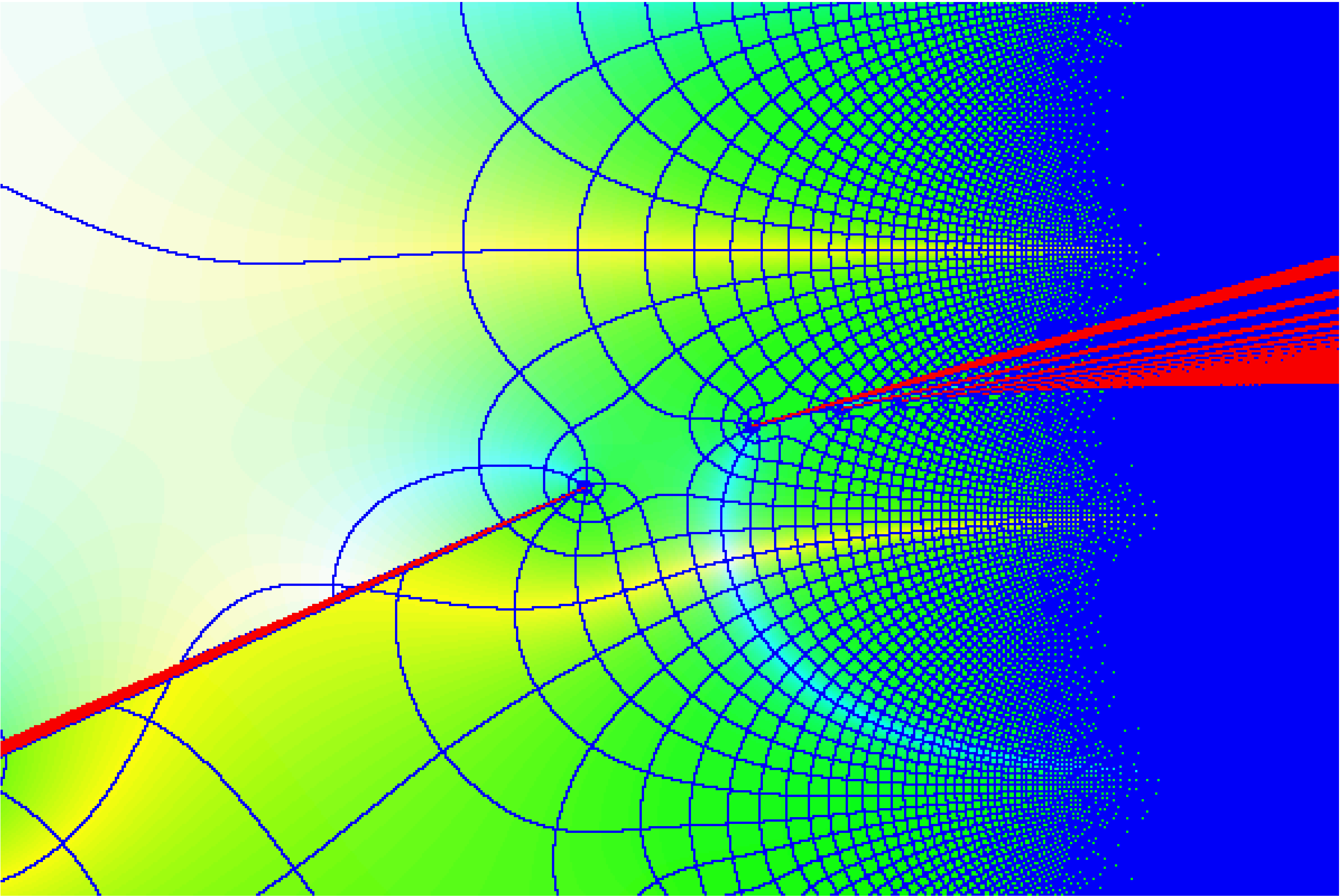

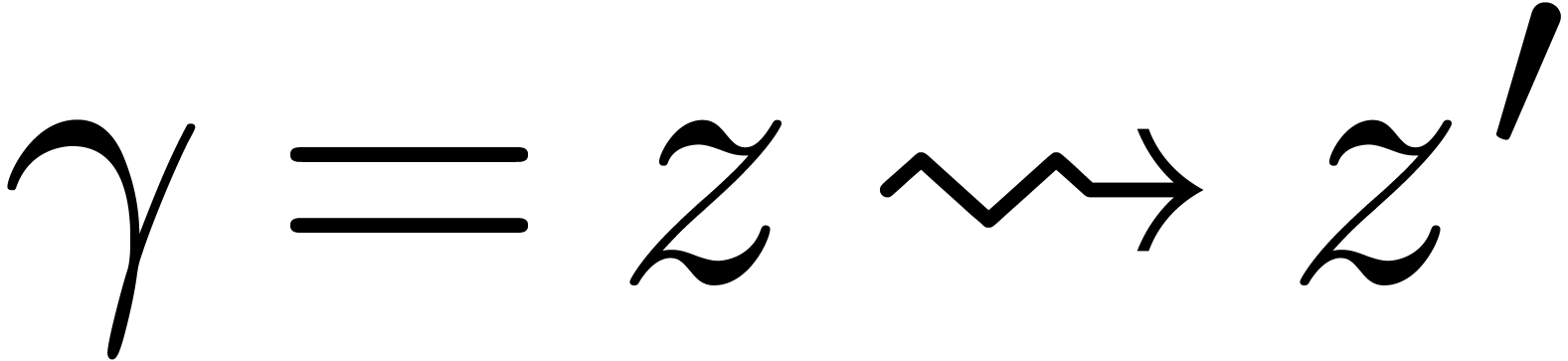

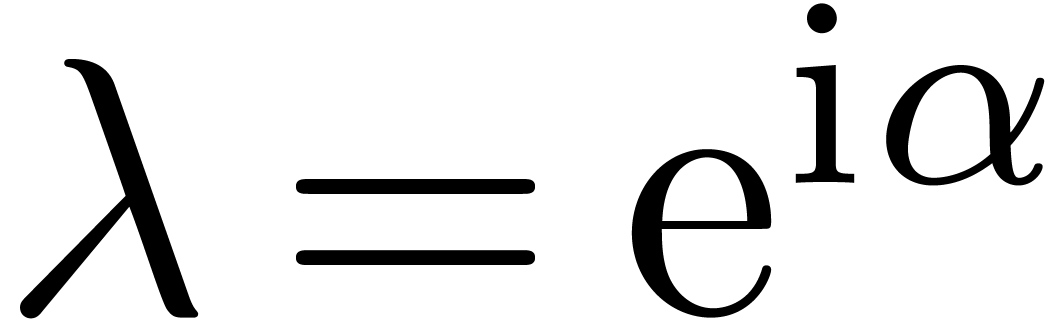

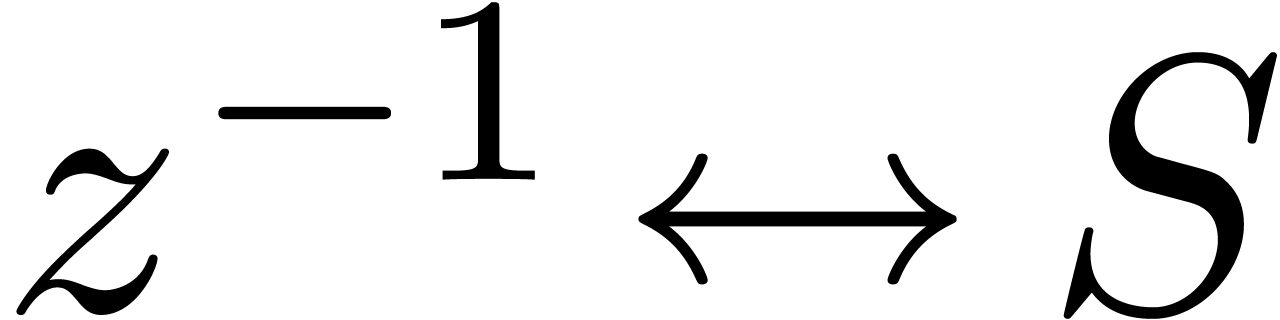

Considérons l'équation d'itération

|

(2.4) |

Toute solution fortement monotone à cette équation

croît plus vite que n'importe quelle exponentielle

itérée pour  .

On ne peut donc pas résoudre cette équation dans des corps

de transséries classiques, qui sont construits à partir de

.

On ne peut donc pas résoudre cette équation dans des corps

de transséries classiques, qui sont construits à partir de

et

et  par les

opérations de corps, la sommation infinie, l'exponentielle et le

logarithme.

par les

opérations de corps, la sommation infinie, l'exponentielle et le

logarithme.

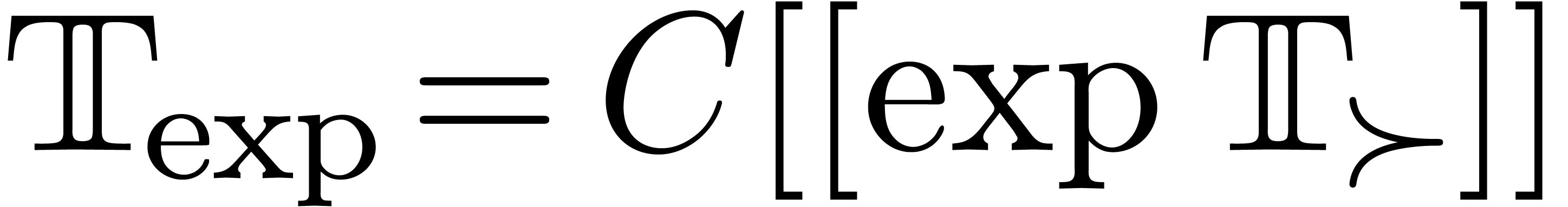

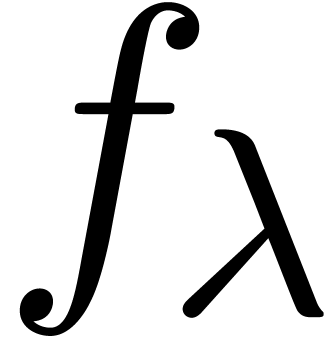

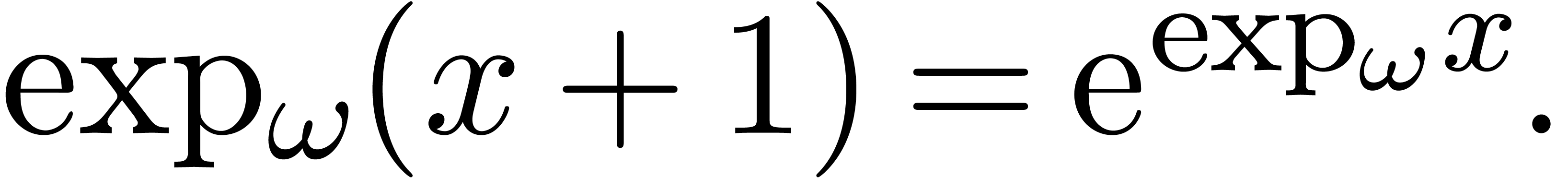

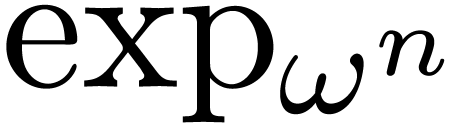

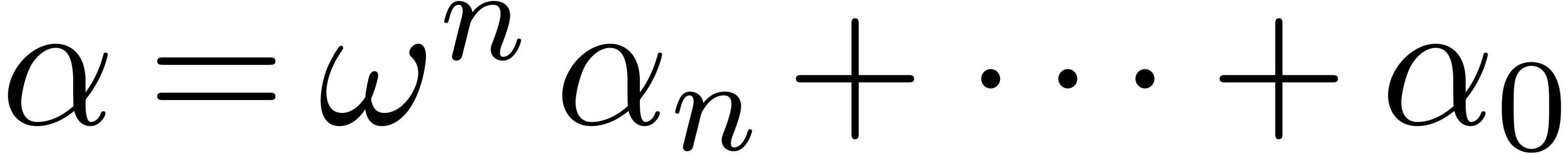

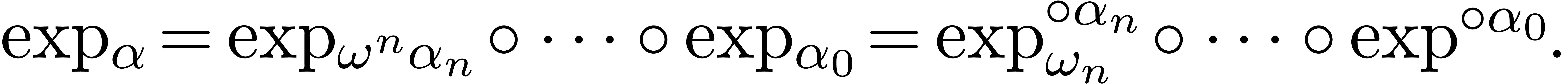

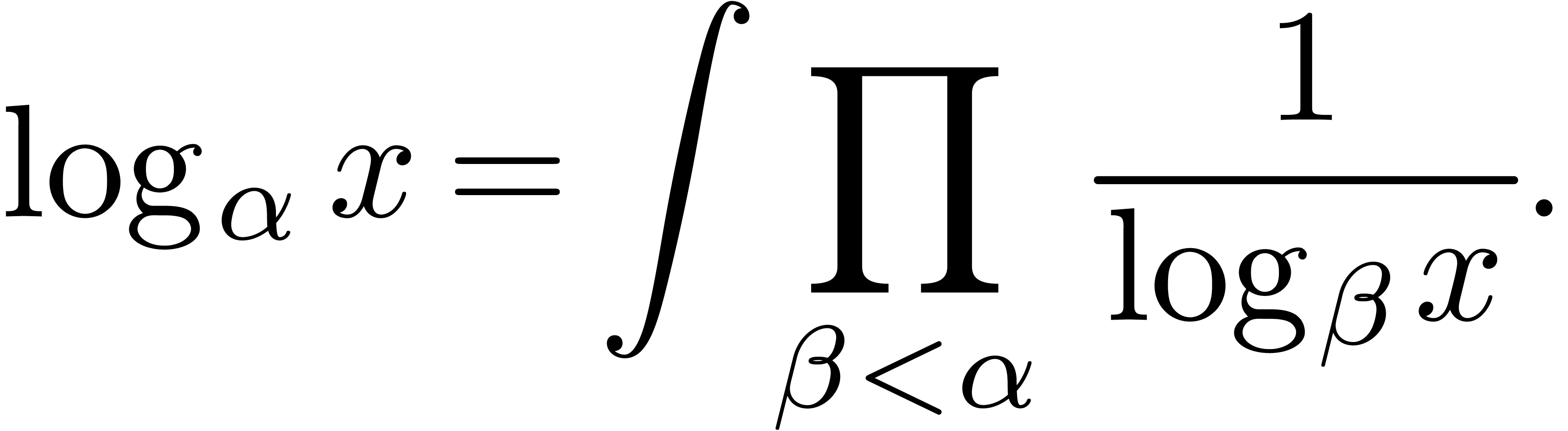

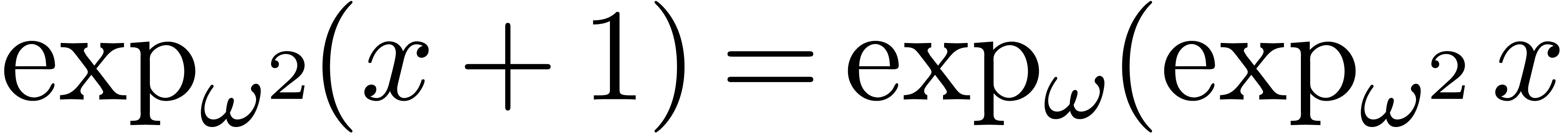

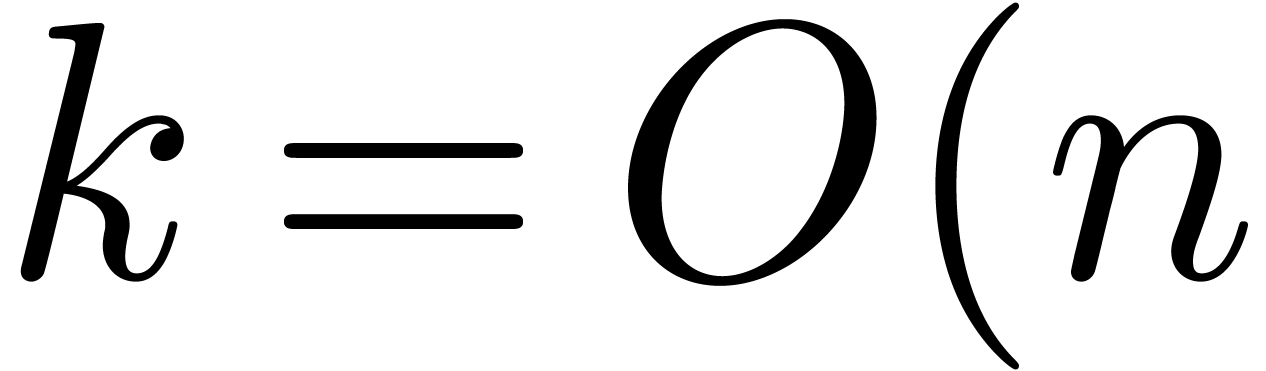

On est donc amené à construire des corps de

transséries, où, outre l'exponentielle et le logarithme,

la fonction  et son inverse

et son inverse  font partie de la signature. Plus généralement, on peut

considérer les itérateurs

font partie de la signature. Plus généralement, on peut

considérer les itérateurs  de

forces

de

forces  supérieures, qui sont

définis par récurrence :

supérieures, qui sont

définis par récurrence :

|

(2.5) |

Pour des ordinaux  , on

définit aussi

, on

définit aussi

On peut même continuer la construction pour des ordinaux plus grands, en utilisant la relation

Dans [79], nous avons entrepris la construction de corps de transséries de forces finies. Il est probablement possible de généraliser la construction selon la même ligne d'idées.

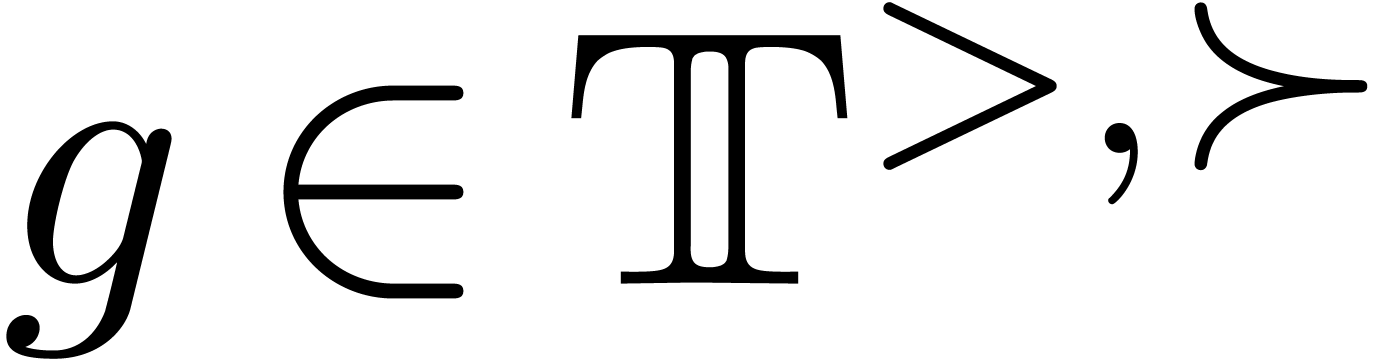

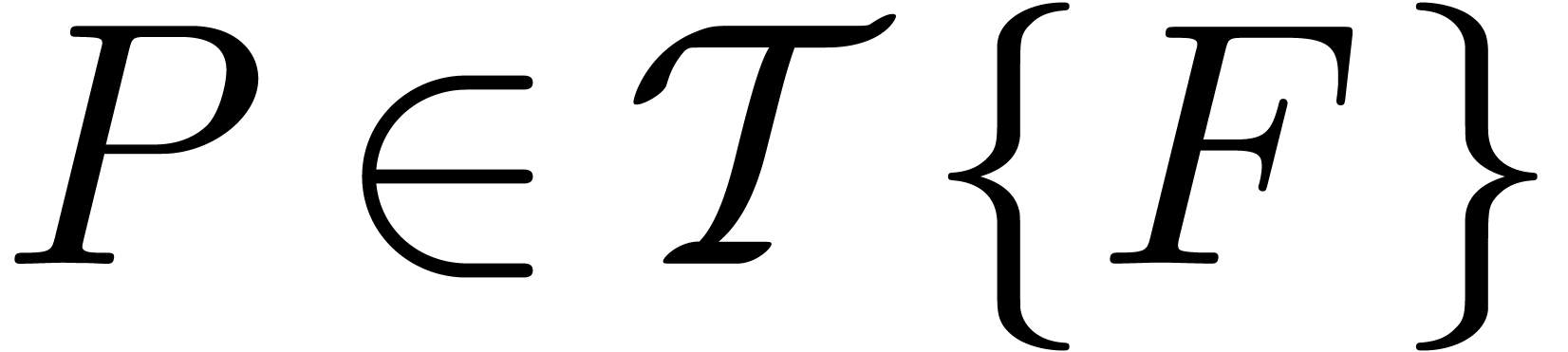

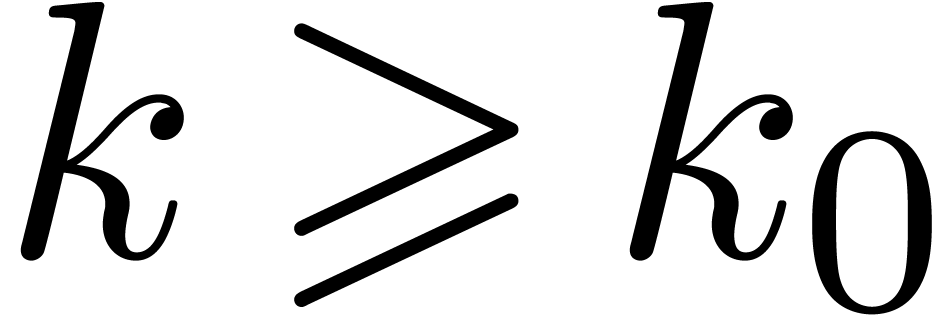

Soit  . Un corps de

transséries de force

. Un corps de

transséries de force  est un corps de

transséries

est un corps de

transséries  de force

de force  , avec des fonctions partielles

, avec des fonctions partielles  , qui vérifient les axiomes suivants :

, qui vérifient les axiomes suivants :

;

;

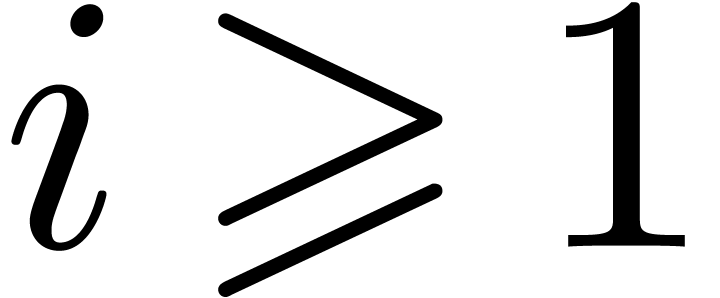

Pour tout  et

et  avec

avec

, on a

, on a

Soit  . Alors

. Alors  , si pour tout

, si pour tout  , on a

, on a

Soit  une suite de monômes telle que

une suite de monômes telle que

, avec

, avec  , pour tout

, pour tout  ;

;

, pour tout ordinal

, pour tout ordinal

.

.

Alors  et

et  ,

pour tout

,

pour tout  suffisamment grand.

suffisamment grand.

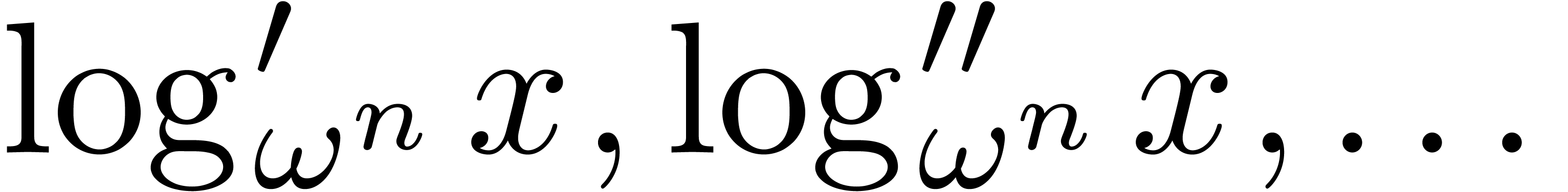

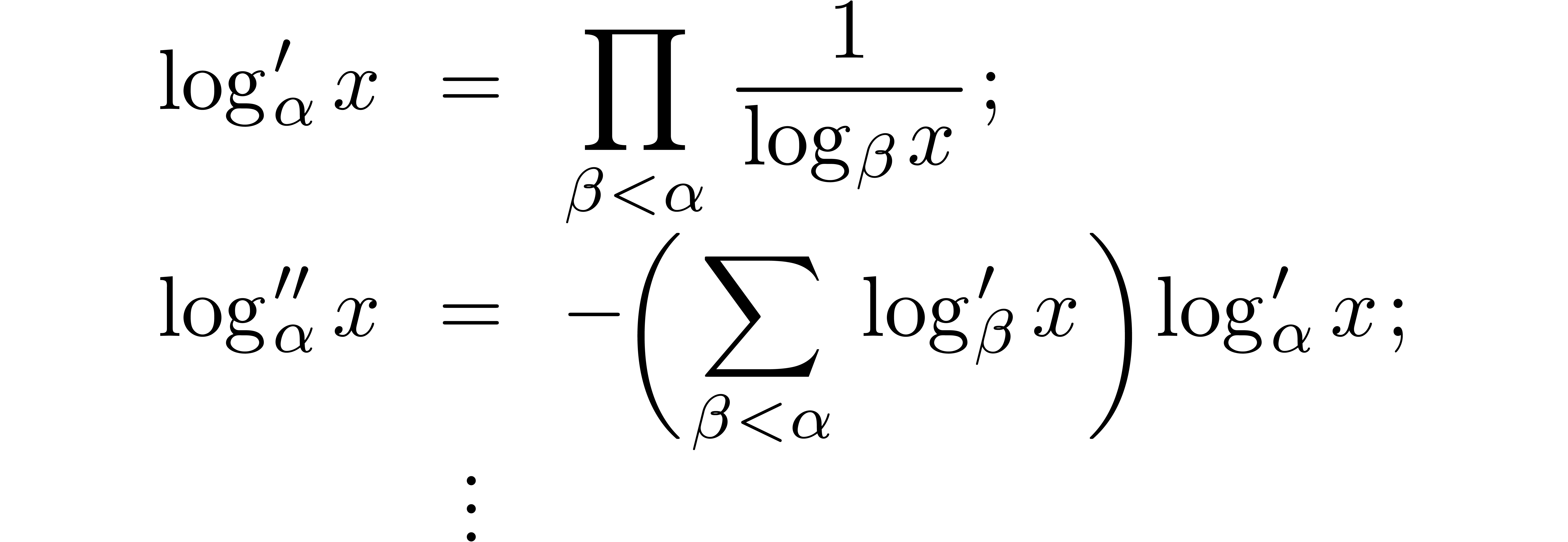

Les dérivées successives  de

de  sont en fait définies comme les

pré-compositions à gauche par les transséries

sont en fait définies comme les

pré-compositions à gauche par les transséries  de force

de force  :

:

Remarque  n'est plus une caractérisation

des monômes dans

n'est plus une caractérisation

des monômes dans  en fonction de

en fonction de  , mais seulement une condition

suffisante pour qu'une transsérie soit un monôme. En fait,

les monômes qui vérifient cette condition jouent un

rôle important dans la construction des corps de

transséries de forces supérieures.

, mais seulement une condition

suffisante pour qu'une transsérie soit un monôme. En fait,

les monômes qui vérifient cette condition jouent un

rôle important dans la construction des corps de

transséries de forces supérieures.

Par ailleurs, la condition sur  est

vérifiée en particulier lorsque

est

vérifiée en particulier lorsque  , mais ceci n'est pas nécessaire, comme le

montre l'exemple

, mais ceci n'est pas nécessaire, comme le

montre l'exemple  . On notera

enfin que si la condition est vérifiée par un certain

. On notera

enfin que si la condition est vérifiée par un certain

, elle le sera

également par

, elle le sera

également par  et

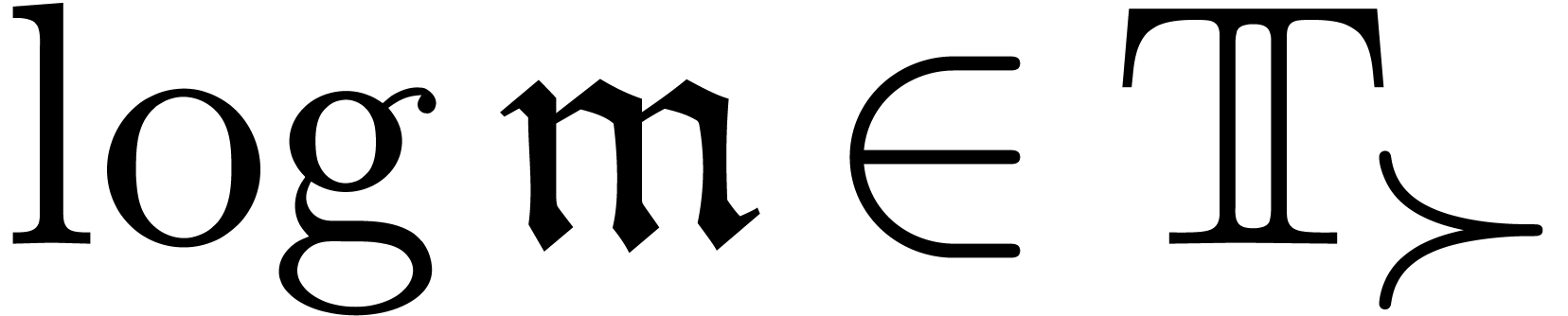

et  , pour tout

, pour tout  .

.

Remarque  est remplacée par

une condition techniquement plus simple qui suffit pour les

résultats ci-dessous, mais qui exclut l'existence de

transséries imbriquées de forces supérieures.

est remplacée par

une condition techniquement plus simple qui suffit pour les

résultats ci-dessous, mais qui exclut l'existence de

transséries imbriquées de forces supérieures.

Les théorèmes suivants sont les résultats

principaux de [79, Chapitres 6–9]. En rajoutant une

hypothèse sur la cardinalité des supports, ils permettent

de clôturer un corps de transséries de force  sous les opérations

sous les opérations  .

.

et

corps exp-log totalement ordonné et

et

corps exp-log totalement ordonné et  .

Alors

.

Alors  est un corps de transséries de

force

est un corps de transséries de

force  .

.

un corps de transséries de force

un corps de transséries de force  et

et  . Alors il existe une extension

. Alors il existe une extension

de

de  ,

telle que

,

telle que  est défini dans

est défini dans  , pour tout

, pour tout  .

.

une suite croissante

de corps de transséries de force

une suite croissante

de corps de transséries de force  .

Alors

.

Alors  est également un corps de

transséries de force

est également un corps de

transséries de force  .

.

Remarque  ) avec

) avec  ,

puisque toute autre solution

,

puisque toute autre solution  vérifie

vérifie  pour une fonction

pour une fonction  -périodique

-périodique

. En particulier, le corps

original contient déjà toutes les solutions.

. En particulier, le corps

original contient déjà toutes les solutions.

Afin d'aboutir à une théorie complète, plusieurs

points du programme de l'introduction attendent d'être parfaits.

Dans l'optique de la résolution d'équations

fonctionnelles, il faudrait d'abord munir les corps de

transséries imbriquées et de forces supérieures de

dérivations et de compositions. Nous conjecturons que dans un

corps suffisamment grand de cette nature, le théorème des

fonctions intermédiaires est vérifié pour des

fonctionnelles arbitraires, fabriquées à partir de la

dérivation et de la composition. Pour ce projet, il suffit sans

doute de considérer des transséries de forces finies pour

lesquelles des paires diagonales  donnent lieu

à des transmonômes

donnent lieu

à des transmonômes  uniques.

uniques.

Un deuxième projet intéressant s'inspire de l'analogie

troublante entre les transséries et les nombres surréels

[22]. Nous conjecturons qu'il existe un isomorphisme entre

une définition adéquate des transséries et les

nombres surréels. Cela donnerait lieu à une description

ultime des ordres de croissance à l'infini par des nombres, une

structure fonctionnelle sur les nombres, et une notion de

simplicité pour les transséries. On peut espérer

que la démonstration d'un tel théorème repose

essentiellement sur une bonne définition de l'itérateur

sur les nombres surréels, pour tout

ordinal

sur les nombres surréels, pour tout

ordinal  .

.

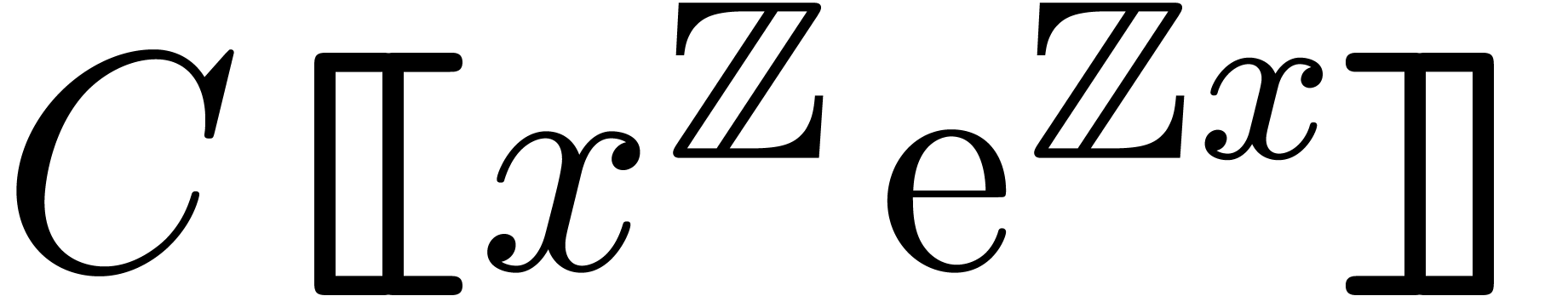

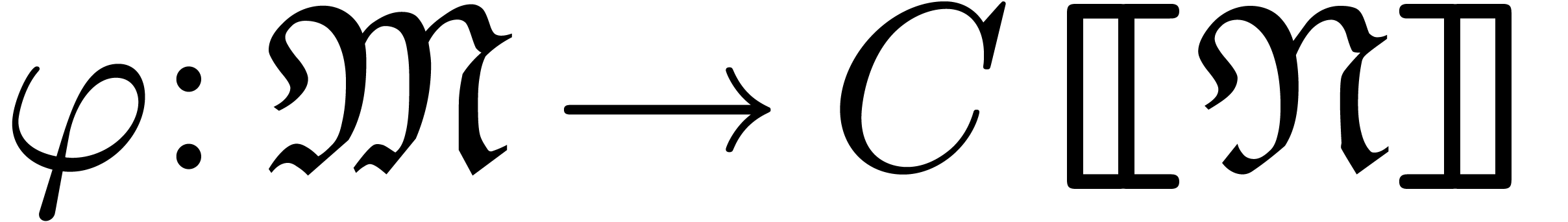

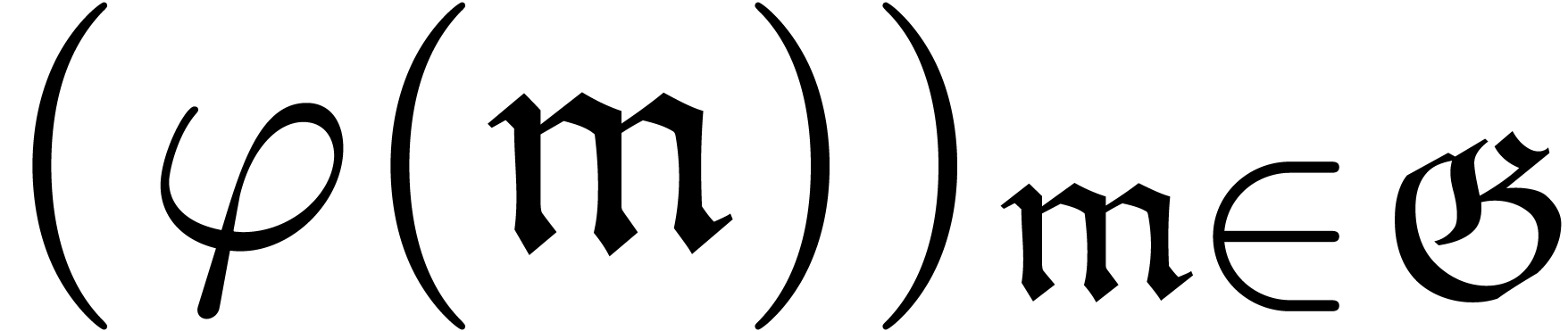

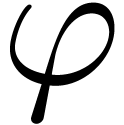

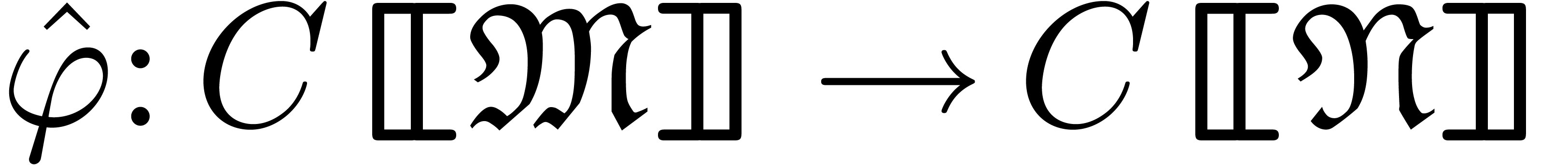

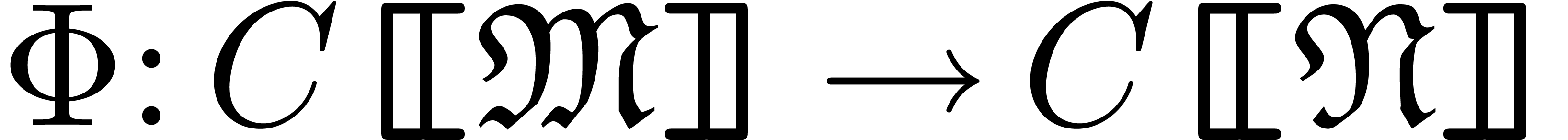

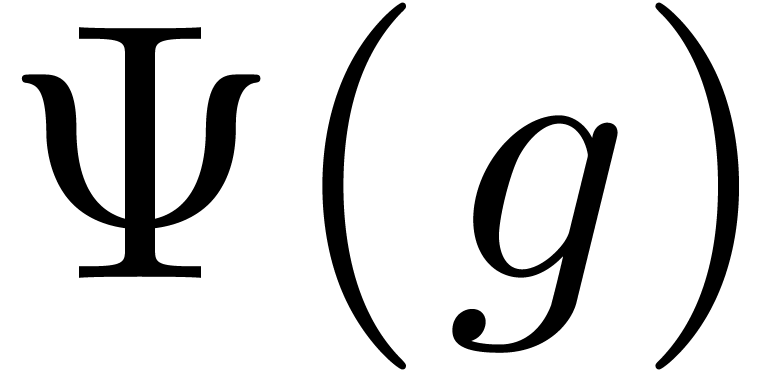

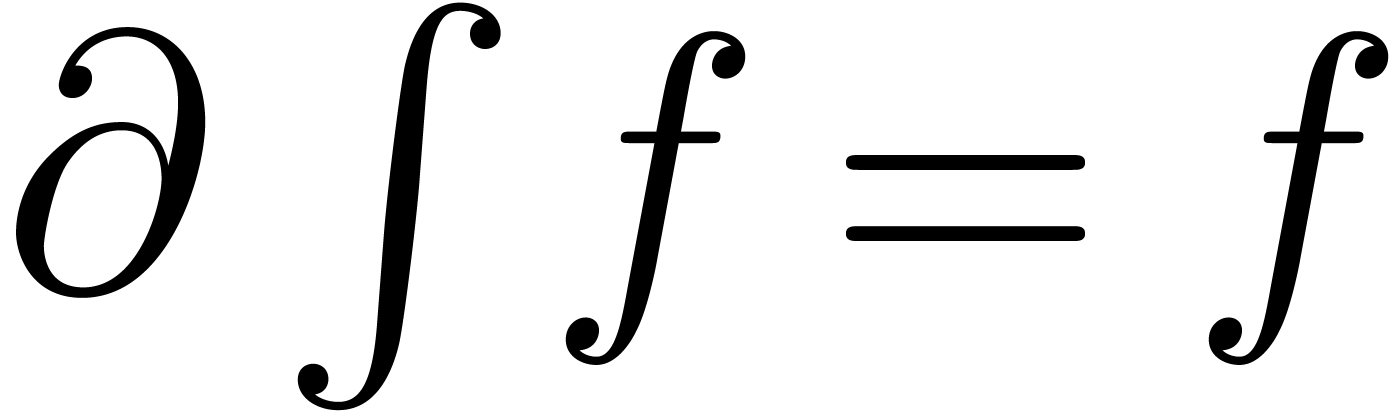

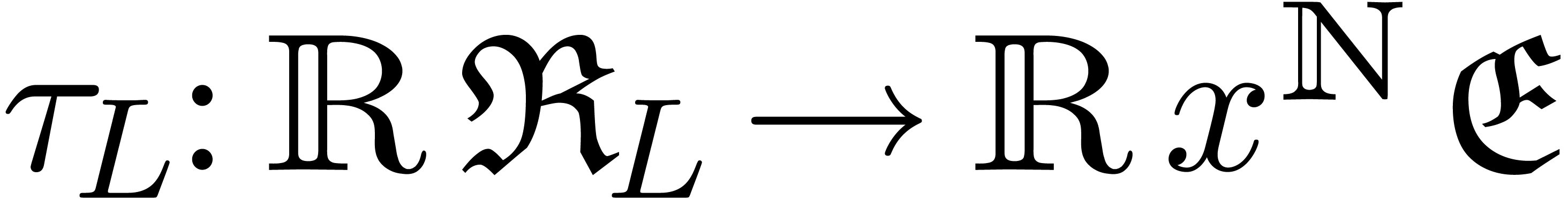

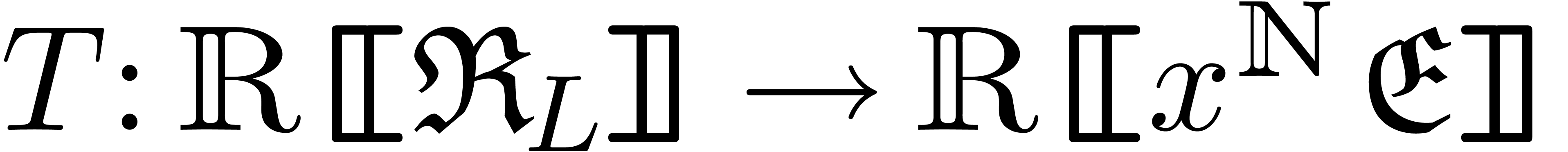

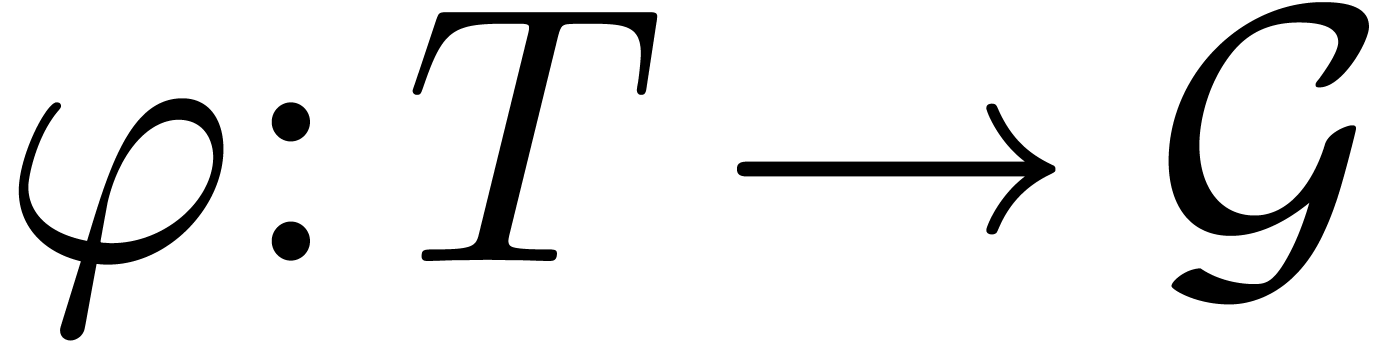

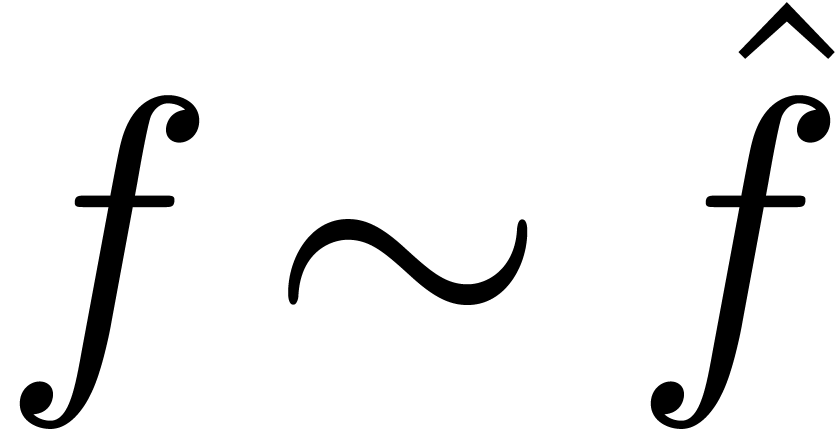

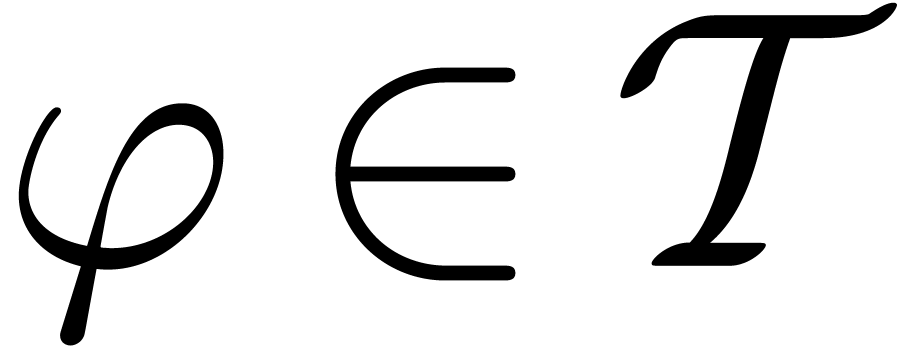

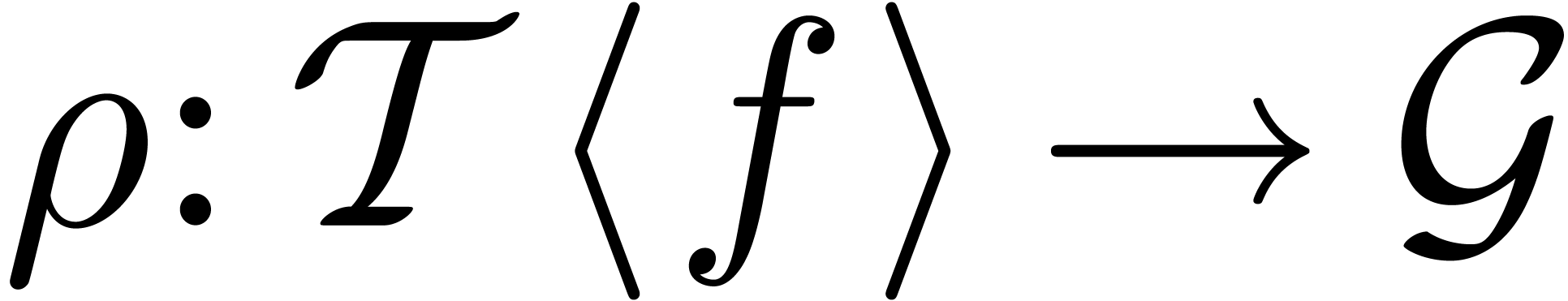

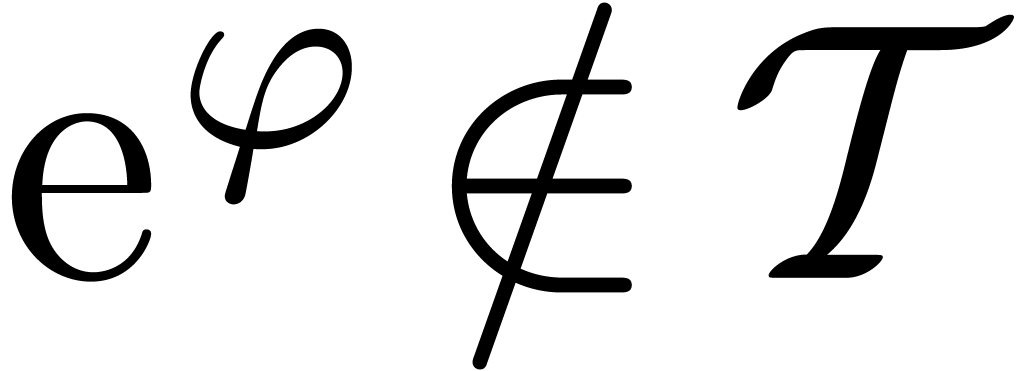

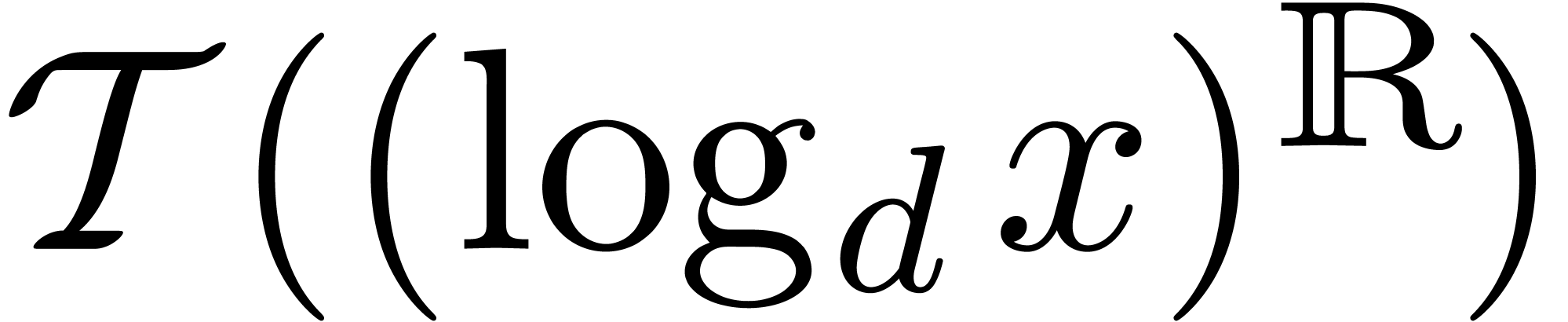

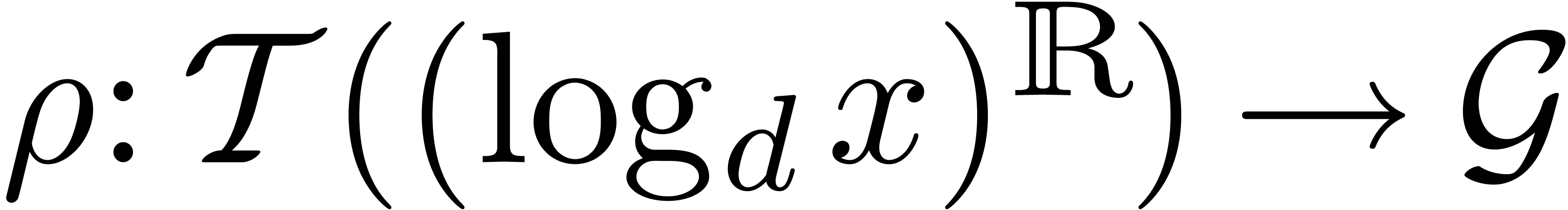

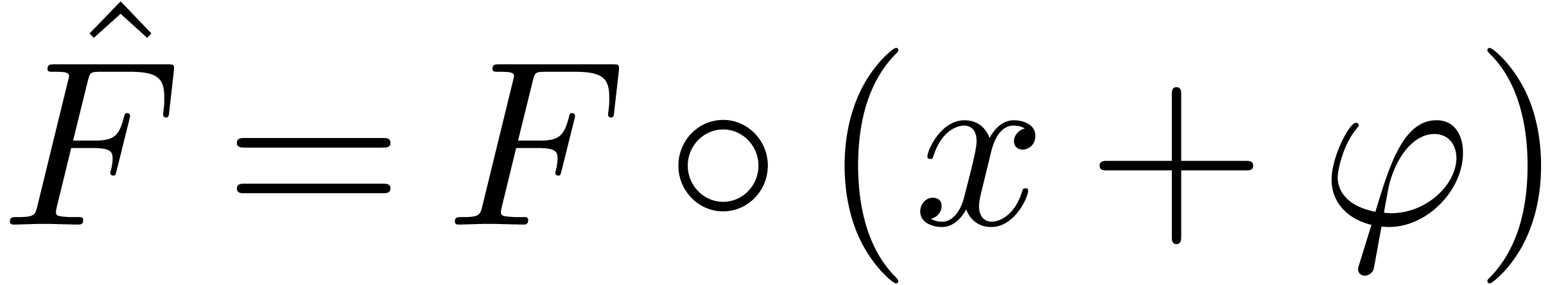

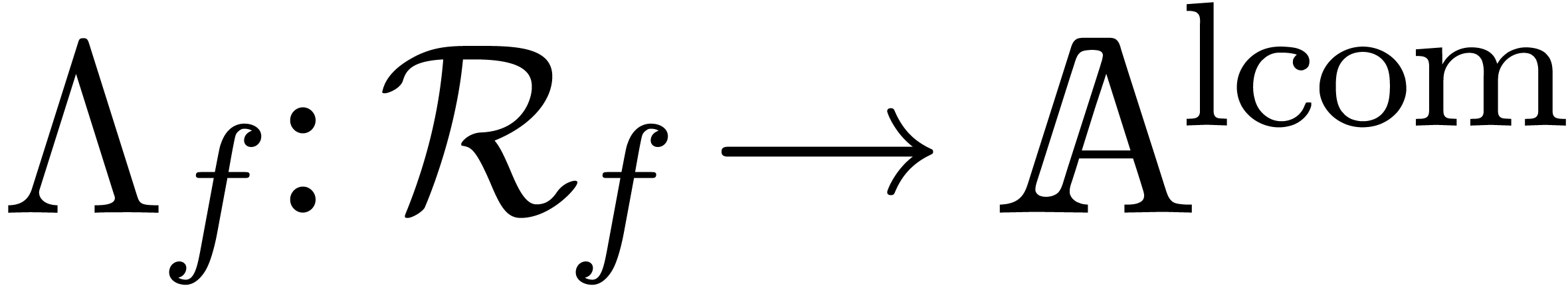

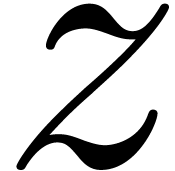

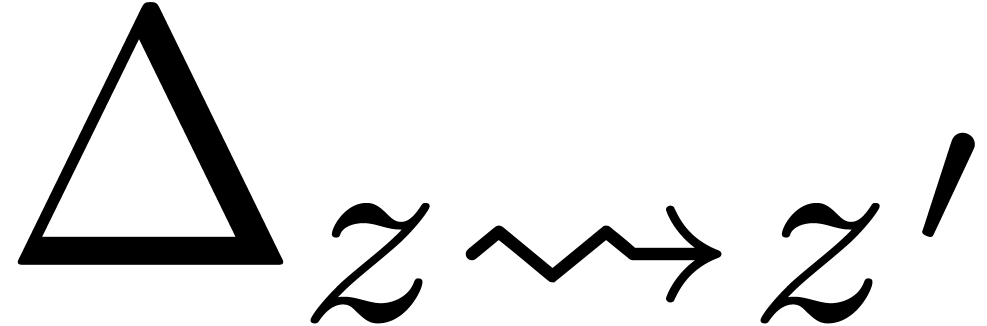

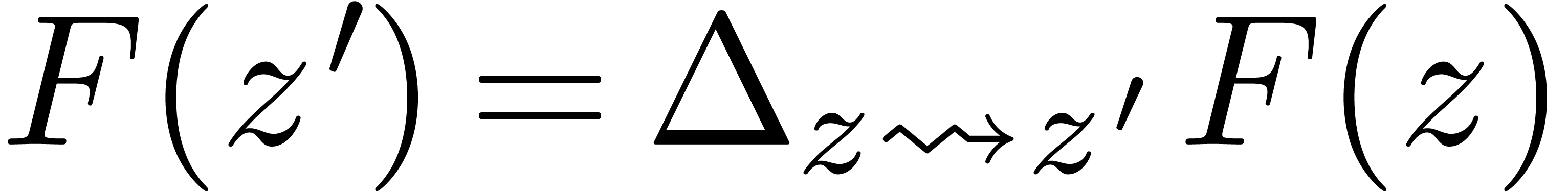

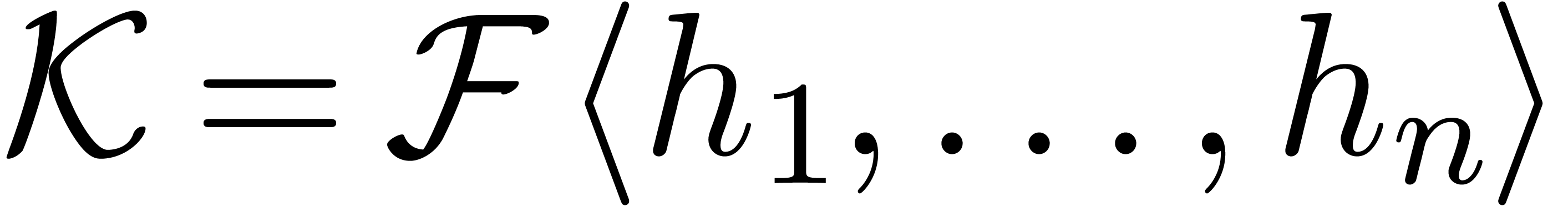

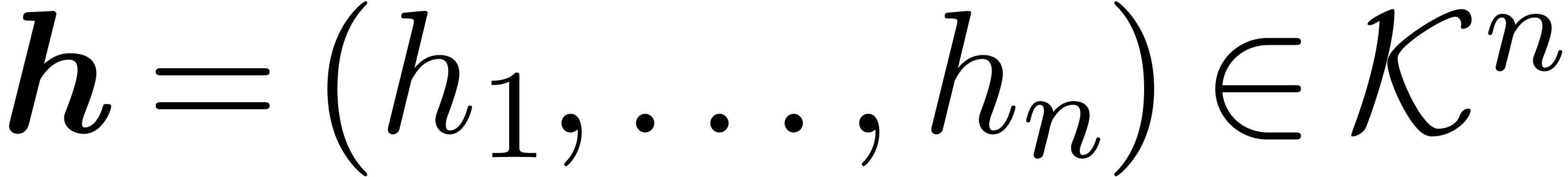

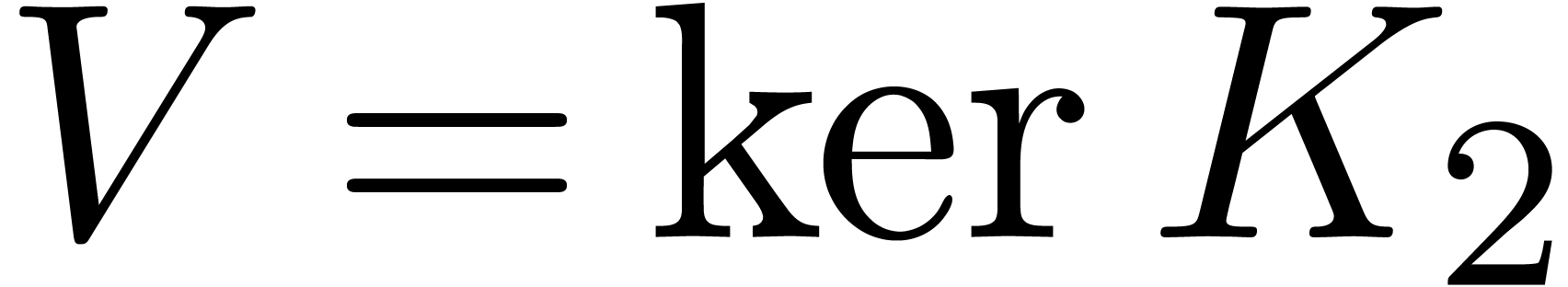

Jusqu'à présent, nous avons exclusivement abordé la théorie des transséries sous l'angle formel. On peut faire le lien avec l'analyse d'au moins deux façons :

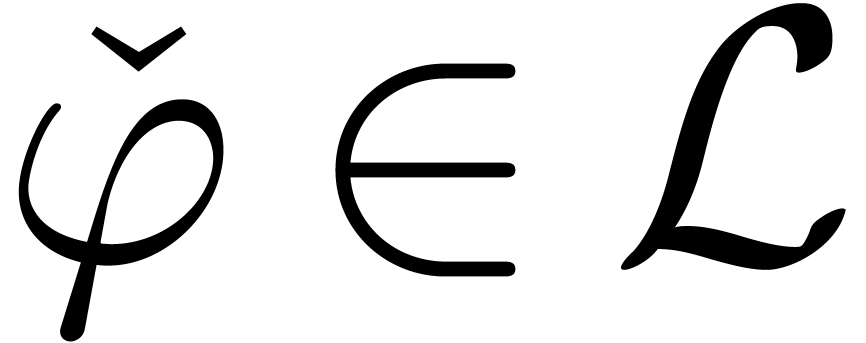

Étant donné un ensemble  de

transséries, issu d'un problème naturel, comment

interpréter les éléments de

de

transséries, issu d'un problème naturel, comment

interpréter les éléments de  comme des germes de fonctions réelles à l'infini ? En

d'autres termes, désignant par

comme des germes de fonctions réelles à l'infini ? En

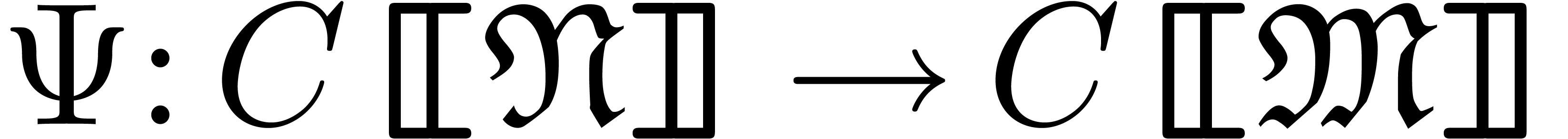

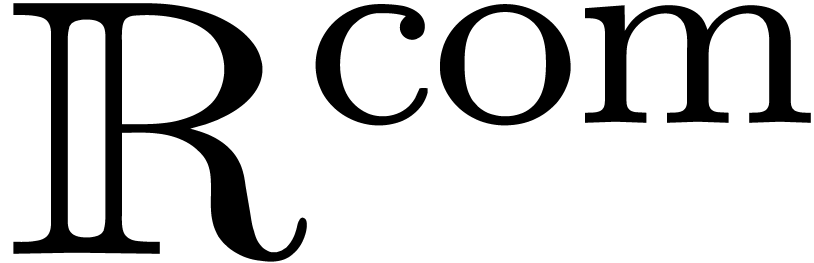

d'autres termes, désignant par  l'anneau des germes de fonctions réelles infiniment

dérivables à l'infini, comment construire un

monomorphisme

l'anneau des germes de fonctions réelles infiniment

dérivables à l'infini, comment construire un

monomorphisme  , qui

préserve le plus de structure possible (comme l'ordre, la

dérivation et la composition) ?

, qui

préserve le plus de structure possible (comme l'ordre, la

dérivation et la composition) ?

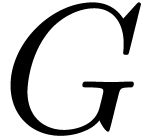

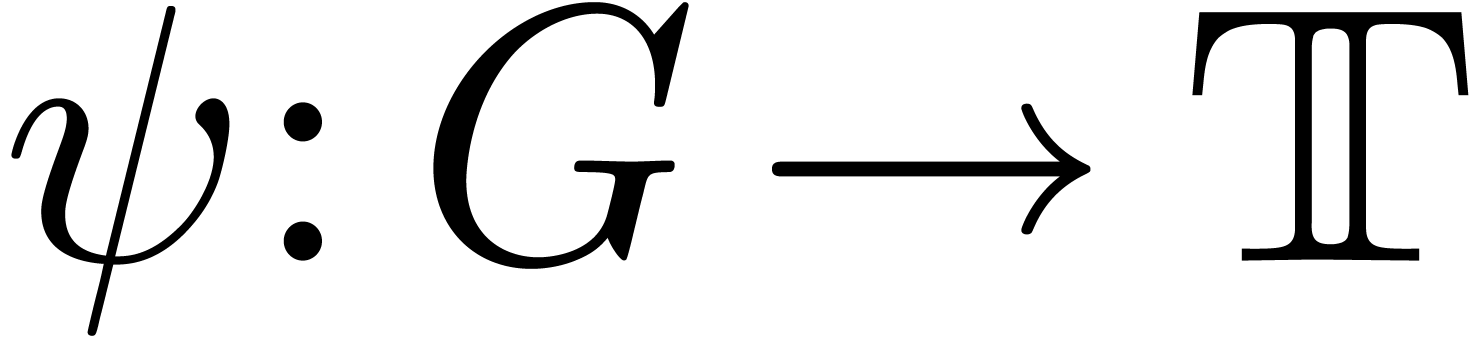

Étant donné un ensemble  de

germes à l'infini, comment modéliser

de

germes à l'infini, comment modéliser  par un ensemble de transséries ? Autrement dit, comment

construire un monomorphisme

par un ensemble de transséries ? Autrement dit, comment

construire un monomorphisme  qui

préserve le plus de structure possible ?

qui

préserve le plus de structure possible ?

Nous étudierons ces questions dans les sections 3.1,

3.2 et 3.3. Plus généralement,

on peut chercher à axiomatiser les propriétés des

corps de Hardy et remplacer  par n'importe quel

autre modèle d'une théorie obtenue ainsi. On

développera brièvement ce point de vue dans la section 3.4.

par n'importe quel

autre modèle d'une théorie obtenue ainsi. On

développera brièvement ce point de vue dans la section 3.4.

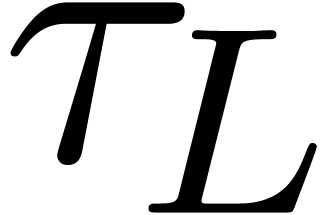

Sans doute, la meilleure méthode pour donner un sens analytique aux transséries est le procédé d'accéléro-sommation réelle d'Écalle. Cette théorie est esquissée dans ses grandes lignes dans [37, 38], mais reste à être étendue afin de s'appliquer aux solutions d'équations différentielles du chapitre 1. L'avantage de l'accéléro-sommation réside dans son caractère à la fois canonique et explicite : après sélection d'une « bonne moyenne », tout arbitraire dans la méthode disparaît et toute la structure (dérivation, composition, ordre) est naturellement préservée.

Dans sa forme la plus générale, l'accéléro-sommation fait appel à de nombreuses techniques : fonctions résurgentes, calcul accélératoire, bonnes moyennes, arborification, gestion des échelles, etc. Ayant recherché en vain quelques simplifications, il nous semble que le procédé soit intrinsèquement complexe à mettre en œuvre dans le cadre qui nous intéresse.

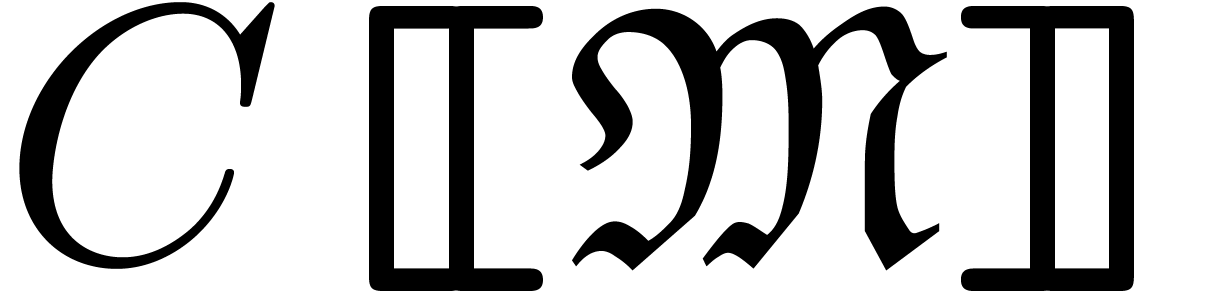

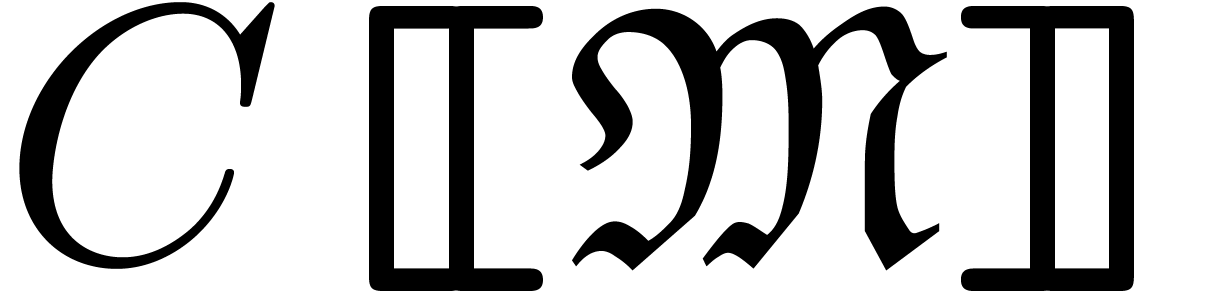

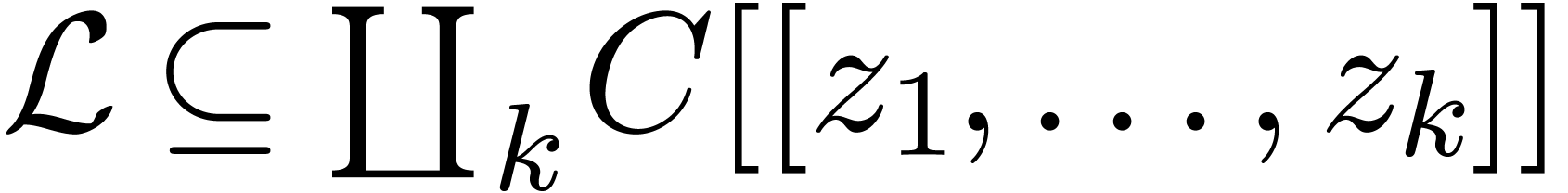

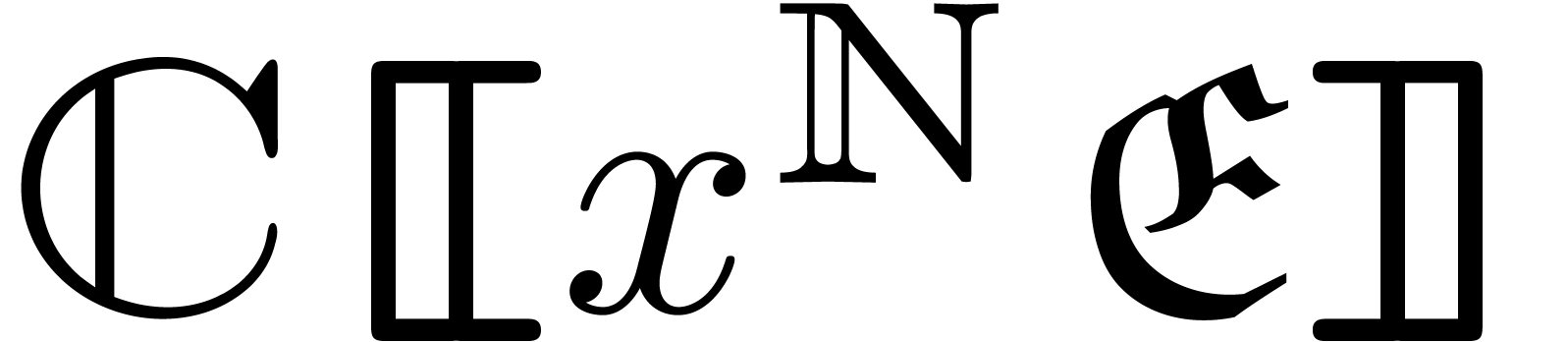

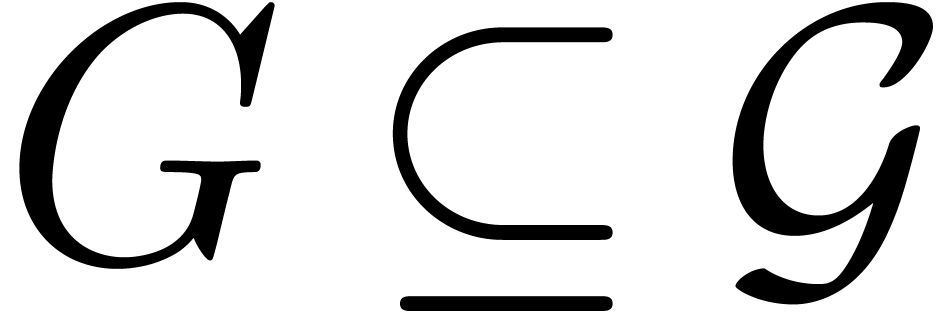

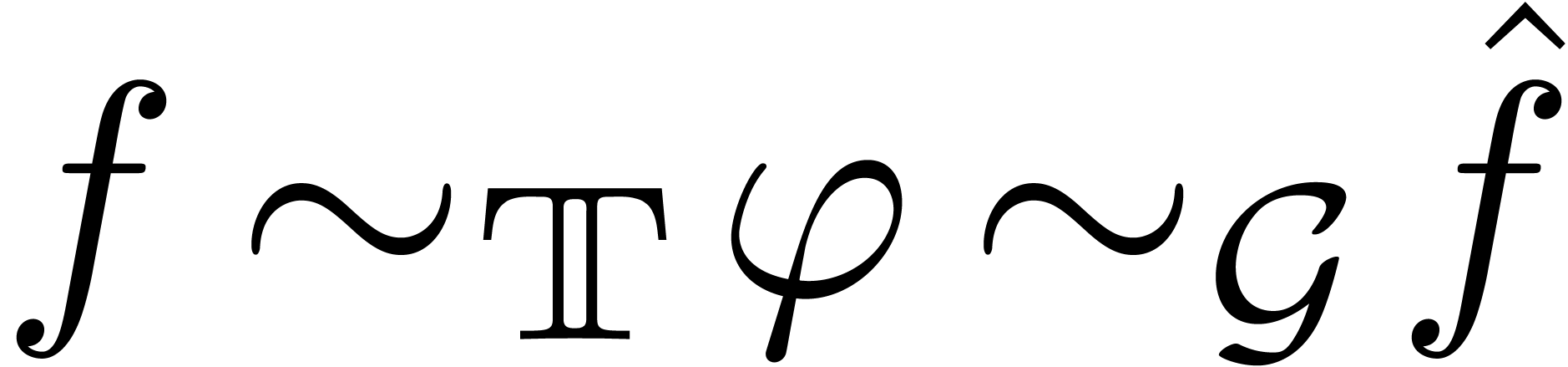

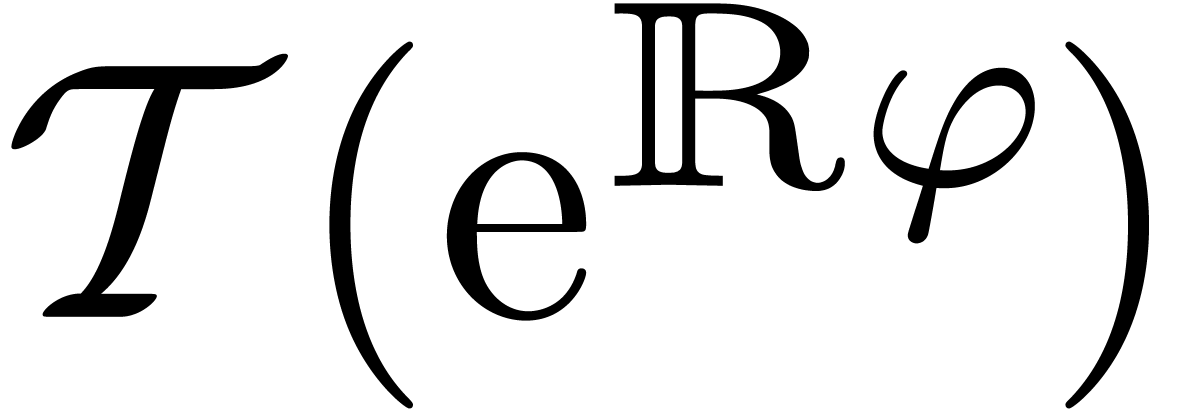

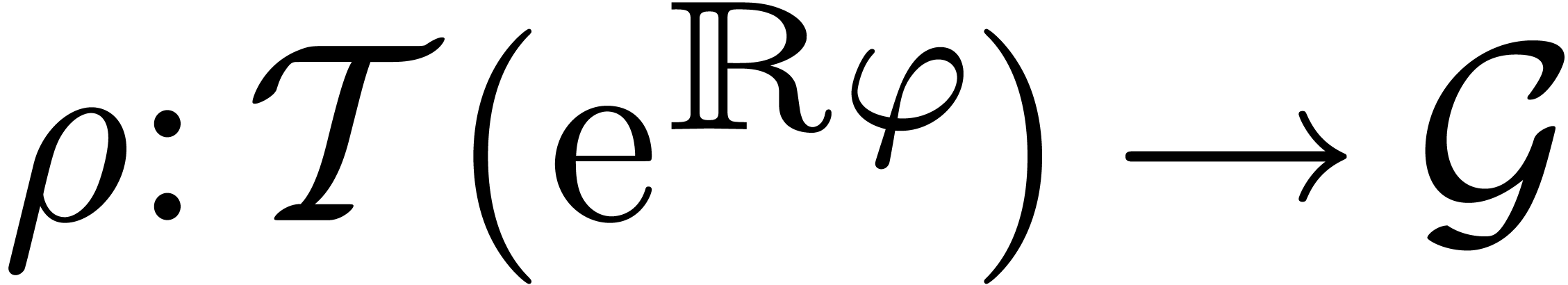

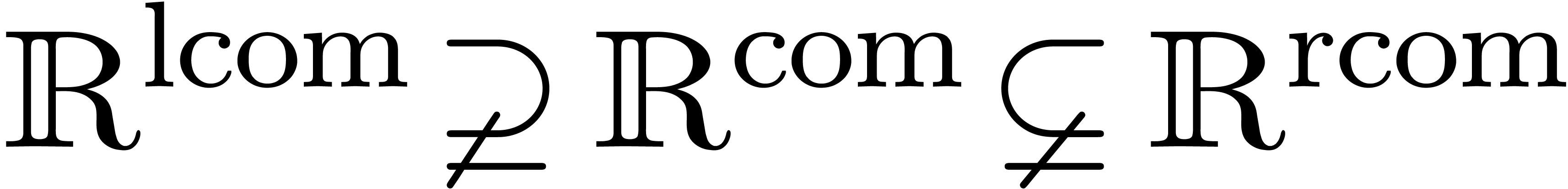

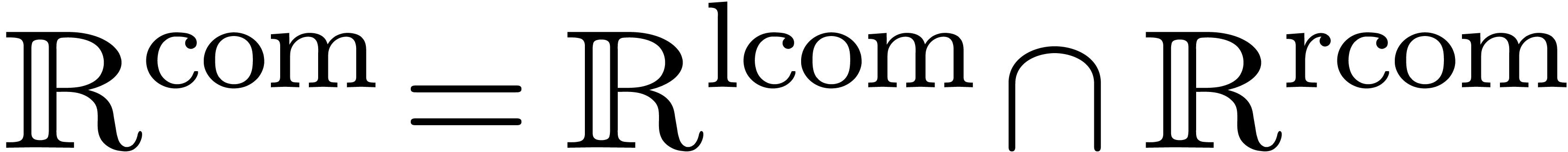

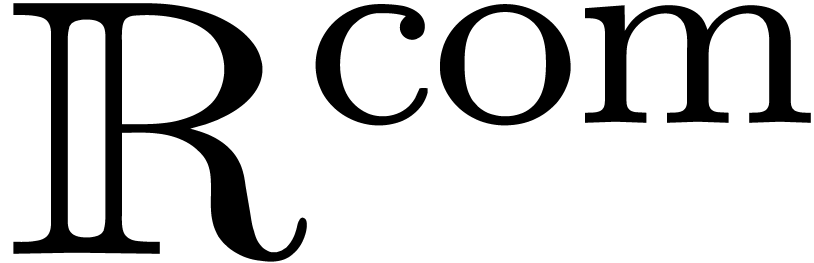

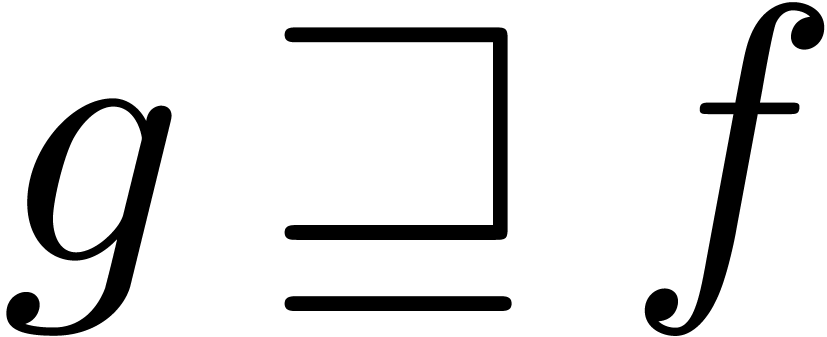

Si on laisse tomber l'exigence de canonicité, une autre

façon de procéder consiste à unifier la

théorie des transséries avec la théorie des corps

de Hardy. Plus précisément, considérons le corps

des transséries réticulées.

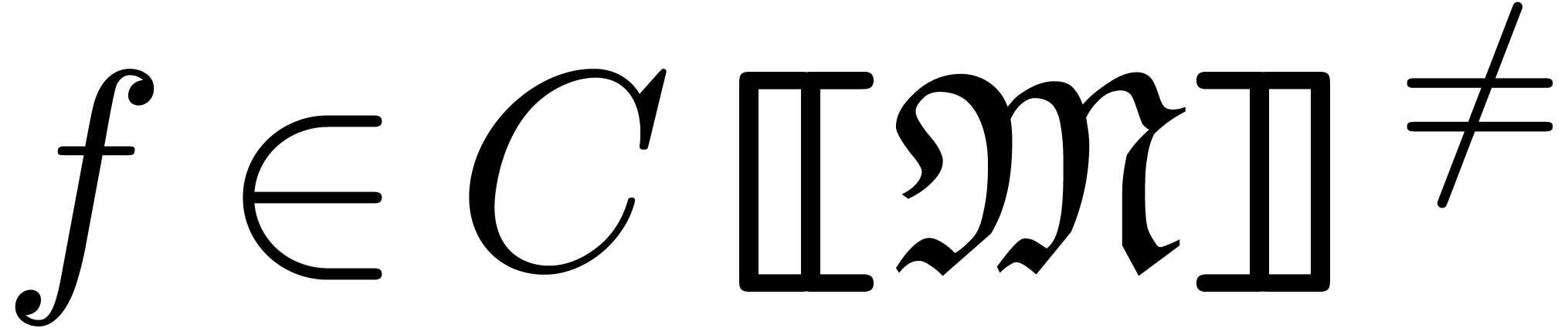

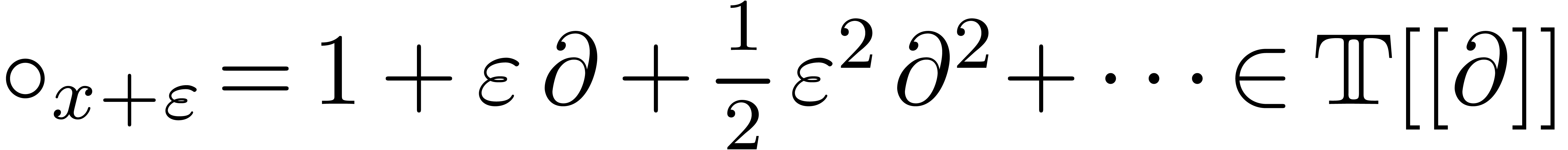

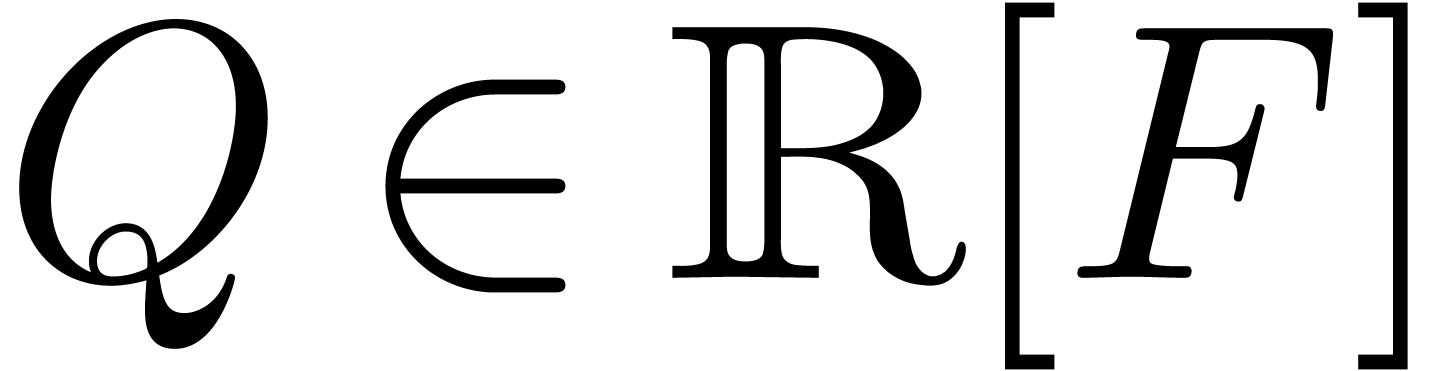

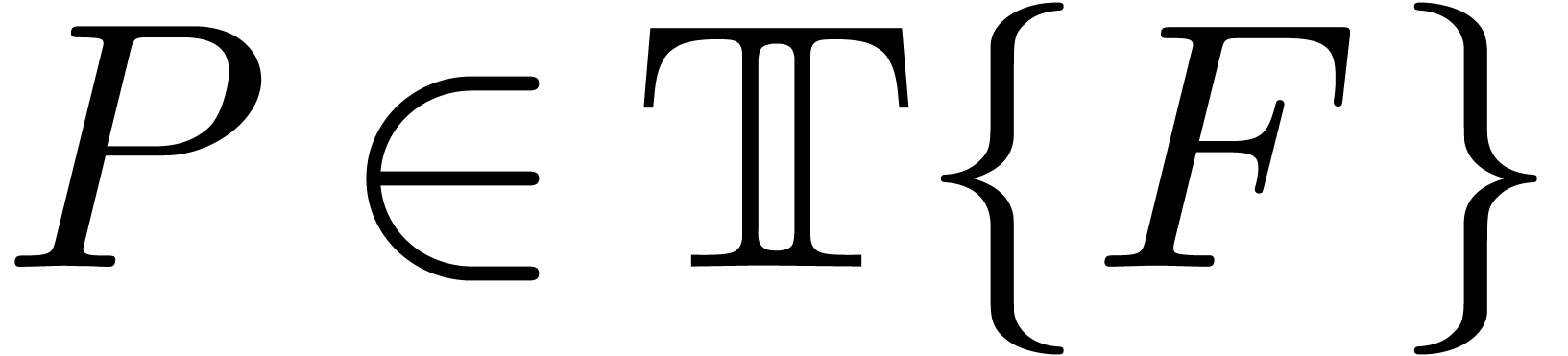

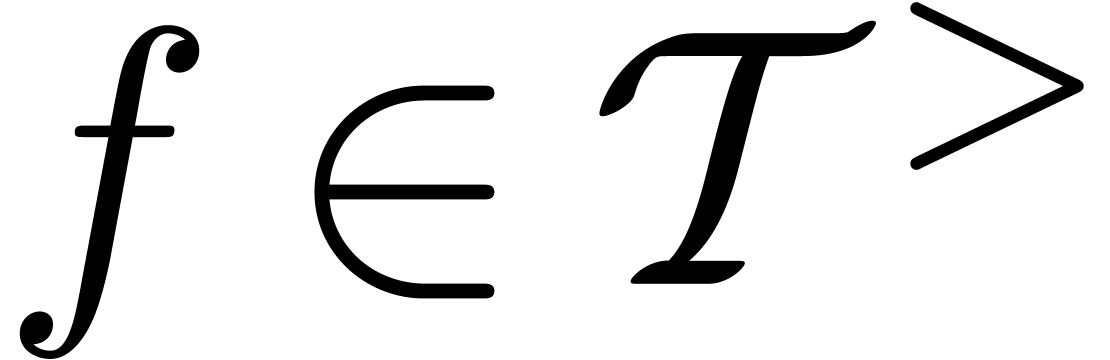

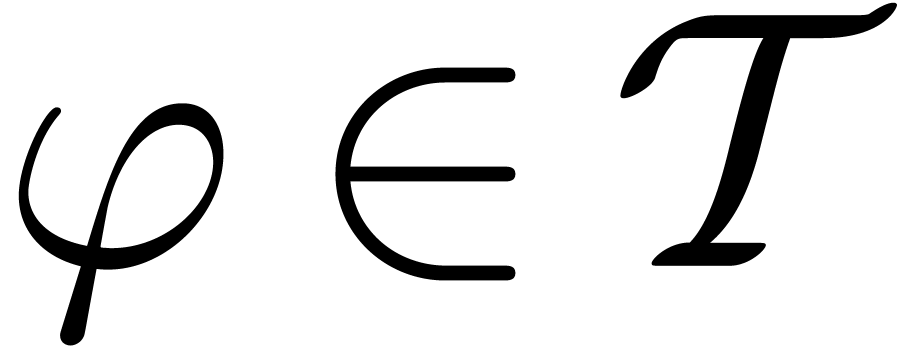

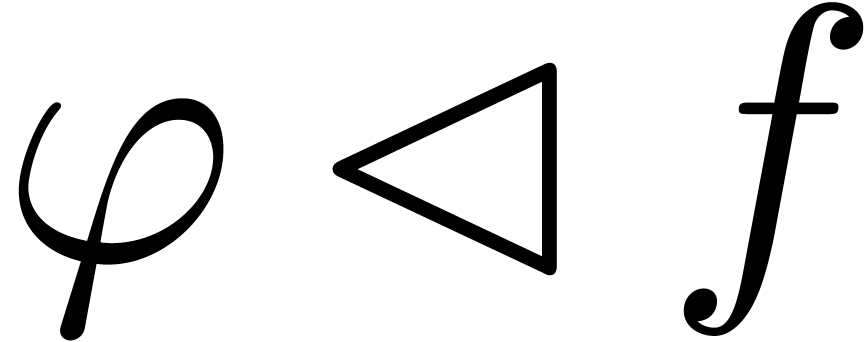

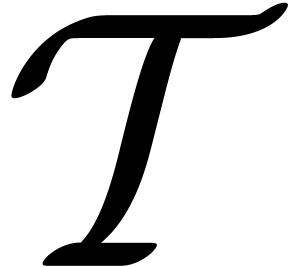

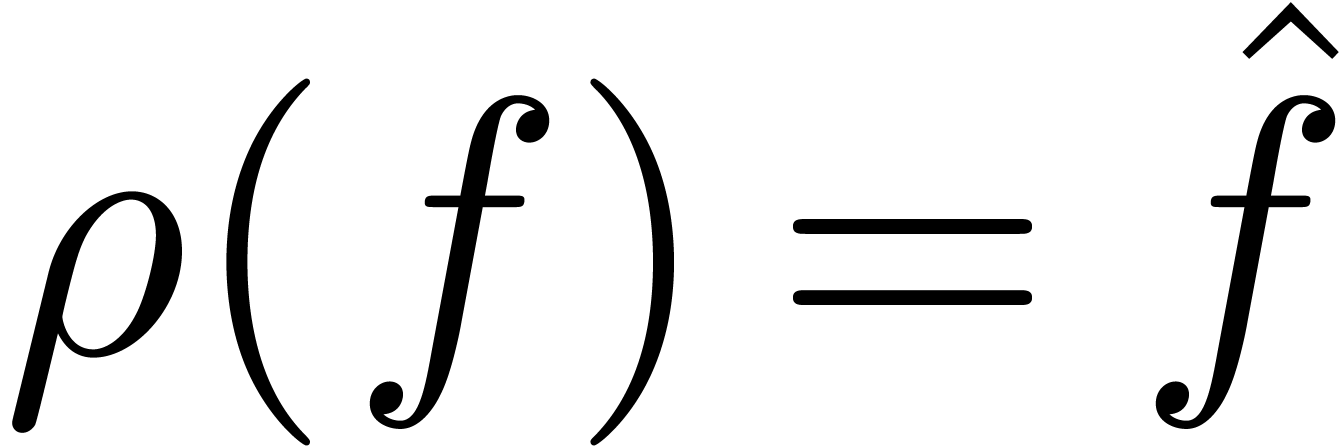

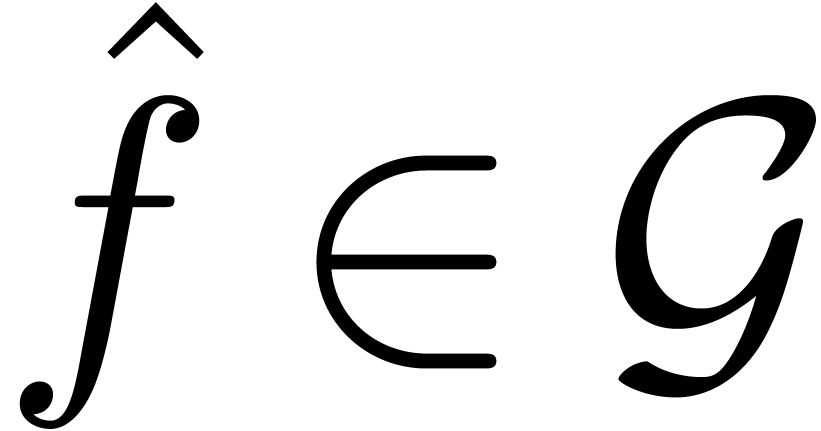

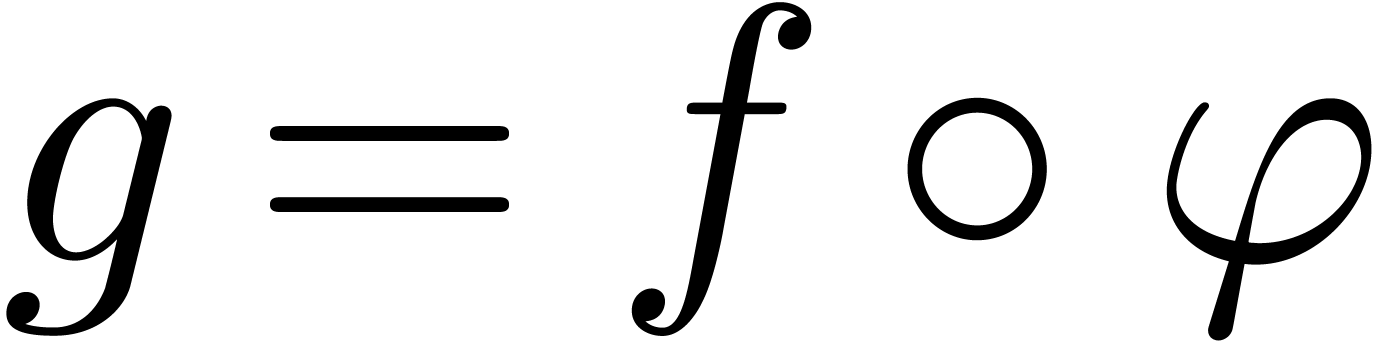

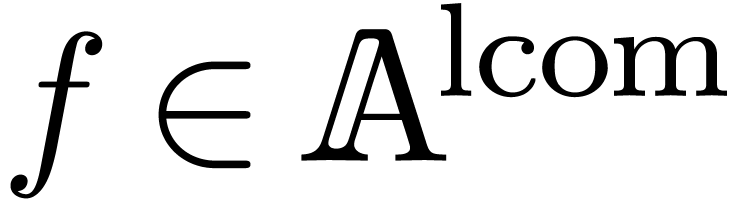

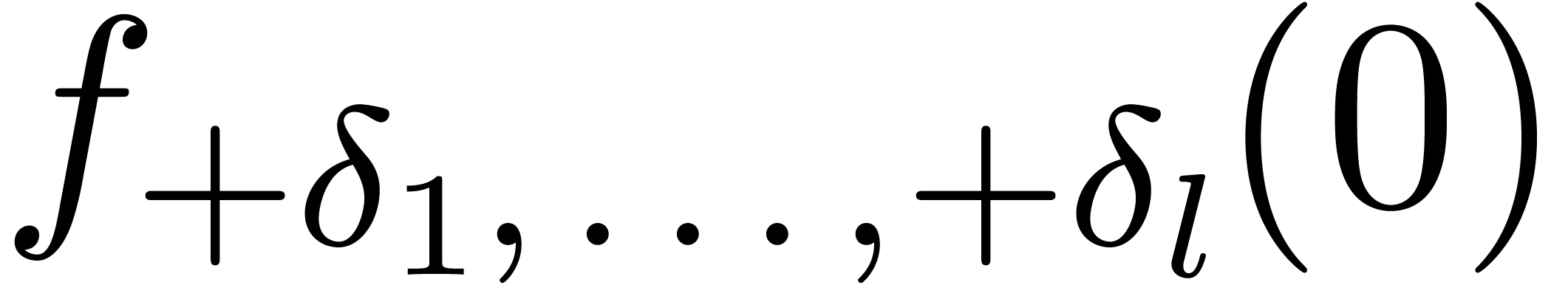

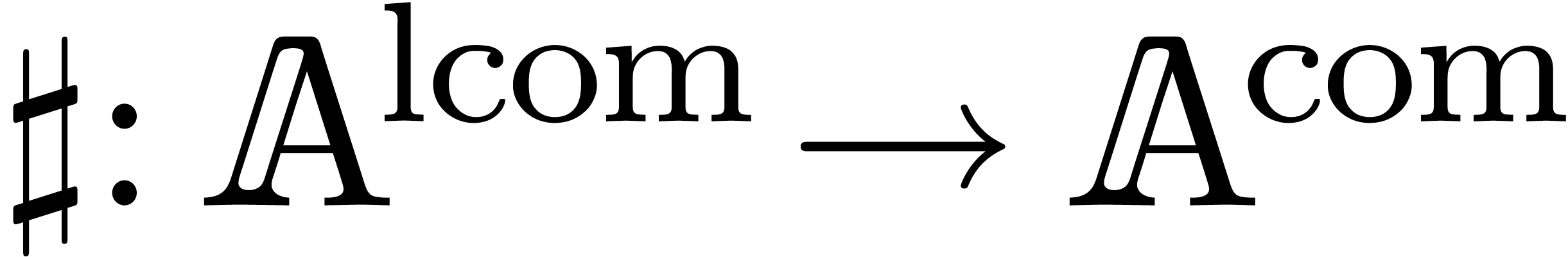

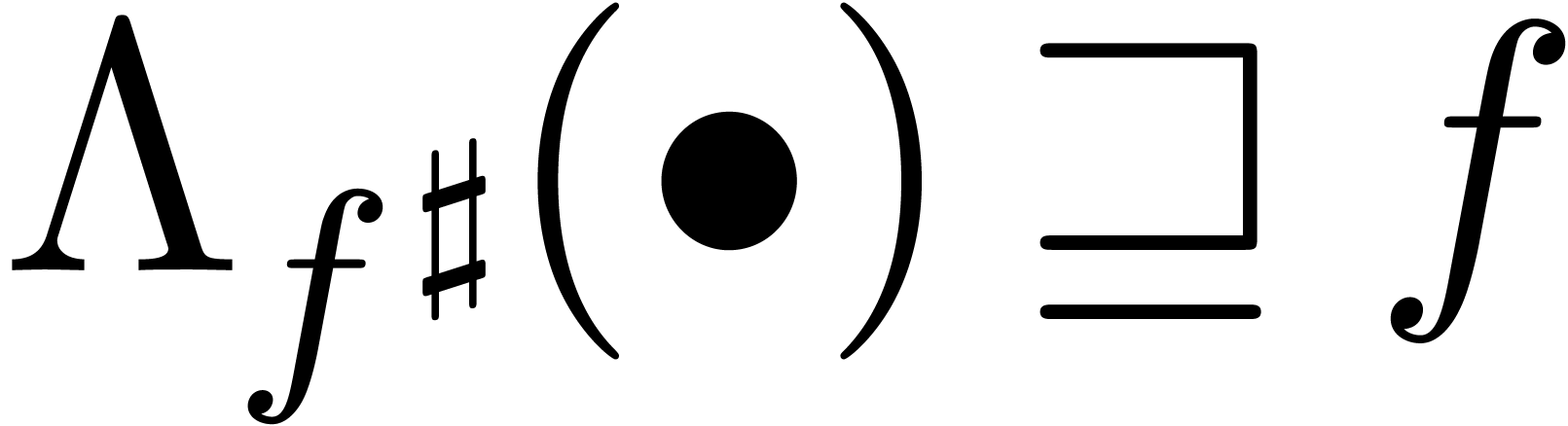

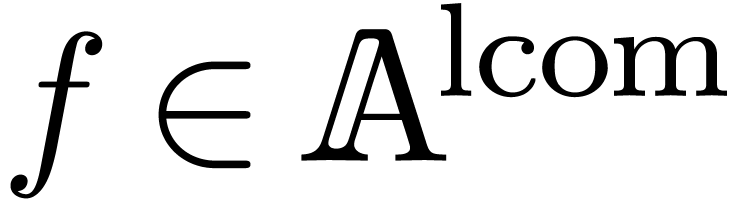

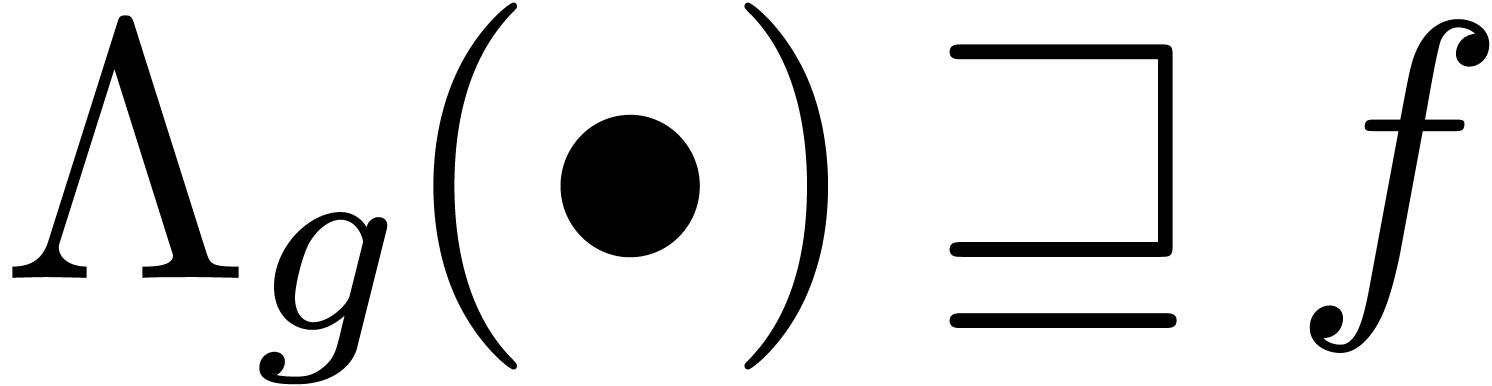

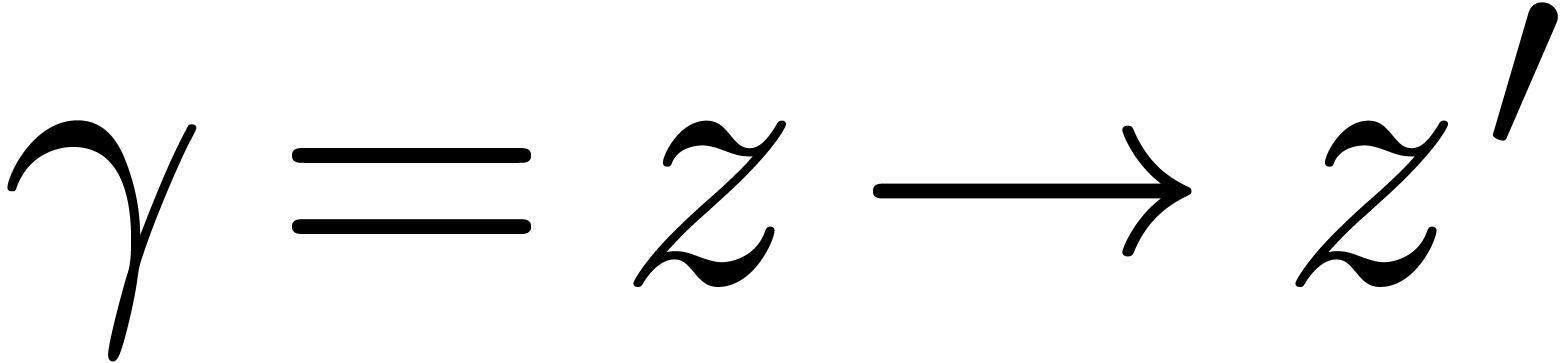

Un corps de Hardy transsériel est un sous-corps

différentiel

des transséries réticulées.

Un corps de Hardy transsériel est un sous-corps

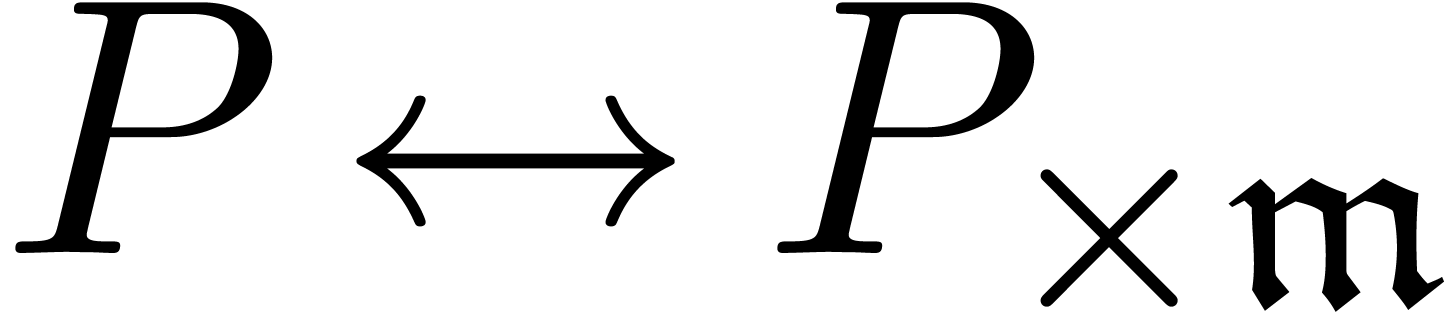

différentiel  de

de  , muni d'un monomorphisme

, muni d'un monomorphisme  de

de

-algèbres

différentielles ordonnées, tel que

-algèbres

différentielles ordonnées, tel que

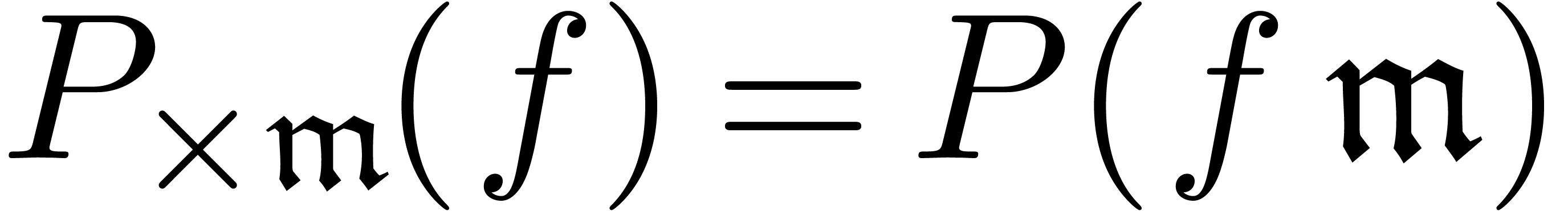

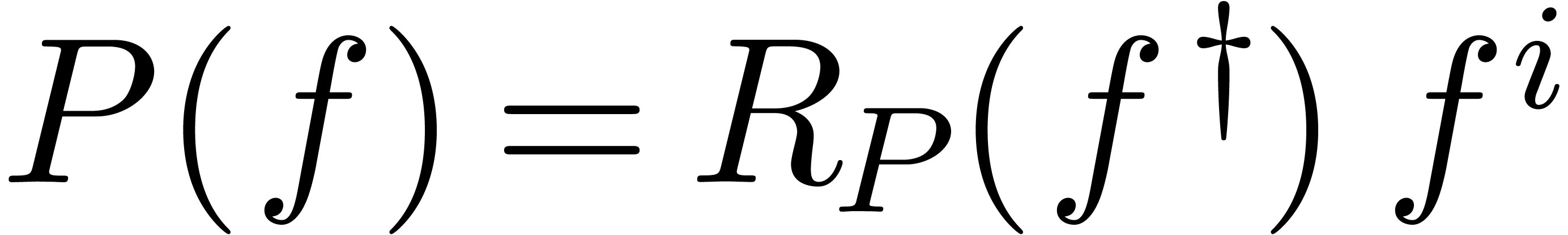

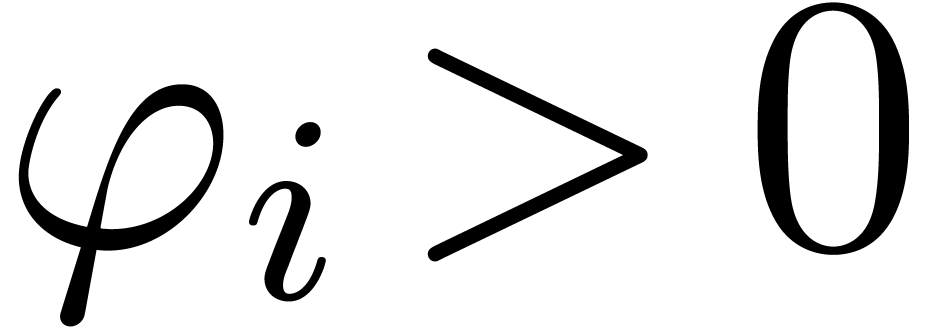

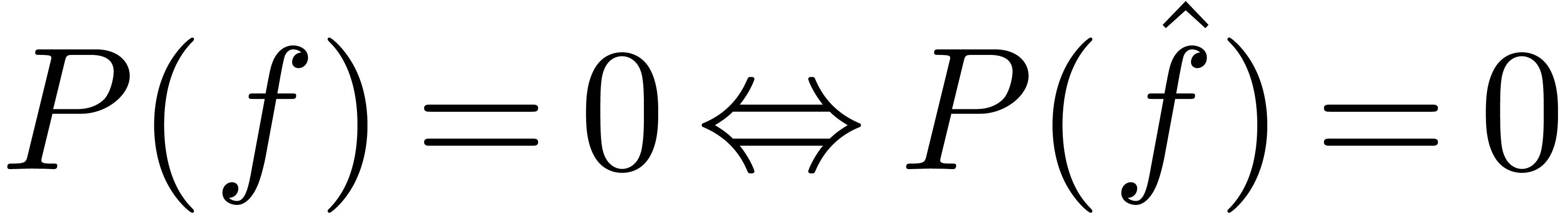

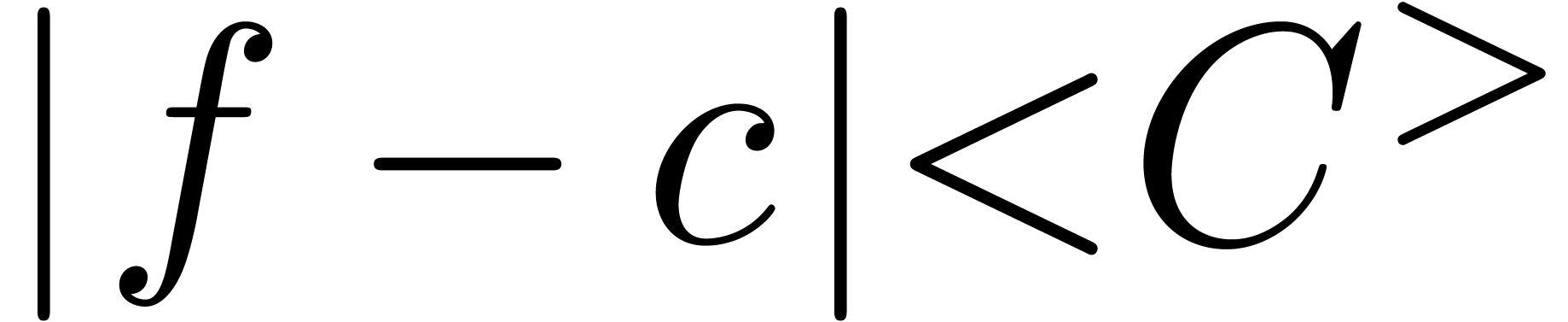

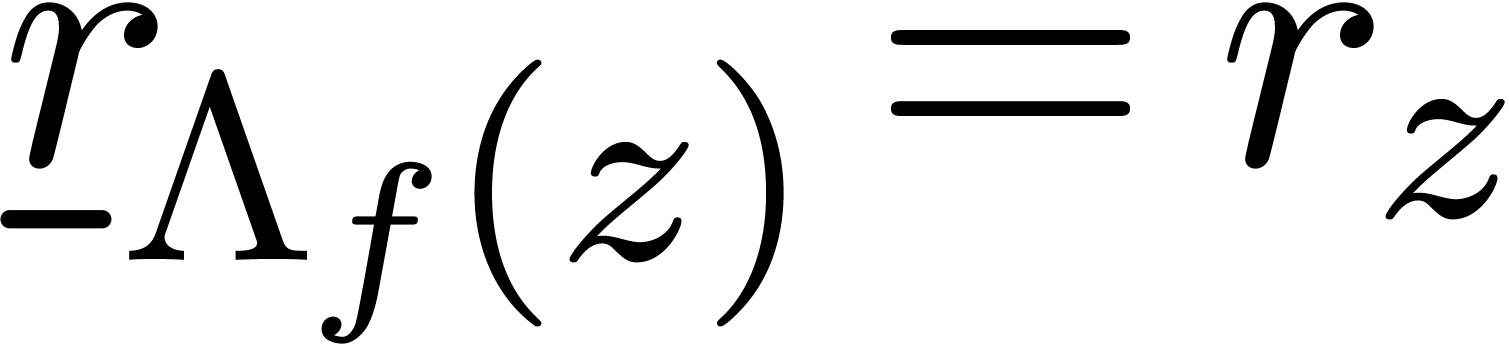

Pour tout  , on a

, on a  .

.

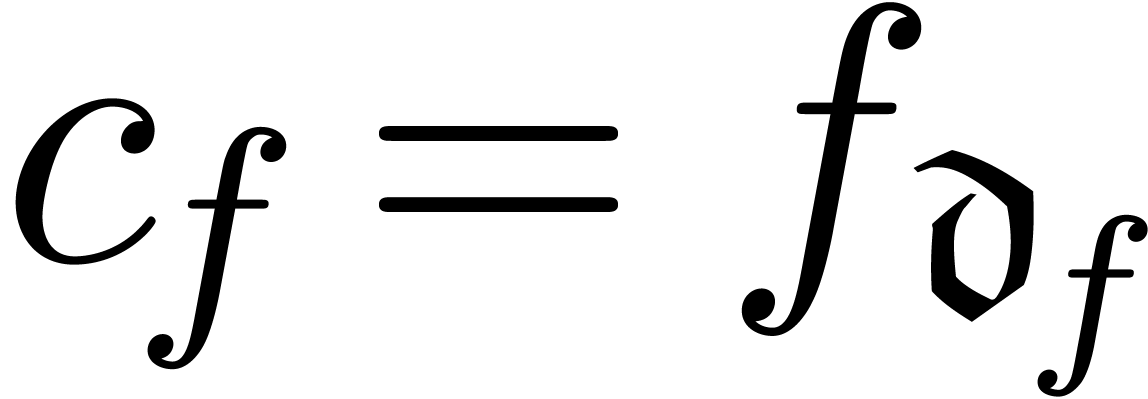

Pour tout  , on a

, on a  .

.

Il existe un  avec

avec  pour tout

pour tout  .

.

L'ensemble  est stable sous la prise de

puissances réelles.

est stable sous la prise de

puissances réelles.

On a  pour tout

pour tout  avec

avec  .

.

Il est commode d'identifier  avec son image sous

avec son image sous

, qui est

nécessairement un corps de Hardy au sens classique. Comme

d'habitude, le jeu consiste ensuite à étendre

, qui est

nécessairement un corps de Hardy au sens classique. Comme

d'habitude, le jeu consiste ensuite à étendre  avec de nouvelles transséries

avec de nouvelles transséries  ou fonctions

ou fonctions  . Typiquement,

le nouvel élément

. Typiquement,

le nouvel élément  vérifie

une équation différentielle à coefficients dans

vérifie

une équation différentielle à coefficients dans

.

.

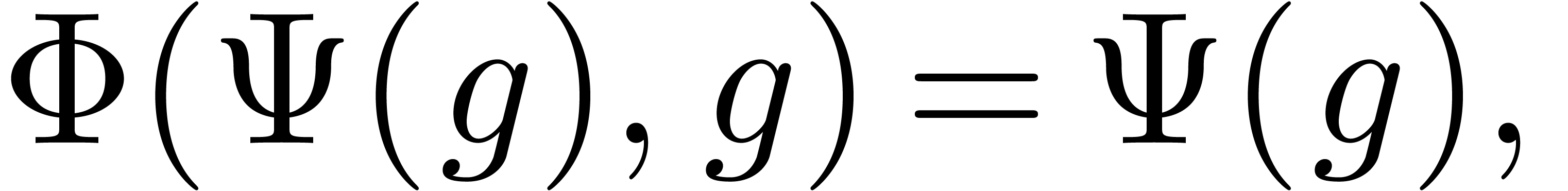

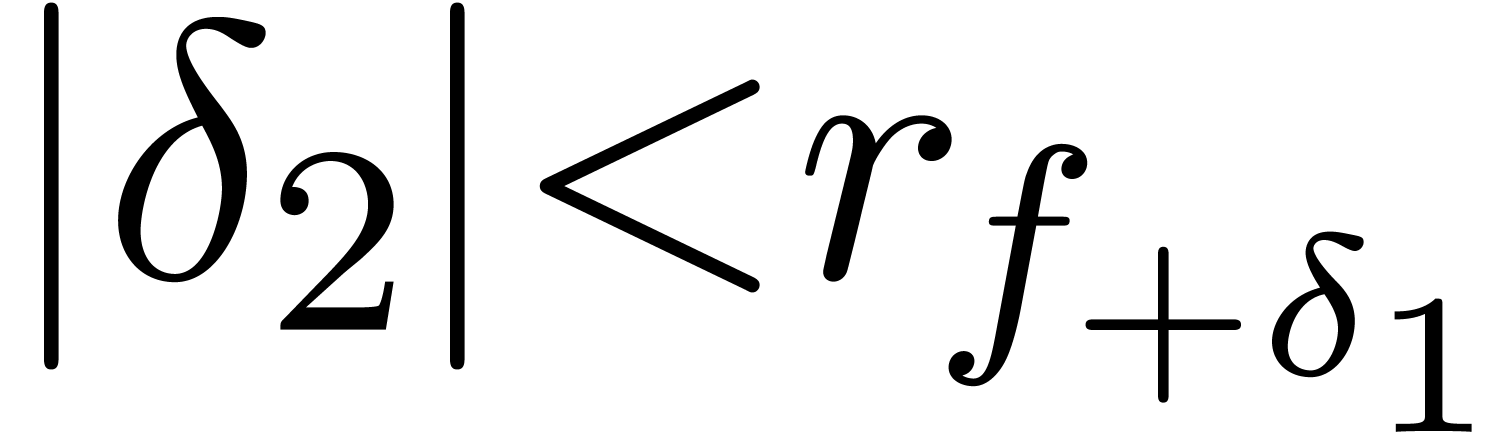

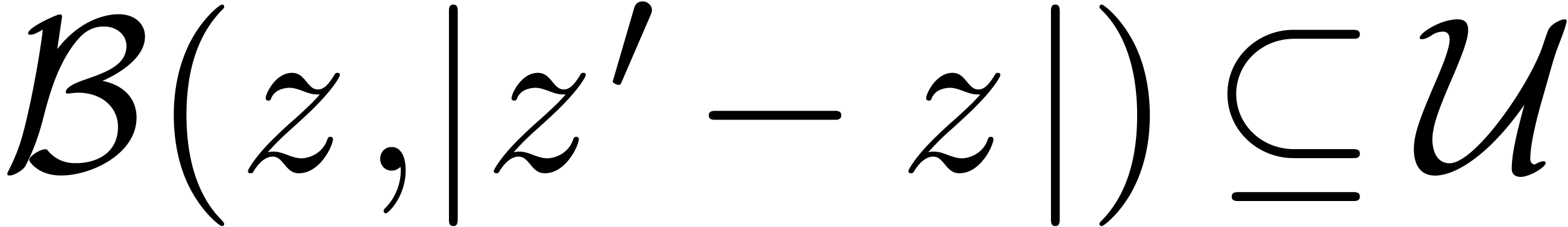

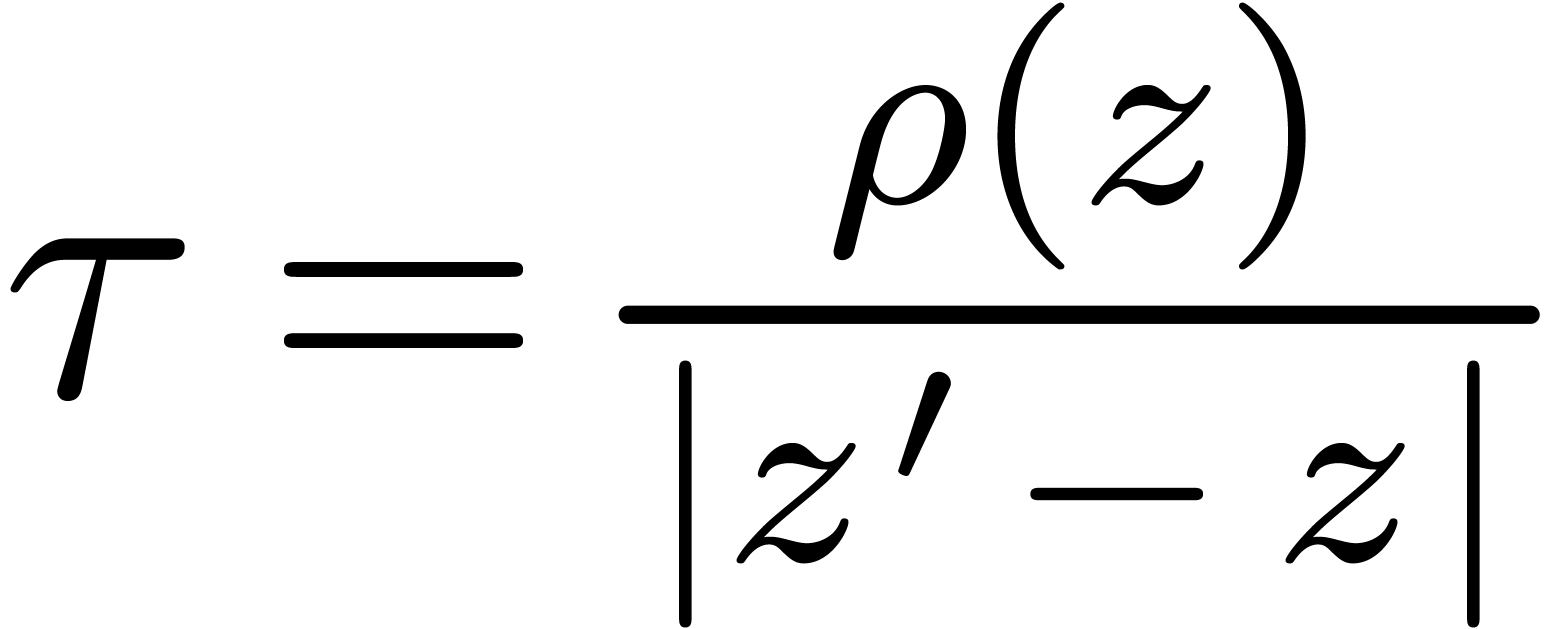

Afin de formuler le lemme central pour réaliser de telles

extensions, on a besoin d'introduire quelques notions. Étant

donnés  et

et  ,

on écrit

,

on écrit  , s'il existe

un

, s'il existe

un  avec

avec  .

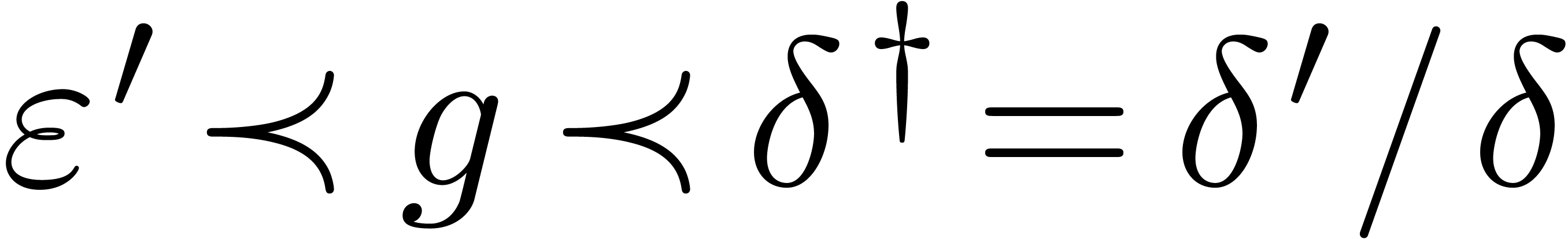

On dira que

.

On dira que  et

et  sont

asymptotiquement équivalents sur

sont

asymptotiquement équivalents sur  , si

, si  pour tout

pour tout  , et différentiellement

équivalents sur

, et différentiellement

équivalents sur  si

si  pour tout

pour tout  . On appellera

aussi coupure sérielle tout élément

. On appellera

aussi coupure sérielle tout élément  tel que

tel que  n'admet pas

d'élément

n'admet pas

d'élément  -minimal

et tel que toute troncature stricte

-minimal

et tel que toute troncature stricte  est dans

est dans

.

.

et

et  tels que

tels que

est une coupure sérielle sur

est une coupure sérielle sur  .

.

et

et  sont

asymptotiquement équivalents sur

sont

asymptotiquement équivalents sur  .

.

et

et  sont

différentiellement équivalents sur

sont

différentiellement équivalents sur  .

.

Alors  est un corps de Hardy

transsériel pour l'unique morphisme différentiel

est un corps de Hardy

transsériel pour l'unique morphisme différentiel  sur

sur  avec

avec  .

.

de

de  admet une unique structure de corps de Hardy transsériel qui

étend celle de

admet une unique structure de corps de Hardy transsériel qui

étend celle de  .

.

Dans le langage de la théorie des modèles, le lemme 3.1 fournit un moyen pour réaliser des «

extensions élémentaires », qui préservent le

groupe des valeurs  de

de  . Les autres extensions différentiellement

algébriques se ramènent essentiellement à rajouter

des exponentielles ou des logarithmes :

. Les autres extensions différentiellement

algébriques se ramènent essentiellement à rajouter

des exponentielles ou des logarithmes :

tel

que

tel

que  . Alors

. Alors  est un corps de Hardy transsériel pour l'unique morphisme

différentiel

est un corps de Hardy transsériel pour l'unique morphisme

différentiel  sur

sur  avec

avec  pour tout

pour tout  .

.

, mais

, mais  .

Alors

.

Alors  est un corps de Hardy transsériel

pour l'unique morphisme différentiel

est un corps de Hardy transsériel

pour l'unique morphisme différentiel  sur

sur

avec

avec  pour tout

pour tout  .

.

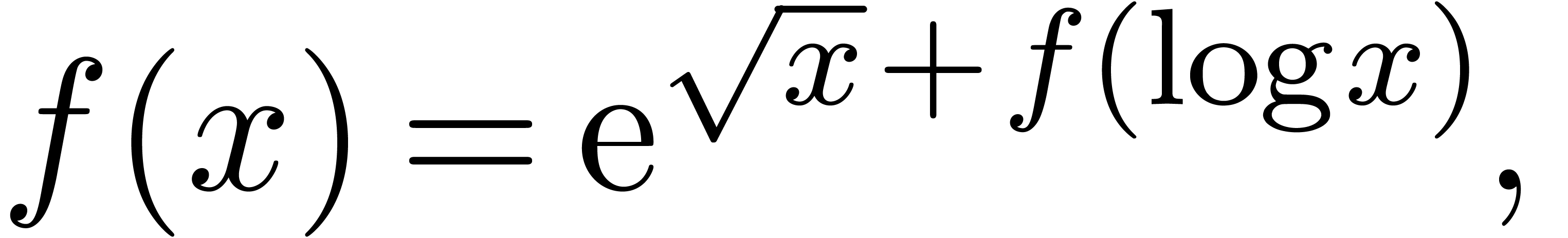

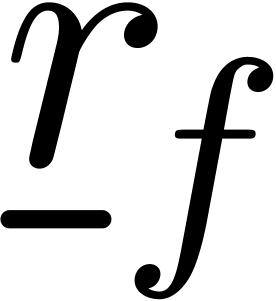

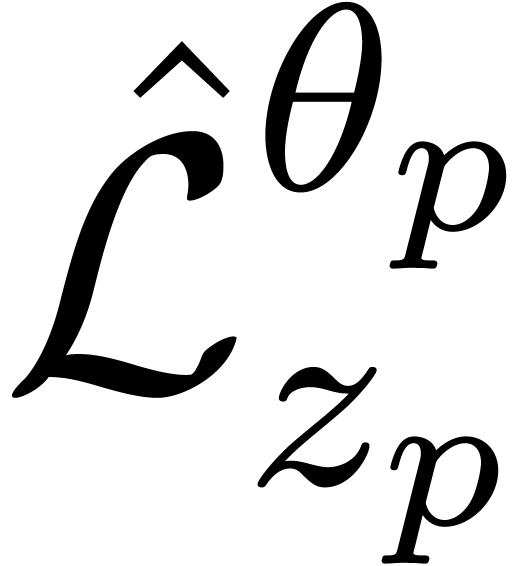

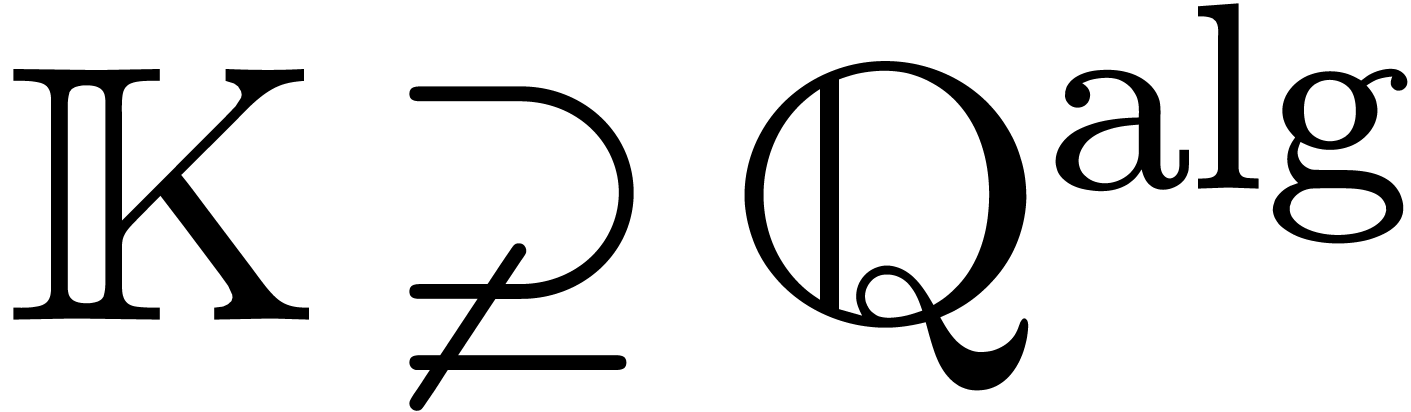

Étant donné un corps de Hardy  , supposons maintenant que l'on veuille adjoindre

une transsérie différentiellement algébrique

, supposons maintenant que l'on veuille adjoindre

une transsérie différentiellement algébrique  sur

sur  . Pour

cela, il faut d'abord être en mesure de fournir une contre-partie

analytique

. Pour

cela, il faut d'abord être en mesure de fournir une contre-partie

analytique  de

de  ,

au moins lorsque

,

au moins lorsque  vérifie une

équation sous une forme normale adéquate. Une technique

simple pour construire de telles

vérifie une

équation sous une forme normale adéquate. Une technique

simple pour construire de telles  est

basée sur les intégrales itérées. Par

exemple, l'équation

est

basée sur les intégrales itérées. Par

exemple, l'équation

admet une solution naturelle

qui converge quand on intègre systématiquement depuis

. Dans des cas moins

favorables, comme

. Dans des cas moins

favorables, comme

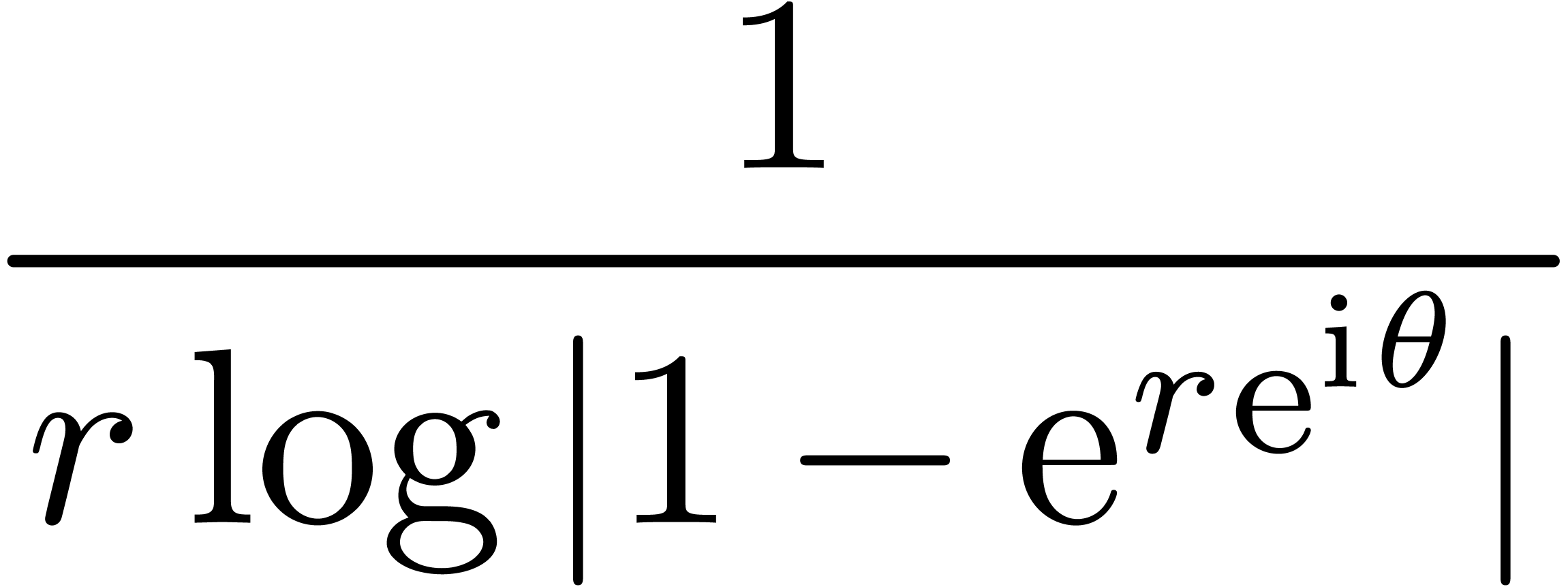

il faut plutôt intégrer depuis un point  suffisamment grand. L'inconvénient de la méthode par

rapport à l'accéléro-sommation tient d'ailleurs en

ceci que le choix du point

suffisamment grand. L'inconvénient de la méthode par

rapport à l'accéléro-sommation tient d'ailleurs en

ceci que le choix du point  n'a rien de

canonique. Toutefois, pour n'importe quel choix de

n'a rien de

canonique. Toutefois, pour n'importe quel choix de  , on obtient bel et bien une solution.

, on obtient bel et bien une solution.

De façon plus systématique, on montre d'abord qu'il est

toujours possible de mettre l'équation pour  sous forme normale

sous forme normale

|

(3.1) |

où  est « petit » et

est « petit » et  se factorise

se factorise

sur  . On montre ensuite

comment résoudre (3.1) dans

. On montre ensuite

comment résoudre (3.1) dans  par des intégrales itérées, en utilisant le fait

que

par des intégrales itérées, en utilisant le fait

que  admet

admet  comme

solution. On obtient ainsi une contre-partie analytique

comme

solution. On obtient ainsi une contre-partie analytique  asymptotiquement équivalent à

asymptotiquement équivalent à  sur

sur

. La préservation de

la réalité est assez technique, mais peut être

assurée en faisant les différentes constructions avec

soin. En supposant que

. La préservation de

la réalité est assez technique, mais peut être

assurée en faisant les différentes constructions avec

soin. En supposant que  vérifie une

équation différentielle algébrique de

complexité (

vérifie une

équation différentielle algébrique de

complexité ( ) minimale

(où

) minimale

(où  est l'ordre de

est l'ordre de  ,

,  et

et  ), on montre en outre que

), on montre en outre que  et

et

vérifient les mêmes

équations différentielles sur

vérifient les mêmes

équations différentielles sur  . Cela nous permet enfin d'adjoindre

. Cela nous permet enfin d'adjoindre  en appliquant le lemme 3.1.

en appliquant le lemme 3.1.

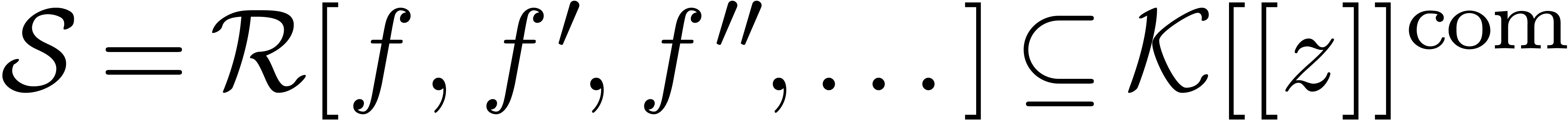

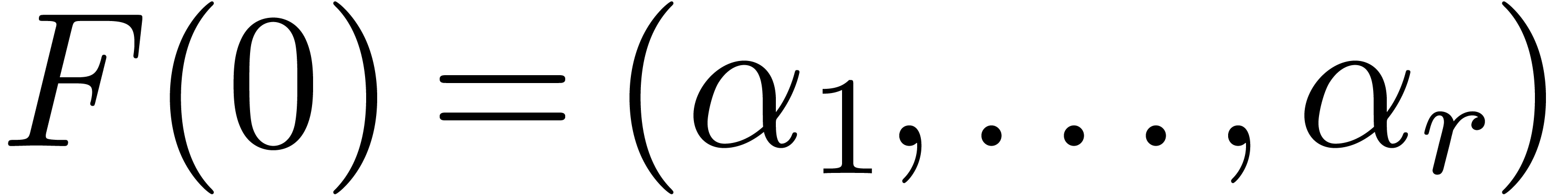

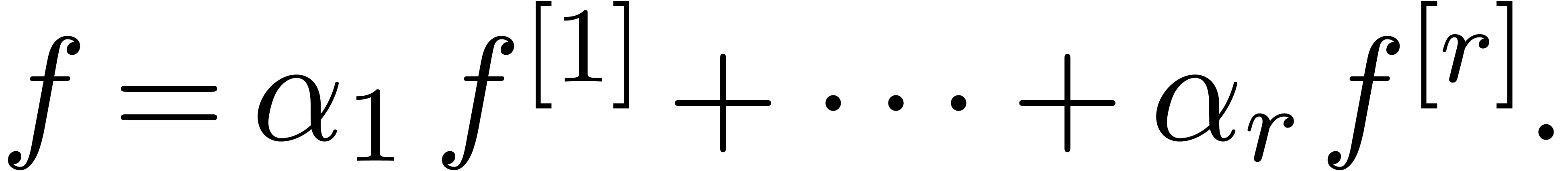

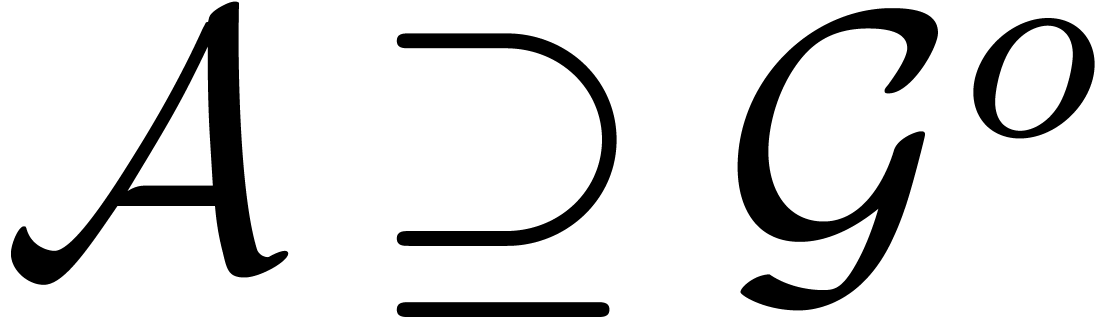

un

corps de Hardy transsériel et soit

un

corps de Hardy transsériel et soit  le

plus petit sous-corps différentiel de

le

plus petit sous-corps différentiel de  tel

que

tel

que  pour tout

pour tout  et

et  . Alors la structure de corps de

Hardy transsériel s'étend à

. Alors la structure de corps de

Hardy transsériel s'étend à  .

.

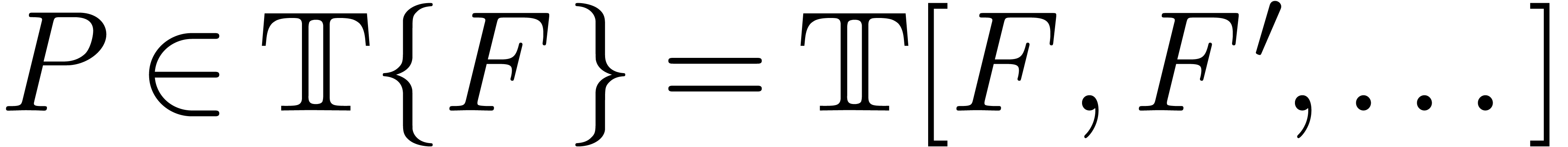

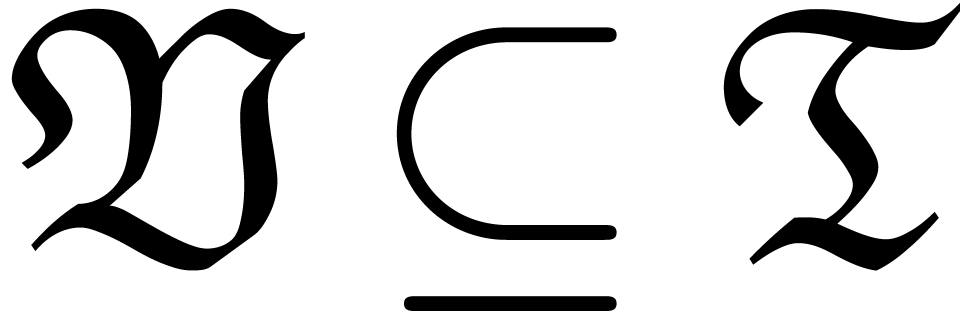

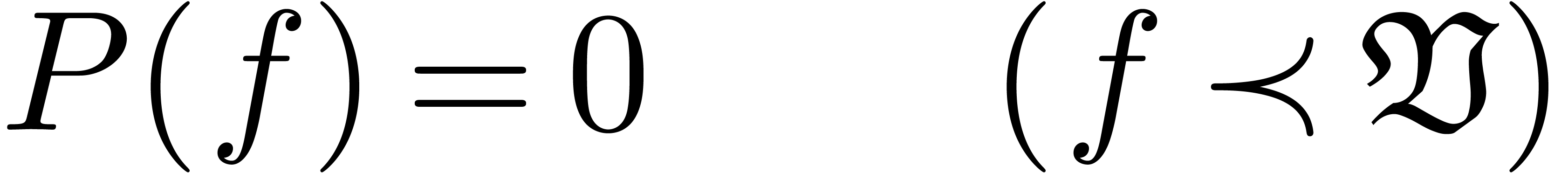

On dit que  est différentiellement

hensélien lorsque toute équation

différentielle quasi-linéaire à coefficients dans

est différentiellement

hensélien lorsque toute équation

différentielle quasi-linéaire à coefficients dans

admet une solution dans

admet une solution dans  . On peut étendre cette notion à des

corps de Hardy différentiellement algébriques sur

. On peut étendre cette notion à des

corps de Hardy différentiellement algébriques sur  , afin de montrer un inverse

partiel du théorème 3.5 :

, afin de montrer un inverse

partiel du théorème 3.5 :

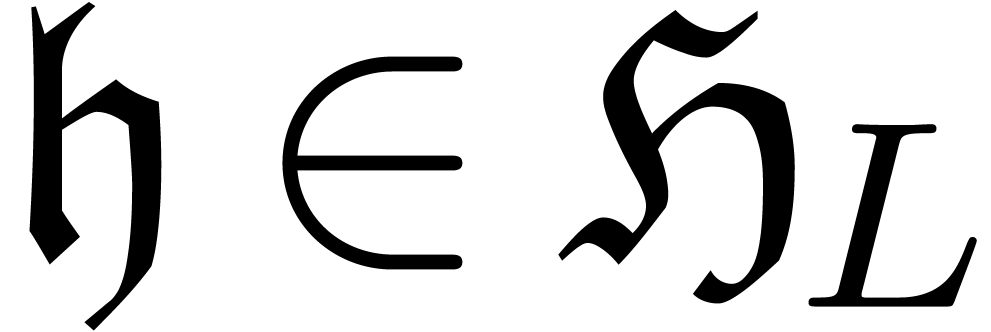

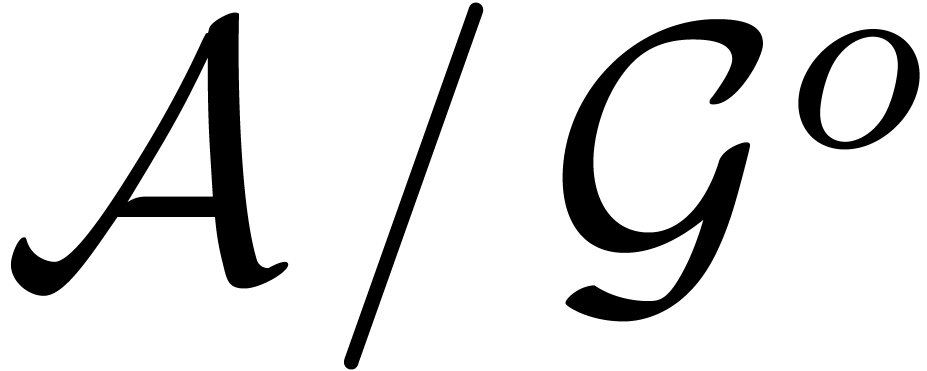

un corps de Hardy

transsériel et

un corps de Hardy

transsériel et  un corps de Hardy qui est

différentiellement algébrique sur

un corps de Hardy qui est

différentiellement algébrique sur  , hensélien, et stable par exponentiation.

Alors on peut munir

, hensélien, et stable par exponentiation.

Alors on peut munir  d'une structure de corps de

Hardy transsériel, qui étend celle de

d'une structure de corps de

Hardy transsériel, qui étend celle de  .

.

un corps de Hardy transsériel et

un corps de Hardy transsériel et  un corps de Hardy qui est différentiellement

algébrique sur

un corps de Hardy qui est différentiellement

algébrique sur  et hensélien.

Supposons que

et hensélien.

Supposons que  n'admet pas d'extensions

différentiellement algébriques de corps de Hardy. Alors

n'admet pas d'extensions

différentiellement algébriques de corps de Hardy. Alors

vérifie le théorème

différentiel des valeurs intermédiaires.

vérifie le théorème

différentiel des valeurs intermédiaires.

Remarque  est contenu

dans un corps de Hardy, mais qu'aucune solution n'appartient à

l'intersection de tous les corps de Hardy maximaux.

est contenu

dans un corps de Hardy, mais qu'aucune solution n'appartient à

l'intersection de tous les corps de Hardy maximaux.

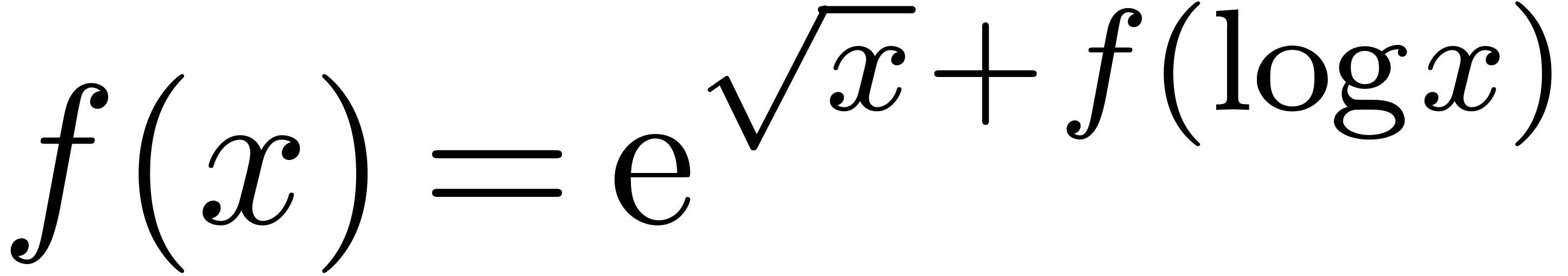

Pour l'instant, la généralisation de la théorie des corps de Hardy transsériels aux équations fonctionnelles plus générales semble compliquée. Toutefois, pour des équations simples comme

on pourrait au moins vouloir s'assurer que les solutions formelles en transséries peuvent s'incarner de façon analytique.

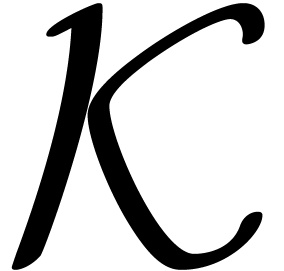

L'équation (3.2) fut étudiée en 1943

par Kneser, à des fins industriels secrets [58]. Il

démontra l'existence d'un itérateur réel analytique

de

de  .

Le IIIième Reich s'en effondre une seconde fois : on

peut même construire des itérateurs réels

analytiques

.

Le IIIième Reich s'en effondre une seconde fois : on

peut même construire des itérateurs réels

analytiques  de forces supérieures

de forces supérieures  . En effet, on peut toujours

s'arranger pour que

. En effet, on peut toujours

s'arranger pour que  admette un « bon

» point fixe

admette un « bon

» point fixe  , puisque

, puisque

est solution de (2.4) pour tout

est solution de (2.4) pour tout

, si

, si  est solution. On prend ensuite une solution réelle analytique de

est solution. On prend ensuite une solution réelle analytique de

) autour de

) autour de  et on la prolonge sur

et on la prolonge sur  ) par

l'équation fonctionnelle.

) par

l'équation fonctionnelle.

Plus généralement, Écalle fournit une

méthode pour trouver des solutions quasi-analytiques de

l'équation  [37, Proposition

8.1] : on commence par perturber

[37, Proposition

8.1] : on commence par perturber  de façon

à exhiber un « bon » point fixe

de façon

à exhiber un « bon » point fixe  . Cette fonction perturbée

. Cette fonction perturbée  admet à nouveau un itérateur naturel

admet à nouveau un itérateur naturel  autour de

autour de  ,

qui se prolonge jusqu'à

,

qui se prolonge jusqu'à  .

Enfin, on obtient

.

Enfin, on obtient  en fonction de

en fonction de  , par un développement asymptotique

rapidement convergent. En revanche, il n'y a pas de véritable

moyen pour privilégier le choix d'un itérateur

spécifique sur les autres ; toute fonction

, par un développement asymptotique

rapidement convergent. En revanche, il n'y a pas de véritable

moyen pour privilégier le choix d'un itérateur

spécifique sur les autres ; toute fonction  , avec

, avec  suffisamment petit et

de période

suffisamment petit et

de période  , fournit

une nouvelle solution.

, fournit

une nouvelle solution.

Afin d'obtenir des solutions quasi-analytiques de (3.3), on

procède en plusieurs étapes. D'abord on perturbe la

fonction logarithmique de façon qu'elle admette un point fixe.

Plus précisément, en écrivant  , où

, où  vérifie

vérifie

|

(3.4) |

et où  pour un certain

pour un certain  , l'équation (3.3) se

transforme en

, l'équation (3.3) se

transforme en

|

(3.5) |

Les solutions quasi-analytiques de (3.4) sont de la forme

, avec

, avec

|

(3.6) |

où  est l'inverse fonctionnelle de

est l'inverse fonctionnelle de

Les solutions de (3.6) sont de la forme  , avec

, avec

|

(3.7) |

Dans un deuxième temps, il s'agit de résoudre l'équation (3.5). Pour ce faire, on considère d'abord l'équation perturbée

|

(3.8) |

où  est choisi convenablement de

façon que (3.8) puisse se résoudre par un

théorème d'itération autour du point fixe

est choisi convenablement de

façon que (3.8) puisse se résoudre par un

théorème d'itération autour du point fixe  . En utilisant l'équation

fonctionnelle (3.8), cette solution est ensuite

prolongée jusqu'à l'infini. Les solutions de (3.5)

s'écrivent maintenant sous la forme

. En utilisant l'équation

fonctionnelle (3.8), cette solution est ensuite

prolongée jusqu'à l'infini. Les solutions de (3.5)

s'écrivent maintenant sous la forme  ,

où

,

où

|

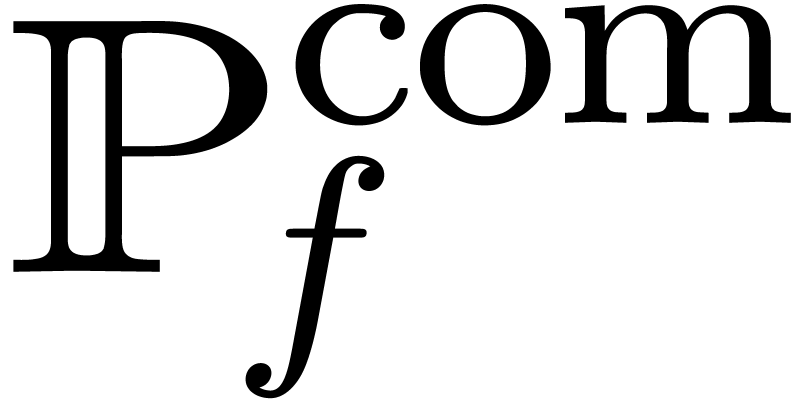

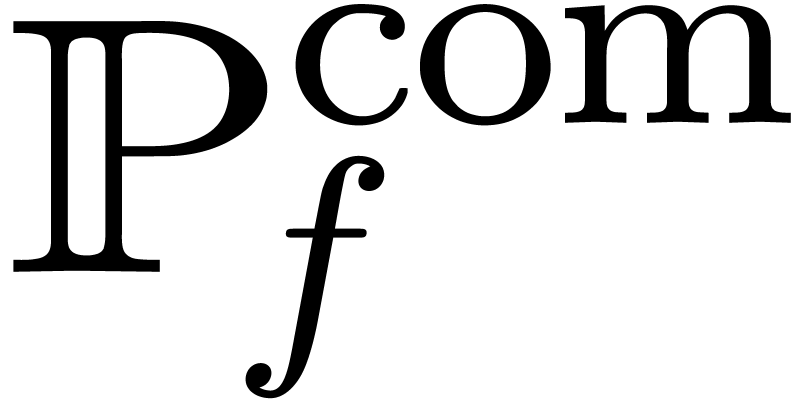

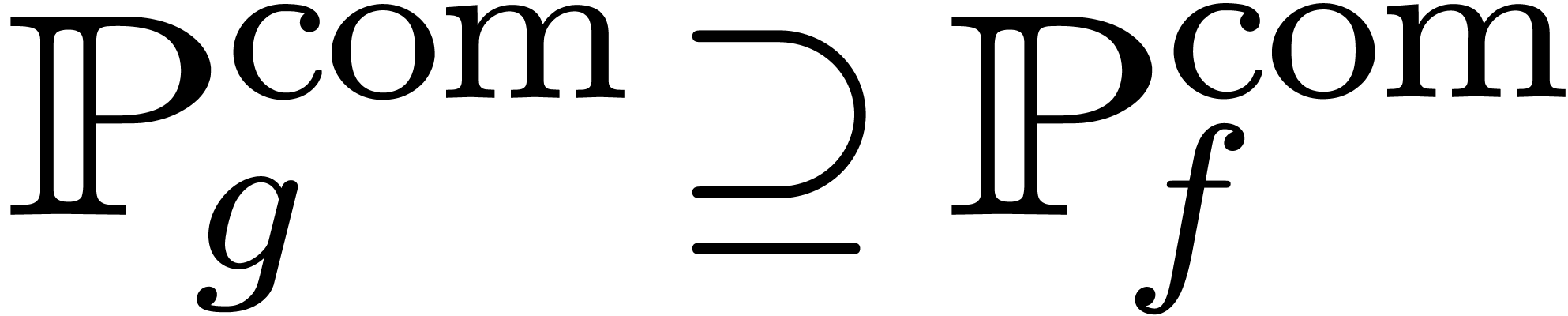

(3.9) |

Nous ignorons actuellement si l'équation (2.2) admet des solutions réelles analytiques. À nouveau, on ne voit pas non plus de façon pour privilégier une solution spécifique de (3.3) sur toute autre solution.

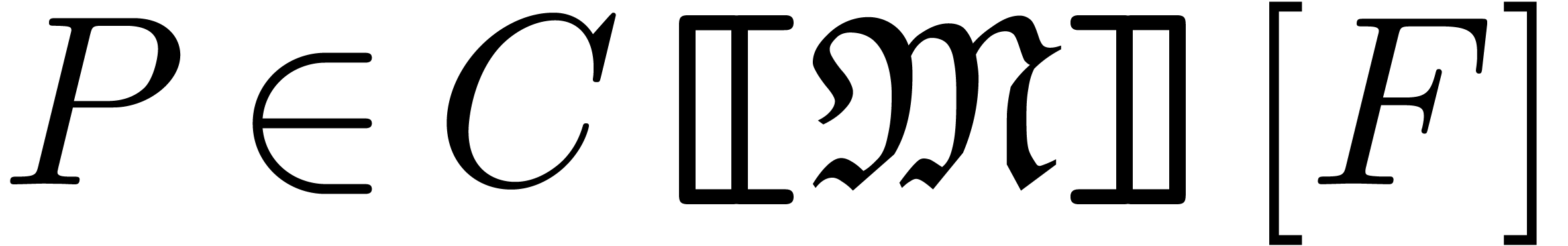

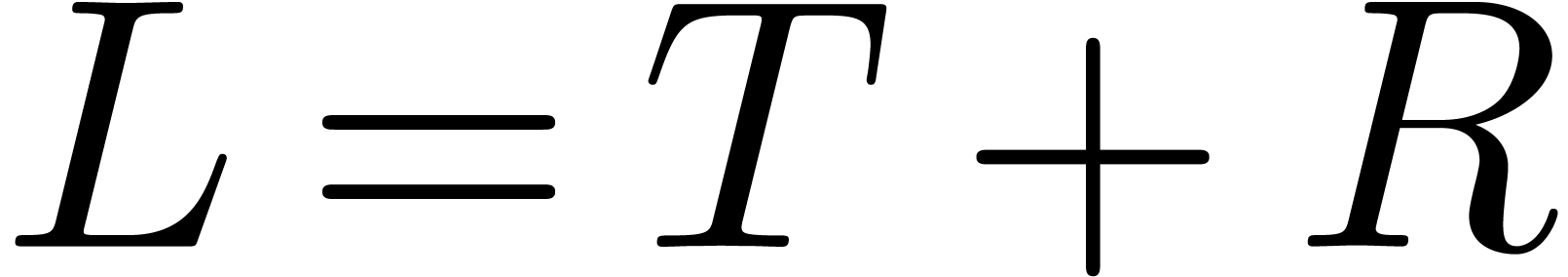

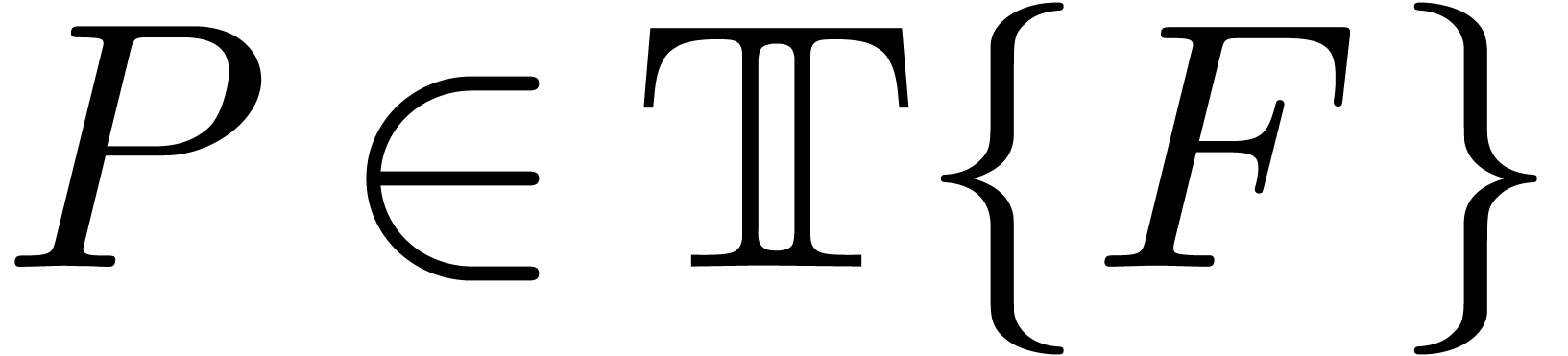

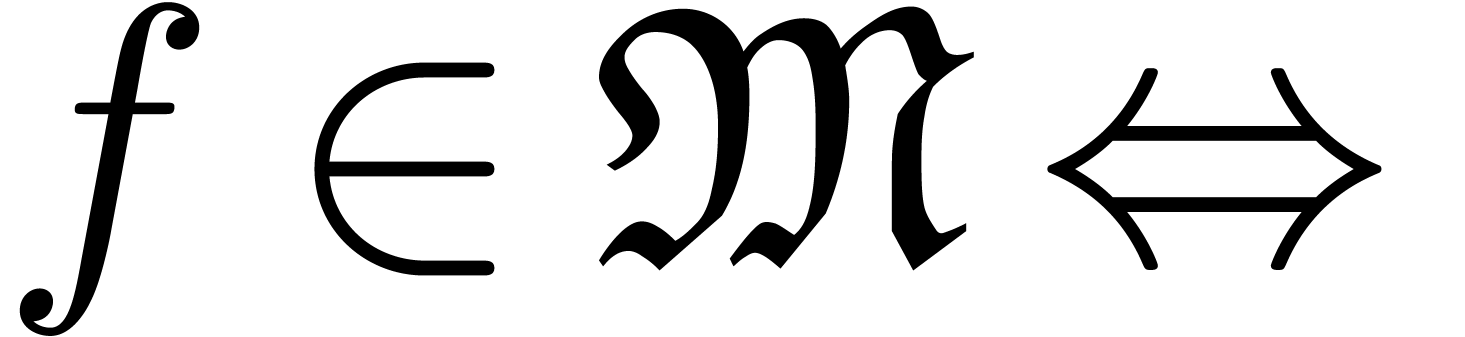

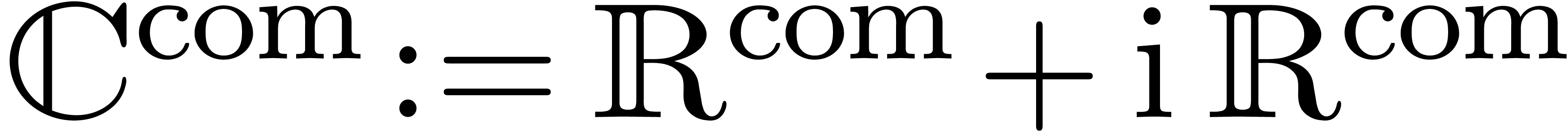

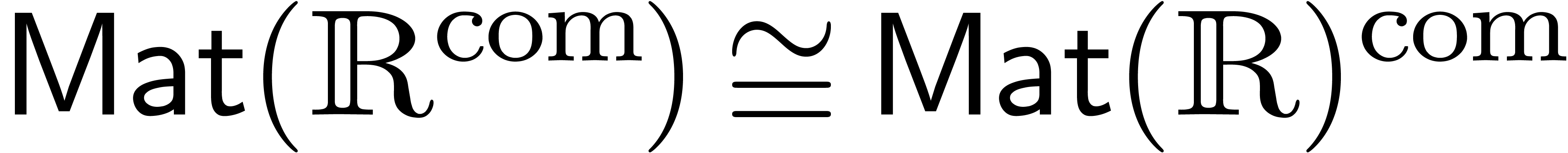

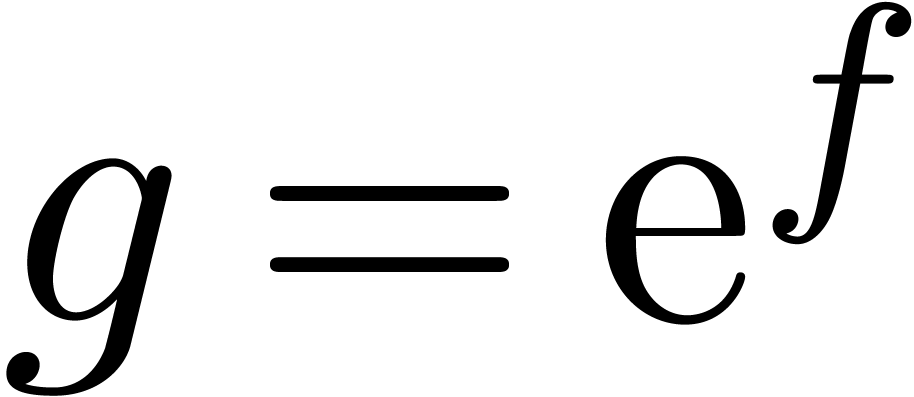

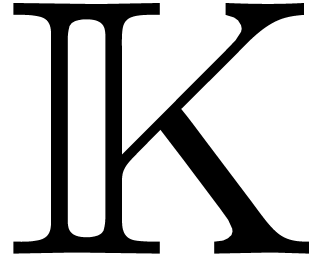

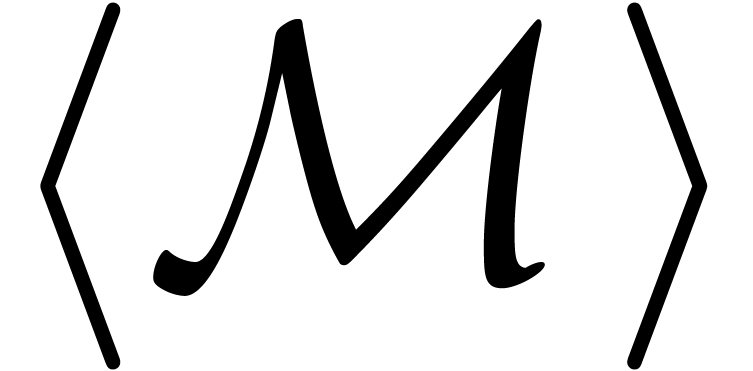

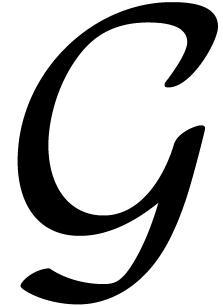

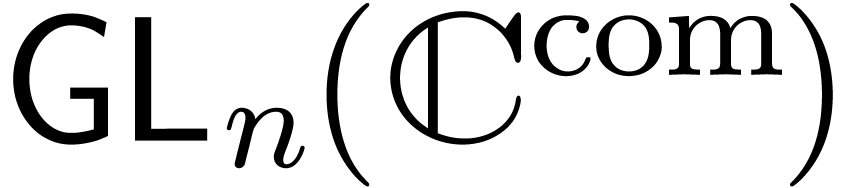

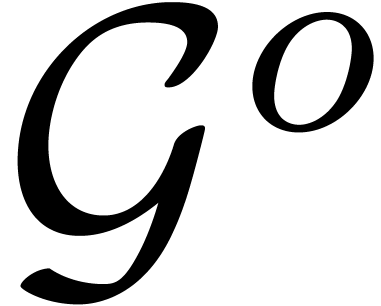

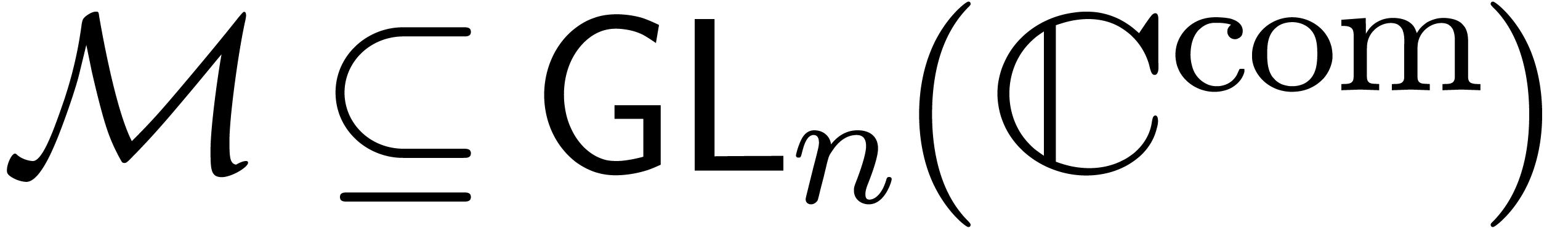

La structure particulièrement riche des corps de transséries en font des modèles naturels de nombreuses théories qui étendent l'algèbre différentielle avec une relation d'ordre, une valuation, une sommation infinie ou encore une composition. En collaboration avec Matthias Aschenbrenner et Lou van den Dries, nous essayons de généraliser la théorie des transséries à ce genre de modèles plus généraux.

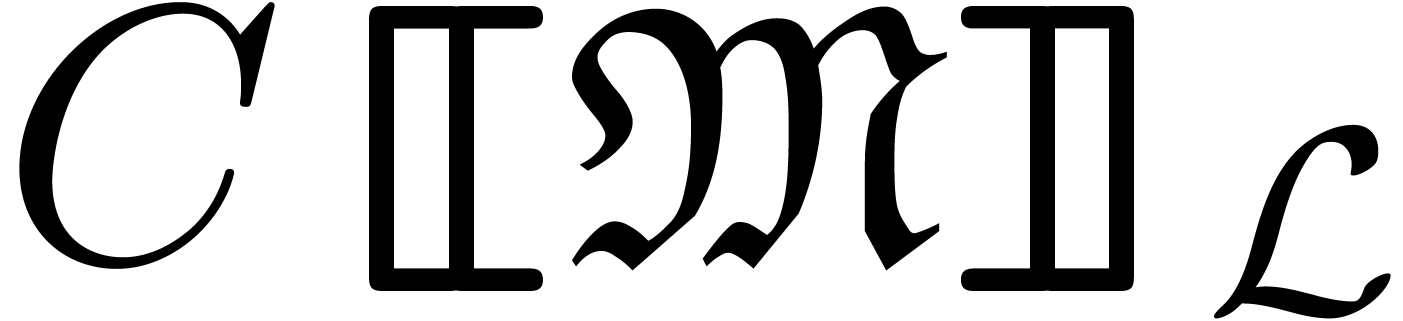

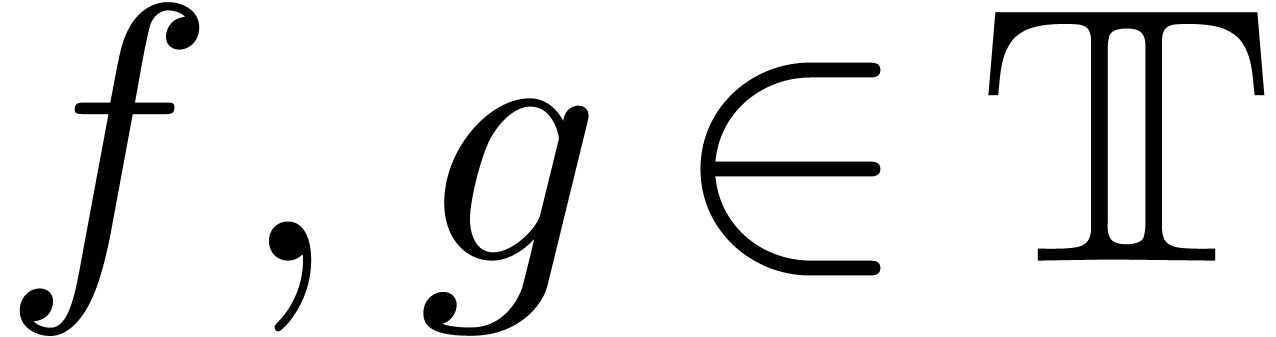

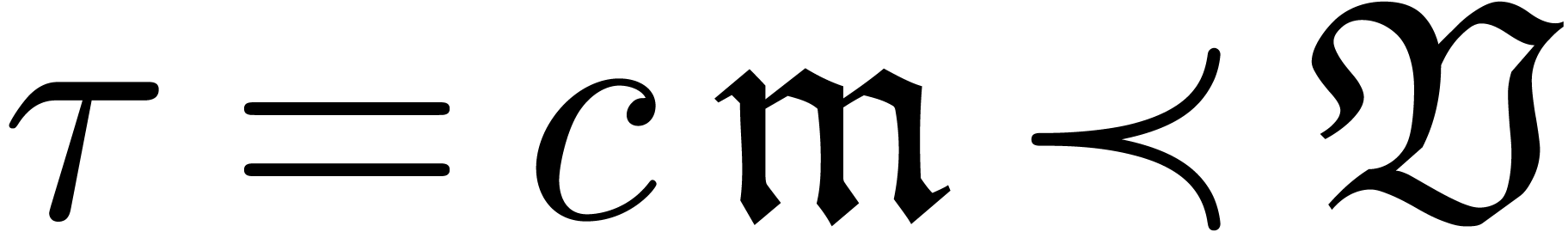

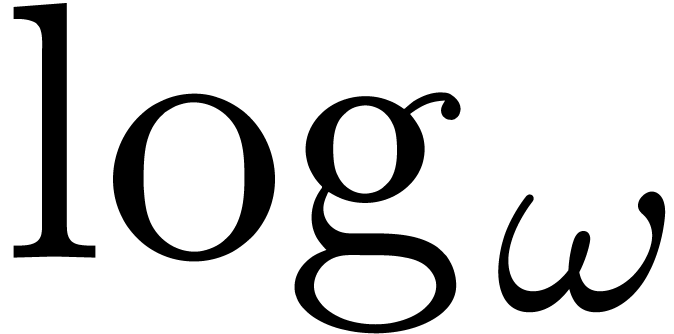

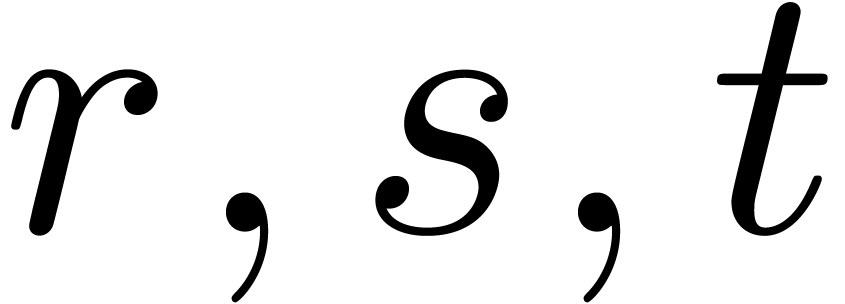

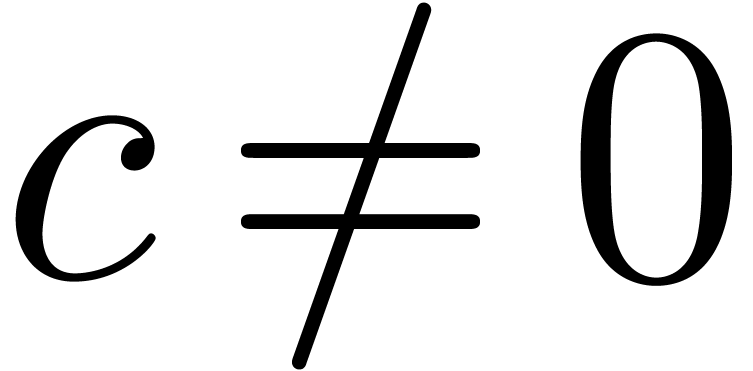

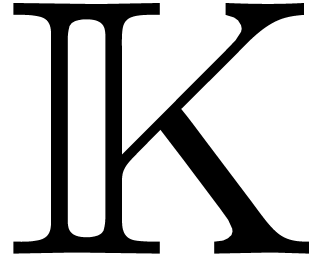

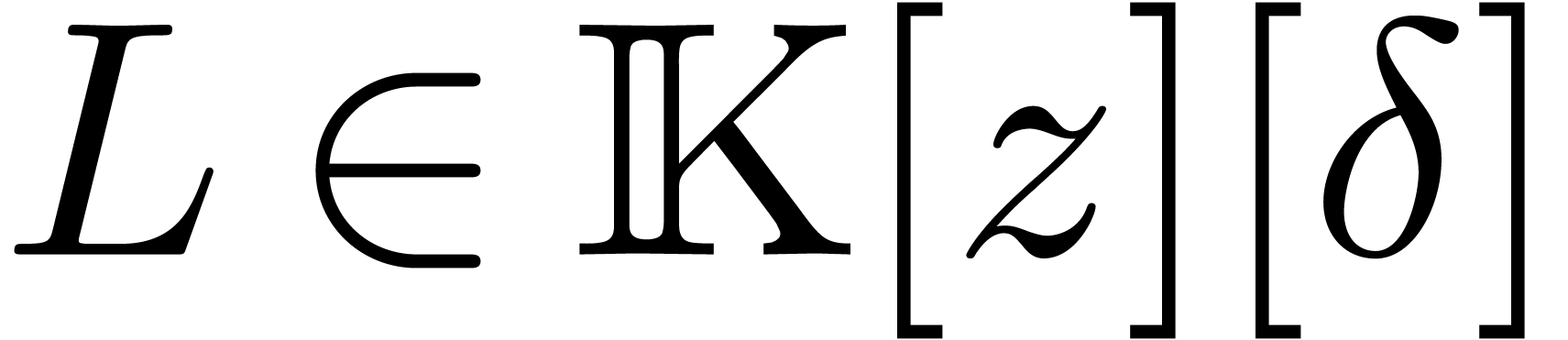

Soit  un corps différentiel avec

un corps différentiel avec  comme corps de constantes. Une valuation

comme corps de constantes. Une valuation  sur

sur  détermine des relations

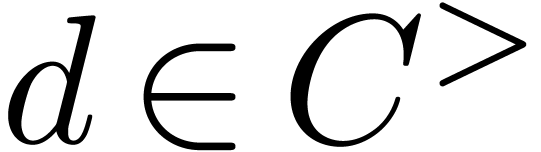

détermine des relations  et

et  de domination et de

prépondérance par

de domination et de

prépondérance par  et

et  . La relation

. La relation  est

compatible avec la dérivation sur

est

compatible avec la dérivation sur  si

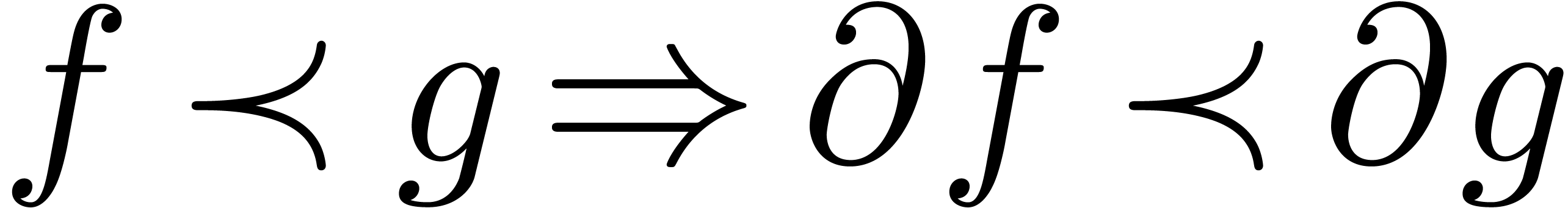

si

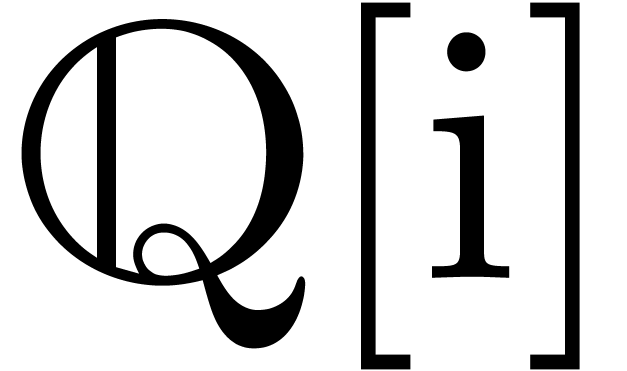

.

.

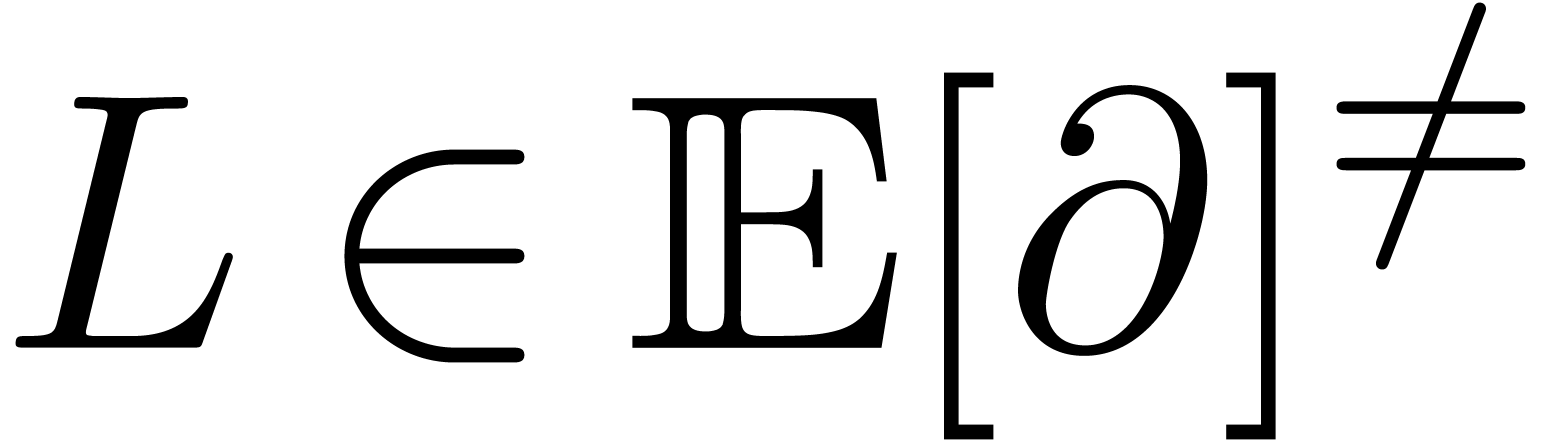

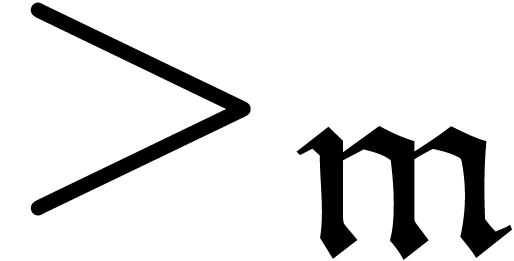

Un corps différentiel  muni d'une telle

relation

muni d'une telle

relation  est appelé corps

asymptotique. De façon similaire, on dit que

est appelé corps

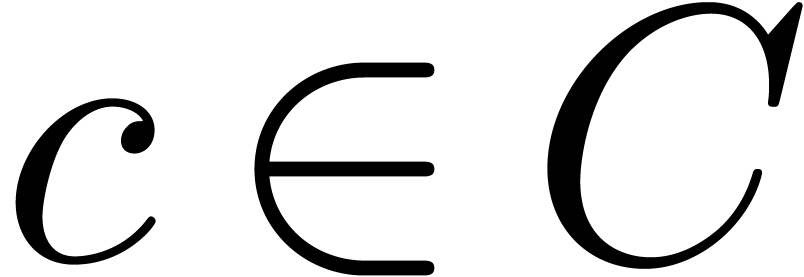

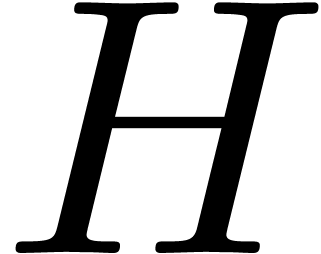

asymptotique. De façon similaire, on dit que  est un corps H, si

est un corps H, si  est

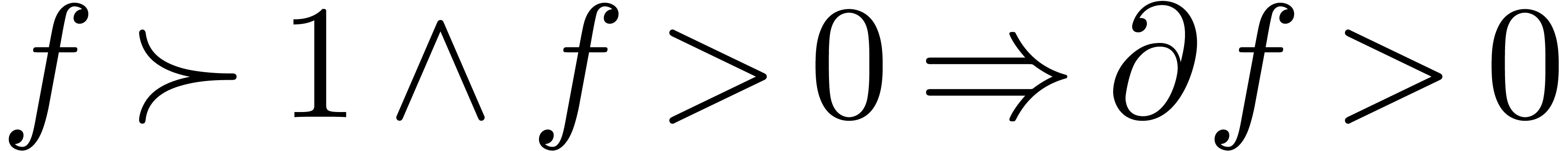

muni d'une relation d'ordre vérifiant

est

muni d'une relation d'ordre vérifiant

.

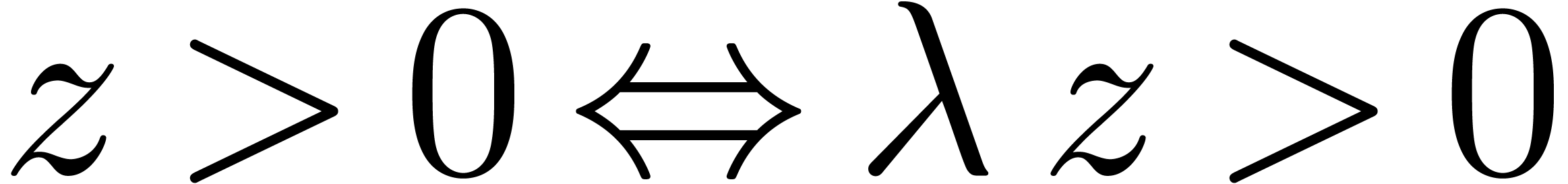

.

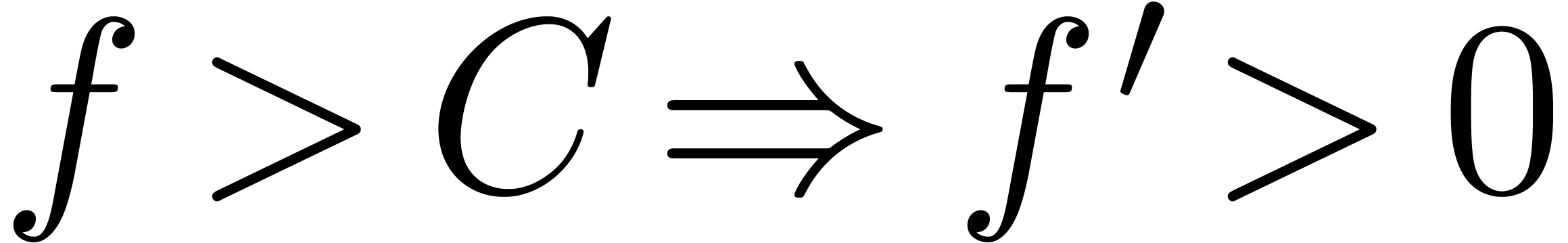

Si  pour

pour  ,

alors il existe un

,

alors il existe un  avec

avec  .

.

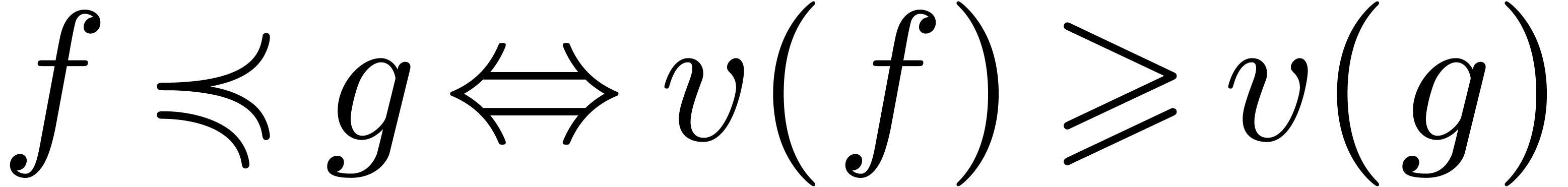

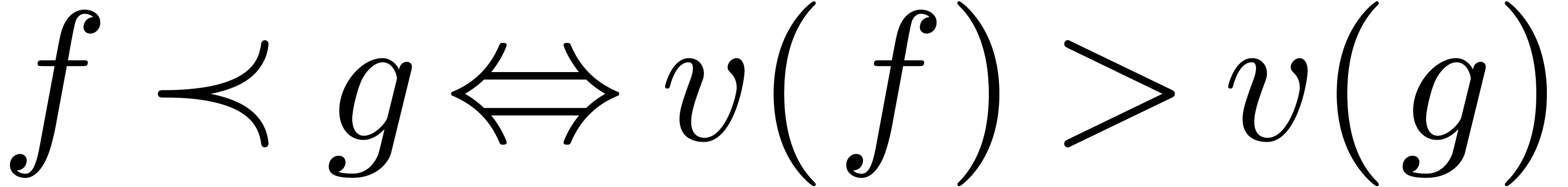

En particulier, tout corps H est un corps asymptotique pour la valuation induite par la relation d'ordre.

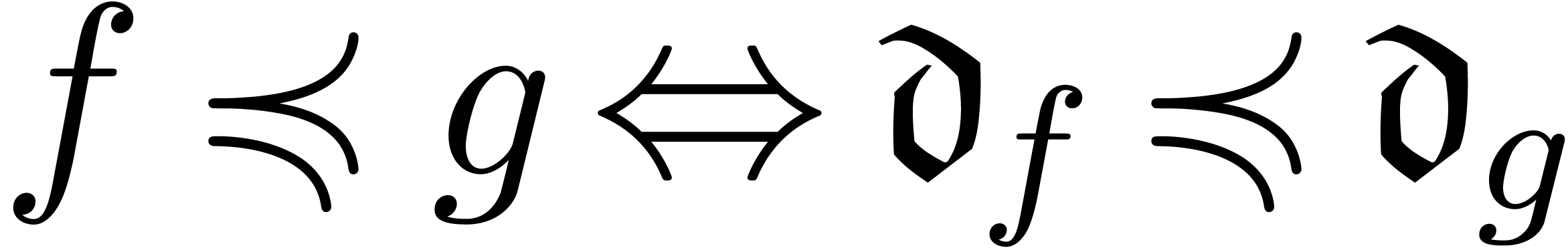

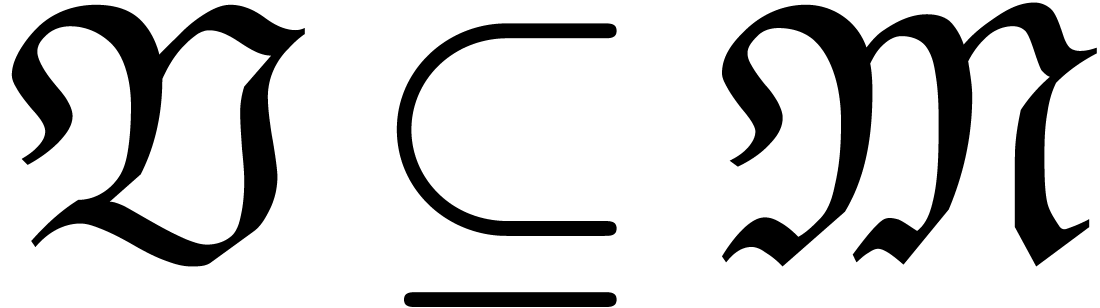

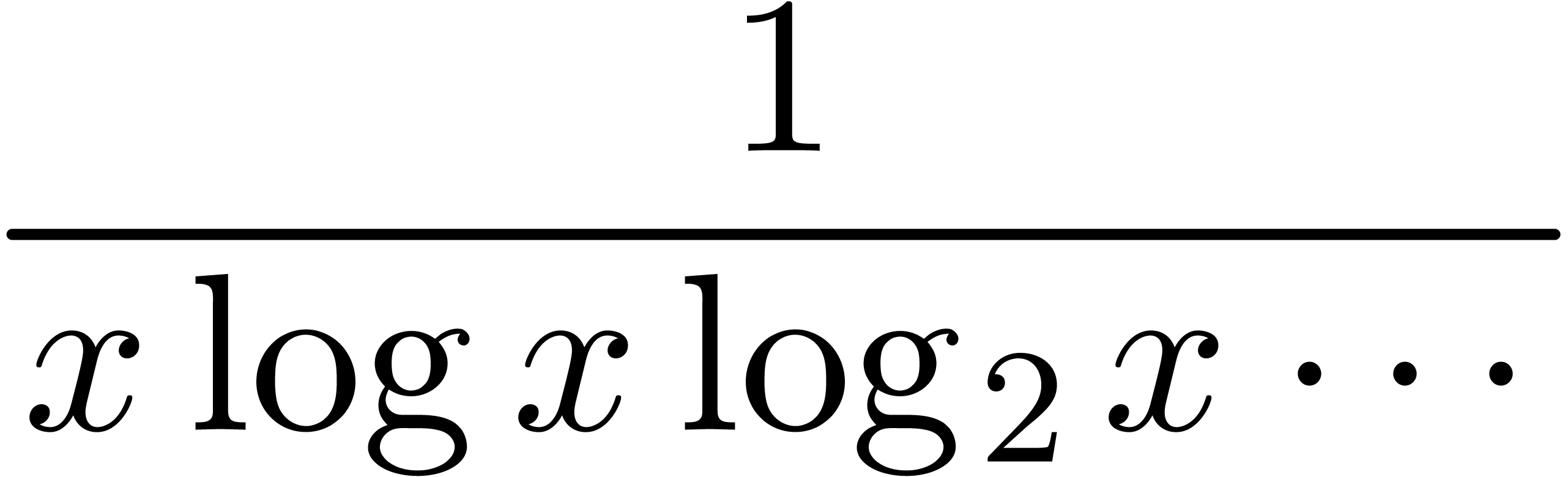

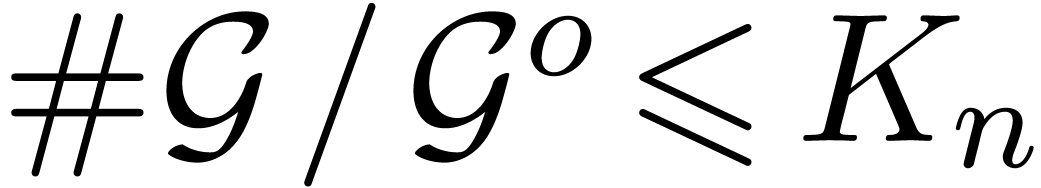

La théorie de base des corps H a été

étudiée par Aschenbrenner et van den Dries [4,

3]. Contrairement à la théorie des corps

différentiels, il s'y produit un phénomène

étrange de dichotomie lorsque l'on considère des

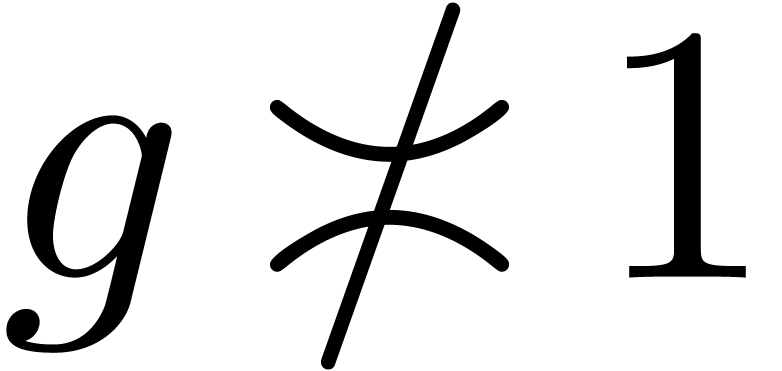

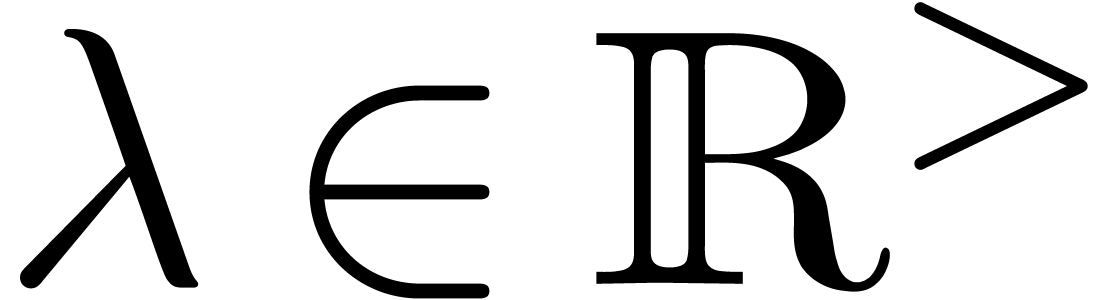

extensions de corps H. Plus précisément, on dit que  est Liouville clos si toute équation

différentielle de type

est Liouville clos si toute équation

différentielle de type  avec

avec  admet une solution dans

admet une solution dans  .

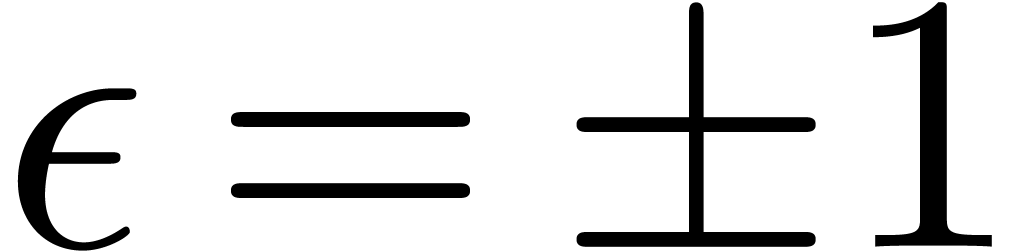

Une lacune dans

.

Une lacune dans  est un

élément

est un

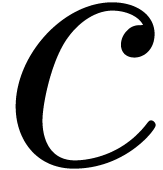

élément  du groupe de valuation de

du groupe de valuation de

telle que

telle que  pour tous les

pour tous les

non nuls. Typiquement, des transséries du

type

non nuls. Typiquement, des transséries du

type

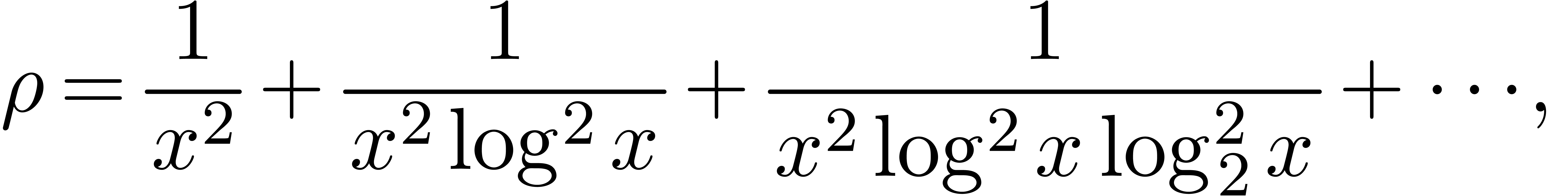

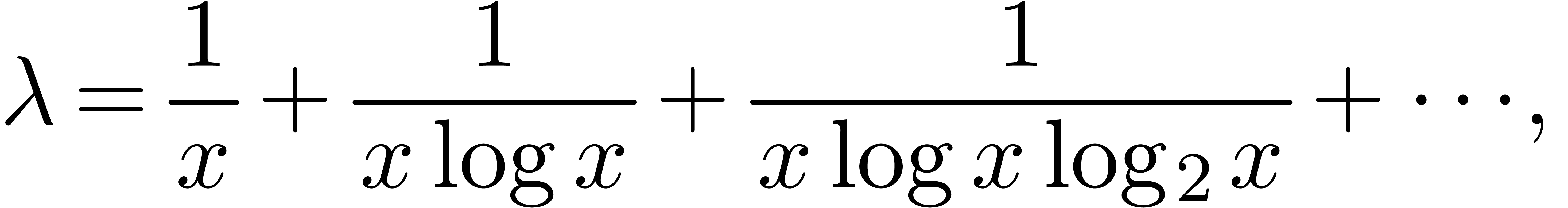

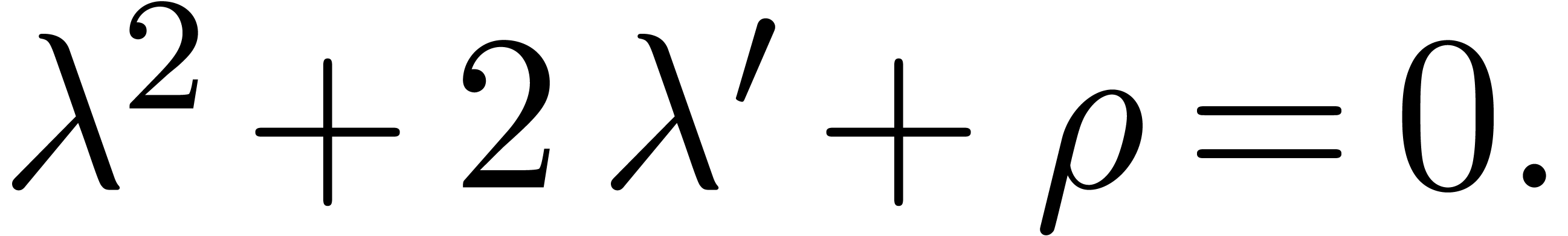

peuvent induire des lacunes. Un corps H admet au plus une lacune et

jamais de lacune s'il est Liouville clos. Un corps H avec une lacune

admet exactement deux clôtures de

Liouville dans lesquelles on a

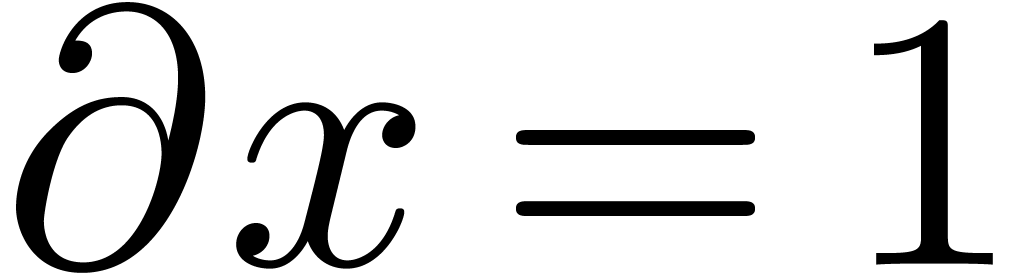

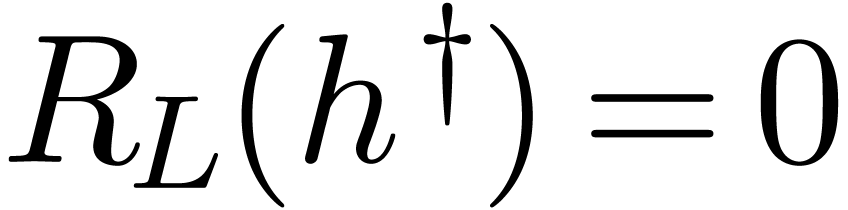

admet exactement deux clôtures de